CVD 預測模型精確度優化措施探究

尹帥帥, 石更強, 孫旭陽

(上海理工大學 健康科學與工程學院,上海 200093)

根據最新統計,全世界每年因心血管疾病(CVD)而死亡的人數約1 530 萬人,占總死亡人數的1/4,CVD 已成為全世界高發病率和高死亡率的主要疾病[1-2]。隨著大數據技術的發展,CVD 相關診斷數據也在持續增加,為今后疾病診斷和預防提供了很好的數據基礎[3-4]。CVD 是由遺傳、環境、行為、疲勞等多種因素共同作用導致的[5],風險預測模型可以整合這些因素,利用機器學習(ML)進行疾病預測[6]。風險預測模型的精確度對于疾病風險分層和中危人群重分類具有重大意義,努力提高預測模型精確度,可以及時對高危人群進行追蹤、防控和個體化干預,減少疾病帶來的危險。

目前國內外關于風險預測模型的研究中,還沒有對如何提高CVD 風險預測模型精確度進行系統性的論述。Bouwmeester 等[2]探究近期文獻中預測模型如果按照傳統方法學建議進行建模,是否會導致較差的預測結果[7-9]。Wessler 等[10]通過對模型進行總結和比較,指出現今預測模型存在的局限性。預測模型的分析不能僅僅局限于對預測結果的探討,而更應該注重構建模型的各個模塊對結果產生的影響。Damen 等[11]探討了預測模型的危險因素、預測結果、預測性能、外部驗證等。Siontis 等[12]收集了大量模型的區分、校準、重分類等信息,對特定信息偏差是否會影響預測模型的結果進行評估。Cooney 等[13]和Cui[14]探討了單因素和多因素對預測結果的影響。為了更好地改善預測模型的精確度,改善青年、中年、老年同一預測模型、不同預測結果而帶來的不同個體化、精確化干預措施,本文檢索了大量文獻,對比了從數據選擇到最后模型評估的整個內容,就如何提高風險預測模型精確度進行綜合性探討。

1 文獻檢索與探究

1.1 文獻處理

文獻選擇:為了提高研究的價值和意義,手動檢索了國內外在醫學領域影響力較高的395 篇文獻,通過對每篇文獻的題目和摘要進行仔細審閱,得到95 篇與研究相關的文章,通過對整篇文章閱讀與分析,剔除了非科研論文和建模不完整文獻,保留了余下的62 篇文獻。

入選原則:文獻必須是原創性研究型論文,本研究主要尋求改善預測模型精確度的方法,因此,文獻必須包含樣本選擇與處理、特征值選擇、預測模型搭建、預測性能探究、模型風險評估等一項或多項改善措施,文獻中必須包含針對某些人群的預測結果。最后對保留的62 篇文獻進行交叉性和系統性研究,并根據項目的不同進行文獻占比分類。整個流程如圖1 所示。

圖1 文獻入選流程圖Fig.1 Flowchart of literature inclusion

1.2 數據處理

制定列表:為了更加方便直觀地展示探究結果,本文制定了列表式對比評分機制。涉及項目包含預測目標、模型種類、數據對象等[15-16],極大地提高了數據的可利用性。

數據挖掘:數據挖掘是為了探究各預測模型之間的相同或不同之處,從中找到可以改善的方面。

精確度等級百分率:精確度作為研究的主體,根據探究目的創新地提出精確度等級百分率。每個模塊進行分類后,得到的文獻數目各不相同,在進行精確度對比時,無法保證單一變量,無法消除文獻數目不同對結果的影響。因此,將精確度進行等級劃分,將文獻各自精確度按等級歸類,然后將等級歸類后的文獻數量進行百分率化得到聚集區,最后進行數據分析與比較,得出所需要的數據意義。

精確度等級百分率的意義在于消除了基數不同帶來的對比影響,將不同數據利用最大化,挖掘數據潛在價值,容易得出聚集區、眾數、中位數、平均數、最大值、最小值、數值走向和各數據的意義,這是對數據挖掘思想的體現,對本研究至關重要。

1.3 探究內容

一個完整的預測模型一般包括4 大模塊[17],為了尋求改善預測模型精確度的措施,本文對這4 個模塊進行探究。

a. 樣本大小和時間間隔。對各類文獻的樣本大小、時間間隔、精確度進行數據處理、相關性分析、描述統計分析、橫縱向對比,繪制相應的評分表格和散點圖,經數據挖掘得出最小樣本量和最小時間間隔[18]。

b. 數據來源。探究改進電子健康記錄(EHRs)的優勢,將不同數據來源進行縱向精確度等量對比,得出最合適的數據來源,并對各數據來源的優缺點和應用范圍進行分析[19]。

c. 特征。將改進特征選擇方法的各算法進行比較,得出最優的特征選擇方法;比較納入新特征前后的精確度,判斷該特征是否改善了精確度;將不同特征選擇方法進行縱向比較,判斷是否選擇更多相關的特征可以提高預測模型精確度。

d. 建模方法。對回歸分析進行簡單的分類、對比,并對各自的適用范圍進行敘述;對機器學習的不同算法采用統計、圖示的方法進行橫向比較,得出精確度最高的最優算法;并對以Framingham risk score(FRS)為代表的項目進行簡單敘述[5]。

2 分析和結果

2.1 樣本大小和時間間隔

在保證其他條件不變的情況下,樣本大小和時間間隔決定了模型的擬合程度。研究人員無法確保所獲得的樣本大小是否影響模型的擬合效果,本文通過對各類文獻的研究,探究在保證一定精確度下的最小樣本量[18]。時間間隔同樣影響著擬合效果,尋找一個在不影響精確度情況下的最小時間間隔會更好地減少時間消耗[20]。

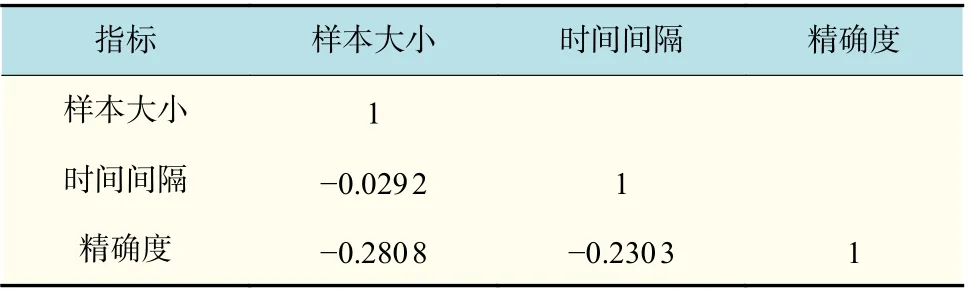

為了獲得最小樣本量和最小時間間隔,將此模塊入選的文獻n=43,根據風險預測評估[19]方法的不同分為3 類:機器學習項目[21-22]文獻n=18、回歸分析項目[23-24]文獻n=15、以FRS 為代表的風險預測項目[25-26]文獻n=10,針對不同項目采取不同的分析方法。分析樣本總量、時間間隔、精確度三者之間的相關性,得到的相關系數如表1 所示。然后對3 類項目分別進行分析,繪制了各自的散點圖,如圖2~4 所示。刪除影響整體分析的數據,建立剩余數據的散點圖,如圖2(c)、4(c)所示,并對散點圖進行趨勢性分析。對3 類項目進行描述統計分析,確定各值的意義,具體數據如表2 所示。

表1 相關系數表Tab.1 Correlation coefficients table

表1 列出了樣本大小、時間間隔、精確度三者的相關系數。由表1 可見:樣本大小與時間間隔相關系數較小,表明兩者數據幾乎平行,存在微弱相關性,符合通常認定;樣本大小和時間間隔分別與精確度存在一定的因果關系,所以合適的樣本大小和時間間隔可以影響精確度。

在機器學習項目的樣本大小和精確度的散點圖2(a)中,點主要分布在精確度為0.8~0.9、樣本大小為0~5 000 的區間。進一步分析點密集的地方,在圖2(c)中,點主要分布在5 000 左右。在表2 中,關于機器學習項目的樣本大小中,中位數為4 103,方差為2.55×108,表明這些數據整體比較離散,采取中位數對這16 個觀測數進行統計具有一定的意義。由圖2(c)的上升趨勢可以得出,為了保證精確度在0.8~0.9 之間,最合適的最小樣本量在4 000~5 000 之間。在時間間隔與精確度圖2(b)中,點主要分布在精確度為0.8~1.0、時間間隔為5~7 a 的區間,散點圖的線性趨勢為下降趨勢,所以初步得出最合適的時間間隔為5 a。表2 機器學習項目的時間間隔中,方差為1.183,說明數據比較聚集,眾數和中位數都為5,綜上可得,最合適的最小時間間隔為5 a。

圖2 機器學習項目各類散點圖Fig.2 Scatter diagram of various types of machine learning projects

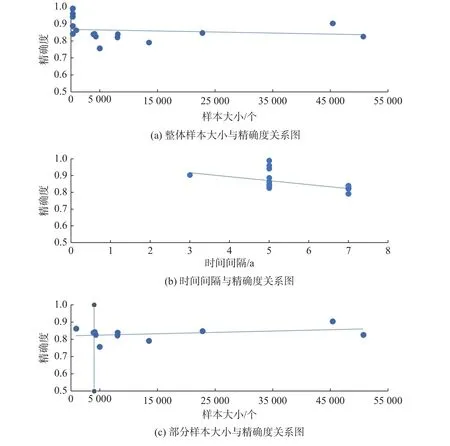

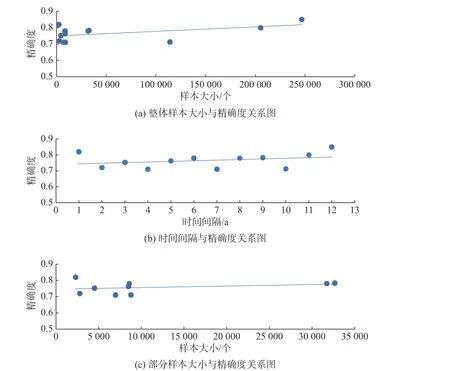

在回歸分析項目的樣本大小和精確度散點圖3(a)中,去掉樣本的最大值和最小值,點主要分布在精確度為0.75~0.80、樣本大小為0~10 000的區間。在表2 回歸分析項目的樣本大小中,中位數為6 894,方差為1.89×109,數據較分散,點主要分布在4 000~7 000 之間,結合散點圖下降趨勢,得出在保證精確度較高的情況下,最合適的最小樣本量在4 000~7 000 之間。在時間間隔與精確度圖3(b)中,精確度為0.75~0.85 之間,時間間隔對應的點較分散,散點圖無法得出一個好的結論。表2回歸分析項目中,時間間隔平均數為7.267,中位數為6,眾數為5,結合這些數據的意義,點主要分布在5~7 a 之間,且最大精確度分布在這個區間。因此,為了提供一個較大的精確度上限,采取的最合適的最小時間間隔為5~7 a。

表2 樣本大小和時間間隔描述統計表Tab.2 Statistics of sample size and time interval

圖3 回歸分析項目各類散點圖Fig.3 Scatter diagram of each type of regression analysis project

在FRS 風險預測項目的樣本大小和精確度的散點圖4(a)中,點主要分布在精確度為0.70~0.85、樣本大小為0~50 000 的區間,但線性趨勢呈上升趨勢,意味著樣本越大精確度越高。在圖4(c)中,去掉影響較大的10 萬級數據,點主要分布在5 000~10 000 之間,但總體來說精確度相對較小,為保證精確度在0.80 以上,對應的圖4(b)中,時間間隔必須為10 a 以上。考慮到圖4(a)后半部分精確度較高,無法忽略,在樣本大小200 000~250 000、精確度0.80~0.85 之間,這些點對應圖4(b)中時間間隔為5~7 a 之間的點。趨勢線呈正相關,樣本容量越大,時間間隔越大,則精確度越高。所以為了保證精確度在0.80 以上,若采取較小樣本量在5 000~10 000 之間,最小時間間隔必須在10 a 以上。若采取大樣本量200 000 以上,最小時間間隔建議在5~7 a 之間。

圖4 FRS 風險預測項目各類散點圖Fig.4 Scatter diagram of various types of FRS risk prediction projects

2.2 數據來源

不同的數據來源提供的醫學信息準確性和全面性各不相同,且導致對未來的預測各不相同[19],不同的數據來源獲取的困難程度也各不相同[27]。

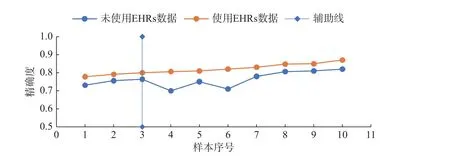

本文將數據來源模塊檢索的文獻n=50,根據數據獲取途徑的不同分為4 類:改進電子健康記錄(EHRs)[21,28],文獻n=10;普通隨訪調查[26,29],文獻n=20;醫院體檢數據[30-31],文獻n=10;UCI機器學習數據庫UCI[32-33],文獻n=10。為了保證等量對比且數據具有隨機性,利用Python 軟件的random 函數,從普通隨訪調查的20 個樣本中隨機選取10 個樣本,將每個序號與列表中的精確度一一對應,形成等量樣本。為了探究EHRs 是否改善了精確度,將使用EHRs 與未使用的數據進行對比,如圖5 所示。將上述4 類數據來源進行等量對比,經過列表升序和散點圖繪制,如圖6 所示,得出對精確度綜合效果最好的數據來源。

圖5 EHRs 使用前后精確度對比圖Fig.5 Comparison of accuracy before and after the use of EHRS

圖6 數據來源精確度對比圖Fig.6 Comparison of accuracy from different data sources

圖5 對比了模型開發過程中EHRs 使用與否的精確度,從圖中可以看出,使用EHRs 數據的模型精確度普遍高于未使用的精確度。在使用EHRs 的散點圖中,80% 的模型精確度高于0.8。因此,EHRs 的使用可以很好地改善模型的精確度,且保持在一個較高的精確度水平。

圖6 將不同數據來源的精確度進行了對比,可以看到采用UCI 的模型其精確度普遍高于其他數據來源,精確度在0.8 以上的點為100%,在0.9 以上的點為50%;采用EHRs 數據和醫院體檢數據的模型,精確度很接近,在0.8 以上的點為80%;采用普通隨訪調查的數據,精確度相對較低,在0.8 以上的點為50%,但都低于0.85,且下限值較低。EHRs 具有良好的時序特征,將EHRs應用于機器學習,利用EHRs 數據的高維性,挖掘數據內部關系,可以極大地提高模型精確度[34]。并且,由于EHRs 數據的豐富性,可以在一定程度上減少樣本的使用量[4]。醫院體檢數據具有較高的準確性,但是獲取困難,人工處理量大,增加了模型的開發時間。普通隨訪調查雖然數據獲取容易,且可以獲得更廣大的樣本量,但是數據的準確度不高,數據之間的聯系較差,人工消耗量較大,針對性不強。所以建議采用EHRs 數據,這樣既可以保證模型具有較高的精確度,而且數據獲取容易且全面。

2.3 特征

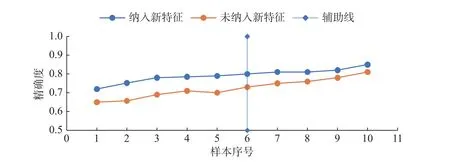

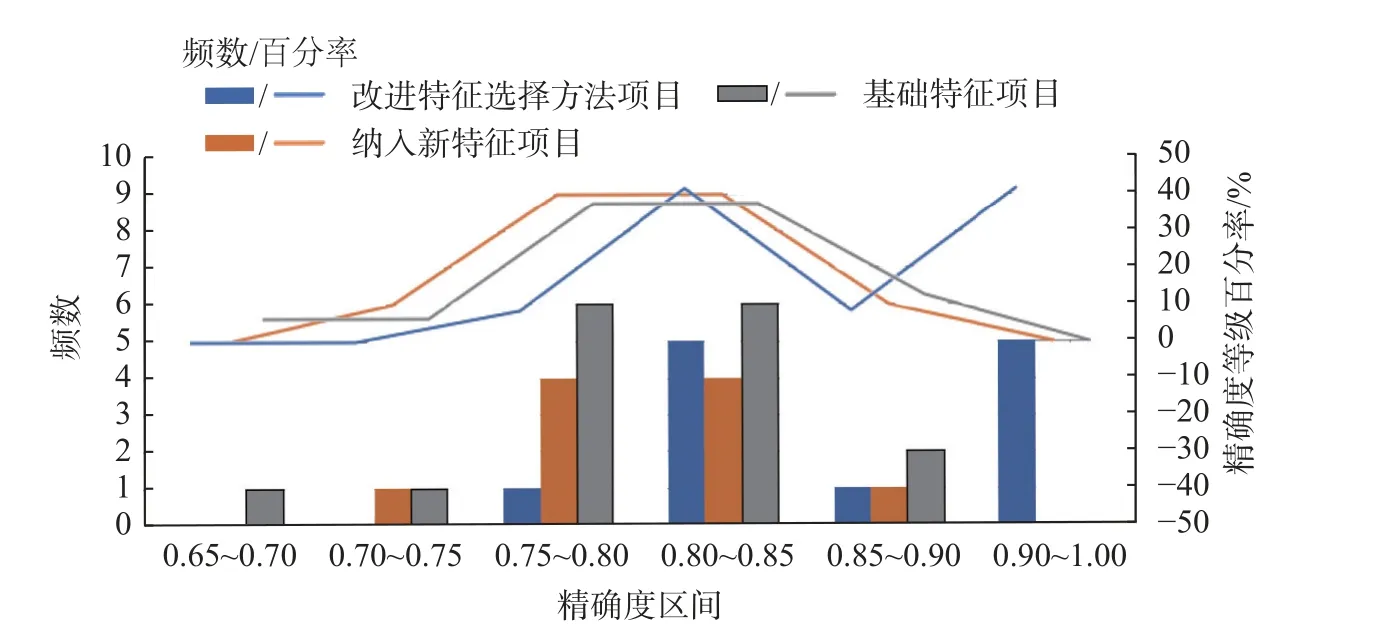

CVD 由多種危險因素引起,更好的特征組合可以實現更加精確的預測效果[27]。不同特征選擇方法可以得到不同的特征組合,為了得到最好的特征選擇方法,本文將檢索的文獻n=38 分為3 類:改進特征選擇方法項目[27,33]n=12、納入新特征項目[35-36]n=10、基礎特征項目[21]n=16。基礎特征包括年齡、性別、血壓等目前預測模型中經常采用的特征[24];納入新特征指在基礎特征上,添加了一些研究者認為可能跟CVD 風險相關的危險因素[36],本文將比較納入新特征前后的精確度,如圖7 所示。改進特征選擇方法是利用新的算法從數據中挖掘與CVD 有關的特征[37-38],通過列表評分機制,如表3 所示,得出最佳特征選擇算法和特征個數。為了消除基數不同產生的影響,采用直方圖和精確度等級百分率進行3 類項目對比,如圖8 所示,得到最有利于精確度的特征選擇方法。

圖7 新特征納入前后對比圖Fig.7 Comparison chart before and after the inclusion of new features

圖7 將納入新特征前后的精確度進行了對比,納入新特征的趨勢線始終高于未納入特征的趨勢線,說明在模型中加入新特征可以很好地改善模型的精確度,并且使模型精確度高于0.8 的百分率從10%提高到了50%。

表3 列出了改進特征選擇方法的各種算法、精確度以及特征個數,由表3 可得,精確度在0.8 以上的占90% 以上,在0.9 以上的占40%以上,這說明改進特征算法可以很好地提高精確度。在采取的算法中,頻數最多的是relief 法和DT 法,都為3,relief 法最大精確度為0.991,DT 法最大精確度為0.966,可以看出采用relief 法和DT 法具有很高的精確度上限,被廣泛使用。通過分析,特征個數建議為11~14 個。

表3 改進特征選擇方法列表評分機制Tab.3 List scoring mechanism for improved feature selection methods

在圖8 中,直方圖顯示了各區間的精確度頻數,改進特征選擇方法項目精確度在0.8~1.0 的占91.67%,0.9~1.0 的占41.67%;納入新特征項目精確度在0.8~1.0 的占50%,0.9~1.0 的占比為0;基礎特征項目精確度在0.8~1.0 的占50%,0.9~1.0 的占比為0,說明改進特征選擇算法相比于其他兩類項目具有較高的精確度。精確度等級百分率主要反映了各項目的未來潛質,基礎特征和納入新特征趨勢線較高的地方主要集中在0.75~0.85之間,在0.85 以上逐漸下降,而改進特征選擇方法在0.9 以上仍為上升趨勢,具有較好的未來潛質。

圖8 不同特征選擇方法的精確度對比圖Fig.8 Comparison of accuracy for different feature selection methods

2.4 建模方法

開發模型的目的決定了采用模型的類別,模型類別的選擇在一定程度上也決定了模型的精確度。

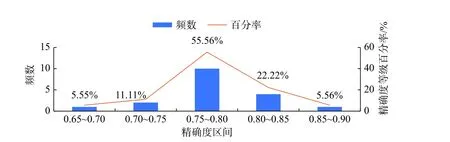

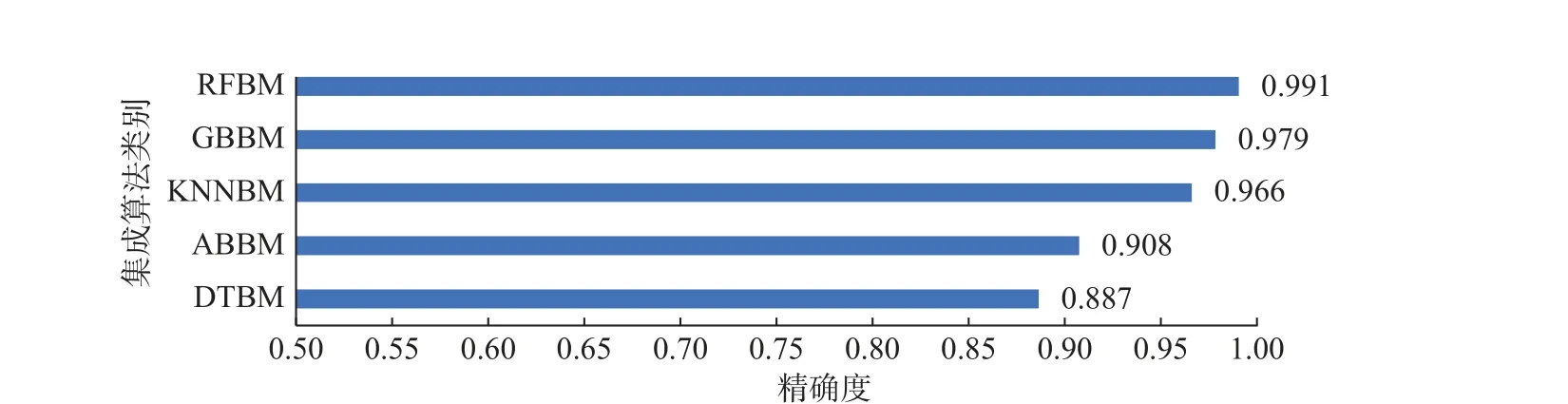

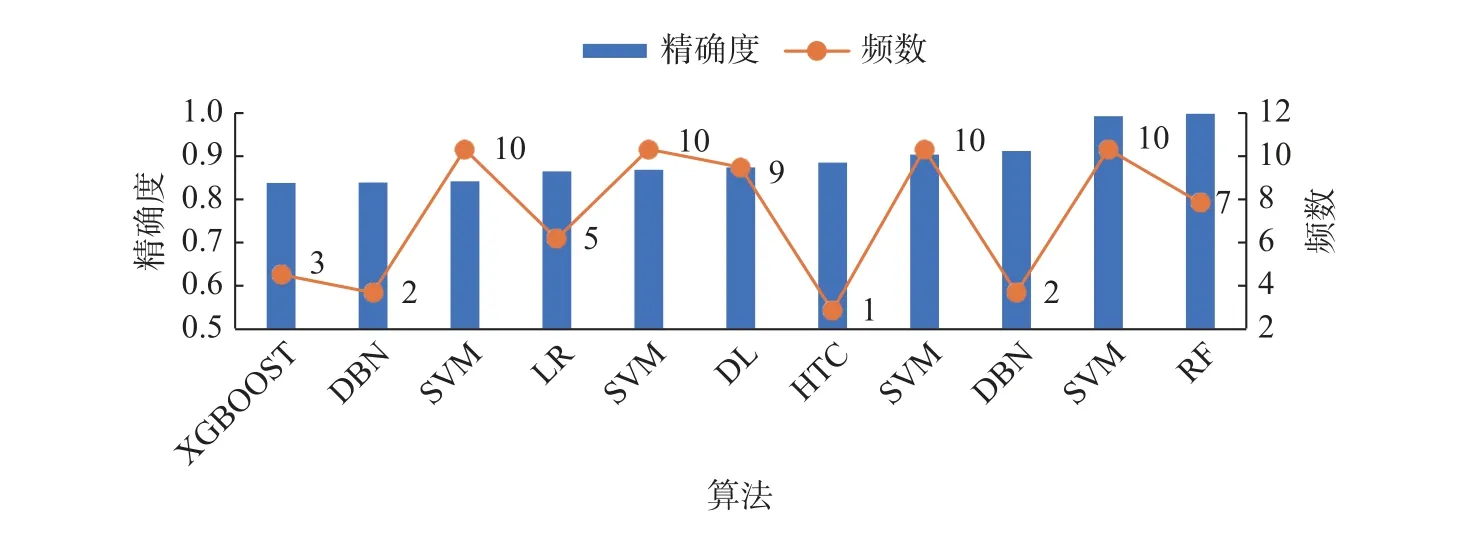

為了獲得精確度更高的建模算法,將n=58 篇文獻根據建模目的分為3 類:回歸分析項目[36,39]n=26、機器學習項目[33,40]n=28、FRS 風險預測項目[19,26]n=4。回歸分析又分為:logistic 邏輯回歸,該類別不分析;Cox 比例回歸,n=17。采用精確度等級百分率的評分形式,如圖9 所示。機器學習項目又分為集成學習、比較多算法、單一算法[27]。集成學習因不同文獻之間具有等量類別的相同集成方法,所以采用精確度平均值,對不同集成方法進行精確度比較,如圖10 所示。圖中:RFBM 表示隨機森林Bagging 法;GBBM 表示梯度法;KNNBM表示k近鄰Bagging 法;ABBM 表示AdaBoost 提升法;DTBM 表示決策樹Bagging法。比較多算法是將每篇文獻中最大精確度對應的算法和在所有文獻中的使用頻數統計出來,如圖11 所示。圖中:XGBOOST 表示XGBoost 提升算法;DBN 表示動態貝葉斯網絡算法;SVM 表示支持向量機算法;LR 表示邏輯回歸算法;DL 表示深度學習算法;HTC 表示混合算法。單一算法采用精確度等級百分率進行統計分析;最后采用列表評分機制,對機器學習的各種方法進行精確度百分率比較,如表4 所示。

表4 不同算法精確度等級百分率Tab.4 Percentage of accuracy grade of different algorithms

圖9 Cox 比例回歸精確度等級直方圖Fig.9 Histogram of accuracy grade for Cox proportional regression

圖10 集成算法分布直方圖Fig.10 Distribution histogram of ensemble algorithm

圖11 比較多算法的最高精確度的頻數分布圖Fig.11 Frequency distribution chart of maximum accuracy of comparative multiple algorithms

從圖9 可以看出,頻數主要分布在精確度0.75~0.80 之間,且頻數百分率在此區間最大,之后迅速下降,說明采用Cox 比例風險模型精確度普遍較低,這是由于Cox 模型的本質和建模的目的導致的。

集成學習指將Bagging 和Boosting 分類器和各種算法組合在一起的不同算法。圖10 展示了不同文獻的不同集成算法的精確度平均值分布,從圖中得到,精確度都超過了0.85,而采用RFBM 算法精確度高達0.991,接近于1,所以采用集成算法可以很大程度上改善精確度。

圖11 是比較多算法類別的直方圖和折線圖,n=11,將每篇文獻精確度最大的算法統計出來繪制了直方圖,其中RF 算法的精確度最高,所以采用RF 算法具有較高的精確度上限。SVM 使用次數最多,為4 次,占所統計的36.36%,說明SVM 算法不僅使模型精確度提高而且是廣為使用的算法。折線圖顯示了統計的精確度最高算法在每篇文獻中的使用頻數,HTC 為1,將其去除,SVM 為10,使用最廣。圖中列出的這些算法在每篇文獻中的使用率達到了75%,甚至100%,除列出的算法外, DT,KNN 也是常用的算法。所以研究者如果采用比較多算法進行建模,建議采用SVM,DBN,LR,DL,RF,DT,KNN 等精確度較高的算法進行比較。

表4 進行了不同算法之間的比較,集成學習類別精確度普遍高于其他兩類,而精確度在0.9~1.0 的百分率更高達80%;其他兩類算法,精確度在0.8~1.0 相差較小,但單一算法精確度在0.9~1.0 之間的百分率為22.22%,高于比較多算法。因此,從以上分析得出,為了使開發的模型具有較高的精確度,建議采用集成學習。

3 結 論

本研究對檢索文獻的各個模塊進行了詳細的審閱和分析,根據探究目的將文獻進行不同歸類,各類別之間文獻有交叉。由于數據的多樣性,對不同模塊采取不同的數據處理方式,為了消除基數差異影響,本研究創立精確度等級百分率數據評分機制,利用精確度平均法消除不同類別的復雜度,采用random 隨機函數保證了獲取數據的隨機性。最后得到了不同模塊對應的建議性改善措施。

在模型中加入新的特征,不僅提高了模型的精確度,更重要是改善了疾病閾值問題,更加細化了高危人群治與不治的難題。利用Cox 比例風險模型,驗證了新特征與CVD 的相關性,可以幫助科研人員探求CVD 分子發病機制和基因的靶向治療。

改進特征選擇項目之所以具有較高的精確度,是因為采用特征選擇算法能夠很好地挖掘樣本中的數據,可以從幾百個特征中篩選出與CVD極度相關的11~14 個特征,保證了模型與數據的相容性和關聯性。而基礎特征項目建模前已經確定了各標簽,用數據向標簽靠攏,發揮不了數據應有的潛力,阻止了數據與模型之間的較好聯系,導致精確度往往偏低。納入新特征項目一般采用Cox 比例風險模型,為了驗證新特征與預測結果的關聯性,精確度在0.8 左右滿足了預測效果。

總的來說,通過對文獻各個模塊進行數據處理、數據挖掘、圖標分析,得到了對模型精確度比較理想的各種改善措施。但是由于時間和人力限制,檢索的文獻相對較少,即使針對某一模塊的文獻數量充足,但是將其進行再分類后,各類別數量變得更少。雖然文獻數量不影響數據分析,但在一定程度上會影響圖形擬合,導致分析結果與事實存在一定誤差。綜合來看,本文得出的各種改善措施,都可以在一定程度上優化模型,減少模型運行量和時間消耗,對未來研究者開發模型具有重大指導性意義。