深度可分離卷積和標準卷積相結合的高效行人檢測器

張運波,易鵬飛,周東生,,張 強,,魏小鵬

深度可分離卷積和標準卷積相結合的高效行人檢測器

張運波1,易鵬飛1,周東生1,2,張 強1,2,魏小鵬2

(1.大連大學軟件工程學院先進設計與智能計算省部共建教育部重點實驗室,遼寧 大連 116622;2.大連理工大學計算機科學與技術學院,遼寧 大連 116024)

行人檢測器對算法的速度和精確度有很高的要求。雖然基于深度卷積神經網絡(DCNN)的行人檢測器具有較高的檢測精度,但是這類檢測器對硬件設備的計算能力要求較高,因此,這類行人檢測器無法很好地部署到諸如移動設備、嵌入式設備和自動駕駛系統等輕量化系統中。基于此,提出了一種更好地平衡速度和精度的輕量級行人檢測器(EPDNet)。首先,主干網絡的淺層卷積使用深度可分離卷積以壓縮模型的參數量,深層卷積使用標準卷積以提取高級語義特征。另外,為了進一步提高模型的性能,主干網絡采用特征融合方法來增強其輸出特征的表達能力。通過實驗對比分析,EPDNet在2個具有挑戰性的行人數據集Caltech和CityPersons上表現出了優越的性能,與基準模型相比,EPDNet在速度和精確度之間獲得了更好的權衡,EPDNet的速度和精確度同時得到了提高。

標準卷積;深度可分離卷積;特征融合;輕量化;行人檢測

行人檢測在諸如自動駕駛、智能監控和機器人等計算機視覺應用中,扮演著舉足輕重的作用。隨著深度學習的興起,盡管近年來的一些行人檢測算法已獲得了顯著成效[1-2],但最先進的行人檢測器仍然達不到人類的認知水平[3],在行人遮擋、模糊、尺度多變等具有挑戰性的情況下,其檢測效果通常會受到嚴重影響。為了解決這些問題,諸多研究學者已經提出了處理特定情況的機制。這些機制包括在檢測之前使用分割[4]和分別為不同的行人遮擋模式設計對應的模型[5-6]等。CAO等[7]提出了位置指導和語義轉換2個模塊,以提取對象更多的上下文信息。但是,上述方法的檢測速度較慢,并且與實時檢測目標相距甚遠。文獻[6]提出的Faster-RCNN+ATT檢測器,利用通道注意力模塊加強算法對遮擋行人的檢測性能,但需要添加額外的模塊才能從數據集中獲取注意力信息,計算復雜度較高。文獻[2]提出了行人檢測和語義分割進行聯合監督的框架——SDS-RCNN,但是僅添加了語義分割分支,并將獲得的語義特征輸入到主干網絡中,而未將語義分割結果直接用于行人檢測。LIU等[8]提出了差分矩陣投影(difference matrix projection,DMP),使用全局矩陣運算計算聚合的多方向像素差異。上述的兩階段行人檢測器主要致力于檢測精度的研究。重要的是,行人檢測對速度的要求也是很高的。與兩階段行人檢測器相比,單階段檢測器具有更高的檢測速度[9-10]。單階段行人檢測器通常使用輕量級的卷積神經網絡(convolutional neural networks,CNN)作為主干網絡,例如MobileNet[11]和YOLOv3[12]。ZHAO等[13]提出了一種行人檢測的新思路,即利用人體姿態估計來提高行人檢測的檢測和定位精度。實際上,缺乏多樣化的行人數據集也限制了行人檢測器的性能,ZHANG等[14]提出了一個具有豐富場景的高分辨率行人數據集,可以在一定程度上提高模型的泛化能力。為了進一步促進未來的行人檢測研究,其團隊發布了一個名為WiderPerson[15]的大規模多樣化數據集,用于野外環境下的密集行人檢測。雖檢測速度快,但是檢測精度不高,無法在速度和精度之間取得更好的折衷。LIU等[16]提出一種無錨點框的行人檢測新方法,即利用行人的關鍵點和尺度獲得回歸框,在速度和精度之間取得了新的權衡。但是,在這項工作中,使用MobileNet作為主干網絡時,行人檢測器的檢測精度較低。

本文針對使用關鍵點與輕量級主干網絡相結合對行人檢測時精度較低的問題,提出了一種基于標準卷積和深度可分離卷積相結合的主干網絡構造方法。其主要思想是在模型的淺層使用深度可分離卷積來壓縮DCNN模型的參數,在模型的深層采用標準卷積以增強特征的語義表達能力。為了進一步提高輕量級行人檢測器(effective pedestrian detector network,EPDNet)的檢測精度,本文采用特征融合方法將淺層和深層特征融合在一起,以增強輸出特征的語義表達能力。另外,基于所設計的主干網絡,在Caltech[17]和CityPersons[14]2個行人數據集上評估了EPDNet的性能。評估過程主要包括消融實驗和基準模型比較實驗。與基準模型相比,EPDNet在保持更快的檢測速度同時,在Caltech和CityPersons數據集上均實現了更高的檢測精度。

1 相關工作

1.1 有錨點框檢測

目前,大多數高性能行人檢測器主要由主干網絡和特定的檢測頭組成。早期的目標檢測算法主要使用CNN作為主干網絡,例如VGG[18]和ResNet[19]。Faster R-CNN[20]是兩階段目標檢測框架,該算法的主干網絡使用ResNet50。RPN+BF[21]采用了區域建議網絡——RPN,并通過人工對這些建議框進行了重新評分,研究團隊對Faster R-CNN在行人檢測中的效果做出了相應的研究和改進。TESEMA等[22]提出了一種新的行人檢測框架,成功地擴展了RPN + BF框架,將手動提取的特征和CNN提取的特征相結合。文獻[21]工作成為了兩階段行人檢測器的先例。例如,在LI等[23]的工作中,基于CNN的兩階段框架在小尺度行人檢測方面取得了重大進展;在MS-CNN[24]中也應用了Faster R-CNN框架,但是該算法是在多尺度特征圖上生成候選建議框;Faster RCNN+ATT[6]的作者建議采用通道注意力模塊來處理行人檢測的遮擋問題;上述方法在基于CNN的有錨點框行人檢測方向獲得了重要進展,充分證明了CNN在兩階段行人檢測器中的有效性和可行性。

1.2 無錨點框檢測

與有錨點框目標檢測器的設計思路相反,近年來流行采用無錨點框進行目標檢測,該方法摒棄了候選建議框的生成過程,直接從圖像中檢測目標。CornerNet[25]是將無錨點框檢測思想推向高潮的杰作,其摒棄了傳統的目標檢測思想,直接從圖像中檢測出目標的左上角和右下角關鍵點,根據這一對關鍵點確定目標框。受無錨點檢測思想的啟發,SONG等[26]將此思想引入了行人檢測之中,提出的拓撲線性定位(topological line localization,TLL)算法大幅提高了行人檢測的性能,尤其是在小尺度行人檢測方面的成效尤為突出。此后,文獻[16]提出通過直接檢測行人的中心點和尺度來對圖像中的特征進行分類和回歸。該方法將行人檢測轉換為分類和回歸2類問題,并在Caltech數據集上獲得了先進的檢測性能,為行人檢測提供了新思路。為了設計更為輕量的行人檢測器,文獻[16]還使用MobileNet[11]作為主干網絡,并設計了一種檢測速度更快的行人檢測模型。

本文工作主要是基于無錨點框的行人檢測,但與上述所有方法均有顯著差異。本文嘗試通過設計高效、輕量的主干網絡來壓縮行人檢測器的參數,以獲得更快、更準確的行人檢測器。EPDNet提供了一種基于標準卷積和深度可分離卷積構建主干網絡和特征融合方法。

2 方 法

2.1 整體框架

EPDNet的總體框架如圖1所示,總體架構主要由主干網絡和檢測頭模塊組成。

2.1.1 主干網絡

主干網絡主要負責圖像特征提取,是深度可分離卷積塊和深度殘差塊的組合。該設計將整個主干網絡分為6個階段進行描述。首先,將原始圖像輸入到步長為2的卷積塊中,對原始圖像進行下采樣,濾波器數量為32,將3通道的RGB圖像提取成具有32通道的特征圖。為了減少模型的計算量,第2到第4階段采用深度可分離卷積的卷積方法,這是整個檢測器模型輕量化的關鍵。為了提取圖像的高級語義信息并提高模型的可訓練性,該網絡結合了深度殘差網絡的優點和原理,在第5和第6階段使用殘差塊,以提高分類精度。從第1階段到第6階段,下采樣率分別為2,4,8,16,16和16。在加深模型深度的同時,考慮到分辨率對行人目標定位的重要性,最終輸出特征圖的分辨率為原始特征圖的1/16。

2.1.2 檢測頭

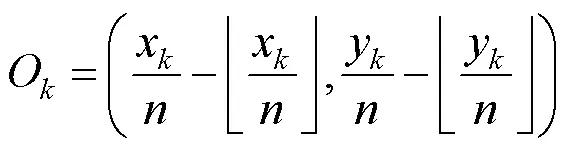

檢測頭模塊負責目標檢測中特征的分類和回歸,在檢測任務中起著重要的作用[27]。首先,將主干網絡提取的特征圖輸入到一個濾波器個數為256的卷積層,將特征圖的特征維度壓縮為256,然后將壓縮后的特征圖輸入到3個卷積層預測分支中,分別生成中心點特征圖、尺度圖和中心點偏置。特征圖的下采樣過程將引起關鍵點偏移的問題,不利于行人的定位。增加偏移量的預測分支可以微調下采樣過程中的中心位置預測精度的損失,中心點的偏移量預測可以定義為

2.2 整體架構

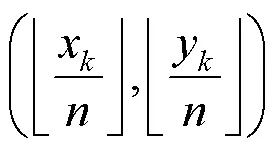

表1給出了EPDNet的詳細信息,包括卷積塊的類型(Type)、步長(Stride)、濾波器個數(Filter Shape)和輸入圖像大小(Input size)。例如,Conv/s2表示標準卷積塊,卷積核移動步長為2。深度可分離卷積是將標準卷積分解為深度卷積(Conv dw/s1)和點卷積(Conv/s1)。Conv_block Res/s1表示步長為1的卷積塊,Identity_block Res/s1表示恒等塊。

表1 EPDNet主干的架構

3 實 驗

3.1 實驗設置

3.1.1 數據集

CityPersons數據集源自Cityscapes[28],具有多個遮擋級別的行人注釋。本文實驗使用2 975張圖像的訓練集和500張圖像的測試集。評估指標遵循Caltech中的評估標準[17],即在[10-2, 100]范圍內,每幅圖像平均誤報率的對數值(false positive per image,FPPI)表示為-2,數值越小表示性能越好。

3.1.2 訓練參數

本文實驗在Keras框架中實現的。訓練和測試在單個GTX 1080Ti GPU顯卡上進行。主干網絡使用基于深度可分離卷積和深度殘差網絡設計。當使用Caltech數據集訓練模型時,批量設置為16,學習率為10-4。訓練過程中加載MobileNet的預訓練權重[11],網絡訓練在200代后停止。Caltech數據集上的訓練模型還包括從CityPersons數據集初始化的模型。此外,當使用CityPersons數據集訓練模型時,批量大小(batch_size)設置為3,學習率為2×10-4,在訓練過程中加載MobileNet的預訓練權重,并且訓練150代后停止訓練。

3.2 消融實驗

消融實驗在Caltech數據集上進行,并將閾值設置為官方標準,即IoU=0.5。本文從4個方面展開實驗和討論:①結合深度可分離卷積和標準卷積的重要性;②可分離卷積輸出特征與殘差塊輸出特征融合的重要性;③模型的卷積層數和特征尺度對模型性能的影響;④深度卷積層使用空洞卷積的對模型性能的影響。

3.2.1 結合深度可分離卷積和標準卷積的重要性

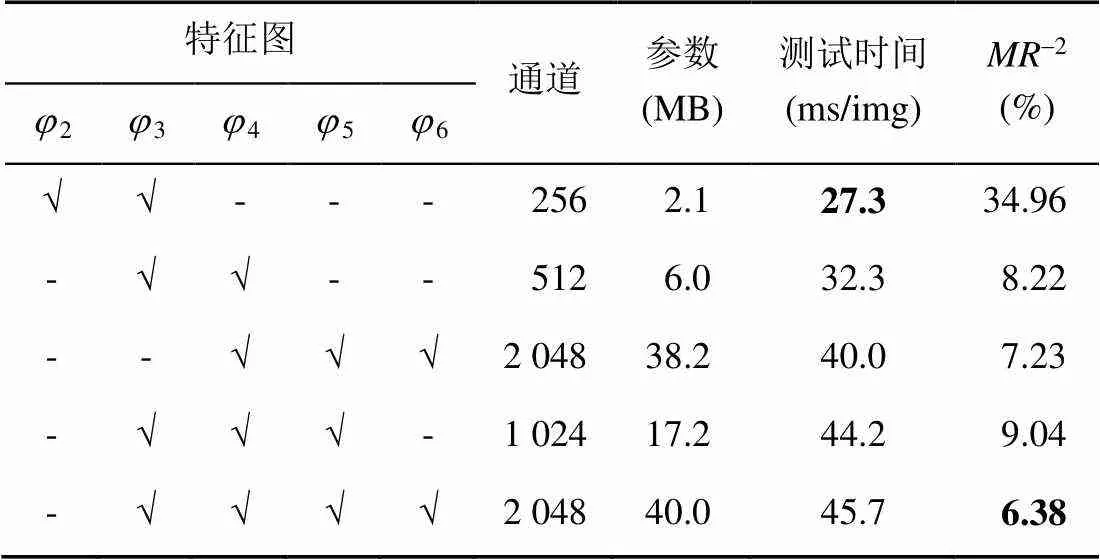

本文提出的主干網絡分為深度可分離卷積和標準卷積2部分。深度可分離卷積可以成倍地壓縮模型參數,殘差網絡可以增加模型的可訓練性。通過增加模型的深度,可以提取圖像的高級語義特征。結合兩者的優勢,構建了輕量級的主干網絡,并且進一步設計的行人檢測器可以提高速度和精度。這組實驗證明了深度可分離卷積和標準卷積相結合的模型壓縮方法的有效性。實驗結果見表2。

表2 不同檢測器的比較

注:加粗數據為最優值

表2展示了不同檢測器之間的性能對比結果。CSP[16]使用MobileNet作為主干網絡的模型。EPDNet是本文設計的行人檢測器模型,其融合了第3到第6階段的輸出特征圖。EPDNet3使用殘差塊將輸出特征圖擴展到1 024維,并融合了第3到第5階段的輸出特征圖,融合后的特征圖作為主干網的最終輸出。通過與CSP比較,可以發現EPDNet3模型的檢測速度提高了約16%,而檢測精度僅僅下降了1.8%,由此可知,在確保檢測精度的同時,EPDNet3在檢測速度上有了顯著提高。

3.2.2 特征融合的重要性

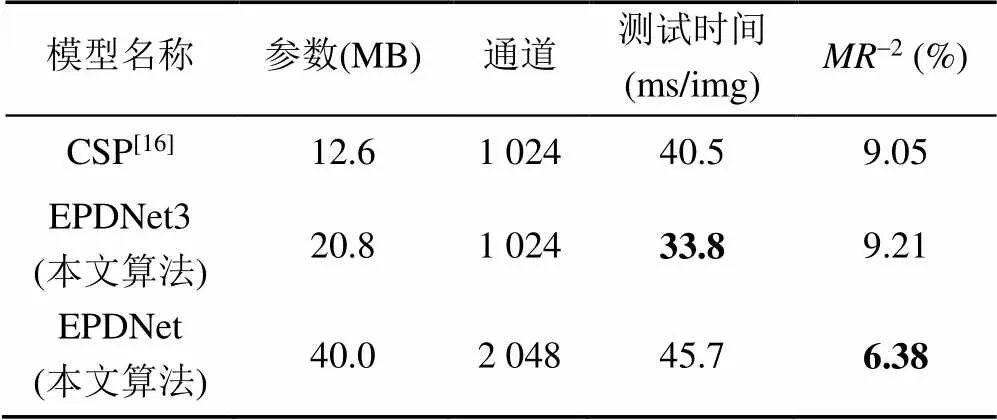

為了分析EPDNet融合的有效,及證明融合高級與低級特征圖的重要性,本文做了對比實驗,整個實驗集均在Caltech數據集上進行,并且將閾值設置為官方標準IoU=0.5。實驗結果見表3,其中2~6分別表示第2到第6階段的輸出特征圖。

表3 融合不同特征圖的模型對比

注:加粗數據為最優值

由表3可看出,融合不同階段輸出特征圖的模型在檢測時間和準確性上存在很大差異。融合了3,4,5和6階段的特征圖的模型具有6.38-2。此模型具有最佳的檢測精度。盡管該模型在檢測速度上沒有優勢,但仍然可以達到約22 FPS。此外,融合了2和3階段特征圖的模型具有最快的檢測速度(約40 FPS)和最小的參數,但是該模型的檢測精度非常低。因此可以看出,淺層模型具有較高的檢測速度,但代價是檢測精度的損失,這種模型不適合處理背景復雜的高分辨率圖像,也不適合處理復雜的檢測任務。

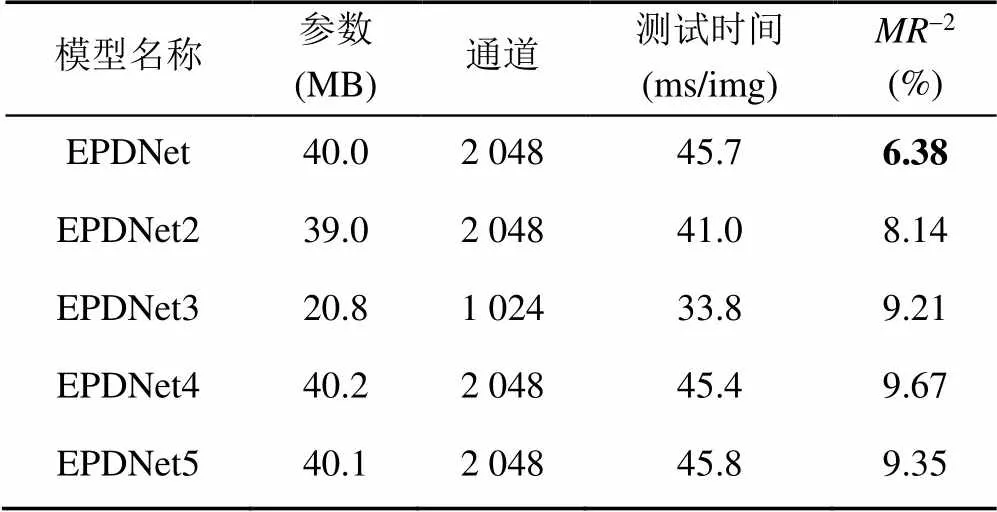

3.2.3 卷積層數和特征圖維度的影響

在圖1所示的主干網絡中,除下采樣層外,第4階段的可分離卷積塊數為4,5和6。另外,卷積層數和輸出特征圖維度也對模型的性能有很大影響。為了討論第4階段中卷積層數對模型性能的影響,本文通過對比實驗展示不同模型的性能,包括模型參數量、測試時間和損失率的比較。整個實驗是在IoU=0.5的條件下進行。實驗結果見表4。

表4 不同卷積層數的模型性能對比

注:加粗數據為最優值

由表4數據可知,對于輸出特征圖維度相同的可分離卷積層,卷積層數較多的模型具有更好的檢測精度,但是該類模型在檢測時間上略高于卷積層數少的模型。其中,在EPDNet的第4階段中設6個深度可分離的卷積塊,主干網通道維數為2 048。EPDNet2在EPDNet的基礎上將4階段的卷積塊數減少到3個,EPDNet4在EPDNet的基礎上將第4階段的卷積塊數減少到4個,EPDNet5在第4階段的基礎上將卷積塊的數量減少到5個。EPDNet3是在EPDNet的基礎上將主干網絡的特征輸出維度減少到1 024。實驗結果表明,無論是減少標準卷積的層數還是可分離卷積的層數,淺層網絡都會導致模型檢測的準確性下降。但是,與EPDNet相比,簡化后的模型提高了檢測速度,EPDNet2將模型的檢測速度提高了約10%,但損失了約28%的精度。EPDNet3將模型速度提高約26%,但損失了約44%的精度。與EPDNet,EPDNet3,EPDNet4和EPDNet5相比,EPDNet具有最佳性能。因此,可以看出,過度壓縮模型參數以提高算法的效率是不可取的。只有合適的卷積層數和特征圖維度才能達到最優的性能。

3.2.4 空洞卷積對模型性能的影響

擴大卷積核的感受野對檢測任務是有幫助的。但是,通過增加卷積層數來增加感受野的做法,不可避免地會增加模型的參數量,導致模型的計算效率下降。另外一種擴大感受野的方法是使用空洞卷積,該方法不會增加參數量。本組實驗比較了使用空洞卷積與否的模型的性能,對比結果包括模型參數、測試時間和丟失率。整個實驗均在IoU=0.5的條件下進行,實驗結果見表5。

注:加粗數據為最優值

由表5可知,在第5和第6階段中的卷積層使用空洞卷積。從實驗結果可以看出,在其他條件不變的情況下,不使用空洞卷積模型的精度會大大降低。由于感受野變小,計算量增大,因此模型測試時間也稍微變長。從本組實驗可以看出,在必要的卷積層中引入空洞卷積可以有效提高模型精度。

3.3 基線模型對比試驗

本文將在Caltech和CityPersons數據集上,對比EPDNet模型與其他行人檢測器模型之間的性能。在本文實驗中,EPDNet和EPDNet+City分別表示初始化權重來自ImageNet[29]和CityPersons數據集上訓練的模型。

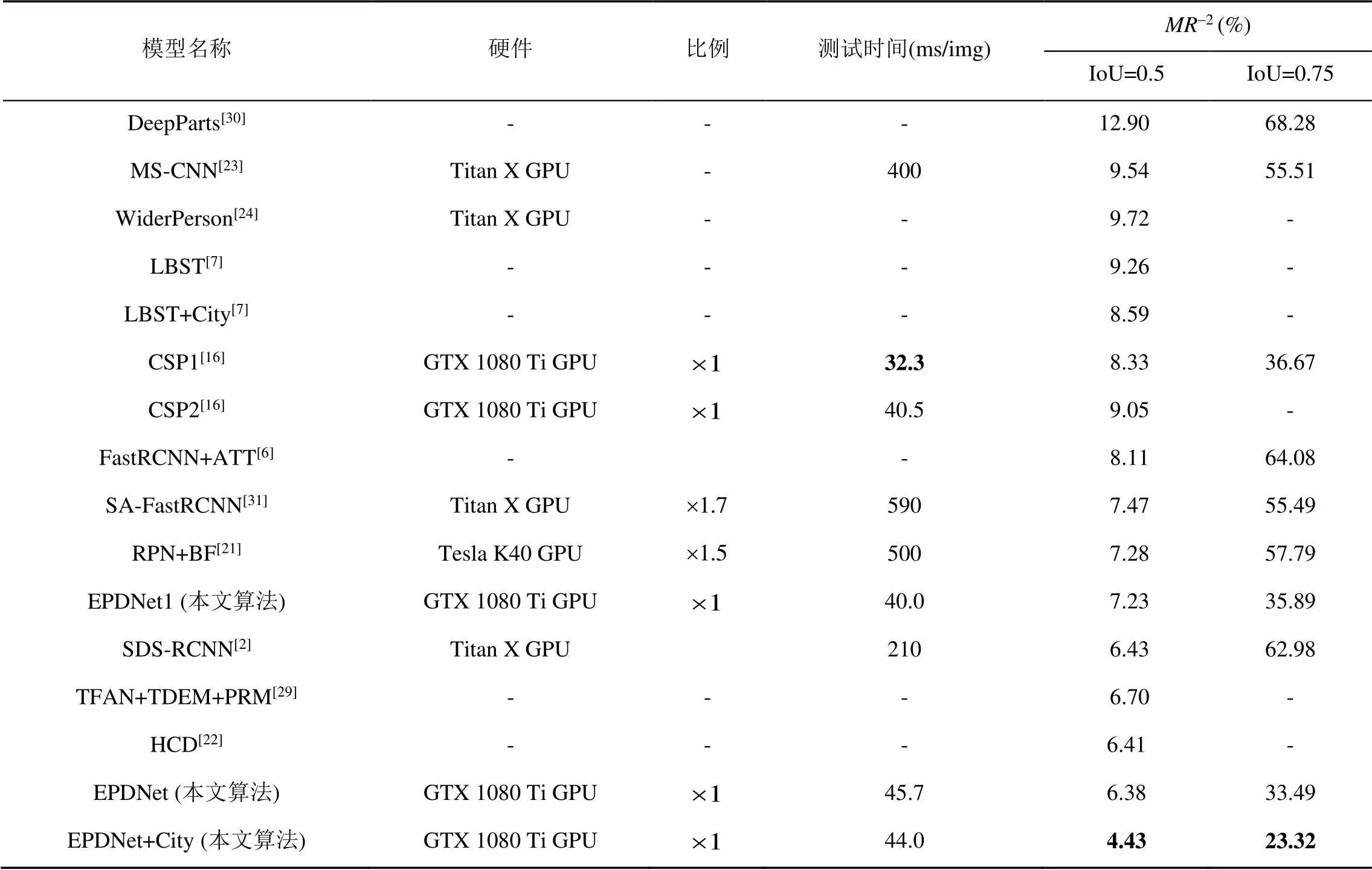

3.3.1 Caltech數據集上對比結果

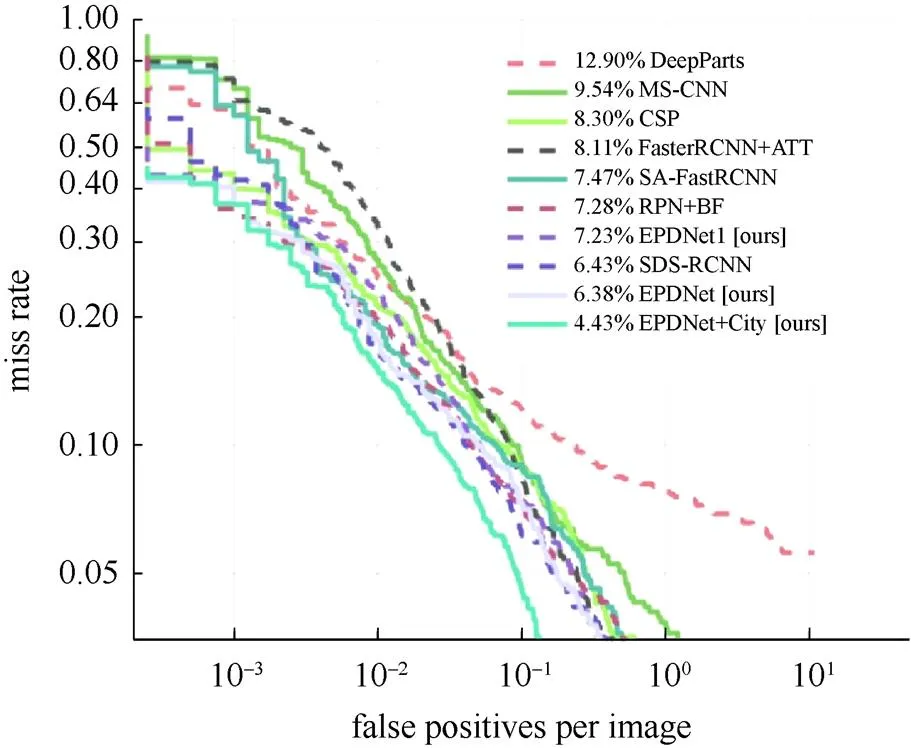

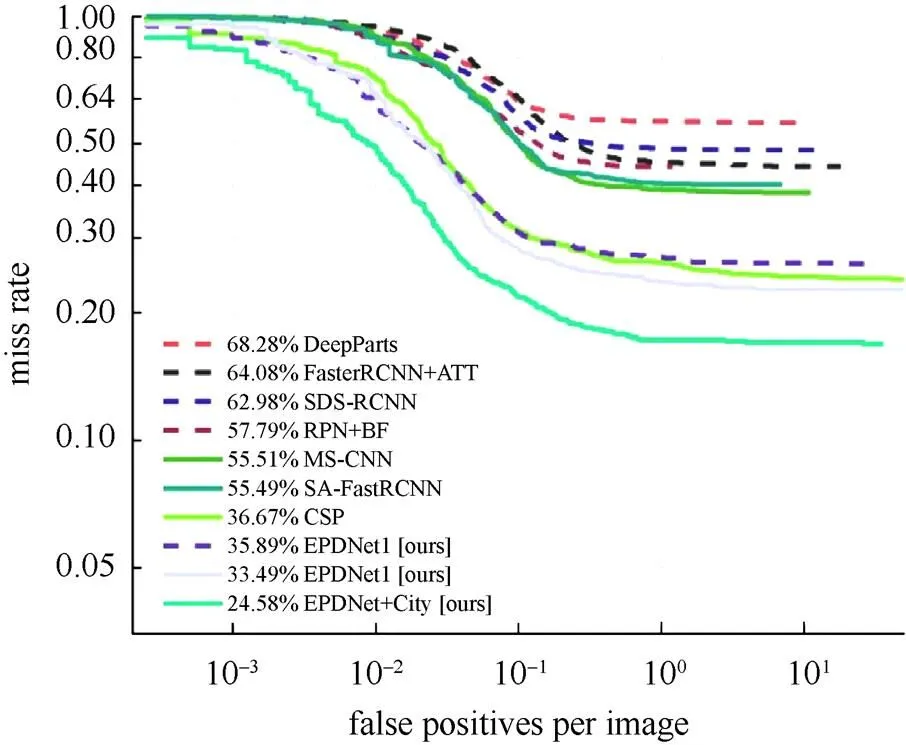

本組實驗對比了基線模型的性能參數,在幾個檢測精度相當的行人檢測器模型中,對比模型的檢測速度。本文方法與幾種基準模型進行對比,包括DeepParts[30],MS-CNN[24],FasterRCN+ATT[6],SA-FasterRCNN[31],RPN+BF[21],SDS-RCNN[2],EPDNet1 (本文算法),EPDNet (本文算法),EPDNet+City (本文算法)和CSP[16]。分別在IoU=0.5和IoU=0.75時進行了比較,FPPI曲線分別如圖2和圖3所示。

圖2 IoU=0.5時,Caltech數據集上的比較

圖2顯示了當IoU=0.5時各個模型的FPPI曲線。從圖中可以看出,EPDNet模型在基準模型中具有更好的準確性。從檢測精度比較可見,EPDNet1和RPN + BF的檢測結果相當。與CSP相比,EPDNet的檢測精度提高了2個百分點;與DeepParts相比,EPDNet的檢測精度提高了6.52個百分點,性能提高了約50%。如圖3所示,當IoU=0.75時,EPDNet顯示的檢測結果也明顯要好于基準模型。

圖3 IoU=0.75時,Caltech的數據集上的比較

為了更詳細地對比模型的運行速度,在表6中報告了包括模型訓練和測試的硬件設備、測試時間和丟失率。對比分析發現,CSP1達到了最好的檢測速度,但是其丟失率為8.33%,排名比較靠后。與CSP2相比,EPDNet1在速度和精度上均占有優勢,在檢測精度上提高了20個百分點。EPDNet也在保持檢測速度的同時,達到了新的精度。使用CityPersons數據集訓練的模型EPDNet+ City在2個閾值下均達到了最好的檢測結果,分別為4.43%和23.32%,性能均較之前模型有大幅度地提升。綜合來看,EPDNet在各個方面的性能均超過了其他的兩階段檢測器。通過對比實驗,使用可分離卷積和標準卷積相結合的思想,能夠更好地對模型進行優化,是目前平衡速度與精度的一種有效方法。

表6 Caltech數據集上檢測器性能對比

注:加粗數據為最優值

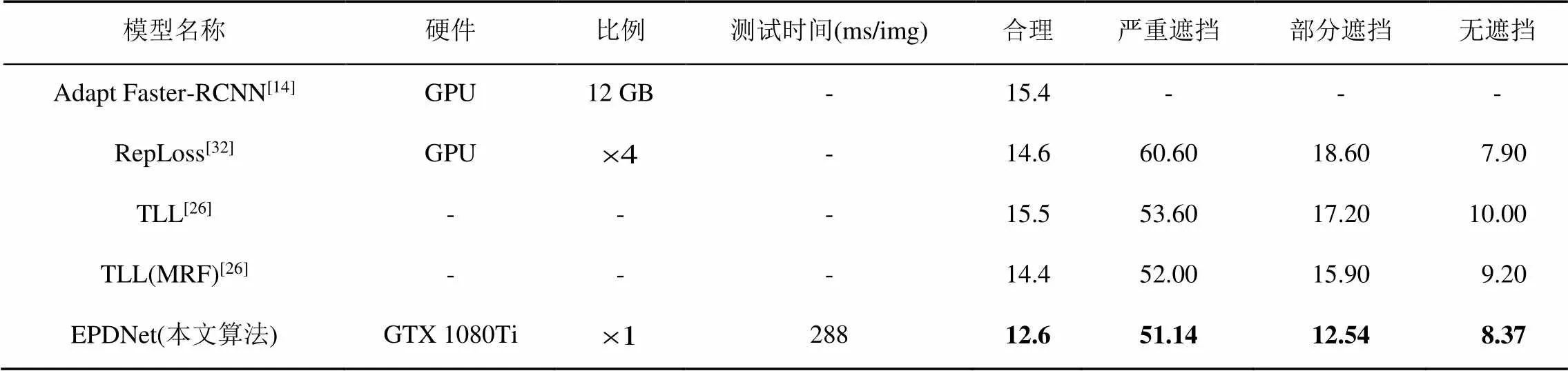

3.3.2 CityPersons數據集上對比結果

本文實驗展示了EPDNet和基準模型在CityPersons數據集上的性能對比結果。對于CityPersons數據集的訓練,本文實驗采用單張GTX 1080Ti型號的GPU進行,批量設置為3。表7數據顯示EPDNet在CityPersons的數據集上,獲得了12.6%的檢測丟失率和288 ms/img的檢測速度,在大分辨率圖片的檢測速度中具有突出的優勢。在部分遮擋子集上,EPDNet相比基線模型在精度方面提高的更多,相比于TLL(MRF)模型提高超過3個百分點。特別是在無遮擋子集上,EPDNet達到了8.37%的-2。從嚴重遮擋子集上的檢測結果看,EPDNet在高遮擋的數據集上的性能仍然有待提高。受限于現階段計算機硬件設備的性能,對于大分辨率圖像的處理只能設置較小的批量。以計算機硬件的發展趨勢看,未來硬件設備能夠滿足大分辨率圖像的處理需求,設置更大的批量,可以進一步提高模型的精度。

表7 CityPersons數據集上檢測器性能對比

注:加粗數據為最優值

4 結論及展望

本文通過對行人檢測實時性能的研究,提出了一種深度可分卷積和標準卷積相結合的方法,并設計了深度卷積神經網絡模型作為主干網絡來提取圖像特征,然后結合無錨點框的檢測思想,將主干網絡提取的特征圖直接輸入到檢測頭中,直接對特征進行分類和回歸。此外,為了增強特征圖的表達能力,本文通過特征融合方法,將2種卷積方式提取的特征圖進行了融合,以進一步提高模型的性能。實驗結果表明,結合標準卷積和深度可分離卷積可有效提高模型的性能;不同階段的特征圖融合可以進一步提高網絡性能。

在未來的工作中,將致力于進一步研究輕量化模型的構建方法,獲取更為高效的行人檢測器模型,在檢測精度和檢測速度方面達到新的權衡。

[1] 陳寧, 李夢璐, 袁皓, 等. 遮擋情形下的行人檢測方法綜述[J]. 計算機工程與應用, 2020, 56(16): 13-20.

CHEN N, LI M L, YUAN H, et al. Review of pedestrian detection with occlusion[J]. Computer Engineering and Applications, 2020, 56(16): 13-20 (in Chinese).

[2] BRAZIL G, YIN X, LIU X M. Illuminating pedestrians via simultaneous detection and segmentation[C]//2017 IEEE International Conference on Computer Vision. New York: IEEE Press, 2017: 4960-4969.

[3] ZHANG S S, BENENSON R, OMRAN M, et al. How far are we from solving pedestrian detection?[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2016: 1259-1267.

[4] HARIHARAN B, ARBELAEZ P, GIRSHICK R, et al. Simultaneous Detection and Segmentation[C]//European Conference on Computer Vision. Heidelberg: Springer, 2014: 297-312.

[5] PANG Y W, XIE J, KHAN M H, et al. Mask-guided attention network for occluded pedestrian detection[C]//2019 IEEE/CVF International Conference on Computer Vision. New York: IEEE Press, 2019: 4966-4974.

[6] ZHANG S S, YANG J, SCHIELE B. Occluded pedestrian detection through guided attention in CNNs[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2018: 6995-7003.

[7] CAO J L, PANG Y W, HAN J G, et al. Taking a look at small-scale pedestrians and occluded pedestrians[J]. IEEE Transactions on Image Processing, 2020, 29: 3143-3152.

[8] LIU X, TOH K A, ALLEBACH J P. Pedestrian detection using pixel difference matrix projection[J]. IEEE Transactions on Intelligent Transportation Systems, 2020, 21(4): 1441-1454.

[9] ZHANG W J, TIAN L H, LI C, et al. A SSD-based crowded pedestrian detection method[C]//2018 International Conference on Control, Automation and Information Sciences. New York: IEEE Press, 2018: 222-226.

[10] LAN W B, DANG J W, WANG Y P, et al. Pedestrian detection based on YOLO network model[C]//2018 IEEE International Conference on Mechatronics and Automation. New York: IEEE Press, 2018: 1547-1551.

[11] HOWARD A G, ZHU M, CHEN B, et al. MobileNets: efficient convolutional neural networks for mobile vision applications[EB/OL]. [2017-04-17]. https://arxiv.org/abs/1704. 04861.

[12] REDMON J, FARHADI A. YOLOv3: an incremental improvement [EB/OL]. [2018-04-08]. https://arxiv.org/abs/ 1804.02767.

[13] ZHAO Y, YUAN Z J, CHEN B D. Accurate pedestrian detection by human pose regression[J]. IEEE Transactions on Image Processing, 2020, 29: 1591-1605.

[14] ZHANG S S, BENENSON R, SCHIELE B. CityPersons: a diverse dataset for pedestrian detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2017: 4457-4465.

[15] ZHANG S F, XIE Y L, WAN J, et al. WiderPerson: a diverse dataset for dense pedestrian detection in the wild[J]. IEEE Transactions on Multimedia, 2020, 22(2): 380-393.

[16] LIU W, LIAO S C, REN W Q, et al. High-level semantic feature detection: a new perspective for pedestrian detection[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2019: 5182-5191.

[17] DOLLAR P, WOJEK C, SCHIELE B, et al. Pedestrian detection: an evaluation of the state of the art[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(4): 743-761.

[18] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. [2014-09-04]. https://arxiv.org/abs/1409.1556.

[19] HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2016: 770-778.

[20] REN S Q, HE K M, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[21] ZHANG L L, LIN L, LIANG X D, et al. Is faster R-CNN doing well for pedestrian detection?[M]//Computer Vision – ECCV 2016. Cham: Springer International Publishing, 2016: 443-457.

[22] TESEMA F B, WU H, CHEN M J, et al. Hybrid channel based pedestrian detection[J]. Neurocomputing, 2020, 389: 1-8.

[23] LI J N, LIANG X D, SHEN S M, et al. Scale-aware fast R-CNN for pedestrian detection[J]. IEEE Transactions on Multimedia, 2018, 20(4): 985-996.

[24] CAI Z W, FAN Q F, FERIS R S, et al. A unified multi-scale deep convolutional neural network for fast object detection[C]// European Conference on Computer Vision. Heidelberg: Springer, 2016: 354-370.

[25] LAW H, DENG J. CornerNet: detecting objects as paired keypoints[J]. International Journal of Computer Vision, 2020, 128(3): 642-656.

[26] SONG T, SUN L Y, XIE D, et al. Small-scale pedestrian detection based on topological line localization and temporal feature aggregation[M]//Computer Vision – ECCV 2018. Cham: Springer International Publishing, 2018: 554-569.

[27] LIU S T, HUANG D, WANG Y H. Receptive field block net for accurate and fast object detection[C]//European Conference on Computer Vision. Heidelberg: Springer, 2018: 404-419.

[28] CORDTS M, OMRAN M, RAMOS S, et al. The cityscapes dataset for semantic urban scene understanding[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2016: 3213-3223.

[29] DENG J, DONG W, SOCHER R, et al. ImageNet: a large-scale hierarchical image database[C]//2009 IEEE Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2009: 248-255.

[30] TIAN Y L, LUO P, WANG X G, et al. Deep learning strong parts for pedestrian detection[C]//2015 IEEE International Conference on Computer Vision. New York: IEEE Press, 2015: 1904-1912.

[31] LI J N, LIANG X D, SHEN S M, et al. Scale-aware fast R-CNN for pedestrian detection[J]. IEEE Transactions on Multimedia, 2018, 20(4): 985-996.

[32] WANG X L, XIAO T T, JIANG Y N, et al. Repulsion loss: detecting pedestrians in a crowd[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2018: 7774-7783.

Efficient pedestrian detector combining depthwise separable convolution and standard convolution

ZHANG Yun-bo1, YI Peng-fei1, ZHOU Dong-sheng1,2, ZHANG Qiang1,2, WEI Xiao-peng2

(1. Key Laboratory of Advanced Design and Intelligent Computing (Dalian University), Ministry of Education, Dalian Liaoning, 116622, China; 2. School of Computer Science and Technology, Dalian University of Technology, Dalian Liaoning, 116024, China)

Pedestrian detectors require the algorithm to be fast and accurate. Although pedestrian detectors based on deep convolutional neural networks (DCNN) have high detection accuracy, such detectors require higher capacity of calculation. Therefore, such pedestrian detectors cannot be deployed well on lightweight systems, such as mobile devices, embedded devices, and autonomous driving systems. Considering these problems, a lightweight and effective pedestrian detector (EPDNet) was proposed, which can better balance speed and accuracy. First, the shallow convolution layers of the backbone network employed depthwise separable convolution to compress the parameters of model, and the deeper convolution layers utilized standard convolution to extract high-level semantic features. In addition, in order to further improve the performance of the model, the backbone network adopted a feature fusion method to enhance the expression ability of its output features. Through comparative experiments, EPDNet has shown superior performance on two challenging pedestrian datasets, Caltech and CityPersons. Compared with the benchmark model, EPDNet has obtained a better trade-off between speed and accuracy, improving the speed and accuracy of EPDNet at the same time.

standardconvolution; depthwise separable convolution; feature fusion; lightweight; pedestrian detection

TP 391

10.11996/JG.j.2095-302X.2022020230

A

2095-302X(2022)02-0230-09

2021-07-21;

2021-10-21

國家自然科學基金重點項目(U1908214);遼寧特聘教授資助計劃;遼寧省中央指導地方科技發展專項(2021JH6/10500140);遼寧省高等學校、大連市及大連大學創新團隊資助計劃;大連市雙重項目(2020JJ25CY001)

張運波(1993–),男,碩士研究生。主要研究方向為數字圖像處理與模式識別。E-mail:zhangyunbo1993@163.com

周東生(1978–),男,教授,博士。主要研究方向為計算機圖形學、人機交互、人工智能和機器人等。E-mail:zhouds@dlu.edu.cn

21 July,2021;

21 October,2021

Key Program of Natural Science Foundation of China (U1908214); Program for the Liaoning Distinguished Professor; Special Project of Central Government Guiding Local Science and Technology Development (2021JH6/10500140); Program for Innovative Research Team in University of Liaoning Province; Dalian and Dalian University, and in Part by the Science and Technology Innovation Fund of Dalian (2020JJ25CY001)

ZHANG Yun-bo (1993–), master student. His main research interests cover digital image processing and pattern recognition. E-mail:zhangyunbo1993@163.com

ZHOU Dong-sheng (1978–), professor, Ph.D. His main research interests cover computer graphics, HRI, AI and robotics, etc. E-mail:zhouds@dlu.edu.cn