多尺度特征增強的SSD目標檢測算法

高娜, 吳清 張滿囤

摘要 針對目標檢測中多類別、多尺度和背景復雜而導致的SSD(Single Shot Multibox Detector)算法檢測精度不高的問題,提出了一種多尺度特征增強的改進SSD目標檢測算法。首先將SSD網絡模型的高層特征依次向下與淺層特征融合,構造一種多尺度目標檢測結構。然后利用注意力機制對特征進行進一步的優化,從而達到增強網絡模型特征提取的目的。最后用DIoU-NMS來處理圖像目標中冗余框的問題,減少目標的漏檢。在公開的NWPU VHR-10遙感數據集上將該方法與其他算法進行對比實驗,其mAP較傳統的SSD算法提高了6.7%。最后將改進后的算法應用于地鐵安檢圖片檢測,并在此數據集上進行消融實驗來驗證此算法每一階段的有效性。

關 鍵 詞 目標檢測;多尺度;特征融合;注意力機制;特征增強

中圖分類號 TP391.41? ? ?文獻標志碼 A

Multi-scale feature enhancement based SSD algorithm

GAO Na, WU Qing, ZHANG Mandun

Abstract Aiming at the low detection accuracy of the SSD (Single Shot Multibox Detector) algorithm caused by the multi-category, multi-scale, and complex background in object detection, an improved SSD object detection algorithm with multi-scale feature enhancement is proposed. First, the high-level features of the SSD network model are sequentially merged with the shallow features to construct a multi-scale object detection structure. Then the attention mechanism is used to further optimize the features, so as to enhance the feature extraction of the network model. Finally, DIoU-NMS is used to deal with the problem of redundant boxes in the image object and reduce the missed detection of the object. In the public NWPU VHR-10 remote sensing data set, the method is compared with other algorithms, and its mAP is improved by 6.7% compared with the traditional SSD algorithm. Finally, the improved algorithm is applied to the subway security inspection image detection, and an ablation experiment is performed on this data set to verify the effectiveness of each stage of the improved algorithm.

Key words object detection; multiscale; feature fusion; attention mechanism; feature enhancement

引言

隨著深度學習在圖像目標檢測中的廣泛應用,如何更有效地解決背景復雜度高、目標方向不確定、目標尺度多變、小目標居多且密集出現等情況下的檢測精度和效率低的問題,成為一個極具挑戰性的課題[1-2]。

基于深度學習的目標檢測方法主要分為2類,一類是基于候選區域的深度學習目標檢測算法(two-stage),典型的算法有Faster RCNN[3]、FPN[4]、Cascade R-CNN[5]、TridentNet[6]等。這類檢測算法的精度較高,但是檢測流程均包含多個階段,實現過程復雜。另一類是基于端到端的深度學習目標檢測算法(one-stage),與 two-stage類方法相比結構更簡單,它將所有計算封裝在一個網絡中,可以實現端到端的優化。One-stage網絡的典型的代表算法有SSD[7]、YOLO系列[8]、CornerNet[9]、CenterNet[10]、EfficentDet[11]等。

SSD算法是一種直接預測目標類別和邊界框的多目標檢測算法,它充分利用了多卷積層的優勢來對目標進行檢測,對目標的尺度變化具有較好的魯棒性。主要是利用Conv4_3、Conv7、Conv8_2、Conv9_2、Conv10_2、Conv11_2這6個不同尺度的特征層做檢測,將不同特征層得到的結果送入檢測器,最后利用非極大值抑制方法(Non-Maximum Suppression,NMS)剔除圖像中的冗余框。SSD中的6個特征層互相都是獨立使用的,忽略了不同特征層之間的聯系,并且沒有用到足夠低層的特征,導致SSD對小尺寸目標的識別比較差。為提高小目標的檢測精度,DSSD[12]使用更加復雜的ResNet-101替換VGG16來增強網絡的特征提取能力,但復雜的網絡結構增加了參數量和計算量,導致檢測的實時性較差。為了改善小目標檢測效果和提升框架對多尺度目標的檢測能力,出現了融合多層特征的思想。Feature Pyramid Network(FPN)和Top Down Modulation (TDM)[13]以自頂向下的方式融合不同的特征層,將語義信息從高層融合到低特征層,對小物體的識別起到了很大的幫助,說明了高層語義的細節特征提取的重要性。RSSD[14]采用rainbow連接的方式,結合pooling和反卷積來融合不同的特征層,在一定程度上解決了小目標的檢測問題。FSSD[15]將不同尺度的特征層融合在一起,通過下采樣子模塊生成新的特征金字塔層用于目標檢測,提高了SSD的精度。因此如何將低層和高層的特征層結合起來構造金字塔結構對目標檢測性能有很大影響。另一方面,背景復雜及目標尺度小的問題,增加了獲取需要重點關注的目標區域的難度。注意力機制源自于人類視覺感知,我們關注一幅圖像時,總能被一些顯著性區域所吸引,從而快速地專注于感興趣的目標。受這種現象的啟發,SENet(Squeeze and Excitation Networks)[16]在CNN分類網絡上引入了通道注意力模塊,贏得了最后一屆ImageNet 2017競賽分類任務的冠軍。之后,Woo等[17]提出的卷積注意力機制(Convolutional Block Attention Module, CBAM)在通道和空間維度上學習關注什么,在哪里關注。2019年,SKNet(Selective Kernel Networks)[18]對SENet進行改進,提出了針對卷積核的注意力機制研究。馬森權等[19]在SSD網絡框架中引入注意力模塊來有效提取小目標的特征信息,提升了檢測精度。為此本文考慮使用注意力機制對特征進一步的優化,使SSD算法中的特征層更好的適應復雜背景中小目標檢測。

1 本文方法

1.1 檢測框架

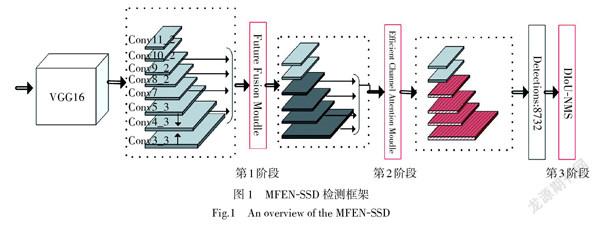

本文提出了一種多尺度特征增強的目標檢測框架(Multiscale Future Enhanced Network,MFEN)。如圖1所示,MFEN-SSD算法保留了SSD的前饋深度卷積網絡VGG16,在SSD原有特征層的基礎上新加入特征層Conv3_3和Conv5_3,這兩個特征層的感受野相對較小,可以保留較多的細節信息,對小目標比較敏感。本文的網絡結構分為3部分,第1階段為特征融合(Feature Fusion,FF),新加入的特征層和基礎骨干網絡的特征層(包括Conv4_3、Conv7、Conv8_2、Conv9_2) 進行特征融合,融合后的特征層語義和定位特征表達能力均得到提升,除用于進行預測外,還將作為下一個階段的初始特征。第2階段為特征增強,在融合后的特征層后面嵌入ECA(Efficient Channel Attention)模塊[20],通過適當的跨通道交互策略實現通道注意力的學習,以提高圖像中目標物體的特征提取能力。它可以將注意力集中在需要關注的細節信息上,并且可以抑制背景等無關信息,極大的提高了信息處理的效率與準確性。第3階段為冗余框的處理,使用DIoU-NMS[21]方法來解決漏檢問題。

1.2 基于特征融合的特征提取網絡

SSD網絡結構與用于特征提取的圖像金字塔類似,都屬于多尺度網絡結構。隨著卷積層的數量增多,特征層的尺度越來越小。其中低層特征層分辨率高,具有豐富的位置信息,但由于缺乏高層特征的語義信息,導致低層特征對小目標的分類效果較差,影響最終的檢測結果。高層特征層感受野大,語義信息表征能力強,適合檢測大目標。本文受FPN特征融合思想的啟發,將高層特征層通過反卷積操作依次向下與低層特征進行融合,使得低層特征的語義表征能力得到增強。融合后的多尺度結構如圖2所示,將MFEN-SSD網絡中的Conv3_3、Conv4_3和Conv5_3分別記為[D0]、[D1]和[D2]。為保持最終用于預測的特征圖的大小和數量不變,先對這三個低層特征進行特征融合,即:

式中:Conv2D代表二維卷積算子;Resize表示上采樣或者下采樣的操作,用于分辨率的匹配;“+”表示特征在通道上的堆疊。將Conv7、Conv8_2、Conv9_2分別記為:[D4]、[D5]、[D6]。由于分辨率太小的特征層進行融合幾乎不會提高檢測精度,反而會降低檢測速度,因此本文選取{[D3]、[D4]、[D5]、[D6]}作為特征金字塔網絡結構自底向上的路徑。為了使不同層次特征圖的上下文信息進行有效的融合,本文增加了一個Top-Down神經網絡作為自底向上前饋網絡的補充,并使用側向連接方式。自底向上的前饋網絡獲取的高層語義特征由自頂向上的網絡反饋回來,經過側向連接與中間特征層進行融合,同時繼續向下傳遞。最終網絡的輸出特征層既捕獲了細節特征又獲取了高層信息,并且預測是在每個融合后的特征層上單獨進行的。這些特征層的計算過程如下:

式(2)中的N = 3,4,5,6,式(3)和式(4)中的N = 3,4,5。[d]代表維度,在融合之前先將自底向上路線中的特征層維度統一成256-d,k表示卷積核尺寸的大小。為了減小參數量和計算量,使用分組卷積(Group Convolution)將標準的卷積分為g組,在對應的組內做卷積,并在分組卷積之后加入通道混洗(Channel shuffle)[22]操作使得組間的信息可以交流,最后得到通道混洗后的輸出。[CN]表示自底向上線路中經過降維得到的特征層,[TN]表示自頂向下線路和側面橫向連接形成的新特征,[Q(?)]為將[Ti]通過反卷積操作調整到和特征層[CN]一樣的尺寸。在進行特征融合之前都使用ReLU函數進行激活操作,在融合之后還會用3×3大小的卷積核對融合后的特征層[TN]進行卷積,目的是消除上采樣帶來的混疊效應。[FN]表示自頂向下線路的輸出特征,隨著N的減小,[FN]的特征信息被不斷地豐富與完善,使得同一特征層上可以覆蓋不同尺度的目標,增加了網絡模型的泛化能力。其特征融合結構如圖3所示,GConv代表分組卷積,采用的特征融合方式為Conact。與原SSD網絡每層特征層檢測特定尺寸的目標相比,本文提出的網絡將上下文信息進行了有效融合,因而更適合圖像中多類別多尺度目標的檢測。

1.3 注意力機制ECA模塊的使用

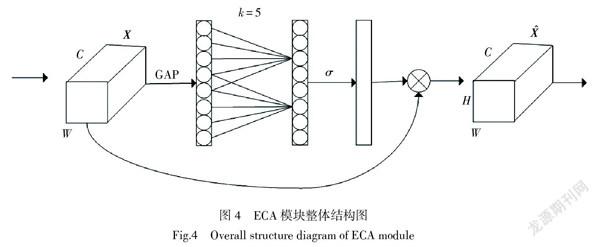

為了在不增加網絡模型復雜度的同時解決圖像中的小目標及背景復雜的問題,本文在運用特征融合后的網絡架構上引入一種有效的通道注意力(Efficient Channel Attention, ECA)模塊。該模塊通過適當的跨通道交互策略實現通道注意力的學習,可以顯著降低模型的復雜度同時保持性能。本文將ECA模塊嵌入到融合后的特征層{F3、F4、F5、F6}后面,這1階段為圖1所示的第2階段。如圖4所示,對于給定的一個輸出的特征[X∈RH×W×C],其中W、H和C分別表示特征層的寬度、高度和通道尺寸。首先采用不降維的全局平均池化(global average pooling)將一個通道上的整個空間特征編碼為一個全局特征,之后通過快速一維卷積來實現每個通道及其k個相鄰通道的局部跨通道信息交互,其公式為

式中:C1D表示一維卷積;[k]是卷積核的大小,表示局部跨通道交互的覆蓋率,與通道的C成正比,計算公式為

式(6)表示C和k之間的映射關系,γ=2,b = 1。[todd]表示t的最接近奇數。最后將學習到的通道權重和原始的特征X相乘來進行特征通道加權,得到最后的輸出特征層[X∈RH×W×C]。經過整個操作,模型可以將它的注意力集中到最有用的通道上,從而達到增強有用信息的作用。

1.4 用DIoU-NMS 替換NMS

在對圖像進行目標檢測時,多個特征層最后會產生大量的候選框,但是這些候選框中存在著大量錯誤的、重疊的和不確定的樣本。傳統的SSD算法是利用非極大值抑制算法(Non Maximun Suppression, NMS),通過設置交并比(Intersection-over-Union, IoU)閾值來去除多余的檢測框,其只考慮了重疊區域。當2個物體離得很近時,由于IoU的值比較大,經過NMS處理后只剩下1個檢測框,會導致漏檢現象的發生,并且圖像中經常會出現目標緊鄰的問題。為了克服NMS在此應用場景中的不利,本文用Distance-IoU (DIoU) NMS替換原本的NMS。和原始的NMS相比,本文的DIoU-NMS不僅考慮了IoU的值,還考慮了2個候選框之間的距離,將這2個因素作為是否刪除候選框的條件。其公式為

式中:[si]是分類置信度;[ε]為NMS閾值;M是最高置信度的框;[RDIoU]可以用式(9)來表示:

式中:[d=ρ(b,bgt)]是框b和框[bgt]的中心點之間的距離;[c]表示能夠同時覆蓋2個框的最小矩形的對角線的長度,如圖5所示。

2 實驗結果與分析

本文實驗是基于Intel(R) Core(TM) i7-4790K CPU @ 4.0 GHZ處理器和單GPU NVIDIA GTX 1070 Ti,采用Pytorch開源深度學習框架完成的。

選擇航天遙感目標檢測數據集NWPU VHR-10作為實驗數據集。此數據集是1個多類多尺度且小目標眾多的目標檢測數據集,提供了650張包含目標的光學遙感圖像,共含有實例樣本3 896個,包括飛機、油罐、車輛、籃球場等10個類別。NWPU VHR-10數據集屬于小樣本數據集,因此需要運用數據增強來人為的增加訓練樣本的數量。首先按照VOC2007數據集格式的標準,將數據集中的圖片隨機的分成了60%的訓練集、20%的驗證集和20%的測試集,圖6為劃分的訓練集、測試集和驗證集中包含的每個類別的目標數量。本文對其中的訓練集進行水平翻轉、旋轉90°、180°和270°。

本實驗使用VGG16作為預訓練的模型,訓練共迭代120 000次,批處理大小為32,初始學習率設置為0.001,隨機梯度下降SGD的權重衰減為0.000 5,動量因子設置為0.9。

實驗選擇平均精確度均值(Mean Average Precision,mAP)和準確率-召回率(Precision-Recall)曲線圖作為圖像多個類別的目標檢測的評價標準。AP即為PR曲線所包圍的面積,可以表示為

式中:[P]和[R]分別表示準確率和召回率,可以根據TP(True Positive)、FP(False Positive)、TN(True Negative)和FN(False Negative)來計算:

根據衡量每個類別檢測效果的AP即可得出

圖7是SSD算法和本文的MFEN-SSD算法在NWPU VHR-10測試集下10個類別的PR曲線對比圖,不同顏色的曲線表示不同的類別。可以看出本文的MFEN-SSD算法對應的PR曲線包圍的面積更大,對車輛和網球場等類別的提升效果明顯。

表1給出了本文算法和另外6種典型的目標檢測算法在NWPU VHR-10數據集中對10個類別進行檢測的精確度的對比。通過結果可以看出本文所提算法的平均準確率有著顯著的提高,相比RICNN[23],FR(Faster R-CNN)[3],YOLOv3[24],Grid R-CNN[25],Cascade R-CNN[5]和SSD[7]分別提升15.3%,6.9%,3.7%,3.5%,0.2%和 6.7%,對尺寸差異過大的目標物體均有較好的檢測效果。基于CNN的RICNN算法的檢測效果最差,且運算時間最長,在網球場、籃球場和橋梁等類別的檢測率很低,它采用的是選擇性搜索算法,所以該算法的計算復雜度也比較高。SSD算法的檢測精度比FR算法較高,驗證了這種多尺度特征金字塔網絡結構模型對于多類別多尺度目標的建模能力較強。YOLOv3采用了更深的網絡層次以及多尺度檢測,在飛機儲油罐和車輛等小目標上檢測結果比較好。Grid R-CNN和Cascade R-CNN是對FR算法的改進,檢測精度比FR分別高3.4%和6.7%。本文提出的MFEN-SSD算法不僅構建了類似FPN結構的多尺度特征金字塔結構來適應圖像的多尺度特征,而且引入的注意力機制對感興趣區域投入更多的關注,在犧牲較小運算時間的同時大大的提高了目標的識別率與準確率,但需要進一步提升和改善在儲油罐和車輛目標的檢測精度。其部分可視化檢測結果如圖8所示。

表2是本文各模塊在NWPU VHR-10數據集上的消融對比實驗。從表中結果可以看出,本文對網絡的3方面改進有效地提高了平均檢測精度。

為了進一步驗證MFEN-SSD算法的通用性和有效性,將本文算法應用于地鐵安檢圖片檢測。表3為在該數據集上對本文各模塊的消融實驗對比,可以看出本文算法比傳統SSD的檢測精度提高了13.9%。首先需要借助目標檢測標注工具LabelImg將地鐵安檢數據集制作成Pascal VOC2007的格式,主要作用是對所有的原始圖像中的目標位置進行標注,每張標注完的圖片都會生成一個相應的xml文件,表示目標真實邊界框的準確位置。本文所用的數據集將打火機、黑釘子、刀具、電池、剪刀5個類別分別用數字1、2、3、4、5來表示,最后共生成981個對應的xml文件。隨后將981張圖片隨機的分成了60%的訓練集、20%的驗證集和20%的測試集,并在送入網絡前對訓練集進行水平翻轉、旋轉等數據增強操作來擴充訓練集的圖片數量。

表4為上述序號1~8的消融實驗對應的每個類別的具體檢測精度差異。可以看出本文所提算法的每1個階段單獨和任意2種組合使用時都對mAP有不同程度的提高,當3個階段同時使用時,地鐵安檢圖片的檢測精度達到了最高值77.4 %。

圖9 中a)是傳統SSD算法的檢測結果圖,b)為本文MFEN-SSD算法的檢測結果圖。可以直觀地看出,和傳統的SSD算法相比,本文MFEN-SSD算法具有更好的檢測結果。它可以檢測到大部分SSD算法漏檢的小目標,該算法降低小目標漏檢率,同時也提高了平均檢測準確率。

3 結論

本文提出了一種多尺度特征增強的改進SSD目標檢測算法MFEN-SSD。該模型以VGG16作為基礎的特征提取網絡,首先將高層和低層的特征層進行融合,形成高分辨率高語義信息的特征層,使得模型能夠更好地實現多尺度目標檢測。隨后通過注意力機制模塊對特征進行進一步優化,將注意力集中在需要投入更多精力的細節信息上,并且抑制無用信息。最后對產生的冗余框進一步處理來減少目標的漏檢。在遙感數據集NWPU VHR-10上進行了實驗驗證,并和SSD算法以及當前一些典型的目標檢測算法進行分析與比較。實驗結果表明MFEN-SSD的性能在平均精度上優于其他算法。在地鐵安檢數據集上的拓展實驗也進一步證明了該算法的通用性和有效性,提高了對小目標的檢測精度。

參考文獻:

[1]? ? 劉小波,劉鵬,蔡之華,等.基于深度學習的光學遙感圖像目標檢測研究進展[J].自動化學報,2021,47(9): 2078-2089.

[2]? ? 寇大磊,權冀川,張仲偉.基于深度學習的目標檢測框架進展研究[J].計算機工程與應用,2019,55(11): 25-34.

[3]? ? REN S Q,HE K M,GIRSHICK R,et al.Faster R-CNN: towards real-time object detection with region proposal networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6): 1137-1149.

[4]? ? LIN T Y,DOLL?R P,GIRSHICK R,et al.Feature pyramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition.July 21-26,2017,Honolulu,HI,USA.IEEE,2017: 936-944.

[5]? ? CAI Z W,VASCONCELOS N.Cascade R-CNN: delving into high quality object detection[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.June 18-23,2018,Salt Lake City,UT,USA.IEEE,2018: 6154-6162.

[6]? ? LI Y H,CHEN Y T,WANG N Y,et al.Scale-aware trident networks for object detection[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV).October 27 - November 2,2019,Seoul,Korea (South).IEEE,2019: 6053-6062.

[7]? ? LIU W,ANGUELOV D,ERHAN D,et al.SSD: single shot MultiBox detector[C]// Computer Vision – ECCV 2016,2016: 21-37.

[8]? ? REDMON J,DIVVALA S,GIRSHICK R,et al.You only look once: unified,real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition.June 27-30,2016,Las Vegas,NV,USA.IEEE,2016:779-788.

[9]? ? LAW H,DENG J.CornerNet: detecting objects as paired keypoints[J].International Journal of Computer Vision,2020,128(3): 642-656.

[10]? DUAN K W,BAI S,XIE L X,et al.CenterNet: keypoint triplets for object detection[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV).October 27-November 2,2019,Seoul,Korea (South).IEEE,2019: 6568-6577.

[11]? TAN M X,PANG R M,LE Q V.EfficientDet: scalable and efficient object detection[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 13-19,2020,Seattle,WA,USA.IEEE,2020: 10778-10787.

[12]? FU C Y,LIU W,RANGA A,et al.DSSD: deconvolutional single shot detector[EB/OL].(2017). https://arxiv.org/abs/1701.06659

[13]? SHRIVASTAVA A,SUKTHANKAR R,MALIK J,et al.Beyond skip connections: top-down modulation for object detection[EB/OL].(2017).https://arxiv.org/abs/1612.06851

[14]? JEONG J,PARK H,KWAK N.Enhancement of SSD by concatenating feature maps for object detection[C]// Proceedings ofthe British Machine Vision Conference 2017.London,UK.British Machine Vision Association,2017: 76.

[15]? LI Z, ZHOU F. FSSD: feature fusion single shot multibox detector[EB/OL].(2018). https://arxiv.org/abs/1712.00960v3

[16]? HU J,SHEN L,SUN G.Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.June 18-23,2018,Salt Lake City,UT,USA.IEEE,2018: 7132-7141.

[17]? WOO S, PARK J, LEE J Y, et al. CBAM: Convolutional block attention module[C]//Proceedings of the European conference on computer vision. September 8-14,2018,Munich,Germany.Springer,2018: 3-19.

[18]? LI X,WANG W H,HU X L,et al.Selective kernel networks[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 15-20,2019,Long Beach,CA,USA.IEEE,2019: 510-519.

[19]? 麻森權,周克.基于注意力機制和特征融合改進的小目標檢測算法[J].計算機應用與軟件,2020,37(5): 194-199.

[20]? WANG Q L,WU B G,ZHU P F,et al.ECA-net: efficient channel attention for deep convolutional neural networks[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 13-19,2020,Seattle,WA,USA.IEEE,2020:11531-11539.

[21]? ZHENG Z H,WANG P,LIU W,et al.Distance-IoU loss: faster and better learning for bounding box regression[J].Proceedings of the AAAI Conference on Artificial Intelligence,2020,34(7): 12993-13000.

[22]? ZHANG X Y,ZHOU X Y,LIN M X,et al.ShuffleNet: an extremely efficient convolutional neural network for mobile devices[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition.June 18-23,2018,Salt Lake City,UT,USA.IEEE,2018: 6848-6856.

[23]? CHENG G,ZHOU P C,HAN J W.Learning rotation-invariant convolutional neural networks for object detection in VHR optical remote sensing images[J].IEEE Transactions on Geoscience and Remote Sensing,2016,54(12): 7405-7415.

[24]? REDMON J, FARHADI A. Yolov3: an incremental improvement[EB/OL].(2018). https://arxiv.org/abs/1804.02767.

[25]? LU X,LI B Y,YUE Y X,et al.Grid R-CNN[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR).June 15-20,2019,Long Beach,CA,USA.IEEE,2019: 7355-7364.

收稿日期:2020-10-31

基金項目:河北省自然科學基金(F2019202054)

第一作者:高娜(1994—),女,碩士研究生。通信作者:吳清(1965—),女,教授,wuqing@scse.hebut.edu.cn。