遙感圖像時空融合綜述

楊廣奇,劉 慧,鐘錫武,陳 龍,錢育蓉

1.新疆維吾爾自治區信號檢測與處理重點實驗室,烏魯木齊 830046 2.新疆大學 軟件學院,烏魯木齊 830000 3.新疆大學 信息工程學院,烏魯木齊 830000 4.新疆大學 軟件工程重點實驗室,烏魯木齊 830000

隨著計算機的發展,遙感技術取得了很大進步,遙感領域進入了一個更大范圍、更高精度、更深層次的階段[1]。時間密集的高空間分辨率遙感圖像在資源調查[2-3]、森林監測[4]、生態系統動態監測[5]、實時災害[6]等動態監測和變化檢測的應用方面都有重要作用。然而,由于技術和預算的限制,目前的遙感衛星還存在著“時空矛盾”的問題[7],即單個衛星傳感器不能同時獲取高空間、高時間分辨率兼并的遙感圖像數據[8]。

一個經濟有效的解決方案是時空特征融合方法,該方法的核心思想是將來自多個衛星傳感器的不同類型的遙感圖像融合在一起,獲得具有高空間分辨率和高時間分辨率的遙感圖像[9]。例如,高空間分辨率陸地衛星(Landsat)系列傳感器獲得的遙感衛星圖像空間分辨率約為30 m,并且可以用于森林監測、精準農業、生態環境動態監測和土地覆蓋分類等領域[10-12]。因為低空間分辨率的圖像具有局限性,所以提取到地物的紋理等細節特征受阻。例如低空間分辨率傳感器Aqua和Terra衛星上的中分辨率成像光譜儀(MODIS)能夠獲得高時間分辨率圖像,重返周期為一天,但是空間分辨率較低,只有250~1 000 m[13]。時空融合的方法就是將這兩種類型的圖像融合,使得融合后的圖像同時具有高時間分辨率和高空間分辨率,在滿足地物快速變化的同時,保留地物細節等特征。

1 相關工作

本文總結了五類時空特征融合方法:基于分解的方法、基于權值函數的方法、基于貝葉斯的方法、基于學習的方法和混合的方法[14]。最先被提出的是基于分解的時空融合算法,例如多傳感器多分辨率技術(multisensor multiresolution technique,MMT)[15]、LAC-GAC NDVI Integration[16]等。隨后出現大量基于權重的時空融合方法,此類方法包含的模型數量最多,最為代表性的是時空自適應反射融合模型(spatial and temporal adaptive reflectance fusion,STARFM)[17],之后基于STARFM方法衍生出非常多的方法。基于貝葉斯的方法將時空融合視為最大后驗概率問題,代表方法有貝葉斯最大熵(Bayesian maximum entropy,BME)[18]、Unified Fusion[19]等。隨著機器學習算法的逐漸成熟,時空融合領域也不斷涌現出基于學習的算法,如基于稀疏表示的時空反射融合模型(spatiotemporal reflectance fusion,SPSTFM)[20]、One-pair Learning Method[21]等。近年來,神經網絡等深度學習模型由于其強大的自動特征表示學習能力,能夠從原始數據中自動高效地學習空間鄰近性和時間相關性,在各種機器學習任務中都取得了顯著的結果[22]。為了結合各類方法,將各類方法最大的優勢集中在一起,提出了混合方法,比如靈活時空數據融合(flexible spatiotemporal data fusion,FSDAF)[23]、時空反射分解模型(spatial and temporal reflectance unmixing model,STRUM)[24]等。

本文主要總結了現有的基于深度學習的遙感圖像時空融合算法及其評估標準,分析各個模型的特點優勢與存在的問題,并對未來的發展方向提出展望。本文的貢獻可歸納如下:

(1)對遙感圖像時空融合的算法進行分類總結分析。

(2)在AHB、DX、TJ數據集上進行傳統和深度學習模型的實驗分析。

(3)為后期遙感圖像時空融合研究提供理論參考。

2 基于傳統遙感圖像時空融合

2.1 基于分解的時空融合模型

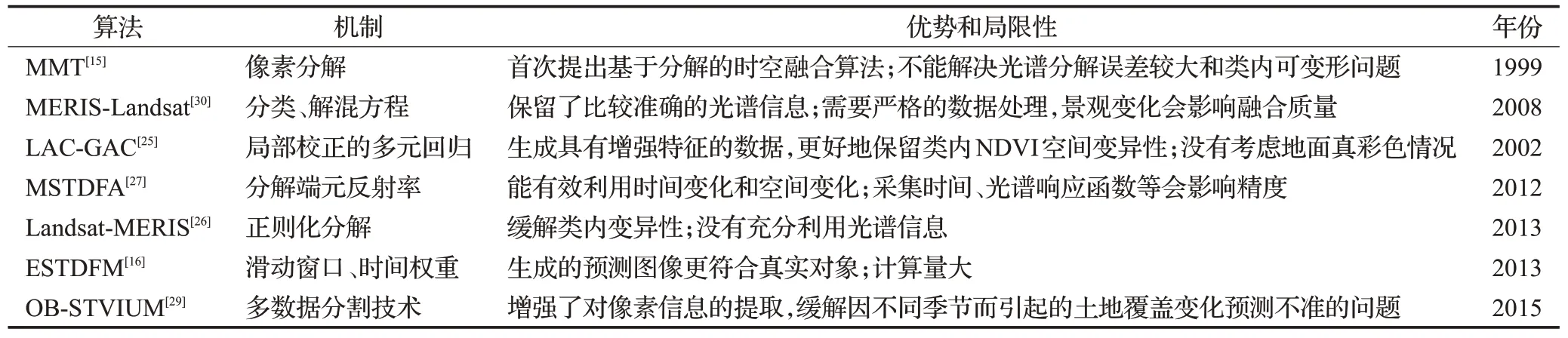

基于分解的方法采用線性光譜混合理論,通過分析粗像素的組成并對其進行分解來估計細像素的值。Zhukov等提出的MMT[15]是一種融合不同時間和不同空間分辨率衛星圖像的基于分解的方法。該方法將分解過程中已有的所有信息融合在一起,采用以下四個步驟來預測精細分辨率圖像:(1)對輸入的高分辨率圖像分類得到高分辨率分類圖。(2)對低分辨率像素信號的類貢獻進行定義。(3)對基于窗口的粗像素進行分解。(4)未混合(銳化)圖像的重建。但是MMT仍不能很好地解決光譜分解誤差較大和類內可變性問題。為了解決類內變異性問題,Maselli等[25]提出使用局部校正的多元回歸模型,通過局部校正的統計量來處理類內NDVI的空間變異性。Landsat-MERIS[26]采用改進的正則化分解方法增加圖像土地覆蓋類別的光譜可變性。此外,改進的成本函數使處理結果更加穩健。Zhang等[16]在STDFM算法的基礎上,引入基于補丁的分類方法和滑動窗口技術,充分考慮了空間異質性,使預測結果更加符合實際地物的變化。Wu等[27-28]通過在一個移動窗口中分解輸入和預測日期的端元反射率來估計反射率變化,將估計的反射率變化添加到基礎精細分辨率圖像中得到預測,又通過自適應窗口大小選取的方法,更精確地分解像素。Lu等[29]采用多數據分割技術,確定最佳分割尺度以此改進像素信息的提取,減緩分解誤差較大的問題。Zurita-Milla等[30]利用基于解混的數據融合技術,引入約束條件,成功保留了更多光譜信息。

基于分解的時空融合的這類模型起源最早,算法原理簡單并且易于操作,但是由于粗圖像分辨率過低而無法準確地分解每一種地物信息,在土地覆蓋類型較多的混合區域無法分解出較好的結果。此類方法適用土地覆蓋類型較少的場景,具體方法對比分析如表1所示。

表1 基于分解的時空融合模型Table 1 Spatiotemporal fusion models based on decomposition

2.2 基于權函數的時空融合模型

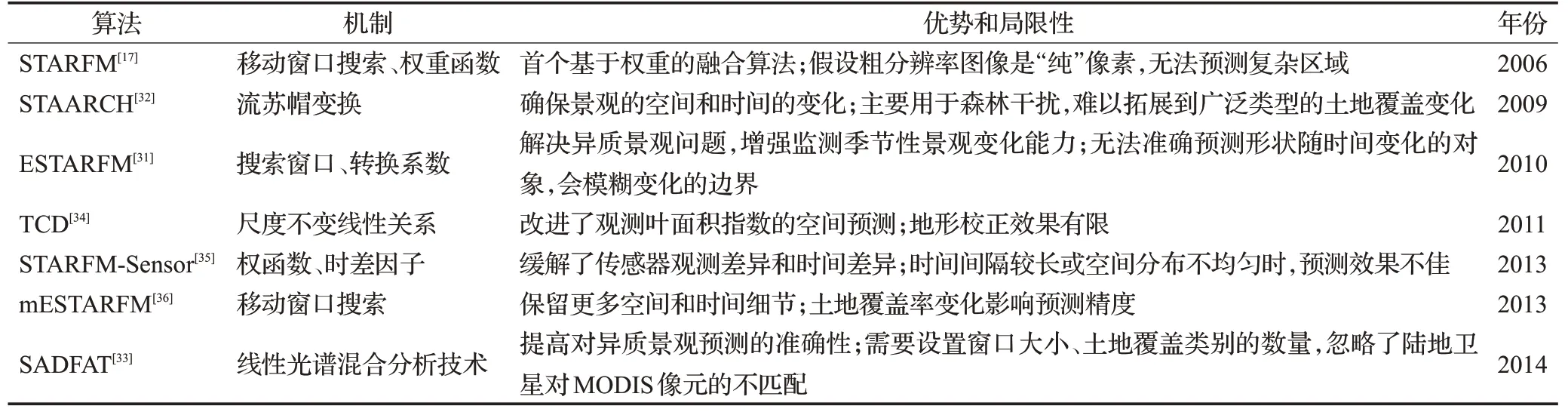

基于權函數的方法通過權函數結合所有輸入圖像的信息來估計精細像素值。Gao等[17]首次提出基于權函數的時空自適應反射率融合模型STARFM。STARFM采用加權函數來預測像素,加權函數通過數據間的光譜差異和鄰近像素的信息計算得出。STARFM存在兩個主要問題:在多種土地覆蓋類型的異質景觀中效果較差,權函數是經驗函數。為了提高STARFM在異質景觀中的預測效果,Zhu等[31]提出增強自適應反射率融合模型(enhanced STARFM,ESTARFM),使用轉換系數更準確地保證了對小對象和線性對象的反射率預測。映射反射變化的時空自適應算法(spatial temporal adaptive algorithm for mapping reflectance change,STAARCH)[32]從粗圖像的密集時間序列中監測變化點,以較好的細節水平識別景觀的空間和時間變化。SADFAT[33]算法修改了STARFM,通過轉換系數將粗細分辨率圖像上的熱輻射變化聯系起來。Hwang等[34]提出基于多時相數據的復雜地形下植被動態降尺度算法,通過降尺度技術將MODIS和Landsat數據融合,并且在降尺度的過程中補償物候差異,最后緩解了空間異質性問題。Shen等[35]考慮不同傳感器的觀測差異,改變STARFM中計算像素權重的方式,提高最終的預測精度。Fu等[36]對ESTARFM進行了改進,引入了土地覆蓋數據作為光譜相似相鄰像素的補充信息,使得在預測圖像時能夠保留更相似的空間細節。

基于權重函數的時空融合模型理論簡單,出現大量基于權重函數的變體算法,但大多屬于經驗函數,依賴其他輸入圖像的像素信息,這導致當土地覆蓋類型過多或發生土地覆蓋突變等異常變化時難以從相鄰圖像提取精確的信息,反而融合精度較差。此類方法適用于土地覆蓋小范圍變化的場景,具體方法對比分析如表2所示。

表2 基于權重的時空融合模型Table 2 Spatiotemporal fusion models based on weight

2.3 基于貝葉斯的方法

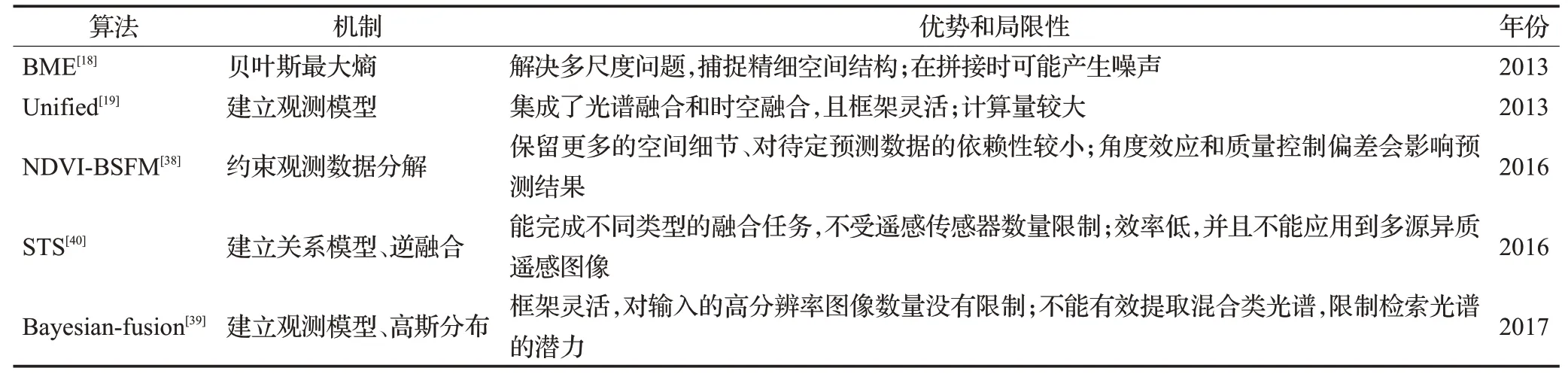

時空貝葉斯數據融合將圖像時間序列中的時間相關信息結合起來,將融合問題轉化為估計問題[37]。Li等[18]使用貝葉斯最大熵的融合方法避免由縮放造成的復雜性和不確定性。Huang等[19]提出統一模型,通過低通濾波對空間關系進行建模,并使用線性模型對時間關系進行建模。在NDVI-BSFM[38]中,使用線性混合模型對高分辨率圖像和低分辨率圖像進行建模,同時利用多年NDVI時間序列作為先驗信息進行建模。Xue等[39]提出將圖像時間序列中的事件信息結合起來,將融合問題轉化為估計問題,提高了在異質景觀場景中的融合效果。Shen等[40]在所提出的融合框架中,利用最大后驗概率理論來描述逆融合問題,建立綜合關系模型,利用共軛梯度優化算法完成最終的融合。

基于貝葉斯的融合方法的重點在于對觀測圖像和待預測圖像之間的關系進行建模,當發生土地覆蓋類型變化時會導致預測精度降低。此方法適用對模型靈活性要求高的場景,具體方法對比分析如表3所示。

表3 基于貝葉斯的時空融合模型Table 3 Spatiotemporal fusion models based on Bayesian

2.4 基于學習的方法

基于學習的方法使用機器學習對觀測到的圖像對之間的關系建模,預測未觀測到的圖像[14]。Huang[20]通過稀疏表示將細圖像和粗圖像之間的對應關系訓練為字典對,利用兩對已知粗細圖像對之間的變化關系對預測圖像進行預測。隨后Song等[21]進行了優化,提出基于一對圖像對進行預測的融合方法。Wu等[41]對字典擾動的誤差界進行正則化,從而達到預測精度。Liu等[42]利用極限學習機技術,建立一個學習差分圖像的映射函數,實現快速準確的精細預測。Moosavi等[43]結合小波變換和人工智能方法,構建出一個非線性模型來處理地表溫度的非線性特征。Wei等[44]提出結構稀疏和半耦合學習的方法解決稀疏表示降低表達精度的問題。

基于學習的方法根據精細和粗略分辨率圖像的結構相似性建立對應關系,可以捕獲預測中的主要特征,包括土地覆蓋類型變化等,但是由于粗圖像與細圖像之間的尺度差異較大,無法準確地保持預測對象的形狀,尤其是不規則形狀的地物對象。此方法適用于對數據樣本量大、時間跨度長的場景,具體方法對比分析如表4所示。

表4 基于學習的時空融合模型Table 4 Spatiotemporal fusion models based on learning

2.5 基于混合的方法

一些時空融合方法結合分解方法、貝葉斯理論、權重函數和學習方法的優勢來追求更好的融合效果。例如Zhu等提出了將基于分解的方法、基于權重的方法和空間插值思想集中在一起的時空融合方法FSDAF[23],FSDAF能夠融合具有挑戰性的場景中的圖像,即異質景觀和突然的土地覆蓋變化。時空遙感圖像和土地覆蓋圖融合模型(spatial-temporal remotely sensed images and land cover maps fusion model,STIMFM)[45]結合光譜分解和貝葉斯框架,將多時相粗圖像和少量土地覆蓋圖生成一系列精細時空分辨率的土地覆蓋圖。時空反射分解模型(spatial and temporal reflectance unmixing model,STRUM)[24]采用貝葉斯的方法分解粗圖像中的時間差異,利用STARFM原理將時間差異添加到細圖像中得到融合圖像。為了生成高空間細節的日精細分辨率地表溫度,BLEST[46]將權值函數、時間插值和空間降尺度融合,保留更多的空間細節和時間變化信息。

混合的時空融合方法可以通過多種方法的組合來處理不同的土地覆蓋類型變化問題,提高了模型的泛化能力,但同時也提高了算法的復雜性,限制了算法的大規模應用。此方法適用于要求預測精度高、模型復雜度沒有限制的場景,具體方法對比分析如表5所示。

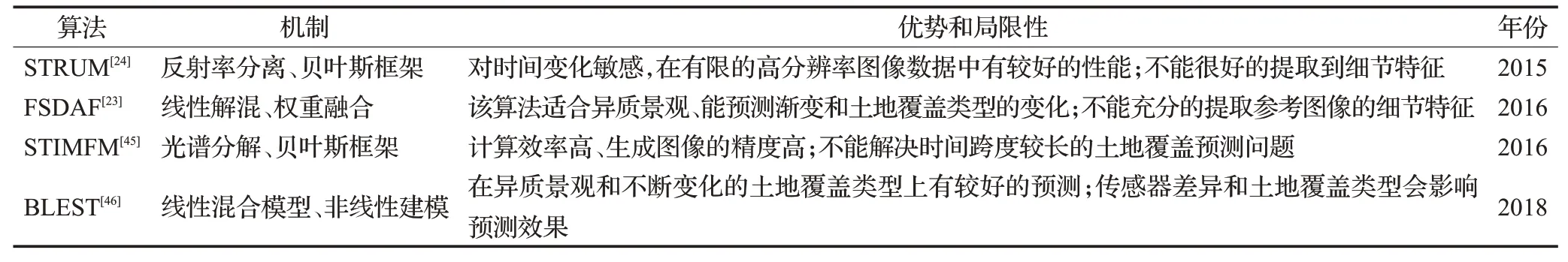

表5 基于混合的時空融合模型Table 5 Spatiotemporal fusion models based on hybrid

3 基于深度學習的遙感圖像時空融合

在基于多層次的遙感圖像超分辨率重建中,基于時序和空間特征的融合在近些年取得了突破,尤其是基于深度學習的時空融合為其發展指明了新的方向。

基于深度學習的時空融合算法一般都需要一對到兩對先驗信息。先驗信息表示同一時刻的高空間低時間分辨率和低空間高時間分辨率結合而成的一對信息。目前,在遙感圖像時空融合領域,大多數實驗中高空間低時間分辨率(HSLT)采用Landsat數據集,低空間高時間分辨率(LSHT)采用MODIS數據集。接下來主要總結了近兩年來涌現出的基于深度學習的時空融合算法,分析各個算法的特點,并對基于深度學習的融合算法進行對比,如表6所示。

表6 深度學習時空融合模型對比Table 6 Comparison of deep learning spatiotemporal fusion models

3.1 基于普通卷積網絡的時空融合算法

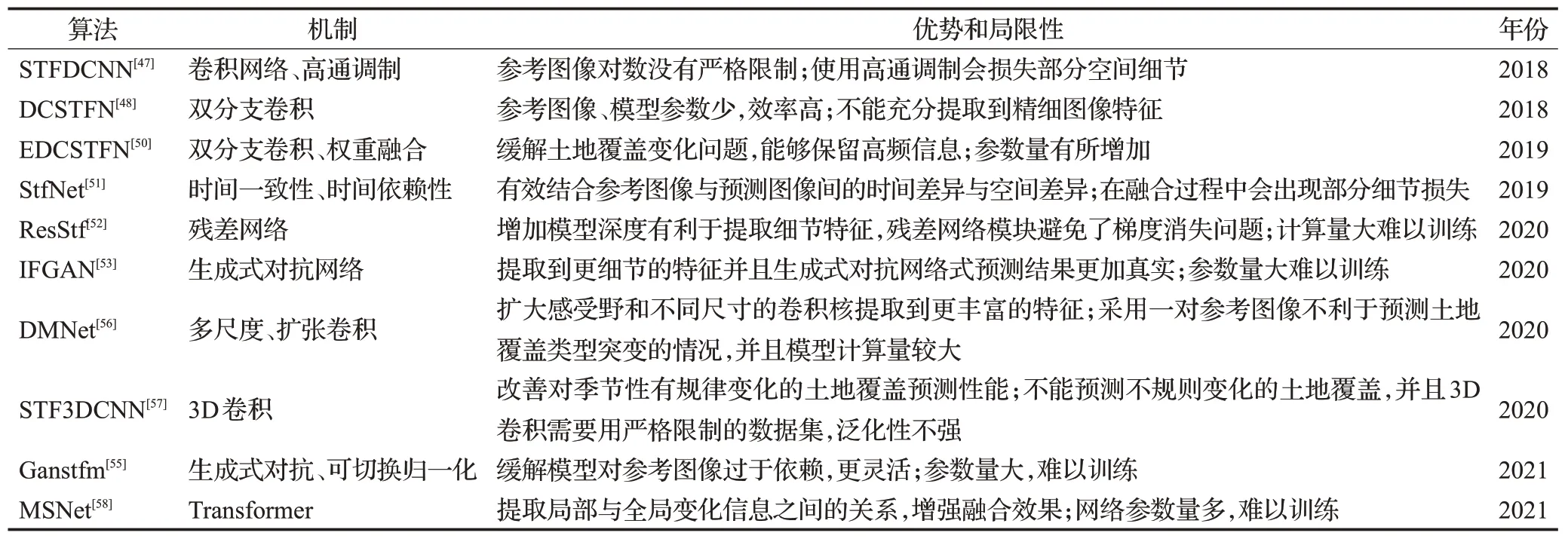

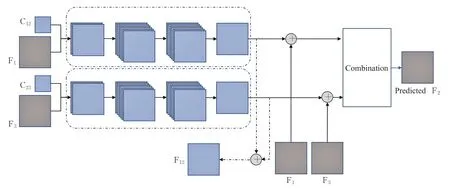

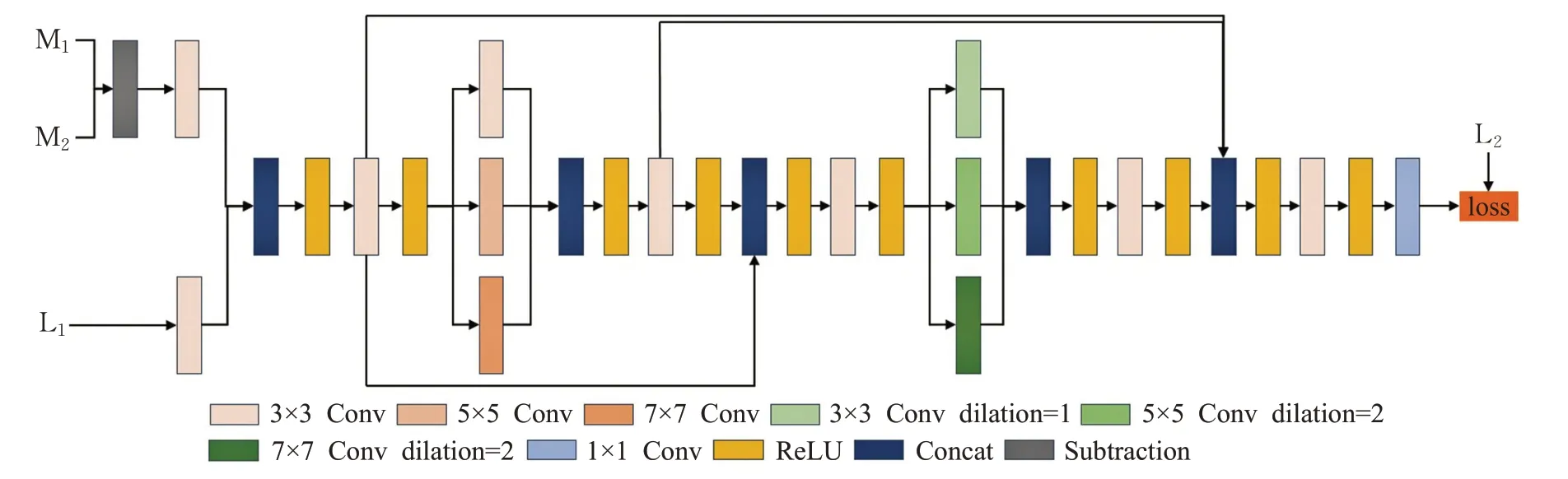

Song等[47]提出了一種基于CNN的時空融合算法(spatiotemporal fusion using deep convolutional neural networks,STFDCNN)。該方法訓練階段分為兩部分,這兩部分充分利用殘差網絡的思想,讓網絡著重于學習高頻細節,如圖1左圖所示。預測階段,為了利用預測日期前后的兩個臨近時刻的先驗圖像的時間變化信息,應用了高通調制方法[48]來預測圖像。該方法既可以使用兩對先驗圖像又可以使用一對先驗圖像來對預測圖像進行信息的補充,在先驗圖像的對數方面沒有嚴格的限制。雖然該方法總體表現良好,但是在預測時由于使用高通調制和權重融合,不可避免地會丟失一些空間細節。

圖1 STFDCNN網絡結構圖Fig.1 STFDCNN network structure diagram

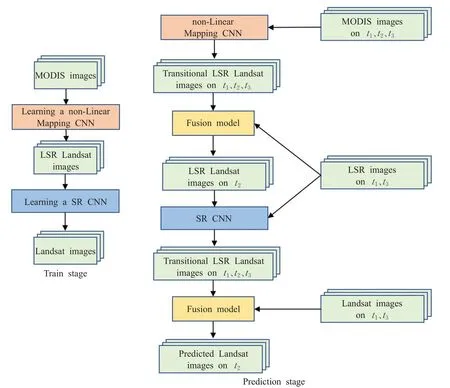

Tan等[49]提出的深度卷積時空融合網絡(deep convolutional spatiotemporal fusion network,DCSTFN)找到了低空間分辨率高時間分辨HTLS與低時間分辨率高空間分辨LTHS圖像之間的直接非線性映射關系。網絡包含兩部分,如圖2所示,第一部分是一個共享子網絡,在提取HTLS和LTHS低頻分量特征的同時擴展其尺寸,第二部分對LTHS的先驗圖像進行高頻分量特征的提取,最后,將三張圖像得來的特征進行融合。該算法的優點是利用一對先驗圖像即可進行預測,然而這對先驗圖像的要求比較高,如果僅有的一對先驗圖像質量不高,將會極大程度地影響預測結果。另外,隨著網絡層數的深度加深,引入殘差網絡也可以解決該算法可能存在的網絡退化問題。隨后Tan等對DCSTFN算法進行改進,提出增強型深卷積時空融合網絡(enhanced deep convolutional spatiotemporal fusion network,EDCSTFN)[50],引入雙分支以支持兩對參考圖像。此外,引入新的復合損失函數,將圖像的精度和視覺損失結合起來,能夠較好地預測土地覆蓋變化問題,并盡可能地保留高頻信息,生成清晰的圖像。

圖2 DCSTFN網絡結構圖Fig.2 DCSTFN network structure diagram

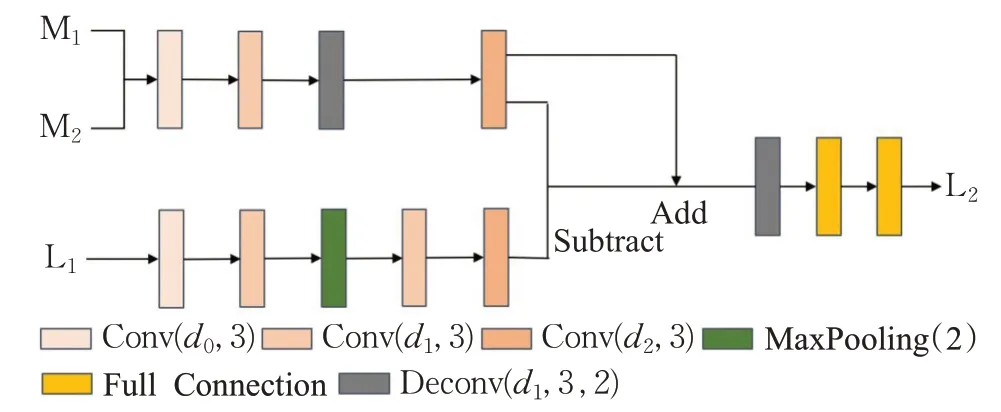

Liu等[51]基于卷積神經網絡提出了雙流卷積神經網絡(two-stream convolutional neural network,StfNet)。該方法為了緩解在特征提取過程中出現的空間信息丟失問題,引入了時間依賴性和時間一致性原理。網絡結構如圖3,預測日期的圖像分別與前一刻日期和后一刻日期的圖像結合,利用時間依賴性得到兩個精細圖像特征,兩個精細圖像特征再利用時間一致性獲得最終的預測結果。此方法在客觀和主觀評價方面都取得了非常好的性能。

圖3 StfNet網絡結構圖Fig.3 StfNet network structure diagram

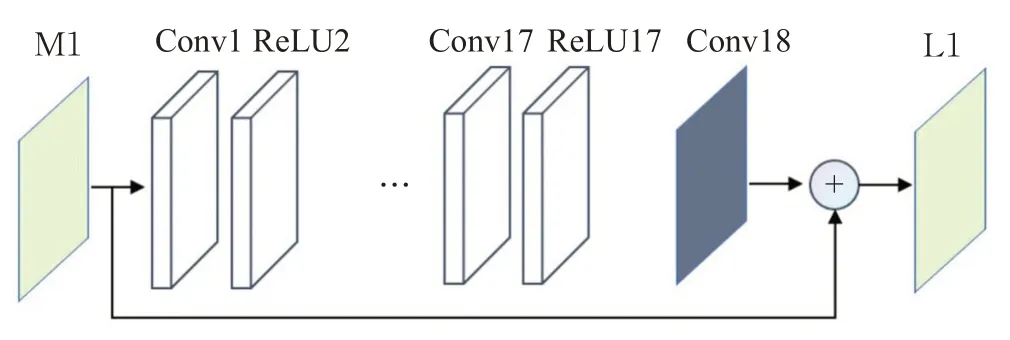

3.2 基于殘差網絡的時空融合算法

Wang等[52]提出了基于殘差網絡的時空融合算法,如圖4所示,網絡建立了一種低空間高時間分辨率圖像與高空間低時間分辨率圖像之間的非線性映射模型。該方法增加了神經網絡的深度,提取到了更多的細節特征,并且利用殘差網絡避免或減少了梯度消失的問題。但是對數據集的時間信息提取不足,不能精準地預測土地覆蓋類型的變化。

圖4 基于殘差網絡的網絡結構圖Fig.4 Network diagram based on residual network

3.3 基于生成對抗網絡的時空融合算法

Zhang等[53]提出了一種基于生成對抗網絡的時空融合方法(spatiotemporal fusion method using a GAN,STFGAN),借鑒SRGAN(generative adversarial network for image super resolution)[54]的思想,如圖5所示,利用生成對抗網絡的優勢提高預測效果,并且在生成器中引入殘差學習的結構,使深層次結構網絡也能獲取到更多地物細節以及高級抽象特征的同時避免了梯度消失和梯度爆炸問題。生成器對抗網絡的參數量多和難訓練是該模型最需要優化的問題。

圖5 IFGAN模塊結構圖Fig.5 IFGAN module structure diagram

為了緩解模型對參考圖像過于依賴的問題,Tan等[55]提出基于生成對抗網絡的時空融合模型(GAN-based spatiotemporal fusion model,Ganstfm),如圖6所示。在以往模型中,往往需要一對或者兩對參考圖像,并且必須對參考圖像應用嚴格的約束。為了應對該問題,并且提升模型在惡劣條件下圖像的預測精度,采用條件生產對抗網絡和可切換歸一化模塊,緩解了對輸入圖像的嚴格限制。

圖6 Ganstfm網絡結構圖Fig.6 Ganstfm network structure diagram

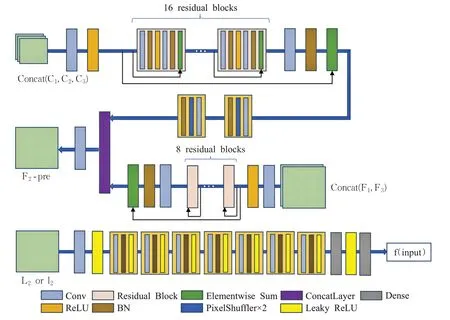

3.4 基于多尺度與擴張卷積的時空融合算法

Li等[56]提出基于多尺度機制和擴張卷積的神經網絡(network architecture using dilated convolution and multiscale mechanisms,DMNet),網絡結構如圖7所示,不但避免局部特征冗余,而且獲取更多的圖像特征,利用多尺度機制采用不同尺度卷積核提取圖像的信息,可以更加準確地提取到特征圖的時間變化和空間細節。同時引入跳躍連接,避免了多尺度機制造成特征信息的丟失。

圖7 DMNet網絡結構圖Fig.7 DMNet network structure diagram

3.5 基于3D卷積神經網絡的時空融合算法

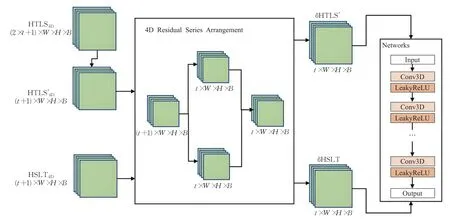

隨著遙感技術和傳感器的快速發展,目前已經積累了大量的遙感數據,為長時間序列遙感數據的處理奠定基礎。Peng等[57]提出了基于三維卷積神經網絡的融合方法(fast three-dimensional convolutional neural network,STF3DCNN),結構如圖8所示,主要包括剩余序列排序和剩余特征映射網絡,根據4D殘差規則使數據排列成4D殘差序列數據集,將數據集輸入到剩余特征映射網絡中進行預測。該方法首次使用三維卷積和四維數據進行時空融合,時間權重改善了季節性有規律變化的土地覆蓋類型,在保持總體精度的同時顯著減少了總運行時間。但該模型對于輸入數據要求嚴格,并且突然不規則的土地覆蓋變化沒有得到改善。

圖8 STF3DCNN網絡結構圖Fig.8 STF3DCNN network structure diagram

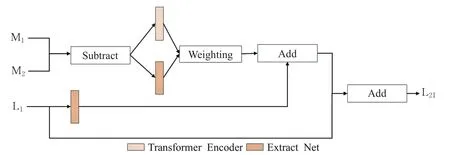

3.6 基于Transformer的時空融合方法

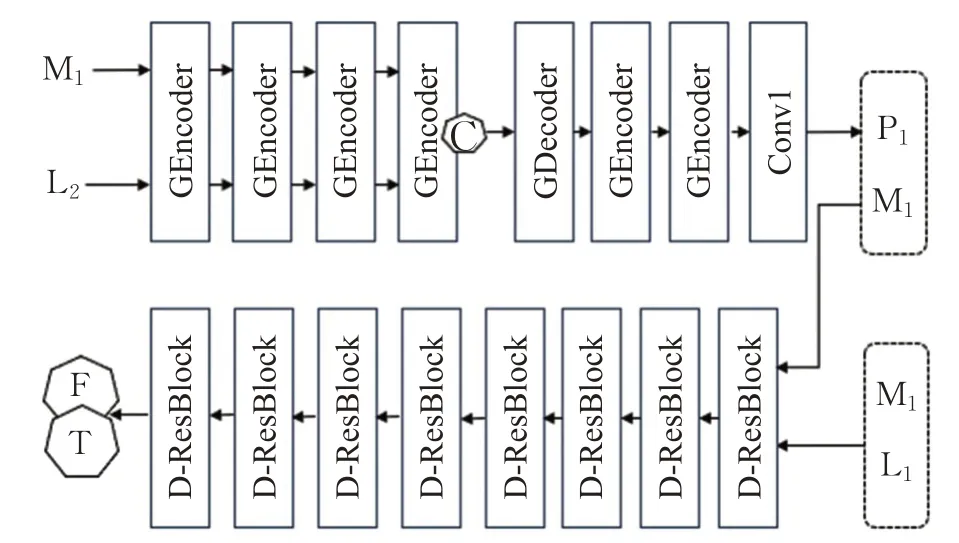

作為注意力機制的一個應用,Transformer引入到視覺領域后取得了良好的效果。為了能夠學習全局變換信息,Li等[58]引入ViT(vision Transformer),ViT與卷積結構進行結合設計出雙分支網絡,分支的結構如圖9所示。網絡在提取到特征的同時,利用ViT的自我注意機制和位置信息來學習粗圖像局部和全局時間變化信息之間的關系,同時使用平均加權的方法對兩個分支進行融合,使融合效果更佳精確。

圖9 MSNet網絡結構圖Fig.9 MSNet network structure diagram

4 實驗

4.1 數據集

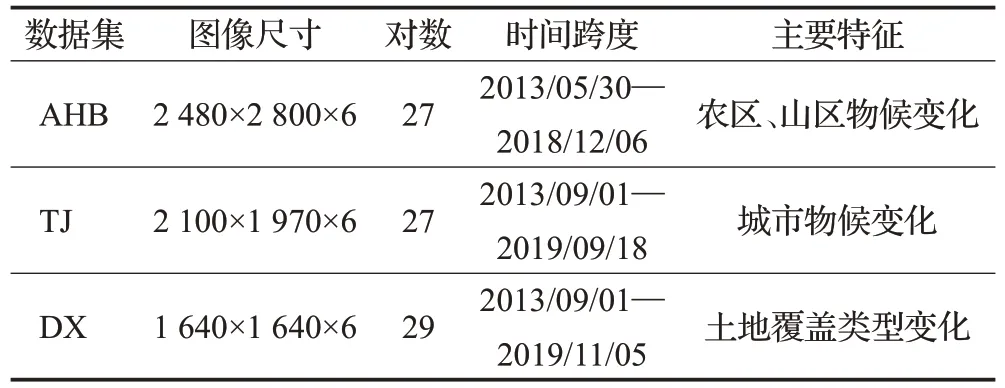

本文選取了AHB數據集、天津數據集(TJ)和大興數據集(DX),分別收集于內蒙古科爾沁旗、天津市和北京市大興區。每一幅遙感數據具有6個波段,包括藍色波段、綠色波段、紅色波段、近紅外波段、短波紅外-1波段、短波紅外-2波段[9]。各個數據集總結詳細信息見表7所示。

表7 數據集介紹Table 7 Dataset introduction

4.2 實驗環境和實現細節

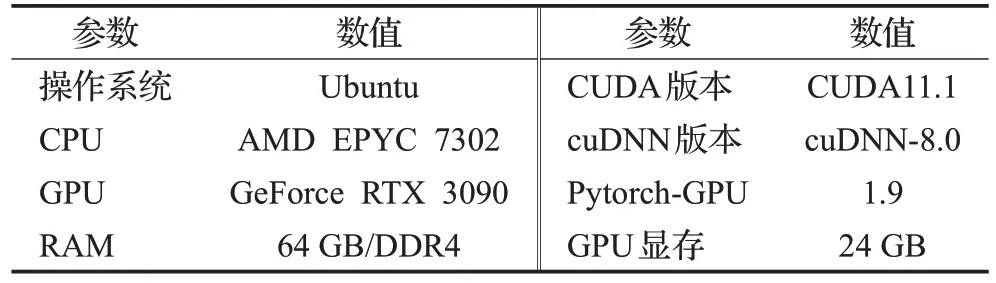

因為在MODIS圖像的兩個短波紅外波段存在著明顯的條帶噪聲,這給訓練過程帶來了很大的挑戰,在實驗中只用前四個波段進行訓練。粗細圖像對(低分辨率和高分辨率圖像對),三對組成一組訓練數據,分別是t0、t1、t2時刻的圖像對。t0和t2是參考圖像,為了預測t1時刻的高分辨率圖像。數據集的80%用于模型的訓練,20%用于模型的驗證和測試。由于訓練過程中整張輸入圖像會導致運行顯存不足,數據采用分塊訓練(整張訓練需要太大顯存),把遙感數據分為80×80。訓練細節方面,本模型采用Adam優化方法更新模型的參數,其中初始學習率為0.001,batch_size設置為8,epoch設置為30。本文使用Pytorch實現所有的實驗,并在NVIDIA RTX 3090設備上進行測試,具體實驗環境配置如表8所示。

表8 實驗環境介紹Table 8 Introduction to environment experiment

4.3 評價標準

圖像質量評價一直是計算機視覺中的重要問題。本文使用研究人員提出的通用評價指標對不同數據集上的實驗結果進行分析。

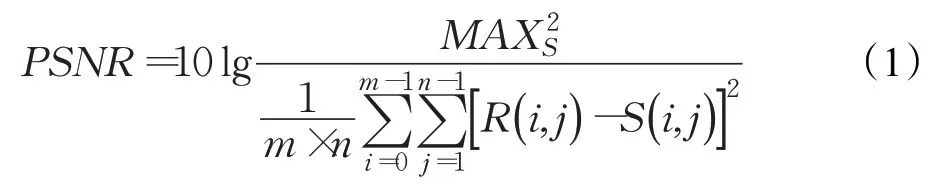

(1)峰值信噪比

峰值信噪比(peak signal to noise ratio,PSNR)[59]是一種十分常用的圖像質量評價準則,在圖像像素級別反映了待評價圖像與真實參考圖像間的統計差異性。通過計算對應像元間灰度差異的統計均值來反映相似性與圖像質量好壞:

其中,R為真實參考圖像,S為重建后的圖像,MAX為圖像點顏色的最大值,m、n為圖像的尺寸。

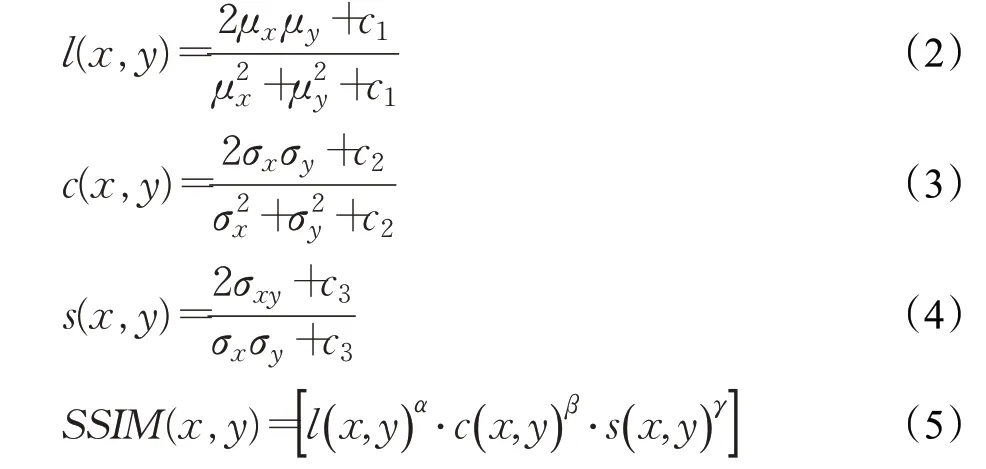

(2)結構自相似性

結構自相似性(structural similarity,SSIM)[60]是一種評價圖像質量的優良準則,主要認為人眼對圖像質量的評價是基于圖像中的結構信息,因此好的圖像質量應該能夠較好地保持恢復圖像中的結構信息,做到結構失真盡量最低。為此,提出了結構相似性測度:

其中,μx、σx分別為待評價圖像x的均值與標差,μy、σy分別為參考圖像y的均值與標準差,σxy為二者的協方差。通過式(5)可以看出,SSIM評價準則的取值范圍為-1到1,SSIM值越大,圖像質量越高。

(3)相對全局綜合誤差

相對全局綜合誤差(ERGAS)[61]用來計算所有波段出現的光譜錯誤率,主要評價融合圖像的波段的光譜質量,其公式如下:

其中,h為高分辨率的圖片的分辨率,l為低分辨率的圖片的分辨率,N為波段數,Bi為多光譜圖像,M i為多光譜圖像的輻射率的平均值。ERGAS值越小,表明在光譜范圍,融合后的圖像的光譜質量越好,光譜損失越少。

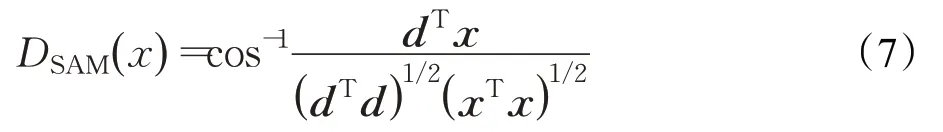

(4)光譜角相似度

普通圖像沒有光譜角相似度(spectral angle mapper,SAM)[62]這個概念,其只存在于多光譜和高光譜圖像,計算的是融合圖像的整體光譜扭曲度,用于度量原始高光譜數據與重構高光譜數據之間的光譜相似度,公式如下:

(5)空間相關系數

為了評估融合圖像與參考圖像空間細節的相似性,利用高通濾波器提取參考圖像的高頻信息,計算高頻信息之間的相關系數(correlation coefficient,CC)[63]。這種數量指標稱為空間相關系數。CC越高,說明融合過程中PAN圖像的大部分空間信息都被注入。計算融合圖像和參考圖像之間的CC,最終的CC在MS圖像的所有波段上取平均值。

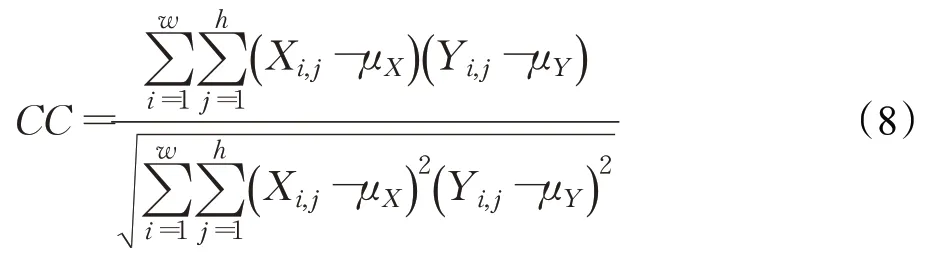

相關系數的計算為:

其中,X為融合圖像,Y為參考圖像,w和h為圖像的寬和高,μ表示圖像的平均值。

(6)均方根誤差

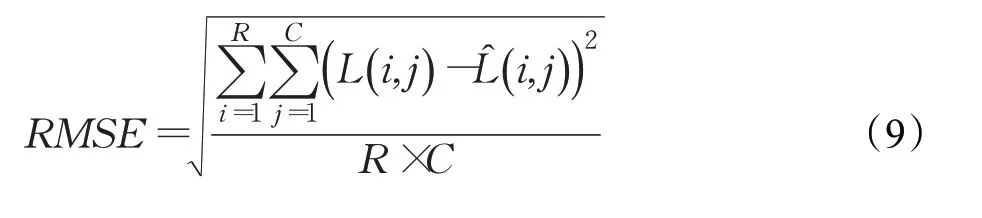

均方根誤差(root mean square error,RMSE)[64]表示融合結果與實際觀測圖像之間的輻射差異的全局描述,通過直接計算像素值的變化來比較融合結果與觀測圖像的差異。定義如下:

4) 通過小曲拐最大節點應力應變的變化趨勢得知3個小曲拐有相似的運動規律與受力狀況。符合小曲拐平面四桿機構的運動規律,為小曲拐進一步的優化提供重要的參考。

其中,L和L?分別表示實際觀測圖像和融合結果,R和C分別記錄圖像的寬度和高度。RMSE越小,預測效果越好。

4.4 實驗結果分析

4.4.1 定量分析

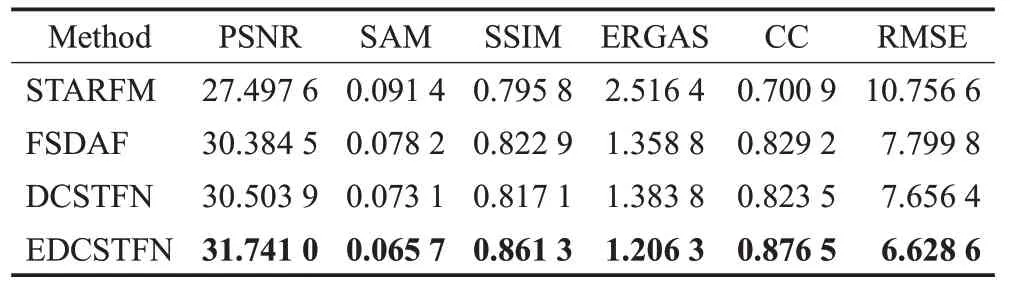

本實驗采用STARFM、FSDAF、DCSTFN、EDCSTFN作為基準模型,綜合超分辨率重建的評價指標,分別采用PSNR、SAM、SSIM、ERGAS、CC、RMSE評價模型性能。STARFM和FSDAF是傳統模型,DCSTFN是單分支的深度學習模型,EDCSTFN是雙分支的深度學習模型,并且由DCSTFN改進而來,選擇這四個模型可以有效地觀察傳統模型和深度學習模型的區別,以及單分支模型和雙分支模型之間的區別。

表9為基準模型在AHB數據集上的測試結果,傳統模型在峰值信噪比(PSNR)、光譜角映射器(SAM)、結構相似性(SSIM)、相對全局綜合尺度(ERGAS)、均方根誤差(RMSE)指標上都略低于深度學習模型,但在相關系數(CC)指標上要比深度學習的模型高。這是由于AHB數據集地物目標較多,現有的大多數深度學習時空融合模型對于多地物特征的重建有一定的困難。同時深度學習模型在提取特征方面具有獨特的優勢,使得模型在其他方面有不錯的效果。

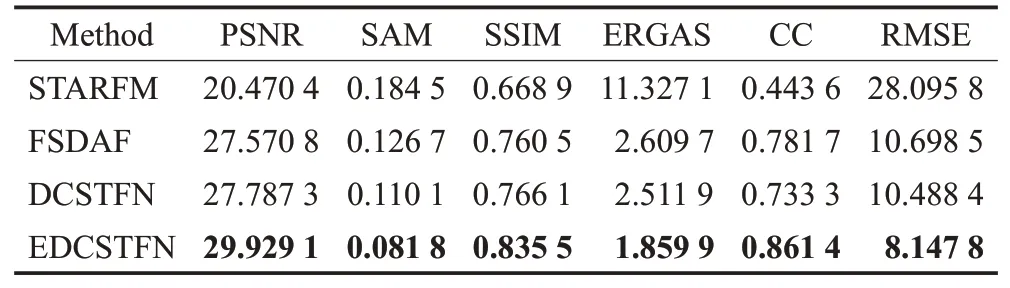

對于DX數據集和TJ數據集,深度學習模型的各方面指標都可以取得最好的效果,如表10和表11所示。在指標方面,部分指標不如AHB數據集上的效果優秀,是因為DX和TJ是城市數據集,城市擁有更多的細節特征需要模型學習。低分辨率圖像與高分辨率圖像的分辨率比值是1∶16,也給細節特征的提取帶來一些困難。

表10 DX數據集實驗結果Table 10 Experimental results of DX dataset

表11 TJ數據集實驗結果Table 11 Experimental results of TJ dataset

4.4.2 定性分析

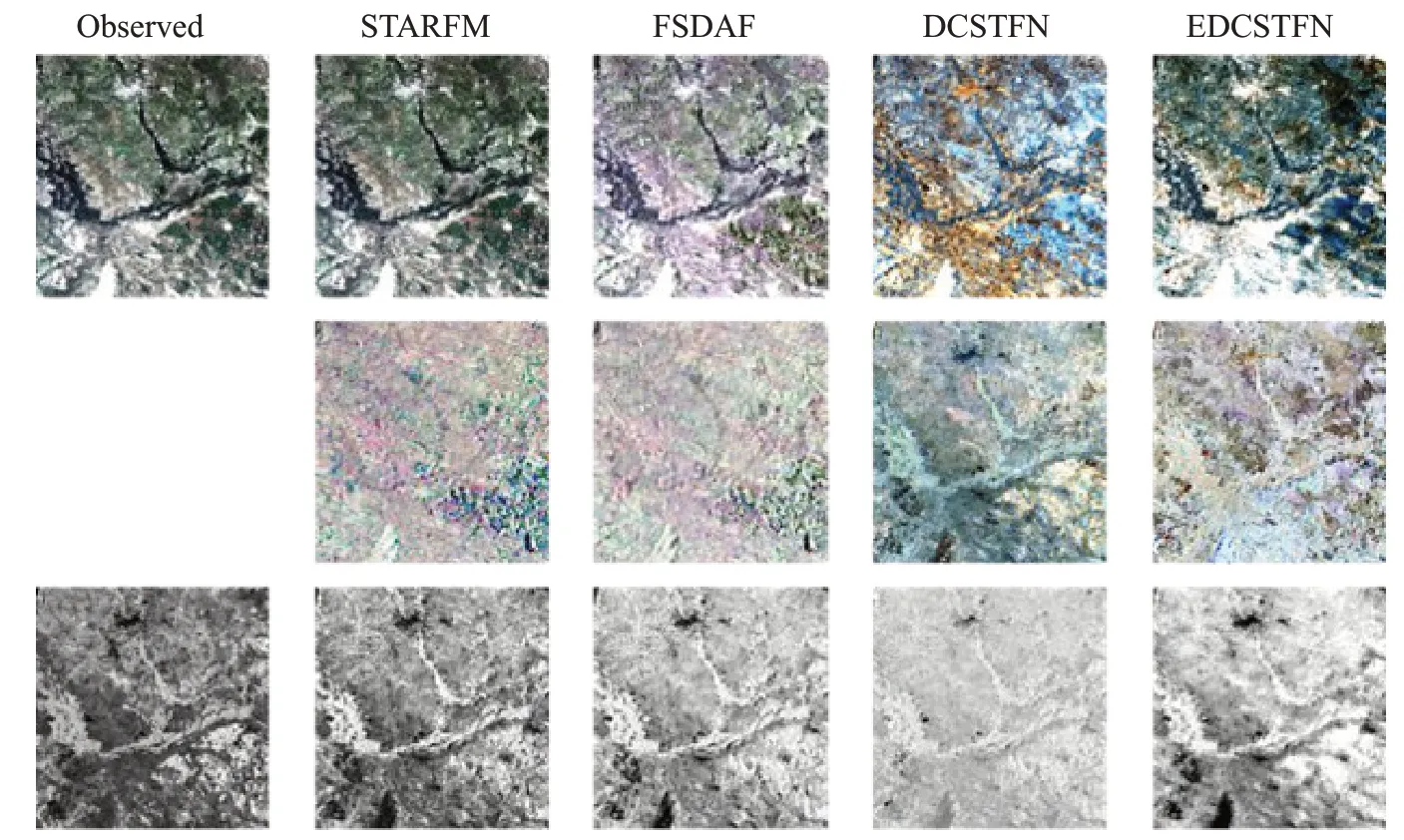

本實驗選擇了一些樣本圖片進行預測,并展示了它的預測結果。

圖10 AHB數據集部分樣例測試結果Fig.10 Sample test results of AHB dataset

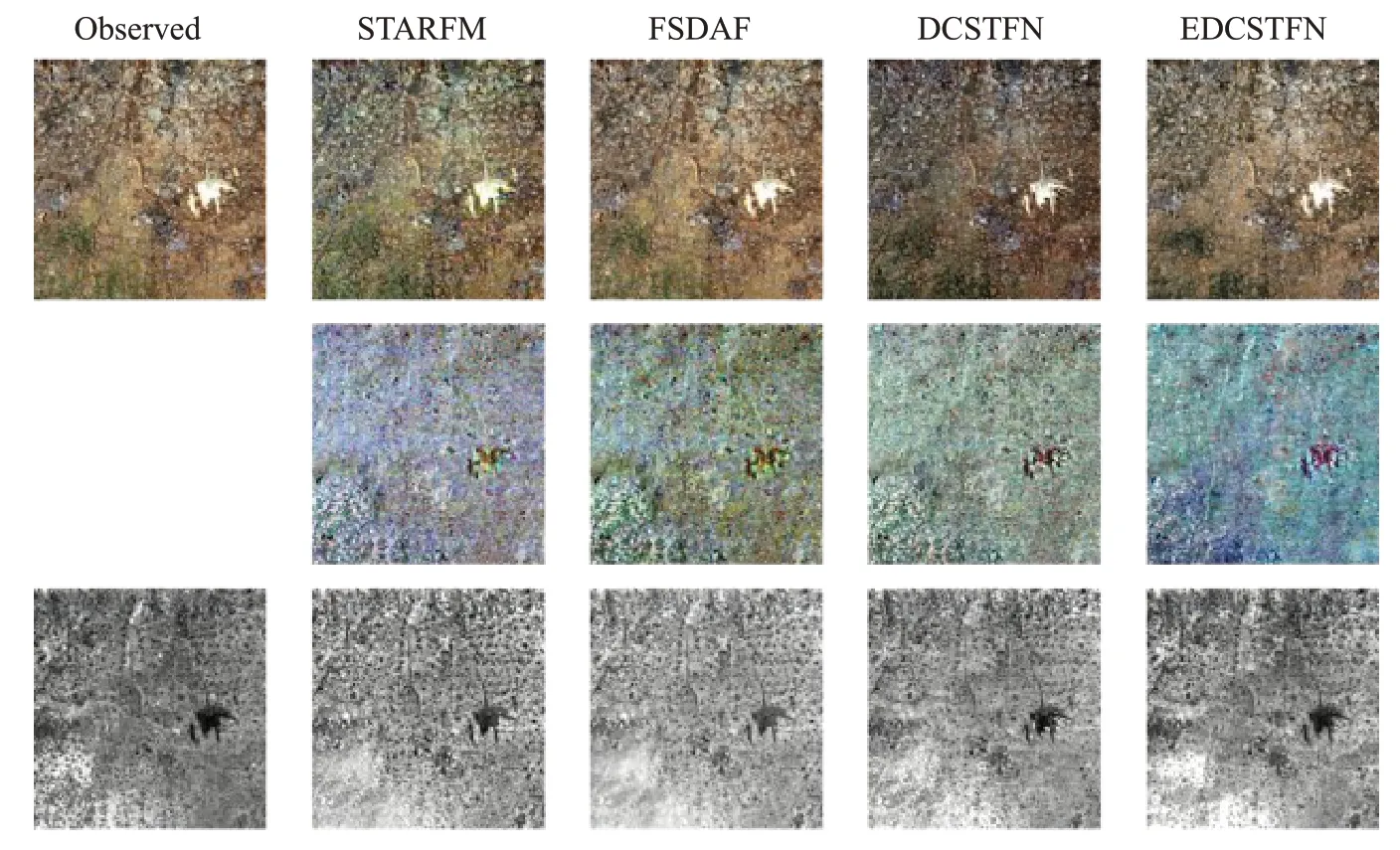

圖11顯示了在DX數據集上各個模型的預測結果圖。在DX數據集中,深度學習模型在每個指標上都要優于傳統學習模型,與AHB不同的是,DX數據集中主要是城市和農田,目標種類較少,在圖像全局效果方面得到了比較不錯的重建。但是也由于城市具有大量的細節特征,部分特征細節難以提取,使得指標略低于AHB數據集。

圖11 DX數據集部分樣例測試結果Fig.11 Sample test results of DX dataset

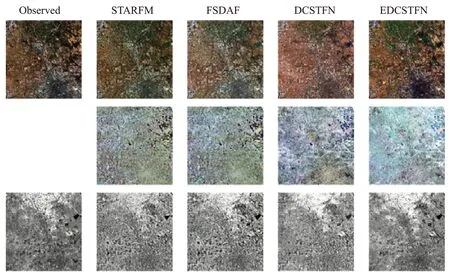

圖12顯示了在TJ數據集上各個模型的預測結果圖。與DX數據集相似,TJ數據集也主要包含城市和農村,目標種類較少,深度學習模型在每個指標上都要優于傳統學習模型,在圖像全局特征和局部特征細節方面也都有比較不錯的重建效果。

圖12 TJ數據集部分樣例測試結果Fig.12 Sample test results of TJ dataset

5 總結和展望

隨著遙感技術的發展,單一的衛星傳感器獲取到的遙感圖像已不能滿足實際應用的需求,遙感圖像時空融合技術作為解決該問題的有效方法,逐漸得到國內外研究學者的關注,尤其是將深度學習方法引入時空融合領域后,基于深度學習的時空融合算法在與傳統的時空融合算法比較中取得了明顯的優勢。本文總結了各類遙感圖像時空融合算法,著重分析了基于深度學習的時空融合模型的優勢和不足,并對時空融合模型的數據方面和模型方面做出如下展望。

(1)多源數據融合

在科技快速發展的支持下,已經有越來越多的衛星傳感器、無人機和雷達等可以獲取到各種類型的遙感圖像,而目前大多數時空融合算法使用兩種類型的數據進行融合,未來的時空融合方法可以考慮將多種類型的遙感數據結合起來。在融合過程中,來自不同傳感器的數據雖然有相似的光譜和空間結構,但它們難免會有差異,比如大氣條件、視角以及由位置偏差導致的像素差異。目前已有的大多數研究使用數據預處理等手段消除這種差異,但仍然難以將精度達到精細像素級。未來的研究可以考慮融合兩種及兩種以上的傳感器數據,在充分利用不同來源的數據信息的同時,降低不同傳感器數據之間的差異,結合不同數據的優勢,提高融合效果。

(2)半監督與無監督學習

在遙感圖像時空融合領域,大多是基于深度學習的有監督學習網絡,基于半監督和無監督學習的模型很少。在遙感領域,伴隨著傳感器的增多,數據也不斷增多,但能夠滿足研究時空融合條件的數據量還是較少,而具有標記的數量更是有限,只用有監督學習無法充分利用已有的數據。目前半監督和無監督學習已經在普通圖像分類、超分重建等領域逐漸成熟,然而在遙感圖像領域的應用很少,未來的研究可以充分考慮使用半監督和無監督學習應對可用數據少的問題。

(3)對時間序列的依賴性

目前的時空融合算法,大多利用一對或者兩對參考圖像提取到參考圖像與預測圖像之間的時間信息,將時間信息與空間信息進行融合進而得到預測日期的精細圖像。這種方法對參考圖像的日期選擇具有嚴格要求,需要預測日期前后兩個日期的參考圖像,且時間相隔不宜太長,然而在實際的應用中,通常無法滿足這種條件限制。目前已有研究使用可切換歸一化和生成式對抗網絡來降低對輸入圖像數量的限制,但仍需要在預測時對參考圖像進行時間的約束,且在某些復雜區域的預測效果并不如使用兩對參考圖像。如何利用已有的數據,在打破輸入數量限制和時間限制的同時,提升預測效果是使模型更具實用性的研究方向之一。

(4)模型泛化性能與效率

限制遙感圖像時空融合算法應用于實際應用的因素主要有以下兩點:模型泛化性和模型計算效率。

不同數據集的研究區域以及研究場景所需要考慮的情況不同,比如針對山區、森林的模型在生態環境監測中有較好預測結果,然而無法準確預測城市中具有大量人為因素的土地覆蓋變化情況。因此提高模型的泛化性,使一個模型能夠在多個不同地區以及不同類型的數據集上有相同的優秀效果至關重要。

另一方面,大多數傳統的時空融合方法是基于像素級計算和移動窗口策略,這種策略造成模型具有復雜性。除此之外,近年來基于生成式對抗網絡和基于Transformer的網絡在遙感圖像時空融合領域也取得了不錯的效果,然而這些模型也存在參數量大、計算時間長等問題。因此,提高模型計算效率,減少模型參數,減少預測所需要的時間,增強模型的實時性也是一個研究重點,是滿足實際應用的需求之一。