基于強化學習的5G URLLC承載網切片流量調度優化

甘浩宇 陳立豐 郭娘容 李佳灝

摘要:隨著5G通信技術的發展,各式各樣的網絡業務層出不窮。與此同時,新型網絡業務使得傳統通信承載網的基礎設施面臨著新的挑戰。一方面,有一部分新型網絡業務需要在5G網絡的超低時延超高可靠性條件下(Ultra-reliable and Low Latency Communications, URLLC)場景下進行服務,此業務需要5G網絡提供超低時延以及超高可靠性的通信保障。另一方面,此類型業務流量在傳統承載網架構下容易形成局部鏈路擁塞從而影響交付質量。為解決這些問題,提出了一種基于SDN軟件定義網絡與強化學習URLLC場景承載網切片流量管理方法。此方法利用SDN轉發與控制分離特性并借助深度強化學習來進行決策,從而達到最小化網絡負載的效果。通過仿真實驗,提出的流量調度方法優于傳統的基本管理方法。

關鍵詞:5G;網絡切片;SDN;深度強化學習;負載均衡

中圖分類號:TN914 ? ? ?文獻標識碼:A

文章編號:1009-3044(2022)13-0009-05

1 概述

近年來隨著通信技術的不斷發展,各式各樣的新型網絡通信業務應運而生,呈現出多場景、差異化特點[1],這對目前網絡基礎設施中有限的網絡資源提出更大的挑戰。

一方面,有相當一部分的網絡業務需要超低時延、超高可靠性的通信保障,另一方面,不同的網絡業務有不同的通信需求,例如:對于無人機巡檢,需要實時傳輸檢測視頻數據,傳輸數據量大,對帶寬要求較高;對于毫秒級精準負荷控制,則對時延要求較高[2],必須滿足不同業務的實際需求,才能保證業務服務質量。

5G通信技術的飛速發展為解決上述挑戰提供了一種新的思路與方法。5G是新一代蜂窩移動通信技術,是面向2020年以后移動通信需求而發展的新一代移動通信系統[3]。在文獻[4]中,作者設計了一個支持URLLC場景的無線系統模型,滿足URLLC場景下超低時延、超高可靠性的通信需求;文獻[5]則針對5G網絡中三種異構通信服務,提出一種溝通理論模型,保證服務質量。因此,研究和探討針對5G網絡切片的資源管理方法是有必要的。

針對URLLC場景下的業務需求,傳統承載網的基礎網絡架構暴露出較多缺陷[6]。比如,傳統通信網絡中的流量管理往往基于最短路徑轉發原則,無法適應WAN網絡流量的動態變化,經常使得網絡設施中某處通信鏈路負載過大,而資源豐富的鏈路或者節點則被空置的狀況。

目前傳統的網絡流量調控往往是基于單獨節點的網絡設備進行管理,無法從基于全局從整體性上對整個網絡拓撲進行監控與調節從而實現全局最優。

SDN(軟件定義網絡)技術作為5G通信的基礎技術,可以在網絡流量管控過程中發揮巨大作用。相較于傳統流量調度技術,SDN技術實現了節點控制與流量轉發解耦的能力,以此達到了針對整個拓撲網絡的全局統一控制,使得網絡監控應用能夠實現流量的動態調度[7]。例如,當網絡流量發生異常波動而導致擁塞,傳統網絡管理技術需要針對所有網絡設備進行排查與調整,而 SDN 架構由于控制功能和底層物理設備相分離,控制功能由控制器集中管理,只需要簡單地修改應用指令就可以實現對網絡的管控,相對于傳統網絡管理的煩瑣工作, SDN 架構使工作效率大大提高,網絡更加穩定[8]。

目前傳統蜂窩網絡中流量調控與負載均衡算法已被大量研究,如小區呼吸技術[9] 已被廣泛應用于第二代和第三代移動通信網絡中。由 X. Lin 和 S. Wang 提出的 Cloud RAN 中的高效 RRH 切換機制在考慮系統能效條件下實現了流量負載優化[10]。C. Ran 和 S. Wang 等人[11] 從另一個角度提出了 Cloud RAN 中的最佳負載均衡算法。通過周期性地監控衡量均衡度的公平指數,當其低于特定閾值時,則重新設計每個小區覆蓋的區域以實現系統的負載均衡。

綜合考慮面向5G網絡通信資源的管理和流量調度管理,在實際資源管理過程中,傳統的算法往往是基于啟發式算法進行流量調控,在計算的過程中一般會增加控制器的計算負擔,并且隨著用戶數量的增加,需要在巨大的決策空間中選擇最優決策,耗時較長,而人工智能領域一個新的研究熱點——深度強化學習,將深度學習的感知能力與強化學習的決策能力相結合,能讓模型在不斷的學習過程中自主選擇最優策略,降低決策時間[12]。

基于上述的考慮,本文針對URLLC場景下網絡切片,提出了一種基于深度強化學習的承載網網絡流量調度管理方法。可以動態地依據整體網絡拓撲運行狀況,彈性地為不同的通信業務流量分配鏈路資源,針對不同業務,在保證其時延和可靠性要求的同時,滿足不同業務的個性化需求,同時優化整體網絡拓撲的負載程度。

2 系統模型

如圖1所示,針對URLLC場景下多種業務需求可將承載網通信管道切分為軟件管道,在SDN上的實現主要是依據需求將物理鏈路資源映射為不同的虛擬子網切片,為不同的網絡業務分配切片資源,在保證其時延和可靠性要求的同時,滿足不同用戶的個性化需求。如在物聯網領域,URLLC場景下業務大致可分為移動應用類、信息采集類和生產控制類三種[13]。

本文針對5G承載網切片網絡中的流量調度問題以優化網絡負載均衡狀況為切入點,在通過網絡虛擬化工作將網絡拓撲映射為若干個虛擬子網后,通過強化學習智能體對不同業務在各個虛擬子網中的流量導向進行調控,從而達到整體網絡負載較為均衡的狀況。

2.1 整體架構

本文提出的切片網絡流量優化技術架構主要如圖2所示,各層級介紹如下:

基礎物理架構層是由一系列SDN可控交換機組成的物理拓撲[14],該層接受SDN控制器的流量監控、重定向以及鏈路映射指令。

子網切片層是利用SDN的網絡虛擬化工具,將不同鏈路映射為對應的虛擬子網,并通過流量重定向將流量走向重定向至由不同鏈路以及節點組成的虛擬子網,以此實現不同業務之間的端到端切片。

而由OpenDaylight及其VTN組件組成的控制層則負責監控整體網絡流量,連接應用層與網絡拓撲,統籌全局網絡,并使用北向接口接受應用層的控制策略,同時借助南向接口向切片層傳遞控制信息。

頂層為運行網絡流量負載均衡優化算法的強化學習智能體,其收集整個網絡的拓撲資源信息以及數據流量狀況從而生成控制策略,然后將控制策略下發至控制層。

2.2 負載均衡模型

負載均衡中流量調度問題可以被建模成一個多商品流問題,多商品流問題(Multi-Commodity Flow Problem)是多種商品(或貨物)在網絡中從不同的源節點流到不同宿節點的網絡流問題。多商品流問題的目標是以最小的成本實現商品在網絡中的流通,且不能超過每條邊的承載能力。

本文中的拓撲模型可泛化作為無向圖G=(V , E)其中V是圖G所有節點即物理交換機的集合,E是圖G中所有邊的集合即整個網絡拓撲中的物理鏈路。本文涉及網絡切片多業務場景,故記[I]為所有業務組成的集合。對于業務[i∈I],一個相鄰節點對之間的單條鏈路可表示為[wi],則[wi∈E],不同鏈路中資源與能力存在一定差異,每條鏈路中的總帶寬資源記為[cw]。

對于V集合中任意一組節點對記為v,所有節點對的集合為K,記v之間的一條鏈路記為業務i的業務切片[si],則K集所有節點對之間網絡切片記為S,節點對v之間針對業務i的所有流量路徑集合記為[Pvi]。將整體拓撲中所有節點對之間的流量請求矩陣記為M,則v之間的業務i流量請求可記為[mvi]。在多業務運行過程中,不同業務會在同一切片中產生競態情況,也就是同一切片中可能會經過多種業務流量,所以這里需要定義變量[xsi∈[0,1]]表示業務i在切片s中的與其他的業務資源占比,當業務i優先級高于其他業務或者無其他業務存在時,[xsi=1],如果當前網絡切片不存在業務[i]或者優先級完全低于其他業務時[xsi=0],當業務[i]需要與其他業務部分共享切片資源時變量[xsi∈(0,1)]。

本文的關鍵在于如何找到多商品流問題的資源分配問題,其目標主要是依據業務優先級以及資源分配需求,保證主要業務在多業務運行環境下的網絡拓撲中運行性能。

首先針對切片資源占有進行建模,定義業務[i]的整體切片資源占有率[Ui],用以表示當前業務流量大小和當前所在物理鏈路帶寬的比值,從而可以反映出鏈路的資源使用情況。

[Uiw=pi∈Pw∈pis,d∈Kxwimvicw] ? ? ? ? ? ? ? ? ? ? (1)

計算出鏈路的資源使用后,可通過所有鏈路中的不同業務上的鏈路利用率的最大值與最小值的差值的平均值來反映鏈路上負載均衡狀況,值越小,說明資源分配較為均衡,負載處于較為均衡狀態。

[δ=i∈ImaxUiw-minUiwI] ? ? ? ? ? ? ? ? ? ? ? ? (2)

同時由于網絡流量存在瞬時激增或速降的狀況,當前時刻的負載均衡值并不能良好地反映網絡狀況,以至于干擾后續拓撲鏈路決策,本文采用梯度更新的方式對負載均衡值進行更新。

[δ=δt+?δt-δt-1] ? ? ? ? ? ? ? ? ? ? (3)

對于流量傳輸過程中的時延信息,一般認為鏈路上的時延與流量擁堵程度成正比,因此對于整體網絡拓撲的時延,其定義如下:

[Ti=αEwi∈Emvicw] ? ? ? ? ? ? ? ? ? ? ?(4)

3 目標函數及解決方法

3.1 問題描述

在本文中,我們希望系統可以在滿足業務時延要求和高可靠性的條件下,盡量采用負載均衡度高的切片鏈路分配與虛擬子網映射方案來進行任務的傳輸。因此我們定義整個系統所要優化的目標函數如下所示:

[min δ] ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? (5)

[p∈Pvixwi=1][] ? ? ? ? ? ? ? ? ? ?(6)

[xwi∈0,1] ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? (7)

式(5)為目標函數,其目的是最小化網絡負載均衡度;式(6)表示當前時刻業務i所有的流量請求都會被分配到對應的虛擬子網切片上。式(7)保證分配到各自虛擬子網切片以及多重映射的鏈路的業務占比不得為負值或者超過鏈路資源。

3.2 解決方法

針對以上場景,本文提出一種基于DQN(Deep Deterministic Policy Gradient)流量管理方法,其網絡結構如圖3所示。其基本原理是DQN智能體與環境不斷交互,獲得當前環境狀態,然后隨機抽樣選擇一個動作執行,執行完該動作后,環境會從當前狀態以某個概率轉移到另一個狀態,同時智能體會接收到環境反饋的一個獎勵或懲罰。在此過程中不斷收斂Q函數,并增大從環境中獲取的獎勵。

DQN智能體每完成一次虛擬子網切片間的流量調度,進而得到該網絡拓撲的整體負載均衡程度,從而給智能體反饋一個獎勵或者懲罰。智能體將當前環境狀態、資源分配動作、反饋獎勵和環境下一個狀態組成一個四元組,作為一個樣本存儲到記憶池。通過記憶回放機制,智能體會根據訓練周期配置從記憶池隨機選取mini-batch樣本數據對智能體進行強化訓練,從而不斷更新神經網絡的系數來降低損失[15]。

將上述過程可轉成強化學習語言,即狀態空間State、動作空間Action和獎勵回報函數Reward這3個基本要素[16],針對本文場景,定義如下:

1)狀態空間,表示當前一次網絡測量中所有流量請求和所有鏈路的時延,鏈路利用率以及鏈路策略信息,具體與前文中三個變量相對應:整體拓撲時延[Ti],資源利用率[Uiw]以及鏈路分配比重[xiw]。

2)動作空間,表示DQN智能體根據環境狀態所做出的策略合集,在本文場景中對應著業務流量在不同虛擬子網路徑中的分流比重。DQN智能體每獲取一個狀態,便會根據Q值從動作空間選擇相應動作執行。對于DQN網絡中的策略函數[π],其動作空間函數與策略函數關系如式(8)所示。

[at=πst] ? ? ? ? ? ? ? ? ? ? ? ? ? ? (8)

3)獎勵回報函數。表示環境交互所反饋的獎勵回報。在每次迭代中,智能體都會根據當前的環境狀態選取并執行一個動作,然后環境轉移至下一個狀態并反饋給智能體一個回報獎勵。本模型中,負載均衡優化模型的優化目標是最小化負載均衡度[δ],本文將獎勵定義為負載均衡度的倒數,以此來最大化獎勵。定義如式(9)所示,[rt]和[δt]分別表示t時刻獎勵與負載均衡度,[β]為獎勵系數。

[rt=βδt] ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?(9)

3.3 算法流程

1. 隨機初始化動作值函數Q即網絡Q

2. 初始化replay memory D

3. 初始化經驗池

4. for each episode:

5. ? 初始化網絡輸入[s1=x1],計算出網絡輸出

6. ? for t = 0 to T:

7. ? ? ?根據概率密度函數隨機采樣動作[at]

8. ? ? ?否則選擇[at=maxαQ*?st,a,θ]

9. ? ? ?執行動作[at],得到獎勵[rt]和下一個網絡的輸入[xt+1]

10. ? ? [st+1=st,?t+1=?(st+1)]

11. ? ? 將[(?t,at,rt,?t+1)]作為此刻的狀態存入到D

12. ? 隨機從D中取出mini batch個狀態[(?j,aj,rj,?j+1)]

13. ? ? ?[yj=rj ? ? ? ? ? ? ? ? ? ? ? ? ? for terminal ?j+1rj+γmaxa'Q(?j+1,a';θ) otherwise]

14. 執行梯度下降

15. ? end for

16. end for

4 實驗仿真

4.1 環境配置

本文實驗利用Mininet網絡仿真平臺來搭建網絡拓撲,使用OpenDaylight控制器作為調控整個網絡流量的控制器,并使用OpenDaylight的VTN組件進行流量調度。強化學習算法基于TensorFlow框架實現。網絡拓撲架構基于traffic-matrices-anonymized提供的其中四個網絡拓撲結構實現,每個拓撲模型其中包含23個交換機拓撲節點和48條物理鏈路,每條鏈路的帶寬資源承載能力都存在一定差異。

4.2 仿真數據

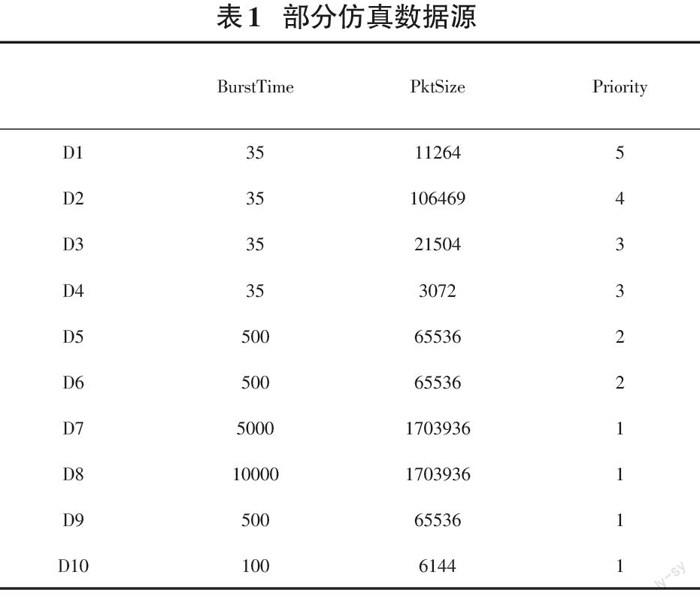

針對URLLC場景下的多種業務的流量特點,仿真數據源應滿足以下特點:

網絡中應經常有碰撞、擁塞等情況的發生。

不同的端系統可能在短時間內同時發送多個數據流,且大小、持續時間各不相同。

承載網承擔著不同的應用,各應用產生的數據流的優先級不同。

基于以上考慮,仿真所用的部分數據源如表1所示,BurstTime為數據流的持續時間(ms),PktSize 是其大小(KB),Priority 為數據流本身的優先級。

4.3 仿真結果

4.3.1算法收斂

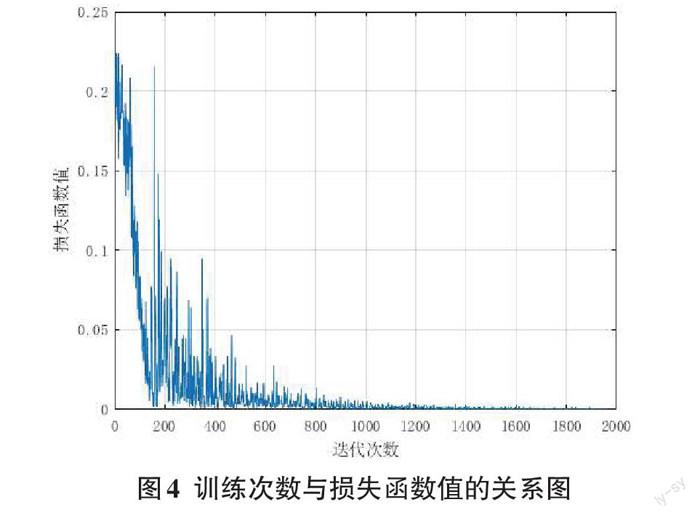

圖4描述了算法收斂性描述了基于DQN的網絡流量調控管理算法的收斂性,隨著訓練次數增加,損失函數值逐漸趨近于局部最優值,算法收斂。

4.3.2 方案對比

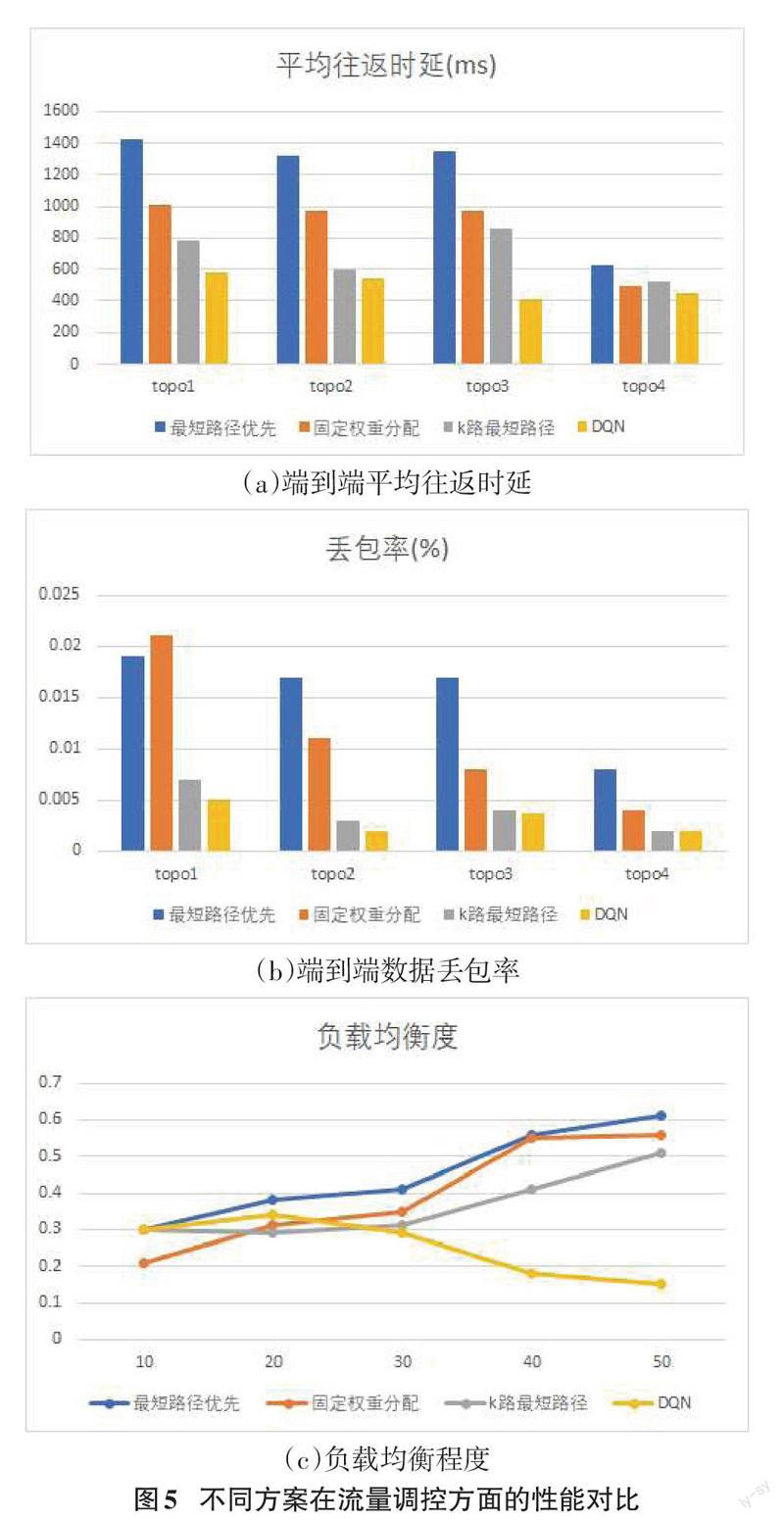

除了本文提出的流量調控方案,還設置了三個對比方案。

1)最短路徑優先,根據該策略,在傳輸數據過程中會優先選擇長度最短的路徑作為數據通路,但該方案沒有考慮到負載堆積狀況,容易陷入局部鏈路擁塞。

2)固定權重分配,該方案會針對路徑設置固定權重,并依據不同鏈路之間的權重占比來決定該由哪條鏈路進行數據傳輸。

3)k路最短路徑,該策略會在兩點之間分配路徑最短的前K條鏈路路徑作為工作的虛擬子網切片,以此來承載流量傳輸業務。

圖5(a)、(b)可以看出在不同拓撲模型中,在網絡時延以及穩定性方面采用本文DQN控制策略明顯優于傳統負載均衡策略,并且隨著流量請求速率不斷增大,采用DQN策略的流量調度方案有著更好的性能。

5 結束語

在5G時代的通信承載網系統中,一方面要面臨大量用戶接入網絡流量同時涌入而導致擁塞的風險,另一方面,不同的業務有不同的通信需求,需要為不同的互聯網業務提供個性化的通信服務,面對這樣的挑戰,設計一種基于切片網絡的彈性流量調控方法至關重要。本文提出了一種面向5G承載網切片網絡的多業務流量優化方案。該方案基于深度強化學習,能夠依據劃分的虛擬子網切片,制定鏈路策略,對擁塞鏈路進行疏導。與傳統算法相比,本文提出的方案確保了流量傳輸時延和數據丟包率,提高了整體網絡的負載均衡度,提高了網絡的可靠性。

參考文獻:

[1] ?5G White Paper V1.0[R]. Germany: NGMN, 2015.

[2] Liu C F,Bennis M,Poor H V.Latency and reliability-aware task offloading and resource allocation for mobile edge computing[J].2017 IEEE Globecom Workshops (GC Wkshps),2017:1-7.

[3] Popovski P,Trillingsgaard K F,Simeone O,et al.5G wireless network slicing for eMBB,URLLC,and mMTC:a communication-theoretic view[J].IEEE Access,2018,6:55765-55779.

[4] Anand A,de Veciana G.Resource allocation and HARQ optimization for URLLC traffic in 5G wireless networks[J].IEEE Journal on Selected Areas in Communications,2018,36(11):2411-2421.

[5] 施巍松,孫輝,曹杰,等.邊緣計算:萬物互聯時代新型計算模型[J].計算機研究與發展,2017,54(5):907-924.

[6] 丁澤柳,郭得科,申建偉,等.面向云計算的數據中心網絡拓撲研究[J].國防科技大學學報,2011,33(6):1-6.

[7] 張朝昆,崔勇,唐翯祎,等.軟件定義網絡(SDN)研究進展[J].軟件學報,2015,26(1):62-81.

[8] 樊自甫,李書,張丹.基于流量調度的SDN數據中心網絡擁塞控制算法[J].計算機科學,2017,44(S1):266-269,273.

[9] Niu Z S,Wu Y Q,Gong J,et al.Cell zooming for cost-efficient green cellular networks[C]//IEEE Communications Magazine.IEEE,2010:74-79.

[10] Lin X J,Wang S W.Efficient remote radio head switching scheme in cloud radio access network:a load balancing perspective[C]//IEEE INFOCOM 2017 - IEEE Conference on Computer Communications.May 1-4,2017,Atlanta,GA,USA.IEEE,2017:1-9.

[11] Ran C,Wang S W,Wang C G.Optimal load balancing in cloud radio access networks[C]//2015 IEEE Wireless Communications and Networking Conference.March 9-12,2015,New Orleans,LA,USA.IEEE,2015:1006-1011.

[12] 劉全,翟建偉,章宗長,等.深度強化學習綜述[J].計算機學報,2018,41(1):1-27.

[13] Gungor V C,Sahin D,Kocak T,et al.A survey on smart grid potential applications and communication requirements[J].IEEE Transactions on Industrial Informatics,2013,9(1):28-42.

[14] Lei K,Liang Y Z,Li W.Congestion control in SDN-based networks via multi-task deep reinforcement learning[J].IEEE Network,2020,34(4):28-34.

[15] Wu Z Q,Wei J,Zhang F,et al.MDLB:a metadata dynamic load balancing mechanism based on reinforcement learning[J].Frontiers of Information Technology & Electronic Engineering,2020,21(7):1034-1046.

[16] MS Ali,Coucheney P,Coupechoux M.Reinforcement Learning Algorithm for Load Balancing in Self Organizing Networks[EB/OL].[2021-08-10].https://onlinelibrary.wiley.com/doi/10.1002/9781119471509.w5GRef137.

【通聯編輯:梁書】