基于圖像翻轉變換的對抗樣本生成方法

楊博,張恒巍*,李哲銘,2,徐開勇

(1.中國人民解放軍戰略支援部隊信息工程大學,鄭州 450001;2.中國人民解放軍陸軍參謀部,北京 100000)

0 引言

在圖像識別領域,一些標準測試集上的實驗結果表明深度神經網絡的識別能力已經超過人類的水平[1-4]。然而,在深度學習帶給人們巨大便利的同時,其本身也存在一些安全性問題。對于一個非正常的輸入,深度神經網絡是否依然能夠得出滿意的結果,其中隱含的安全問題也漸漸引起人們的關注。深度神經網絡已經被證實容易受到對抗樣本的攻擊[5-6],它是通過在原始輸入圖像中添加人類不易察覺的附加擾動導致模型誤分類而產生的。如圖1 所示,盡管添加了擾動的“靛青鳥”圖像(圖(c))與原始的“靛青鳥”圖像(圖(a))在視覺上沒有明顯區別,即對抗擾動(圖(b))非常小,但是深度神經網絡還是將添加了擾動的“靛青鳥”圖像(圖(c))以98.9%的置信度錯誤分類為“大白鯊”。直觀上來看,對抗擾動與隨機噪聲有一定的相似性,但兩者卻有著根本性區別。首先,對抗擾動是人為精心設計生成的,而不是隨機生成的,能夠用來誤導神經網絡;其次,相較于訓練數據中的正常隨機噪聲,對抗擾動是在測試網絡時添加的噪聲,因此不參與網絡訓練;然后,對抗擾動十分微小,使得原始圖像與對抗樣本在視覺上沒有明顯差別,兩者不易區分[7];此外,對抗樣本具有一定的遷移性,即針對一個模型生成的對抗樣本可能對另一個模型也是對抗的,這種現象使得黑盒攻擊成為可能[8],更加凸顯了其威脅性。因此,攻擊性能強的對抗樣本可以用于攻擊測試神經網絡模型,從而作為評估模型魯棒性的重要工具,還可以作為對抗訓練的輸入改善模型的魯棒性。

圖1 原始圖像、對抗擾動與對抗樣本的示例Fig.1 Examples of original image,adversarial perturbation and adversarial example

雖然對抗樣本具有可遷移性,但如何進一步提高其遷移性以進行有效的黑盒攻擊仍然有待研究。一些基于梯度的攻擊方法被提出以尋找對抗樣本,例如單步攻擊方法[6]和迭代攻擊方法[9-10]。在白盒攻擊場景下,這些方法表現出強大的攻擊能力,然而在黑盒設置下,上述方法的攻擊成功率卻比較低。這被認為是對抗樣本發生了“過擬合”,即同一對抗樣本在白盒和黑盒設置下的攻擊能力類似于同一神經網絡在訓練集與測試集上的表現差異。因此,將提高深度學習模型性能的方法用于對抗樣本的生成過程中,以此減輕“過擬合”,從而提高對抗樣本的可遷移性。已經有很多方法被提出以提升深度神經網絡的性能[1-2,10-13],數據增強[1-2]就是其中之一。數據增強能夠有效防止深度神經網絡訓練過程中的過擬合,提升模型的泛化能力。

本文從數據增強的角度出發,優化對抗樣本的生成過程,提出了基于圖像翻轉變換的生成方法以提高對抗樣本的可遷移性。

本文的主要工作如下:

1)受數據增強[1-2]的啟發,將圖像翻轉變換引入對抗攻擊中,通過對輸入圖像進行隨機翻轉變換,從而有效地減輕對抗樣本生成過程中的過擬合,提升對抗樣本的可遷移性。

2)通過調整相關的參數,本文方法可以與現有的基于梯度的對抗樣本生成方法進行關聯和變換,充分體現了本文方法的優勢和便利性。

3)在ImageNet 數據集[14]上的大量實驗結果表明,與現有的傳統攻擊方法[9-10]相比,本文提出的圖像翻轉變換攻擊方法有著更好的攻擊性能,實現了黑盒攻擊成功率的較大提升,提升了對抗樣本的遷移性。因此,本文所提出的攻擊方法有助于評估不同模型的魯棒性。

1 相關工作

1.1 對抗樣本生成方法

Biggio 等[15]首次基于MNIST(Modified National Institute of Standards and Technology)數據集[16]針對傳統的機器學習分類器進行了“逃避攻擊”,即讓模型分類錯誤,說明傳統的機器學習算法容易受到對抗樣本的攻擊。Szegedy 等[5]在研究中發現了深度神經網絡的有趣特性,即深度神經網絡面對對抗樣本的攻擊是非常脆弱的,并提出了基于優化的LBFGS(Limited-memory Broyden-Fletcher-Goldfarb-Shanno)方法生成對抗樣本。Goodfellow 等[6]提出了僅執行一個梯度步長就能生成對抗樣本的快速梯度符號法(Fast Gradient Sign Method,FGSM),該方法降低了生成對抗樣本的計算成本。Kurakin 等[9]將FGSM 方法擴展為多步迭代版本I-FGSM(Iterative FGSM),大幅提高了白盒攻擊成功率,并且證明了對抗樣本也可能存在于物理世界中。Dong 等[10]提出了MIFGSM(Momentum I-FGSM),以此穩定梯度更新方向,優化收斂過程,提高對抗樣本的遷移性。相關研究人員還證明了物理世界中也可能存在對抗樣本[9,17],而不僅僅存在于數字模型中,這給深度神經網絡的實際應用帶來了安全威脅。

1.2 對抗樣本防御方法

面對對抗樣本的威脅,大量關于對抗樣本防御的方法被提出以保護深度學習模型[18-21]。對抗訓練[6,22-23]是其中很重要的一種防御方法,它將對抗樣本引入到訓練數據中參與模型訓練,提高了模型的魯棒性。Liao 等[19]提出了高級表示引導去噪器來凈化對抗樣本,以此消除對抗樣本的影響。Guo等[20]發現存在一系列圖像變換,它們有可能在保持圖像關鍵視覺內容的同時消除對抗擾動。Samangouei 等[21]利用生成模型將對抗樣本移回到原始干凈圖像的分布來凈化對抗樣本,降低對抗樣本的影響。Tramèr 等[23]提出了集成對抗訓練,該方法利用針對其他模型生成的對抗樣本來增加訓練數據,進一步提高了模型的魯棒性,由該方法訓練的模型也成為了評價對抗樣本攻擊能力的標準模型。

2 FT-MI-FGSM方法

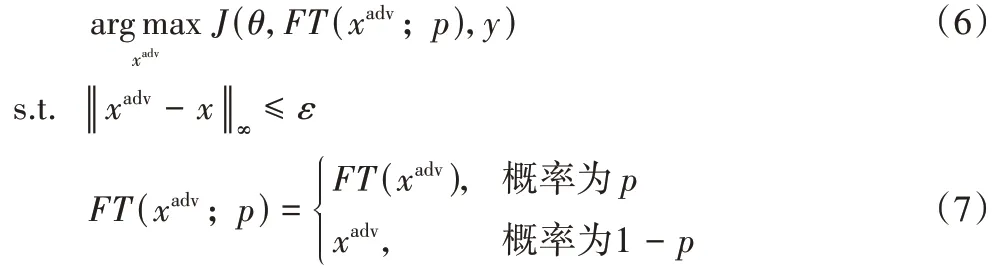

令x和y分別為原始輸入圖像和對應的真實標簽,θ是模型的參數。J(θ,x,y)是神經網絡的損失函數,通常是交叉熵損失函數。對抗樣本生成的目標是通過最大化J(θ,x,y)來生成一個與x視覺上不可區分的對抗樣本xadv來愚弄模型,即讓模型對對抗樣本xadv進行錯誤分類。在本文中,使用無窮范數對對抗擾動進行了限制,即‖ ‖xadv-x∞≤ε。因此對抗樣本生成可轉化為以下條件約束優化問題:

2.1 基于梯度的生成方法

由于本文方法是在基于梯度的生成方法基礎上改進而來的,故在本節中,首先簡要介紹生成對抗樣本的幾種梯度方法。

FGSM(Fast Gradient Sign Method)[6]是最簡單的對抗樣本生成方法之一,其在損失函數關于輸入的梯度方向上尋找對抗樣本,并對對抗擾動予以無窮范數限制。更新公式如下:

I-FGSM[9]是FGSM 的迭代版本,它將FGSM 中的梯度運算分成多步迭代進行,以此減輕單步攻擊帶來的“欠擬合”。該方法可表示為:

其中:α是每次迭代的步長,α=ε/T,T為迭代次數;Clip 函數的作用是將對抗樣本約束在原始圖像x的ε鄰域內,以滿足無窮范數約束。

MI-FGSM[10]首次提出將動量運用到對抗樣本生成過程中,動量項能夠穩定梯度更新方向,改進了收斂過程,從而大幅度提高了攻擊成功率。與I-FGSM 相比,MI-FGSM 的不同在于對抗樣本的更新方向不一樣:

其中:μ是動量項的衰減因子;gt是前t輪迭代的梯度加權累積。

PGD(Projected Gradient Descent)[17]是對FGSM 的改進,是FGSM 的強迭代版本,它提高了對抗樣本的攻擊成功率。

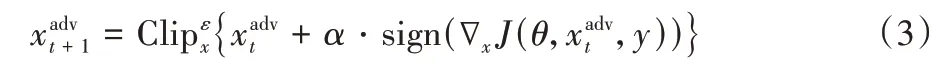

2.2 圖像翻轉變換生成方法

數據增強[1-2]被證明是在深度神經網絡訓練過程中防止網絡過擬合的一種有效方法。基于此,本文提出了圖像翻轉變換攻擊方法,其總體思路如圖2 所示。

圖2 圖像翻轉變換生成方法框架Fig.2 Framework of image flipping transformation generation method

該方法在每次迭代時對原始輸入圖像以p的概率進行隨機翻轉變換,以緩解過擬合現象。該方法對隨機翻轉變換的圖像的對抗擾動進行優化:

圖像變換函數FT(·)是圖像翻轉的調整,它將輸入圖像進行左右翻轉,轉換概率p控制著原始輸入圖像和變換圖像之間的平衡。采用這種方法,可以通過數據增強來實現對模型的有效攻擊,從而避免白盒模型的“過度擬合”攻擊,提高對抗樣本的可遷移性。

2.3 圖像翻轉變換生成算法描述

針對對抗樣本的生成過程,FT-MI-FGSM 引入了數據增強,緩解了過擬合現象,提升了對抗樣本的可遷移性。此外,FT-MI-FGSM 可通過不同的參數設置與FGSM 類方法進行關聯,例如轉換概率p=0,則FT-MI-FGSM 退化為MI-FGSM,即去掉算法1 的第4)步就可以得到MI-FGSM 攻擊算法,這體現了本文方法的優勢與算法便利性。圖3 對不同的對抗樣本生成算法之間的關系進行了展示。算法1~2 對單模型和集成模型下的FT-MI-FGSM 生成算法進行了總結。

圖3 不同對抗樣本生成算法關系Fig.3 Relationship between different adversarial example generation algorithms

算法1 FT-MI-FGSM(單個模型)。

輸入原始干凈圖像x以及對應的分類標簽y;神經網絡f和損失函數J;擾動大小ε;迭代輪數T和衰減因子μ。

輸出對抗樣本xadv。

算法2 FT-MI-FGSM(集成模型)。

輸入原始干凈圖像x以及對應的分類標簽y;K個深度神經網絡f(f1,f2,…,fK),對應的網絡邏輯值l(l1,l2,…,lK)以及相應的網絡集成權重ω(ω1,ω2,…,ωK);擾動大小ε;迭代輪數T和衰減因子μ。

輸出對抗樣本xadv。

3 實驗與結果分析

3.1 實驗設置

如果原始圖像不能被網絡正確分類,那么基于這些圖像生成對抗樣本則沒什么意義。因此,本文從ImageNet 驗證集中隨機選擇1 000 張屬于1 000 個類別的圖像(即一個類別選取一張圖像),這些圖像都能夠被測試的網絡正確分類。所有圖像都事先調整為299 × 299 × 3。

在實驗中,對于超參數,本文遵循文獻[10]中的設置,擾動為ε=16,迭代次數T=10,步長α=1.6。對于MIFGSM,衰減系數默認為μ=1.0。對于隨機變換函數FT(xadv;p),轉換概率p=0.5。為了對隨機翻轉變換有直觀的認識,圖4 對隨機翻轉變換后的部分圖像進行了展示。

圖4 原始圖像、變換后圖像以及對應生成的對抗樣本Fig.4 Original images,transformed images and the corresponding generated adversarial examples

在實驗中一共研究了7 個網絡,其中包括4 個正常訓練的網絡,即Inception-v3(Inc-v3)[24]、Inception-v4(Inc-v4)[25]、Inception-Resnet-v2(IncRes-v2)[25]和 Resnet-v2-101(Res-101)[26],以及3 個經過對抗訓練的網絡[23],即Inc-v3ens3、Incv3ens4和IncRes-v2ens。

3.2 單個網絡攻擊

首先對單個網絡進行了攻擊。使用I-FGSM,MI-FGSM以及FT-MI-FGSM 方法在正常訓練的網絡上(Inc-v3、Inc-v4、IncRes-v2、Res-101)生成對抗樣本,并在所有7 個網絡(4 個正常訓練網絡,3 個對抗訓練網絡,)上測試它們。實驗結果展示在表1 中,其中成功率是指以對抗樣本作為輸入的模型分類錯誤率,即成功率等于攻擊成功的對抗樣本數量除以總的對抗樣本數量,這里攻擊成功的對抗樣本數量也就是模型錯誤分類的對抗樣本數量。圖4 對在Inc-v3 單模型上生成的對抗樣本進行了展示,從圖4 可以看出,原始圖像和對應生成的對抗樣本之間的差別很小,即對抗擾動對于人眼幾乎是不可見的。

表1 中的結果表明,FT-MI-FGSM 在黑盒設置下的攻擊成功率遠遠高于其他攻擊方法,并且在所有白盒模型上都保持較高的成功率。例如,在Inc-v3 網絡上生成對抗樣本并攻擊Inc-v4 網絡時,FT-MI-FGSM 黑盒攻擊的成功率達到65.2%,在這些方法中最高。此外,FT-MI-FGSM 在對抗訓練網絡上的性能也更好。與其他3 種攻擊方法相比,FT-MIFGSM 大幅提高了黑盒攻擊的成功率。例如,在IncRes-v2 網絡上生成對抗樣本來攻擊對抗訓練網絡時,FT-MI-FGSM 和MI-FGSM 的平均攻擊成功率分別為26.0%和19.9%。這充分說明了將隨機翻轉變換引入到對抗樣本的生成過程中對提高對抗樣本遷移性的重要性。

表1 攻擊單模型的成功率比較 單位:%Tab.1 Success rate comparison of single model attack unit:%

3.3 集成網絡攻擊

盡管表1 的實驗結果表明,FT-MI-FGSM 能夠提升對抗樣本的遷移性,但還能夠通過攻擊集成模型進一步提高黑盒攻擊成功率。本文遵循文獻[10]中提出的策略,即對多個網絡邏輯值的集成進行攻擊。本實驗考慮了3.1 節中提到的7個網絡,分別運用I-FGSM、MI-FGSM 和FT-MI-FGSM 針對4 個正常訓練網絡的集成來生成對抗樣本,并在7 個網絡上測試。在實驗中,迭代輪數T=10,擾動大小ε=16,每個網絡的集成權重相等,即ωk=14。

實驗結果如表2 所示,這表明在黑盒設置下,FT-MIFGSM 相較于其他對比方法具有更高的攻擊成功率。例如,FT-MI-FGSM 攻擊Inc-v3ens3的成功率為48.2%,而I-FGSM 和MI-FGSM 的成功率分別為18.8%和38.5%。在具有挑戰性的對抗訓練的網絡上,FT-MI-FGSM 對黑盒攻擊的平均成功率為40.7%,比I-FGSM 和MI-FGSM 分別高出26.0 和8.4 個百分點。這些結果表明了該方法的有效性和優越性。

表2 攻擊集成模型的成功率比較 單位:%Tab.2 Success rate comparison of attacking ensemble models unit:%

3.4 超參數研究

在本節中,進行了一系列拓展實驗進行超參數研究。首先,研究轉換概率p對FT-MI-FGSM 攻擊成功率的影響。本實驗考慮攻擊集成模型,即FT-MI-FGSM 針對4 個正常訓練網絡的集成模型生成對抗樣本,并在7 個網絡上測試,以此來更準確地評估轉換概率p對攻擊成功率的影響。通用的實驗設置如下:最大擾動ε=16,迭代次數T=10,步長α=1.6,動量項衰減系數μ=1.0。本實驗研究的轉換概率p則從0 以0.1 的步長增長到1。當p=0 時,FT-MI-FGSM 退化為MI-FGSM。圖5 展示了FT-MI-FGSM 在不同轉換概率下的攻擊成功率,其中實線表示的是在正常訓練網絡上的白盒攻擊成功率,虛線表示的是在對抗訓練網絡上的黑盒攻擊成功率。從圖5 可以觀察到:隨著轉換概率p的增大,FT-MIFGSM 上的白盒和黑盒攻擊成功率變化趨勢是不一樣的。對于FT-MI-FGSM,隨著p的增加,黑盒攻擊成功率先逐漸升高到達峰值后再逐漸降低,而白盒攻擊成功率總體呈降低的趨勢。此外,對于FT-MI-FGSM,如果p較小,即僅利用少量隨機轉換輸入,對抗訓練網絡上的黑盒成功率會顯著提高,而白盒成功率只會略有波動。這種現象表明將隨機轉換后的輸入添加到對抗樣本生成過程中的重要性。特別是,還可以通過控制p的取值實現黑盒攻擊成功率和白盒攻擊成功率之間的平衡。本文綜合考慮白盒和黑盒攻擊成功率的重要性,無論是攻擊單個網絡還是集成網絡,FT-MI-FGSM 中的轉換概率p均取0.5。

圖5 不同網絡上轉換概率與攻擊成功率的關系Fig.5 Relationship between transformation probability and attack success rate in different networks

其次,研究擾動大小ε對黑盒攻擊成功率的影響。本實驗考慮攻擊集成模型,即I-FGSM、MI-FGSM 和FT-MI-FGSM針對4 個正常訓練網絡的集成模型生成對抗樣本,并在3 個對抗訓練網絡上測試。通用的實驗設置如下:迭代次數T=10,動量項衰減系數μ=1.0。本實驗研究的擾動大小ε則從1 以3 的步長增長到22。圖6 展示了不同擾動大小下I-FGSM、MI-FGSM 和FT-MI-FGSM 在Inc-v3ens3、Inc-v3ens4和IncRes-v2ens上的攻擊成功率。從圖6 可以看出盡管隨著擾動大小ε的逐漸增大,3 種方法在不同模型上的攻擊成功率都逐漸增大,但是本文所提的FT-MI-FGSM 方法的攻擊成功率總是最高的,實驗結果說明了FT-MI-FGSM 的優越性。

圖6 對抗訓練網絡上擾動大小與攻擊成功率的關系Fig.6 Relationship between perturbation and attack success rate in adversarially trained networks

最后,研究迭代次數T對黑盒攻擊成功率的影響。本實驗考慮攻擊集成模型,即I-FGSM、MI-FGSM、FT-MI-FGSM 針對4 個正常訓練網絡的集成模型生成對抗樣本,并在3 個對抗訓練網絡上進行測試。通用的實驗設置如下:擾動大小ε=16,動量項衰減系數μ=1.0。本實驗研究的迭代次數T從2 以2 的步長增長到16。圖7 展示了不同迭代次數下I-FGSM、MI-FGSM 和FT-MI-FGSM 在Inc-v3ens3、Inc-v3ens4和IncRes-v2ens上的攻擊成功率。從圖7 中可以看出:隨著迭代次數T的逐漸增大,3 種方法在不同模型上的攻擊成功率呈現的變化趨勢是不一樣的,其中I-FGSM 對應的曲線呈現降低的趨勢,而MI-FGSM 和FT-MI-FGSM 所對應的曲線則是先增大然后緩慢下降的趨勢,拐點大致在迭代次數取8~12。另外,從圖7 還可以看出:無論迭代次數取何值時,FT-MIFGSM 方法的攻擊成功率幾乎總是最高的,這表明了FT-MIFGSM 的有效性。

圖7 對抗訓練網絡上迭代次數與攻擊成功率的關系Fig.7 Relationship between iteration number and attack success rate in adversarially trained networks

3.5 進一步研究

前面部分已經在ImageNet 數據集上對本文所提的FTMI-FGSM 進行了有效驗證。本節在MNIST 和CIFAR 10(Canadian Institute For Advanced Research 10)[27]兩個數據集上進行了拓展實驗進一步驗證FT-MI-FGSM 的有效性。相關實驗設置和模型選取參照文獻[28],在MNIST 和CIFAR10數據集的實驗中,擾動大小ε=1255,迭代次數T=10,動量項衰減系數μ=1.0,轉換概率p=0.5。實驗結果如表3所示。從表3 可以看出:無論是在MNIST 還是CIFAR10 數據集上,FT-MI-FGSM 都有著最高的攻擊成功率,以在CIFAR10上的實驗為例,采用FT-MI-FGSM 在模型VGG16(Visual Geometry Group 16)[2]上生成對抗樣本,然后攻擊模型ResNet50[4],即在模型ResNet50 上進行檢驗,所得的攻擊成功率為42.3%,而I-FGSM 和MI-FGSM 的攻擊成功率分別為40.5%和40.7%,這凸顯了FT-MI-FGSM 的優越性。

表3 MNIST和CIFAR10數據集上的黑盒攻擊成功率比較 單位:%Tab.3 Black-box attack success rate comparison on MNIST and CIFAR10 datasets unit:%

4 結語

本文提出了一種基于圖像翻轉變換的對抗樣本生成方法FT-MI-FGSM,該方法在對抗樣本生成過程的每次迭代中對輸入圖像進行隨機翻轉變換,以緩解過擬合現象,從而生成更具遷移性的對抗樣本。與傳統的FGSM 類方法相比,在ImageNet 數據集上的實驗結果表明,本文方法在黑盒設置下的攻擊成功率有了大幅提高。此外,通過使用攻擊集成模型的方法,進一步提高了對抗樣本的遷移性,實驗結果表明,與原有方法I-FGSM 相比,FT-MI-FGSM 在對抗訓練網絡上的平均黑盒攻擊成功率提升了26.0 個百分點。FT-MI-FGSM 的工作表明,其他數據增強的方法也可能有助于構建強攻擊,這是未來可以探索和研究的方向之一,關鍵是如何找到有效應用于迭代攻擊的數據增強方法。