基于草圖紋理和形狀特征融合的草圖識別

張興園 黃雅平 鄒 琪 裴艷婷

隨著數字設備手機、平板和繪圖板的迅速發展,手繪草圖正在成為直觀表達用戶想法的主要方式之一[1].因此,草圖識別在計算機視覺領域蓬勃發展,其中包括基于草圖的圖像檢索[2],草圖分析[3],草圖分割[4]和基于草圖的圖像合成[5-6]等.

草圖識別的目的是物體類別識別,該任務相比于圖像識別更具有挑戰性.主要原因是圖像一般表示為稠密像素[7-8],但是草圖缺乏豐富的顏色細節和視覺線索[9-11],使得草圖特征的表示更加困難.為此,近些年來國內外很多研究人員致力于草圖識別方面的研究.早期草圖識別主要針對CAD 圖和藝術畫[12].受到最新提出的大型數據集啟發[13],Schneider 等[14]提出了一系列基于手工特征的草圖識別方法.這些方法將草圖看作自然圖像并利用方向梯度直方圖[15]和尺度不變特征變換[16]提取草圖特征,再利用支持向量機(Support vector machine,SVM)[17]分類器對草圖類別進行預測[18].然而,上述方法普遍存在的問題是淺層特征不能充分表達草圖.因此,Yu 等[18]提出了Sketch-a-Net 網絡,這是第1 個使用深度學習的草圖識別網絡,通過參數學習方式代替手工設計策略提高分類性能.受到上述研究工作啟發[19-31]設計了新的深度學習框架,使得草圖識別的性能首次超過了人類.近期基于循環神經網絡提取草圖特征的工作[23-31],除了考慮草圖內在結構還加入了筆畫的時序序列,即考慮草圖的筆畫順序來提取草圖特征,由此進一步提升了草圖識別性能.

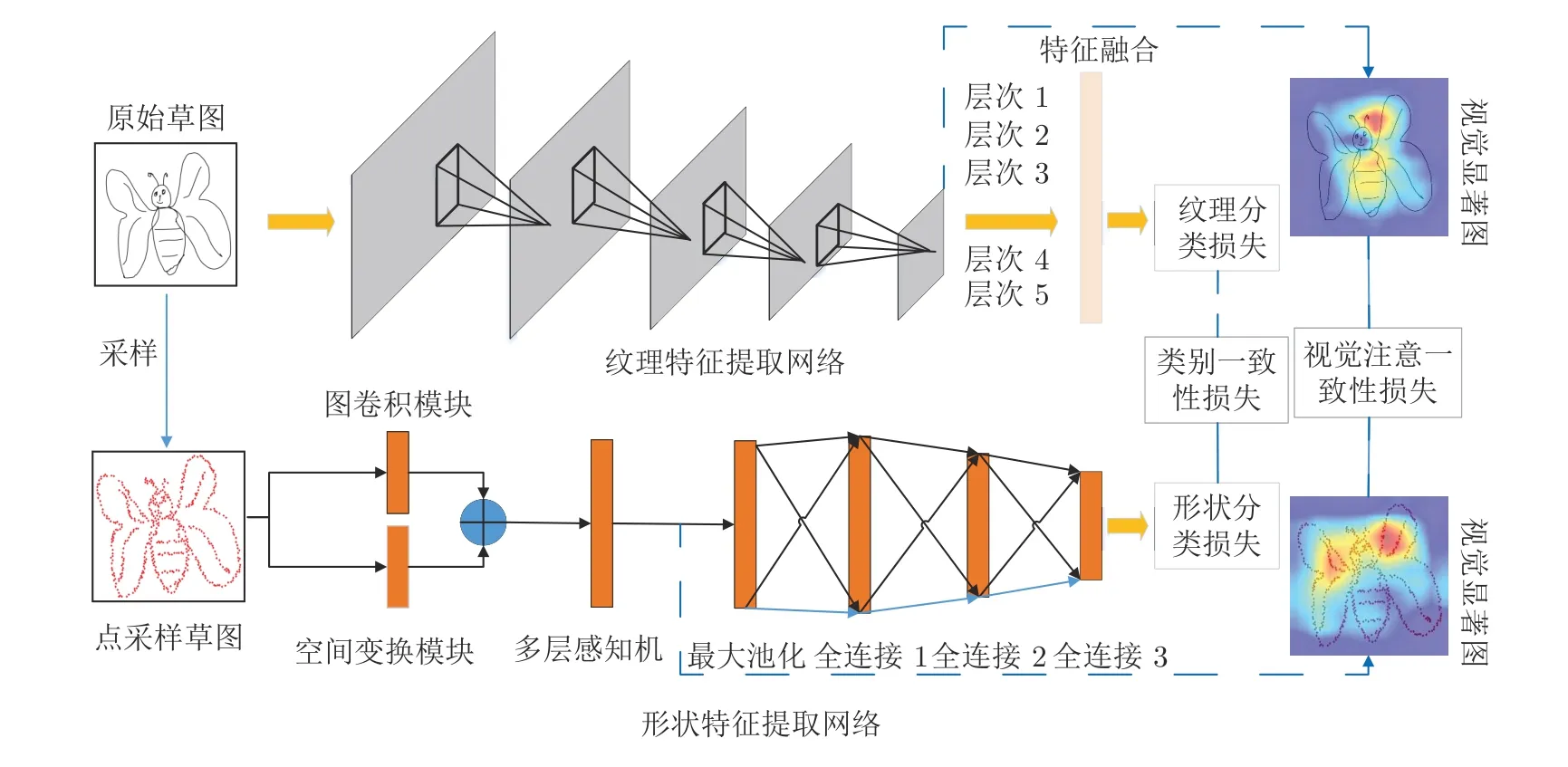

然而,大多數深度卷積神經網絡模型將草圖視為自然圖像來獲得具有判別力的紋理特征,而沒有考慮草圖本身所具有的形狀信息.具體來說,草圖在二維空間中以曲線的形式進行信息傳遞[24],因此草圖具備很好地描述物體幾何形狀的特性.但由于不同人繪畫技巧和繪制風格的差異,對同一物體進行描述的草圖形狀會千差萬別,而傳統的特征描述子并不能很好的描述類間和類內的形狀差異性.本文工作的目標是尋找一種更有效的方法來將草圖形狀信息融合到端到端的神經網絡中,從而使得深度學習網絡具有更好的草圖識別效果.為此,本文提出了一種新穎的基于雙分支互學習的深度學習網絡,即雙模型融合網絡(Dual-model fusion network,DMF-Net),以此實現草圖紋理信息和形狀信息的結合來進行草圖識別.在訓練階段,第1 個網絡分支輸入原始草圖,并使用傳統的卷積神經網絡提取紋理信息;第2 個分支輸入草圖的采樣點集合,并使用基于圖卷積神經網絡提取形狀信息;2 個網絡使用互引導機制實現聯合訓練.測試階段將訓練好的網絡分別提取不同特征并將其融合,然后輸入分類器實現最終草圖的類別預測.

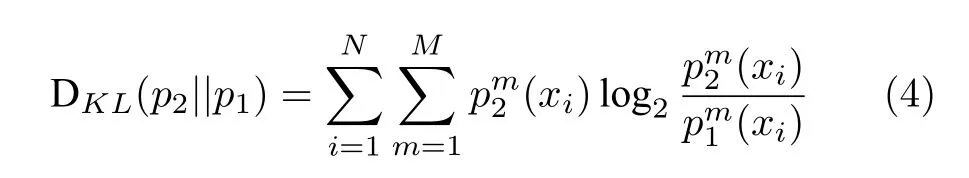

在提出的雙分支融合網絡中,基于損失函數互引導機制實現的相互學習主要由2 部分組成: 1)網絡的每個分支使用傳統的監督分類損失和基于另一個分支分類概率作為后驗的模仿損失.為此使用2個概率分布的Kullback-Leibler (KL)距離作為類別一致性損失;2)網絡基于視覺顯著圖的一致性計算損失.顯然,當草圖使用兩種不同的形式進行表示時,視覺顯著圖的區域應該相同或相近,因此網絡將視覺一致性定義為原始草圖的顯著圖和基于點表示草圖的顯著圖之間的歐氏距離.最后,將分類損失、類別一致性損失和視覺注意一致性損失結合完成網絡參數的訓練.

本文主要貢獻有: 1)針對草圖識別問題,首次提出用新的雙模型融合網絡來提取草圖的紋理信息和形狀信息;2)針對雙分支網絡的互學習問題,提出了利用視覺注意一致性損失、分類損失和類別一致性損失聯合訓練的策略;3)在Sketchy 數據集和TUBerlin 數據集上進行了實驗驗證.實驗結果表明,本文提出的模型在草圖分類任務上取得了最好的效果.

本文結構安排如下: 第1 節詳細闡述了基于雙分支網絡的草圖識別算法;第2 節闡述了網絡的訓練和測試細節;第3 節通過與已有算法在公開數據集上進行定性和定量比較,實現了對本文提出方法有效性的驗證;第4 節總結本文所研究的工作并提出下一步的研究方向.

1 雙分支識別網絡

雙分支識別網絡的框架如圖1 所示,由2 部分組成: 第1 部分主要完成基于多層次特征融合網絡提取草圖的紋理特征,第2 部分主要完成基于點采樣的圖卷積網絡提取草圖的形狀特征,最后利用分類損失、類別一致性損失和視覺注意一致性損失實現網絡參數的優化.第1.1 節介紹基于原始草圖的神經網絡提取紋理特征的過程,第1.2 節介紹基于點表示草圖的神經網絡提取形狀特征的過程,第1.3 節介紹網絡訓練使用的損失函數.

圖1 本文算法總體框架圖Fig.1 The overall framework of our method

1.1 紋理特征提取網絡

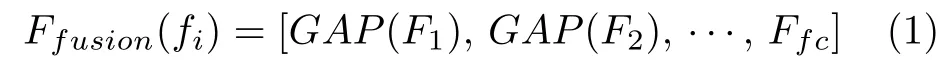

紋理特征提取網絡用于提取草圖的紋理信息.近年來,基于卷積神經網絡提取的信息已被證明能夠提供判別性紋理特征以用于草圖識別[20-18].因此,本文基于ImageNet 數據集訓練的ResNet50 模型[25],提出了紋理特征提取網絡Texture-Net.為了豐富草圖的特征表示,同時不引入更多的學習參數,模型利用多層特征融合策略來提取更加豐富的語義信息.如圖2 所示,ResNet50 網絡由4 個塊組成,每個塊的最后1 個卷積層使用池化操作來保留顯著特征并降低特征維度,然后與網絡的第一個全連接層進行特征融合以實現草圖紋理特征表示,即層次1到層次5 的特征融合.對于第k個卷積層所生成的特征圖表示為多層特征圖融合用式(1)表示為:

圖2 本文形狀特征提取網絡的原理框架示意圖Fig.2 Schematic diagram of Shape-net framework proposed in this paper

式中,Ffc表示第1 個全連接層的特征,GAP(·)表示在不同特征圖上做全局平均池化(Global average pooling,GAP),即GAP(Fk)∈RCk.將 G AP 后的卷積層特征與Ffc特征連接得到最后的草圖特征表示.因此,最終生成的草圖紋理特征包含了從高層語義信息到低層細節信息的多層聯合表示.同時,網絡并沒有引入額外的學習參數,這樣保證了融合過程的簡單性和高效性.

1.2 形狀特征提取網絡

與傳統神經網絡模型對規則網格提取特征的Texture-Net 不同,本文提出了基于點集的形狀特征提取網絡(Shape-Net)以對代表性的點集提取結構特征.兩種網絡提取特征過程有本質性區別: 對于Texture-Net,輸入和輸出特征圖分別表示為其中W、H和W′、H′分別表示F1和F2的寬度和高度.c表示上一層的通道數,c′表示當前層的通道數.卷積濾波器表示為一個張量,即,其中s1和s2分別表示濾波器的寬度和高度.與F1相比,F2有更低分辨率(R1<R2)和更多通道 (c′ >c),因此更能表示高層語義信息.上述步驟遞歸執行最終生成分辨率低但通道數多的特征圖.對于Shape-Net,輸入是一系列的點并且每個點表示一個特征,即F={(p1,f1),(p2,f2),···,(pn,fn)}.網絡在輸入特征圖F1上使用點卷積獲得高層語義表示F2,其中F2比F1有更低的空間分辨率(即更少的點)和更多的通道數.此外,F1到F2的過程能夠將特征聚集成更少點但是每個點包含了更豐富的特征.

以離散點作為網絡輸入的方法最初用于點云處理[34-27],主要原因是基于點卷積的神經網絡可以大大降低模型的時間復雜度和空間復雜度.Hua 等[26]構建了針對場景語義分割和目標識別的兩個逐點卷積神經網絡,并設計了一種可以輸出點云中每一點特征的逐點卷積算子.Wang 等[27]提出了一個端到端的漸進式學習方法,即通過訓練一個基于圖像塊的多階段網絡,在不同的細節級別學習點云信息.基于上述點云中點卷積的思想,本文通過將草圖看成一系列的二維點,充分考慮草圖的空間結構,最終實現高效、具有魯棒性的草圖特征表示.

通常情況下,基于點的草圖表示具有采樣點的起始點位置及草圖旋轉和平移不變性,本文采用基于點采樣的神經網絡作為骨干網絡,該網絡模型引入了最大池化和空間變換網絡來解決上述兩個問題.但是上述網絡設計仍存在不足之處,即不能獲得二維點中局部結構信息,而鄰域信息對特征表達非常重要.

以往的點特征提取方法往往僅利用每個點的特征表示,而忽略了相鄰點的關系,為了解決上述問題,人們提出了基于圖卷積的神經網絡并應用于點云任務中[29-44].Wang 等[29]提出使用拉普拉斯算子和池化層次結構動態構件圖,并使用局部譜卷積提取每個點鄰域中的結構信息.Simonovsky 等[30]提出了可以作用在任何圖結構上且權重由節點間邊權決定的圖卷積模型.Kipf 等[44]提出了一種基于圖卷積神經網絡的可擴展模型圖卷積神經網絡(Graph convolutional network,GCN).該模型要求網絡在訓練過程中計算整個圖的拉普拉斯矩陣,然后利用局部譜卷積提取特征,實驗在半監督任務上取得了很好的效果.基于圖卷積思想,本文提出了基于圖卷積的點草圖形狀特征提取網絡.與GCN 在譜圖上進行卷積操作不同,此網絡在空間域上對圖進行卷積操作,不僅提取當前點的特征,同時結合了當前點周圍的K個近鄰點特征來表征草圖,即首先以每個點為中心并利用K近鄰(K-nearest neighbor,KNN)算法構建圖模型,然后將中心點特征加入到圖中的K條邊特征中,再利用卷積操作將K個特征整合成一個特征作為中心點最終的特征表示.

下文給出Shape-Net 的基本結構如下: 第1.2.1節通過描述特征提取網絡提取草圖的形狀表示流程,第1.2.2 節介紹為了解決草圖空間不變性而提出的空間變換網絡,第1.2.3 節介紹采樣點構建鄰域圖并利用圖卷積提取局部結構信息的過程.

1.2.1 特征提取過程

對于Shape-Net 網絡,首先預處理草圖并使用最遠采樣策略[31]獲取1 024 個采樣點.然后,利用點卷積學習每個點的特征描述子,這是提取點特征的關鍵步驟.如圖2所示,Shape-Net 實現過程如下:第1 步,將N個M維采樣點輸入到二維空間變換網絡,其中N表示采樣點數,M表示坐標維度,由于二維空間坐標為(x,y),因此M取值為2;第2 步,利用空間變換網絡中的T-Net 模塊學習2×2仿射矩陣(第1.2.2節),使得網絡輸入在正則空間中對齊,同時網絡引入圖卷積(第1.2.3 節)來從M維采樣點中學習鄰域信息的表示;最終將圖卷積生成的特征圖和空間變換生成的特征圖拼接生成N×(L+2)維特征圖;第3 步,將拼接得到的特征送入多層感知機中,最終經過多層感知機、最大池化和全連接得到點采樣草圖的特征表示.

1.2.2 空間變換網絡

形狀特征提取網絡在提取基于點表示草圖的信息時,通過對輸入的二維坐標點進行一系列的點坐標變換,又稱為正則變換[36],來實現形狀特征的表達.而網絡對目標的點變換應該具有空間不變性,即草圖旋轉和平移不變性.為此,網絡在進行特征提取之前,先對點表示的草圖進行對齊,即正則空間對齊,以保證目標物體對空間變換的不變性.實際上,類似于點云模型中使用仿射變換解決幾何變形問題[34],對于基于點坐標的空間變換已經被證明在二維點集匹配[33-35]和點特征表征[28]任務中依然重要.

實現對齊操作首先要訓練空間變換網絡中的TNet 模塊完成2 × 2 仿射矩陣的生成,然后將訓練得到的矩陣與輸入的N個2 維采樣點進行矩陣相乘來實現最終的對齊目的.如圖2 所示,T-Net 結構與Shape-Net 結構類似,對網絡輸入的N個二維采樣點,分別使用多層感知機、最大池化和全連接層學習特征,其中全連接層的維度分別設置為1 024、512 和250,最后通過矩陣變換得到2 × 2 的仿射矩陣.

1.2.3 圖卷積網絡

鄰域點往往具有類似的幾何結構[37],因此通過對每個點構建局部鄰域圖并對圖中的邊使用卷積操作,實現草圖局部點集特征的提取.基本流程如下:首先,基于目標點和其K個鄰近點構建局部圖.然后,對圖中的邊利用1 × 1 卷積來提取K維鄰域特征.將學習到的特征在向前傳遞過程中,使用池化層壓縮特征以保留重要細節和去掉不相關的信息,實現局部特征的表達.

具體地,n個F維的點表示為P={p1,p2,···,pn}.其中,F=2,每個點表示為2 維坐標.對于草圖中的每個點,計算無向圖ξ=(ν,ε),其中ν={ν1,ν2,···,νk}和ε={ε1,ε2,···,εk}分別代表頂點和圖中的邊.在最簡單的情況下,利用每個點的K近鄰在二維空間構建無向圖ξ.提取圖中的邊特征并表示為eij=hθ(xmi,xj),其中hθ:RF ×RF →RF′表示一系列可學習參數θ的非線性函數.最后,圖卷積網絡使用池化將學習到的特征進行聚集從而實現每個點局部信息的表達.

1.3 目標函數

網絡利用互學習策略進行草圖識別模型的訓練,從而進一步提高性能.本文方法同時訓練兩個分支,從而實現網絡之間的知識遷移.網絡的目標函數包括分類損失、類別一致性損失和視覺注意一致性損失3 部分.

1)分類損失.網絡的兩個分支采用softmax 交叉熵損失函數,定義如式(2)所示:

式中,xi表示輸入的草圖,yi表示xi對應的標簽.N表示草圖的數量.M表示當前草圖類別的數量.θ表示全連接層的權重,用來將隱藏層的特征映射為標簽.

2)類別一致性損失.對于樣本xi ∈{x1,x2,···,xN},Texture-Net 利用式(3)計算xi屬于類M的概率:

式中,zi表示隱藏層的輸出.Shape-Net 另外一個分支網絡使用類似定義并表示為.為了定量匹配2 個網絡的預測p1和p2,網絡使用KL散度計算2 個分布的距離.從p1到p2的KL 距離定義如下:

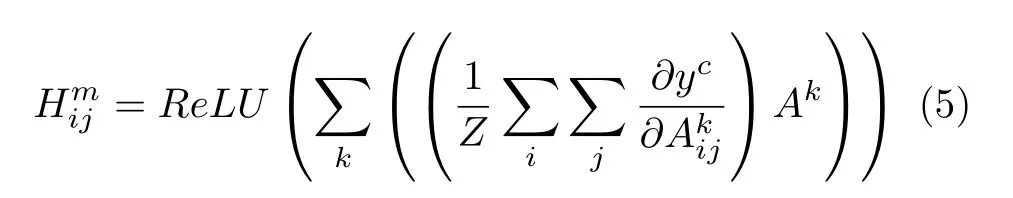

3)視覺注意一致性損失.通常來講,兩個分支視覺顯著圖的一致性能夠提高圖像分類的性能.同時,如果視覺顯著圖能夠反映與類別標簽相關的區域,網絡則能夠學習到更有判別力的特征.對于每個原始草圖和點采樣草圖,網絡使用類激活圖(Class activation mapping,CAM)[32]提取視覺顯著圖.具體來講,網絡在前向激活圖上使用加權結合,然后使用ReLU 激活函數獲得視覺顯著圖為:

式中,Z表示特征圖像素數量,Ak表示卷積層第k個特征圖.

為了增強顯著圖的一致性,網絡使用均方誤差計算原始草圖顯著圖Hs和基于點采樣草圖視覺圖Hp之間的損失為:

式中,Hnm表示第n張圖像屬于第m類的視覺顯著圖.

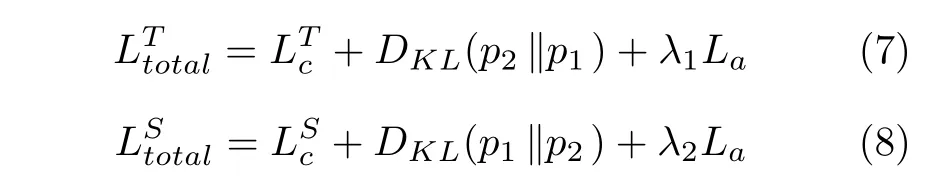

最終,將式(2)、式(4)和式(6)分別結合實現網絡Texture-Net 和Shape-Net 的訓練,如下所示:

2 網絡的訓練和測試

實驗使用Pytorch 深度學習開源工具訓練網絡模型,所有實驗在兩塊英偉達TitanXp 顯卡上運行.

2.1 訓練階段

本節基于文獻[38] 的訓練策略,在ImageNet 數據集上訓練Texture-Net.同時使用隨機梯度下降法進行梯度更新,每批圖像數量為64.學習率為0.1,錯誤率穩定時學習率減為原來的0.1 倍.衰減率和動量分別為0.0001 和0.9.對于Shape-Net,使用Adam 優化器訓練網絡,學習率和每批圖像數量分別設置為0.001 和64,每訓練40 輪學習率為原來的0.5 倍.衰減率和動量參數設置同Texture-Net.式(7)和式(8)中的超參數設置為1.

2.2 測試階段

測試過程中,首先保持圖像縱橫比并設置草圖的最大尺寸為256 像素.然后,填充邊緣像素使得圖像大小最終為256 × 256.在預測草圖類別時,將兩個分支的全連接層特征進行連接,然后輸入到softmax 分類器中,得到最終的類別預測.

3 實驗結果與分析

為了驗證第3.3 節DMF-Net 模型在草圖分類的有效性,在2 個公開數據集TU-Berlin 數據集和Sketchy 數據集上進行了實驗.第3.1~ 3.2 節對數據集和評價標準做詳細描述,第3.4 節通過消融實驗分析模型不同模塊的性能,第3.5 節分析點集采樣策略和點數對分類性能的影響.

3.1 數據集介紹

1) TU-Berlin 數據集[13]是提出的第一個廣泛應用于草圖識別的手繪草圖數據集,其中包含250 個草圖類別,例如飛機、日歷和長頸鹿.人類在該數據集所有類別的平均識別率為73.1%.由于數據集訓練數量的有限性,采用數據增廣方法[18,32]進行數據擴展,包括水平映射和筆畫移除.

2) Sketchy 數據集[39]是第一個用于細粒度草圖檢索的大型草圖數據集,包含75 471 張手繪草圖并分成了125 個類別.此數據集廣泛應用于細粒度草圖檢索并為圖像合成和風格轉換提供了可能性.

3.2 評價標準

本文使用和文獻[40-51]一樣的訓練策略,在草圖分類任務上定量評估模型性能.具體來說,在每個類別上使用平均預測評估分類性能.然后,在所有類別上使用平均預測率和其他方法比較分類準確率.同時引入受試者工作特征曲線(Receiver operator characteristic curve,ROC)[43]和曲線下面積(Area under curve,AUC)[50]對分類效果進行更好的評價.

3.3 草圖分類實驗結果

本節展示了TU-Berlin 數據集在草圖分類任務上的性能.類似于文獻[13],每個類別在訓練集上圖像數量的設置分別為8、40、64 和72.數據集中的訓練圖像是隨機選擇的,剩余圖像作為測試集.基準方法分為兩類: 傳統手工特征和深度特征.對于手工特征,選擇文獻[14]中提出的4 種帶有空間金字塔的FisherVector (FV)特征表示.同時采用文獻[13]提出的映射特征進行草圖表示.對于后者,對比方法包括SketchPoint[42]、Alexnet[38]、Network in network (NIN)[45]、視覺幾何組網絡 (Visual geometry group network,VGGNet)[46]、GoogLeNet[47]、SketchNet[41]、Sketch-a-Net[18]、Cousion Network[49]、Hybrid CNN[48]、Landmark-aware Network(LN)[51]和SSDA 方法.

對比結果如表1 所示.由表1 可以看出,DMFNet 在所有設置都優于其他方法,并且相對于最優方法有明顯提升(86%相對84%、85%相對82%、77%相對76% 和60%相對59%).優越性主要得益于紋理特征和形狀特征的結合同時引入了2 個分支的互學習策略進行模型的優化.

表1 不同算法下在TU-Berlin 數據集上分類準確率的比較 (%)Table 1 Comparison of sketch classification accuracy with different algorithms on the TU-Berlin dataset (%)

圖3 展示了TU-Berlin 數據集的6 個類別,每個類別隨機選取72 張圖片進行受試者工作特征曲線的繪制和曲線下面積值的計算.從圖中可以看出,6 個類別的受試者工作特征曲線均靠近坐標的左上角,且曲線下面積值均高于隨機試驗的曲線下面積的值(0.5),結果表明了基于互學習的雙分支網絡在草圖分類問題上有著很好的效果.

圖3 TU-Berlin 數據集上6 個類別的受試者工作特征曲線及曲線下面積值Fig.3 ROCs and AUC values of 6 classes in the TU-Berlin dataset

3.4 消融實驗

為了驗證本文算法不同模塊對分類性能的影響,模型在2 個數據集上進行實驗測試.實驗包括圖卷積、不同的損失函數、2 個分支結構和多層特征融合的影響.

1)圖卷積和不同損失函數的影響.首先利用實驗驗證圖卷積(Graph convolution,GC)對局部幾何信息具有更強的表示.然后驗證注意力一致性(Attention consistency,AC)和類別一致性(Category consistency,CC)嵌入模型訓練前后對分類準確率的影響.基礎網絡(Base network,BN)表示在TU-Berlin 數據集和Sketchy 數據集上不采用GC、AC 和CC 三種策略訓練的Texture-Net 和Shape-Net.

分類的實驗結果如表2 所示.通過實驗可以得出如下結論: 1)當結合目標點特征和其臨近點特征時,能夠增強局部結構特征的表達并因此解決了不同類別但是結構相似的草圖由于局部差異而被錯分的問題;2)兩種草圖表示的注意力一致性能夠提升性能,即在TU-Berlin 數據集上原始模型為82.71%,原始模型和注意力一致性結合的準確率為84.12%.主要原因是由于視覺注意區域的感知一致性能夠幫助兩個分支得到更準確的判別區域;3) 原始模型和類別一致性策略的結合使得模型訓練過程中一個分支能夠利用其他分支的信息并提升各自的性能;4)本文使用原始模型和多個策略的聯合,使得模型能夠得到更好的參數優化和特征表達.

表2 在TU-Berlin 數據集和Sketchy 數據集上實現草圖分類的網絡結構分析 (%)Table 2 Architecture design analysis for sketch classification on TU-Berlin and Sketchy (%)

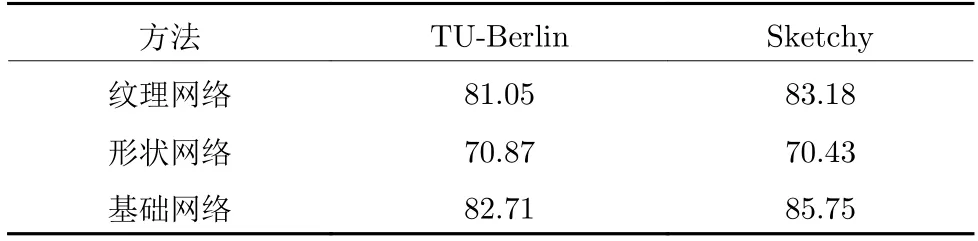

2) 兩個分支性能評價.對于構造復雜和類間相似度高的草圖,傳統的神經網絡提取的視覺特征往往不能很好的描述草圖差異.因此,學習基于采樣點的結構化特征對草圖形狀表示具有重要的意義.為評估兩個單獨分支和整個網絡結構的性能,在TU-Berlin 數據集和Sketchy 數據集上對草圖分類準確率進行了實驗驗證,所得結果如表3 所示.基礎網絡表示融合Shape-Net 和Texture-Net 特征,而不使用圖卷積和互學習損失函數對模型進行優化.通過對比可以發現,使用兩個分支進行草圖的特征表達能夠提高分類準確率.主要原因是紋理特征提取網絡對于相似構造的草圖差異性具有很差的表達能力.相反,形狀特征提取網絡能獲得很好的結構信息,對草圖形狀有更好的表達.

表3 利用雙分支神經網絡的草圖分類準確率 (%)Table 3 Classification accuracy results using two-branch neural networks (%)

為了進一步驗證每個模塊對草圖分類的重要性,從TU-Berlin 數據集中隨機挑選了13 個類別進行定量實驗分析.如圖4 所示,相比于只使用紋理特征表示草圖,加入形狀特征后的草圖分類準確率平均提升了1.5%,加入形狀特征和互學習策略的分類準確率平均提升了4%.另外可以發現,對于一些對于識別困難的樣本,如Panda、Flying bird 和Wheel,無論單獨加入形狀特征還是融合互學習策略,分類準確率都有大幅度提升.因此可以得出以下結論: a)單純的紋理表征對難例草圖具有很低的判別能力;b)通過對草圖進行點采樣,可以挖掘更多的形狀信息以及潛在的草圖模式,從而證明了點表示草圖對形狀信息具有強表達性;c)互學習策略可以使得2 個模型相互學習和共同進步,從而促進兩個網絡共同學習到更加具有魯棒性的特征表示,使得分類性能得到大幅提升.

圖4 TU-Berlin 數據集上13 個類別的分類準確率Fig.4 Classification accuracy of 13 classes in the TU-Berlin dataset

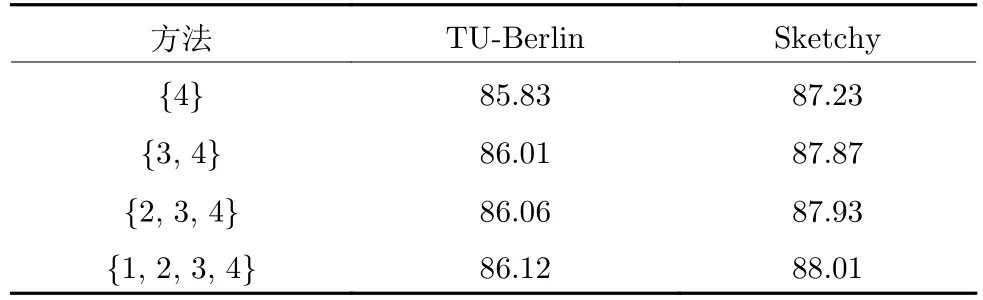

3)多層特征融合評價.盡管多數神經網絡方法只利用全連接層特征表示草圖,但是其他網絡層提取的草圖特征也能夠表達草圖并提升分類性能.因此,為了融合更多的草圖信息,本文將底層特征和高層特征結合以生成更加豐富的語義信息.如表4所示,{1,2,3,4} 表示圖2 中ResNet50 第1 個全連接層融合層次1、層次2、層次3 和層次4 四個模塊中最后一個卷積層經過池化生成的特征表示.通過對比可以發現,2 個數據集準確率有相同的趨勢:融合4 個隱藏層的特征時,分類準確率最高.同時,分類性能逐漸趨于飽和,并且第1 層和第2 層中的卷積層特征對最終草圖分類準確率影響很小.

表4 不同層的分類準確率結果 (%)Table 4 Classification accuracy results using given feature levels (%)

3.5 點采樣策略和點數對草圖分類的影響

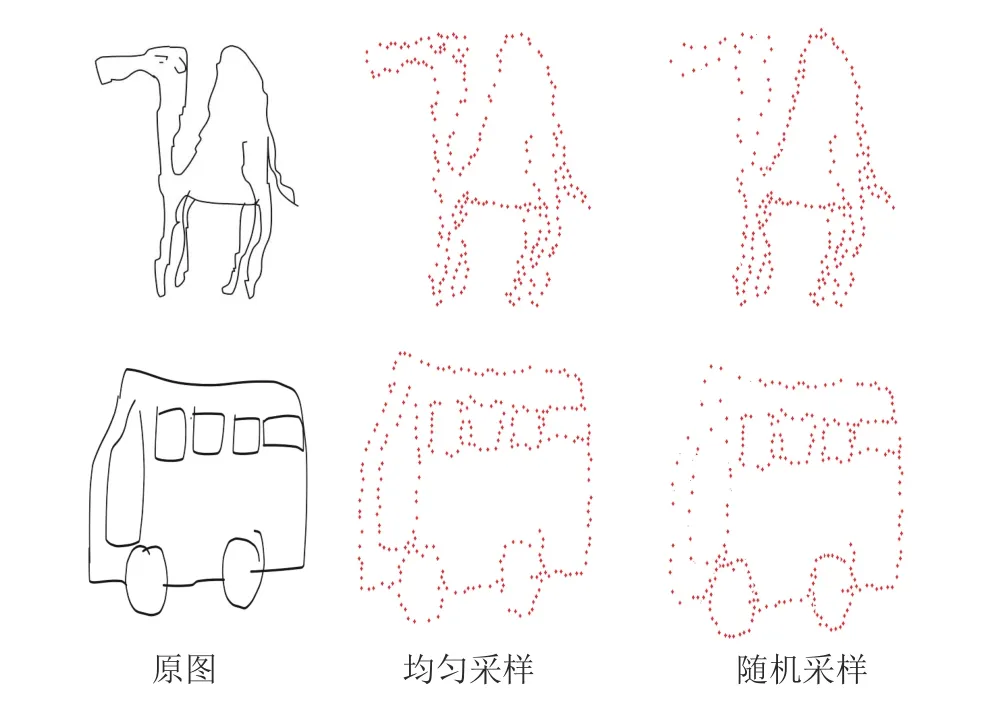

采樣常用的策略主要包括均勻采樣和隨機采樣兩種.兩種采樣結果如圖5 所示,本文實驗采用了均勻采樣策略.通常情況下,隨機采樣容易生成抖動噪聲,因此Shape-Net 模型引入了池化操作和空間變換網絡來消除噪聲影響.兩種采樣對比實驗結果如表5 所示.由表5 可以看出,均勻采樣和隨機采樣在TU-Berlin 數據集的草圖分類準確率分別為86.12%和86.09%.綜上所述,隨機采樣性能基本與均勻采樣持平,同時模型對隨機采樣具有魯棒性.

表5 2 種采樣策略在TU-Berlin 數據集的分類準確率 (%)Table 5 Classification accuracy on TU-Berlin dataset using two sampling strategies (%)

圖5 兩種策略在草圖點采樣的結果示意圖Fig.5 The point sampling demonstration of two strategies on the sketch

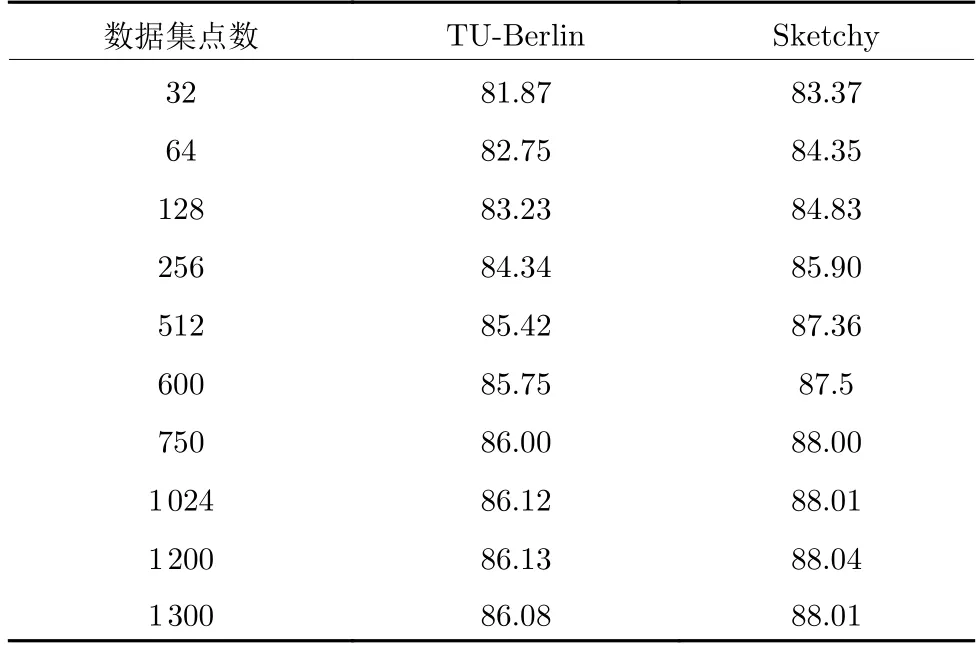

為了驗證本文提出的草圖識別模型在不同采樣點數目下的影響,在TU-Berlin 數據集和Sketchy數據集上進行了對比實驗分析.從表6 可以得出以下結論: 1)隨著點數的不斷增加,草圖分類準確率在不斷的上升.當采樣點數到1 000 時,準確率趨于穩定.同時,如果采樣點過少,草圖分類準確率會大大降低.因此,本文設置采樣點數為1 024,這樣在保證計算效率的同時,準確率也可以達到預期目標;2)當采樣點數繼續增加時,準確率反而會下降.其主要原因在于,太多的點數使得點表示的草圖集中于表達重復的模式而不是具有判別力的形狀,對于某些難例樣本的分類會更加困難.

表6 不同采樣點數對分類準確率的影響 (%)Table 6 Effects of the point number for the classification accuracy (%)

4 結束語

本文提出了一種基于雙分支神經網絡結構,實現手繪草圖識別的任務.網絡引入了視覺顯著圖來學習具有判別力的草圖區域,同時使用注意力一致性和類別一致性的互學習策略實現模型的優化.在常用兩個數據集的實驗結果證明了該模型提取的特征優于傳統手工特征,相比于其他幾種算法在草圖分類任務上擁有更好的表現,并且對草圖的點采樣策略具有魯棒性.未來將考慮融合筆畫順序到網絡中并使用互學習策略,實現草圖性能的進一步優化.