批量分組異構(gòu)的殘差人臉表情識別網(wǎng)絡(luò)*

王均峰,桑海峰,范 佳

(沈陽工業(yè)大學(xué)信息科學(xué)與工程學(xué)院,沈陽 110870)

1 引言

人臉表情識別作為人工智能領(lǐng)域中重要的研究方向,自問世以來一直受到國內(nèi)外研究者的關(guān)注。20世紀(jì)80年代前后,Ekman和Friesen分析了六種基本表情的特點(diǎn),提出了面部行為編碼系統(tǒng),用于檢測面部肌肉的變化,將其與表情聯(lián)系起來[1]。1991年,Mase和Pentland二人利用面部表情肌肉運(yùn)動引起的光流變化表征表情,對高興、憤怒、厭惡和驚訝四種表情進(jìn)行識別[2]。光流法也是動態(tài)特征提取的重要方法。此外,在表情特征提取工作中,最常用的是局部二值模式[3]和Gabor小波變換[4],結(jié)合SVM等特征分類算法[5],效果更好。到了2012年,Alexnet在ImageNet大規(guī)模視覺識別競賽取得了第一名的成績,開辟了卷積神經(jīng)網(wǎng)絡(luò)的研究熱潮[6]。而對于表情識別而言,卷積神經(jīng)網(wǎng)絡(luò)及其變體的提出也意味著表情識別自特征工程階段走入網(wǎng)絡(luò)工程階段。在國內(nèi),張文萍等學(xué)者,采用指數(shù)損失減小類內(nèi)距離的方法改進(jìn)了Island損失函數(shù),提高了網(wǎng)絡(luò)的測試性能與泛化性能[7]。在傳統(tǒng)卷積神經(jīng)網(wǎng)絡(luò)的表情特征提取階段,存在著感受野不足、部分關(guān)鍵信息丟失的情況。對此,Szegedy等學(xué)者在2014年提出的GoogLeNet[8],采用并行架構(gòu),通過不同卷積操作,獲得了更加豐富的信息,避免了關(guān)鍵信息的丟失。

本研究基于謝賽寧等學(xué)者提出的批量殘差神經(jīng)網(wǎng)絡(luò)ResNeXt[9],提出批量分組異構(gòu)的殘差人臉表情識別網(wǎng)絡(luò)He-ResNeXt。

2 網(wǎng)絡(luò)設(shè)計(jì)

所設(shè)計(jì)網(wǎng)絡(luò)不同于傳統(tǒng)的ResNeXt操作,即殘差塊對于輸入特征圖分為32個(gè)并行通道進(jìn)行同樣的卷積操作,先1×1卷積降維,然后3×3卷積提取特征,最后1×1卷積升維;He-ResNeXt則是將殘差塊針對輸入特征圖的32個(gè)通道分為3組,各含11、10和11個(gè)并行通道,同組通道內(nèi)卷積相同,不同組不同,經(jīng)過卷積操作后,進(jìn)行組內(nèi)優(yōu)先特征融合。不同卷積操作可以獲得更多的有效信息,提升特征提取能力,而針對于He-ResNeXt的組內(nèi)優(yōu)先特征融合可以避免直接融合特征帶來的信息混亂。

由三個(gè)He-ResNeXt殘差塊堆疊構(gòu)成的He-Res NeXt-29網(wǎng)絡(luò)結(jié)構(gòu)如圖1所示。

圖1 He-ResNeXt-29網(wǎng)絡(luò)圖

整個(gè)網(wǎng)絡(luò)共有四個(gè)卷積塊,除了第一個(gè)卷積塊只有一層1×1卷積,其他均由三個(gè)He-ResNeXt殘差塊堆疊構(gòu)成用以提取特征,經(jīng)最終1×1卷積下采樣,卷積塊增加兩倍通道數(shù),保持層間信息流通。假設(shè)最初輸出特征圖大小為FER2013數(shù)據(jù)集圖像尺寸48×48,經(jīng)過三個(gè)卷積塊提取特征,從48×48降至12×12,最后接入全局平均池化輸出的最終特征向量,通過Softmax進(jìn)行分類。全局平均池化輸出對減少參數(shù)和降低過擬合風(fēng)險(xiǎn)具有很大實(shí)際意義[10]。

3 相關(guān)網(wǎng)絡(luò)

3.1 He-ResNeXt殘差塊設(shè)計(jì)

何愷明等在2016年針對深度網(wǎng)絡(luò)的退化問題提出深度殘差卷積網(wǎng)絡(luò)[11],這一網(wǎng)絡(luò)由很多殘差塊組成,其中的第l個(gè)殘差塊的結(jié)構(gòu)如圖2所示。

圖2 何愷明2016年ResNet的第l個(gè)殘差塊結(jié)構(gòu)

在這其中,殘差塊的最基本思想首次被提出:通過殘差連接來克服網(wǎng)絡(luò)變深帶來的梯度消失。殘差塊執(zhí)行以下計(jì)算:

其中xl和xl+1是第l個(gè)單元的輸入和輸出,F(xiàn)表示一個(gè)殘差函數(shù)。在該網(wǎng)絡(luò)中,h(xl)=xl代表一個(gè)恒等映射;f代表激活函數(shù)ReLU。

假設(shè)f也是一個(gè)恒等映射,則xl+1=yl,可得:

通過遞歸,對于任意深的殘差塊L和任意淺的殘差塊l,可以得到:

從上式中可以看出任意殘差塊L和l之間都具有殘差特性。假設(shè)損失函數(shù)為ε,由反向傳播的鏈?zhǔn)椒▌t可以得到:

從式(5)中可以看出,即使權(quán)重任意小,也不可能出現(xiàn)梯度消失的情況[12],這就避免了梯度消失帶來的網(wǎng)絡(luò)退化。

各類殘差塊結(jié)構(gòu)的對比如圖3所示。

圖3 殘差塊結(jié)構(gòu)對比

原始?xì)埐顗KResNet結(jié)構(gòu)如圖3(a)所示,方框中三個(gè)數(shù)據(jù)的意義是:輸入通道數(shù)、卷積核大小、輸出通道數(shù)。ResNeXt結(jié)構(gòu)如圖3(b),它用一種平行堆疊相同拓?fù)浣Y(jié)構(gòu)的殘差塊代替原來ResNet的三層卷積的殘差塊,在不明顯增加參數(shù)量級的情況下提升了模型的準(zhǔn)確率,同時(shí)由于拓?fù)浣Y(jié)構(gòu)相同,便于模型移植。在同為256-d的輸入下,可以看到ResNeXt對于ResNet的改進(jìn)在于:不再采用直接卷積,而是把輸入特征圖分別送入32個(gè)同樣的并行通道,最后再相加特征圖輸出,通道的卷積核都是相同的1×1、3×3和1×1。此模型提出了一個(gè)基數(shù)的概念,在圖中實(shí)例下就是32條通道。研究者認(rèn)為這個(gè)基數(shù)帶給了ResNeXt更好的精度與效果,另外在加深或加寬網(wǎng)絡(luò)的收益開始遞減時(shí),增加基數(shù)也是獲得精度的一種更有效的方法。本研究提出的He-ResNeXt殘差塊結(jié)構(gòu)如圖3(c),它是基于ResNeXt的設(shè)計(jì),做出了并行架構(gòu)上的修改。

殘差塊設(shè)計(jì)希望通過分組進(jìn)行不同卷積的方法從輸入特征圖中獲得更加豐富有效的信息,據(jù)此將ResNeXt的32個(gè)并行通道分成3組,組內(nèi)通道數(shù)分別為11、10和11。其中第一組的11個(gè)通道經(jīng)過兩次1×1卷積,另一組的11個(gè)通道先經(jīng)過1×1卷積,再經(jīng)過5×5卷積;10通道的那組與原來基本相同,但是為了不過度增加網(wǎng)絡(luò)參數(shù),將原來的3×3卷積改成先進(jìn)行1×3卷積再進(jìn)行3×1卷積。

通過異構(gòu)的卷積操作可以獲得不同尺度的特征,再進(jìn)行組內(nèi)優(yōu)先特征融合,這樣在基本不增加網(wǎng)絡(luò)參數(shù)的基礎(chǔ)上,可以使網(wǎng)絡(luò)觀察到更多尺度的特征,提升了網(wǎng)絡(luò)特征提取能力。

3.2 組內(nèi)優(yōu)先特征融合

在ResNeXt中,即便并行通道共計(jì)32條,但這32條通道采用的卷積方式相同,所以可以采用直接融合的形式,用密集成分來近似最優(yōu)的局部稀疏結(jié)構(gòu)。其融合策略結(jié)構(gòu)如圖4所示。

圖4 多尺度融合結(jié)構(gòu)

圖中的F(x)可以表示為:

式中,xi表示第i個(gè)輸入特征圖;fi(xi)表示第i個(gè)輸出;D為輸入特征圖個(gè)數(shù);F(x)是輸出特征圖。

對于He-ResNeXt殘差塊共有3組共計(jì)32個(gè)通道并且有三種卷積操作的情況,直接進(jìn)行多尺度特征融合容易帶來信息混亂,影響信息提取能力。為了避免過多同種卷積帶來的信息混亂,殘差塊先在相同通道組內(nèi)優(yōu)先特征融合,然后進(jìn)行不同通道組間特征融合,結(jié)構(gòu)如圖5所示。其特征融合方式可以表示為:

圖5 組內(nèi)優(yōu)先特征融合

其中,xij表示第i組第j個(gè)通道的輸入特征圖;fij(xij)表示第i組第j通道輸出特征圖;G為分組組數(shù);g為每組通道數(shù)。

對于He-ResNeXt殘差塊,其分組組數(shù)G=3,每組通道數(shù)g=11、10、11。通過組內(nèi)優(yōu)先融合的方式,避免了多種卷積方式可能帶來的信息混亂,提升了信息提取能力。

4 實(shí)驗(yàn)與分析

4.1 數(shù)據(jù)集及數(shù)據(jù)增強(qiáng)

為了驗(yàn)證He-ResNeXt的有效性,分別在CK+、FER2013和JAFFE三個(gè)公開數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn)評估。其中,CK+數(shù)據(jù)集是CK(Cogn-Kanade)數(shù)據(jù)集的擴(kuò)展。該數(shù)據(jù)集包含981個(gè)樣本,來自123個(gè)受試者,實(shí)驗(yàn)使用7分類標(biāo)注,分別為憤怒、輕視、厭惡、害怕、高興、悲傷、驚訝。樣本均為正前方拍攝,受試者均無妝容、不佩戴眼鏡,但年齡、膚色、人種、國籍、光照條件等各不相同,樣本的分辨率有640×480、640×490和720×480三種。該數(shù)據(jù)集在人臉表情識別研究中應(yīng)用范圍最廣。

FER2013人臉表情數(shù)據(jù)集是一種大型互聯(lián)網(wǎng)數(shù)據(jù)集。該數(shù)據(jù)集包括35887張人臉表情灰度圖像,分為訓(xùn)練圖像(28709張)、公共驗(yàn)證圖像(3589張)和私有驗(yàn)證圖像(3589張)。所有圖像使用7種標(biāo)簽進(jìn)行分類標(biāo)注,分別為憤怒、厭惡、恐懼、高興、悲傷、驚訝和中性。受試者的年齡、妝容、頭部姿態(tài)、背景、光照條件差異很大,圖像的分辨率均為48×48。該數(shù)據(jù)集更接近自然狀態(tài),且其樣本數(shù)量較多,很多人臉表情識別研究都選擇該數(shù)據(jù)集進(jìn)行訓(xùn)練和測試。

JAFFE數(shù)據(jù)集由日本ATR于二十世紀(jì)末創(chuàng)建,是識別亞洲人表情的有效工具。該數(shù)據(jù)集共213個(gè)人臉表情樣本,來自10位日本女性,有憤怒、厭惡、恐懼、高興、悲傷、中性和驚訝七種表情,每人都有中性表情樣本和三至四個(gè)基本表情樣本。受試者均為女性,年齡、頭部姿態(tài)、光照等條件無較大差別,表情稍顯夸張,樣本均為256×256的灰度圖片。該數(shù)據(jù)集數(shù)量較少且簡單,目前人臉表情識別研究在此數(shù)據(jù)集上已有很高的識別率。

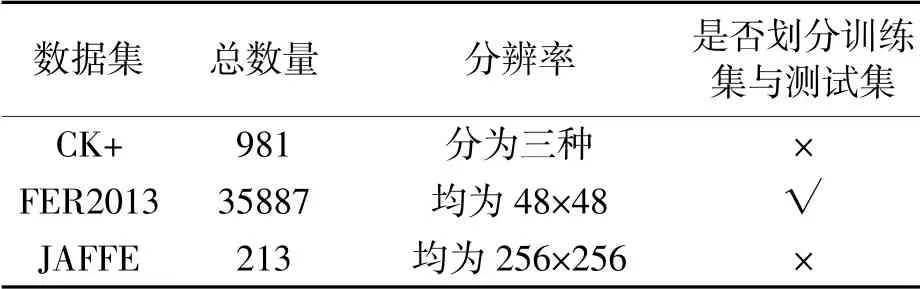

實(shí)驗(yàn)采用的均為七分類數(shù)據(jù)集,部分圖像展示如圖6。其他關(guān)鍵指標(biāo)對比如表1。

圖6 數(shù)據(jù)集樣本示例

表1 各數(shù)據(jù)集情況對比表

為了豐富圖像數(shù)據(jù)的訓(xùn)練集,更好地提取圖像特征,提高模型泛化能力(防止模型過擬合),需要對圖像數(shù)據(jù)進(jìn)行數(shù)據(jù)增強(qiáng)。除了采用隨機(jī)亮度、隨機(jī)對比度、隨機(jī)飽和度、隨機(jī)角度、隨機(jī)水平翻轉(zhuǎn)、隨機(jī)豎直翻轉(zhuǎn)的方法增強(qiáng)數(shù)據(jù),還加入了高斯噪聲,增加噪聲數(shù)據(jù)提升模型魯棒性。這七種數(shù)據(jù)增強(qiáng)方式的效果如圖7所示。

圖7 七種數(shù)據(jù)增強(qiáng)方式示例

通過混合使用以上七種圖片數(shù)據(jù)增強(qiáng)方法,便可獲得更大的數(shù)據(jù)樣本。

4.2 實(shí)驗(yàn)環(huán)境與設(shè)置

所有實(shí)驗(yàn)均在Linux Ubuntu平臺下完成,深度學(xué)習(xí)框架為PyTorch,框架版本1.8.1,Python版本3.8,CUDA版本11.1,顯卡選用NVIDIA GeForce RTX 3090,顯存為24G。

在使用的三個(gè)數(shù)據(jù)集中,F(xiàn)ER2013數(shù)據(jù)集已經(jīng)標(biāo)定好了訓(xùn)練集和測試集,而CK+和JAFFE數(shù)據(jù)集并未標(biāo)定訓(xùn)練集與測試集,對此采用十折交叉驗(yàn)證方法。網(wǎng)絡(luò)權(quán)重參數(shù)采用何愷明方法初始化,使用對數(shù)損失函數(shù)的隨機(jī)梯度下降法(BGD)更新權(quán)值,批大小為128。

考慮到實(shí)驗(yàn)中CK+和JAFFE數(shù)據(jù)集的圖像數(shù)量過少,為避免模型過擬合,先在FER2013數(shù)據(jù)集上預(yù)訓(xùn)練,再投入CK+和JAFFE數(shù)據(jù)集上進(jìn)行訓(xùn)練。

4.3 實(shí)驗(yàn)設(shè)置與結(jié)果分析

不同算法在各個(gè)數(shù)據(jù)集上的加權(quán)平均識別率結(jié)果如表2所示。

表2 各數(shù)據(jù)集加權(quán)平均識別率對比 單位:%

從表中可以看出,采用He-ResNeXt網(wǎng)絡(luò),在同等層數(shù)下三個(gè)數(shù)據(jù)集上的識別率都得到了提升,在CK+、FER2013和JAFFE上分別達(dá)到了97.91%、71.93%和95.28%,提升了1.47%、5.5%和1.68%;對比基礎(chǔ)的網(wǎng)絡(luò)中識別率最高的ResNet-50,獲得的提升則為2.54%、4.12%和2.09%。

對比其他數(shù)據(jù)集,F(xiàn)ER2013數(shù)據(jù)集識別率較低,對此,經(jīng)研究發(fā)現(xiàn)數(shù)據(jù)集存在部分圖像未對齊或未正確標(biāo)記,有的甚至存在沒有人臉的情況,因此總體識別率偏低;而JAFFE和CK+中圖像數(shù)量少,分辨率高,故識別率更高。

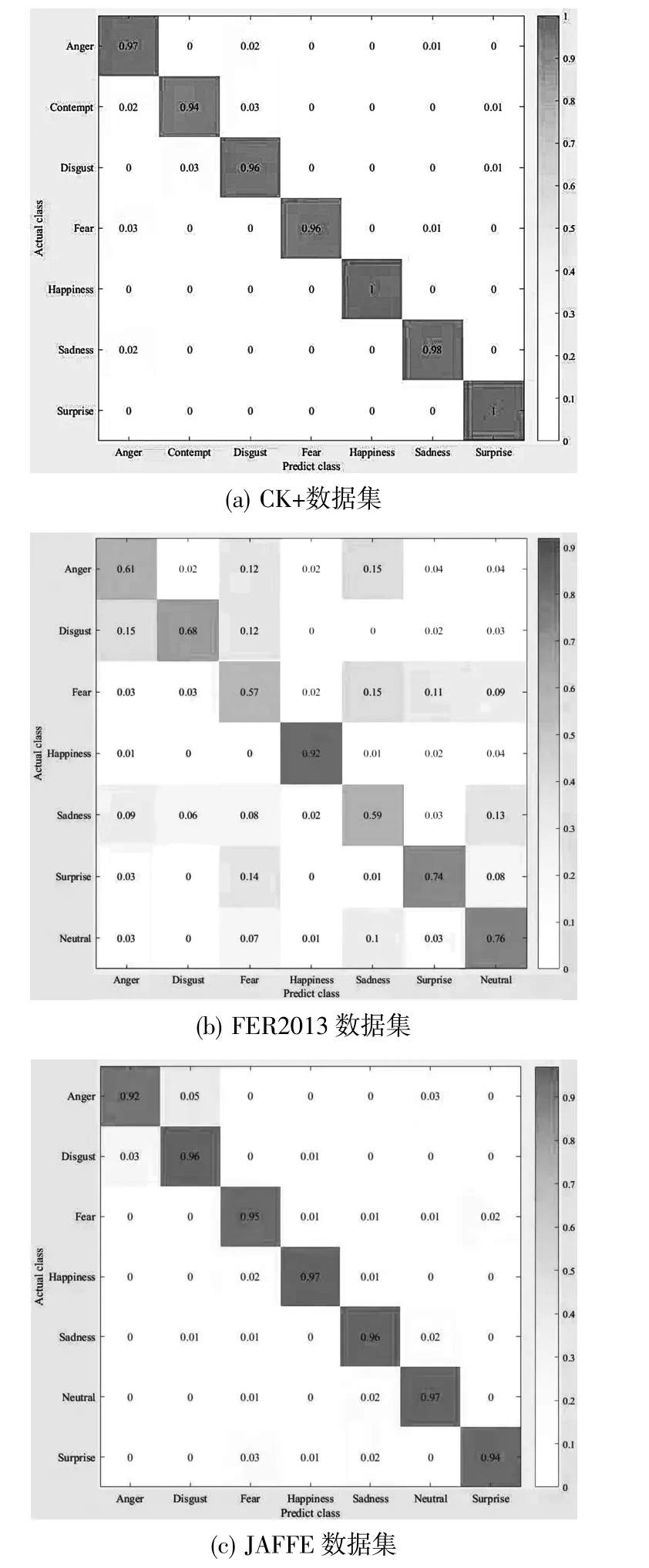

He-ResNeXt-29在識別實(shí)驗(yàn)中得到的混淆矩陣如圖8所示。

從圖8(a)上可以看出:在CK+數(shù)據(jù)集上,提出的網(wǎng)絡(luò)對于每類表情的識別率都較高。其中對于“高興”和“驚訝”的識別率達(dá)到了100%;對于“輕視”的識別率最低,也達(dá)到了94%,識別結(jié)果仍然較為理想。從圖8(b)中可以看出,對于FER2013整體識別率不高,最低的是“害怕”識別率,為57%,其容易被誤認(rèn)成“悲傷”、“驚訝”和“中性”。最高的是“高興”,識別率92%。“高興”的數(shù)據(jù)在訓(xùn)練集中權(quán)重也是最大的。從圖8(c)中可以看出,在JAFFE數(shù)據(jù)集上,表現(xiàn)同樣較好,只是對“憤怒”的識別率較低,容易被誤認(rèn)成“厭惡”和“中性”。

圖8 He-ResNeXt-29在各數(shù)據(jù)集上的混淆矩陣

4.4 消融實(shí)驗(yàn)

為了進(jìn)一步驗(yàn)證He-ResNeXt殘差塊設(shè)計(jì)及其特征融合策略的有效性,現(xiàn)以ResNeXt-29作為基礎(chǔ)網(wǎng)絡(luò),在區(qū)分度較高的FER2013數(shù)據(jù)集上進(jìn)行消融實(shí)驗(yàn),步驟如下:

a)首先對未添加任何模塊的基礎(chǔ)網(wǎng)絡(luò)ResNeXt-29進(jìn)行實(shí)驗(yàn);

b)更換基礎(chǔ)網(wǎng)絡(luò)ResNeXt-29的He-ResNeXt殘差塊,特征融合方式不變;

c)不改變ResNeXt-29的He-ResNeXt殘差塊,使用組內(nèi)優(yōu)先特征融合;

d)更換ResNeXt-29的He-ResNeXt殘差塊,并改變特征融合方式。

實(shí)驗(yàn)結(jié)果如表3所示。從實(shí)驗(yàn)結(jié)果可以看出,組合使用He-ResNeXt殘差塊和特征融合方式可以提高網(wǎng)絡(luò)識別率。

表3 消融實(shí)驗(yàn)結(jié)果

5 結(jié)束語

本研究中提出批量分組異構(gòu)的殘差人臉表情識別網(wǎng)絡(luò)He-ResNeXt,是基于主流網(wǎng)絡(luò)優(yōu)化,改善了原始網(wǎng)絡(luò)對圖像信息的提取能力。經(jīng)由實(shí)驗(yàn)也驗(yàn)證了新模型在原始模型基礎(chǔ)上獲得了相當(dāng)程度的提升。后續(xù)工作中還可在多個(gè)方面繼續(xù)作出改進(jìn):隨著硬件算力的提高,使得對視頻進(jìn)行表情識別成為可能,對于視頻的準(zhǔn)確表情識別更具應(yīng)用價(jià)值;可以進(jìn)行多模態(tài)工作,結(jié)合腦電、聲音、體溫、肢體動作等信息輔助表情識別系統(tǒng),提高系統(tǒng)穩(wěn)定性和識別的準(zhǔn)確度;在保證識別率的情況下,通過減少參數(shù)量,輕量化模型,使其在低算力平臺上部署成為可能。