動(dòng)態(tài)聚合權(quán)重的隱私保護(hù)聯(lián)邦學(xué)習(xí)框架

應(yīng)作斌,方一晨,張怡文

動(dòng)態(tài)聚合權(quán)重的隱私保護(hù)聯(lián)邦學(xué)習(xí)框架

應(yīng)作斌1,方一晨1,張怡文2

(1. 澳門城市大學(xué),中國(guó) 澳門 999078;2. 安徽新華學(xué)院,安徽 合肥 230000)

在非可信中心服務(wù)器下的隱私保護(hù)聯(lián)邦學(xué)習(xí)框架中,存在以下兩個(gè)問(wèn)題。①在中心服務(wù)器上聚合分布式學(xué)習(xí)模型時(shí)使用固定的權(quán)重,通常是每個(gè)參與方的數(shù)據(jù)集大小。然而,不同參與方具有非獨(dú)立同分布的數(shù)據(jù),設(shè)置固定聚合權(quán)重會(huì)使全局模型的效用無(wú)法達(dá)到最優(yōu)。②現(xiàn)有框架建立在中心服務(wù)器是誠(chéng)實(shí)的假定下,沒(méi)有考慮中央服務(wù)器不可信導(dǎo)致的參與方的數(shù)據(jù)隱私泄露問(wèn)題。為了解決上述問(wèn)題,基于比較流行的DP-FedAvg算法,提出了一種非可信中心服務(wù)器下的動(dòng)態(tài)聚合權(quán)重的隱私保護(hù)聯(lián)邦學(xué)習(xí)DP-DFL框架,其設(shè)定了一種動(dòng)態(tài)的模型聚合權(quán)重,該方法從不同參與方的數(shù)據(jù)中直接學(xué)習(xí)聯(lián)邦學(xué)習(xí)中的模型聚合權(quán)重,從而適用于非獨(dú)立同分布的數(shù)據(jù)環(huán)境。此外,在本地模型隱私保護(hù)階段注入噪聲進(jìn)行模型參數(shù)的隱私保護(hù),滿足不可信中心服務(wù)器的設(shè)定,從而降低本地參與方模型參數(shù)上傳中的隱私泄露風(fēng)險(xiǎn)。在數(shù)據(jù)集CIFAR-10上的實(shí)驗(yàn)證明,DP-DFL框架不僅提供本地隱私保證,同時(shí)可以實(shí)現(xiàn)更高的準(zhǔn)確率,相較DP-FedAvg算法模型的平均準(zhǔn)確率提高了2.09%。

聯(lián)邦學(xué)習(xí);差分隱私;動(dòng)態(tài)聚合權(quán)重;非獨(dú)立同分布數(shù)據(jù)

0 引言

隨著大數(shù)據(jù)的興起與發(fā)展,機(jī)器學(xué)習(xí)在計(jì)算機(jī)視覺(jué)、醫(yī)療、金融、電信、無(wú)人駕駛等領(lǐng)域廣泛應(yīng)用[1]。傳統(tǒng)的機(jī)器學(xué)習(xí)是由一個(gè)服務(wù)商從各個(gè)參與用戶處收集數(shù)據(jù)進(jìn)行統(tǒng)一的模型訓(xùn)練,因此會(huì)直接將原始數(shù)據(jù)泄露給第三方服務(wù)商。而這類數(shù)據(jù)中可能包含敏感類信息,如醫(yī)療健康信息(個(gè)人生理特征、既往病史、基因序列等)、文本郵件、交易記錄、資產(chǎn)數(shù)據(jù)、行蹤軌跡等[2-3]。

在滿足數(shù)據(jù)融合需求的條件下,解決數(shù)據(jù)孤島難題,同時(shí)保障包含敏感信息的數(shù)據(jù)共享中的隱私安全,聯(lián)邦學(xué)習(xí)技術(shù)應(yīng)運(yùn)而生。聯(lián)邦學(xué)習(xí)最早在2016年由Google公司提出,是一種分布式的機(jī)器學(xué)習(xí)框架,其核心機(jī)制是多個(gè)數(shù)據(jù)持有方(個(gè)人、企業(yè)、機(jī)構(gòu))在參與協(xié)同訓(xùn)練時(shí),僅在中間過(guò)程中交換模型參數(shù),無(wú)須直接共享原始數(shù)據(jù),從而避免原始敏感信息的泄露[4-6]。聯(lián)邦學(xué)習(xí)在一定程度上有效保護(hù)了原始數(shù)據(jù)直接泄露給第三方[7-9],但隨著對(duì)聯(lián)邦學(xué)習(xí)的深入研究,其自身框架存在的安全問(wèn)題被挖掘出來(lái)[10-12]。首先,聯(lián)邦學(xué)習(xí)存在一個(gè)中心服務(wù)器,中心服務(wù)器接收來(lái)自所有本地參與方客戶端的模型參數(shù),Nicolas等[13]發(fā)現(xiàn),一個(gè)不可信的中心服務(wù)器可以通過(guò)共享的參數(shù)(如梯度)還原原始的數(shù)據(jù)集。其次,參與聯(lián)邦學(xué)習(xí)的不可靠參與方客戶端可以輕松并且合法得到中間參數(shù)從而推斷出其他參與方的模型參數(shù),進(jìn)而通過(guò)模型參數(shù)獲取用戶數(shù)據(jù)[14]。參與方客戶端也可以通過(guò)構(gòu)建惡意的數(shù)據(jù)集誘導(dǎo)其他參與方暴露更多含有敏感信息的原始數(shù)據(jù)。此外,其他的第三方攻擊者可以通過(guò)發(fā)布的模型進(jìn)行模型重構(gòu)演練從而還原原始數(shù)據(jù)集收集敏感信息[15]。

對(duì)于聯(lián)邦學(xué)習(xí)算法的隱私保護(hù)問(wèn)題,需要一個(gè)嚴(yán)格的、有原則的框架來(lái)加強(qiáng)數(shù)據(jù)隱私。以差分隱私為代表的數(shù)據(jù)擾動(dòng)方法作為成熟的隱私保護(hù)技術(shù)已廣泛運(yùn)用于聯(lián)邦學(xué)習(xí)[16-23]。已有在聯(lián)邦學(xué)習(xí)的框架上引入差分隱私從而保護(hù)用戶數(shù)據(jù)的研究,McMahan等[24]提出了DP-FedAvg(differentially private-federated averaging)算法。DP-FedAvg在聯(lián)邦學(xué)習(xí)模型參數(shù)共享算法FedAvg[4]的基礎(chǔ)上,引入了差分隱私,是第一個(gè)通過(guò)應(yīng)用高斯機(jī)制來(lái)保證聯(lián)邦學(xué)習(xí)中用戶級(jí)差分隱私的算法。DP-FedAvg算法主要有兩個(gè)階段:①參與方使用本地?cái)?shù)據(jù)集訓(xùn)練模型;②中心服務(wù)器收集并聚合模型,通過(guò)加權(quán)平均獲得全局模型并注入高斯噪聲。然而,DP-FedAvg算法存在以下兩個(gè)問(wèn)題。

1) 在中心服務(wù)器中全局模型的聚合權(quán)重通常由用戶端的數(shù)據(jù)樣本量決定,這種設(shè)計(jì)假定數(shù)據(jù)在不同客戶端之間是同分布的,但在現(xiàn)實(shí)世界中,無(wú)法知道不同參與方的數(shù)據(jù)分布類型,即不同參與方之間很可能是非獨(dú)立同分布的數(shù)據(jù)(non-iid,non-independent and identically distributed data)。采用此種聚合方法導(dǎo)致模型的效用和適用能力不足。

2) DP-FedAvg算法建立在中心服務(wù)器是誠(chéng)實(shí)的假定下,然而中心可以接收到來(lái)自所有本地參與方的模型參數(shù)信息,一旦中心服務(wù)器不可信,它能利用本地參與方的模型參數(shù)倒推數(shù)據(jù)的分布特征,甚至倒推出具體的訓(xùn)練集數(shù)據(jù),導(dǎo)致本地參與方的數(shù)據(jù)隱私泄露,甚至出于利益相關(guān)將本地參與方的數(shù)據(jù)售賣給其他第三方,進(jìn)一步導(dǎo)致本地參與方的數(shù)據(jù)隱私大規(guī)模泄露。

針對(duì)以上問(wèn)題,本文提出了一種基于非可信中心服務(wù)器設(shè)定下的動(dòng)態(tài)聚合權(quán)重的隱私保護(hù)聯(lián)邦學(xué)習(xí)(DP-DFL,differentially private- dynamic federated learning)框架,主要貢獻(xiàn)總結(jié)如下。

1) 構(gòu)建了一種動(dòng)態(tài)的模型聚合權(quán)重的方法,該方法可以從數(shù)據(jù)中直接學(xué)習(xí)聯(lián)邦學(xué)習(xí)中的模型聚合權(quán)重,進(jìn)一步實(shí)現(xiàn)更好的性能和不同數(shù)據(jù)分布類型的通用。

2) 假定中心服務(wù)器不可信,設(shè)計(jì)了一種新的協(xié)議,參與方客戶端在本地模型隱私保護(hù)階段使用噪聲進(jìn)行模型參數(shù)的隱私保護(hù),從而降低本地參與方模型參數(shù)上傳中的隱私泄露風(fēng)險(xiǎn)。

3) 驗(yàn)證了所提算法的效率,在數(shù)據(jù)集CIFAR-10上采用兩種卷積神經(jīng)網(wǎng)絡(luò)模型進(jìn)行實(shí)驗(yàn),結(jié)果顯示,DP-DFL在有效保證本地隱私的條件下,平均準(zhǔn)確率相比DP-FedAvg算法提高了2.09%。

1 相關(guān)工作

越來(lái)越多的工作研究聯(lián)邦學(xué)習(xí)背景下的隱私保護(hù),將DP約束引入聯(lián)邦學(xué)習(xí)模型共享是其中一種主要的研究。Geyer[25]等提出了一種算法,中心服務(wù)器將高斯機(jī)制注入每一輪迭代后的權(quán)重矩陣中,將單個(gè)客戶的貢獻(xiàn)隱藏在聚合中。

McMahan[24]等也提出了類似的想法,DP-FedAvg算法和DP-FedSGD算法擴(kuò)展了FedAvg和FedSGD。FedAvg[4]算法和FedSGD[4]算法是聯(lián)邦學(xué)習(xí)中的經(jīng)典算法,中心服務(wù)器聚合每一輪迭代本地參與方客戶端的最優(yōu)梯度更新,F(xiàn)edAvg算法與FedSGD算法相比,前者在本地參與方客戶端進(jìn)行多輪迭代。DP-FedAvg算法和DP-FedSGD算法則是在每一輪的模型更新中加入擾動(dòng)。以上算法在共享模型參數(shù)時(shí)通常假定不同參與方的數(shù)據(jù)具有相同分布,在異質(zhì)環(huán)境下,DP-FedAvg算法和DP-FedSGD算法存在不穩(wěn)定性和收斂的問(wèn)題。

除此之外,非獨(dú)立同分布數(shù)據(jù)上的聯(lián)邦學(xué)習(xí)問(wèn)題引起了人們的關(guān)注。在非DP環(huán)境下,Wang[26]提出了一種歸一化的平均方法,在保持異質(zhì)數(shù)據(jù)用戶端快速收斂的同時(shí),消除了目標(biāo)的不一致性。Zheng[27]等在共享參數(shù)平均化階段引入了基于注意力的加權(quán)平均法,以針對(duì)異質(zhì)數(shù)據(jù)。在DP環(huán)境下,Hu[28]等針對(duì)數(shù)據(jù)異質(zhì)性問(wèn)題,提出了一種個(gè)性化的FL-DP方法,但此方法只針對(duì)線性模型。現(xiàn)有工作通常是在非DP環(huán)境下,考慮模型的統(tǒng)計(jì)數(shù)據(jù)或基本分布進(jìn)行聚合,對(duì)客戶數(shù)據(jù)進(jìn)行基于梯度的優(yōu)化,直接學(xué)習(xí)聚集權(quán)重的研究較少。聯(lián)邦學(xué)習(xí)中DP約束條件下數(shù)據(jù)異質(zhì)環(huán)境問(wèn)題的研究尚且不足,尤其是針對(duì)神經(jīng)網(wǎng)絡(luò)模型及數(shù)據(jù)類型為圖片的原始數(shù)據(jù)。為了解決數(shù)據(jù)異質(zhì)性這一問(wèn)題,在DP約束條件下的聯(lián)邦學(xué)習(xí)中,本文引入了一種為聯(lián)邦學(xué)習(xí)尋找最佳聚合權(quán)重的自動(dòng)化方法。通過(guò)使用Dirichlet分布[29-30]對(duì)權(quán)重進(jìn)行建模,將聚合權(quán)重由原來(lái)的依據(jù)客戶端數(shù)據(jù)集大小優(yōu)化為依據(jù)不同參與方的數(shù)據(jù)分布和模型的訓(xùn)練進(jìn)度。

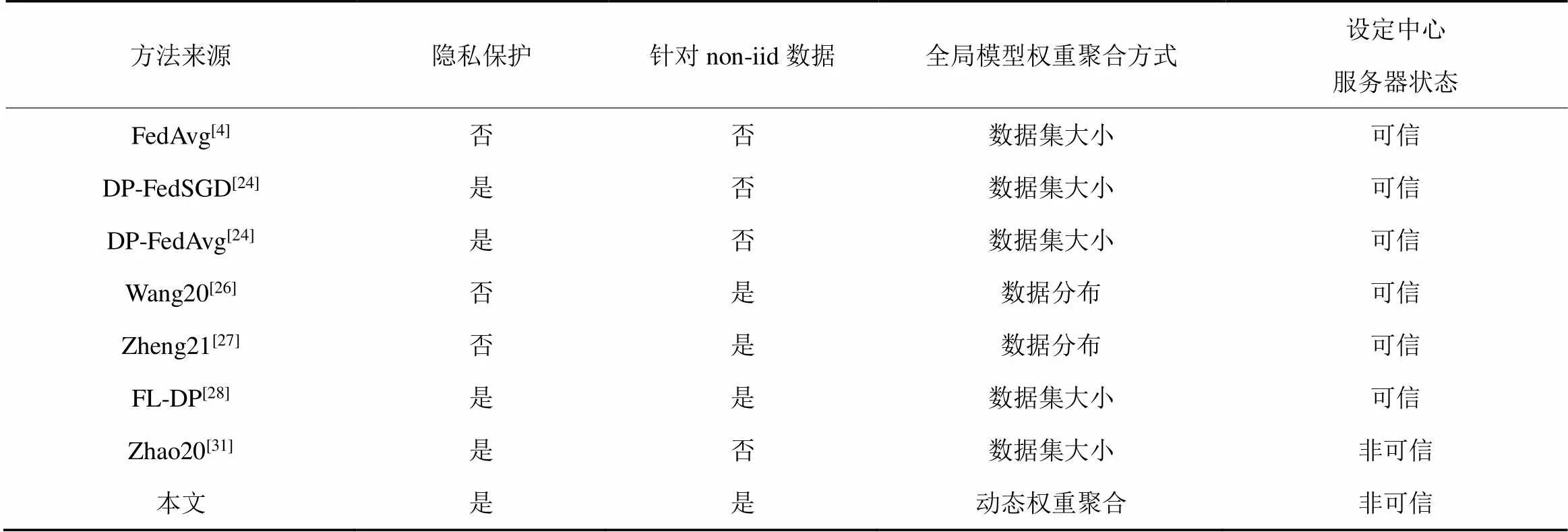

上述研究通常假定中心服務(wù)器是誠(chéng)實(shí)的,然而實(shí)際中,中心服務(wù)器可能是“誠(chéng)實(shí)但好奇”或是“惡意”的。Zhao[31]等考慮了DP-FedSGD算法在“誠(chéng)實(shí)但好奇”的中心服務(wù)器條件下的聯(lián)邦學(xué)習(xí)隱私保護(hù)。Li[32]等認(rèn)為服務(wù)器是“誠(chéng)實(shí)而好奇”的,但沒(méi)有確保用戶的端到端隱私。本文基于DP-FedAvg算法,并且假設(shè)中心服務(wù)器狀態(tài)為非可信,設(shè)定中心服務(wù)器處于兩種狀態(tài)中的“誠(chéng)實(shí)但好奇”這一狀態(tài),本地參與方客戶端在將參數(shù)發(fā)送給中心服務(wù)器前需要進(jìn)行擾動(dòng)保護(hù)。相關(guān)工作比較如表1所示。

表1 相關(guān)工作比較

2 基本定義

2.1 聯(lián)邦學(xué)習(xí)

2.2 差分隱私

定義1 嚴(yán)格差分隱私

傳統(tǒng)的DP基于最嚴(yán)格的假設(shè),即攻擊者擁有除了某一條信息以外的所有其他信息,但在現(xiàn)實(shí)中這類攻擊者是十分少見(jiàn)的。嚴(yán)格差分隱私在隱私性的保護(hù)方面十分嚴(yán)格,影響了數(shù)據(jù)在使用過(guò)程中的可用性,在實(shí)際應(yīng)用中主要使用含有松弛機(jī)制的差分隱私定義。帶有松弛機(jī)制的差分隱私與傳統(tǒng)差分隱私相比,引入了一個(gè)松弛項(xiàng)。

定義2 松弛差分隱私

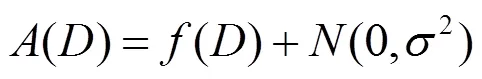

2.3 高斯機(jī)制

差分隱私通常通過(guò)添加噪聲的方式來(lái)擾動(dòng)數(shù)據(jù),具體實(shí)現(xiàn)機(jī)制有高斯機(jī)制、指數(shù)機(jī)制、拉普拉斯機(jī)制。其中,拉普拉斯機(jī)制僅針對(duì)傳統(tǒng)的差分隱私,而高斯機(jī)制可以滿足松弛的本地差分隱私。

定義3 全局敏感度

定義4 高斯噪聲機(jī)制

2.4 差分隱私隨機(jī)梯度下降法

得到梯度后對(duì)梯度進(jìn)行裁剪,即

3 方案實(shí)現(xiàn)

3.1 方案概述

本文提出了一種基于非可信中心服務(wù)器設(shè)定下的動(dòng)態(tài)聚合權(quán)重的隱私保護(hù)聯(lián)邦學(xué)習(xí)框架,流程如圖1所示。

圖1 DP-DFL流程

Figure 1 The illustration of DP-DFL

DP-DFL框架的完整流程為:①部分本地參與方客戶端從中心服務(wù)下載全局模型參數(shù)和聚合權(quán)重參數(shù);②本地參與方客戶端在本地訓(xùn)練模型和更新權(quán)重,并將DP隱私保護(hù),即采用DPSGD方法添加噪聲后的模型更新和動(dòng)態(tài)權(quán)重算法更新后的聚合權(quán)重上傳給中心服務(wù)器;③中心服務(wù)器接受本地參與方客戶端的模型更新和聚合權(quán)重更新,生成新的全局模型并進(jìn)行DP隱私保護(hù)添加噪聲;④重復(fù)上述每一輪迭代,直至達(dá)到設(shè)定的迭代輪數(shù)或期望的模型精確度。

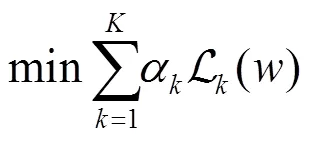

3.2 動(dòng)態(tài)聚合權(quán)重算法

算法1給出了動(dòng)態(tài)聚合權(quán)重算法的描述。

算法1 動(dòng)態(tài)聚合權(quán)重算法

9) end for

3.3 DP-DFL框架

表2列出了DP-DFL框架相關(guān)符號(hào)和定義。

表2 符號(hào)和定義

算法2給出了DP-DFL的描述。DP-DFL框架分為中心服務(wù)器端和參與方客戶端。在參與方客戶端,主要使用DP-SGD進(jìn)行模型的訓(xùn)練和參數(shù)的隱私保護(hù),具體步驟如下。

步驟4 (第4行):裁剪梯度,限制單個(gè)數(shù)據(jù)對(duì)整體的影響。

算法2 DP-DFL

中心服務(wù)器

11) end

6) end for

4 實(shí)驗(yàn)與結(jié)果

4.1 實(shí)驗(yàn)環(huán)境設(shè)置

實(shí)驗(yàn)環(huán)境:操作系統(tǒng)為Windows 10,CPU為InterCore i5-5250U,基于框架為TensorFlow2.0,開(kāi)發(fā)環(huán)境為Anaconda3、Python3.8.0、Pycharm、CUDA Toolkit 10.0。

數(shù)據(jù)集:CIFAR-10數(shù)據(jù)集共用60 000幅圖片,每幅照片均為32×32的彩色照片,每個(gè)像素點(diǎn)包含R、G、B這3個(gè)數(shù)值,數(shù)值范圍為0~255,照片可以劃分為10種不同的類別。其中,50 000幅圖片劃為訓(xùn)練集,10 000幅圖片劃為測(cè)試集。

4.2 結(jié)果分析

(1)non-iid結(jié)果分析

本文實(shí)驗(yàn)使用兩個(gè)常用的圖像分類問(wèn)題CNN模型Resnet18和VGG16。Resnet18網(wǎng)絡(luò)分為4層,每層有兩個(gè)模塊組成,第一層由兩個(gè)普通的殘差塊組成,其他3層由一個(gè)普通的殘差塊和下采樣的卷積塊組成。VGG16網(wǎng)絡(luò)中,主要有13層卷積層以及3層全連接層,其中卷積層和全連接層使用ReLU函數(shù)作為激活函數(shù)。為了模擬異質(zhì)數(shù)據(jù)的環(huán)境,對(duì)數(shù)據(jù)進(jìn)行non-iid操作,本文實(shí)驗(yàn)使用Zheng等[27]的方法對(duì)數(shù)據(jù)集進(jìn)行劃分。

圖2是模型設(shè)定為Resnet18時(shí)的實(shí)驗(yàn)結(jié)果,其中,圖2(a)挑選每輪參與訓(xùn)練的本輪訓(xùn)練的參與方的概率為0.2,圖2(b)概率為0.5。根據(jù)迭代10次后的模型最終準(zhǔn)確率,DP-DFL優(yōu)于DP-FedAvg,圖2(a)中DP-DFL準(zhǔn)確率為68.81%,高于DP-FedAvg的2.19%,圖2(b)中DP-DFL準(zhǔn)確率為78.56%,高于DP-FedAvg的2.42%。圖3是模型設(shè)定為VGG16時(shí)的實(shí)驗(yàn)結(jié)果,其中圖3(a)挑選每輪參與訓(xùn)練的本輪訓(xùn)練參與方的概率為0.2,圖3(b)概率為0.5。根據(jù)迭代10次后的模型最終準(zhǔn)確率,DP-DFL優(yōu)于DP-FedAvg,圖3(a)中DP-DFL準(zhǔn)確率為81.37%,高于DP-FedAvg的2.36%,圖3(b)中DP-DFL準(zhǔn)確率為88.21%,高于DP-FedAvg的1.39%。

圖2 Resnet18實(shí)驗(yàn)結(jié)果

Figure2 The experimental result of Resnet18

根據(jù)結(jié)果顯示,無(wú)論訓(xùn)練模型選擇Resnet18或VGG16,無(wú)論每輪迭代選取的本地參與方客戶端數(shù)量為2或5,DP-DFL在保障本地隱私的條件下,不僅模型精度沒(méi)有受損,相較DP-FedAvg算法的模型準(zhǔn)確率平均提高了2.09%。

差分隱私以損失部分準(zhǔn)確率來(lái)達(dá)到隱私保護(hù)的效果。將DP-DFL框架與其他兩個(gè)非DP環(huán)境下的聯(lián)邦學(xué)習(xí)方法相比,模型準(zhǔn)確率也未受到很大的影響。

(2)iid結(jié)果分析

圖3 VGG16實(shí)驗(yàn)結(jié)果

Figure 3 The experimental result of VGG16

圖4是iid環(huán)境下的實(shí)驗(yàn)結(jié)果,其中圖4(a)挑選每輪參與訓(xùn)練的本輪訓(xùn)練的參與方的概率為0.2,圖4(b)概率為0.5。結(jié)果表明,在同分布情況下,DP-DFL收斂速度雖然慢于DP-FedAvg,但在第10次全局迭代左右,兩者準(zhǔn)確率已經(jīng)達(dá)到相似水平。DP-DFL在同分布數(shù)據(jù)情況下仍可以保持良好的性能表現(xiàn)。

表3 實(shí)驗(yàn)結(jié)果

圖4 iid環(huán)境下的實(shí)驗(yàn)結(jié)果

Figure 4 The experimental result of iid

5 結(jié)束語(yǔ)

針對(duì)現(xiàn)有聯(lián)邦學(xué)習(xí)全局模型聚合時(shí),不同參與方客戶端擁有非獨(dú)立同分布的數(shù)據(jù)類型造成模型全局模型效用和適用性效果不高,以及中心服務(wù)器不可信的問(wèn)題,本文提出了一種DP-DFL框架。該框架在本地參與方模型訓(xùn)練階段引入了DP-SGD以保證本地模型參數(shù)的隱私不會(huì)被不可信第三方竊取,同時(shí),在本地模型參數(shù)聚合階段設(shè)計(jì)了一種新的動(dòng)態(tài)模型聚合權(quán)重的方法。實(shí)驗(yàn)驗(yàn)證,DP-DFL不僅進(jìn)一步保證了用戶隱私,而且模型精度優(yōu)于DP-FedAvg算法。未來(lái)的工作將研究更復(fù)雜的聚合操作,同時(shí)可以模擬現(xiàn)實(shí)真實(shí)攻擊,尋找效用和隱私保護(hù)均衡更優(yōu)的方法。

[1] LI T, SAHU A K, TALWALKAR A, et al. Federated learning: challenges, methods, and future directions[J]. IEEE Signal Processing Magazine, 2020, 37(3): 50-60.

[2] XU X H, PENG H, SUN L C, et al. Fedmood: federated learning on mobile health data for mood detection[J]. arXiv preprint arXiv:2102.09342, 2021.

[3] CHE SICONG, PENG H, SUN L C, et al. Federated multiview learning for private medical data integration and analysis[J]. arXiv preprint arXiv:2105.01603, 2021.

[4] MC-MAHAN B, MOORE E, RAMAGE D, et al. Communication-efficient learning of deep networks from decentralized data[C]//Artificial Intelligence and Statistics. 2017: 1273-1282.

[5] LIU Z, GUO J, YANG W, et al. Privacy-preserving aggregation in federated learning: a survey[J]. arXiv preprint arXiv: 2203.17005, 2022.

[6] RAMASWAMY S, THAKKAR O, MATHEWS R, et al. Training production language models without memorizing user data[J]. arXiv preprint arXiv:2009.10031, 2020.

[7] LI Z, SHARMA V, MOHANTY S P. Preserving data privacy via federated learning: challenges and solutions[J]. IEEE Consumer Electronics Magazine, 2020, 9(3): 8-16.

[8] LI T, SAHU A K, ZAHEER M, et al. Federated optimization in heterogeneous networks[J]. Proceedings of Machine Learning and Systems, 2020, 2: 429-450.

[9] 陳前昕, 畢仁萬(wàn), 林劼, 等. 支持多數(shù)不規(guī)則用戶的隱私保護(hù)聯(lián)邦學(xué)習(xí)框架[J]. 網(wǎng)絡(luò)與信息安全學(xué)報(bào), 2022, 8(1): 139-150.

CHEN Q X, BI R W, LIN J, et al. Privacy-preserving federated learning framework with irregular-majority users[J]. Chinese Journal of Network and Information Security, 2022, 8(1): 139-150.

[10] 劉藝璇, 陳紅, 劉宇涵, 等. 聯(lián)邦學(xué)習(xí)中的隱私保護(hù)技術(shù)[J]. 軟件學(xué)報(bào), 2021, 33(3): 1057-1092.

LIU Y X, CHEN H, LIU Y H, et al. Privacy-preserving techniques in Federated Learning[J]. Journal of Software, 2022, 33(3): 1057?1092.

[11] 王騰, 霍崢, 黃亞鑫, 等. 聯(lián)邦學(xué)習(xí)中的隱私保護(hù)技術(shù)研究綜述[J].計(jì)算機(jī)應(yīng)用, 2022.

WANG T, HUO Z, HUANG Y X, et al. Survey of privacy-preserving technologies in federated learning [J]. Journal of Computer Applications,2022.

[12] FIGURNOV M, MOHAMED S, MNIH A. Implicit repara-meterization gradients[C]//Advances in Neural Information Processing Systems. 2018: 441-452.

[13] PAPERNOT N, ABADI M, ERLINGSSON U F, et al. Semi-supervised knowledge transfer for deep learning from private training data[C]//ICLR. 2017.

[14] SONG C, RISTENPART T, SHMATIKOV V. Machine learning models that remember too much[C]//2017 ACM SIGSAC Conf. on Computer and Communications Security. 2017: 587-601.

[15] SHOKRI R, STRONATI M, SONG C, et al. Membership inference attacks against machine learning models[C]//2017 IEEE Symposium on Security and Privacy (SP). 2017: 3-18.

[16] KIM M, GüNLü O, SCHAEFER R F. Federated learning with local differential privacy: Trade-offs between privacy, utility, and communication[C]//ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). 2021: 2650-2654.

[17] SUN L, QIAN J, CHEN X. LDP-FL: practical private aggregation in federated learning with local differential privacy[J]. arXiv preprint arXiv:2007.15789, 2020.

[18] ABADI M, CHU A, GOODFELLOW I, et al. Deep learning with differential privacy[C]//Proceedings of the 2016 ACM SIGSAC Conference on Computer and Communications Security. 2016: 308-318.

[19] MIRONOV I, TALWAR K, ZHANG L. R'enyi differential privacy of the sampled gaussian mechanism[J]. arXiv preprint arXiv:1908.10530, 2019.

[20] SUN L, LYU L. Federated model distillation with noise-free differential privacy[J]. arXiv preprint arXiv:2009.05537, 2020.

[21] NAGAR A, TRAN C, FIORETTO F. Privacy-preserving and accountable multi-agent learning[C]//AAMAS Conference proceedings. 2021.

[22] DAI Z, LOW B K H, JAILLET P. Differentially private federated Bayesian optimization with distributed exploration[J]. Advances in Neural Information Processing Systems, 2021, 34.

[23] ANDREW G, THAKKAR O, MCMAHAN B, et al. Differentially private learning with adaptive clipping[J]. Advances in Neural Information Processing Systems, 2021, 34.

[24] MC-MAHAN H B, RAMAGE D, TALWAR K, et al. Learning differentially private recurrent language models[C]//arXiv preprint arXiv:1710.06963, 2017.

[25] GEYER R C, KLEIN T, NABI M. Differentially private federated learning: a client level perspective[J]. arXiv preprint arXiv:1712.07557, 2017.

[26] WANG J Y, LIU Q H, LIANG H, et al. Tackling the objective inconsistency problem in heterogeneous federated optimization[C]// NeurIPS. 2020.

[27] ZHENG Q, CHEN S, LONG Q, et al. Federated f-differential privacy[C]//International Conference on Artificial Intelligence and Statistics. 2021: 2251-2259.

[28] HU R, GUO Y X, LI H N, et al. Personalized federated learning with differential privacy[J]. IEEE Internet of Things Journal, 7(10):9530–9539, 2020.

[29] CHEN X N, WANG R C, CHENG M H, et al. Drnas: dirichlet neural architecture search[J]. arXiv preprint arXiv:2006.10355, 2020.

[30] XIA Y, YANG D, LI W, et al. Auto-FedAvg: learnable federated averaging for multi-institutional medical image segmentation[J]. arXiv preprint arXiv:2104.10195, 2021.

[31] ZHAO Y, ZHAO J, YANG M, et al. Local differential privacy-based federated learning for internet of things[J].IEEE Internet of Things Journal,2022,8(11):8836-8853.

[32] LI Y W, CHANG T H, CHI C Y. Secure federated averaging algorithm with differential privacy[C]//2020 IEEE 30th International Workshopon Machine Learning for Signal Processing (MLSP), 2020: 1-6.

Privacy-preserving federated learning framework with dynamic weight aggregation

YING Zuobin1, FANG Yichen1, ZHANG Yiwen2

1. City University of Macau, Macau 999078, China 2. Anhui Xinhua University, Hefei 230000, China

There are two problems with the privacy-preserving federal learning framework under an unreliable central server.① A fixed weight, typically the size of each participant’s dataset, is used when aggregating distributed learning models on the central server. However, different participants have non-independent and homogeneously distributed data, then setting fixed aggregation weights would prevent the global model from achieving optimal utility. ② Existing frameworks are built on the assumption that the central server is honest, and do not consider the problem of data privacy leakage of participants due to the untrustworthiness of the central server. To address the above issues, based on the popular DP-FedAvg algorithm, a privacy-preserving federated learning DP-DFL algorithm for dynamic weight aggregation under a non-trusted central server was proposed which set a dynamic model aggregation weight. The proposed algorithm learned the model aggregation weight in federated learning directly from the data of different participants, and thus it is applicable to non-independent homogeneously distributed data environment. In addition, the privacy of model parameters was protected using noise in the local model privacy protection phase, which satisfied the untrustworthy central server setting and thus reduced the risk of privacy leakage in the upload of model parameters from local participants. Experiments on dataset CIFAR-10 demonstrate that the DP-DFL algorithm not only provides local privacy guarantees, but also achieves higher accuracy rates with an average accuracy improvement of 2.09% compared to the DP-FedAvg algorithm models.

federated learning, differential privacy, dynamic aggregationweight, non-independent and identically distributeddata

TP393

A

10.11959/j.issn.2096?109x.2022069

2022?04?09;

2022?09?06

方一晨,fyc980601@163.com

澳門科學(xué)技術(shù)發(fā)展基金(0038/2022/A)

General R&D Subsidy Program Fund Macau (0038/2022/A)

應(yīng)作斌, 方一晨, 張怡文. 動(dòng)態(tài)聚合權(quán)重的隱私保護(hù)聯(lián)邦學(xué)習(xí)框架[J]. 網(wǎng)絡(luò)與信息安全學(xué)報(bào), 2022, 8(5): 56-65.

Format: YING Z B, FANG Y C, ZHANG Y W. Privacy-preserving federated learning framework with dynamic weight aggregation [J]. Chinese Journal of Network and Information Security, 2022, 8(5): 56-65.

應(yīng)作斌(1982?),男,安徽蕪湖人,澳門城市大學(xué)助理教授,主要研究方向?yàn)閰^(qū)塊鏈、聯(lián)邦學(xué)習(xí)。

方一晨(1998?),女,浙江湖州人,澳門城市大學(xué)碩士生,主要研究方向?yàn)椴罘蛛[私、聯(lián)邦學(xué)習(xí)。

張怡文(1980?),女,安徽阜陽(yáng)人,安徽新華學(xué)院教授,主要研究方向?yàn)閿?shù)據(jù)挖掘、聯(lián)邦學(xué)習(xí)。