生成對抗網絡研究綜述

劉鶴丹,葉漢平,徐夢真,趙旭磊

(廈門大學嘉庚學院 信息科學與技術學院,福建 漳州 363105)

0 引 言

隨著人工智能和深度學習的發展,GAN的出現成為了深度學習領域學者們研究的熱點。GAN在多個領域均表現得極其出色,如圖像的生成[1]、修復[2]、識別[3-5]等。機器學習算法可分為監督學習和無監督學習兩類,監督學習譬如YOLO系列[6]需要依賴已知的帶標記數據進行訓練,這類算法雖有較好的效果但消耗成本較高;而無監督學習因其無須提前標記好數據,受到越來越多學者們的青睞,并且GAN具有無須監督和做數據標記的優勢,解決了數據集問題[7]。GAN不僅可生成高質量圖像,還可進行圖像增強、圖像遷移。

1 GAN的理論基礎

GAN(生成對抗網絡)[8]由兩大部分組成:生成器網絡(Generative Model)、判別器網絡(Discriminative Model)。生成器根據要求會不斷生成與實際標簽數據相近的數據,并傳遞給判別器;判別器會區分生成器生成數據的結果與實際標簽之間的區別,并且判別器會根據判斷后產生的誤差反向傳遞至生成器中進行更新,生成器收到反饋后會生成更加接近的數據再傳遞給判別器,迭代數次后,直至生成器生成的數據使判別器無法區分數據的真實性才停止訓練。

如圖1所示,生成器G接收到隨機變量z的數據后,會生成假樣本數據G(z);將其傳入到判別器D中,判別器會對接收的真實樣本數據x進行判別處理并輸出生成結果。生成結果為判別器D輸入的是否為真實分布的概率,若為1則數據為真實數據,為0則為假數據。同時,判別器D會把輸出結果返回給生成器G用于其訓練。當D的輸出概率值為0.5左右,表明無法區別數據來源,即模型已達到最優狀況,則停止訓練。而該停止條件如果導致判別器D判別沒調好,會造成不收斂、模式崩潰、梯度弱化,甚至消失等問題,當梯度消失時,訓練的生成器G相當于沒有訓練時的狀態。這也是GAN模型難以訓練的原因[9]。

圖1 GAN網絡模型的基本結構示意圖

2 GAN變體模型

GAN的訓練較為困難,因此在研究者們的不斷探索中出現了很多不同的變體模型,本章對具有代表性的變體模型進行簡述與分析。

2.1 DCGAN

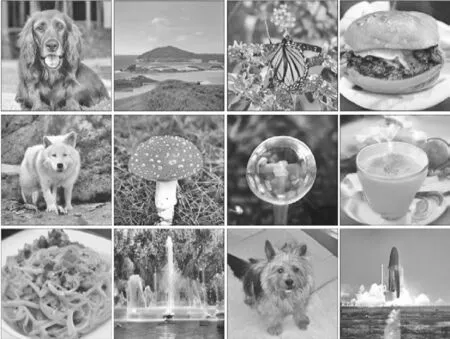

DCGAN(Deep Convolutional GAN)[10], 由 Alec Radford于2015年提出,是最基本的GAN版本,通過改變卷積神經網絡的結構提高了樣本質量和收斂速度,許多GAN模型都基于DCGAN進行了改進。它可以很好地適應于卷積神經網絡,能夠有效實現高質量圖片的生成和相關模型生成。其中包含了一種突破性的關鍵技術:批歸一化。DCGAN的生成效果如圖2所示。雖然DCGAN的批歸一化效果被證明是有效的,但經過實驗發現如果改變某些層的BN或者改變激活函數,都可能導致網絡生成的圖像為噪聲。

圖2 DCGAN的生成效果

2.2 BigGAN

BigGAN(Large Scale GAN)[11]被稱為史上最強的GAN圖像生成器,首次生成具有高保真度和低品種差距的圖像。它與傳統的GAN的區別之一在于訓練中采用了很大的Batch值,同時也增強了卷積的通道數和網絡參數,還包含了“截斷技巧”和模型穩定性的控制等。隨著相關研究的不斷進步,還衍生出了BiGAN、BigBiGAN。BigGAN的生成效果如圖3所示。

圖3 BigGAN的生成效果

2.3 StyleGAN

StyleGAN (A Style-based Generator Architecture for GAN)[12]從ProGAN中演變而來,具有可基于樣式的生成器,可生成更高質量的高分辨率圖像。StyleGAN將生成的過程可控化,可通過數據集中的屬性轉換圖像中的風格,譬如可以實現無監督地修改人臉姿勢、身份、發型等,生成相對應的圖像,還可以生成汽車、臥室等高質量圖像。

StyleGAN參考了ProGAN,發現漸進層的視覺特征會受層和分辨率的影響,越高的分辨率越可進行更細微和精確地控制。根據不同的分辨率范圍,在StyleGAN中分為粗糙、中等、高質三種類型。StyleGAN在GAN模型基礎上刪除了傳統輸入,添加了噪聲noise,使用了自適應實例歸一化(AdaIN)。

StyleGAN極大幅度地提高了研究者們對GAN合成的理解和可控性。隨著StyleGAN的發展,其版本已經延續到StyleGAN3。StyleGAN的生成效果如圖4所示。

圖4 StyleGAN的生成效果

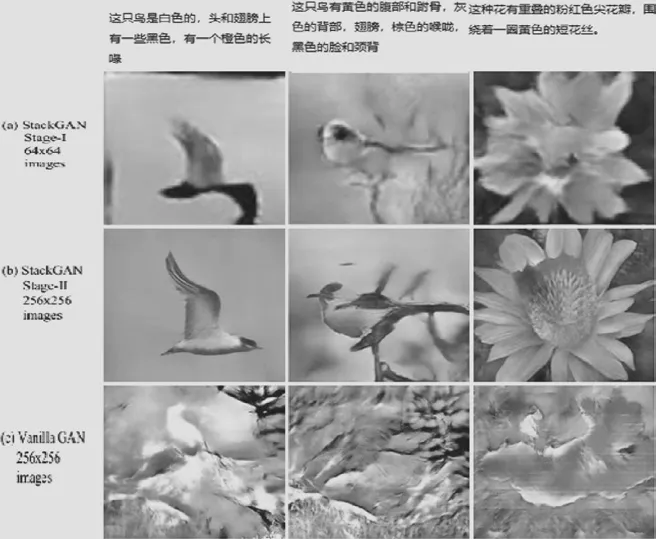

2.4 StackGAN

StackGAN(Text to Photo-Realistic Image Synthesis With Stacked GAN)[13]是首個可根據文本描述來生成圖像分辨率達到256×256的網絡模型。StackGAN的訓練方式分為兩個階段。其中Stage-I會通過給定的文字生成低分辨率(64×64)圖片; Stage-Ⅱ在Stage-Ⅰ基礎上生成高分辨率(256×256)圖片并捕獲被Stage-I忽視的文字信息,修正Stage-I結果的缺陷、添加細節。這種分段式模型可能由于每個任務找不到重點而導致生成失敗。StackGAN 的生成效果如圖5所示。

圖5 StackGAN 的生成效果

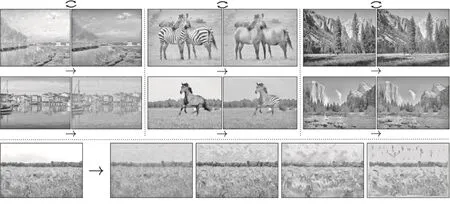

2.5 CycleGAN

CycleGAN (Unpaired Image-To-Image Translation Using Cycle-Consistent GAN)的核心思想是:設有X域和Y域兩個域,從X中映射Y,再從Y中映射X,循環往復[14],如圖6所示。

圖6 CycleGAN的核心原理

CycleGAN主要應用于域遷移(Domain Adaptation)領域。域遷移是將數據從一個域移動到另一個域的過程,譬如將照片中的馬轉換成斑馬。在傳統算法中,一般對于兩個域之間的某一物體相互轉換需要該兩個域之間具有相同的成對圖片作為數據集進行訓練,如pix2pix[15],而CycleGAN并不需要成對的圖片作為訓練數據,只需要有充足的圖片數據集就可實現物品之間的相互轉換。CycleGAN的生成效果如圖7所示。

圖7 CycleGAN的生成效果

3 GAN系列的主要應用領域

3.1 圖像生成

GAN作為一個生成模型,能從大量的無標簽數據中無監督地學習到一個具備生成各種形態(圖像、語音、語言等)數據能力的函數(生成器),因此可以達到數據增廣的目的。但GAN并不是單純地對真實數據的復現,而是具備一定的數據內插和外插作用。例如:路面生成[16]、機器翻譯[17-18]、二次元風格轉換[19]、人臉生成[20]等。

在CQMM的基本框架下,課題組以如下方式引入家庭負債率變動所產生的這兩條傳遞渠道:首先,假定居民負債率的變化是外生的。其次,建立居民負債率的變動對居民貸款和存款的影響機制。在貸款方面,構建行為方程由居民負債率和GDP共同決定居民貸款;在存款方面,居民負債率將決定居民消費,進而決定居民存款。最后,定義居民貸存比為居民貸款與居民存款之比,將其與一年期人民幣基準貸款利率作為解釋變量,對資金市場的加權利率進行回歸,以此內生化資本市場的利率決定。

3.2 圖像超分辨率

圖像超分辨率相關的研究中一個比較重要的課題是對天文圖像和衛星圖像做超分辨率,該課題的成果在各領域得到廣泛應用。例如SRGAN(Super-Resolution Generative Adversarial Network)[21]可應用于圖像超分辨率方面。它基于相似性感知方法[22]提出了損失函數,可有效解決恢復后的圖像丟失高頻細節問題。

3.3 圖像合成

圖像合成是通過某種形式的圖像描述創建新圖像的過程。CycleGAN[14]和pix2pix[15]均屬于圖像合成領域,具體應用例如:應用于場景合成的pix2pix[15],應用于人臉合成[23]的TpGAN[24],應用于文本到圖像合成的StackGAN[13],應用于風格遷移的CycleGAN[14]。

3.4 其 他

GAN除了被應用于以上三個領域外,在其他領域也有著很好的表現,如3D打印[25]、圖形修復[26]、圖片編輯[27]、人體相關的姿態估計[28]、自動駕駛[29]、目標跟蹤檢測[30-32]等。

4 GAN與傳統算法對比

4.1 GAN的優勢

GAN是一種生成式模型,相比于其他生成模型只用到了反向傳播,而無需復雜的馬爾科夫鏈,可產生更為清晰和真實的樣本;其采用無監督訓練,可廣泛用在無監督、半監督學習領域。相比于其他機器學習模型,不受樣本脆弱性的影響,可應用于圖片風格遷移、超分辨率、圖像補全、去噪等場景,避免了損失函數設計的困難;還可以通過GAN生成以假亂真的樣本,緩解了小樣本機器學習的困難。

4.2 GAN的劣勢

訓練GAN需要達到納什均衡,采用梯度下降法不一定都可以實現。目前并沒有達到納什均衡的更好方法,因此訓練GAN并不穩定。

(1)梯度消失:隨著訓練次數增加,G、D的生成和判別能力逐漸增強且互相影響,當D訓練到最好的情況下,原始GAN中G的損失函數存在自相矛盾的缺陷,從而導致GAN很難訓練,微調敏感。

(2)模式崩潰:模型只學習到真實樣本分布的一部分,導致模型生成的樣本單一,樣本差異較小。

(3)GAN不適合處理文本等離散形式的數據。

5 前景預測

如何根據簡單的隨機輸入生成多樣的、能夠更好地與人類進行交互的數據,更好地配合深度學習,是GAN的近期發展方向。如何讓GAN與特征學習、模仿學習、強化學習等技術更好地融合,利用GAN的特性或博弈論思想來推動人工智能的發展與應用,提高其對世界的理解甚至激發其創造能力是值得研究的問題。GAN是生成式模型,采用模型學習方式來估測其分布并生成同分布的新樣本,因此在圖像視覺計算、語音語言處理、信息安全等領域有巨大的應用價值。但GAN解決了生成式模型問題的同時也引入了新的問題[33],譬如有限的注釋、多樣性有限、受限數據、訓練波動大等。以下四個方面是今后針對GAN進行研究的新方向:

(1)資源問題的解決受數據集的限制,使得GAN沒有普適性和安全性。

(2)可結合其他機器學習算法改善GAN的目標函數和框架,對結構進行拓展。

(3)實現統一的度量標準。由于GAN的速度有快有慢,各自都有自己的優勢,所以無法判斷模型的好壞。

(4)需要更加完善的體系來減少梯度損失、模型不穩定等因素帶來的干擾。

6 結 語

本文簡要介紹了GAN的基本概念、代表模型及主要應用領域,從多個角度對GAN和傳統算法進行深入的對比與分析,闡述了GAN在當前社會的研究意義以及未來前景預測。