基于改進Seq2Seq-Attention 模型的文本摘要生成方法

門鼎,陳亮

(西安工程大學計算機科學學院,陜西 西安 710048)

隨著社會進入信息時代,人們可以通過多種渠道從互聯(lián)網(wǎng)平臺獲取重要信息,信息社會中人們把時間和精力花在閱讀大量信息上。互聯(lián)網(wǎng)上的信息盈余,將引導人們有效地解決信息過載的問題,而從海量的有效數(shù)據(jù)來看信息化的工作量不僅是巨大的,而且是迫切需要解決的問題。網(wǎng)絡(luò)數(shù)據(jù)需要從大量文本信息中快速挖掘語義數(shù)據(jù)。因此,通過文本摘要生成技術(shù)可以快速獲得文本主要信息。

自動摘要生成技術(shù)不僅過程完全自動化,而且生成的摘要概括能力強。互聯(lián)網(wǎng)上的文本信息數(shù)量龐大,自動摘要生成技術(shù)可以幫助用戶自動歸納文本信息的主要內(nèi)容,節(jié)省了用戶的閱讀時間。當人工閱讀文本信息總結(jié)文本主旨時,摘要質(zhì)量的高低依賴于讀者自身的語言概括能力和信息提取能力,容易導致捕獲的語義與文本核心主旨形成較大偏差。在面對復雜且篇幅過長的文本時,人們的閱讀理解能力有限,不能快速準確地獲取文本主旨。自動摘要生成技術(shù)模仿人工摘要過程,學習文本的深層語義,具有高水準的概括能力。

該文利用抽取式與生成式摘要抽取模型相結(jié)合的方法應(yīng)用在工業(yè)領(lǐng)域中,對于文本提取摘要的技術(shù)做出創(chuàng)新,在摘要提取的準確度、核心詞以及詞匯重復等方面做出一些突破,結(jié)合BERT 摘要模型進行摘要句抽取[1],分析Seq2Seq-Attention 模型,并通過Seq2Seq-Attention 模型進行文本摘要生成,在注意力機制中加入核心詞,然后結(jié)合指針網(wǎng)絡(luò)生成模型[2],該模型可以通過核心詞中的重要信息,構(gòu)建出摘要框架,生成信息全面精煉的文章摘要。

1 相關(guān)工作

1.1 問題描述

文本摘要問題一直是學者們研究的焦點,該文采用文本自動摘要技術(shù),將其凝練復制成一段簡單有效的段落,對于機器翻譯過程中會存在關(guān)鍵詞丟失、詞匯重復以及語句不通順等問題。調(diào)研了關(guān)于西安高壓開關(guān)操動有限公司項目的質(zhì)量數(shù)據(jù)管理問題,其中,質(zhì)量問題主要包括質(zhì)量問題的描述、質(zhì)量問題的分類以及原因等。通過調(diào)研公司目前客戶經(jīng)常出現(xiàn)的質(zhì)量問題,方便進行統(tǒng)計分析。調(diào)研質(zhì)量問題,產(chǎn)生大量文本數(shù)據(jù),不利于后期管理和查詢統(tǒng)計,為了使工業(yè)生產(chǎn)更加信息化,通過收集工業(yè)數(shù)據(jù)集,進行廣泛的實驗,構(gòu)建一種新的混合模型應(yīng)用于工業(yè)領(lǐng)域,進行技術(shù)創(chuàng)新并解決以上問題。

1.2 系統(tǒng)框架

BERT 模型中集成文章的主題信息,在長語句處理時會出現(xiàn)問題。因為Seq2Seq 模型將產(chǎn)生數(shù)據(jù)截斷,導致丟失信息。于是提出融合核心詞注意機制,把全文本作為摘要輸出。

結(jié)合現(xiàn)有的文本摘要模型技術(shù),構(gòu)建出一個新的混合模型,處理流程如圖1 所示。

圖1 文本摘要混合模型處理流程

2 文本摘要自動生成的方法

2.1 基于BERT模型的摘要句抽取

BERT 模型采用Transformer 網(wǎng)絡(luò)結(jié)構(gòu)[2],對語言模型進行預訓練,通過多次語言訓練得到一種通用的語言理解模型。BERT 語言模型的結(jié)構(gòu)如圖2所示。

圖2 BERT語言模型結(jié)構(gòu)

雙向預訓練與單項預訓練有所不同,BERT 在文本摘要抽取過程中,利用了遮蔽語言機制來表示深度雙向訓練。在許多訓練模式中,BERT 可以根據(jù)特定的任務(wù)需求改變體系結(jié)構(gòu)的需求。同時,它在訓練過程中顯示了自己先進的性能。BERT 擁有兩個變體,一個是BERTBASE,該變體擁有12 層Transformer 模塊,另一個變體是BERTLarge:,該變體擁 有24 層Transformer 模塊。

2.2 Seq2Seq模型

2014 年,Seq2Seq 模型[3]進入文本摘要的研究領(lǐng)域,學者們試圖將其應(yīng)用到機器學習等各個領(lǐng)域中,該模型的本質(zhì)就是Encoder-Decoder 框架,在生成摘要的過程中,輸入一段長文本,使用編碼器進行編碼,得到原文的向量化表示,然后用解碼器進行解碼得到文本摘要,輸出的句子是短文本。Seq2Seq 模型結(jié)構(gòu)如圖3 所示。

圖3 Seq2Seq模型結(jié)構(gòu)

2.3 Seq2Seq-Attention模型

Encoder-Decoder 框架在需要語句向量中存在較大的局限性。該模型在解碼過程中需要壓縮整個語句向量,這就使得壓縮后的語句與原來的文本主旨存在差異,原文本中的重要信息隨著壓縮逐漸變少,重要信息存在遺漏,在解碼階段就不會產(chǎn)生重要信息,導致解碼關(guān)鍵信息丟失。

該文提出的Attention 模型[4-6],在文本輸出時,會有一個特定的范圍把需要關(guān)注的重要信息標記出來,然后根據(jù)這些標記的主要信息生成輸出。Seq2Seq模型中,因為向量自身長度限制,輸出過長的文本導致信息丟失,在Attention 模型中,可以分為多個向量來儲存信息,在編碼階段,把重要信息標注出來,在向量輸出后進行調(diào)整,該模型在編碼端使用雙向LSTM,在解碼端使用單項LSTM。模型圖如圖4所示。

圖4 Seq2Seq-Attention模型

2.4 改進模型

在Seq2Seq-Attention 模型[7-8]中,對于長文本多次出現(xiàn)未登錄詞以及生成詞匯重復率極高的情況,使得原文本中重要信息在解碼階段,由于向量長度的自身限制沒有解碼出來,導致得到的摘要讀起來不通順,原文主要意思無法表達出來。于是加入指針網(wǎng)絡(luò)來解決這一問題。

2.4.1 指針網(wǎng)絡(luò)

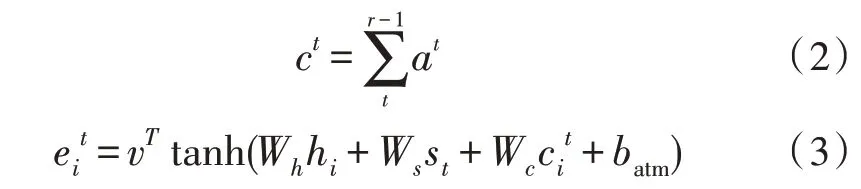

模型中添加指針網(wǎng)絡(luò)[9-10],為了能夠在模型抽取原文主要信息后,可以自動生成標題,而且可以根據(jù)生成詞匯擴充新詞匯來豐富生成的摘要信息,有效提高了原文信息的利用率,使得生成的摘要內(nèi)容信息更加飽滿,讀者閱讀也會更加通順。相關(guān)公式如下:

式中,Pgen作為開關(guān),可控制新詞生成。

2.4.2 覆蓋機制

在Seq2Seq-Attention 模型中,重復問題比較嚴重,由于在機制計算時,機制計算在不同時間段內(nèi)相對獨立,模型在采集信息位置上會出現(xiàn)重復現(xiàn)象,這就導致生成文本摘要會出現(xiàn)重復詞匯或者會漏掉相應(yīng)的重要信息。在絕大多數(shù)長文本中會重復出現(xiàn)一些詞匯,這也說明這些詞匯十分重要,針對該詞匯模型注意力會更加集中,因此,模型需要對已經(jīng)注意過的位置進行標記,防止下次再集中到某一位置,而導致某一詞匯多次出現(xiàn)。因此,該文在原有模型中加入覆蓋機制。相關(guān)公式如下:

2.4.3 核心詞注意力機制

神經(jīng)網(wǎng)絡(luò)進行摘要生成的過程中,原文中許多詞匯沒有編譯出來,文章主旨表述不完整。于是在注意力機制中融入指導核心詞,核心詞包括原文中的主要句子和短語,核心詞匯在解碼時會被重要關(guān)注,生成的摘要也會概括出原文主要信息[11]。

TF-IDF 算法[12]可以提取文檔中的重要詞匯,然后測評出一段文本對于原文檔的重要程度。TF-IDF表示某關(guān)鍵詞在文檔中出現(xiàn)的頻率,由兩部分組成:

TF 為詞頻,表示某詞匯或短語在該文檔中出現(xiàn)的頻率,頻率的高低可以反映其對于文檔的重要程度。

IDF 為逆文檔頻率,表示對于某一詞語權(quán)重的衡量,若詞匯在其他文檔中出現(xiàn)頻率較低,則認為該詞語為少見詞,若該詞匯在文檔中重復出現(xiàn),該詞匯IDF 值越大,它的權(quán)重越大,反之越低。

2.5 基于混合模型的摘要生成

基于以上模型對于文本摘要生成過程中起到了十分重要的作用,單個模型在編碼以及解碼中存在一些問題,該文提出混合模型的方法,然后加入注意力機制以及指針網(wǎng)絡(luò)[13],解決了重復問題以及核心詞的提取,讓文本摘要語義表達更加準確,語句更加通順。在Seq2Seq-Attention 模型中,針對無法生成OOV 詞匯,并且會產(chǎn)生其他信息,加入了覆蓋機制與指針網(wǎng)絡(luò),解決了詞匯重復的問題。在注意力機制中,過多的關(guān)注摘要與原文的信息對比,忽略一些核心詞對原文的信息表達的影響,該文將核心詞提取到注意力機制中,然后通過核心詞引導出較為準確的文本摘要。

3 實驗分析

3.1 實驗設(shè)置

1)實驗選取西安高壓開關(guān)操動有限公司的項目進行駐場調(diào)研,對設(shè)備進行入庫、檢定、維修、封存,啟封、報廢狀態(tài)變更等過程信息的記錄、查詢和統(tǒng)計分析。收集統(tǒng)計文本記錄,對于選取的數(shù)據(jù)集進行預處理,數(shù)據(jù)集包含訓練集、驗證集以及測試集,統(tǒng)計結(jié)果如表1 所示。

表1 數(shù)據(jù)統(tǒng)計結(jié)果

2)采集樣本如圖5 所示。

圖5 采集樣本

3)文本自動分詞,通過分詞工具,把文本內(nèi)容分為兩字詞語,對于低頻詞語用符號來代替,數(shù)據(jù)集分詞結(jié)果如圖6 所示。

圖6 數(shù)據(jù)集分詞結(jié)果

4)選取抽取式摘要模型:①TextRank;②TFIDF;③BERTSUM

5)選取生成式摘要模型:①Seq2Seq;②Seq2Seq-Attention;③Pionter+Generator 4.core words

6)進行ROUGE 打分,并進行結(jié)果分析。

3.2 結(jié)果及分析

實驗結(jié)果如表2 所示。實驗對比模型如下:

表2 生成式摘要與基于混合模型的摘要生成結(jié)果對比

1)基本Seq2Seq:屬于一種encoder-decoder 結(jié)構(gòu),應(yīng)用在機器翻譯等領(lǐng)域[14]。

2)Seq2Seq-Attention:將序列到序列的模型。

3)Pointer-Generator:使用pointer 機制從原文中復制未登錄詞匯,保證信息的正確率[15]。

通過觀察表1、表2,繪制柱狀圖,如圖7 所示,可以得出:

1)Attention 機制的模型ROUGE 平均值較高,基礎(chǔ)Seq2Seq 模型的ROUGE 平均值較低,Attention 機制更加適用于混合模型。

2)BERTSUM+Seq2Seq-Attention 模型[16]相比于BERTSUM+Seq2Seq 模型ROUGE 平均值提高了1.8%,混合模型相比BERTSUM+Pointer-Generator提高了2.57%。可以得出,混合模型的表現(xiàn)更好。

3)從圖7 可以看出,混合模型比生成模型具有更好的結(jié)果,生成模型會存在信息不完整等問題。與直接輸入原文相比,BERTSUM 生成的摘要更加符合原文的主旨大意,則認為它生成的摘要更為全面。

圖7 柱狀圖

4 結(jié)論

實驗證明,在工業(yè)領(lǐng)域中,文本摘要技術(shù)也可以得到很好的應(yīng)用,讓制造生產(chǎn)更加信息化和智能化,該文采用混合模型進行了實驗。在摘要生成過程中使用了指針網(wǎng)絡(luò)以及融合了核心詞注意力機制,得到了比較精確的文本摘要,但是在文本提取過程中仍然存在很多的問題。在BERT 模型的摘要提取過程中,輸出端處理工作欠缺,使得輸出原文信息覆蓋不全面,并且存在信息重復。在注意機制中,可以使用多種的模型方法,并且更加有效快捷地提取文章主要包含的信息,最終成為簡明扼要的文本。