主動容錯云存儲系統的故障預警調度策略

李 國,曾婷婷,曹衛東,李 靜

(中國民航大學 計算機科學與技術學院,天津 300300)

0 引 言

大規模云存儲系統作為主流數據中心的主要存儲架構,需要數以百萬計的硬盤來存儲數據,硬盤故障會造成數據丟失,從而影響系統性能[1-3]。為了提高存儲可靠性,以副本或糾刪碼為代表的被動容錯技術和以硬盤故障預測為代表的主動容錯技術被廣泛應用于各大云存儲系統[4-7]。硬盤故障預測模型能監控硬盤的運行情況,在發現即將故障的硬盤時發出預警,從而提醒操作人員盡快處理預警硬盤,降低數據丟失的概率。

然而,隨著存儲系統規模的不斷擴大,硬盤故障預測模型發出的預警也在隨之增加,由于網絡帶寬等資源的限制,系統無法一次性處理多個預警,否則會影響正常的用戶服務。通常情況下,操作人員根據FIFO來處理預警事件,對于大規模云存儲系統來說,無論是通過提前預測對故障硬盤中的數據進行遷移,還是通過被動容錯方式進行重構,都需要幾個小時甚至幾天的時間[8]。同時,考慮到系統的冗余機制,大多數操作人員并不會及時地處理預警[9],而預警不能得到及時處理會導致數據丟失。因此,系統需要更合適的調度策略來避免該情況的發生。文獻[10]通過構建遞歸神經網絡模型來確定硬盤故障模型發出的預警的優先級,為預警調度提供了依據。優先級調度能夠保證系統優先處理更緊急的預警事件,然而該方法有一定的缺陷:①低優先級的預警事件可能會“饑餓”;②無法保證響應時間,除非一個預警事件的優先級在優先級隊列中最高,否則程序將無法立即處理該預警事件。

為解決以上問題,本文提出了一種調度策略,將優先級思想引入云存儲系統并加以改進,使用非完全搶占式的動態優先級策略調度不同的預警事件。同時,該策略在保證系統性能的情況下分配帶寬資源,并統計存儲系統在一定運行周期內發生數據丟失事件的期望次數。利用本文的方法可以調度預測模型在一段時間內發出的多個預警,降低云存儲系統中的數據丟失次數,提高云存儲系統的性能。

1 相關研究

1.1 冗余機制

RAID-5和RAID-6冗余機制廣泛應用于云存儲系統中,是在故障發生后進行數據重構的被動容錯技術。硬盤在系統中被劃分為不同的校驗組,若校驗組內出現的故障超出限制,則會導致數據丟失。硬盤發生故障后,RAID會自動根據剩余硬盤中的數據和校驗數據重建丟失的數據,如果重構過程能夠及時完成,則可以避免數據丟失事件的發生。然而,RAID是以犧牲空間換取更高的可靠性和性能的冗余機制,這會減少全體硬盤的總可用存儲空間[11]。此外,硬盤的容量不斷增加,但其讀寫速度卻增長得十分緩慢,這樣就導致了硬盤故障之后RAID重構時間不斷延長。在重構數據的過程中,校驗組中其它硬盤發生故障的可能性增加[12],這無疑增加了數據丟失的風險,進而降低系統的服務質量。

1.2 主動容錯技術

硬盤故障預測模型可以在硬盤即將發生故障時發出預警,在故障發生之前進行處理,是典型的主動容錯技術[13]。目前,大部分硬盤內部都具有S.M.A.R.T.配置,即“自我監測、分析及報告技術”,可以實時采集硬盤的參數信息[14]。硬盤故障預測模型就是根據S.M.A.R.T.參數信息,運用統計學和機器學習的相關算法建立的[15,16]。一般情況下,硬盤故障預測模型都是二分類模型,即一個硬盤的狀態是“健康”或“即將故障”。在主動容錯系統中,硬盤故障預測模型監測工作硬盤的狀態并輸出預警,但由于二進制結果既不能提供預警命令,也不能提供準確的值來指示預警的優先級,因此很難對預警調度提供有效的幫助。

1.3 調度策略

目前,部署有故障預測模型的存儲系統默認的預警調度算法是先進先出算法(FIFO)。FIFO的特點是易于實現,并且系統的調度開銷比較少,任務平均完成時間較短[17]。研究表明,硬盤故障預測模型可以提前幾十甚至幾百個小時的時間發出預警[7]。隨著預測模型發出的預警的數量不斷增加,對于被預測為短時間內即將發生故障的硬盤,如果僅遵循FIFO的順序等待處理,則很有可能因為等待時間過長而造成數據丟失。

優先級調度是按照系統分配的優先級數值的大小來調度任務的一種調度策略[18]。在這種策略下,系統給每一個任務分配一個優先級數值來確定其優先級,優先級高的任務會被優先響應,而對于優先級相同的任務請求,則按照FIFO的順序進行響應。

2 預警調度模型

2.1 模型框架

一個完整的調度機制應具有兩方面的功能:一是主動容錯,即能夠提前預測出將要發生的故障并發出預警;二是調度,即能對系統發出的多個預警事件進行處理。本文提出的調度模型不僅可以利用硬盤監測數據訓練預測模型,還可以對多個預警事件進行調度。

圖1描述了調度模型的基本框架。模型首先解析硬盤在RAID校驗組中的分布,然后將預處理后的硬盤監測數據傳輸到硬盤故障預測模型,接著根據硬盤的數據以及預測模型的結果發出預警事件,調度算法根據系統中的冗余布局將不同級別的預警事件按照一定的順序加入優先級隊列,在系統帶寬允許的情況下將其依次加入工作隊列并分配帶寬資源,最后校驗組進行故障重構。

2.2 主動容錯RAID-5和RAID-6系統

對于一個RAID-5校驗組,當有一個硬盤發生故障時,校驗組會進入降級模式,如果故障盤能夠得到及時有效的處理(故障盤被及時替換,并完成數據重構),則不會造成數據丟失;若不能及時處理,一旦校驗組內發生并發故障則會造成數據永久丟失,不能再提供正常服務,即一個RAID-5校驗組只能容許一個運行故障發生。

如圖2所示,校驗組DG3中已有一個硬盤處于故障狀態,該校驗組處于降級狀態,此時硬盤D1發出預警,必須盡快進行處理,否則將會造成數據丟失,影響系統性能。對于校驗組DG2來說,硬盤D2發出預警,但其所在校驗組其余的硬盤是健康狀態,故若硬盤D1和D2同時發出預警,則應優先處理D1硬盤,以最大程度地避免數據丟失事件的發生。

圖2 RAID-5示例

同樣地,對于一個RAID-6校驗組,當有一個故障發生故障時,校驗組會進入降級模式,本文稱之為降級1,當有兩個硬盤發生故障時,稱為降級2。當校驗組處于降級2模式時,若故障盤能夠得到及時有效地處理,則不會造成數據丟失;若不能及時處理,當第三個硬盤故障發生時就會造成數據永久丟失,不能再提供正常服務,即一個RAID-6校驗組最多能容許兩個運行故障發生。

如圖3所示,校驗組DG1中已有兩個硬盤處于故障狀態,該校驗組處于降級2模式,此時硬盤D1發出預警,必須盡快進行處理,否則將會造成數據丟失,影響系統性能。而校驗組DG3處于降級1模式,故若硬盤D1和D4同時發出預警,則應優先處理D1硬盤,以最大程度地避免數據丟失事件的發生。

圖3 RAID-6示例

2.3 硬盤故障預測方法的選擇

一個好的硬盤故障預測模型,應該實現較高的預測準確率和較低的誤報率。為了更真實地反映大型云存儲系統的硬盤運行狀況,本文使用了Backblaze公司提供的公共數據集來構建硬盤故障預測模型,并將預測結果用于之后的實驗。數據集中記錄了超過10萬個硬盤,覆蓋了Seagate和West Digital的30多個不同的硬盤型號。為排除型號影響,本文選擇了2019年數據量最大的型號為ST4000DM0007的Seagate硬盤進行實驗。從這個硬盤型號中,本文收集了37 102個健康盤和1144個故障盤的屬性信息。在本文的實驗中,從健康盤中隨機選出70%作為訓練集,剩余30%作為測試集;從故障盤中隨機選出70%作為訓練集,剩余30%作為測試集。

本文使用了決策樹和BP神經網絡兩種方法來構建硬盤故障預測模型。此外,考慮原始值屬性對預測結果的影響[15],基于是否增加原始值屬性分別進行了兩次實驗。其中,對于決策樹預測模型,設置復雜性CP為0.01,劃分前最小樣本數Min Split為20,葉子節點最小樣本數Min Bucket為7;對于BP神經網絡預測模型,設置隱藏層個數為4個,每層神經元個數分別設為1000、500、200、100,輸出層為3個,激活函數選擇tanh。其結果見表1。

表1 預測結果分析/%

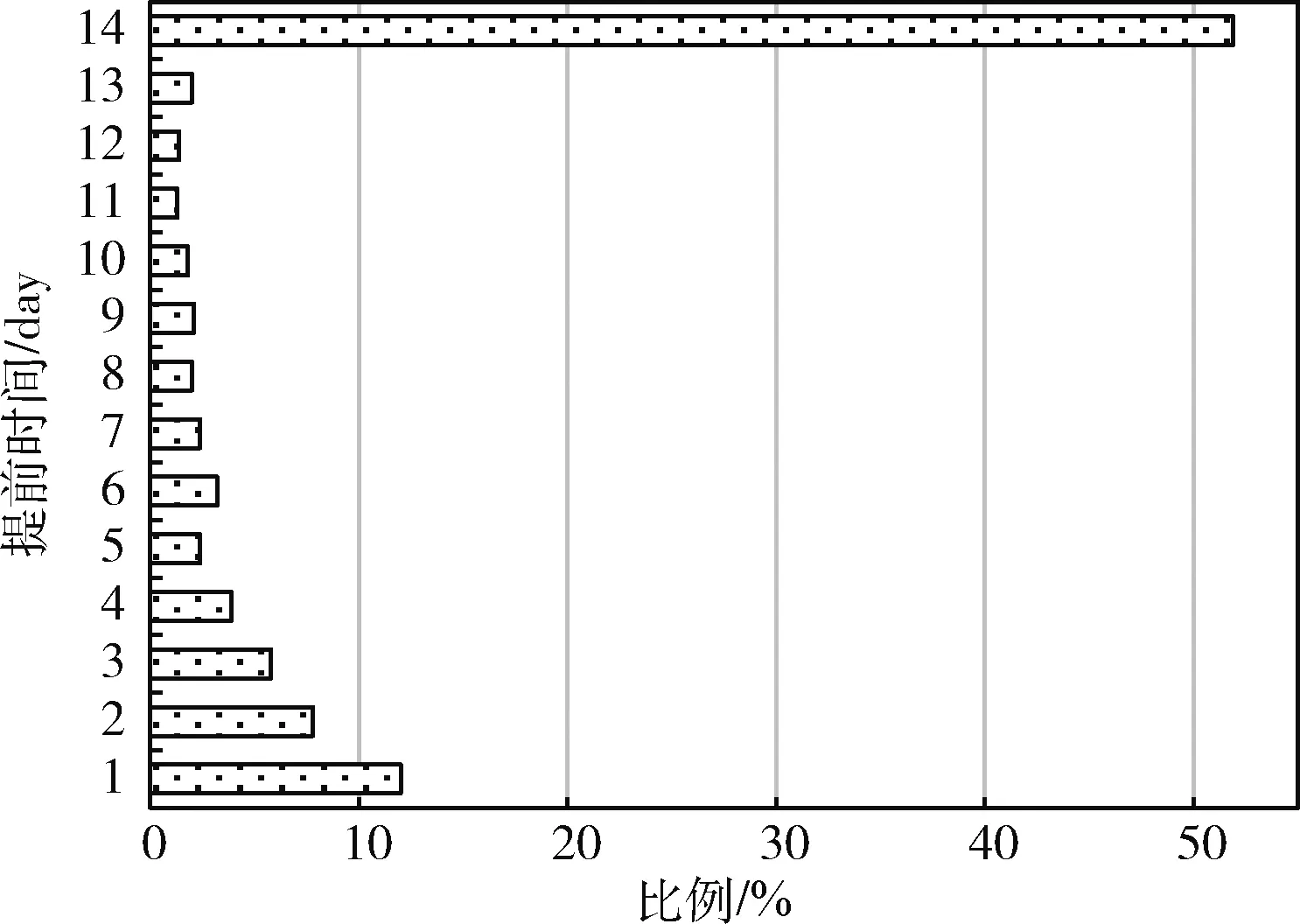

由表1可以看出,選擇12個屬性并通過決策樹模型訓練可以實現更高的準確率和更低的誤報率,故本文選用決策樹預測模型作為實驗的基本預測模型,模型的預測結果顯示在圖4中。由圖4可以看出,超過半數的預警可以在硬盤發生故障前兩周以上發出預警,而對于提前預警時間較短的硬盤,系統應盡快處理。圖4中提前預警時間的概率分布將用于后續的實驗中。

圖4 提前預警時間分布

2.4 預警優先級定義

2.4.1 硬盤健康度

以往的研究大多以提高預測性能為目的,提出的預測模型大都是二分類模型,其產生的結果只有兩種:健康或預警。在一般情況下,硬盤故障并不是突然發生的,它往往是一個漸變的過程,而簡單的二分類預測結果并不能指導如何進行預警調度。本文使用具體的值來描述預警硬盤的危險程度,稱為健康度,其計算過程如式(1)

(1)

式中:wd(i) 表示i時刻硬盤d的剩余壽命,即從發出預警到真實的故障發生所間隔的時間,wd(i) 可由決策樹預測模型獲得,由于本文使用的故障硬盤樣本均被預測為14天以內發生故障,故設wc(i) 為336 h。

若硬盤為健康硬盤或在短時間內不會發生故障,設hd(i) 為0;若硬盤被預測為將在336 h之內發生故障,則hd(i)∈(-1,0); 若硬盤已經發生故障,設hd(i) 為-1。hd(i) 既可以衡量硬盤d在i時刻的運行狀況,又可以作為設定預警事件優先級的一個重要指標。

2.4.2 校驗組

對預警事件的處理不僅需要考慮單個硬盤,還要結合云存儲系統的特點,考慮冗余機制的影響。對于配置了RAID-5或RAID-6的云存儲系統,除了將硬盤的健康度作為一個評價指標,還要考慮硬盤所在校驗組的所有硬盤的健康狀況,對于已經處于降級模式的校驗組,該組中的預警硬盤應獲得更高的分數,其組中的預警硬盤應得到優先處理。每個校驗組的嚴重程度分數的計算公式為

(2)

式中:hk(i) 表示校驗組k中硬盤i的健康度。算法1對校驗組的嚴重程度分數的計算進行了詳細描述。

算法1:校驗組嚴重程度分數算法

輸入:硬盤信息及其預測結果集D={d11,d12,…,d1n,d21,d22,…,d2n,…,dmn} 和校驗組集R={r1,r2,r3,…,rm}

輸出:校驗組的嚴重程度分數集S={s1,s2,s3,…,sm}

(1)Begin

(2)/* 初始化健康度集 */

(3)H={h11,h12,…,h1n,h21,h22,…,h2n,…,hmn}

(4)For each ri∈R

(5)/* 校驗組分布 */

(6) ri={di1,…,di2,di3,…,din}

(7) For each dij∈ri

(8)/* 使用式(1)計算硬盤dij的健康度hij*/

(9) hij←dij

(10)/* 更新健康度集 */

(11) H←hij

(12) End for

(13)/* 使用式(2)計算每個校驗組的嚴重程度分數 */

(14) sj←ri

(15)/* 更新嚴重程度分數集ri*/

(16) S←si

(17)End for

(18)End

2.4.3 預警優先級

本文依據硬盤的健康度以及存儲系統的冗余機制為每個預警事件設置優先級,優先處理較高優先級的預警事件。每個預警事件的嚴重程度的計算公式為

pd(i)=α×hd(i)+β×scorek(i)

(3)

式中:hd(i) 和scorek(i) 由式(1)和式(2)分別給出,α和β為動態因數權值,滿足條件α+β=1。

預警事件嚴重程度值的大小代表該事件的緊急程度,可以用該值來劃分預警事件的優先級。在劃分優先級時,對于嚴重程度相差不多的預警事件,處理順序的先后不會對系統的性能造成很大的影響,故本文將預警事件嚴重程度的值映射為k個離散的值,它們代表不同的優先級。結合預測模型的預測結果以及存儲系統中的冗余機制,本文設置k值為6。預警事件的嚴重程度與其優先級的映射關系見表2。

表2 優先級映射

2.5 非完全搶占式的動態優先級調度

為了減少主動容錯機制對系統性能的影響,當故障發生后,RAID只使用系統總帶寬的一小部分用于重構數據,以此來保證系統的正常服務質量。由于帶寬資源的限制,優先級隊列中的預警事件不能無限增加,否則將集體陷入“饑餓”狀態。因此,設置優先級隊列中的預警事件總數上限為5,在不超過上限的情況下,優先級隊列中的所有任務都可以獲取帶寬資源用于數據重構,而不是等待前一個預警事件處理完成,此為非完全搶占式的優先級調度。此外,未加入優先級隊列的預警事件由于等待時間的不斷延長,其嚴重程度會越來越高,系統定時更新處于等待狀態的預警事件的優先級,以保證帶寬資源允許時優先處理更緊急的預警事件。本文設置了一個閾值,系統為校驗組重構數據所分配的帶寬之和不超過該值,否則調度任務將會被延后執行。為了保證更危險的硬盤或校驗組被快速處理,系統按照式(4)為每個預警事件分配帶寬,在這樣的分配方式下,優先級高的預警事件將會獲得更多的帶寬資源。

(4)

式中:pd(i) 為硬盤d在i時刻對應預警事件的優先級,由式(3)得出。MAX為系統分配的總帶寬,?為一個動態因數,可根據系統的負載情況來調整?值的大小。

3 DPS的設計

DPS(dynamic priority-incorporated scheduling)的設計過程如下所述:

步驟1 根據硬盤故障預測模型得出的結果,將云存儲系統中的硬盤分為健康盤和預警盤,健康盤為被預測為近期不會出現故障的硬盤,預警盤為被預測為近期即將發生故障的硬盤。

步驟2 啟動硬盤預警進程,更新本地信息。

步驟3 根據預測結果按照式(1)計算出硬盤的健康度。

步驟4 定位硬盤所在的RAID校驗組,根據式(2)計算出其所在校驗組的嚴重程度分數。

步驟5 根據以下兩種情況調整預警事件的優先級。

情況1:若系統配置RAID-5被動容錯機制,首先判斷預警盤所在的校驗組是否已處于降級模式。若校驗組中已處于降級模式,則該預警事件的優先級設為最高,即Level 6。若校驗組沒有處于降級模式,則基于步驟2和步驟3的結果,根據式(3)設置預警事件的優先級。

情況2:若系統配置RAID-6被動容錯機制,首先判斷預警盤所在的校驗組是否處于降級模式。若校驗組處于降級2模式,則該預警事件的優先級設為最高,即Level 6。若校驗組處于降級1模式或沒有處于降級模式,則基于步驟2和步驟3的結果,根據式(3)設置預警事件的優先級。

步驟6 建立優先級隊列。將預警事件按照優先級的大小先后加入到優先級隊列中。

步驟7 建立工作隊列。將優先級隊列中的預警事件按照優先級的大小依次加入到工作隊列中,并更新優先級隊列中預警事件的優先級。

步驟8 分配帶寬。根據式(4)為工作隊列中的預警事件分配帶寬。

步驟9 移除工作隊列中已完成的任務,并更新工作隊列。

步驟10 判斷是否達到指定條件,達到則結束程序,否則重復步驟3~步驟10。

其中,硬盤預警進程的流程如圖5所示。

圖5 硬盤預警進程流程

4 仿真程序

本文根據第2.1節提出的預警調度模型設計了仿真程序,仿真程序通過事件轉換模擬主動容錯系統中各個事件的發生過程。程序通過4種仿真事件向前推進模擬時間:

(1)運行故障事件,系統中的每一塊硬盤均有幾率觸發,事件發生后系統將增加一個新的硬盤;

(2)故障預警事件,在故障預測模型檢測到某塊硬盤即將發生故障時觸發;

(3)數據重構完成事件,在校驗組重構數據完成后觸發;

(4)預警處理完成事件,在所有預警硬盤所在的校驗組完成數據重構后觸發。

仿真程序使用一個最小堆來保存即將發生的事件,這些事件根據時間的先后順序插入最小堆。程序在開始時基于硬盤的屬性信息和決策樹預測模型的結果生成一些預警事件,并將預警事件的信息保存在預警信息表中,然后按照時間的先后順序將預警事件依次插入最小堆。

仿真程序引入了一種值守進程,它按時從最小堆的頂部彈出預警事件,調度算法根據事件彈出的時間及其信息來進行調度。在程序運行期間,每個事件發生的時間將會被累積,直到達到指定條件或者超過設定的仿真時間,程序才會停止運行。在本文中,重復執行仿真程序,直到數據丟失次數達到十次以上才停止運行,并在最后統計運行周期內發生數據丟失事件的期望次數,并以此作為仿真程序的結果。

5 實驗及結果分析

5.1 實驗準備

對于仿真程序中的故障預警事件,根據2.3節的預測結果確定提前預警時間的概率分布。預警事件彈出后,系統會啟動硬盤預警進程。表3列出了仿真程序使用的參數,參數對應的數據為默認值。仿真程序執行環境為Intel Core i7 CPU 3.0 G,內存4 G,64位微軟操作系統windows 10,集成開發環境為JetBrains PyCharm Professional 2020.1.2。

表3 參數設置

5.2 帶寬分配過程

在主動容錯云存儲系統中,出現多個故障預警是十分常見的,而系統用于重構數據的帶寬資源十分有限。在本節中,實驗使用了一組不同優先級的預警事件來說明調度算法如何調度多個預警事件并為其分配合適的帶寬。在不考慮系統性能影響的情況下,設置?=0.3,先后觸發3個不同優先級的預警事件,它們的優先級分別為Level 1、Level 3和Level 5。為了驗證算法的效果好壞,先觸發優先級較低的預警事件,一段時間后再觸發優先級更高的預警事件。圖6顯示了3個不同優先級的預警事件的帶寬分配情況。

圖6 不同優先級的預警事件的帶寬

實驗在開始時觸發了Level 1的預警事件,當系統中只有一個任務時,它獲得了全部的帶寬資源。10 h之后,觸發級別為Level 3的預警事件,由于該任務級別較高,因此它會獲得更多的帶寬資源;24 h之后,再次觸發級別為Level 5的預警事件,系統再次重新分配帶寬。由圖6可以看出,系統會優先處理優先級更高的預警事件,當隊列中加入了更高優先級的預警事件后,系統會重新分配帶寬,優先級高的事件將會獲得更多的帶寬資源。

5.3 效果分析

根據本文提出的調度模型,操作人員可以更高效率地處理多個預警事件,本節實驗將對比分析本文提出的DPS與系統默認的FIFO在不同情境下的應用效果。

5.3.1 RAID重構時間

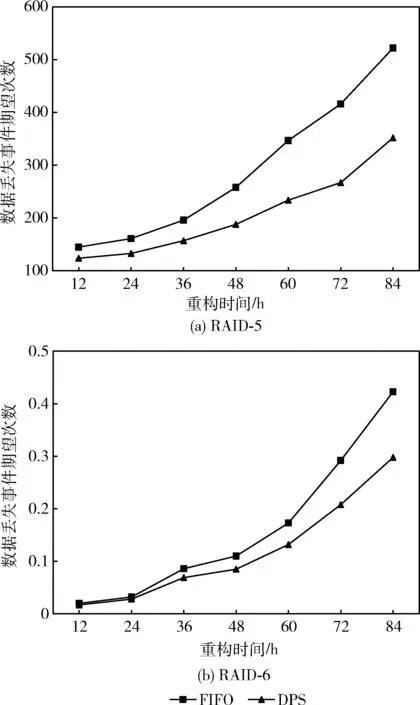

本節實驗分析了兩種調度方式在RAID-5和RAID-6系統中統計的運行周期內的數據丟失事件的期望次數,通過調節參數Rc改變RAID重構時間,其余參數參照表3中的默認值,結果顯示在圖7中。

圖7(a)和圖7(b)分別給出了兩種調度方式在RAID-5和RAID-6系統中運行的結果,可以看出隨著重構時間的增加,發生數據丟失事件的期望次數不斷增多。其中,在RAID-5云存儲系統中,DPS相比于FIFO的調度方式,其數據丟失事件的期望次數降低約14.5%~35.8%;在RAID-6云存儲系統中,其數據丟失事件的期望次數降低約12.5%~29.5%。

圖7 不同重構時間下的數據丟失事件期望次數

5.3.2 操作人員反應時間

在大型的數據中心中,操作人員往往不能及時對預測模型發出的預警進行處理,從而增加了并發故障發生的概率,造成數據丟失。在不同的數據中心中,操作人員處理預警事件的間隔時間不同,本文將從系統發出預警到操作人員處理預警事件的時間稱為反應時間。本節實驗對比了不同反應時間下在一定運行周期內云存儲系統中發生數據丟失事件的期望次數,通過調節參數Rt改變反應時間,其余參數參照表3中的默認值,結果顯示在圖8中。

圖8(a)和圖8(b)分別給出了兩種調度方式在RAID-5和RAID-6系統中運行的結果,隨著操作人員反應時間的增加,發生數據丟失事件的期望次數增多。其中,在RAID-5云存儲系統中,DPS相比于FIFO的調度方式,其數據丟失事件的期望次數降低約27.1%~34.1%;在RAID-6云存儲系統中,其數據丟失事件的期望次數降低約27.2%~36.1%。

圖8 不同反應時間下的數據丟失事件期望次數

6 結束語

本文將硬盤故障預測技術與調度算法結合起來,并提出了一種改進的動態優先級調度策略,更高效地處理主動容錯云存儲中的硬盤故障預測模型發出的多個預警。該策略綜合考慮了RAID-5和RAID-6云存儲系統中的冗余機制和主動容錯技術,合理分配系統中的用于RAID重構的帶寬資源,降低了云存儲系統中的數據丟失次數。

本文的調度策略僅考慮了RAID云存儲系統,未來的一個研究方向是將調度策略推廣到配置了其它被動容錯及主動容錯技術的存儲系統中,并針對不同存儲系統的結構對調度策略進行改進。