融合對(duì)象和多尺度視覺(jué)特征的遙感圖像描述模型*

賈亞敏,陳 姣,彭玉青

(河北工業(yè)大學(xué) 人工智能與數(shù)據(jù)科學(xué)學(xué)院,天津 300401)

0 引言

圖像描述是旨在從語(yǔ)義層面上對(duì)圖像進(jìn)行總結(jié)。遙感圖像是利用遙感技術(shù)從高空獲取的圖像,遙感圖像描述(Remote Sensing Image Caption,RSIC)是上述兩個(gè)領(lǐng)域的結(jié)合,旨在為指定的遙感圖像生成綜合性的文本描述,在交通指揮、地理研究等領(lǐng)域[1]具有廣泛的應(yīng)用前景,已成為新興的研究熱點(diǎn)。遙感圖像描述的實(shí)現(xiàn)最初沿用了圖像描述的編碼器-解碼器模型[2],隨后提出了許多模型來(lái)解決不同的問(wèn)題,多數(shù)研究使用卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks,CNN)作為編碼器提取圖像特征,但CNN卷積層的輸出特征所對(duì)應(yīng)的感受野都是大小和形狀相同的均勻網(wǎng)格,因此僅利用CNN提取的圖像特征容量有限,難以識(shí)別圖像中的微小物體,且由于拍攝角度問(wèn)題,遙感圖像中存在一些多義和易混淆物體,不易區(qū)分。

為解決上述問(wèn)題且適應(yīng)遙感圖像場(chǎng)景多尺度的特點(diǎn),本文提出了融合對(duì)象和多尺度視覺(jué)特征的遙感圖像描述模型(Fusion of Object and Multiscale Visual Feature,F(xiàn)O-MSV)。該模型構(gòu)建對(duì)象提取器(Object Extractor,OE)利用指針生成網(wǎng)絡(luò)[3]得到的整合描述提取對(duì)象信息以避免遺漏微小物體。同時(shí)提出了一種新的多尺度交互模塊(Multiscale Interaction Module,MSCM)來(lái)獲取圖像的多尺度視覺(jué)特征適應(yīng)多尺度的特點(diǎn)。此外,設(shè)計(jì)一種新的對(duì)象-視覺(jué)融合機(jī)制(Object-Visual Fusion Mechanism,ovFM)來(lái)利用對(duì)象信息并融合多尺度視覺(jué)信息避免出現(xiàn)識(shí)別對(duì)象錯(cuò)誤的問(wèn)題,且改善了長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)(Long Short Term Networks,LSTM)的結(jié)構(gòu),稱為多輸入LSTM(Multi-Input LSTM,I_LSTM)。

1 相關(guān)工作

由于遙感圖像自身的多尺度、多方向、分辨率低等特點(diǎn),且在采集遙感圖像過(guò)程中容易受到光照、遮擋、距離等周?chē)h(huán)境的影響,會(huì)造成目標(biāo)遙感圖像特征模糊易混淆,使得遙感圖像的語(yǔ)義層次的理解變得更加困難,研究者針對(duì)上述問(wèn)題也提出了大量RSIC方法。

從模型設(shè)計(jì)的角度,Wang等人[4]提出了一種檢索主題循環(huán)記憶網(wǎng)絡(luò),利用循環(huán)神經(jīng)網(wǎng)絡(luò)處理圖像特征以及從主題庫(kù)中檢索出的主題信息生成描述。考慮到注意機(jī)制的有效性,Cui等人[5]提出了一種基于注意力的遙感圖像語(yǔ)義分割和空間關(guān)系識(shí)別方法,但是其描述模塊獨(dú)立于其他模塊,并未有效提升描述性能。Cheng等人[6]采用多級(jí)注意模塊自適應(yīng)聚合特定區(qū)域的圖像特征以解決多方向的問(wèn)題,并提出一個(gè)新的NWPU數(shù)據(jù)集。Li等人[7]提出了一種多層次的注意模型,有效地結(jié)合視覺(jué)信息和語(yǔ)義信息增強(qiáng)注意指導(dǎo)描述生成。Zhao等人[8]提出了一種結(jié)構(gòu)化注意機(jī)制,來(lái)解決粗粒度注意單元問(wèn)題,減少因圖像模糊而帶來(lái)的特征誤差。

從遙感數(shù)據(jù)本身出發(fā),Zhang等人[9]探索如何解決由于訓(xùn)練樣本少造成的過(guò)擬合的問(wèn)題,并受到圖片分類(lèi)任務(wù)的啟發(fā),提出了多尺度的裁剪機(jī)制;Zhang等人[10]提出利用圖片類(lèi)別標(biāo)簽的LAM模型,該模型能夠更好地挖掘與類(lèi)別相關(guān)的目標(biāo)和關(guān)系信息;Huang等人[11]提出了一種基于降噪的方法來(lái)增強(qiáng)圖像特征表示的清晰度。Zhang等人[12]引入了全局視覺(jué)特征,并通過(guò)去除冗余特征分量,得到了與圖像場(chǎng)景密切相關(guān)的描述性語(yǔ)句。

上述工作雖然在一定程度上提升了描述性能,但大多僅致力于改進(jìn)或增強(qiáng)圖像特征表示,未充分考慮上述提到的CNN感受野的局限性,因此會(huì)遺漏微小物體。并且遙感圖像從高空拍攝且分辨率低,僅利用編碼器提取的視覺(jué)特征極易識(shí)別錯(cuò)誤,不能有效區(qū)分易混淆物體,如森林和草地等。在多尺度問(wèn)題的處理上,大多工作只是簡(jiǎn)單地連接多層特征代表全局特征,未考慮層間交互的重要性。基于此,本模型總結(jié)如下:(1)提出一種新的對(duì)象提取器從描述圖像的整合描述中提取準(zhǔn)確全面的對(duì)象信息;(2)設(shè)計(jì)了多尺度交互模塊獲取圖像多尺度視覺(jué)特征;(3)探索了一種新的對(duì)象視覺(jué)融合方式并改進(jìn)了LSTM結(jié)構(gòu)。

2 FO-MSV模型

本文提出的基于FO-MSV的方法分為三部分:整合描述及對(duì)象提取器、多尺度交互模塊、屬性視覺(jué)融合模塊。圖1為模型結(jié)構(gòu)圖。

2.1 對(duì)象提取器

為了彌補(bǔ)CNN的不足,本文考慮可直接向解碼器提供對(duì)象的語(yǔ)義概念來(lái)避免遺漏微小物體,從真實(shí)描述中提取對(duì)象信息。利用指針生成網(wǎng)絡(luò)處理五個(gè)真實(shí)描述得到整合描述I,既消除了真實(shí)描述中的冗余信息,又保證了句子的完整性。OE旨在提取其中的對(duì)象信息,對(duì)象的關(guān)系、動(dòng)作等信息可依靠視覺(jué)特征更好地獲取。由于篇幅有限,指針生成網(wǎng)絡(luò)的具體實(shí)現(xiàn)過(guò)程不再贅述,可參考文獻(xiàn)[3]。

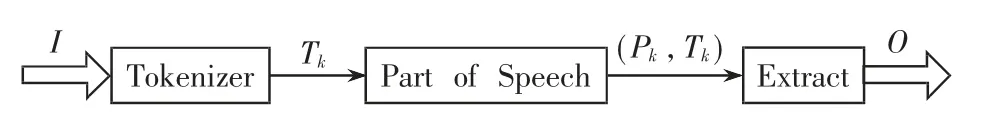

整合描述是對(duì)真實(shí)描述的總結(jié),獲取的對(duì)象信息具有全面和準(zhǔn)確性。如圖2所示,本文首次提出將自然語(yǔ)言處理的詞性標(biāo)注(Part Of Speech,POS)任務(wù)應(yīng)用于RSIC,作用于本文的OE獲取圖像對(duì)象特征,之前沒(méi)有此類(lèi)的研究。利用POS任務(wù)可得到文本中單詞的對(duì)應(yīng)類(lèi)型。此階段,OE對(duì)I進(jìn)行分詞、實(shí)體詞性標(biāo)注和物體詞的提取。屬性信息用詞嵌入列表 的形式表示,O={O1,O2,…,Om},Oi∈RE,其中E是屬性詞嵌入的維度。

圖2 對(duì)象提取器結(jié)構(gòu)圖

首先通過(guò)Tokenizer注釋器對(duì)I進(jìn)行分割處理得到令牌級(jí)別的單詞Tk。通過(guò)詞性標(biāo)記,Tk得到對(duì)應(yīng)的詞性標(biāo)簽Pk,以(Pk,Tk)形式表示。 例如,′N(xiāo)N′、′CC′等分別表示名詞、連接詞等。本文認(rèn)為對(duì)象詞在I中均以名詞形式描述,因此提取Pk=′N(xiāo)N′的Tk表示對(duì)象信息,最后進(jìn)行詞嵌入操作,實(shí)現(xiàn)對(duì)象生成。

2.2 多尺度交互模塊

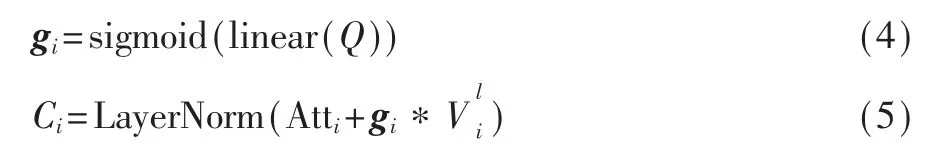

相比在正常角度拍攝的自然圖像,遙感圖像具有多尺度的特點(diǎn)。為此,本文設(shè)計(jì)了MSCM結(jié)構(gòu),分別抽取CNN第5、7層的特征,首先在每一層設(shè)計(jì)一個(gè)層內(nèi)注意只關(guān)注一個(gè)尺度并且使所有特征之間建立內(nèi)部連接。其次設(shè)計(jì)交互注意部分實(shí)現(xiàn)不同尺度特征之間的信息流交互,基于上述連接兩層輸出特征Ci后可實(shí)現(xiàn)本文的多尺度特征Vm。

層內(nèi)注意是在多頭自注意的基礎(chǔ)上添加了一個(gè)殘差連接,并分別在自注意前和殘差連接后添加了歸一化處理。這里設(shè)置多頭自注意里的多頭為4。

2.3 對(duì)象-視覺(jué)特征融合模塊

注意力機(jī)制可以使解碼器在根據(jù)最感興趣的信息得到結(jié)果,為了充分融合視覺(jué)信息和對(duì)象信息,該部分在上層I_LSTM、視覺(jué)注意、屬性注意的基礎(chǔ)上設(shè)計(jì)了一種新的融合機(jī)制(Fusion Mechanism,F(xiàn)M)引導(dǎo)視覺(jué)信息和對(duì)象信息之間的信息流,F(xiàn)M包含本文設(shè)計(jì)的函數(shù)S和下層I_LSTM結(jié)構(gòu)。

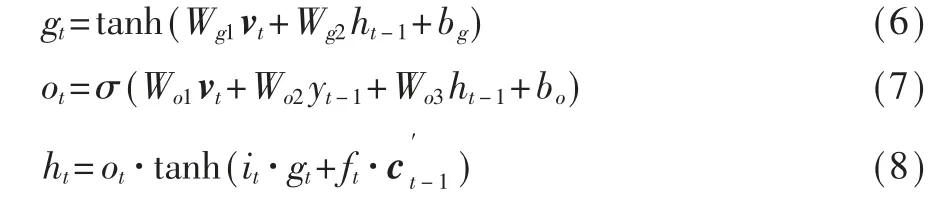

2.3.1 I_LSTM

LSTM會(huì)在每一時(shí)刻根據(jù)兩個(gè)輸入(上一時(shí)刻單詞yt-1和上下文向量vt)進(jìn)行單詞的預(yù)測(cè),在以往工作中經(jīng)常將兩個(gè)輸入向量串聯(lián)進(jìn)而進(jìn)行預(yù)測(cè)。然而,這種連接的向量中的一些信息往往在預(yù)測(cè)當(dāng)前單詞時(shí)會(huì)帶來(lái)噪聲,若前一個(gè)單詞預(yù)測(cè)不準(zhǔn)確,會(huì)造成累積錯(cuò)誤。因此本文設(shè)計(jì)了I_LSTM以更合理的方式處理這兩個(gè)輸入,將yt-1和vt分別作為記憶單元的輸入,可以丟棄用于生成前一個(gè)單詞的視覺(jué)特征(可能是視覺(jué)噪聲)和先前單詞的累積偏差。

其中,W、b都是可學(xué)習(xí)參數(shù),輸入門(mén)it和遺忘門(mén)ft計(jì)算方式同gt和ot,注意vt在上層I_LSTM中是多尺度特征Vm,在下層I_LSTM中是上下文向量ct。

2.3.2 注意機(jī)制

(1)視覺(jué)注意

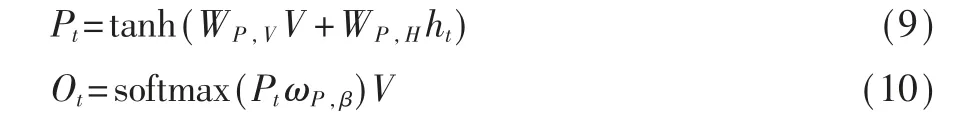

本文認(rèn)為,上一時(shí)刻的單詞輸出yt-1比下層I_LSTM的隱藏狀態(tài)更具明確的指示性,而當(dāng)前時(shí)刻上層I_LSTM的隱藏狀態(tài)ht∈RJ同時(shí)包含yt-1和視覺(jué)信息,因此本文利用ht來(lái)計(jì)算視覺(jué)注意向量。

其 中,WP,V∈RD×N,WP,H∈RJ×N,ωP,β∈RN是 可 學(xué) 習(xí) 參數(shù)。值得注意的是,為了方便后續(xù)計(jì)算,用vt=tanh·(Wv,oOt),Wv,o∈RE×D表 示 視 覺(jué) 注 意 向 量。

(2)對(duì)象注意

基于OE獲得的屬性具有無(wú)序性,若只依靠O和yt-1獲取屬性注意向量,因?yàn)槿狈﹃P(guān)注的視覺(jué)信息,生成描述時(shí)很可能將描述詞或關(guān)系詞與物體任意組合。為避免上述問(wèn)題,本文利用包含視覺(jué)信息和先前單詞信息的ht作為注意計(jì)算額外的輸入,來(lái)計(jì)算屬性注意上下文向量at,計(jì)算過(guò)程同視覺(jué)注意。

2.3.3 融合機(jī)制

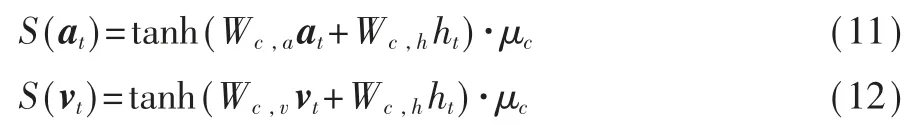

基于以上,本文得到了當(dāng)前最感興趣的視覺(jué)區(qū)域和對(duì)象,但在每一時(shí)刻同等對(duì)待兩種信息是不合理的。因此本文設(shè)計(jì)了程度函數(shù)S,基于ht計(jì)算當(dāng)前時(shí)刻對(duì)象注意和視覺(jué)注意的重要程度,分別用S(at)和S(vt)表示。

其 中,Wc,a∈RM×E,Wc,v∈RM×E,μc和Wc,h是 可 學(xué) 習(xí)參數(shù)。通過(guò)與其對(duì)應(yīng)程度分?jǐn)?shù)的加權(quán)和實(shí)現(xiàn)對(duì)象和視覺(jué)的融合,得到用于計(jì)算輸出詞的上下文向量ct。最后,通過(guò)下層I_LSTM得到輸出詞yt。

其中pt∈R|T|表示詞匯表T中對(duì)應(yīng)的單詞是當(dāng)前輸出單詞的可能性。總之,ovFM可以精準(zhǔn)加權(quán)對(duì)象和視覺(jué)并使模型充分利用對(duì)象。

3 實(shí)驗(yàn)

在本節(jié)中,會(huì)依次介紹實(shí)驗(yàn)的數(shù)據(jù)集、評(píng)價(jià)指標(biāo)和參數(shù)設(shè)置以及實(shí)驗(yàn)結(jié)果的定量和定性分析來(lái)證明本文提出方法的有效性。

3.1 數(shù)據(jù)集和評(píng)價(jià)指標(biāo)

本文使用了RSIC領(lǐng)域的三個(gè)數(shù)據(jù)集:RSICD[13]、UCM-captions[2]和新提出的NWPU-captions[6]數(shù)據(jù)集。對(duì)每個(gè)數(shù)據(jù)集進(jìn)行了劃分,其中80%作為訓(xùn)練集,驗(yàn)證集和測(cè)試集分別占10%,每張圖像都有五個(gè)描述。

RSICD數(shù)據(jù)集有10 921張圖像。圖像的大小為224像 素×224像 素,包 含30種 場(chǎng) 景。UCM-captions數(shù)據(jù)集包含21種類(lèi)別,每個(gè)類(lèi)別有100張256像素×256像素的圖片。NWPU-captions數(shù)據(jù)集包含45種類(lèi)別,圖像大小為256像素×256像素。

本文采用了在圖像描述領(lǐng)域應(yīng)用比較廣泛的評(píng)價(jià)指標(biāo)來(lái)衡量生成描述,分別是BLEU[14]、Meteor[15]、Rouge[16]和CIDEr[17],其中BLEU利用了B-1和B-4指標(biāo)。上述指標(biāo)都是分值越高代表描述性能越好。

3.2 實(shí)驗(yàn)設(shè)置

本文采用ResNet152[18]網(wǎng)絡(luò)作為CNN,損失函數(shù)采用交叉熵?fù)p失。作為編碼器的輸入之前,本文對(duì)圖像進(jìn)行了預(yù)處理,將其大小調(diào)整為512×512。單詞嵌入維度和LSTM的隱藏層的大小為512,詞匯表中保留了在訓(xùn)練集中至少出現(xiàn)2次的單詞,設(shè)置了屬性詞的個(gè)數(shù)m為5。本文在一個(gè)GPU上使用Adam優(yōu)化器進(jìn)行了兩個(gè)階段的訓(xùn)練。首先設(shè)置學(xué)習(xí)率為5×10-4,批量大小設(shè)置為60,訓(xùn)練迭代25次,然后使用自臨界序列訓(xùn)練(Self-Critical Sequence Training,SCST)方法[19]進(jìn)行強(qiáng)化訓(xùn)練迭代15次,學(xué)習(xí)速率設(shè)置為5×10-5,批量大小設(shè)置為50。測(cè)試時(shí),采用beam search算法,beam size大小設(shè)置為3。

3.3 實(shí)驗(yàn)結(jié)果

在本節(jié)中,本文在RSICD數(shù)據(jù)集上對(duì)比了屬性詞的個(gè)數(shù)對(duì)實(shí)驗(yàn)結(jié)果的影響,分別驗(yàn)證了FO-MSV各部分的有效性。并在多個(gè)數(shù)據(jù)集上與其他方法進(jìn)行了對(duì)比。

3.3.1 屬性個(gè)數(shù)

本文分別在屬性詞個(gè)數(shù)為3、5、7和9的情況下在FO-MSV模型上進(jìn)行了實(shí)驗(yàn),圖3展示了B-1、B-4和CIDEr的結(jié)果,當(dāng)屬性詞數(shù)量為5個(gè)時(shí),分?jǐn)?shù)最高,當(dāng)個(gè)數(shù)從5到9的過(guò)程中,結(jié)果明顯降低。這是由于當(dāng)提取屬性詞過(guò)多時(shí),會(huì)產(chǎn)生重復(fù)或相似的屬性,從而降低生成描述的性能。因此限制屬性詞的個(gè)數(shù)很重要。綜合考慮,本文設(shè)置屬性詞個(gè)數(shù)為5。

圖3 屬性個(gè)數(shù)實(shí)驗(yàn)

3.3.2 消融結(jié)果

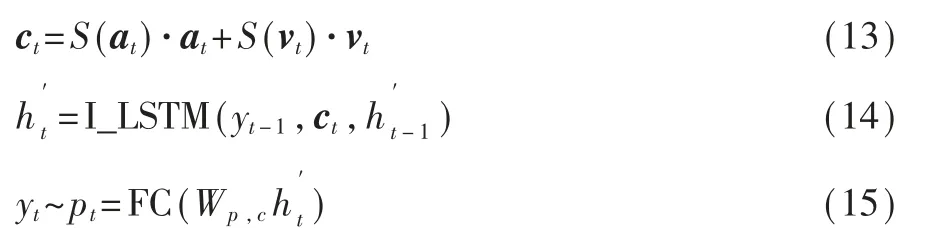

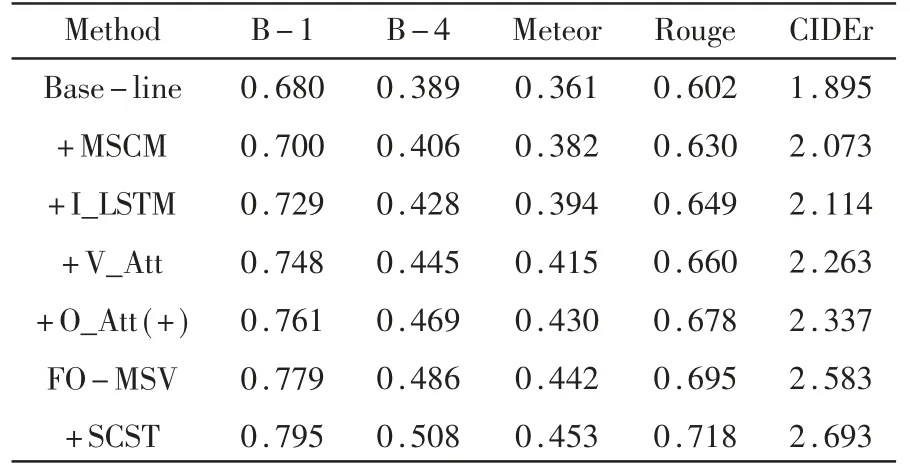

消融實(shí)驗(yàn)的結(jié)果見(jiàn)表1。其中“Base-line”是傳統(tǒng)的CNN-LSTM結(jié)構(gòu),使用CNN最后一層特征;“+MSCM”表示使用本文提出的多尺度交互特征;“+I_LSTM”表示改進(jìn)LSTM結(jié)構(gòu)之后的結(jié)果;“+V_Att”表示引入視覺(jué)注意;“+O_Att(+)”表示以直接相加的形式結(jié)合對(duì)象注意;“FO-MSV”表示本文的模型;最后的“+SCST”是強(qiáng)化訓(xùn)練后的結(jié)果。

表1 本模型消融實(shí)驗(yàn)結(jié)果

從表1可以看出,提出多尺度特征和改進(jìn)LSTM機(jī)制都會(huì)使結(jié)果有明顯提升;使用傳統(tǒng)的方法使視覺(jué)注意與對(duì)象注意直接相加也會(huì)使結(jié)果有所提升,但是利用FM對(duì)兩者進(jìn)行融合,明顯有更為顯著的提升,且強(qiáng)化訓(xùn)練效果也較為明顯。

3.3.3 對(duì)比實(shí)驗(yàn)

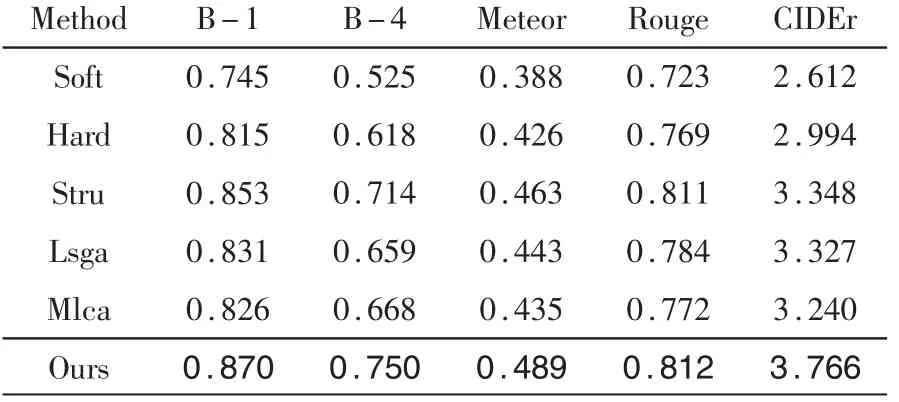

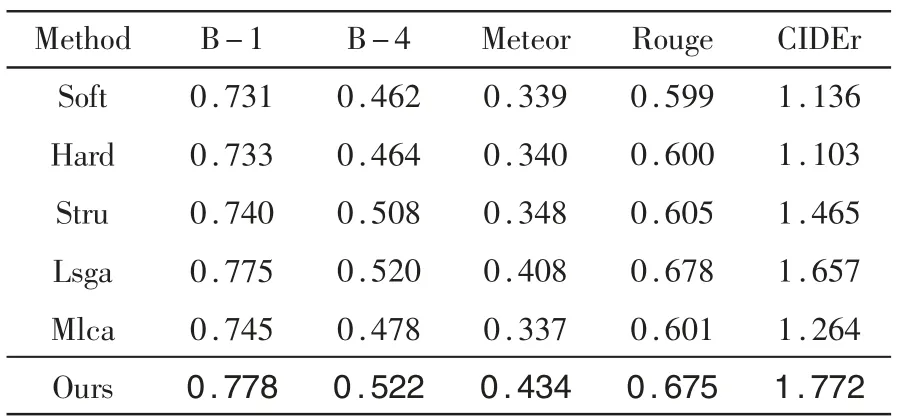

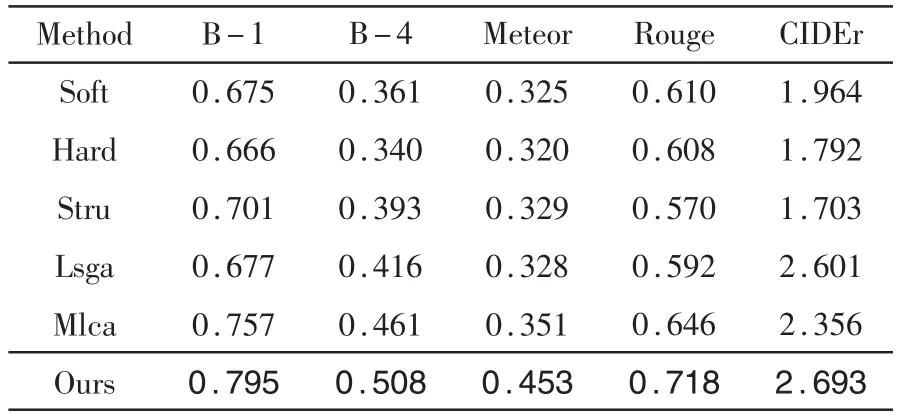

在三個(gè)數(shù)據(jù)集上對(duì)本文的方法進(jìn)行了評(píng)估,并與典型的遙感圖像描述方法進(jìn)行了比較,包括Soft[14]、Hard[14]、Stru[8]、Lsga[2]、Mlca[6]。 比 較 結(jié) 果 如 表2~表4所示,并標(biāo)粗了最好的結(jié)果。

表2 UCM數(shù)據(jù)集上不同模型對(duì)比實(shí)驗(yàn)

表3 NWPU數(shù)據(jù)集上不同模型對(duì)比實(shí)驗(yàn)

表4 RSICD數(shù)據(jù)集上不同模型對(duì)比實(shí)驗(yàn)

由于缺乏數(shù)據(jù),本文在NWPU數(shù)據(jù)集上進(jìn)行了其他模型的實(shí)驗(yàn)。在UCM、RSICD和NWPU數(shù)據(jù)集上,本文的方法均優(yōu)于其他模型,并且在未進(jìn)行強(qiáng)化訓(xùn)練的情況下,本文的結(jié)果也明顯高于其他方法。總體而言,本模型在RSIC領(lǐng)域內(nèi)表現(xiàn)出較好的性能。

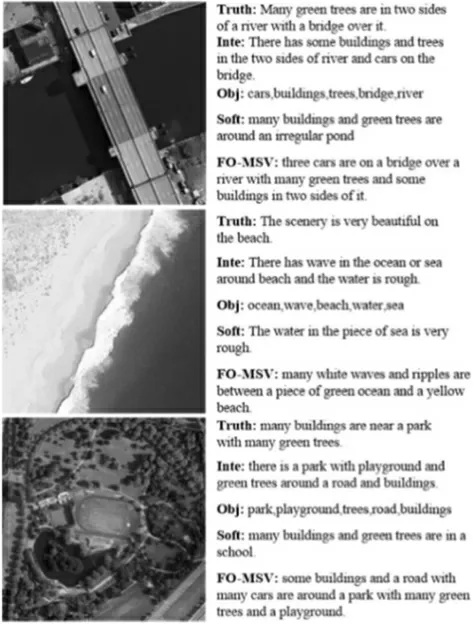

3.4 定性分析

在圖4中展示了本文模型結(jié)果示例。文字部分依次為:五個(gè)ground-truth中的一個(gè),整合描述,OE得到的對(duì)象詞,軟注意描述,本模型描述。可以看出,本文的整合描述全面概括了每個(gè)圖像的內(nèi)容,對(duì)象詞可以準(zhǔn)確獲取每個(gè)物體信息。雖然“soft”描述可以很好地表示顏色等描述性詞語(yǔ),但在對(duì)象上不夠全面,且易出現(xiàn)錯(cuò)誤,例如“pond”“school”;而FO-MSV通過(guò)對(duì)象注意充分利用了對(duì)象詞,可以得到正確的對(duì)象類(lèi)別,幾乎沒(méi)有錯(cuò)誤的描述。總之,本模型可以描述更多且正確的對(duì)象,并包含豐富的描述性詞語(yǔ),且對(duì)于單一場(chǎng)景的描述更具有紋理性,在各方面都具有較好的性能。

圖4 RSICD數(shù)據(jù)集部分描述結(jié)果

4 結(jié)論

本文提出了融合對(duì)象和多尺度視覺(jué)特征的遙感圖像描述方法,通過(guò)引入詞性標(biāo)注任務(wù)設(shè)計(jì)了對(duì)象提取器來(lái)提取圖像對(duì)象信息,以避免遺漏小物體并保證物體類(lèi)別準(zhǔn)確。同時(shí),提出了MSCM機(jī)制對(duì)不同層的特征進(jìn)行交互連接來(lái)獲取多尺度視覺(jué)特征。最后,基于注意機(jī)制和改進(jìn)的I_LSTM結(jié)構(gòu),經(jīng)過(guò)設(shè)計(jì)了程度函數(shù)的FM模塊以平衡有效的方式融合了兩種信息并生成描述。在三個(gè)公共遙感圖像數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果表明,F(xiàn)O-MSV方法與其他主流RSIC方法相比,準(zhǔn)確率有較大的提升且生成的描述更為全面、靈活和健壯。