基于實例分割與畢達哥拉斯模糊決策的目標跟蹤

趙元龍,單玉剛,袁 杰,趙康迪

(1.新疆大學 電氣工程學院,烏魯木齊 830017;2.湖北文理學院 教育學院,湖北 襄陽 441053)

0 引言

視頻目標跟蹤是計算機視覺的一個重要研究方向,普遍地運用在智能監控、移動終端、無人駕駛以及軍事勘測等領域[1]。在實際場景目標跟蹤中,如何解決尺度變化、相似性干擾、遮擋等問題成為研究熱點。

近年來,隨著深度學習在目標識別、檢測等領域的廣泛應用,越來越多的研究人員投入到基于深度學習的目標跟蹤算法研究中。Danelljan 等[2]將卷積神經網絡(Convolutional Neural Network,CNN)與空間正則化判別相關濾波器(Spatially Regularized Discriminative Correlation Filter,SRDCF)結合,提出了DeepSRDCF 算法,利用深度學習網絡增強了特征的外觀表征能力,但網絡參數過多導致跟蹤速度不滿足實時性要求。為了進一步提高跟蹤速度,Bertinetto 等[3]將全卷積網絡融入孿生網絡結構中提出了SiamFC(Siamese Fully-Convolutional)算法,通過卷積網絡計算兩條分支中圖像的相關性,提高了算法的實時性,但復雜環境下的目標跟蹤效果欠佳。Danelljan 等[4]提出的連續卷積算子跟蹤器(Continuous Convolution Operator Tracker,C-COT)算法采用多分辨率高維特征圖,將不同分辨率的特征圖通過隱式插值的方式插入連續空間域,有效地提高了跟蹤精度,然而深度特征的使用需要訓練大量濾波器,導致算法復雜度較高。Danelljan 等[5]在C-COT 算法的基礎上對濾波器降維,提出了高效卷積算子(Efficient Convolution Operators,ECO)算法,該算法利用混合高斯模型表征樣本,降低了算法復雜度,跟蹤速度雖然有所提升,但復雜場景中魯棒性略有下降。Nam 等[6]提出的TCNN(CNN in a Tree structure)算法利用多個CNN 構成樹結構,通過共享卷積層的所有參數,節省了存儲空間,但沒有解決部分幀中目標被遮擋致使跟蹤失敗的問題。Li等[7]將區域建議網絡加入SiamFC 框架,提出了SiamRPN(Siamese Region Proposal Network)算法,雖然增強了目標的判別性,但跟蹤過程中位置預測和尺度估計存在誤差,容易出現漂移現象。Wang 等[8]在SiamFC 算法的基礎上進行改進,提出了SiamMask 算法。SiamMask 將掩模特征應用于目標跟蹤任務,實現了視覺目標分割(Video Object Segmentation,VOS)與視覺目標跟蹤(Video Object Tracking,VOT)的統一,但對于復雜情景中目標遮擋、相似性干擾等問題仍需進一步優化。

上述算法均不能很好地應對尺度變化、相似性干擾、遮擋等問題,為此,本文提出一種基于實例分割與畢達哥拉斯模糊決策的目標跟蹤算法。針對大多數正常幀,通過選擇基于MaskIoU(Mask Intersection over Union)的匹配方式或基于外觀的匹配方式權衡運行速度和精度;對于大范圍遮擋或目標消失這樣的特殊幀,使用基于卡爾曼濾波的軌跡預測法預測目標位置,有效地提高了成功率;同時采用基于畢達哥拉斯模糊決策[9]的模板更新機制DFPN(Decision Fusion of Pythagoras fuzzy Number)決定是否更新目標模板和更換匹配方式,有效地防止了漂移問題,提高了魯棒性。實驗結果表明,本文算法能夠準確地在存在尺度變化、相似性干擾、遮擋等問題的視頻序列上進行跟蹤。

1 本文跟蹤算法

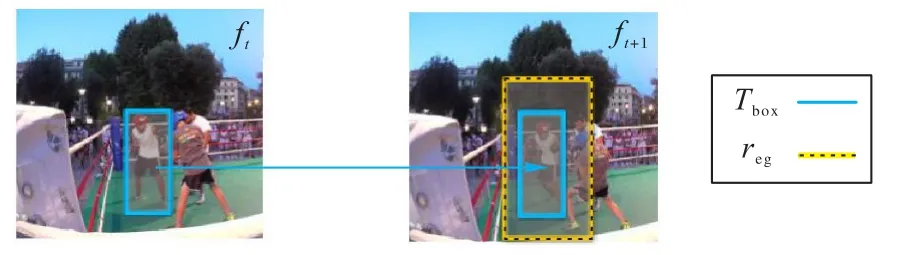

在本文算法中,目標模板用來表示目標信息。如圖1 所示,目標模板Tem包含目標的邊界框Tbox、分割掩碼Tmask,根據邊界框Tbox內裁實例圖塊Tpatch。相應地,預測結果Pre包含了預測目標的邊界框Pbox、分割掩碼Pmask、根據邊界框Pbox內裁實例圖塊Ppatch。設當前幀ft的目標狀態為Ct,則:

圖1 目標模板Fig.1 Object template

1.1 跟蹤框架

本文跟蹤算法屬于檢測跟蹤(tracking-by-detection),使用YOLACT++(improved You Only Look At CoefficienTs)實例分割網絡[10]作為檢測器,與檢測算法相比,實例分割網絡能夠提供更多的目標信息,例如掩碼信息,以便跟蹤部分實現多種匹配方式。跟蹤框架如圖2 所示,在實例分割網絡的掩碼分支(mask branch)上引入基于MaskIoU 的匹配方式,在邊界框分支(box branch)上引入基于外觀的匹配方式,同時融合卡爾曼濾波器(Kalman Filter,KF)來縮小候選目標范圍和預測特殊情景中的目標位置。基于畢達哥拉斯模糊決策的模板更新機制DFPN 對預測結果進行質量鑒定,并以此決定是否更新目標模板和更換匹配方式。對當前幀的處理分為4 個步驟。

圖2 本文算法的跟蹤框架Fig.2 Tracking framework of the proposed algorithm

1)采用基于MaskIoU 的匹配方式生成臨時的初步結果。首先確定目標的搜索區域reg(見圖3),將它輸入YOLACT++分割網絡,生成大量的候選預測;然后采用基于MaskIoU 的快速匹配,在候選預測中找到初步預測結果。

圖3 搜索區域regFig.3 Region of search reg

2)DFPN 判斷初步預測結果的正確性和質量,確定目標模板是否更新。DFPN1、DFPN2 都是DFPN,只不過DFPN1、DFPN2 的輸入不同,所以在DFPN 后加1 和2 來區分。DFPN1、DFPN2 的決策結果為D0 或者D1,D0 表示預測結果質量高,目標模板將完全被初步結果所取代,并生成最終結果;D1 表示預測結果質量低,初始結果將被丟棄,目標模板保持不變,將進一步采用其他方式預測目標。

3)判斷當前幀ft是否需要基于外觀的重檢測。如果遇到目標漏檢、遮擋等特殊情景,則需要使用基于外觀的匹配方式重新檢測目標。在進行基于外觀的重檢測時,是將整個幀而不是上述搜索區域送入YOLACT++網絡;然后,通過基于外觀的匹配方式從所有候選預測中選擇一個新的結果,再次執行第2)步以生成新的最終結果。

4)判斷ft是否需要軌跡預測法預測目標位置。如果目標消失或被大范圍遮擋,則需要使用基于卡爾曼濾波的軌跡預測法預測目標位置;否則,不需要對ft重新檢測,將對下一幀ft+1進行處理。

1.2 基于MaskIoU的快速匹配過程

對于大多數正常幀,使用MaskIoU 進行快速匹配,以提升跟蹤速度。首先,根據歷史幀的目標運動矢量信息(位置、移動速度等)確定目標的搜索區域reg(見圖3),將它輸入YOLACT++網絡,生成大量的候選預測。然后采用基于MaskIoU 的匹配方式,在所有候選預測中找到初步預測結果。傳統算法采用邊界框交并比(Intersection over Union,IoU)匹配,只能從位置信息上匹配目標,容易造成模板漂移。本文使用MaskIoU,結合了目標的輪廓信息與位置信息,以減少模板漂移現象。

1.2.1 搜索區域

搜索區域的大小在一定程度上影響著分割與跟蹤結果的質量[8]。如果對出現在場景中的所有對象都進行特征提取、匹配,將會增加系統的計算成本,因此有必要采用一定的方式預測運動目標可能出現的區域以減少冗余,提高目標跟蹤的速度。SiamRPN 和SiamMask 以上一幀目標框為中心,將目標框尺寸放大2 倍作為當前幀目標可能出現的范圍[7-8]。如圖3 所示,本文搜索區域reg以上一幀目標框Tbox為基礎,先利用卡爾曼濾波法預測當前幀目標的中心點,然后根據目標移動的快慢確定搜索區域的尺寸大小。

1.2.2 MaskIoU快速匹配

其中n表示候選預測個數。

在產生預測結果之后,保持Tmask、Pmask區域不變,將Tmask、Pmask以外區域的像素值變為0,記為:

其中函數Ω()可以將像素值變為0。

MT、MP提供了目標在模板幀和當前幀中的位置、外觀和分割信息。計算MT、MP的IoU 值Ipos,該值表示模板幀中的目標與當前幀中目標的位置重合度,能夠進一步從位置信息確認預測結果的正確性。視頻序列的幀率越高,上下幀之間目標位置越接近,Ipos值越大,則預測結果是跟蹤目標的可能性越大。將Im、Ipos送入模板更新機制DFPN1 中,DFPN1 將對預測結果進行質量評估,并根據評估結果決定是否更新目標模板以及是否進行外觀匹配。

1.3 基于孿生網絡的外觀匹配過程

外觀匹配網絡是一個添加了空間金字塔池化(Spatial Pyramid Pooling,SPP)層的孿生網絡[11],如圖4 所示,它的輸入是目標模板中的實例圖塊Tpatch和候選預測結果每個輸入將生成它們各自的嵌入向量。這兩個向量之間的歐氏距離較小,說明兩個圖塊是相似的,反之亦然。

圖4 加入SPP的孿生網絡框架Fig.4 Architecture of Siamese network with SPP

標準CNN 的輸入尺寸是固定的,當任意尺寸的圖像塊輸入這些網絡,會導致識別精度降低。將SPP 層放在特征提取層和第一個全連接層中間,可以使網絡能夠接受任意尺寸的圖像塊作為輸入且不影響精度,避免了因縮放分割對象而造成的信息損失[11]。3 層空間金字塔的池化層結構為{(4×4),(2×2),(1×1)},改進后池化層結構為{(3×3),(2×2),(1×1)},如圖5 所示。改進后的空間金字塔能夠滿足本文實驗的要求,并且進入全連接層的特征向量由21(4×4+2×2+1×1)個減少到14(3×3+2×2+1×1)個,對應全連接層的神經元數量減少了1/3,在一定程度上提升了跟蹤速度。

圖5 改進后的SPPFig.5 Improved SPP

其中:Sim()表示計算相似度的孿生網絡,n表示候選預測個數。

取預測結果對應的分割掩碼Pmask,它充分展示了預測結果的輪廓信息。Pmask與目標模板分割掩碼Tmask的IoU 值Spro能夠從一定程度上體現目標輪廓的重合度。將Sm、Spro送入到模板更新機制DFPN2 中,與1.2.2 節一樣,DFPN2 將根據預測結果質量評估結果決定是否更新目標模板以及是否使用基于卡爾曼濾波的軌跡預測法進行目標位置預測。

1.4 基于卡爾曼濾波的目標位置預測

在目標消失、大范圍遮擋這類特殊情景下,無論是基于MaskIoU 的快速匹配還是基于孿生網絡的外觀匹配都會跟蹤失敗。針對這類特殊情景,本文提出了一種基于卡爾曼濾波的軌跡預測法預測目標位置。預測過程如式(6)所示:

其中:Δt表示目標速度系數,大小根據目標在相鄰兩幀之間Tbox的IoU 值確定,該IoU 值若小于設定閾值,表示目標運動速度非常大,需要在預測時提高速度分量的比重,此時將Δt設置為1;相反,表示目標運動緩慢,則將Δt設置為一個較小的數0.01。

1.5 基于畢達哥拉斯模糊決策的模板更新機制

1.5.1 畢達哥拉斯模糊決策

設X為一個論域,則該論域X中的一個畢達哥拉斯模糊集(Pythagorean Fuzzy Set,PFS)可表示為:

其中:對于集合P中的任意x∈X而言,映射μp:X→[0,1]表示它的隸屬度;映射vp:X→[0,1]表示它的非隸屬度。πp(x)表示它的不確定性,稱之為猶豫度:

一個PFS 中的某一元素(μp(x),vp(x))稱為畢達哥拉斯模糊數(Pythagorean Fuzzy Number,PFN),也可表示為p=p(μ,v),其中μ為隸屬度,v為非隸屬度。Peng 等[9]在考慮猶豫度的影響下提出得分函數:

將猶豫度納入得分函數中,高效地利用了決策信息,在遇到隸屬度與非隸屬度相等而無法區分PFN 情形時,可以通過比較它們的猶豫度進行區分[9]。

1.5.2 模板更新機制

本文算法中將畢達哥拉斯模糊決策應用于模板更新機制。如圖2 所示,基于MaskIoU 的快速匹配和基于孿生網絡的外觀匹配,產生的預測結果Pre都會由模板更新機制DPFN決定是否更新為模板。式(8)中μ和v為隸屬度和非隸屬度,在本文中分別表示為對當前預測結果更新為模板的贊成度和懷疑度;猶豫度πp(x)表示對贊成度或懷疑度的偏向。模板更新機制如圖6 所示。

圖6 模板更新機制DFPNFig.6 Template update mechanism DFPN

如圖6(a),DFPN1 的輸入有兩個:一是MaskIoU 匹配過程中,候選預測與目標模板掩碼Tmask的最高IoU 值Im;二是表示模板幀與當前幀目標重合度的值Ipos。令

如圖6(b),DFPN2 的輸入也是兩個值:一是外觀匹配過程中,候選預測中與目標模板圖塊Tpatch外觀相似度的最高值Sm;二是表示模板幀與當前幀中目標輪廓重合度的值Spro。令

DPFN 的決策過程如式(11)所示:

2 實驗平臺與參數設置

本文算法使用Python 語言調用PyTorch 深度學習框架實現,操作系統為Windows 10 專業版,顯卡使用NVIDIA GTX1080Ti GPU(11 GB),處理器為lntel Core i7 -11700K CPU @ 4.90 GHz。

實驗中,YOLACT++實例分割網絡的訓練分為3 步進行,首先使用ImageNet 分類數據集對ResNet-101 進行預訓練,然后將訓練好的ResNet-101 與特征金字塔網絡作為主干網絡,最后在COCO 數據集上進行網絡訓練[12]。損失函數主要包含分類損失函數Lcls、邊界框回歸損失函數Lbox和Mask 損失函數Lmask,權重分別為1、1.5、6.125。使用隨機最速下降法(Stochastic Gradient Descent,SGD)訓練8×105次迭代,初始學習率為0.001,分別在第3×105、6×105、7×105和第75×104次迭代進行衰減,衰減為當前學習率的10%。

3 實驗與結果分析

本文算法實現了目標分割與目標跟蹤的統一,使用YOLACT++實例分割網絡作為檢測器,將掩模特征應用于目標跟蹤,同時利用跟蹤器進行目標模板更新,以便準確地對后續幀進行目標分割,因此從目標分割與目標跟蹤兩方面進行實驗。

3.1 VOS評估

3.1.1 數據集

在VOS實驗中,利用DAVIS(Densely Annotation VIdeo Segmentation)數據集進行評估,包括DAVIS 2016[12]、DAVIS 2017[13]。DAVIS 2016 數據集中有50 個高質量的視頻序列,每個視頻序列只標注一個目標。DAVIS 2017 數據集在DAVIS 2016 數據集的基礎上進行了擴展,由90 個視頻序列組成。不同于DAVIS 2016 的單目標分割,DAVIS 2017 數據集的每個視頻序列均包含多個需要分割的對象,并且出現了不同于常見視頻目標分割的多個挑戰,如外觀變化、尺度方向變化、目標遮擋、光線變化和運動模糊等。按照DAVIS 2016 中提出的方法進行評估,采用的評估指標包括區域相似度J和輪廓相似度F。區域相似度J為預測目標分割掩膜RM與真實掩膜RG之間的IoU 值,如式(12)所示;而輪廓相似度F權衡了輪廓精度PC和輪廓召回率RC,如式(13)所示。J&F為區域相似度J和輪廓相似度F的平均值,表示每個算法性能的總體度量。

3.1.2 評估結果

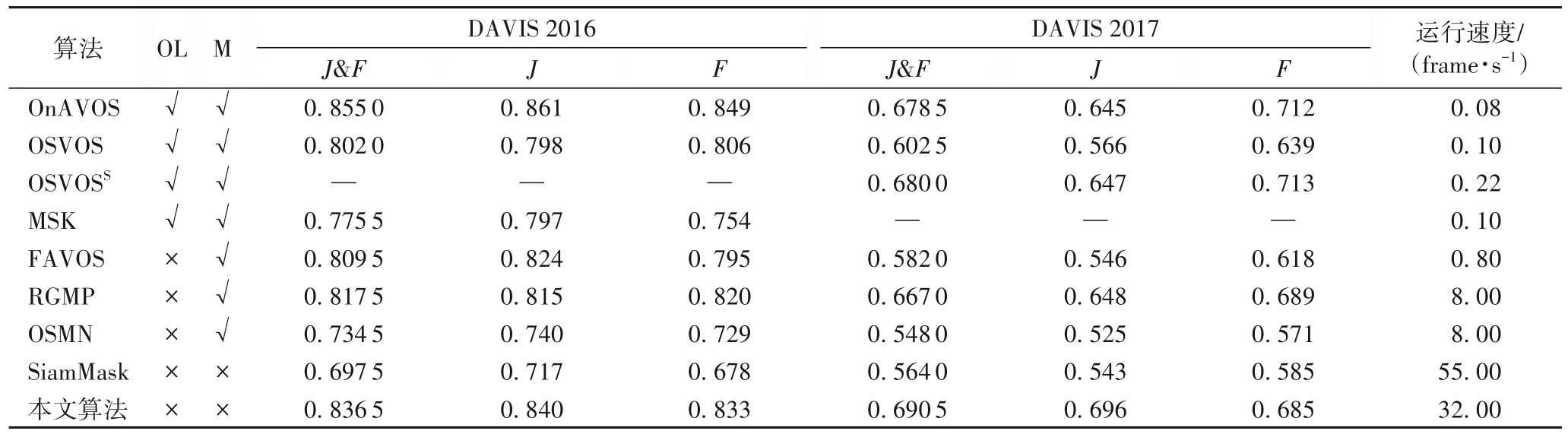

本文在480P 分辨率(720×480)的視頻下進行測試。表1給出了本文算法和其他對比算法在DAVIS 2016 與DAVIS 2017 數據集上的性能指標實驗結果,其中OnAVOS(Online Adaptive VOS)[14]、OSVOS(One-Shot VOS)[15]、OSVOSS(Semantic One-Shot VOS)[16]、MSK(即MaskTrack 算法)[17]使用掩碼進行初始化,并使用在線微調的方法;FAVOS(Fast and Accurate online VOS)[18]、RGMP(Reference-Guided Mask Propagation)[19]、OSMN 算法[20]也使用掩碼進行初始化,但不使用在線微調的方法;本文算法和SiamMask[8]使用邊界框進行初始化,不使用在線微調的方法。從表中可以看出,本文算法在DAVIS 2016 上的J&F指標為83.65%、區域相似度J為84.0%,輪廓相似度F為83.3%,優于所有不使用在線微調的算法,僅略低于使用在線微調的OnAVOS 算法,相較于SiamMask,J和F分別提升了12.3 和15.5 個百分點;在DAVIS 2017 上的J&F指標為69.05%、區域相似度J為69.6%,優于其他對比算法,相較于SiamMask,J和F分別提升了15.3 和10.0 個百分點。

表1 不同算法在DAVIS 2016與DAVIS 2017數據集上的實驗結果Tab.1 Experimental results of different algorithms on DAVIS 2016 and DAVIS 2017 datasets

相較于DAVIS 2016 數據集,DAVIS 2017 更具有挑戰性,在DAVIS 2016 上性能較好的算法,在DAVIS 2017 數據集上不一定有較好的表現,如OnAVOS 算法,而本文算法在兩個數據集上都有較高的性能指標,表明本文算法具有更好的穩健性。

3.2 VOT評估

3.2.1 數據集

對于VOT 實驗,在VOT2016[21]、VOT2018[22]數據集上對本文算法進行評估,VOT2016 和VOT2018 均包含60 個具有挑戰性的視頻序列,這60 個序列中包含了單目標跟蹤領域中的難點問題,如光照變化、尺度變化、外觀變化、相似背景干擾、運動模糊和遮擋等。將VOT2016 中一些易于跟蹤且準確度較高的視頻序列進行更換,形成了VOT2018 序列。VOT2018 重新標定了序列的真值,給出了更為精細的標注信息。根據VOT 的評估標準,本文采用以下3 個指標顯示跟蹤性能:準確率(A)用于評價算法跟蹤目標的準確度,值越大準確度越高;魯棒性(R)表示跟蹤算法的穩定性,值越小穩定性越高;預期平均重疊率(Expected Average Overlap rate,EAO)是一種綜合考慮跟蹤算法準確性和魯棒性的度量指標,值越大表示跟蹤器性能越好。

3.2.2 評估結果

將本文算法與SiamMask[2]、ATOM(Accurate Tracking by Overlap Maximization)[23]、ECO[5]、ASRCF(Adaptive Spatially-Regularized Correlation Filters)[24]、C-COT[4]、TCNN[6]、SiamRPN[7]、DaSiamRPN(Distractor-aware Siamese RPN)[25]、SiamRPN++(SiamRPN with Deep Networks)[26]、LADCF(Learning Adaptive Discriminative Correlation Filters)[27]、SPM(Series-Parallel Matching)[28]、RCO(Continuous Convolution Operators with Resnet Features)[22]、UPDT(Unveiling the Power of Deep Tracking)[29]、MFT(Multi-Hierarchical Independent Correlation Filters for Visual Tracking)[30]和GFS-DCF(Group Feature Selection and DisCriminative Filter)[31]算法進行對比分析,在不同數據集上的對比結果如表2 所示。在VOT2016 數據集上,在A 相差不大的情況下,本文算法的R 達到了最優,EAO 為0.475,高于其他對比算法。在VOT2018 數據集上,A為0.586,僅次于SiamMask 和ATOM[23];R 為0.183,雖然沒能排在前列,但優于SiamMask 和ATOM;EAO 為0.421,優于其他對比算法。相較于SiamMask 算法,雖然本文算法的A略低,但R 和EAO 指標均較好,在VOT2016 數據集分別降低和提高了7.2 個和4.2 個百分點,在VOT2018 數據集分別降低和提高了9.3 個和4.1 個百分點。

在VOT 實驗中,本文算法的A、R 和EAO 雖然沒能同時優于其他對比算法,但各指標均排在前列。VOT2016 和VOT2018 的測試中,EAO 值均高于其他對比算法,表明本文算法有著不錯的跟蹤性能。同時,本文算法的運行速度為32.00 frame/s,滿足實時性要求。

3.2.3 與其他算法的定性對比

為驗證本文算法的有效性,選取VOT2018 數據集中具有代表性的視頻序列做定性對比實驗,測試結果如圖7 所示,由上到下bmx、basketball、dinosaur、girl這4個視頻序列包含尺度變化、相似目標干擾、相似背景干擾、目標遮擋等挑戰場景。

圖7 在不同視頻序列上的定性對比Fig.7 Qualitative comparison on different video sequences

1)目標尺度變化下的對比。目標在運動過程中,尺度變化是很常見的,當目標的尺度變化過快,會對跟蹤效果產生影響。從bmx 序列的跟蹤效果可以看出,當目標的尺度發生快速變化時,SiamMask 只預測到了目標的一部分,本文算法有更準確的預測結果。

2)相似目標干擾下的對比。當目標與周圍存在的相似干擾物共同進入檢測視野時,容易發生混淆導致跟錯目標。basketball 序列的第647 幀到664 幀,目標被相似物體部分遮擋,SiamMask 將目標與干擾物共同預測為跟蹤對象,而本文算法準確地預測了結果。

3)相似背景干擾下的對比。目標圖像與圖片背景反差不明顯,比如目標圖像顏色與背景顏色基本相同,會干擾對目標的辨識,影響跟蹤的性能。dinosaur 序列中背景顏色與目標顏色相差較小,從結果來看,本文算法準確地完成了對目標的跟蹤。

4)目標遮擋情況下的對比。由于周圍環境的復雜性和其他物體的干擾,目標在運動過程中會被部分遮擋或者完全遮擋(目標消失)。在girl 序列中當目標被遮擋時,SiamMask將遮擋物預測為跟蹤對象,而本文算法沒有丟失目標,完成了對目標的跟蹤。

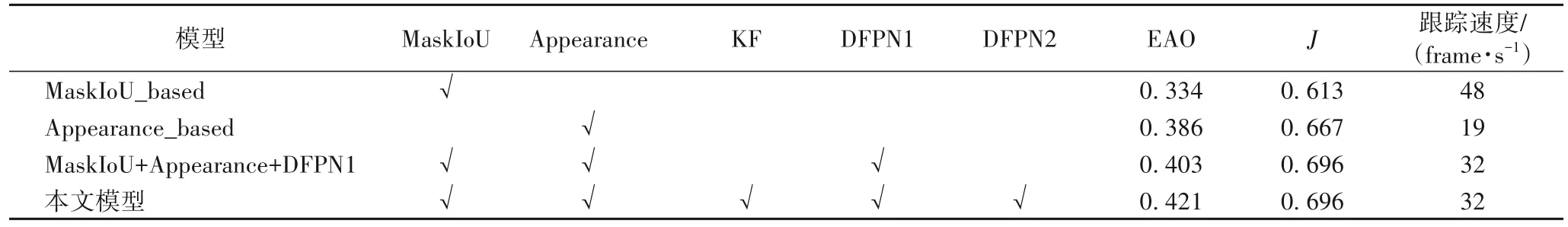

3.3 消融實驗

為驗證不同模塊對目標跟蹤性能的影響,本文在VOT2018 和DAVIS 2017 數據集上進行消融實驗。首先,移除模板更新機制DFPN,采用單一的MaskIoU 匹配或外觀匹配(Appearance),此時目標模板一直更新。然后,同時采用MaskIoU 匹配和外觀匹配,并增加基于畢達哥拉斯模糊決策的模板更新機制DFPN 進行目標模板更新和匹配方式選擇。從表3 可以看出,僅采用MaskIoU 匹配,跟蹤速度是可觀的,但是模板漂移問題導致跟蹤性能不佳;僅采用外觀匹配,跟蹤性能有所提升,但復雜的深度網絡導致跟蹤速度僅19 frame/s。增加模板更新機制DFPN 進行目標模板更新和匹配方式選擇(MaskIoU 或外觀),EAO 指標達到了0.403,速度滿足實時性要求。在此基礎上,增加卡爾曼濾波器,跟蹤性能有所提升,EAO 達到了0.421。

表3 消融實驗對比結果Tab.3 Comparative results of ablation experiments

單一的匹配方式中,目標模板無論正確與否,總是被更新,因此跟蹤性能不均衡。從表3的消融實驗結果可以觀察到,增加DFPN,跟蹤性能有所提升。DFPN1用來鑒定MaskIoU 匹配過程中目標模板的質量,DFPN2 用來鑒定外觀匹配過程中目標模板的質量,整個DFPN 所起到的作用是將3種匹配方式的優勢結合在一起,進而均衡跟蹤的速度與精度。

3.4 分割跟蹤定性分析

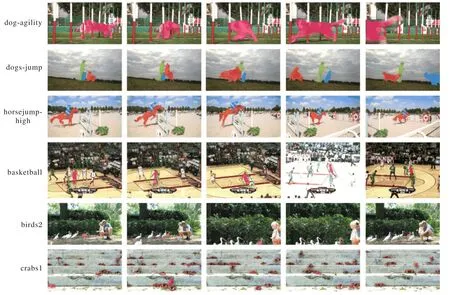

本文算法在DAVIS 和VOT 序列上的分割跟蹤定性結果如圖8 所示,其中,第1 行為DAVIS 2016 上的單對象分割效果,掩膜輪廓展示了像素級的分割結果;第2~3 行為DAVIS 2017 上的多對象分割效果,圖像中多個目標以不同的輪廓突出顯示。第4 行圖像序列同時存在于VOT2016 和VOT2018 中,第5 行只存在于VOT2016 中,第6 行只存在于VOT2018 中,從這3 行視頻序列的分割跟蹤結果可以清晰觀察到,不論在簡單場景,還是復雜場景,本文算法都能產生準確地分割掩碼和目標邊界框。這6 個視頻序列,包含了目標形變、光照變化、尺度方向變化、目標遮擋、相似性干擾等挑戰場景。不難看出,即使存在干擾,本文算法仍能夠產生準確的分割掩碼和匹配到正確的目標,實現持續穩定的跟蹤。

圖8 本文算法在VOT和DAVIS數據集上的定性分析結果Fig.8 Qualitative analysis results of the proposed algorithm on VOT and DAVIS datasets

4 結語

本文提出了一種基于實例分割與畢達哥拉斯模糊決策的目標跟蹤算法,在深度學習實例分割網絡YOLACT++的mask 分支上引入MaskIoU 匹配,以提升速度;在box 分支上引入外觀匹配,以提升精度;同時融合卡爾曼濾波算法縮小候選目標范圍和預測特殊情景中的目標位置。提出的基于畢達哥拉斯模糊決策的模板更新機制決定是否更新目標模板和更換匹配方式,以應對不同場景中的目標跟蹤問題。在DAVIS 和VOT 數據集上的實驗結果表明,即使在尺度變化、相似性干擾、遮擋等復雜場景下,本文算法仍能夠實現準確穩定的跟蹤。在后續的研究中,將考慮改進YOLACT++網絡結構以提高分割精度和設計新的目標模板更新機制,進一步提高算法的性能。