基于Transformer和CNN的真實場景下植物病害識別方法

劉 暢,莫海芳,馬 春

(1. 中南民族大學計算機科學學院,武漢 430074;2.農業區塊鏈與智能管理湖北省工程研究中心,武漢 430074;3. 湖北省制造企業智能管理工程技術研究中心,武漢 430074)

0 引言

植物病害影響農產品的質量和產量,是造成農業經濟損失的主要原因之一。通過人工判斷植物病害的方式復雜、耗時且受主觀因素影響,因此需要一種自動、快速、準確的植物病害識別方法來保證植物的品質和產量。

近年來,基于卷積神經網絡(convolutional neural networks, CNN)的模型在圖像識別領域取得了巨大的成功,這些模型能夠作為骨干模型,自動從圖像中提取特征。目前常見的卷積神經網 絡 模 型 有AlexNet[1],VGG[2],InceptionNet[3]和ResNet[4]等。很多研究人員利用卷積神經網絡模型替代人工識別的方法,在植物病害識別領域進行研究。Lyv 等[5]針對AlexNet 模型在復雜的自然環境中難以獲取玉米病害特征的問題,使用膨脹卷積保留特征的細節信息,使用多尺度卷積增加特征的多樣性,取得了98.62%的準確率。鮑文霞等[6]將ResNet 模塊和Inception 模塊結合,增大模型的特征映射區域,識別準確率達到98.73%。何欣等[7]為了進一步準確識別葡萄葉片的病害程度,在ResNet 中引入多尺度卷積,識別準確率達到90.83%。

以上研究中,模型都取得了很高的準確率,但都是針對單一物種的數種病害,數據集中的病害種類少且沒有不同植物同種病害的情況,應用場景受限,難以適應復雜的農業生產環境。為此,有學者針對非單一物種的植物病害識別進行研究,發現模型在真實場景下的識別精度不高。Ferentinos[8]使用Plant Village 數據和自制的真實環境數據,分別對模型進行訓練,實驗表明AlexNet與VGG模型使用實驗環境的病害圖像進行訓練并識別真實場景下的病害圖像時準確度僅為32.23%和33.27%。王東方等[9]提出基于深度殘差網絡和遷移學習的農作物病害識別模型,在真實農業場景數據集PlantDoc 上平均識別率達到47.37%。李進[10]提出一種基于多尺度的殘差網絡,在PlantDoc 數據集上最高識別準確率達到了64.86%。以上的研究均采用CNN架構模型,這些模型會更多地關注局部特征信息,缺乏對遠程依賴關系的提取,模型泛化能力弱,導致對復雜背景的植物病害圖像識別不夠精準。因此,增強模型的泛化能力,有助于提高真實場景下植物病害圖像的準確識別率。

TransFormer[11]在視覺任務上也取得了巨大成果。該模型是一種非局部模型[12],不使用卷積核,對于長距離特征的提取能力較強,并且具有較強的泛化能力[13-15]。Dosovitskiy 等[16]提出的ViT 使用圖像塊(patch)作為圖像分類的輸入,首次證明了Transformer 模型可以達到與CNN 同樣的圖片分類精度。于是,基于Transformer 提取全局特征的優勢和CNN提取局部特征的優勢,有學者提出將兩種模型結構結合起來。谷歌研究人員提出的BotNet[17]利用Transformer 中的多頭注意力模塊去替換Res-Net中的3×3卷積模塊;Peng 等[18]提 出 的Conformer 混 合Transformer 和CNN 兩種結構,融合了不同分辨率下的全局特征和局部特征;Wang 等[19]提出的PVT 將Transformer模型設計為漸進的金字塔結構來實現較大的分辨率輸出,同時減少特征圖的計算。

為了提升模型的泛化能力,提高真實場景下的植物病害識別準確率,本文設計了一種基于Transformer 和CNN 的深度學習模型CLT。CLT利用卷積改進Token 嵌入,并將模型設計為多階段漸進式結構,降低Token的長度,同時增加了Token 的維度,從而保證了模型容量。同時,在Transformer 模塊中,融入卷積模塊以增強模型的局部特征提取能力。

1 模型設計

1.1 模型整體結構

CLT 模型融合了視覺Transformer 模塊和CNN 模塊,并利用卷積操作增強Transformer 模塊的局部感知能力,結合Transformer 架構在全局特征提取上的優勢,提升對真實場景下植物病害圖像的特征提取能力。CLT 模型在Transformer模塊中融入一個帶殘差的深度可分離卷積模塊和一個卷積投影模塊,并借鑒CNN 中多階段層次的設計思想,將模型設計為三個階段,整體結構如圖1所示。

圖1 CLT模型整體架構

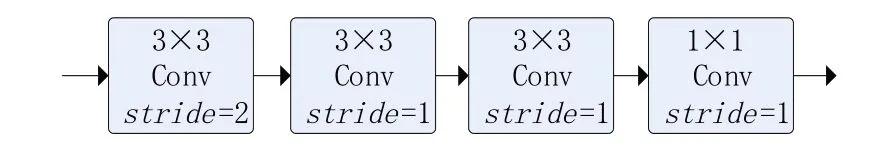

第一階段,首先圖像輸入到Conv Stem 模塊,如圖2 所示。Conv Stem 由4 個卷積模塊構成。前三個模塊使用卷積核大小為3×3 的卷積提取圖像的淺層特征,使模型能夠捕捉到更多局部細節,其中第一個模塊的步長設置為2,起到對輸入圖像維度縮減的作用。最后一個模塊使用卷積核大小為1×1 卷積,用于加強通道之間的信息交互。然后輸出的特征圖經過分塊操作,輸入到Transformer模塊中。

圖2 Conv Stem 模塊

第二階段,將第一階段輸出的Token序列重塑為Token map,經過卷積Token 嵌入層,對Token map 進行卷積操作,減少Token 的數量,同時增加Token 的維度,從而實現空間下采樣。然后輸出的Token序列直接輸入到Transformer模塊中。

第三階段,和第二階段的設計基本一樣,不同的是在卷積Token 嵌入層后,為新的Token添加一個class Token 用于進行分類。最后,輸出的分類標記通過MLP來預測結果。

1.2 融入卷積的Token嵌入層

在傳統的視覺Transformer 中,直接將輸入的圖像切分成大小相同的塊,然后將2D 的分塊圖像展平為Token向量作為模型的輸入,圖3(a)展示了ViT中通過patch嵌入獲取Tokens的過程。這種簡單的切分方式會導致圖像的邊緣信息丟失。CLT 通過對上一個階段得到的Token 序列進行卷積運算,得到下一個階段的Token序列,充分利用圖像的邊緣和線條等局部結構信息。整個過程如圖3(b)所示,圖中的Token map都是由Token 序列重塑所得,第i- 1 階段得到的Token map 記 為xi-1∈RHi-1×Wi-1×Ci-1,這 里 通過 一 個 卷積函數f(·)將xi-1映射到一個新的通道大小為Ci的Token map,其 中f(·) 卷 積 核 大 小 為k×k,padding為p。那么新得到的Token mapf(xi-1)∈RHi×Wi×Ci,其寬度和高度為

圖3 傳統的Token嵌入和融入卷積的Token嵌入

再將這個Token map展平成HiWi×Ci,就得到了第i階段的Token序列。

卷積Token嵌入層允許通過改變卷積運算的參數來調整每個階段的Token 特征維數和數量。通過這種方式,在每個階段逐步減少Token序列長度,同時增加Token 特征維數。這使得Token能夠在越來越大的空間上表示越來越復雜的視覺模式,類似于CNN的特征層。

1.3 融入卷積的Transformer模塊

為了增強模型的泛化能力,減少背景干擾,提升模型真實場景下病害特征的提取能力,CLT在Transformer 模塊中融入兩個卷積模塊,一個帶殘差的深度可分離卷積模塊和一個卷積投影模塊,詳細說明如下。

1.3.1 帶殘差的深度可分離卷積模塊

在原始的視覺Transformer 模塊中通常采用絕對位置編碼存儲圖片中像素的空間位置關系,這導致模型對圖像中目標的旋轉、平移、縮放不敏感。而CNN 對局部特征提取能力強,目標出現的位置不影響模型的輸出,具有平移不變性。因此,本文在Transformer 模塊中引入3×3的深度分離卷積(DW conv),用于增強網絡的平移不變性,并利用殘差連接穩定網絡訓練,如圖1 中Transformer 模塊所示。考慮到模型中堆疊了多個Transformer 模塊,為了不增加過多的運算參數,這里使用深度分離卷積。

1.3.2 卷積投影

Transformer 模塊中的多頭注意力模塊(MHA)中Q/K/V矩陣的Token 輸入采用的是線性投影。本文在MHA 前面添加一層卷積操作,將線性投影替換為卷積投影,實現對局部空間上下文的額外建模,如圖4 所示。首先將Token 重塑為Token map。然后使用卷積核大小為3 的深度可分離卷積來實現Q/K/V矩陣的映射,計算方式如下:

圖4 卷積投影層結構

2 實驗與分析

2.1 數據集

PlantDoc[20]數據集是印度理工學院的研究人員于2019 年秋季發布的用于圖像分類和對象檢測的數據集。該數據集花費了300多個人工小時收集和標注,包含13 個植物物種和27 個類別(17 個疾病;10 個健康)的2598 張圖像。本文將網絡爬取的真實場景下的病害圖片和數據集PlantDoc 融合構建成擴充的PlantDoc 數據集,擴充的PlantDoc數據集與PlantDoc具有相同的植物物種和類別。共計3171 張病害圖片。通過此數據集評價各個模型對真實環境下的植物病害識別性能。圖5給出了該數據樣本的展示圖。

圖5 擴充后的PlantDoc植物病害圖片示例

2.2 實驗環境與參數設置

2.2.1 實驗環境

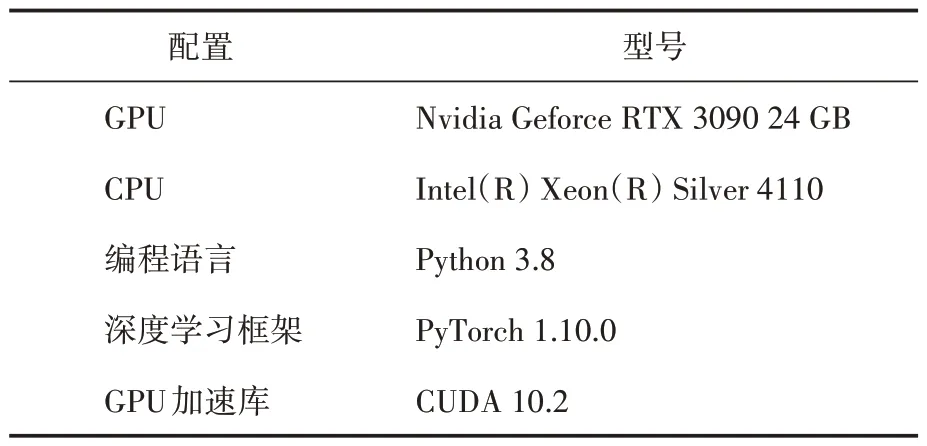

實驗環境如表1 所示,GPU 配置為Nvidia Geforce RTX 3090 24 GB,并使用CUDA 計算框架進行加速,實驗平臺為Centos 64 位,處理器為Intel(R)Xeon(R)Silver 4110,并以PyTorch為深度學習框架,Python 3.8為編程語言。

表1 實驗環境

2.2.2 參數設置

參數設置對模型的訓練有著重要的影響。本實驗對學習率、每個批次病害圖片的數量(batch size)、損失函數和優化算法進行統一設置。學習率的大小影響著模型的收斂速度,本實驗將學習率設置為0.0001。Batch Size 會影響模型的性能和速度,為了提升GPU的使用效率,平衡內存和算力,使用不同的Batch Size 進行測試,最終選定為128。實驗選擇交叉熵損失函數,優化算法使用自適應矩估計(adaptive moment estimation,Adam)。相較于廣泛使用的隨機梯度下降算法(stochastic gradient descent,SGD),Adam的計算效率更高。

2.3 實驗結果與分析

2.3.1 不同模型對比實驗

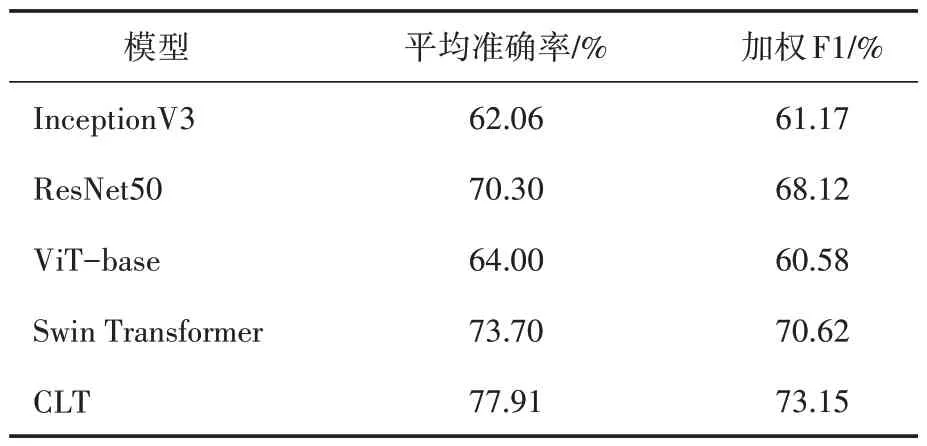

為驗證本文提出的模型CLT 在真實場景下的植物病害識別效果,選取InceptionV3、ResNet50、ViT 和Swin Transformer 作 為 對 比 模型,在擴充后的PlantDoc 數據集上訓練并進行實驗對比。其中,InceptionV3 和ResNet50 為CNN 架 構 的 模 型,ViT 和Swin Transformer 為Transformer架構的模型。

為了評價各個模型的性能,結合植物病害識別分類的特點,本實驗選擇平均準確率(Average accuracy rate)和加權F1(Weighted-F1)作為模型性能的評價指標。各模型均在PlantVillage 上進行預訓練,然后遷移到PlantDoc 上迭代300次。

本文提出的CLT 在迭代50 次以后,已經取得了優于其他模型的平均準確率,且在后續訓練中模型的準確率仍在緩慢提升,如圖6所示。

圖6 不同模型平均識別率對比結果

雖然CLT 的收斂速度略慢于其他模型,但是取得了最好的平均準確率,這說明融合CNN和Transformer 結構提升了模型的泛化性能,能更好地識別真實場景下的植物病害。

表2展示了不同植物病害識別模型在測試集上的平均準確率和加權F1 值。各模型的平均準確率在60%~80%之間,說明深度學習模型在真實場景下的植物病害分類性能還有很大提升空間。其中,Transformer 架構的模型比CNN 架構的模型表現的更好,說明全局特征提取有助于提升模型在復雜背景下的病害特征提取。本文所提出的CLT 模型結合Transformer 和CNN 對不同距離特征的提取優勢,突出植物病害信息,抑制無用背景信息,在測試集上平均準確率達到了77.91%,分類效果優于其他模型。同時加權F1 值也高于其他模型,證明CLT 對不同類別的植物區分能力更強,更適合多物種的病害識別場景。

表2 不同模型識別性能對比

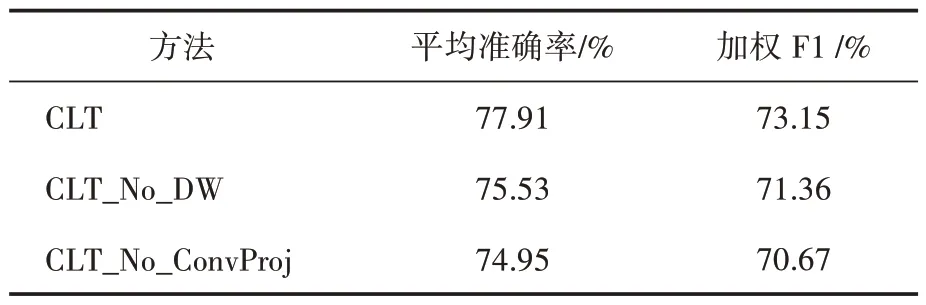

2.3.2 消融實驗

對CLT的Transformer模塊中添加的DW conv和卷積投影部分進行消融實驗,實驗均在擴充后的PlantDoc 數據集上進行。表3 中CLT_No_DW 表示在Transformer模塊中不使用帶殘差的深度可分離卷積模塊。CLT_No_ConvProj 表示在Transformer 模塊中,多頭注意力機制中的Q/K/V矩陣使用線性投影而非卷積投影獲取。在不使用DW Conv 時,模型的平均準確率為75.53%,對比CLT 下降了2.38 個百分點。而不使用卷積投影的CLT 模型的平均準確率為74.95%,下降了2.96 個百分點。證明了融入卷積的Transformer模塊能更好地提取病害圖像中的特征,使用卷積投影的多頭注意力機制能更好地對局部空間上下文進行建模,使得模型在真實場景下的植物病害識別能力得到進一步的提升。

表3 局部感知單元LPU消融實驗

3 結語

本文基于CNN 模型與Transformer 模型,提出了一種植物病害分類模型CLT,用于不指定具體植物種類的病害檢測,避免了傳統方法繁瑣的人工特征設計,提升模型在真實場景下病害的檢測分類性能。CLT 以Conv stem 作為初始特征提取模塊提取淺層局部特征,結合Transformer模塊以學習全局特征。通過卷積的方式改進Token 嵌入,調整每個階段Token 的序列長度和特征維數,結合模型的多階段結構設計,增強模型空間局部特征提取能力。同時,在Transformer模塊中插入卷積層并在多頭注意力中使用卷積投影,增加模型的平移不變性和局部感知能力。通過在擴充后的PlantDoc 數據集上實驗,CLT 獲得了77.91%的平均準確率,高于單獨的CNN 網絡和Transformer 網絡,并通過消融實驗證明了融合模型的有效性,更適合真實場景下的植物病害分類任務。