一種利用注意力增強(qiáng)卷積的暗網(wǎng)用戶對(duì)齊方法

楊燕燕,杜彥輝,劉洪夢(mèng),趙佳鵬,時(shí)金橋,王學(xué)賓

(1.中國(guó)人民公安大學(xué),信息網(wǎng)絡(luò)安全學(xué)院,北京 100038;2.北京郵電大學(xué),網(wǎng)絡(luò)空間安全學(xué)院,北京 100876;3.中國(guó)科學(xué)院 信息工程研究所,北京 100080)

1 引 言

隨著互聯(lián)網(wǎng)技術(shù)飛速發(fā)展,網(wǎng)絡(luò)數(shù)據(jù)呈現(xiàn)爆發(fā)式增長(zhǎng),但網(wǎng)絡(luò)信息良莠不齊。有害信息傳播成為網(wǎng)絡(luò)空間管控領(lǐng)域的一大難題。對(duì)網(wǎng)絡(luò)文本作者開(kāi)展身份識(shí)別,其中一個(gè)前提就是實(shí)現(xiàn)網(wǎng)絡(luò)用戶的對(duì)齊,對(duì)網(wǎng)絡(luò)文本的特征進(jìn)行提取,判定多個(gè)文本是否為同一作者所做。基于網(wǎng)絡(luò)文本作者風(fēng)格分類識(shí)別技術(shù)的作者身份判定技術(shù),可以協(xié)助相關(guān)執(zhí)法機(jī)構(gòu)獲取有害信息發(fā)布者的身份信息,為計(jì)算機(jī)取證提供依據(jù),是凈化網(wǎng)絡(luò)空間的有效手段。暗網(wǎng)信息既具有短文本語(yǔ)料特征,又具有其獨(dú)特的犯罪“黑話”特性,決定了其相對(duì)明網(wǎng)數(shù)據(jù)來(lái)說(shuō),更加依賴全局信息和長(zhǎng)序列信息來(lái)判斷語(yǔ)料的特征。

為了解決用戶身份識(shí)別問(wèn)題中易于識(shí)別的特征稀缺問(wèn)題,文獻(xiàn)[1]首先將文本卷積神經(jīng)網(wǎng)絡(luò)(Text Convolutional Neural Networks,TextCNN)模型用于用戶身份識(shí)別,并在短文本語(yǔ)料上顯示出了良好的結(jié)果。文獻(xiàn)[2]在此基礎(chǔ)上結(jié)合對(duì)上下文信息和時(shí)間特征的分析,提出了一個(gè)在紅迪網(wǎng)和推特上建立社交媒體用戶代表的模型。文獻(xiàn)[3]基于此種模型引入異質(zhì)圖方法對(duì)上下文信息進(jìn)行建模,構(gòu)造用戶嵌入,在用戶跨市場(chǎng)識(shí)別上取得了較好的結(jié)果。然而,卷積運(yùn)算有一個(gè)顯著的弱點(diǎn),即它只作用于一個(gè)局部鄰域,缺少全局信息[4]。另一方面,自注意力機(jī)制可以很好地提取全局信息和長(zhǎng)序列信息用以建模。自我注意背后的關(guān)鍵思想是產(chǎn)生一個(gè)從隱藏單位計(jì)算出的值的加權(quán)平均值。暗網(wǎng)論壇中的網(wǎng)絡(luò)文本包含大量的長(zhǎng)文本,已有的研究工作主要采用池化和卷積算子提取文本特征,比較適用于短文本,不適用于對(duì)暗網(wǎng)市場(chǎng)長(zhǎng)文本的特征提取。增強(qiáng)提取長(zhǎng)文本特征的能力是暗網(wǎng)文本特征提取面臨的主要挑戰(zhàn)。

針對(duì)已有的對(duì)暗網(wǎng)用戶發(fā)布文本內(nèi)容特征進(jìn)行提取的方法不能有效處理長(zhǎng)文本的問(wèn)題,筆者提出了一種適用于暗網(wǎng)長(zhǎng)文本特征提取的方法。通過(guò)自注意力機(jī)制增強(qiáng)卷積,實(shí)現(xiàn)長(zhǎng)文本特征的提取。在公開(kāi)的暗網(wǎng)市場(chǎng)數(shù)據(jù)集上,達(dá)到改進(jìn)基于暗網(wǎng)用戶發(fā)布文本內(nèi)容對(duì)齊用戶的效果。主要?jiǎng)?chuàng)新點(diǎn)在于提出使用自注意力機(jī)制與卷積網(wǎng)絡(luò)相結(jié)合的方式提取用戶文本內(nèi)容的特征,并取得了較好的實(shí)驗(yàn)效果,并且驗(yàn)證了完全自注意模型比完全卷積結(jié)構(gòu)差,當(dāng)卷積和自注意相結(jié)合時(shí)才會(huì)得到最好的結(jié)果。實(shí)證研究表明,將卷積特征映射與一組通過(guò)自注意產(chǎn)生的特征映射連接,可增強(qiáng)卷積算子。大量的實(shí)驗(yàn)表明,注意力增強(qiáng)可以有效改進(jìn)用戶對(duì)齊的結(jié)果。

2 相關(guān)工作

暗網(wǎng)上的內(nèi)容包括專門(mén)用于非法毒品交易、成人內(nèi)容、假冒商品和信息、泄露的數(shù)據(jù)、欺詐和其他非法服務(wù)的資源[5],還包括討論政治、匿名化和加密貨幣的論壇。

文獻(xiàn)[1]引入了卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行文本嵌入,利用多個(gè)不同大小的卷積核來(lái)提取句子中的關(guān)鍵信息(類似于多窗口大小的n-gram模型),從而能夠更好地分類捕捉局部相關(guān)性。在關(guān)于用戶身份識(shí)別的后續(xù)工作中,[6-7]利用這些想法來(lái)證明卷積神經(jīng)網(wǎng)絡(luò)模型優(yōu)于其他模型,特別是對(duì)于短文本語(yǔ)料。對(duì)子詞標(biāo)記化的進(jìn)一步研究[8],特別是字節(jié)級(jí)標(biāo)記化,使得多種語(yǔ)言跨數(shù)據(jù)共享詞匯表成為可能。使用子詞標(biāo)記器建立的模型在特定語(yǔ)言[9]和跨多語(yǔ)言社交媒體數(shù)據(jù)[2]的用戶對(duì)齊任務(wù)上表現(xiàn)良好。自2013年以來(lái),非英語(yǔ)和多語(yǔ)言暗網(wǎng)市場(chǎng)的數(shù)量一直在增加[10]。筆者的工作建立在以上想法的基礎(chǔ)上,通過(guò)使用面對(duì)暗網(wǎng)的注意力增強(qiáng)卷積神經(jīng)網(wǎng)絡(luò)(Darkweb Attention augmented Convolutional Networks,DACN)模型,對(duì)句子中字符和子詞級(jí)標(biāo)記進(jìn)行實(shí)驗(yàn)。

自注意力機(jī)制[11]是一種最新的捕獲全局信息的方式,主要應(yīng)用于序列建模和生成建模任務(wù)。值得注意的是,文獻(xiàn)[12]首次提出將注意力與遞歸神經(jīng)網(wǎng)絡(luò)結(jié)合起來(lái),用于機(jī)器翻譯中的對(duì)齊。利用自我注意與卷積是最近在自然語(yǔ)言處理和強(qiáng)化學(xué)習(xí)的工作中常用的一個(gè)機(jī)制。例如,文獻(xiàn)[13-14]的Transformer架構(gòu)分別在自注意層和卷積層之間交替進(jìn)行問(wèn)答應(yīng)用程序和機(jī)器翻譯。此外,針對(duì)視覺(jué)任務(wù)提出了多種注意機(jī)制,以解決卷積的弱點(diǎn)。例如,文獻(xiàn)[15-16]使用從整個(gè)特征地圖中聚集出來(lái)的信號(hào)來(lái)重新加權(quán)特征通道,而瓶頸注意模塊(Bottleneck Attention Module,BAM)[17]和卷積注意力機(jī)制模塊(Convolutional Block Attention Module,CBAM)[18]模型在信道和空間維度上獨(dú)立地細(xì)化卷積特征。在非局部神經(jīng)網(wǎng)絡(luò)中[19],通過(guò)在卷積結(jié)構(gòu)中使用自注意的一些非局部剩余塊,在視頻分類和目標(biāo)檢測(cè)方面得到了改進(jìn)。

文獻(xiàn)[4]使用自注意力機(jī)制替代卷積,引入了一種新的二維相對(duì)自注意機(jī)制,證明了其在取代卷積作為圖像分類的獨(dú)立計(jì)算原語(yǔ)方面具有競(jìng)爭(zhēng)力,最后證明了當(dāng)卷積和自注意相結(jié)合時(shí),圖像分類結(jié)果最好。最近的工作利用異構(gòu)信息網(wǎng)絡(luò)嵌入的概念來(lái)改進(jìn)圖建模,其中不同類型的節(jié)點(diǎn)、關(guān)系(邊)和路徑可以通過(guò)類型實(shí)體來(lái)表示[20-23]。文獻(xiàn)[24]使用異構(gòu)信息網(wǎng)絡(luò)在暗網(wǎng)上建模市場(chǎng)供應(yīng)商西比爾(sybil)賬戶,其中代表一個(gè)對(duì)象的每個(gè)節(jié)點(diǎn)都與各種特征(如內(nèi)容、攝影風(fēng)格、用戶簡(jiǎn)介和物質(zhì)信息)相關(guān)聯(lián)。類似地,文獻(xiàn)[25]提出了一種多視圖無(wú)監(jiān)督的方法,該方法結(jié)合了文本內(nèi)容、物質(zhì)和位置的特征來(lái)生成供應(yīng)商嵌入。文獻(xiàn)[26]提出了一種新穎的方法,將時(shí)間、內(nèi)容風(fēng)格與訪問(wèn)身份結(jié)合,以建模和增強(qiáng)用戶表示,從而用于識(shí)別暗網(wǎng)論壇中的相同用戶。文獻(xiàn)[3]在此基礎(chǔ)上引入異質(zhì)圖方法對(duì)上下文信息進(jìn)行建模,從而增強(qiáng)用戶嵌入,并首次應(yīng)用到暗網(wǎng)上,在暗網(wǎng)用戶跨市場(chǎng)對(duì)齊上取得了較好的結(jié)果。

通過(guò)對(duì)已有工作的廣泛調(diào)研,發(fā)現(xiàn)文本特征的提取是用戶對(duì)齊的先決條件,而用戶的一些網(wǎng)絡(luò)行為也在發(fā)揮著越來(lái)越重要的作用,如發(fā)帖時(shí)間、用戶之間的交互行為等。然而,目前的文本特征提取工作對(duì)于文本特征的表示能力不足,尤其是面對(duì)大規(guī)模訓(xùn)練文本時(shí),以卷積神經(jīng)網(wǎng)絡(luò)為代表的特征提取器特征提取的能力受到顯著制約,與池化或卷積算子不同,加權(quán)平均運(yùn)算中使用的權(quán)值是通過(guò)隱藏單元之間的相似性函數(shù)動(dòng)態(tài)產(chǎn)生的。輸入信號(hào)之間的相互作用取決于信號(hào)本身,而不像在卷積中由它們的相對(duì)位置來(lái)預(yù)先確定,故自我注意力可以捕捉全局信息。受到近年來(lái)自注意力機(jī)制對(duì)于大規(guī)模數(shù)據(jù)特征提取有效性的啟發(fā),筆者提出采用自注意力增強(qiáng)卷積的方式提取用戶的文本特征,并通過(guò)廣泛的實(shí)驗(yàn)驗(yàn)證了其對(duì)用戶對(duì)齊方法改進(jìn)的有效性。

3 基于注意力增強(qiáng)卷積的暗網(wǎng)用戶對(duì)齊方法

對(duì)于暗網(wǎng)用戶的對(duì)齊,首先需要獲取每個(gè)用戶在一段時(shí)間內(nèi)發(fā)布的帖子,然后從用戶發(fā)布的帖子中提取有效的特征。除此之外,還需獲取帖子的文本內(nèi)容、時(shí)間和上下文信息,組合形成用戶最終的嵌入式表示。所提方法的建模框架是受到了文獻(xiàn)[3]的啟發(fā),并且使用注意力增強(qiáng)卷積的方法添加了長(zhǎng)文本語(yǔ)料特征,從而增強(qiáng)了模型的表示能力。

本框架分為兩個(gè)主要的部分:① 將用戶在同一時(shí)間片段內(nèi)發(fā)布的帖子集合中的每一條帖子的文本、時(shí)間和上下文信息分別解析為長(zhǎng)、短文本特征、時(shí)間戳特征和上下文特征,即向量化過(guò)程;② 使用度量學(xué)習(xí)方法gφ訓(xùn)練f(θ),使同一用戶獲得相同的向量化表示,具體的建模過(guò)程如圖1所示。在接下來(lái)的節(jié)中,將根據(jù)各個(gè)組件來(lái)介紹所提方法。

圖1 文中方法的建模過(guò)程

3.1 文本嵌入

文本嵌入的功能是從文本輸入中提取語(yǔ)義特征,并將語(yǔ)義特征投影到信息空間中。首先,填充句子,以保持所有句子的統(tǒng)一長(zhǎng)度,使得文本嵌入輸入是固定長(zhǎng)度為m的句子s。其次,通過(guò)獨(dú)熱編碼(one-hot)將每個(gè)詞映射到dt維連續(xù)空間,得到單詞嵌入向量k。然后,將所有的詞向量連接起來(lái),形成一個(gè)m×dt矩陣作為模型輸入:X=[X0,X1,…,Xm-1]。最后,應(yīng)用語(yǔ)義特征提取器在嵌入矩陣上產(chǎn)生潛在的語(yǔ)義特征映射。

3.1.1 短文本特征

利用卷積算子對(duì)短文本預(yù)料特征進(jìn)行嵌入,通過(guò)一維卷積來(lái)獲取句子中的n-gram特征表示,利用多個(gè)不同大小的卷積核來(lái)提取句子中的關(guān)鍵信息(類似于多窗口大小的n-gram模型),從而能夠更好地捕捉局部相關(guān)性。具體工作機(jī)制是:卷積窗口沿著長(zhǎng)度為n的文本一個(gè)個(gè)滑動(dòng),類似于n-gram機(jī)制對(duì)文本切詞,然后和文本中的每個(gè)詞進(jìn)行相似度計(jì)算,后面拼接最大池化層。最后,拼接全連接層,生成短文本語(yǔ)料特征嵌入。

3.1.2 長(zhǎng)文本特征

由于Transformer模型直接處理整個(gè)句子的信息,因此必須提供每個(gè)字的位置信息給Transformer模型,這樣它才能識(shí)別出語(yǔ)言中的順序關(guān)系。對(duì)于輸入的句子X(jué),通過(guò)文本嵌入得到該句子中每個(gè)字的字向量,同時(shí)通過(guò)位置向量得到所有字的位置向量,將其相加(維度相同,可以直接相加),得到該字最終的向量表示,其計(jì)算公式為

MultiHead(Q,K,V)=Concat(Att1,Att2,…,Attn)w0。

(1)

多頭注意力機(jī)制可以為注意力模塊提供多個(gè)表示子空間。Atti表示第i個(gè)注意力頭,w0為詞語(yǔ)的初始向量標(biāo)識(shí),Concat分別表示n個(gè)不同的注意力頭相拼接。因?yàn)樵诿總€(gè)注意力模塊中,采用不同的Q,K,V權(quán)重矩陣,每個(gè)矩陣都是隨機(jī)初始化生成的。然后通過(guò)訓(xùn)練,將詞嵌入投影到不同的表示子空間中。在上一步得到了經(jīng)過(guò)多頭注意力機(jī)制加權(quán)之后輸出,再通過(guò)前饋神經(jīng)網(wǎng)絡(luò)生成潛在語(yǔ)義特征圖。

3.1.3 注意增強(qiáng)卷積

相對(duì)于卷積算子受到其局部性和缺乏對(duì)全局上下文的理解的限制,所提的方法有如下優(yōu)點(diǎn):① 使用一種注意機(jī)制,該機(jī)制可以共同關(guān)注空間和特征子空間(每個(gè)頭對(duì)應(yīng)一個(gè)特征子空間);② 引入額外的特征映射。圖2總結(jié)了提出的增廣卷積,其中Ti表示句子的第i個(gè)字符,Ei表示第i個(gè)字符對(duì)應(yīng)的向量表示,Hζ表示句子向量經(jīng)過(guò)注意力機(jī)制的投影空間,HΦ表示經(jīng)過(guò)卷積和的投影空間,Hξ表示最終的投影空間。連接卷積和注意特征映射:形式上,考慮一個(gè)通道數(shù)量為mc,級(jí)聯(lián)分類器數(shù)量為nc的卷積算子,和一個(gè)通道數(shù)量為mt,級(jí)聯(lián)分類器數(shù)量為nt的注意力特征映射。相應(yīng)的注意增強(qiáng)卷積計(jì)算公式為

圖2 文本嵌入模型圖

AAConv(X)=Concat[Conv(X),MultiHead(X)] ,

(2)

其中,Conv(·)和MultiHead(·)分別為上文介紹的卷積函數(shù)和多頭注意力函數(shù),AAConv(·)為所提注意力增強(qiáng)的卷積神經(jīng)網(wǎng)絡(luò)。這樣的結(jié)構(gòu)可以直接產(chǎn)生額外的特征圖,而不是通過(guò)加法、乘法或門(mén)控重新校準(zhǔn)卷積特征。這一特性允許靈活地調(diào)整注意力通道的比例,考慮從完全卷積到完全注意模型的一系列架構(gòu)。

3.2 時(shí)間嵌入

每個(gè)帖子的時(shí)間信息對(duì)應(yīng)于帖子創(chuàng)建的時(shí)間,文中用每篇文章的日期數(shù)作為時(shí)間特征,它是一個(gè)維數(shù)為dτ的嵌入向量標(biāo)識(shí),dτ的緯度與詞匯矩陣EW中每個(gè)詞匯的維度相同。

3.3 上下文嵌入

文獻(xiàn)[26]使用了子論壇作為紅迪網(wǎng)文章的背景。借鑒此方式,將一篇文章的子論壇編碼為一個(gè)獨(dú)熱向量,并使用它來(lái)生成一個(gè)上下文嵌入。在前面提到的工作中,這個(gè)嵌入是隨機(jī)初始化的。文獻(xiàn)[3]改變了這種設(shè)置,使用一種基于論壇帖子構(gòu)建的異構(gòu)圖的替代方法來(lái)初始化這種嵌入。

定義1(異構(gòu)圖) 異構(gòu)圖G=(V,E,T),是每個(gè)節(jié)點(diǎn)v和邊e與邊的類別TI∈T關(guān)聯(lián),其中,關(guān)聯(lián)是由映射函數(shù)φ(v):V→TV,ψ(e):E→TE給出的;其中,|TV|+|TE|>2。

構(gòu)建一個(gè)圖,其中有4種類型的節(jié)點(diǎn):用戶(U)、子論壇(S)、線程(T)和帖子(P),每條邊都表示新線程的帖子(U-T)、回復(fù)現(xiàn)有的帖子(U-P)(評(píng)論)或包含(T-P、S-T)關(guān)系。為了學(xué)習(xí)這種異構(gòu)圖中的節(jié)點(diǎn)嵌入,利用了metapath2vec框架為暗網(wǎng)論壇設(shè)計(jì)的特定元路徑方案。metapath2vec通過(guò)最大化異構(gòu)鄰域的概率來(lái)生成維度為dc的嵌入。每個(gè)元路徑方案都可以將特定的語(yǔ)義關(guān)系合并到節(jié)點(diǎn)嵌入中。

因此,為了完全捕獲異構(gòu)圖中的語(yǔ)義關(guān)系,使用了7種元路徑方案:UPTSTPU、UTSTPU、UPTSTU、UTSTU、UPTPU、UPTU和UTPU。學(xué)習(xí)到的嵌入將保留每個(gè)子論壇、所包括的帖子以及相關(guān)用戶之間的語(yǔ)義關(guān)系。

3.4 用戶發(fā)布帖子片段集合

一個(gè)用戶的多個(gè)帖子中每個(gè)組件的嵌入被連接到一個(gè)de=dt+dτ+dc維嵌入中。因此,有L個(gè)帖子的集合有L×de維的嵌入。文中為每個(gè)集合生成一個(gè)最終的嵌入。對(duì)于Transformer模型,集合嵌入作為T(mén)ransformer模型的輸入[11,27],每個(gè)嵌入作為總序列中的一個(gè)元素。在平均池化中,集合嵌入是后置嵌入的平均值,導(dǎo)致了一個(gè)維化的集合嵌入,得到一個(gè)de維的嵌入表示。在這個(gè)池化架構(gòu)中不使用位置嵌入,如圖3所示。

圖3 用戶建模模型圖

3.5 基于度量學(xué)習(xí)的用戶對(duì)齊方法

在基于用戶發(fā)帖內(nèi)容得到了用戶的向量表示之后,采用對(duì)分類的方法對(duì)齊用戶,主要是基于用戶的表示向量計(jì)算用戶表示向量的相似度。為了訓(xùn)練嵌入的f(θ),文中將其組成為一個(gè)鑒別分類器gφ:RD→RY,參數(shù)φ通過(guò)訓(xùn)練預(yù)測(cè)一個(gè)集合的用戶,其中Y是訓(xùn)練集中的用戶數(shù)量。

分類損失函數(shù)Softmax(SM):定義了參數(shù)φ=W,W∈RY×D為一個(gè)可學(xué)習(xí)的權(quán)重矩陣,并定義參數(shù)為φ=W的映射gφ(z)=softmax(W*z)。當(dāng)使用這個(gè)損失函數(shù)時(shí),可以使用歐幾里得距離比較嵌入。

4 實(shí)驗(yàn)分析

4.1 數(shù)據(jù)集

文中使用了兩個(gè)暗網(wǎng)市場(chǎng)的數(shù)據(jù)集——絲綢之路(SR)和廣場(chǎng)市場(chǎng)(Agora)。數(shù)據(jù)來(lái)源主要是基于文獻(xiàn)[3]構(gòu)造的數(shù)據(jù)集,該數(shù)據(jù)集通過(guò)基于規(guī)則和人工分析的結(jié)果標(biāo)注數(shù)據(jù)。文中將數(shù)據(jù)集分成大小相等的訓(xùn)練集和測(cè)試集,并按時(shí)間順序在中間進(jìn)行分割。除此之外,測(cè)試數(shù)據(jù)中包含了訓(xùn)練集中沒(méi)有的用戶。

4.2 對(duì)比模型

為了驗(yàn)證每個(gè)建模貢獻(xiàn)的優(yōu)點(diǎn),將其與下面描述的3個(gè)對(duì)比模型進(jìn)行了比較。經(jīng)過(guò)查閱文獻(xiàn)可知,筆者較早開(kāi)展了注意力增強(qiáng)卷積對(duì)齊用戶的工作,將已有工作分為文本嵌入模型和用戶表示模型兩類,在公開(kāi)數(shù)據(jù)集上,通過(guò)實(shí)證實(shí)驗(yàn)對(duì)比突出所提方法的優(yōu)勢(shì),驗(yàn)證了所提方法的有效性。

4.2.1 文本嵌入模型

(1) TextCNN(2014)模型[1]:一個(gè)基于短文本預(yù)料特征的用戶多賬號(hào)關(guān)聯(lián)模型。該模型使用文本卷積神經(jīng)網(wǎng)絡(luò)對(duì)每個(gè)文本進(jìn)行嵌入,不支持其他屬性(時(shí)間、上下文),同時(shí)只考慮每次發(fā)表1個(gè)文本。

表1 預(yù)處理后的數(shù)據(jù)的統(tǒng)計(jì)數(shù)據(jù) 個(gè)

(2) Transformer(2017)模型[11]:一個(gè)基于長(zhǎng)序列信息的用戶多賬號(hào)關(guān)聯(lián)模型。該模型使用Transformer對(duì)每個(gè)文本進(jìn)行嵌入,不支持其他屬性(時(shí)間、上下文),同時(shí)只考慮每次發(fā)表1個(gè)文本。

4.2.2 用戶表示模型

(1) IUR(2019)模型[2]:該模型不考慮基于圖的上下文信息。

(2) SYSML-CNN(2021)模型[3]:該模型使用文本卷積神經(jīng)網(wǎng)絡(luò)對(duì)每個(gè)文本進(jìn)行嵌入,同時(shí)考慮到時(shí)間和上下文信息,構(gòu)建用戶嵌入,進(jìn)行用戶多賬號(hào)關(guān)聯(lián)。

(3) SYSML-Transformer(2021)模型[3]:該模型使用Transformer對(duì)每個(gè)文本進(jìn)行嵌入,同時(shí)考慮到時(shí)間和上下文信息,構(gòu)建用戶嵌入,進(jìn)行用戶多賬號(hào)關(guān)聯(lián)。

4.3 評(píng)價(jià)方法和參數(shù)設(shè)置

雖然無(wú)法獲得擁有多個(gè)賬戶的單個(gè)用戶的真實(shí)標(biāo)簽,但單個(gè)模型仍然可以通過(guò)衡量它們?cè)谟脩魧?duì)齊上的表現(xiàn)來(lái)進(jìn)行比較。對(duì)每種方法生成的嵌入都使用基于檢索的度量標(biāo)準(zhǔn)進(jìn)行評(píng)估。將所有事件嵌入的集合表示為E={e1,e2,…,en},并讓Q={q1,q2,…,qK}∈E為采樣子集。計(jì)算了查詢事件嵌入與所有事件的余弦相似度。讓Ri={ri1,ri2,…,rin}表示E中的事件列表,按它們與事件qi的余弦相似性(不包括事件本身)排序。使用了以下度量方式。

平均倒數(shù)排名(Mean Reaprocal Rank,MRR)是一個(gè)國(guó)際上通用的對(duì)搜索算法進(jìn)行評(píng)價(jià)的機(jī)制,即第1個(gè)結(jié)果匹配,分?jǐn)?shù)為1,第2個(gè)匹配分?jǐn)?shù)為0.5,……,第n個(gè)匹配分?jǐn)?shù)為1/n,如果沒(méi)有匹配的句子分?jǐn)?shù)為0。最終的分?jǐn)?shù)為所有得分之和,其計(jì)算公式為

(3)

其中,k表示用戶個(gè)數(shù),A(rij)表示根據(jù)用戶發(fā)帖結(jié)果計(jì)算的排名值。Recall@k表示同一用戶的發(fā)布帖子內(nèi)容是否發(fā)生在子集內(nèi),MRR(Q)表示所有查詢樣本中這些召回值的平均值。

4.4 實(shí)驗(yàn)結(jié)果

理論上自注意力機(jī)制在取代卷積作為獨(dú)立計(jì)算單元方面是有競(jìng)爭(zhēng)力的,但是在消融實(shí)驗(yàn)中發(fā)現(xiàn),將自注意力和卷積組合起來(lái)的情況可以獲得最好的結(jié)果。因此,筆者并沒(méi)有完全拋棄卷積,而是提出使用自注意力機(jī)制來(lái)增強(qiáng)卷積,即將強(qiáng)調(diào)局部性的卷積特征圖和基于自注意力機(jī)制產(chǎn)生的能夠建模更長(zhǎng)距離依賴的特征圖拼接來(lái)獲得最終結(jié)果。評(píng)估結(jié)果見(jiàn)表2。

表2 DACN兩個(gè)數(shù)據(jù)集的評(píng)估結(jié)果

MRR為平均倒數(shù)排名指標(biāo),Recall@10表示計(jì)算前10名的召回率。由表2可以看出,在只考慮文本建模的模型中,DACN模型比TextCNN模型的MRR值平均高約2.45%,Recall@10值平均高約0.16%;DACN模型比Transformer模型的MRR值平均高約4.70%,Recall@10值平均高約6.35%;在用戶模型中,DACN模型比IUR模型的MRR值平均高約7.55%,Recall@10值平均高約8.80%; DACN模型比SYSML-CNN模型的MRR值平均高約3.25%,Recall@10值平均高約2.65%;DACN模型比SYSML-Transformer模型的MRR值平均高約6.90%,Recall@10值平均高約8.70%。我們發(fā)現(xiàn),注意力增強(qiáng)卷積都實(shí)現(xiàn)了一致的提升。另外,完全的自注意模型(不用卷積那部分),可以看作是注意力增強(qiáng)模型的一種特殊情況,但結(jié)果比完全卷積結(jié)構(gòu)略差。

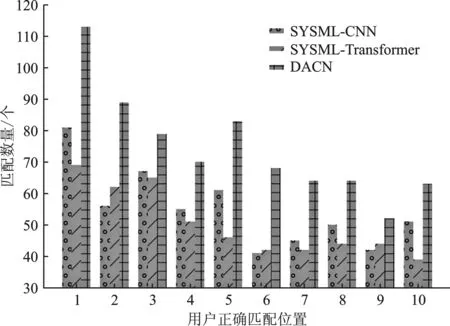

在對(duì)兩個(gè)數(shù)據(jù)集的結(jié)果觀察后發(fā)現(xiàn),在Recall@10中用戶正確匹配的位置數(shù)量對(duì)比中,前10個(gè)用戶正確匹配的位置,無(wú)論在哪個(gè)位置,所提模型的匹配數(shù)量均比SYSML-CNN 和SYSML-Transformer模型多,說(shuō)明所提模型優(yōu)于SYSML-CNN 和SYSML-Transformer模型,具體如圖4和圖5所示。

圖4 廣場(chǎng)市場(chǎng)數(shù)據(jù)集用戶正確匹配個(gè)數(shù)對(duì)比圖

圖5 絲綢之路數(shù)據(jù)集用戶正確匹配個(gè)數(shù)對(duì)比圖

5 結(jié)束語(yǔ)

暗網(wǎng)因其匿名性吸引了大量犯罪分子從事違法犯罪活動(dòng),同時(shí)也給執(zhí)法人員帶來(lái)了極大困難。近年來(lái)深度神經(jīng)網(wǎng)絡(luò)在各個(gè)領(lǐng)域取得廣泛成功,越來(lái)越多的研究者開(kāi)始利用神經(jīng)網(wǎng)絡(luò)對(duì)匿名的網(wǎng)絡(luò)文本作者進(jìn)行身份識(shí)別。針對(duì)已有的方法主要面向短文本、不擅長(zhǎng)處理全局和長(zhǎng)序列信息的問(wèn)題,提出了一種自注意機(jī)制來(lái)增強(qiáng)卷積算子,利用長(zhǎng)序列信息來(lái)建模暗網(wǎng)用戶發(fā)表的網(wǎng)絡(luò)文本的方法,從文本內(nèi)容入手,對(duì)匿名的暗網(wǎng)用戶進(jìn)行多賬號(hào)關(guān)聯(lián),達(dá)到聚合多個(gè)匿名賬號(hào)信息的目的,為獲取用戶的真實(shí)身份提供更多線索。在公開(kāi)數(shù)據(jù)的實(shí)驗(yàn)中,結(jié)果表明,所提方法優(yōu)于已有工作,驗(yàn)證了所提方法的有效性;同時(shí),在探索不同的注意機(jī)制如何權(quán)衡計(jì)算效率和表征能力的消融實(shí)驗(yàn)中,發(fā)現(xiàn)注意力機(jī)制很大程度上增強(qiáng)了卷積算子提取用戶特征的性能。