基于模態信息交互的多模態情感分析

蔡宇揚 蒙祖強

摘 要:基于全局語義交互的粗粒度注意力機制不能有效利用各模態間的語義關聯提取到模態信息中的關鍵部分,從而影響分類結果。針對這個問題提出了一個模態信息交互模型MII(modal information interaction),通過細粒度注意力機制提取模態的局部語義關聯特征并用于情感分類。首先,模態內信息交互模塊用于構建模態內的聯系并生成模態內交互特征,隨后模態間信息交互模塊利用圖像(文本)的模態內交互特征生成門控向量來關注文本(圖像)中相關聯的部分,從而得到模態間的交互特征。考慮到特征中存在的冗余信息,模型加入了自適應特征融合模塊從全局特征層面對特征進行選擇,增強了包含情感信息的關鍵特征的表達能力,弱化了冗余信息對分類結果的影響。在MVSA-Single和MVSA-Multi兩個公開數據集上的實驗結果表明該模型優于一系列基線模型。

關鍵詞:多模態; 情感分析; 信息交互; 注意力機制

中圖分類號:TP391?? 文獻標志碼:A

文章編號:1001-3695(2023)09-006-0000-00

doi:10.19734/j.issn.1001-3695.2023.02.005

Multimodal sentiment analysis based on modal information interaction

Cai Yuyang, Meng Zuqiang

(School of Computer, Electronics & information, Guangxi University, Nanning 530004, China)

Abstract:Coarse-grained attention mechanisms based on global semantic interactions cant effectively use the interconnection between modalities to extract the key parts of modal information, which affects classification results. Aiming at this problem, this paper proposed a modal information interaction model, which extracted the local semantic association features of the modality through a fine-grained attention mechanism and used them for sentiment classification. First, the intra-modal information interaction module constructed intra-modal connections and generated intra-modal interaction features. After this, the inter-modal information interaction module used intra-modal information interaction features to generate gating vectors, which focused on the appropriate parts of the text (image) , thereby obtaining inter-modal information interaction. Finally, considering the redundant information in the features, the model also added an adaptive feature fusion module to select features from the global feature level, enhanced the expression ability of key features containing emotional information, and weakened the impact of redundant information on classification results. Experimental results on two public datasets MVSA-Single and MVSA-Multi demonstrate that the model outperforms a series of baseline models.

Key words:multimodality; sentiment analysis; information interaction; attention mechanism

0 引言

情感分析是對含有情感信息的數據進行分析、處理,進而得到情感極性的過程[1,2]。傳統的情感分析研究主要集中于文本單模態,即通過對一段文字進行分析來判斷其所包含的情感極性。隨著Twitter、微博等社交媒體的快速發展,用于表達情感極性的媒介日益呈現多樣化趨勢,尤其是圖文多模態數據已經成為承載用戶情感觀點的主流媒介[3]。對富含情感信息的多模態數據進行情感分析已經成為發現網絡用戶情感趨向的主要途徑。多模態情感分析在應對社會突發事件輿論監控和新聞謠言檢測等實際應用方面有著重要研究意義[4,5],能幫助政府機構高效監管網絡內容,正確引導輿論并樹立科學價值觀。

由于單一模態的信息難以反映真實的情感,越來越多的用戶選擇通過圖像和文本等多模態形式表達情感和觀點,但這樣的轉變也給情感分析領域帶來了挑戰。傳統的文本情感分析難以辨別多模態數據的情感極性,多模態情感分析逐漸成為情感分析領域的重要方法。

早期的多模態情感分析大多先獨立地從文本和圖像信息中提取特征,然后使用特征拼接和線性加權等方法對兩種模態的特征進行融合[6,7],最后輸入全連接網絡進行分類。例如文獻[8]提出了新型跨媒體詞袋模型,用詞袋表示微博中圖像和文本的特征,使用邏輯回歸訓練模型從而實現情感分類,實驗結果表明使用多模態數據進行分類的準確率比使用單模態數據分類的準確率要高。

同一用戶在社交媒體中發布的圖像與文本在語義上是存在著某種聯系的,然而對圖像和文本獨立地提取特征忽視了模態之間固有的語義關聯對各模態特征學習的影響。基于全局信息的粗粒度交叉注意力構建的模態間的聯系缺少跨模態的深層信息交互,無法高效構建局部語義特征關聯。若直接拼接模態交互后的特征進行分類,其中包含的冗余信息可能會影響最終情感分類結果。本文的主要貢獻如下:

a)提出了用于情感分類的多模態情感分析模型,在模態交互過程中能通過模態間的局部語義關聯精準地選擇相關性高的特征,并自適應地選擇其中用于情感分類的部分特征。通過在兩個公開數據集MVSA-Single和MVSA-Multi上的實驗結果證明了模型的有效性。

b)提出了基于門控注意力機制的模態間信息交互模塊,能夠利用模態間的聯系精準地學習模態間的局部語義關聯,利用文本(圖像)的模態內交互特征捕捉圖像(文本)中相關聯的信息,實現細粒度交叉注意,獲得融合了文本(圖像)信息的圖像(文本)模態間交互特征。

c)提出了自適應特征融合模塊,可以靈活地從模態內和模態間輸出的圖文全局特征中選擇富含情感信息的特征。模塊從全局特征角度對圖文特征之間的關系進行建模,進而自適應地調整特征中用于情感分類的部分,增強包含情感信息的關鍵特征的表達能力并過濾部分冗余信息。

1 相關研究

多模態情感分析包括兩個方面:分別處理單模態數據;將處理后的數據進行融合。對單一模態數據處理不好,會影響多模態情感分析的結果;融合方式的性能不好會破壞多模態系統的穩定性[9]。Borth等人[10]使用Sentibank提取了1 200個形容詞—名詞對(ANP)作為圖像特征,再通過SentiStrength計算文本情感得分,然后將二者結合起來得到最終情感極性。Cai等人[11]提出了一種基于卷積神經網絡的多模態情感分析方法,用兩個獨立的CNN分別學習文本特征和圖像特征,輸入全連接層得到最后分類結果。Yu等人[12]先使用預訓練CNN和DNN分別對文本和圖像進行情感分析,然后通過訓練邏輯回歸模型得到分類結果。Zadeh 等人[13]引入多模態字典,幫助理解人在表達情感時面部表情與話語之間的關系,并建立一個多模態情感數據集CMU-MOSI。雖然多模態情感分析的研究取得了一定的進展,但這些基于神經網絡模型的工作通常是獨立地從圖像和文本提取特征,并將圖文特征輸入分類器得到分類結果,忽略了圖像與文本之間的聯系。

隨著注意力機制研究的發展[14,15],基于注意力的特征提取可以根據上下文選擇顯著特征,從而實現有效地模態間信息交互。Xu等人[16]考慮了圖像對文本的單向影響,對圖像分別提取場景特征和對象特征,在提取文本特征過程中使用場景和對象特征進行引導,得到圖像引導的文本特征。郭可心等人[17]利用文本引導的空間注意力分別關注圖像高層實體特征和中低層視覺特征,從而加強模態間的關聯。劉琦瑋等人[18]利用圖片信息引導關注文本中的關鍵信息,增強了文本中影響情感分類的特征,使模型能夠關注到文本中貢獻度較大的詞匯。上述研究都考慮到了模態之間的單向交互,使用其中一個模態引導關注另一個模態中的信息,但沒有充分考慮模態之間的相互影響。Zadeh等人[19]考慮到模態內部信息以及模態之間的交互作用提出了一種基于張量融合的特征融合網絡TFN,在MOSI 數據集上得到了較高的準確率。Ghosal 等人[20]提出一種使用成對注意力的方法MMMU-BA,不僅能學習一個視頻段落的文本—語音、語音—視覺、文本—視覺兩兩模態間的交互關系,也能充分利用當前視頻段與其上下文信息的在不同模態對內部的跨模態交互作用,在MOSI和MOSEI兩個公開數據集上都取得了出色的表現。Xu等人[21]提出了一種Co-Memory網絡迭代地利用文本信息找到圖片中的關鍵內容、利用圖片信息定位文本關鍵詞,從而對圖像和文本之間的相互影響進行建模分析。Zhang等人[22]利用新型編碼器提取圖像和文本特征,然后通過多模態交叉特征融合模塊相互學習模態內部的特征,最后將學習后的圖像和文本特征拼接后輸入全連接層進行分類;但他們使用的是對全局語義信息進行交互的粗粒度注意力機制,不能高效關注模態間局部語義關聯,特征會包含冗余信息,對分類結果造成影響。

社交媒體中,圖文模態之間存在局部相關性并且這種相關性會影響多模態情感分析的結果。針對處理單模態數據過程中沒有充分考慮模態之間的相互聯系以及拼接模態特征帶有冗余信息的問題,本文提出了基于注意力機制的模態信息交互模型MII用于社交媒體圖文多模態情感分析任務。模型先使用自注意力和門控交叉注意力分別挖掘模態內和模態間的聯系。基于門控細粒度交叉注意力的模態間信息交互模塊可以準確地捕捉模態間的局部語義關聯,然后將模態內和模態間的交互特征輸入自適應特征融合模塊。自適應特征融合模塊對模態內和模態間拼接后的交互特征進行選擇,模塊的思想與通道注意力類似,先對圖像區域和文本中字的特征進行建模,學習特征之間的關系,最后從全局特征層面選擇包含情感信息的特征進行情感分類。

2 模態信息交互模型

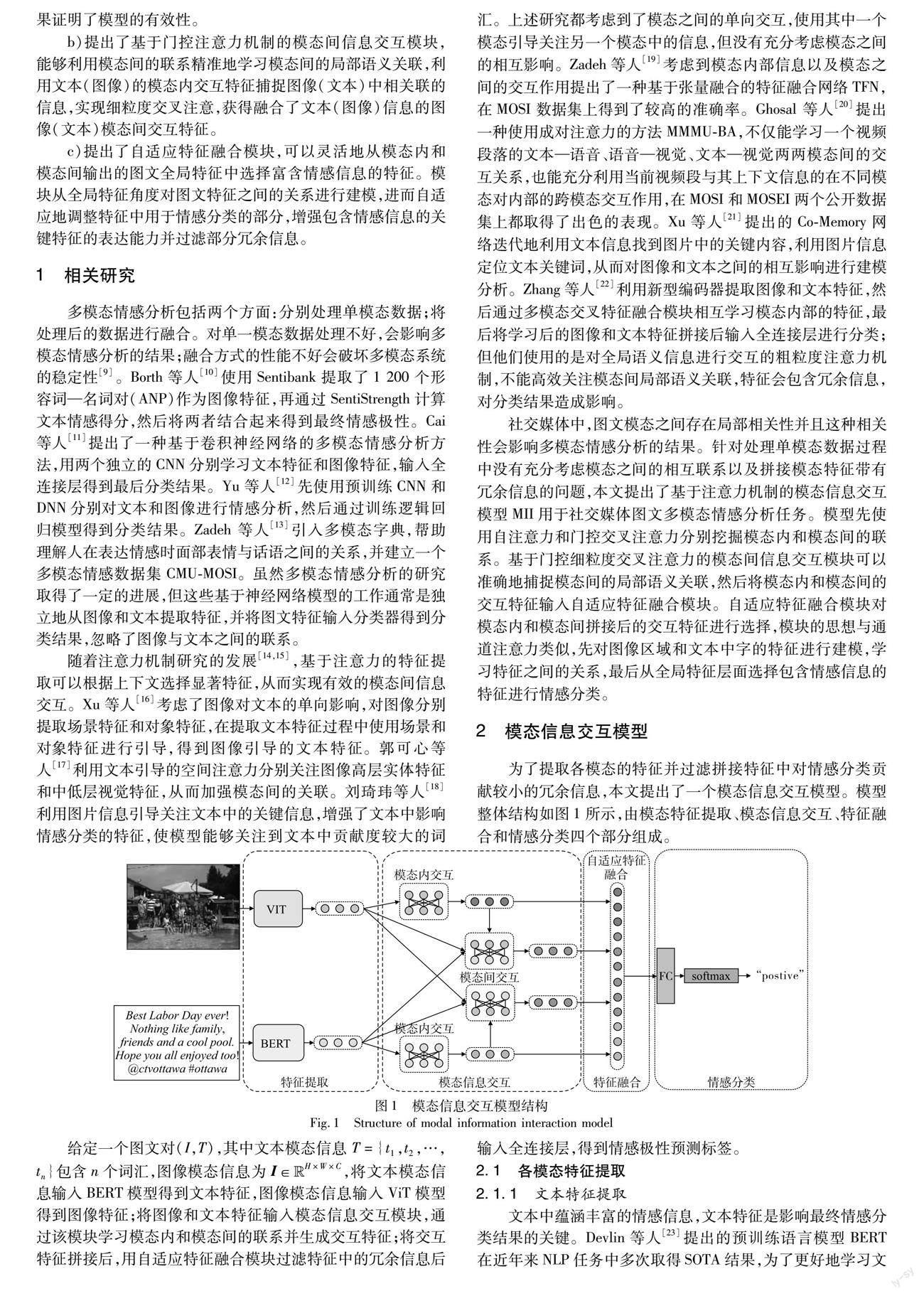

為了提取各模態的特征并過濾拼接特征中對情感分類貢獻較小的冗余信息,本文提出了一個模態信息交互模型。模型整體結構如圖1所示,由模態特征提取、模態信息交互、特征融合和情感分類四個部分組成。

3.2 數據集

本文實驗所用的數據集為MVSA多模態數據集[25]。該數據集從Twitter上收集了大量圖文對,通過人工標注的方式對數據賦予情感標簽。MVSA數據集包括兩個獨立的數據集MVSA-Single和MVSA-Multi。MVSA-Single包含5 129個圖像文本對,并且每一組數據由一名人員分別對圖像和文本標記積極、中性、消極三種情感標簽中的一種;MVSA-Multi包含19 600個圖像文本對,但與前者不同的是每組圖像文本對由三名獨立的人員進行標記,因此每組數據的圖像和文本都會包含三個標簽。為了確保數據的高質量,本文采用與文獻[11]中相同的方法對數據集進行預處理。

a)針對MVSA-Multi中單模態包含多個標簽的情況,以相同分類數量最多的標簽作為單模態的真實標簽,此時情感標簽分類標注與MVSA-Single相同,圖像和文本分別有唯一標簽;b)若圖像與文本的標簽相反,即一個為積極而另一個為消極的情況下,棄用該數據進行實驗,若圖像與文本標簽相同,則將其標簽作為該圖像文本對的最終標簽,若圖像與文本中一個為中性而另一個為積極或者消極,則將該圖像文本對標記為積極或者消極;c)得到處理后的MVSA-Single和MVSA-Multi。對數據進行篩選和處理后的數據集標簽信息如表1所示。

3.3 基線模型

本文選擇了八個多模態情感分析模型與MII進行對比。

a)SentiBank+SentiStrength[10]。通過Sentibank提取了1200個形容詞—名詞對(adjective-noun pairs)作為圖像特征,然后計算文本和圖像的情感得分,進而判斷圖文對的情感標簽。

b)CNN-Multi[11]。先通過文本CNN和圖像CNN分別提取文本特征和圖像特征,然后將拼接后的特征送入另一個CNN學習圖文之間的聯系,得到最終情感標簽。

c)DNN-LR[12]。在預訓練詞向量的基礎上訓練了一個用于文本情感分析的CNN模型,然后使用一個深度卷積神經網絡對圖像進行情感分析,最后通過邏輯回歸預測文本和圖像的情感標簽。

d)MultiSentiNet[16]。考慮到圖像對文本的影響,提出了一個用于多模態情感分析的深度語義網絡,先識別圖像中的物體和場景作為圖像的深層語義特征,然后訓練一個圖像特征引導的LSTM模型來尋找文本中對情感分析有影響的關鍵詞,最后將物體、場景、關鍵詞的特征組合后預測多模態數據的情感標簽。

e)MLSA[17]。考慮到文本對圖像的影響,使用具有多層分支結構的文本引導的空間注意力模塊,針對CNN不同層次卷積的輸出進行空間注意力加權;從圖像中獲取和使用與文本相關的高層語義特征和中、低層視覺特征,加強了圖文之間的情感關聯。

f)TSAIE[18]。考慮到圖像對文本的影響,利用組合注意力特征融合模塊計算出文本信息中每一個詞與圖片包含情感的相似度,從而增強文本中能夠影響情感極性分類的特征,使模型能夠關注到文本中貢獻度較大的詞匯,然后與圖片特征融合,最后將融合特征輸入全連接層進行分類。

g)COMN[21]。考慮到圖像與文本之間存在的相互聯系,提出了一個新的協同記憶網絡,在特征提取過程中迭代地對圖像內容和文本之間的相互聯系進行建模分析。

h)CFF-ATT[22]。通過使用去噪自動編碼器更準確地提取原始文本特征,同時提出了一種注意力模型使圖像和文本對稱地學習內部特征,生成融合特征用于最終分類。

i)MII。用模態內信息交互和模態間信息交互模塊獲取圖像和文本的模態內交互特征。與COMN不同的是,在特征提取過程中加入了門控機制實現細粒度注意力交互,挖掘圖像文本間的局部語義關聯。COMN和CFF-ATT忽略了拼接特征中包含的冗余信息,MII同時對模態內和模態間交互的輸出特征進行自適應特征融合,從全局特征層面有選擇地保留包含情感信息的關鍵特征進行情感分類,從而達到更好的分類效果。

3.4 實驗結果及分析

3.4.1 定量分析

為了直觀地證明本文提出的模型能有效利用模態間的聯系提升情感分類的結果,以準確率和F1值為指標,將本文提出的MII模型與一系列基線模型在兩個公開數據集MVSA-Single和MVSA-Multi上進行量化對比,表中直接引用了這些方法文獻中的實驗結果。MII與一系列基線模型在MVSA數據集上的實驗結果如表2、3所示。

由表2、3中數據可以看出SentiBank+SentiStrength的效果最差,因為使用形容詞—名詞對的圖文特征不能準確提取圖像和文本模態的信息。CNN-Multi和DNN-LR由于使用了深度學習模型,通過卷積神經網絡獲取圖像文本的特征,取得了較好的結果,但忽略了圖像文本之間的聯系。MultiSentiNet考慮到了圖像對文本的影響,訓練了一個圖像特征引導的深度學習模型來尋找文本中的關鍵部分,提升了模型性能;MLSA利用文本來獲取圖像不同層次特征中的關鍵部分;TSAIE則利用圖像特征增強文本,尋找文本特征中的關鍵部分。但它們只考慮了模態之間的單向影響,沒有考慮到注意力機制和特征融合中的冗余信息對分類結果的影響。

COMN是在圖像和文本特征提取過程中對模態間的聯系迭代地建模分析,因為考慮到了模態間的相互影響而非圖像對文本的單向影響,取得了比MultiSentiNet更好的結果。但對圖文特征使用全局特征的粗粒度注意力交互,可能會使網絡關注部分冗余信息;最后直接拼接圖像和文本記憶網絡中的輸出會使得冗余信息對分類結果產生影響。CFF-ATT考慮到噪聲對特征提取準確性的干擾,通過自動編碼器更準確地提取單模態特征,并加入注意力機制利用圖像和文本交互學習各模態內部特征。分別將圖像和文本特征作為主輸入和二次輸入,用交叉特征融合模塊融合兩個模態的特征后,得到用于分類的輸出特征;但其沒有考慮到用于分類的特征中所包含的冗余信息對分類結果的影響。MII模型采用預訓練模型提取圖像和文本特征,模態信息交互模塊關注模態內的聯系和模態間的相互影響,先在模態間交互中使用門控細粒度交叉注意力準確地提取與另一模態相關的特征,然后使用模態內和模態間的輸出進行自適應特征融合,從全局特征層面對特征之間的關系建模,有選擇地調整用于最終情感分類的特征,取得了最好的效果。

3.4.2 定性分析

為了更為直觀地觀察門控交叉注意力所起到的作用,對粗粒度交叉注意力和門控交叉注意力分別進行可視化,結果如圖4所示。如圖4(a)(d)所示,圖像及其對應的文本為“我可以很容易地搬到維多利亞漁夫碼頭的一艘游艇上,多么明亮和快樂!(譯文)”。對圖像和文本進行注意力交互,模型除了關注圖中碼頭上停放的游艇以外,有部分注意力集中在了水中的倒影以及天空中的白云上,如圖4(b)所示;圖4(c)展示了圖像和文本通過門控交叉注意力進行交互后的注意力,模型的注意力主要集中在圖中的游艇和碼頭上,有少量注意力關注水面和白云。通過圖4(e)(f)可以看出,用圖像交互引導后模型更為關注與圖像相關的“游艇”“碼頭”等單詞。綜合來看,本文模型能構建圖像和文本中局部信息關聯,并能在情感分類實驗中取得更好的效果。

3.4.3 消融實驗

為了驗證本文所提出的帶門控注意力模態間信息交互模塊和自適應特征融合模塊的有效性,本節通過消融實驗進行對比。

消融實驗結果如表4所示,其中MII-1設置為使用粗粒度交叉注意力進行模態間交互,然后直接拼接特征進行分類;MII-2為使用了帶門控注意力的模態間交互模塊,但不考慮拼接特征可能帶有的冗余信息,直接進行分類;MII-3為使用粗粒度注意力進行模態間交互,但在特征融合階段使用自適應特征融合模塊選擇包含情感信息的關鍵特征進行分類。

從表4可以看出MII-1情感分類的結果最差,沒有有效利用模態間的相互聯系提取特征,拼接特征中過多的冗余信息干擾了最終分類結果的準確性。由于MII-2使用了門控機制對交叉注意力中輸入的特征進行約束,以文本引導圖像為例,先將圖像和文本模態內交互特征映射到公共空間來表示模態特征之間的相關性,然后選擇圖像中相關性較高的特征進行細粒度注意力交互,從而準確地挖掘圖像文本之間的局部語義關聯,關注圖像中與文本相關的特征。所以MII-2的結果表現較之MII-1更好,從而證明了模態間交互模塊中門控交叉注意力的有效性。MII-3中加入了自適應特征融合模塊對圖像和文本特征之間的依賴關系進行建模,從全局角度選擇其中用于情感分類的特征。MII-3的結果表現較之MII-1更好,證明了自適應特征融合模塊的有效性。

4 結束語

本文提出了一個用于多模態情感分類任務的社交媒體多模態情感分析模型MII,使用了預訓練BERT和ViT模型提取文本和圖像特征。為了挖掘學習圖像和文本之間存在的聯系和相互影響,模型加入了模態信息交互模塊用于關注模態內和模態間信息的聯系;在模態間信息交互模塊中使用門控細粒度交叉注意力準確地選擇與另一模態相關聯的特征,并且利用自適應特征融合模塊選擇交互特征中包含情感信息的部分進行分類,通過在兩個公開數據集上的實驗結果證明了本文提出模型的有效性。后續工作將對圖文模態信息交互模型MII進行改進,對圖像、文本和音頻三模態之間的信息交互進行深入研究。

參考文獻:

[1]張亞洲,戎璐,宋大為,等.多模態情感分析研究綜述[J].模式識別與人工智能,2020,33(5):426-438.(Zhang Yazhou,Rong Lu,Song Dawei,et al.A survey on multimodal sentiment analysis[J].Pattern Recognition and Artificial Intelligence,2020,33(5):426-438.)

[2]鐘佳娃,劉巍,王思麗,等.文本情感分析方法及應用綜述[J].數據分析與知識發現,2021,5(6):1-13.(Zhong Jiawa,Liu Wei,Wang Sili,et al.Review of methods and applications of text sentiment analysis[J].Data Analysis and Knowledge Discovery,2021,5(6):1-13.)

[3]孫影影,賈振堂,朱昊宇.多模態深度學習綜述[J].計算機工程與應用,2020,56(21):1-10.(Sun Yingying,Jia Zhentang,Zhu Haoyu.Survey of multimodal deep learning[J].Computer Engineering and Applications,2020,56(21):1-10.)

[4]陳志毅,隋杰.基于DeepFM和卷積神經網絡的集成式多模態謠言檢測方法[J].計算機科學,2022,49(1):101-107.(Chen Zhiyi,Sui Jie.DeepFM and convolutional neural networks ensembles for multimodal rumor detection[J].Computer Science,2022,49(1):101-107.)

[5]Wu Yang,Zhan Pengwei,Zhang Yunjian,et al.Multimodal fusion with co-attention networks for fake news detection[C]//Findings of the Association for Computational Linguistics.Stroudsburg,PA:Association for Computational Linguistics,2021:2560-2569.

[6]任澤裕,王振超,柯尊旺,等.多模態數據融合綜述[J].計算機工程與應用,2021,57(18):49-64.(Ren Zeyu,Wang Zhenchao,Ke Zunwang,et al.Survey of multimodal data fusion[J].Computer Engineering and Applications,2021,57(18):49-64.)

[7]何俊,張彩慶,李小珍,等.面向深度學習的多模態融合技術研究綜述[J].計算機工程,2020,46(5):1-11.(He Jun,Zhang Caiqing,Li Xiaozhen,et al.Survey of research on multimodal fusion technology for deep learning[J].Computer Engineering,2020,46(5):1-11.)

[8]Wang Min,Cao Ddonglin,Li Lingxiao,et al.Microblog sentiment analysis based on cross-media bag-of-words model[C]//Proc of International Conference on Internet Multimedia Computing and Service.New York:ACM Press,2014:76-80.

[9]劉繼明,張培翔,劉穎,等.多模態的情感分析技術綜述[J].計算機科學與探索,2021,15(7):1165-1182.(Liu Jiming,Zhang Peixiang,Liu Ying,et al.Summary of multi-modal sentiment analysis technology[J].Journal of Frontiers of Computer Science & Technology,2021,15(7):1165-1182.)

[10]Borth D,Ji Rongrong,Chen Tao,et al.Large-scale visual sentiment ontology and detectors using adjective noun pairs[C]//Proc of the 21st ACM International Conference on Multimedia.New York:ACM Press,2013:223-232.

[11]Cai Guoyong,Xia Binbin.Convolutional neural networks for multimedia sentiment analysis[C]//Proc of the 4th CCF International Conference on Natural Language Processing and Chinese Computing.Cham:Springer,159-167.

[12]Yu Yuhai,Lin Hongfei,Meng Jiana,et al.Visual and textual sentiment analysis of a microblog using deep convolutional neural networks[J].Algorithms,2016,9(2):https://doi.org/10.3390/a9020041.

[13]Zadeh A,Zellers R,Pincus E,et al.Multimodal sentiment intensity analysis in videos:Facial gestures and verbal messages[J].IEEE Intelligent Systems,2016,31(6):82-88.

[14]Niu Zhaoyang,Zhong Guoqiang,Yu Hui.A review on the attention mechanism of deep learning[J].Neurocomputing,2021,452(9):48-62.

[15]Vaswani A,Shazeer N,Parmar N,et al.Attention is all you need[C]//Proc of the 31st International Conference on Neural Information Processing Systems.Red Hook,NY:Curran Associates Inc,2017:6000-6010.

[16]Nan Xu,Mao Wenji.Multisentinet:a deep semantic network for multimodal sentiment analysis[C]//Proc of ACM on Conference on Information and Knowledge Management.New York:ACM Press,2017:2399-2402.

[17]郭可心,張宇翔.基于多層次空間注意力的圖文評論情感分析方法[J].計算機應用,2021,41(10):2835-2841.(Guo Kexin,Zhang Yuxiang.Visual-textual sentiment analysis method based on multi-level spatial attention[J].Journal of Computer Applications,2021,41(10):2835-2841.)

[18]劉琦瑋,李俊,顧蓓蓓,等.TSAIE:圖像增強文本的多模態情感分析模型[J].數據與計算發展前沿,2022,4(3):131-140.(Liu Qiwei,Li Jun,Gu Beibei,et al.TSAIE:text sentiment analysis model based on image enhancement[J].Frontiers of Data & Domputing,2022,4(3):131-140.)

[19]Zadeh A,Chen Minghai,Poria S,et al.Tensor fusion network for multimodal sentiment analysis[EB/OL].(2017-07-23).https://arxiv.org/abs/1707.07250.

[20]Ghosal D,Akhtar M S,Chauhan D,et al.Contextual inter-modal attention for multi-modal sentiment analysis[C]//Proc of Conference on Empirical Methods in Natural Language Processing.Stroudsburg,PA:Association for Computational Linguistics,2018:3454-3466.

[21]Xu Nan,Mao Wenji,Chen Guandan.A Co-Memory network for multimodal sentiment analysis[C]//Proc of the 41st International ACM SIGIR Conference on Research & Development in Information Retrieval.New York:ACM Press,2018:929-932.

[22]Zhang Kang,Geng Yushui,Zhao Jing,et al.Sentiment analysis of social media via multimodal feature fusion[J].Symmetry,2020,12(12):https://doi.org/10.3390/sym12122010.

[23]Devlin J,Chang M W,Lee K,et al.BERT:pre-training of deep bidirectional transformers for language understanding[C]//Proc of Conference of the North American Chapter of the Association for Computational Linguistics:Human Language Technologies.Stroudsburg,PA:Association for Computational Linguistics,2019:4171-4186.

[24]Dosovitskiy A,Beyer L,Kolesnikov A,et al.An image is worth 16x16 words:transformers for image recognition at scale[EB/OL].(2021-06-03).https://arxiv.org/abs/2010.11929.

[25]Niu Teng,Zhu Shiai,Pang Lei,et al.Sentiment analysis on multi-view social data[C]//Proc of the 22nd International Conference on Multimedia Modeling.Cham:Springer,2016:15-27.

收稿日期:2023-02-06;

修回日期:2023-04-06

基金項目:國家自然科學基金資助項目(62266004)

作者簡介:蔡宇揚(1998-),男,貴州遵義人,碩士研究生,主要研究方向為多模態情感分析;蒙祖強(1974-),男(通信作者),廣西河池人,教授,博導,博士,主要研究方向為跨媒體智能、多模態情感分析、粒計算(zqmeng@126.com).