具有方面項和上下文表示的方面情感分析

徐丹,龔紅仿,羅容容

具有方面項和上下文表示的方面情感分析

徐丹,龔紅仿*,羅容容

(長沙理工大學 數學與統計學院,長沙 410114)( ? 通信作者電子郵箱ghongfang@126.com)

針對預測特定方面情感極性時存在只依賴單一方面項而忽略了同一句子中方面項之間間情感依賴關系的問題,提出一種具有方面項和上下文表示的多層多跳記憶網絡(AICR-M3net)。首先,通過雙向門控循環單元(Bi-GRU)融合位置加權信息,并將隱藏層輸出作為混合上下文編碼層的輸入以獲取與上下文語義關聯度更高的上下文表示;其次,引入多層多跳記憶網絡(M3net)多次逐詞匹配方面詞和上下文,從而生成特定上下文的方面詞向量;同時,建模特定方面項與句子中其他方面項的情感依賴性,從而引導特定方面項的上下文向量的生成。在Restaurant、Laptop和Twitter數據集上的實驗結果表明,與AOA-MultiACIA (Attention-Over-Attention Multi-layer Aspect-Context Interactive Attention)相比,所提模型的分類準確率分別提高了1.34、3.05和2.02個百分點,F1值分別提高了3.90、3.78和2.94個百分點。以上驗證了所提模型能更有效地處理上下文中多方面的混合信息,且在處理特定方面情感分類任務中具有一定的優勢。

特定方面情感分析;情感依賴;記憶網絡;多頭注意力機制;門控循環單元

0 引言

情感分類是自然語言處理中一項重要的任務,主要分析用戶對產品或者事件的評論的情感極性。與傳統的對評論句子或者文段的情感分類不同,針對特定方面的情感分類是情感分類的分支,它捕獲給定評論句子或者上下文中特定方面的情感極性,是一種更加細粒度的分析。例如句子“Everything is so easy to use, Mac software is just so much simpler than Microsoft software”,分別對目標詞“use”和“Microsoft software”表達了積極和消極的情感。

特定方面情感分析的關鍵挑戰是如何設計有效的算法建模方面與它相對應的意見詞部分,在同一個句子中可能存在多個方面詞,在判斷每個方面詞的情感極性時只需要上下文中的部分內容。例如句子“The restaurant is good but the service is terrible”,“good”能確定方面詞“restaurant”的情感極性為積極,不影響判斷方面項“service”的情感極性。因此,精準建模上下文和方面詞之間的語義具有挑戰性[1]。以往的研究集中通過注意力機制學習特定方面的上下文表示,相關模型也取得了較好的效果,但是仍然沒有有效提取目標特定的情緒信息,模型在判斷的過程中也可能定位到不正確的目標特征。

因此,作為一種替代方法,文獻[2]中提出的AOA(Attention-over-Attention)模型讓上下文和方面項分別參與對方的特征生成,相較于只使用注意力機制的模型,進一步提高了性能。文獻[3]中提出了一種交互式注意網絡(Interactive Attention Network, IAN)交互式學習上下文和目標的注意,并分別生成目標和上下文的表示。在該網絡中,交互注意力機制在從給定方面詞的上下文中選擇性地提取目標相關的情感信息,起著至關重要的作用;然而該模型的信息交互方法是粗粒度的,分別使用上下文和方面詞隱藏層輸出的向量平均后作為查詢向量,生成方面詞和上下文的表示,這種方法會造成一定的信息損失。

受問答系統中記憶網絡(Memory Network, MN)[4]的啟發,文獻[5]中將外部記憶網絡引入神經系統。文獻[6]中提出了一種深度記憶網絡(deep Memory Network, MemNet)用于特定方面的情感分類,該模型通過多個計算層明確捕獲每個上下文的重要性,取得了和支持向量機(Support Vector Machine, SVM)性能相當的結果。文獻[7]中引入門控循環單元(Gated Recurrent Unit, GRU)作為深度記憶網絡的門控機制,將注意力結果與遞歸神經網絡非線性結合,提高了模型處理復雜語境的能力。文獻[8]中針對傳統MN僅依賴于注意力機制不能很好地檢測給定目標的情緒特征的問題,提出了一種目標敏感記憶網絡(Target-sensitive Memory Network, TMN),以捕獲目標敏感情緒。為了利用相關句法約束和單詞長距離依賴性,文獻[9]中在依賴樹上構建一個圖卷積網絡(Graph Convolutional Network, GCN),再結合注意力機制提取最終用于分類的特征。文獻[10]中考慮了具有邊緣約束的不同類型的鄰域,更有效地學習方面和目標表示,用于具有交互注意力的方面情感分類。文獻[11]中使用一系列卷積神經網絡(Convolution Neural Network, CNN)從句子中捕獲多尺度信息,通過GCN和注意力機制將方面信息合并用于情感分析。文獻[12]中首先利用GCN提取句法依存樹上的句法信息,其次通過交互式學習生成上下文和方面表示。文獻[13]中考慮到了依賴項標簽信息,集成類型化句法依賴信息提出了一種關系圖注意網絡(Relational Graph ATtention network, RGAT),實驗結果證明有效利用標簽信息能提高目標情感分類性能。

上述預測模型通過捕獲上下文和方面項的相互作用提取對情感分析有效的特征,但是忽略了同一句話中特定方面項和其他方面項的情感依存關系。本文認為,方面項之間的情感依賴有助于生成更精確的特定方面項的句子特征表示,因此要建立一個有效的記憶網絡用于方面情感分類需要考慮以下幾點:

1)方面項之間的情感依賴信息有助于生成更精確的句子特征表示。例如在句子“The best thing about this laptop is the price along with some of the newer features”中,方面項“newer features”沒有明顯修飾的情感詞,但是通過鄰近方面項“price”積極的情感極性和“along with”表達的并列關系可以得知它的情感極性是積極的。

2)與上下文相同,部分目標詞中也包含多個詞語,每個詞語在生成最終目標詞的表示時貢獻不同,因此需要計算各個詞語的重要度以捕獲相關信息。例如方面詞“cooling system”中,“system”在方面詞的角色更關鍵。

3)考慮到位置信息在方面項和上下文語境之間的作用,直覺上越接近方面項的詞語對判斷方面的情感貢獻越大。

基于以往研究的不足,本文提出一種具有方面項和上下文表示的多層多跳記憶網絡(Multi-layer Multi-hop Memory network with Aspect Item and Context Representation, AICR-M3net),用于方面情感分析。

本文的主要工作如下:

1)提出AICR-M3net用于方面情感分類。通過多次提取方面項之間的情感依賴信息用于合成特定方面項的情感分類特征向量,并通過GRU剔除冗余信息,保留對情感分類有用的特征用于下一個計算層的更新。

2)對方面項單獨建模,逐詞匹配方面詞和上下文,生成特定的方面詞向量。

3)考慮上下文關于特定方面項的位置信息的有效性,通過對雙向門控循環單元(Bi-directional GRU, Bi-GRU)融合位置特征,獲得上下文和方面項向量表示。

1 模型架構

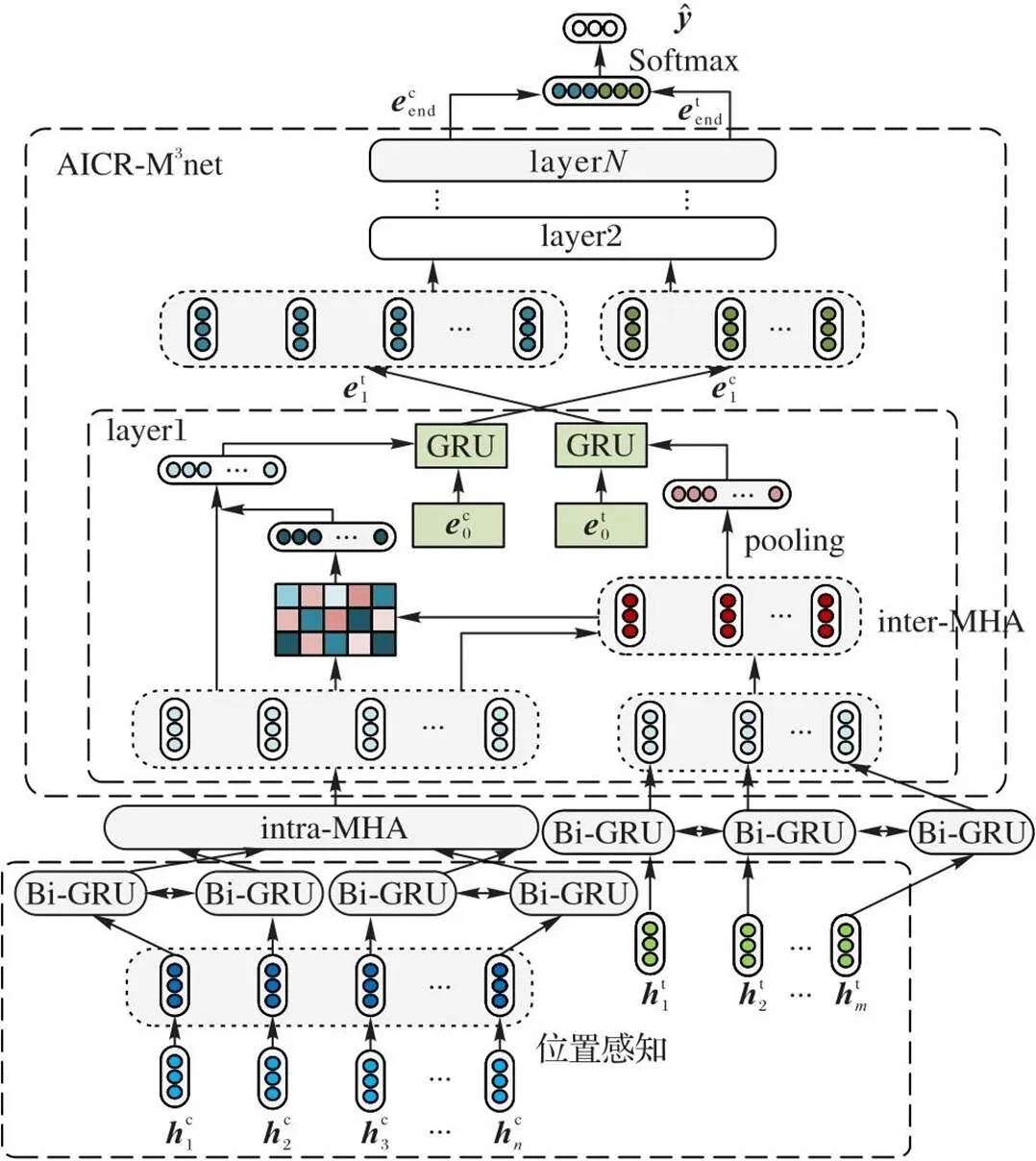

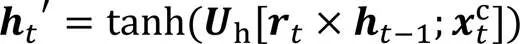

AICR-M3net的模型架構如圖1所示。模型包含4個部分:嵌入層、混合上下文編碼層、多層多跳記憶層和輸出層,其中:嵌入層生成位置感知的字向量表示;混合上下文編碼層獲得與句子語義更相關的特征表示,以涵蓋單詞之間的長距離依賴;多層多跳記憶層對給定方面和句子中其他方面依賴關系建模,分別生成更準確的上下文和方面詞向量,用于情感分類。

圖1 AICR-M3net模型框架

1.1 任務定義

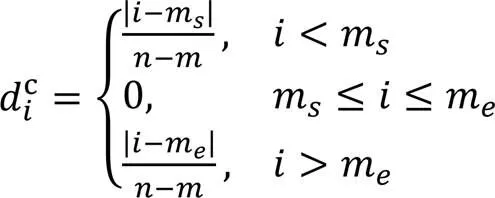

1.2 位置感知的嵌入層

模型的嵌入層由位置加權和Bi-GRU兩部分組成。獲得句子和方面項對應的詞向量表示后進行位置加權,再通過Bi-GRU融合位置特征,獲得上下文和方面項向量表示。

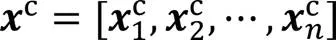

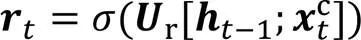

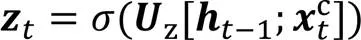

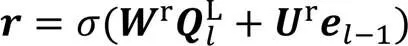

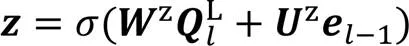

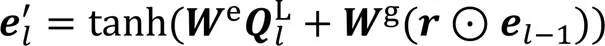

為了融合位置信息,獲得整個模型的輸入詞向量,本文模型使用Bi-GRU網絡,GRU通過重置門和更新門控制輸入和輸出,利用門控機制讓模型學習當前時刻的依賴關系,時刻重置門和更新門的計算公式為:

1.3 混合上下文編碼層

混合上下文編碼層的主要目的是捕獲語義特征,生成新的單詞向量用于方面間情感依賴關系建模。本文采用多頭注意力(Multi-Head Attention, MHA)機制生成上下文的語義編碼[15]。內部多頭注意力(intra-MHA)機制是MHA中一種特殊情況,通過多通道機制可以在訓練的過程中學習前文與自身、后文與自身的依賴關系和自身內部關系。

具體地,

1.4 多層多跳記憶網絡

為了準確預測目標方面詞的情感極性,需要獲得更準確的上下文表示。受文獻[16]啟發,考慮到同一句話中不同的方面詞的情感具有的依賴性,將多層多跳記憶網絡(Multi-layer Multi-hop Memory Network, M3net)用于建模特定方面項與其他方面項間的依賴關系。本文所闡述的“多跳”指在單個計算層中包含兩個計算步驟:一是生成問題向量表示,二是捕捉方面項之間的情感依賴生成上下文表示。

選取一個句子中的特定方面項輸入MN,首先需要生成方面項單個詞匯特定的特征表示。方面詞與上下文相同,也可以由多個詞語組成,每個詞對它生成的最終表示貢獻不同,將它們均值化后作為方面項的特征表示不合適;因此考慮逐詞匹配方面詞和上下文,生成特定的方面詞向量,即問題向量,用于在上下文特征中計算特定方面項與句子中其他方面項情感依賴的相關信息,生成更準確的上下文特征表示。M3net是單層網絡的疊加,每個計算層使用兩個GRU作為門控機制分別重置更新上下文到方面的注意信息和方面項之間的注意信息。單層訓練過程如下:

其中pooling為平均池化函數。

3)M3net更新。單層MN可能無法充分提取情感依賴信息,因此本文將多個計算層疊加,每一層得到比上一層更精確的上下文和方面詞表示。MN的更新分為兩個部分:

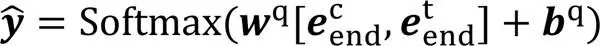

1.5 情感分類和模型訓練

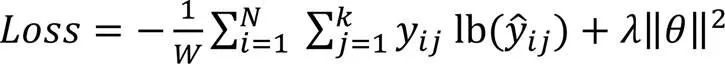

在模型訓練的過程中,引入L2正則化機制,通過最小化交叉熵函數優化模型參數,目標函數的定義如下:

2 實驗與結果分析

2.1 數據集

本文使用Twitter數據集[17],以及SemEval 2014任務4中提供的用于方面情感分析的評論公開數據集[18]:Laptop數據集和Restaurant數據集,3個數據集的統計結果如表1所示。

表1 數據集詳情

2.2 實驗設置和參數指標

在本文實驗中,使用預訓練的BERT初始化詞向量,維度為768,隱藏層的維度設置為300。模型的所有權重使用均勻分布初始化。注意力的頭數、GCN層和深度交互層是本文實驗的重要參數,采用網格搜索的方式調整這3個參數。模型的主要參數值見表2。此外設置早停機制,如果模型連續5輪訓練性能沒有提高,將自動停止訓練并保留最佳模型。本文的句法依存樹由開源工具Spacy的依存解析器生成。本文采用準確率(ACCuracy,ACC)和Macro-F1(F1)評估針對特定方面情感分類模型的性能。

表2 每個數據集的主要參數值

2.3 對比的基準模型

為了評估本文模型的性能,選擇了以下前沿模型作為基準模型:

1)長短時記憶(Long Short-Term Memory, LSTM)網絡[17]。使用單一模型LSTM的隱藏層的輸出進行情感分類。

2)目標相關的長短時記憶(Target-Dependent LSTM, TD-LSTM)網絡[1]。將句子以方面詞為界分為左右兩個部分,分別輸入LSTM,將左上下文和右上下文的隱藏狀態轉移到目標以獲得情感信息。

3)基于注意的方面嵌入的長短時記憶(ATtention-based LSTM with Aspect Embedding, ATAE-LSTM)網絡[19]。為了更好地捕獲方面信息,將方面詞嵌入向量和上下文嵌入向量拼接后輸入LSTM,得到的隱藏層輸出結合注意力機制捕獲方面詞和上下文的依賴信息進行情感分類。

4)深度交互式記憶網絡(Deep Interactive Memory Network, DIMN)[20]。基于注意力和特殊門控機制構建了一個深度交互記憶網絡,以捕獲目標和上下文的多個交互,為目標和上下文生成特定的記憶,有助于情感分類。

5)注意力編碼網絡(Attentional Encoder Network, AEN)[15]。針對循環神經網絡(Recurrent Neural Network, RNN)難以并行化的問題,設計了一種基于多頭注意力編碼的網絡在上下文和方面詞之間建模。

6)IAN[3]。基于LSTM和注意力機制的交互式注意力網絡。利用與目標相關聯的注意力機制從上下文中提取重要信息,生成上下文表示;同理,利用上下文與目標的交互信息監督目標的生成,拼接向量后用于情感分類。

7)具有語義依賴和上下文矩的深度掩碼記憶網絡(Deep Mask Memory Network with Semantic Dependency and Context Moment, DMMN-SDCM)[21]。一種具有語義依賴和上下文時刻的深度掩碼記憶網絡。將方面的語義解析信息和方面間的相關信息集成在記憶網絡中,引用語義解析信息代替傳統的位置信息引導注意力機制,同時有效學習其他非目標方面提供的信息。

8)AOA-MultiACIA(Attention-Over-Attention Multi-layer Aspect-Context Interactive Attention)[22]。一種上下文和方面詞的深層交互模型,僅依賴注意力機制在上下文中捕獲特定方面相關特征,合成更精確的方面詞表示。

9)具有位置感知的分層門控深度記憶網絡(Hierarchical Gated Deep Memory network with Position-Aware, HGDM-PA)[23]。提出了細粒度信息交互機制,對方面詞和上下文之間的詞級交互建模,并且將位置信息作為特征嵌入句子的表示中,從而獲得句子和方面詞的特征表示。

實驗結果如表3所示。可以看出,本文模型在3個數據集上的方面情感分類結果均為最優,在Restaurant、Laptop和Twitter數據集上,比AOA-MultiACIA的分類準確率分別提升了1.34、3.05和2.02個百分點,F1分別提升了3.90、3.78和2.94個百分點。結果表明對方面短語單獨建模并利用其他非目標方面的情感依賴信息,對特定方面的情感分類的準確率的提高有一定作用。

傳統的LSTM、TD-LSTM模型僅粗粒度學習上下文的語義關系,對方面項前后的上下文賦予的權重一致,無法考慮到上下文中方面詞的信息。一般地,基于注意力的模型優于基于LSTM的模型,ATAE-LSTM在方面詞的監督下,使用單個注意力對句子和目標建模,在Restaurant和Laptop數據集上,相較于LSTM和TD-LSTM,分類準確率分別提升了1.70~2.92和1.00~2.25個百分點。由于數據集中可能出現多個方面項,因此考慮到方面項和上下文交互作用的AOA-MultiACIA、AEN、IAN模型在3個基準數據集上的表現均優于基于單個注意力機制的ATAE-LSTM模型。而本文模型基于M3net,實質是多重注意網絡,相較于ATAE-LSTM,在3個數據集上的分類準確率分別提升了6.73、9.62和5.02個百分點。說明基于方面項引導注意力機制對捕獲方面項相關的情感特征是有效的。

在Restaurant和Laptop數據集上,本文模型相較于性能較好的HGDM-PA的分類準確率分別提升了1.98和3.50個百分點。HGDM-PA和本文模型都使用記憶網絡,區別是本文的記憶網絡在殘差連接的基礎上對每一個計算層外部記憶和查詢特征向量更新,經過多個計算層,每一層都利用特定方面項和句子中其他方面的情感信息合成更精確的特定方面的上下文表示。DMMN-SDCM在深度掩碼記憶網絡中有效學習其他非目標方面提供的信息,在Laptop數據集上分類準確率僅次于本文模型。本文模型同樣使用一個句子中特定方面項和其他方面項的依賴關系對上下文建模,比其他基準模型的分類準確率高。

表3 不同數據集上的方面情感分類實驗結果 單位:%

2.3.1模型消融分析

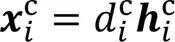

為了驗證AICR-M3net各個子模塊對模型性能的影響,本文對模型進行了消融,分別在Restaurant、Laptop和Twitter數據集上進行實驗,結果見圖2。

從圖2可以看出,消融后的模型在3個數據集上的分類準確率和F1評估指標都不如原始模型,表明,被消融的子模塊對提高模型性能至關重要。首先,混合上下文編碼前取消對句子表示的位置編碼(AICR-M3net w/o POS),在3個數據集上的準確率和F1均有一定的下降,表明接近特定方面項的詞語對最終的情感分析預測有一定的作用。其次,用Bi-GRU代替方面項單獨建模(AICR-M3net w/o A),在3個數據集上的分類準確率也有一定程度的下降。最后,取消使用方面間情感依賴引導特定方面項的上下文生成(AICR-M3net w/o IA),相較于前兩次消融,模型的效果進一步下降,表明建模特定方面項與句子中其他方面項情感依賴性對最終的情感分類起著關鍵作用。

圖2 移除關鍵模塊對準確率和F1值的影響

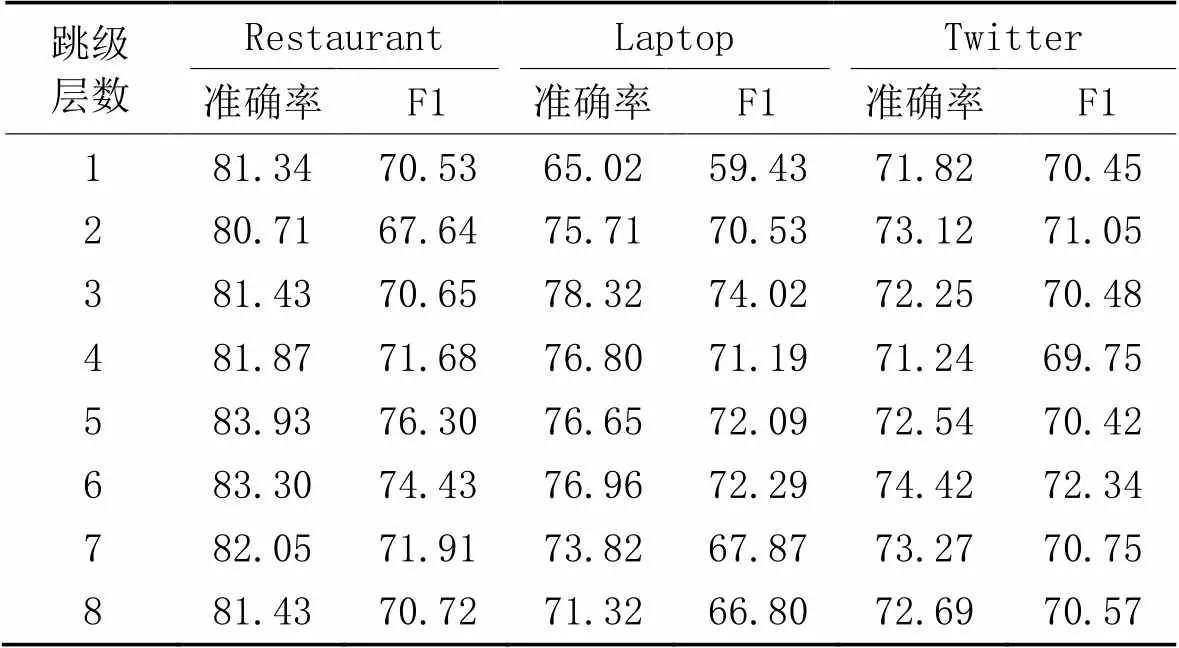

2.3.2記憶網絡的層數對性能的影響

為了驗證多重多跳記憶網絡的層數對模型性能的影響,在Restaurant、Laptop和Twitter數據集上設置層數從1到8進行實驗,以準確率和F1為評價指標,得到在不同層數下,AICR-M3net在3個數據集上的方面情感分類的準確率和F1值,結果如表4所示。

表4 M3net層數對準確率和F1值的影響 單位:%

從表4可以看出,多個計算層對模型情感分類能力的提升是有效的。在Restaurant數據集上,設置多重多跳記憶網絡的層數為5時,準確率和F1都最高;在Laptop數據集上設置層數為3時,模型達到最佳性能;在Twitter數據集上,當記憶網絡計算層為6時,準確率和F1最高。因此,在設置模型的超參數時,在Restaurant、Laptop和Twitter數據集上分別設置層數為5、3、6。這說明具有不同層數記憶網絡的模型的分類性能不同,表明AICR-M3net對特定目標和其他非特定目標項的情感依賴信息進行了有效的建模,生成了與特定目標更相關的上下文特征向量表示。當跳級數大于5時,模型在3個公開數據集上的性能開始下降,這是因為隨著層數增多,模型參數也增多,出現過擬合現象,因此設置合適的參數有助于分類性能的提高。

2.4 模型泛化能力實驗

利用本文模型和基準模型IAN[15]、ATBL-MHMN[15]模型進行分類性能的對比分析,以此研究本文模型的泛化能力。將樣本數據集Restaurant和Laptop根據評論句子中含有單個方面或多個方面進行分類形成4個數據集,分別為Restaurant單方面、Restaurant多方面、Laptop單方面和Laptop多方面。分別在這4個數據集上展開實驗,得到各個模型在單方面和多方面數據集上情感分類的結果,如表5所示。

表5 在單方面和多方面數據集上的情感分類準確率 單位:%

由表5可知,本文模型在2個單方面數據集上的情感分類準確率比IAN模型提高了7.20個百分點和4.90個百分點,由此可見本文模型對于只含有一個方面項的評論句子進行情感分類時性能有所提升。本文模型在2個多方面數據集上的分類準確率比IAN模型提高了5.80個百分點和6.50個百分點,比ATBL-MHMN模型提高了3.02個百分點和4.00個百分點。由于單個句子中方面項的個數增加,導致單個句子中情感信息增多,IAN模型在區分特定方面項對應的情感信息上優勢減弱,故分類準確率降低。ATBL-MHMN模型在Bi-LSTM的基礎上,使用了端到端記憶網絡,一定程度上提高了模型的分類性能。本文模型除了引入方面項的位置信息外,將GRU融入記憶網絡中剔除冗余信息,分別生成方面項和特定方面項句子的上下文表示,多次提取特定方面項的情感依賴信息,同時對方面項進行單獨建模。根據以上分析,本文模型能很好地處理多方面評論句子的情感極性分類,泛化能力較強。

3 結語

本文通過Bi-GRU融合上下文中每個詞的位置權重,用多頭注意力機制得到句子的語義編碼,使用改進的多層記憶網絡捕獲方面項之間的情感依賴關系,生成特定上下文的方面項表示和特定方面項的上下文表示,以確定特定方面項在句子中的情感極性。在3個公開數據集上的實驗結果表明,本文模型能夠有效處理上下文中的方面混合信息,可以構建與特定方面項更相關的情感特征向量。未來將進一步完善模型,提高模型的語義識別能力,以更好地分析一些不符合語法的句子,進一步擴大模型的應用范圍。

[1] TANG D, QIN B, FENG X, et al. Effective LSTMs for target-dependent sentiment classification[C]// Proceedings of the 26th International Conference on Computational Linguistics: Technical Papers. [S.l.]: The COLING 2016 Organizing Committee, 2016: 3298-3307.

[2] HUANG B, OU Y, CARLEY K M. Aspect level sentiment classification with attention-over-attention neural networks[C]// Proceedings of the 2018 International Conference on Social Computing, Behavioral-Cultural Modeling and Prediction and Behavior Representation in Modeling and Simulation, LNCS 10899. Cham: Springer, 2018: 197-206.

[3] MA D, LI S, ZHANG X, et al. Interactive attention networks for aspect-level sentiment classification[C]// Proceedings of the 26th International Joint Conference on Artificial Intelligence. California: ijcai.org, 2017: 4068-4074.

[4] WESTON J, CHOPRA S, BORDES A. Memory networks[EB/OL]. (2015-11-29) [2022-04-13].https://arxiv.org/pdf/1410.3916.pdf.

[5] SUKHBAATAR S, SZLAM A, WESTON J, et al. End-to-end memory networks[C]// Proceedings of the 28th International Conference on Neural Information Processing Systems — Volume 2. Cambridge: MIT Press, 2015: 2440-2448.

[6] TANG D, QIN B, LIU T. Aspect level sentiment classification with deep memory network[C]// Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2016: 214-224.

[7] CHEN P, SUN Z, BING L, et al. Recurrent attention network on memory for aspect sentiment analysis[C]// Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2017: 452-461.

[8] WANG S, MAZUMDER S, LIU B, et al. Target-sensitive memory networks for aspect sentiment classification[C]// Proceedings of the 56th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers). Stroudsburg, PA: ACL, 2018: 957-967.

[9] ZHANG C, LI Q, SONG D. Aspect-based sentiment classification with aspect-specific graph convolutional networks[C]// Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing. Stroudsburg, PA: ACL, 2019: 4568-4578.

[10] XIAO Y, ZHOU G. Syntactic edge-enhanced graph convolutional networks for aspect-level sentiment classification with interactive attention[J]. IEEE Access, 2020, 8: 157068-157080.

[11] ZHA Y, XIE Y, HUANG Q, et al. Aspect level sentiment classification with multi-scale information[C]// Proceedings of the 2nd International Conference on Electronics, Communications and Information Technology. Piscataway: IEEE, 2021: 279-285.

[12] HAN H, QIN X, ZHAO Q. Interactive attention graph convolution networks for aspect-level sentiment classification[C]// Proceedings of the 3rd International Conference on Artificial Intelligence and Advanced Manufacture. Piscataway: IEEE, 2021: 271-275.

[13] BAI X, LIU P, ZHANG Y. Investigating typed syntactic dependencies for targeted sentiment classification using graph attention neural network[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2021, 29: 503-514.

[14] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Piscataway: IEEE, 2016: 770-778.

[15] SONG Y, WANG J, JIANG T, et al. Attentional encoder network for targeted sentiment classification[EB/OL]. (2019-04-01) [2022-07-05].https://arxiv.org/pdf/1902.09314.pdf.

[16] 盧天蘭,陳荔. 面向方面級別情感分析的端到端多跳記憶網絡[J]. 計算機應用研究, 2021, 38(5): 1409-1415, 1427.(LU T L, CHEN L. End-to-end multi-hop memory network for aspect-level sentiment analysis[J]. Application Research of Computers, 2021, 38(5): 1409-1415, 1427.)

[17] DONG L, WEI F, TAN C, et al. Adaptive recursive neural network for target-dependent Twitter sentiment classification[C]// Proceedings of the 52nd Annual Meeting of the Association for Computational Linguistics (Volume 2: Short Papers). Stroudsburg, PA: ACL, 2014: 49-54.

[18] PONTIKI M, GALANIS D, PAVLOPOULOS J, et al. SemEval-2014 Task 4: aspect based sentiment analysis[C]// Proceedings of the 8th International Workshop on Semantic Evaluation. Stroudsburg, PA: ACL, 2014:27-35.

[19] WANG Y, HUANG M, ZHU X, et al. Attention-based LSTM for aspect-level sentiment classification[C]// Proceedings of the 2016 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2016: 606-615.

[20] SUN C, LV L, TIAN G, et al. Deep interactive memory network for aspect-level sentiment analysis[J]. ACM Transactions on Asian and Low-Resource Language Information Processing, 2021, 20(1): No.3.

[21] LIN P, YANG M, LAI J. Deep mask memory network with semantic dependency and context moment for aspect level sentiment classification[C]// Proceedings of the 28th International Joint Conference on Artificial Intelligence. California: ijcai.org, 2019: 5088-5094.

[22] WU Z, LI Y, LIAO J, et al. Aspect-context interactive attention representation for aspect-level sentiment classification[J]. IEEE Access, 2020, 8: 29238-29248.

[23] JIA Z, BAI X, PANG S. Hierarchical gated deep memory network with position-aware for aspect-based sentiment analysis[J]. IEEE Access, 2020, 8: 136340-136347.

Aspect sentiment analysis with aspect item and context representation

XU Dan, GONG Hongfang*, LUO Rongrong

(,,410114,)

When predicting the emotional polarity of a specific aspect, there is a problem of only depending on a single aspect item and ignoring the emotional dependence between aspect items in the same sentence, a Multi-layer Multi-hop Memory network with Aspect Item and Context Representation (AICR-M3net) was proposed. Firstly, the position weighting information was fused by Bi-directional Gated Recurrent Unit (Bi-GRU), and the hidden layer output was used as the input of the mixed context coding layer to obtain a context representation with higher semantic relevance to the context. Then, Multi-layer Multi-hop Memory Networks (M3net) was introduced to match aspect words and context many times and word by word to generate aspect word vectors of specific context. At the same time, the emotional dependence between specific aspect item and other aspect items in the sentence was modeled to guide the generation of context vector of specific aspect item. Experimental results on Restaurant, Laptop and Twitter datasets show that the proposed model has the classification accuracy improved by 1.34, 3.05 and 2.02 percentage points respectively, and the F1 score increased by 3.90, 3.78 and 2.94 percentage points respectively, compared with AOA-MultiACIA (Attention-Over-Attention Multi-layer Aspect-Context Interactive Attention). The above verifies that the proposed model can deal with the mixed information with multiple aspects in context more effectively, and has certain advantages in dealing with the sentiment classification task in specific aspects.

aspect-specific sentiment analysis; emotional dependence; Memory Network (MN); Multi-Head Attention (MHA) mechanism; Gated Recurrent Unit (GRU)

This work is partially supported by National Natural Science Foundation of China (61972055), Natural Science Foundation of Hunan Province (2021JJ30734).

XU Dan, born in 1997, M. S. candidate. Her research interests include natural language processing, sentiment analysis.

GONG Hongfang, born in 1968, Ph. D., professor. His research interests include machine learning, intelligent information processing, queuing theory and its applications.

LUO Rongrong, born in 1997, M. S. candidate. Her research interests include natural language processing, sentiment analysis.

1001-9081(2023)10-3086-07

10.11772/j.issn.1001-9081.2022101482

2022?10?11;

2023?04?04;

國家自然科學基金資助項目(61972055);湖南省自然科學基金資助項目(2021JJ30734)。

徐丹(1997—),女,湖南婁底人,碩士研究生,主要研究方向:自然語言處理、情感分析; 龔紅仿(1968—),男,湖北天門人,教授,博士生導師,博士,CCF會員,主要研究方向:機器學習、智能信息處理、排隊論及應用; 羅容容(1997—),女,湖南邵陽人,碩士研究生,主要研究方向:自然語言處理、情感分析。

TP391.1

A

2023?04?10。