一場關于人工智能風險的爭議

文/本刊記者 余秀

人工智能滅絕人類風險言論在引發了廣泛關注的同時,也引來了質疑的聲音。諸多專家和公眾人物認為,AI 末日論分散了人們對真正重要的實際問題的注意力。

“減輕人工智能帶來的人類滅絕風險,應該與大流行病和核戰爭等其他影響社會的大規模風險一同成為全球性的優先事項。”[1]5 月30 日,這則短短的聲明,出現在美國非營利組織“人工智能安全中心(Center for AI Safety)”的官網上,超過350 名從事人工智能工作的高管、研究人員和工程師在上面簽名。

人工智能對人類的威脅,堪比大流行病和核戰爭,這份簡短聲明旨在鼓勵公開討論 AI 最嚴重的威脅,降低AI 滅絕人類的可能風險。帶頭簽名這份聲明的是深度學習領域的兩位重磅專家杰弗里·辛頓(Geoffrey Hinton)和約書亞·本希奧(Yoshua Bengio)。兩人和楊立昆(Yann LeCun)一起,因在深度學習方面的開創性工作,共同獲得了2018 年圖靈獎(有“計算界的諾貝爾獎”之稱),被稱為“AI教父”或“深度學習教父”。除此以外,目前三大領先的自然語言大模型研究機構的CEO,OpenAI 的山姆·阿爾特曼(Sam Altman)、谷歌DeepMind 的杰米斯·哈薩比斯(Demis Hassabis)和Anthropic的達里奧·阿莫迪(Dario Amodei),也都簽名支持。簽名名單還包括了清華大學智能科學講席教授、智能產業研究院院長張亞勤,中國科學院自動化研究所研究員、中國科學院大學教授曾毅等中國學者。

“減輕人工智能帶來的人類滅絕風險,應該與大流行病和核戰爭等其他影響社會的大規模風險一同成為全球性的優先事項。”

當前對人工智能表示擔憂的聲音已經大到無法忽視。3 月,一封由科技行業專家牽頭的公開信,因為擔憂人工智能可能對“社會和人類構成深遠風險”,呼吁暫停先進人工智能模型的開發。4 月,杰弗里·辛頓從谷歌離職,以便公開討論人工智能技術的危險性。

在6 月的北京智源大會AI 安全與對齊論壇上,山姆·阿爾特曼和杰弗里·辛頓分別作了開場和閉幕演講,強調了人工智能的未來風險,呼吁全球盡早邁出通用人工智能(AGI)治理的第一步。辛頓表示數字式智能群體共享知識的速度遠超人類,當AI 進化到比人類更有智慧的時候,會帶來巨大的風險。“到目前為止,我還想象不到更智能的事物,被一些反倒沒那么智能的事物所控制的例子。我打個比方,假設青蛙創造了人類,那么你認為現在誰會占據主動權,是人,還是青蛙?”[2]

AGI 接管人類

人工智能可能滅絕人類的說法,有一個前提假設,即具備人類級別學習能力的計算機會由于技術優勢而超越人類智能,成為通用人工智能(AGI)。通用人工智能(AGI)的重大進展可能導致人類滅絕或其他一些無法恢復的全球災難,正如大猩猩的命運取決于人類的善意,人類的命運也可能取決于未來超級智能機器。

自阿蘭·圖靈開始,對失控的、自我改進的機器的擔憂由來已久。隨著ChatGPT 等生成式人工智能工具的普遍使用,曾經的極端觀點引起了廣泛關注。2021 年1 月發表在《人工智能研究雜志》的一篇文章,通過計算提出,控制遠超出人類理解能力的超級智能幾乎是不可能的。因為要控制超級智能,我們需要對其進行模擬和分析,但如果我們無法理解它,就無法創建這樣的模擬。當我們不了解人工智能將要提出的場景類型,就無法制定諸如“不對人類造成傷害”之類的規則。[3]

一篇名為“自然選擇偏愛AI,而不是人類(Natural Selection Favors AIs over Humans)”的文章,認為人類和AGI 的前途類似于自然選擇。自然選擇理論中,自私的物種通常在物競天擇中更具優勢。達爾文主義也可以適用于AGI,當AGI 追求自身利益而對人類關注較少時,將會給人類帶來災難。[4]牛津大學人類未來研究所人工智能安全研究員瑞安·凱里(Ryan Carey)表示:“如果人工智能具有某些成分,即超人智能、廣泛的自主權、一些資源和新技術,它可能會對人類的未來構成威脅。”“如果你將少數擁有一些資源和一些現代技術的現代人類置于一個擁有80 億非人類靈長類動物成員的世界中,那可能對該物種的未來構成威脅。”

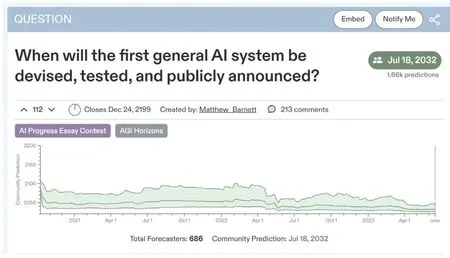

目前,以ChatGPT 為代表的大型語言模型(LLM)還遠不能實現通用人工智能(AGI)。對于人工智能超過人類智能的AGI 什么時候到來的問題,杰弗里·辛頓表示:“這個東西實際上可能比人類更聰明——有一些人相信這一點,……但大多數人認為這還遙遠。而我也認為離那還很遠,可能是30 到50 年甚至更久以后。顯然,我不再持有這樣的觀點了。”在備受推崇的預測平臺Metaculus 上,AGI 的平均預測日期是2032 年。[5]

AI 對齊:回形針制造機

人工智能滅絕人類的風險假說,有令人信服的邏輯。劍橋大學計算與生物學習實驗室的助理教授大衛·克魯格(David Krueger),說明了人工智能接管人類的三個要素:

首先,AI 在優化特定目標時缺乏人類常識,可能發出奇怪和不受歡迎的行為。由于AI“思考”解決問題的方式,AI 處理看似簡單的事情可能會產生無法預測的意想不到的后果。例如,如果有人告訴孩子家里的書本數量與大學錄取有關,他可能不會多讀書給孩子聽,而是開始堆放成箱的書本。即使AI 只能在非常嚴格的規則下運行,異常行為仍然會發生。

第二,AI 在特定任務中的過度優化可能會導致權力尋求行為。當特定任務優化的AI 有一個單一的目標時,它可能會使用其掌握的所有工具來實現該目標。“這種推理循環不會自然結束,”克魯格說,“如果你在做以目標為導向的推理,尤其是當你有一個長期目標時,你自然會最終尋求越來越多的權力和資源。”

第三,人類會主動向AI移交更多的權力。“如果你給系統更多的自主權、更多的權力,或者以更多方式重塑世界的能力,那么它就會更有能力。”克魯格繼續說道,“如果你讓它直接采取影響現實世界或影響數字世界的行動,你將賦予它更多的力量,使其更有能力更高效地實現你的目標。”

將三個要素放在一起可能會導致這樣的結果:人類目標可能與AI 的目標不同。當我們給AI 一個目標時,它可能不是我們的實際目標,這是“AI 對齊”問題。AI 對齊的目標是確保AGI 能夠正確理解人類的意圖,將其行動與人類價值保持一致。[6]

哲學家尼克·博斯特羅姆(Nick Bostrom)在回形針制造機思想實驗中令人印象深刻地捕捉到了這一點。他設想了一個負責制作回形針的人工智能,通過對現實世界系統的充分控制,它可能會采取極端措施,如消耗所有資源和轉化所有物質來制造盡可能多的回形針,從而對人類生存產生威脅。

分歧和質疑:AI末日論轉移了對真正問題的注意

誠然,關于人工智能的未來風險存在分歧。據耶魯大學首席執行官領導力研究所對高管進行的一項調查顯示,42%的受訪者表示人工智能可能在5~10 年內“毀滅人類”,58%的受訪者表示“不擔心”人工智能的生存威脅。[7]

人工智能滅絕人類風險言論在引發了廣泛關注的同時,也引來了質疑的聲音。諸多專家和公眾人物認為,AI 末日論分散了人們對真正重要的實際問題的注意力。Meta 首席AI 科學家、與杰弗里·辛頓和約書亞·本希奧共同獲得2018 年圖靈獎的楊立昆(Yann LeCun)表示,對人工智能未來風險的擔憂“極其荒謬”。計算機變得比人類更聰明,還需要很多年。他認為,那些擔憂的人之所以這樣,是因為他們無法想象如何才能確保人工智能的安全。“這就好像你在1930 年問如何確保渦輪噴氣發動機的安全,1930 年渦輪噴氣發動機還沒有發明,就像人類水平的人工智能還沒有發明一樣……渦輪噴氣式飛機最終變得非常可靠和安全,人工智能同樣如此。”Meta 的人工智能研究副總裁喬爾·皮諾(Joelle Pineau)同意楊立昆的觀點,她表示,對AI 未來風險的極度關注,擠壓了討論當前人工智能的危害的空間。[8]

紐約大學名譽教授加里·馬庫斯(Gary Marcus),于3 月簽署了公開信,與包括埃隆·馬斯克(Elon Musk)在內的1000 多人一起,呼吁全球暫停人工智能開發,但他沒有簽署22 字聲明,他認為AI 的生存威脅被“夸大了”,社會不應該把注意力集中在沒有人幸存的牽強的場景上,而應該把注意力集中在真正的危險所在。人工智能公司Cohere 的首席執行官艾丹·戈麥斯(Aidan Gomez)評價,這是“對我們時間的荒謬利用”。麻省理工學院經濟學教授達倫·阿西莫格魯(Daron Acemoglu)認為,它(AI 滅絕人類的風險)夸大了當前的技術水平,“使我們將注意力從這些新模型可能造成的更普遍的損害上移開,包括錯誤信息、失業、民主威脅等”。

同樣地,Nature 網站上一篇題為“當AI 今天帶來風險時,停止談論明天的AI世界末日(Stop talking about tomorrow’s AI doomsday when AI poses risks today)”的社論文章旗幟鮮明地指出,就像魔術師的花招一樣,人工智能滅絕人類的言論分散了人們對真正問題的注意力,阻礙了對人工智能目前造成的社會危害的有效監管。有關AI 風險和監管的對話默認了由公司高管和技術人員組成的同質群體主導,而將其他社區排除在外。紐約市AI Now 研究所(研究所專注于人工智能的社會影響)所長安巴·卡克(Amba Kak)表示,科技行業領袖撰寫的聲明“本質上是在界定誰才是這場對話中的專家”。

人工智能有許多潛在的好處,從合成數據到協助醫療診斷,可能將在醫療保健、教育和應對氣候危機領域發揮重要的積極作用。但它同時也造成了有據可查的危害,生成和傳播大量錯誤信息,帶有系統偏見,擠壓勞動市場崗位。關于這些明確而現實的問題的討論正處于“缺氧”狀態。政府必須建立適當的法律和監管框架,科技公司必須制定負責任地開發人工智能系統和工具的行業標準,研究人員必須發揮作用,建立負責任的人工智能文化。關于存在風險的危言聳聽的敘述沒有建設性,認真討論實際風險以及遏制風險的行動更重要。“人類越早建立與人工智能的互動規則,我們就能越早學會與技術和諧相處。”[9]