基于深度學習的循環水養殖鰻鱺(Anguilla)行為狀態識別的研究*

許志揚 江興龍 林 茜 李 凱

基于深度學習的循環水養殖鰻鱺()行為狀態識別的研究*

許志揚1, 2江興龍1, 2①林 茜1, 2李 凱1, 2

(1. 集美大學水產學院 福建廈門 361021; 2. 鰻鱺現代產業技術教育部工程研究中心 福建廈門 361021)

對魚類的行為進行智能監測, 精準地量化與識別其健康狀態, 已成為研究熱點。為實現養殖鰻鱺行為狀態精準識別, 提出一種基于DenseNet雙流卷積神經網絡的鰻鱺行為狀態檢測方法。利用混合高斯背景模型進行前景提取構建數據集, 針對傳統卷積神經網絡對于時間動態信息提取能力有限的問題, 搭建關聯空間特征與時間特征的雙流網絡結構(Two-stream), 并使用DenseNet-121網絡替換原網絡, 對比VGGNet、ResNet等網絡, 通過密集連接實現特征重用, 在搭建更深的網絡結構基礎上加強了運動特征傳遞并減少了參數量, 更好地提取具有代表性的行為特征。傳統雙流網絡在兩端的softmax層僅作簡單的決策層平均融合, 無法更深程度關聯時空高級特征, 提出在網絡卷積層提取空間特征與時間特征后, 加上一層卷積層將時空特征進行卷積融合以提升模型識別精度。實驗結果表明: 文中提出的基于DenseNet雙流卷積神經網絡對6種鰻鱺行為狀態檢測方法準確率達到96.8%, 相較于單通道的空間流與時間流網絡, 準確率分別提升了10.1%和9.5%; 相較于以VGGNet、ResNet搭建的雙流網絡, 準確率分別提升了12.4%和4.2%; 與決策層平均融合、特征層拼接融合的方式相比, 時空特征卷積融合方式準確率分別提升了2.5%和1.7%。

鰻鱺; 行為狀態; 混合高斯背景模型; DenseNet-121; 雙流網絡結構; 卷積融合

我國是世界上最大的鰻鱺生產國, 養殖產量穩居世界首位, 鰻鱺因其具有較高的營養價值, 是我國優良水產養殖種類之一(李岑鵬等, 2009)。目前, 在鰻鱺養殖過程中, 對魚類養殖狀態的監測方法多為人工觀察法, 但是人工觀察存在效率低、工作量大, 以及判斷易出錯等缺點。近年來, 隨著科學技術的發展和人工智能技術的不斷革新, 計算機視覺技術已經應用在許多領域里, 為了適應水產養殖業向智能化方向發展的需求, 在水產養殖行業里利用計算機視覺技術進行魚類行為智能監測也逐漸成為一個研究熱點(Niu, 2018; 鄭書康, 2020)。通過計算機視覺技術對其進行非入侵式的行為狀態監測, 在不影響正常養殖的前提下, 高效精準地量化與識別鰻鱺行為, 監測養殖魚類健康狀態, 利用魚類行為表現判斷水體環境是否優良, 對于鰻鱺高效養殖具有重要的現實意義。

國內外學者利用計算機視覺技術, 對水產養殖對象的行為進行特征提取、量化、分析的研究日漸加深。Kato等(1996)開發了以金魚為研究對象的計算機圖像處理系統并進行了模擬分析, 首次對魚群目標進行群體行為檢測, 但該研究只統計金魚的直行、左轉、右轉等簡單特征作為行為分析依據, 無法充分地反映魚類行為狀態。Sadoul等(2014)采集虹鱒魚的圖像數據, 并對其進行灰度化和濾波操作, 通過背景模型獲取虹鱒魚群的周長, 以此來計算分散程度并描述其游泳行為, 但該研究的行為分類特征選擇較為簡單。范良忠等(2011)在分析比較計算機視覺領域常用的目標檢測算法上, 將幀間差分、背景建模和光流估計等方法相互結合提出了3種改進算法, 提升了魚體運動的檢測精度, 但該方法的魯棒性與泛化能力較差。近年來, 深度學習發展迅速, 相較于傳統圖像處理算法, 深度學習網絡不再使用人為定義特征的方法, 而是直接將圖像信息送進神經網絡自動提取其高維抽象語義特征, 進一步挖掘圖像數據的時空信息。沈軍宇等(2018)結合計算機視覺技術與深度學習方法, 提出了一種基于YOLO算法的端到端魚群檢測方法, 對于實時視頻的魚群檢測精度能夠達到90%以上, 但該方法對魚群行為識別能力較弱。李星輝(2021)通過訓練目標檢測模型Faster RCNN對運動魚類進行檢測, 提出軌跡關聯方法提取軌跡數據并對其進行異常軌跡判別, 實現水下魚類異常行為在線監測, 但該方法在魚類密集區域的監測效果較差。

綜上, 將深度學習技術應用在水產養殖業已成為今后智能化水產養殖的重要研究趨勢。本文針對養殖鰻鱺行為監測, 提出一種以DenseNet雙流卷積神經網絡搭建的深度學習改良模型, 實現對養殖鰻鱺行為狀態的精準識別。由于鰻鱺習性喜暗怕光(龔盼, 2015), 一經普通光線照射會產生躲避、逃竄等應激行為, 但紅外光照射對鰻鱺行為無明顯干擾和影響(李凱等, 2022), 因此在拍攝鰻鱺行為圖像時選擇使用紅外相機與紅外補光燈進行圖像采集。本研究為鰻鱺精準化高效養殖提供可量化的數據參考, 有助于及時發現和處理養殖過程中存在的問題, 研究成果可為鰻鱺乃至魚類的精準高效綠色養殖提供有效技術支撐和應用參考。

1 圖像采集系統與構建鰻鱺行為狀態數據集

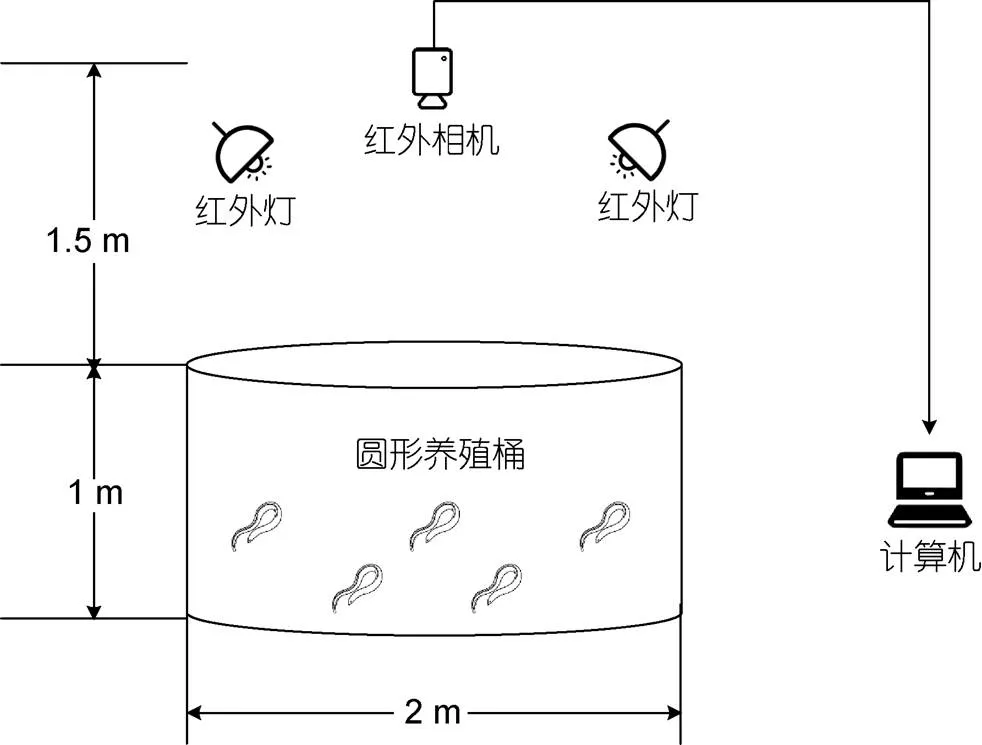

1.1 圖像采集系統

鰻鱺行為圖像數據采集自集美大學水產試驗場的鰻鱺循環水養殖車間。如圖1所示, 將紅外監控攝像機(海康威視Q/BFW 066)安裝于養殖桶正上方1.5 m, 并在養殖桶上方周圍使用紅外燈進行補光。以傾斜的角度設置紅外燈避免燈光直射桶底, 降低水面反射紅外燈光造成的圖像噪聲。相機通過一根5 m長的千兆網線與計算機相連接, 使用H.264編碼的方式存儲圖像數據于計算機硬盤中。采集視頻圖像信息時讓車間處于完全黑暗環境, 減少外界光線變化帶來的影響。視頻采集的幀率均為20幀/s, 位深度8 bits, 分辨率2 560×1 440 (16︰9)。

圖1 圖像采集系統

1.2 構建鰻鱺行為狀態數據集

實驗用魚為取自集美大學水產試驗場自行養殖的澳洲鰻鱺, 每組實驗選取大小均勻、無病無傷的鰻鱺各10尾。在實驗開始前, 提前一周將鰻鱺移入養殖桶內適應環境, 避免產生應激反應。

通過長時間的實驗觀察及篩選, 參考謝富華(2020)對于魚群行為狀態樣本數據庫的建立, 本文確定了6種具有明顯分辨特征的行為狀態作為本文的研究對象, 分別為正常狀態、饑餓狀態、缺氧狀態、高水溫狀態、攝食狀態、受驚擾狀態, 見表1。其中, 攝食狀態及受驚擾狀態可直接進行圖像采集, 取10條體質量(274.4±8.5) g的鰻鱺, 用攝像頭記錄正常狀態下攝食餌料的行為作為攝食狀態數據集, 并記錄通過環境刺激使鰻鱺受驚擾的行為作為受驚擾狀態數據集。但采集饑餓狀態、缺氧狀態、高水溫狀態的行為圖像時, 需確保鰻鱺已處于異常狀態中, 因此先設置不同饑餓天數、不同溶解氧濃度、不同水溫的梯度實驗探究3種異常狀態與正常狀態可區分的臨界點, 并取與正常狀態可區分的異常狀態圖像作為本實驗的訓練數據。

表1 鰻鱺行為狀態分類表

Tab.1 Classification of eel behavior states

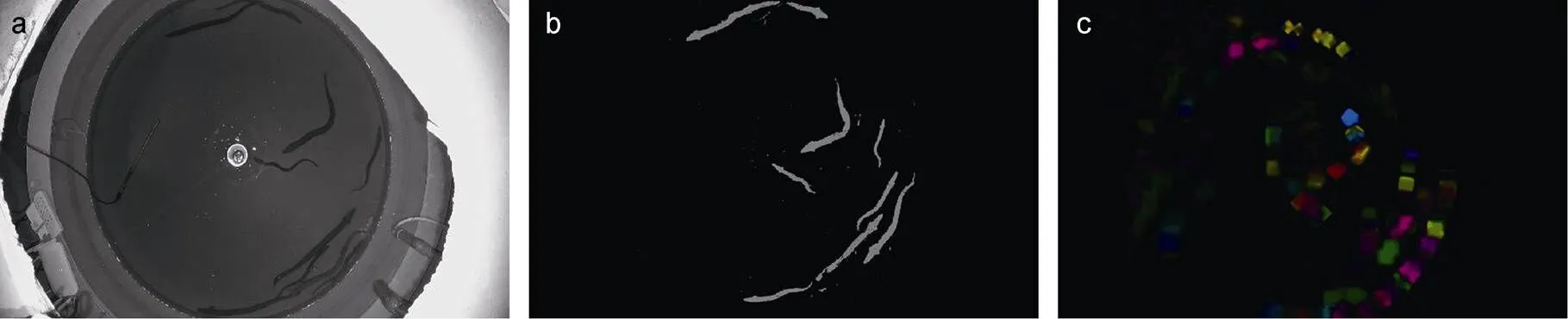

將采集視頻進行逐幀分解。相機采集的原始分辨率較高, 為加快運算需將其標準化處理, 固定每張圖像尺寸為576×360。相機直接采集的空間位置圖(見圖2a)描述鰻鱺運動時序信息能力較弱, 為加強圖像行為特征, 在圖2a基礎上利用混合高斯背景模型提取運動目標, 去除相對不變的背景, 所得前景提取圖(圖2b)作為網絡模型的空間流圖像數據輸入。在圖2a的基礎上利用Farneb?ck稠密光流算法(Farneb?ck, 2003)提取鰻鱺行為的光流圖像, 用光流能量圖(圖2c)描述鰻鱺的運動時序信息, 并作為網絡模型的時間流圖像數據輸入。

本實驗共選擇1 800張圖像作為6種鰻鱺行為狀態數據集, 每種狀態選取前景提取圖和光流能量圖各300張。將數據集圖片的70%劃分為訓練集, 30%劃分為測試集, 并使用DataLoader程序里的shuffle將數據集里的圖片打亂使其呈現隨機分布, 更好地加強模型的泛化能力。

圖2 圖像樣本示例

注: a. 空間位置圖; b. 前景提取圖; c. 光流能量圖

2 基于DenseNet雙流卷積神經網絡的鰻鱺行為狀態檢測

2.1 DenseNet網絡模型

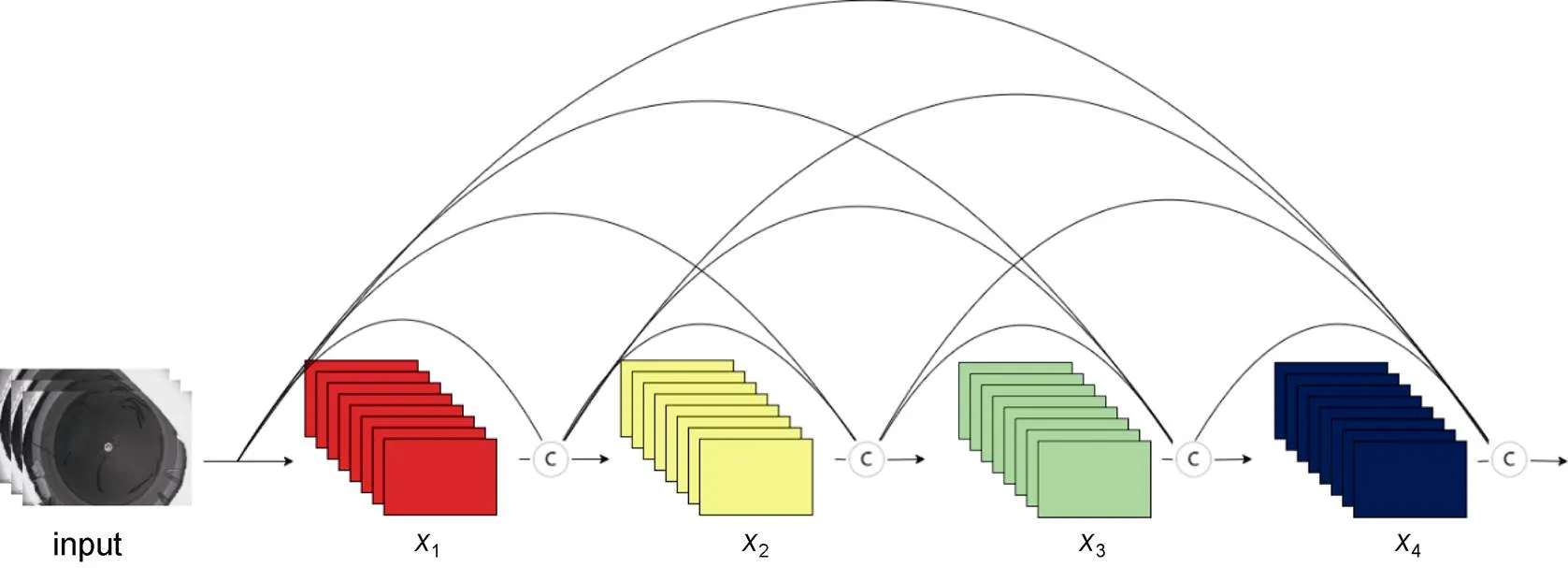

Huang等(2017)提出了DenseNet網絡。DenseNet網絡建立在ResNet的基礎上(He, 2016), 基本網絡模型由密集連接塊(Dense Block)和過渡層(Transition Layer)組成, 采用所有層互相連接的密集連接機制, 見圖3, 實現了特征重用和更強的梯度流動性, 最大程度保留低維度特征和提升梯度的反向傳播, 在參數量和計算量更少的情況下獲得比VGGNet、ResNet更優的性能。其結構如式(1)所示:

x=H([0,1, …,x-1]), (1)

式中,x為DenseNet網絡在層的輸出,H為非線性轉化函數(non-linear transformation), 它包括了BN (Batch Normalization)、ReLU、Conv等特征提取操作, 相較于ResNet采用的元素級相加操作(addition), DenseNet采用的是特征通道級連接操作(concatenation)。

圖3 DenseNet網絡的密集連接機制

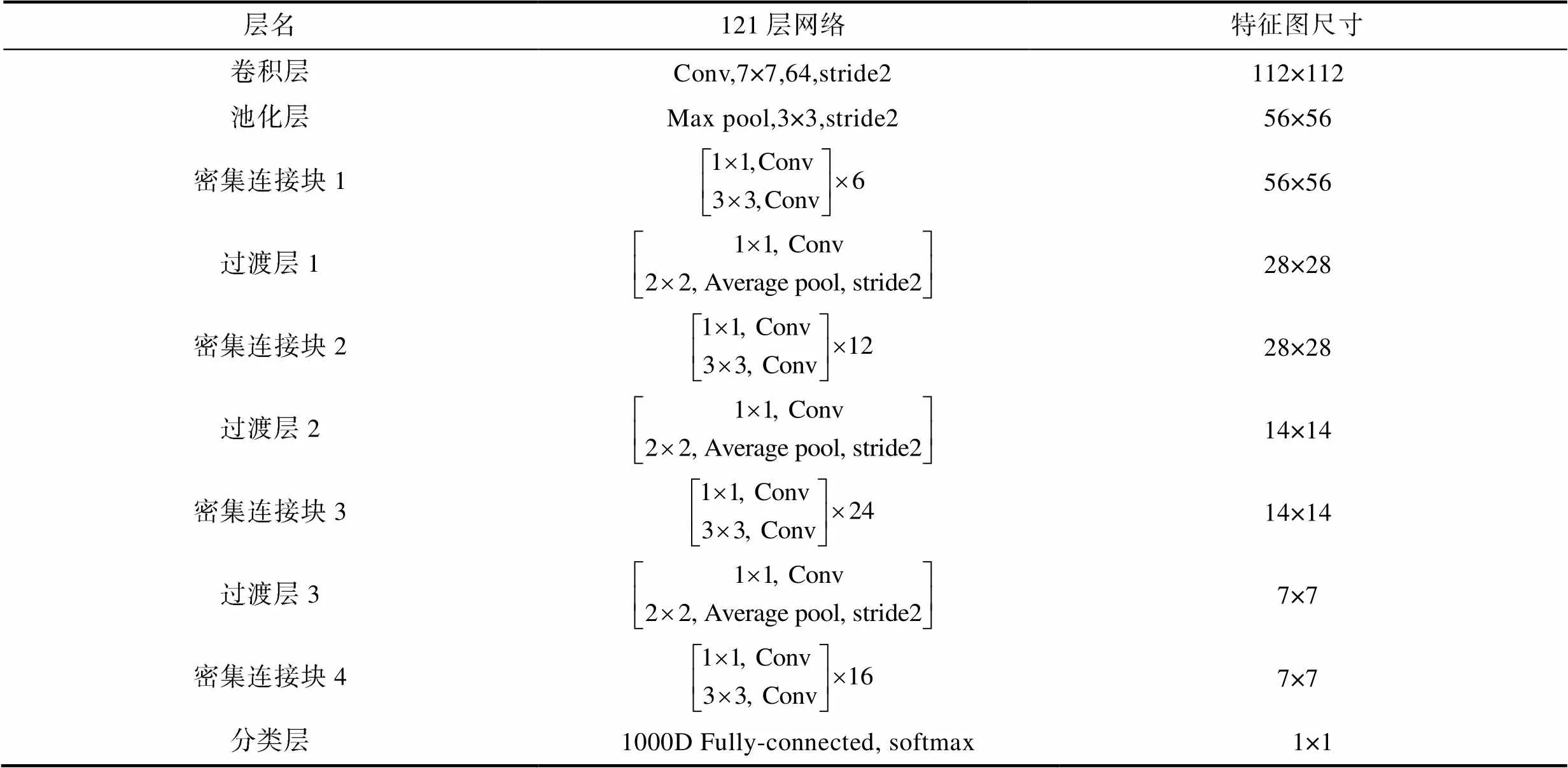

在本文實驗中采用的是DenseNet-121網絡, 網絡結構由3個Transition Layer模塊連接4個Dense Block模塊, 增長率(Growth rate)設置為32。DenseNet-121網絡結構如表2所示。

表2 DenseNet-121網絡結構

Tab.2 The structure of the DenseNet-121 network

DenseNet網絡結構中每個Dense Block模塊內部使用Bottleneck來降低網絡參數量, Bottleneck具體結構為BN + ReLU + 1×1 Conv + BN + ReLU + 3×3 Conv。整個網絡一共為121層, 4個密集連接塊中的Bottleneck層分別有6層、12層、24層以及16層, 輸出的特征圖維度分別為256維、512維、1 024維、1 024維。

2.2 DenseNet雙流卷積神經網絡

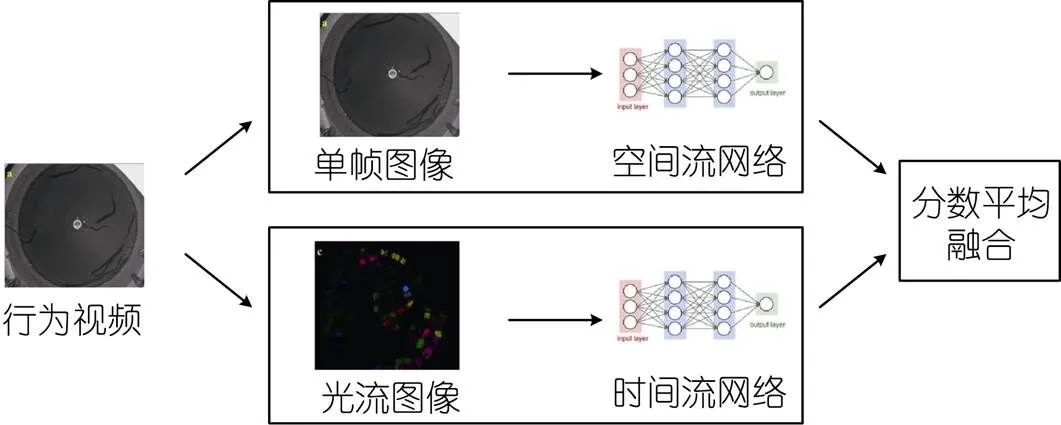

2.2.1 雙流卷積網絡 傳統單幀卷積神經網絡(Single Frame CNN)對圖像信息的空間信息有較好的獲取能力, 但無法獲取時間信息, 即使利用多幀圖像并使用多種不同融合方式如Late Fusion、Early Fusion、Slow Fusion融合視頻幀進行改進以獲取圖片上的時間信息, 其獲取的能力也有限, 最佳融合方式Slow Fusion在UCF101數據集上預測準確率達到60.9% (楊戈等, 2022)。雙流卷積網絡是Simonyan等(2014)提出的關聯時空特征信息的網絡模型, 其網絡結構由空間流網絡與時間流網絡構成, 見圖4。對于給定的行為視頻來說, 圖像信息被雙流卷積網絡分成空間信息與時間信息兩部分。空間信息以單幀RGB圖像作為輸入, 利用卷積神經網絡提取空間位置特征信息, 最后通過全連接層給每個視頻幀標注上行為標簽。時間信息則以多張相鄰幀計算得到的光流圖像作為輸入, 同樣經過卷積層與全連接層, 對每個光流圖像的動作特征進行標注。最后兩個網絡都要各自經過Softmax層, 輸出向量進行平均融合, 確定最終分類的結果。雙流卷積神經網絡在UCF101數據集上預測準確率達到了88.0%。

圖4 雙流卷積神經網絡結構

2.2.2 DenseNet雙流卷積神經網絡模型設計 上文提到雙流卷積神經網絡是將行為視頻分解成空間圖像和光流圖像進行輸入。對于本文所研究的鰻鱺行為分類任務而言, 關注的重點是鰻鱺本身, 在雙流網絡中直接輸入視頻單幀圖像和對應的光流圖像可能會存在背景噪聲干擾, 因此選擇利用混合高斯背景模型去除背景的干擾, 僅保留有意義的鰻鱺運動目標, 提取鰻鱺的運動信息。下面對混合高斯背景模型進行介紹。

混合高斯背景模型是基于像素樣本統計信息的背景表示方法, 對于各像素點的處理都是獨立的。圖像中的每個像素值短時間內在一定的距離里滿足圍繞某一中心值分布, 如果數據點足夠多的話認為其滿足高斯分布, 如果像素值偏離中心值較遠, 則認為其屬于前景; 如果像素值偏離中心值較近, 則認為其屬于背景。利用像素在較長時間內大量樣本值的概率密度等統計信息, 使用統計差分進行目標像素判斷, 對復雜動態背景進行建模。

將圖片的每個像素值由個高斯模型疊加的混合高斯背景模型來建模, 通常的取值為3~5。即:

每個新像素值x和個高斯模型比較, 找到匹配x的高斯分布模型, 即和該模型的偏差在2.5σ內。如果匹配的高斯模型符合要求, 則認為該像素是背景, 否則認為該像素屬于前景。本文實驗的取值為3。

將經過混合高斯背景模型處理的鰻鱺行為單幀空間圖像與光流圖像作為雙流卷積神經網絡的輸入, 并對雙流卷積神經網絡進行改進。原雙流卷積網絡所使用的神經網絡模型為VGG-16, 網絡深度為16層, 為加深網絡層數以獲取更深層的圖像目標運動特征, 使用DenseNet-121替換神經網絡, 將網絡層數加深至121層。原模型使用的是決策層融合, 時空網絡分別在Softmax層得出分數后再進行平均分數融合。為更大程度地關聯時空特征, 采用卷積融合的特征融合方式, 在網絡卷積層提取空間特征與時間特征后, 再加上一層卷積層將時空特征進行卷積融合以提升模型識別精度。本文所使用的DenseNet雙流卷積神經網絡模型結構如圖5所示。

3 實驗與結果分析

3.1 環境框架與超參數設置

本實驗使用的是Pytorch框架, 以Python為開發語言。深度學習運算平臺的硬件配置信息為: 處理器為Inter i9-12900KF, 顯卡為NVDIA GeForce RTX 3090Ti (24GB); 使用的軟件環境配置為: 系統為Window 11, 運行內存為32GB, python版本為3.8, CUDA版本為11.3。

在DenseNet雙流卷積網絡模型中的超參數設置如下: 批尺寸(Batch size)為16; 迭代輪次(Epoch)為100; 模型優化器選擇帶動量的隨機梯度下降算法SGD, 動量因子(momentum)設置為0.9; 學習率(learning rate)為0.001; 權重衰減參數(weight_decay)設置為0.000 4。

為加快并優化DenseNet雙流卷積網絡模型的學習效率, 采用遷移學習(transfer learning)的方式, 選擇使用ImageNet數據庫進行預訓練處理, 得到預訓練網絡模型之后再使用自制的鰻鱺行為狀態數據集進行訓練和優化。

3.2 三種狀態下的鰻鱺異常行為區分點

上文提到針對鰻鱺狀態分類確立6種具有較為明顯的分辨特征的行為狀態作為研究對象, 但在饑餓、缺氧、高水溫這3種狀態中, 如何選定合適的饑餓天數、溶氧量、水溫, 使鰻鱺的行為狀態處于異常, 是一項需要預先進行的實驗。實驗環境設置參考楊小東等(2019), 將不同饑餓天數、不同溶解氧濃度、不同水溫各自設置7個梯度, 每個梯度的鰻鱺行為狀態都與正常狀態的圖像數據一起送入DenseNet雙流卷積神經網絡進行二分類識別, 以二分類網絡識別準確率達90%以上的狀態為行為異常區分點, 并以此設定為本文研究所需的異常狀態訓練數據。

每個梯度使用200張空間圖像與光流圖像用作訓練與測試; 使用DenseNet-121的權重參數初始化DenseNet雙流卷積神經網絡的權重參數; 網絡迭代輪次設置為50輪, 每迭代1輪記錄訓練過程中的網絡損失函數值與測試集的準確率, 選取網絡模型最優狀態。

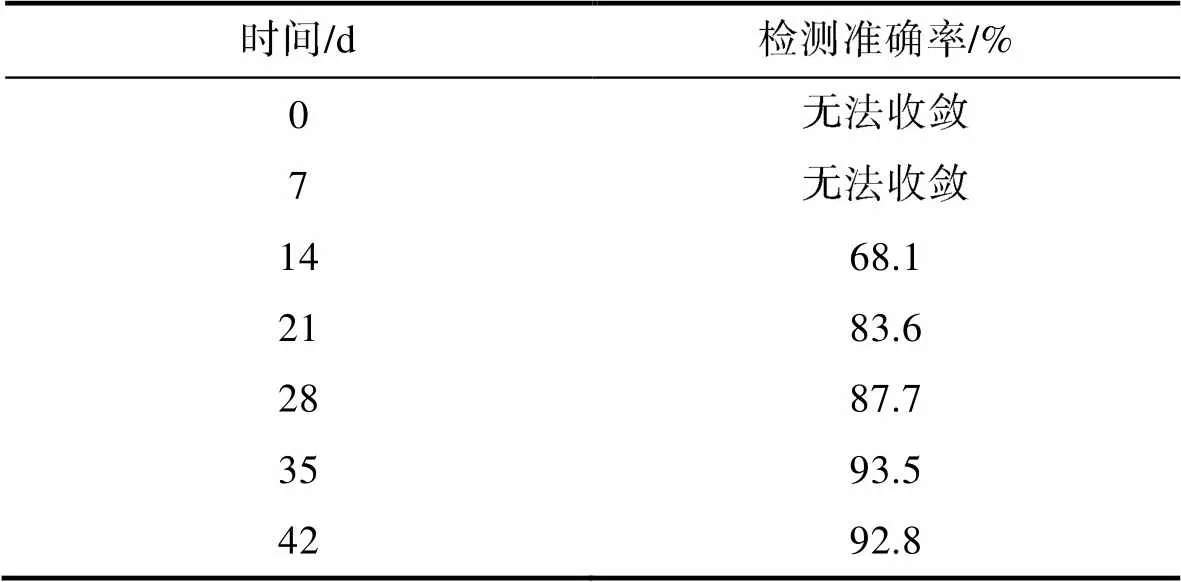

3.2.1 饑餓狀態異常行為區分 將體質量(275.6± 6.2) g的10條成鰻放入養殖桶內暫養一周消除鰻鱺的應激反應對實驗結果的影響, 保持溶氧6.5~ 7.5 mg/L, pH 7.0±0.2, 控制水溫25 °C, 正常喂食。一周后停止喂食并使用攝像頭記錄鰻鱺活動情況, 每隔7 d記錄一次, 記錄總次數為7次, 將圖像數據送入DenseNet雙流卷積神經網絡模型中與正常喂食狀態下的鰻鱺活動圖像數據作二分類識別, 識別結果如表3所示。在第7天時記錄的圖像數據與正常狀態區別不大, 識別準確率低, 訓練集預測準確率劇烈震蕩, 網絡無法收斂; 第14天記錄的圖像數據送進網絡模型中發現雖然開始收斂, 但是識別準確率僅為68.1%, 說明與正常狀態下的行為區分度依然較低; 第35天的記錄數據異常檢測準確率首次突破90%, 達到93.5%, 說明將鰻鱺停食35 d后其活動行為與正常狀態下可通過DenseNet雙流卷積神經網絡模型作出區分, 因此選擇停食35 d后的鰻鱺活動狀態作為本文研究的饑餓異常狀態。

圖5 DenseNet雙流卷積神經網絡結構

3.2.2 缺氧狀態異常行為區分 將體質量為(291.2±9.2) g的10條成鰻放進養殖桶內暫養一周消除鰻鱺的應激反應, 保持溶氧6.3~7.3 mg/L, pH 7.0±0.2, 控制水溫25 °C, 正常喂食。一周后停止曝氣, 使用聚酯薄膜(PET)將養殖桶與攝像頭一起密封, 確保桶內環境與空氣隔絕, 使用溶氧儀(哈納HI98193)和攝像頭記錄水的溶解氧濃度與鰻鱺活動情況。起始溶解氧含量為6.9 mg/L, 后待溶氧儀顯示溶解氧濃度分別為6.0、5.0、4.0、3.0、2.0、1.0 mg/L時用攝像頭記錄此時鰻鱺活動狀態。所得圖像數據送入DenseNet雙流卷積神經網絡模型中與正常狀態下的鰻鱺活動圖像數據作二分類識別, 識別結果如表4所示。當溶解氧濃度降至5.0 mg/L時, 其行為狀態與正常狀態的行為基本無區分, 網絡不收斂; 當溶解氧濃度下降至4.0 mg/L時, 網絡開始收斂, 模型檢測準確率為69.4%; 當溶解氧濃度下降至2.0 mg/L時, 鰻鱺的行為狀態與正常狀態具有明顯區分, 識別準確率達到99.6%; 而當溶解氧濃度下降至1.0 mg/L時, 識別準確率反而下降至88.7%, 分析其原因是當溶解氧濃度為1.0 mg/L時, 已經接近澳洲鰻鱺成鰻窒息點0.90 mg/L (魏金生等, 2021), 此時已有3條鰻鱺出現死亡而無行為活動, 影響了網絡模型的識別效果。因此選擇2.0 mg/L的溶解氧濃度下的鰻鱺行為狀態作為本文研究的缺氧異常狀態。

表3 不同饑餓天數對鰻鱺饑餓狀態識別準確率的影響結果

Tab.3 Effect of the length of starvation (number of days) on the accuracy of recognition of the hungry state of eel

表4 不同溶解氧濃度對鰻鱺缺氧狀態識別準確率的影響結果

Tab.4 Effect of dissolved oxygen concentration on the accuracy of recognition of anoxic state of eel

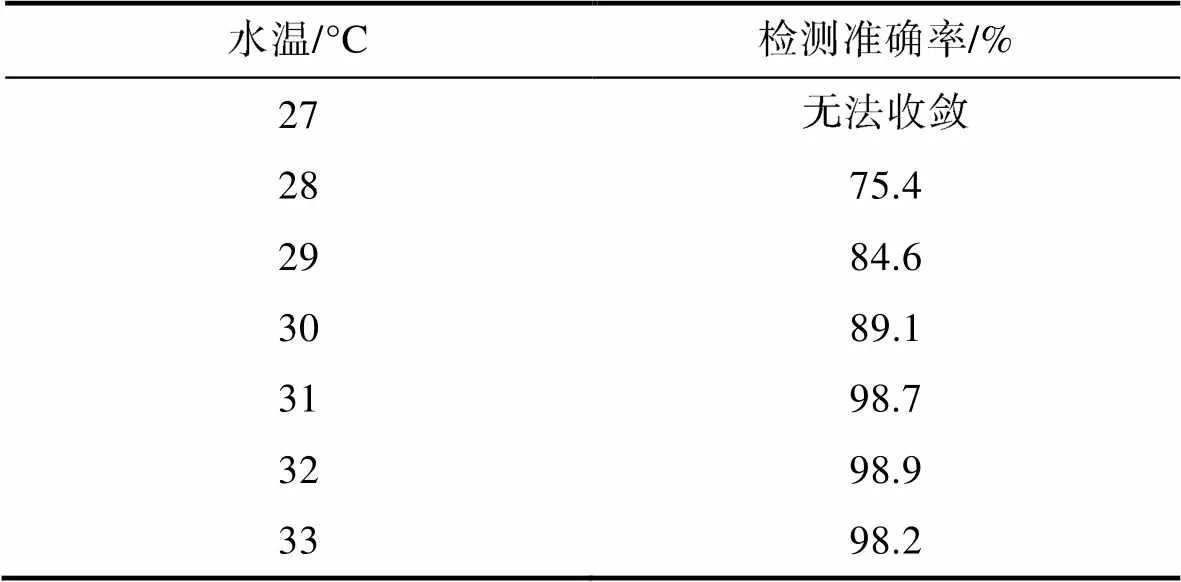

3.2.3 高水溫狀態異常行為區分 將體質量(246.9±5.3) g的10條成鰻放入養殖桶內暫養一周, 保持溶氧6.4~7.4 mg/L, pH 7.0±0.2, 正常喂食。一周后測量初始水溫為27 °C, 用攝像頭記錄鰻鱺活動狀態。此后利用加熱棒將水溫每上升1 °C后保持目標水溫4 h, 并用攝像頭記錄鰻鱺行為活動。后將所有圖像數據送入DenseNet雙流卷積神經網絡模型中與正常狀態下的鰻鱺活動圖像數據作二分類識別, 識別結果如表5所示。水溫對鰻鱺活動行為的影響較大, 當水溫從初始溫度27 °C提高1~28 °C時, 網絡模型識別準確率為75.4%; 當溫度達到31 °C時網絡模型識別準確率達到98.7%, 表明鰻鱺在這個溫度下行為狀態與正常溫度下具有明顯區分, 因此選擇水溫31 °C下的鰻鱺行為狀態作為本文研究的高水溫異常狀態。

表5 不同水溫對鰻鱺高水溫狀態識別準確率的影響結果

Tab.5 Effects of water temperature on the accuracy of recognition of eel under high water temperature

3.3 DenseNet雙流卷積神經網絡狀態識別訓練結果

本文使用的鰻鱺行為狀態數據集一共有1 800張圖像, 將其70%作為訓練集, 30%作為測試集; 設置網絡迭代輪次(epoch) 100輪; 使用DenseNet-121的權重參數初始化DenseNet雙流卷積神經網絡的權重參數; 在空間流網絡與時間流網絡進行并行訓練, 每迭代1輪記錄訓練過程中的網絡損失函數值(Loss)與測試集的準確率(Accuracy); 雙流融合方式為卷積融合, 即將空間流網絡與時間流網絡各自通道數為2 048的特征層, 使用1×1卷積核的卷積層將其融合為通道數1 024的特征層, 再通過全連接層與需要進行分類的6種狀態進行分類。

模型訓練過程中網絡損失函數值與測試集準確率的變化趨勢如圖6和圖7所示。網絡損失函數值在前20個epoch下降較快, 此后放緩下降速度, 在第45個epoch趨于穩定, 說明此時模型達到收斂。模型的測試準確率在前30個epoch上升較快, 在第55個epoch時趨于穩定, 準確率達到95%以上, 此后模型經過多輪訓練, 測試準確率緩慢上升, 最終穩定于96.8%。

3.4 不同網絡模型檢測結果比較和分析

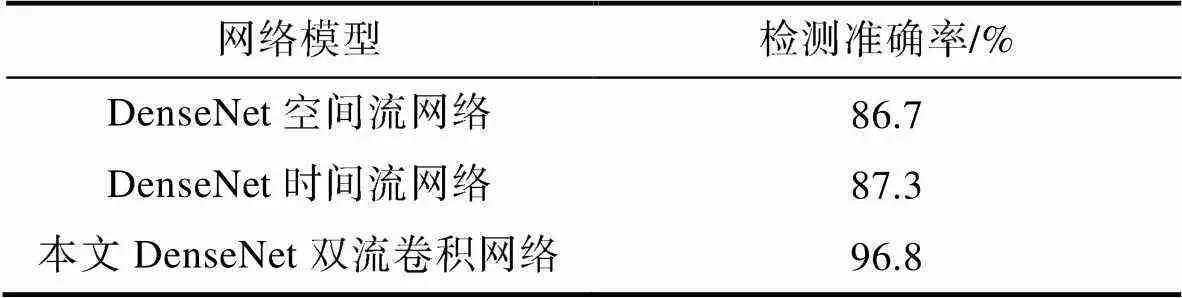

將DenseNet雙流卷積神經網絡的檢測準確率與單空間流網絡與單時間流網絡的檢測準確率作對比, 驗證雙流網絡結構相比單流網絡結構在鰻鱺行為狀態識別檢測的優勢, 其結果如表6所示。

圖6 DenseNet雙流卷積網絡訓練損失變化圖

圖7 DenseNet雙流卷積網絡在測試集上準確率變化圖

表6 DenseNet雙流卷積網絡與單流網絡準確率比較

Tab.6 Comparison in recognition accuracy between the DenseNet double-flow convolutional network and single-stream network

本文所使用的雙流卷積網絡模型為DenseNet網絡, 如果采用其他網絡如VGGNet、ResNet的雙流卷積網絡, 并使用不同策略的雙流融合方式, 其模型檢測準確率與本文的模型作對比, 其結果如表7所示。

從表6可以看出, 在模型結構相同的情況下, 使用DenseNet網絡的空間流網絡模型在鰻鱺行為狀態識別檢測準確率為86.7%, 而時間流網絡的檢測準確率為87.3%, 兩者的檢測準確率相近, 后者要比前者稍高, 證明了在行為識別檢測上, 即使作為輸入的光流圖像更容易受到光照變化、水面擾動、水面反光等情況的干擾, 但是依然比空間位置圖像更能描述鰻鱺的行為運動信息, 包含了更多的運動特征。使用本文的DenseNet雙流卷積網絡在特征層上通過卷積融合的方式將雙流各自的特征信息進行融合, 檢測準確率達到96.8%, 對比空間流網絡與時間流網絡分別提升了10.1%和9.5%, 證明了雙流網絡相比單流網絡對于運動特征信息的提取具有更好的效果, 有效區分了鰻鱺在不同狀態下的行為模式。

表7 DenseNet雙流卷積網絡與其他雙流網絡準確率比較

Tab.7 Comparison in recognition accuracy between the DenseNet double-flow convolutional network and other two-stream networks

從表7可以看出, 在傳統雙流網絡中使用VGG-16的檢測準確率為84.4%, 將VGG-16替換成網絡層數更深的ResNet-50, 檢測準確率提升為92.6%; 之后再將ResNet-50替換成DenseNet-121, 檢測準確率提升為94.3%, 說明網絡層數加深有利于提取更深層的圖像特征。而后在DenseNet雙流卷積神經網絡中使用不同的雙流融合方式, 從決策層平均融合替換成特征層拼接融合, 檢測準確率提升為95.1%, 說明特征層融合更能使網絡學習圖像的時空關聯特征; 替換成特征層卷積融合, 檢測準確率提升為96.8%, 在特征層進行卷積融合的方式相比拼接融合效果更佳。

而相較于以往對魚類行為識別的研究方法, 本文方法也具有更好的效果。Zhou等(2017)用背景差分法提取魚體, 通過狄羅尼三角剖分計算魚群的群聚指數來描述魚群的活躍程度, 識別準確率達到94.5%。黃志濤等(2022)以大西洋鮭為研究對象, 利用背景差分法、光流法、灰度共生矩陣提出一種基于魚體運動特征和圖片紋理特征的魚群活動強度量化方法, 其檢測準確率達到94.17%。李濟澤等(2022)將魚群活動行為圖像通過歸一化、PCA降維和支持向量機的方法提出一種基于機器視覺的攝食行為識別方法, 其平均準確率為92.3%。與以上研究相比, 本文的研究方法利用深度學習這一工具, 深入挖掘鰻鱺活動圖像的時空特征信息, 且將研究范圍進一步擴大到6種不同的行為狀態, 檢測準確率為96.8%。

4 結論

本文使用了DenseNet雙流卷積神經網絡對鰻鱺的6種行為狀態進行識別分類。首先通過攝像機采集不同狀態下鰻鱺行為視頻, 并通過混合高斯背景模型和光流算法對視頻數據進行處理得到雙流圖像數據集。針對傳統卷積神經網絡對于時間信息獲取能力有限的問題提出以DenseNet網絡進行改進的雙流卷積神經網絡, 采用所有層互相連接的密集連接機制實現了特征重用和更強的梯度流動性, 網絡層數更深, 性能更優; 使用并行訓練, 在特征層進行卷積融合的方式關聯時空信息特征。使用DenseNet雙流卷積神經網絡對饑餓狀態、缺氧狀態、高水溫狀態進行正常狀態與異常狀態二分類識別, 確定3種狀態的異常行為區分點, 并將其作為本文識別任務中的所需異常狀態。最后對于6種行為狀態使用DenseNet雙流卷積神經網絡進行識別分類并與其他網絡模型的檢測結果進行比較和分析。

實驗結果表明, 使用本文的DenseNet雙流卷積神經網絡對鰻鱺6種行為狀態進行識別, 準確率達到96.8%; 相較于使用VGG-16的傳統雙流網絡準確率提升了12.4%; 相較于使用ResNet-50的雙流卷積網絡準確率提升了4.2%; 相較于決策層平均融合、特征層拼接融合方式的DenseNet雙流卷積神經網絡, 特征層卷積融合方式準確率分別提升了2.5%和1.7%。綜上, 本文的DenseNet雙流卷積神經網絡在鰻鱺行為狀態識別研究具有重要的參考價值。

李岑鵬, 關瑞章, 江興龍, 等, 2009. 循環水處理系統處理鰻鱺養殖污水的應用實驗[J]. 集美大學學報(自然科學版), 14(2): 126-130.

李凱, 江興龍, 陳爾康, 等, 2022. 基于深度學習的循環水養殖鰻鱺()計數研究[J]. 海洋與湖沼, 53(3): 664-674.

李星輝, 2021. 基于軌跡提取的魚類異常行為監測[D]. 杭州: 浙江大學: 11-35.

李濟澤, 位威, 張凱凱, 2022. 基于機器視覺的養殖魚攝食行為識別方法[J]. 福建工程學院學報, 20(4): 378-382.

楊小東, 江興龍, 樂普敏, 等, 2019. 南美洲鰻鱺()的耗氧率(ROC)、窒息點(AP)和適溫范圍(RT)及對非離子氨(NIA)、NO2–的LC50和SC的研究[J]. 海洋與湖沼, 50(2): 455-464.

楊戈, 鄒武星, 2022. 基于深度學習的視頻行為分類方法綜述[J]. 電子技術應用, 48(7): 1-7, 12.

沈軍宇, 李林燕, 夏振平, 等, 2018. 一種基于YOLO算法的魚群檢測方法[J]. 中國體視學與圖像分析, 23(2): 174-180.

范良忠, 劉鷹, 余心杰, 等, 2011. 基于計算機視覺技術的運動魚檢測算法[J]. 農業工程學報, 27(7): 226-230.

鄭書康, 2020. 基于計算機視覺的魚類行為學規律與精準投喂的研究[D]. 杭州: 浙江大學: 3-5.

黃志濤, 何佳, 宋協法, 2022. 基于魚體運動特征和圖像紋理特征的魚類攝食行為識別與量化[J]. 中國海洋大學學報, 52(1): 32-41.

龔盼, 2015. 日本鰻鱺幼體對環境因子的選擇行為研究[D]. 上海: 上海海洋大學: 35-36.

謝富華, 2020. 基于深度學習的魚群行為狀態分類研究[D]. 天津: 天津理工大學: 22-23.

魏金生, 江興龍, 王澤旭, 等, 2021. 澳洲鰻鱺()不同生長階段的生物學耐受性特征及其演變趨勢[J]. 海洋與湖沼, 52(4): 983-993.

FARNEB?CK G, 2003. Two-frame motion estimation based on polynomial expansion [C] // Proceedings of the 13th Scandinavian Conference on Image Analysis. Berlin, Heidelberg: Springer: 363-370.

HE K, ZHANG X, REN S,, 2016. Deep residual learning for image recognition [C]. Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 770-778.

HUANG G, LIU Z, VAN DER MAATEN L,, 2017. Densely connected convolutional networks [C] // Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE.

KATO S, TAMADA K, SHIMADA Y,, 1996. A quantification of goldfish behavior by an image processing system [J]. Behavioural Brain Research, 80(1/2): 51-55.

NIU B S, LI G Y, PENG F,, 2018. Survey of fish behavior analysis by computer vision [J]. Journal of Aquaculture Research & Development, 9(5): 1000534.

SADOUL B, EVOUNA MENGUES P, FRIGGENS N C,, 2014. A new method for measuring group behaviours of fish shoals from recorded videos taken in near aquaculture conditions [J]. Aquaculture, 430: 179-187.

SIMONYAN K, ZISSERMAN A, 2014. Two-stream convolutional networks for action recognition in videos [C] // Proceedings of the 27thInternational Conference on Neural Information Processing Systems. Montreal: MIT Press: 568-576.

ZHOU C, ZHANG B H, LIN K,, 2017. Near-infrared imaging to quantify the feeding behavior of fish in aquaculture [J]. Computers and Electronics in Agriculture, 135: 233-241.

RECOGNITION OF BEHAVIORAL STATE OF EELIN RECIRCULATING AQUACULTURE SYSTEM VIA DEEP LEARNING

XU Zhi-Yang1, 2, JIANG Xing-Long1, 2, LIN Qian1, 2, LI Kai1, 2

(1. Fisheries College, Jimei University, Xiamen 361021, China; 2. Engineering Research Center of the Modern Technology for Eel Industry, Ministry of Education, Xiamen 361021, China)

In order to achieve accurate identification of behavioral states of cultured eel, a recognition of behavioral state of eel in recirculating aquaculture system was proposed based on the DenseNet double-flow convolutional neural network. The Gaussian Mixture Model was used for foreground extraction to construct the dataset. Aiming at the problem in traditional convolutional neural network whose ability to extract time dynamic information is limited, a double-flow network structure associated with spatial and temporal features was built, in which the DenseNet-121 network was used to replace the original network. Compared to VGGNet, ResNet, and other networks, the proposed system can reuse the characteristic attributes via dense connection by building a deeper network structure, by which the motion feature transmission can be strengthened and the number of parameters reduced, thus achieving better extraction of representative behavioral features. The softmax layer at both ends of a traditional two-stream network makes simple average fusion of decision layers only, which cannot correlate spatio-temporal high-level features to a deeper extent. Therefore, after the network convolution layer extracts the spatial and temporal features, a convolution layer is added to the convolutional fusion of spatio-temporal features to improve the recognition accuracy. Results show that the accuracy of the proposed system for the behavior state detection of six eels reached 96.8%, which is 10.1% and 9.5% greater than that of the single-channel spatial stream and temporal stream networks. Compared with the two-stream network built with VGGNet and ResNet, the accuracy was increased by 12.4% and 4.2%, respectively. Compared with the average fusion method of decision layer and the concatenation fusion method of feature layer, the accuracy of the spatio-temporal feature convolution fusion was increased by 2.5% and 1.7%, respectively.

eel; behavioral state; Gaussian Mixture Model; DenseNet-121; double-flow network structure; convolutional fusion

* 國家重點研發計劃“特色魚類精準高效養殖關鍵技術集成與示范”, 2020YFD0900102號; 福建省科技廳高校產學合作項目, 2020N5009號。許志揚, 碩士研究生, E-mail: 1227550569@qq.com

江興龍, 博士, 教授, E-mail: xinlongjiang@jmu.edu.cn

2023-03-02,

2023-05-08

Q959.9; S965

10.11693/hyhz20230300048