基于人工智能的無人機測繪遙感圖像信息提取方法

陳立娜,李 真,宋 輝

(國網河南省電力公司內鄉縣供電公司,河南內鄉 474350)

無人機測繪遙感是當前遙感技術發展的一個重要方向,它在實時性、針對性和靈活性等方面具有很大的優勢,是獲取遙感資料的一個重要方法。但是在實際應用中,不能很好地提取出一些細節特征。因此,對無人機測繪遙感圖像信息進行提取具有重要意義。

劉強[1]等提出卷積神經網絡模型方法,采用基于分類的方法對各個像素進行分類,在像素水平上的提取精確度可能會很高,但是也很容易忽視像素與像素之間的相互關系。由于實際場景的復雜性和多樣性,使用該方法常常會受到目標對象大量變化、目標遮擋和重疊、目標缺乏高識別特性以及光照變化等原因,使得提取模型缺乏泛化能力。鄭蓉珍[2]等提出將無人機影像與數字地表模型相融合,利用最大似然法提高圖像識別準確率。然而該方法已經無法適應高分辨率圖像的要求。為此,提出了基于人工智能的無人機測繪遙感圖像信息提取方法。

1 圖像信息提取模型構建

利用無人機測繪與遙感技術對多幅無人機測繪遙感圖像進行了采集,將所獲得的圖像信息分成若干個圖像信息,這些圖像信息均為同一像素。利用聚類方法,將小圖像信息中的背景信息劃分為亮色裸地、暗色裸地、綠色植被和枯萎植被四種類型。指數NDVI 的表達公式為:

式中,I表示圖像紅外波段反射值;R表示標準紅光波段反射值。當利用該指數計算獲取植被面積[3]占小幅圖像總面積之比大于5%時,認為該圖像背景信息是植被,否則是裸地。

選擇有目標的小幅圖像數據與無目標的小圖像數據相結合,構成一個圖像數據對,從而構成多個圖像數據對。在此基礎上,將圖像數據集分為四個集合:亮色裸地影像數據集、暗色裸地影像數據集、綠色植被影像數據集和枯萎植被影像數據集[4]。

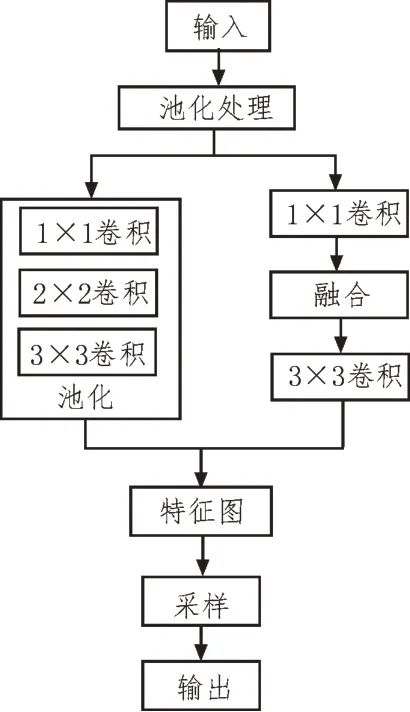

在四組圖像數據集合中,分別對各小圖像數據建立學習樣點,由此構成學習樣本對。根據學習樣本對訓練結果構建基于機器學習算法的目標提取模型,如圖1 所示。

圖1 基于機器學習算法的目標提取模型

由圖1 可知,將原無人機遙感影像分割為一組n×n尺寸的遙感圖像,在此基礎上繪制一幅標簽圖像,并將每幅圖像與其相應的標簽圖像作為訓練數據。在上述構建的模型中,需要使用2×2 的最大池化函數max pooling[5]。基于機器學習的方法,在無人機測繪遙感影像的數據抽取中采用了以下卷積過程:

過程1:對64 個卷積核進行兩次卷積,并執行一次池化層處理;

過程2:對128 個卷積核進行兩次卷積,并執行一次池化層處理;

過程3:對256 個卷積核進行三次卷積,并執行一次池化層處理;

過程4:對512 卷積核進行三次卷積,并執行一次池化層處理;

過程5:采用三階全連接層Fc-layer,并由softmax分類器進行處理。

經過卷積處理后,判斷模型輸出的提取準確度是否達到閾值,如果沒有達到,則需對圖像數據進行降維處理,并繼續更新圖像信息集[6-8];如果達到,則訓練完成,得到圖像信息提取結果。

2 遙感圖像信息提取過程

基于人工智能的無人機測繪遙感圖像信息提取方法包括以下步驟。

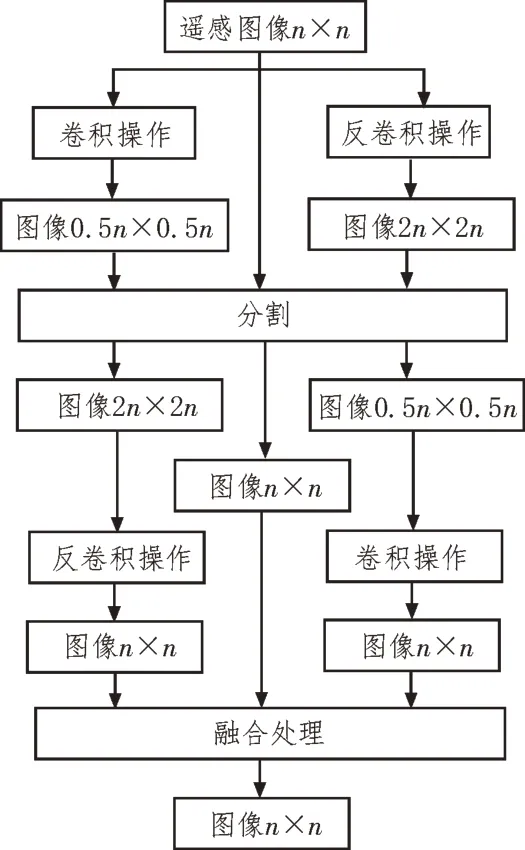

步驟1:圖像特征融合

1)利用RGB 三通道圖像進行卷積操作,獲得了尺寸為0.5n×0.5n、2n×2n的RGB 三通道圖像[9];

2)將2n×2n的RGB三通道圖像進行端對端訓練,并經過圖像分割處理后,獲得2n×2n的分類概率特征圖,并進行卷積運算,獲得尺寸為n×n的概率特征圖[10];

3)將0.5n×0.5n的RGB 三通道圖像進行端對端訓練,并經過圖像分割處理后,獲得0.5n×0.5n的分類概率特征圖,并進行卷積運算,獲得尺寸為n×n的概率特征圖[11];

4)將n×n的遙感圖像RGB 經端到端訓練后,可獲得具有n×n遙感圖像的分類概率特征圖[12]。

結合上述內容,設計詳細圖像特征融合過程,如圖2 所示。

圖2 圖像特征融合過程

由圖2 可知,將以上所得的三個大小均為n×n的概率特征圖進行統計學尺度的圖像特征融合[13],從而得到了目標提取模型輸出特征圖。

步驟2:卷積過程中的權值共享

為了實時更新機器學習的判別參數,需要對卷積過程進行權值共享。在共享時,需要測試各個性能指標的取值,形成目標相對優屬度矩陣[14]。

在共享過程中,需要測試各個性能目標的取值,基于此構成目標特征值矩陣,如式(2)所示:

式(2)中,zij表示第j個參數被采集時第i個性能目標的取值。

為了準確分析,應采用適當的優屬度計算方法對目標值進行標準化處理,將式(2)轉化為無量綱的目標相對優屬度矩陣,標準化處理公式為:

經過標準化處理后,得到目標相對優屬度矩陣為:

式(4)在客觀層面上體現出了各個參數對目標的影響,根據獲取的目標相對優屬度矩陣,安全共享卷積過程中的權值。

步驟3:模型訓練

在獲取共享權值情況下,采用人工智能的機器學習算法進行模型訓練。通過訓練得到遙感影像和相應的標記圖像[15],通過機器學習模型的訓練,使得機器學習和識別過程之間的關系趨于均衡。

步驟4:信息提取

首先,在n×n幅遙感圖像上添加訓練數據,將其輸入到所構造的圖像特征融合處理[16]過程中;然后,將輸出與n×n大小的遙感圖像進行卷積運算,并將其作為判別目標的輸入內容;最后,在確定判別目標后,得到一個介于0 和1 之間的輸出值。如果期望輸出為0,則判別該信息下所對應的圖像是假圖像;如果期望輸出為1,則判別該信息下所對應的圖像是真圖像。

在機器學習模型中,通常采用模型復雜度懲罰項η來衡量其空間容量,η數值的大小與泛化性能通常是成比例的,它被定義為:

式中,k表示樣本總數量;c表示機器學習模型的維數;c值越大,η值也就越大,反之,則越小。因此,在機器學習模型維數一定的情況下,增加訓練樣本數量,能夠避免提取模型在提取信息過程中出現過擬合現象。

3 實 驗

3.1 實驗區域與數據

為了驗證基于人工智能的無人機測繪遙感圖像信息提取方法的有效性,實驗區域為某城市某地區的焦化工廠,位于礦區詳查區的西南部,面積約1.60平方公里,高程在1 150~1 210 m 之間,該地區的地形中西部較高,西北部較低。

無人機測繪遙感圖像是在2021 年5 月6 日9:00時拍攝的,天氣晴但有霧,使用某公司制造的eBee Ag 固定翼無人機。無人機能夠迅速、高效地產生地形圖、正射影像圖、地面數字模型等數據。機身搭載索尼DSC-WX220 相機,該相機的鏡頭是索尼的G 鏡頭,它的焦距是4.50~43.5 mm。選取的地物目標圖像如圖3 所示。

圖3 地物目標標注結果

以圖3 所示的目標標注結果為研究對象進行實驗驗證分析。

3.2 實驗指標

使用整體像素精度評估不同信息提取方法下遙感圖像目標識別精度,公式為:

式中,a、b表示目標類別;n表示被預測成不同類的像元數量;m表示目標類型數量。

3.3 實驗結果與分析

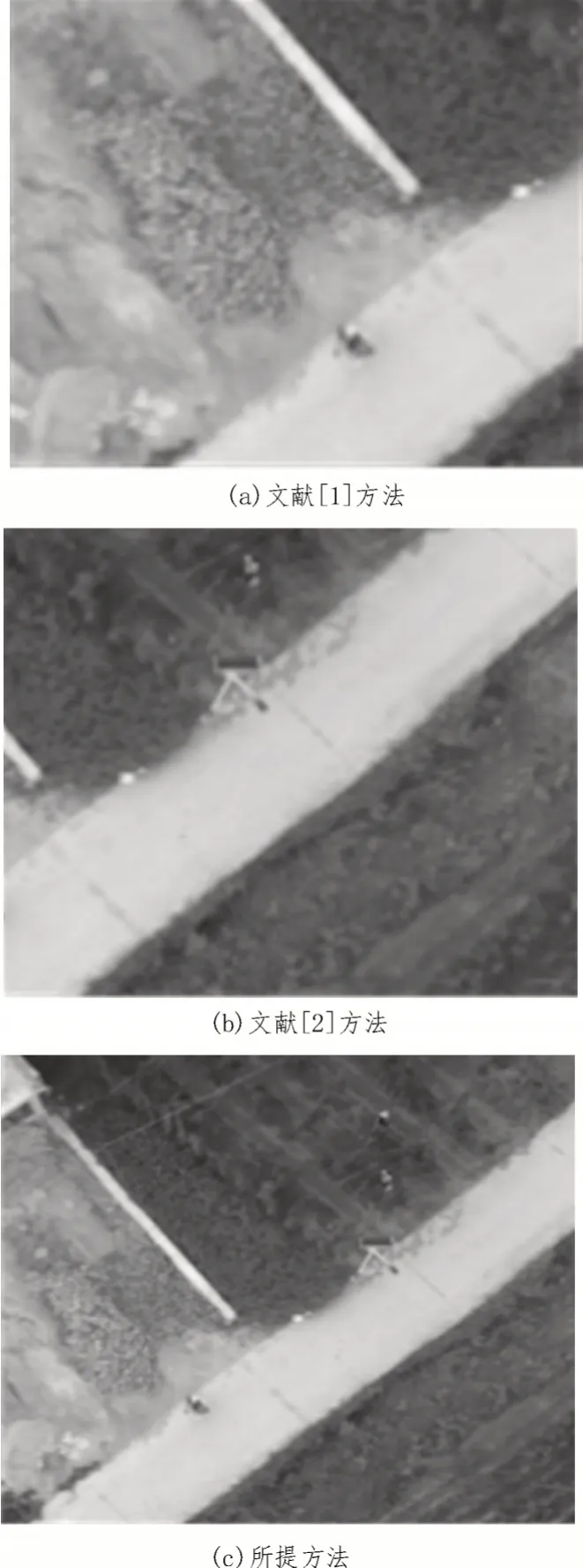

在提取遙感圖像信息過程中,不僅要考慮所收集的圖像數據,而且需將圖像失真問題納入其中。因此,分別使用文獻[1]方法、文獻[2]方法和所提方法,對比分析無人機測繪遙感圖像提取結果,如圖4所示。

圖4 三種方法的圖像提取結果對比分析

由圖4 可知,文獻[1]方法和文獻[2]方法提取的圖像并不全面,導致部分信息丟失,而所提方法提取的圖像全面,且與圖3 所示選取區域一致,能夠獲取全部圖像信息。

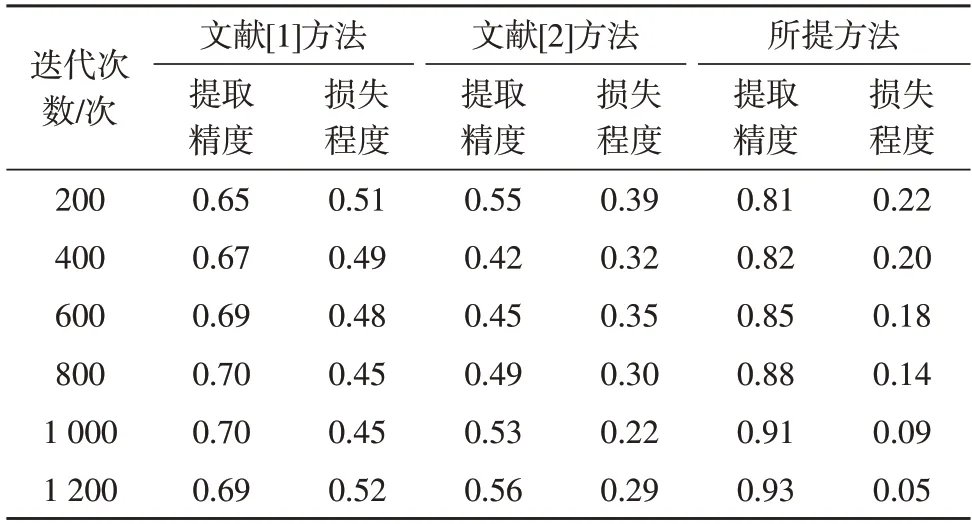

基于此,分別使用這三種方法對比分析圖像信息提取的精度和提取過程的損失情況,如表1 所示。

表1 三種方法的信息提取精度和損失情況對比分析

由表1 可知,文獻[1]方法和文獻[2]方法圖像信息提取精度最高分別為0.70 和0.56,損失程度最高分別為0.52 和0.39。而所提方法提取精度最高為0.93,損失程度最高為0.22。由此可知,所提方法信息提取精度高的同時損失程度低。

4 結束語

該文提出了一種基于人工智能的無人機測繪遙感圖像信息提取方法,該方法相比于現有的提取方法,提取精度高且損失程度低,可以滿足當前實際需要,通過使用人工智能方法識別的圖像和人類視覺效果更接近。在今后的遙感圖像質量評估中,可以從以下方面進行:同一區域內不同時期的遙感圖像,其數據自身具有一定的時間序列性。因此,可以將時間信息引入到圖像質量評估模式中,以實現將不同時期所收集到的數據進行整合,進而優化提取方法。