基于圖像分割與軌跡追蹤的室內飾面施工進度智能評估方法

盧昱杰 仲濤 魏偉 陳雋

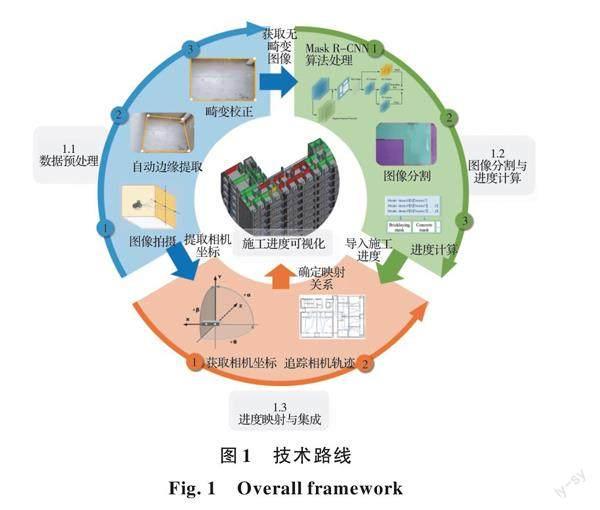

摘要:施工進度是工程項目管理的關鍵組成部分,傳統的進度管理多依靠人工巡檢,耗時費力且無法保障進度評估的時效性。為了實現施工進度的自動化、高效化監管,針對室內施工濕作業鋪貼場景,提出一套智能化進度追蹤與評估框架,基于改進的Mask R-CNN深度學習框架,自動提取室內墻面和地面的瓷磚鋪貼進度,基于相機軌跡追蹤算法,將整個施工層的大范圍施工進度識別結果映射至BIM可視化模型,為施工數字孿生奠定基礎。在上海市某高層建筑項目中進行實例研究,實現了施工圖像的高精度分割,驗證了研究框架的可行性。該框架不僅適用于室內瓷磚鋪貼,也適用于抹灰、刷涂等室內裝修工程。

關鍵詞:建筑信息模型;計算機視覺;室內施工;施工進度;圖像分割;軌跡追蹤

中圖分類號:TU767;TU17? ? ?文獻標志碼:A? ? ?文章編號:2096-6717(2024)01-0163-10

Intelligent evaluation method of indoor finishing construction progress based on image segmentation and positional tracking

LU Yujiea,b,c, ZHONG Taoa, WEI Weia, CHEN Juna

(a. College of Civil Engineering; b. Key Laboratory of Performance Evolution and Control for Engineering Structures of Ministry of Education; c. Shanghai Research Institute of Intelligent Science and Technology, Tongji University, Shanghai 200092, P. R. China)

Abstract: Construction progress is a key part of project management. Traditional progress management mostly relies on manual inspection, which is time-consuming and can not guarantee the progress evaluation. In order to automatically and efficiently monitor construction progress, this article proposed an intelligent framework for indoor construction progress evaluation. This framework can automatically extract the tile laying progress of indoor wall and ground based on the improved Mask R-CNN, and map the progress results to the BIM for visualization using camera tracking algorithm. The framework was successfully applied in a building project in Shanghai with a high precision of image segmentation, verifying the feasibility of the presented framework. This study provides theoretical and practical reference for the automated progress tracking and unmanned construction progress supervision of indoor continuous space.

Keywords: building information model (BIM), computer version, indoor construction, construction progress; image segmentation; positional tracking

工程項目的進度監控有助于項目管理人員及時發現并校正進度偏差,直接影響項目的成本和經濟效益[1-2]。傳統的進度監控方式多為人工巡檢與填表,耗費大量工作時間,且無法保障進度評估的時效性,難以滿足現階段工程項目高效管理的需求。室內施工流程繁雜,工序間關聯性強,每一道工序的施工進程都將直接影響總體進度。此外,室內環境存在構件堆積、視線遮擋等問題,需要花費更多的時間和人力用于進度管理。將AI技術應用于室內進度監控,可以非人工監督方式實時獲取進度信息,并動態更新與集成至BIM模型,為施工數字孿生奠定基礎。同時,還可通過動態測量施工量用于效率計算,滿足日益重要的施工精細化管理要求,對提升進度管理效率意義重大[3]。室內施工包含多道工序,瓷磚鋪貼以膩子、抹灰施工為基礎,對施工技術要求很高,最后一道工序的施工進程對總進度監控影響重大。因此,筆者以瓷磚鋪貼為例針對室內施工的智能化監控展開研究。

目前,施工進度自動化監控方式主要包括3種方式:1)基于傳感器布設的進度管理;2)基于點云三維重建的進度管理;3)基于圖像處理與分析的進度管理。第1種方式通過綁定施工構件與相應的二維碼或RFID標簽實現構件級別的進度追蹤,大大降低了進度管理人員的工作量[4-5]。但在室內環境中構件數量種類繁多,人為設置標簽較為耗時且存在丟失、遺漏的風險。第2種方式則是通過傾斜攝影或激光掃描等方式重建現場的三維模型,并從三維模型中獲取更直觀更豐富的場景信息[6-7],但由于室內場景復雜、多遮擋的特點,點云數據獲取不便,且處理過程耗時過長,對于室內進度監控而言時效性過差。相比之下,近年來,基于計算機視覺(CV)[8-9]的施工進度監控方法得到廣泛應用,其數據獲取便利、信息處理速度快等[10],能夠從圖像中快速提取豐富的室內場景信息,時效性強且應用成本較低,將其應用于室內進度監控具有獨特優勢。現階段基于計算機視覺的室內施工進度監控方法主要包括定性評價和定量計算兩種,定性進度評價主要是通過提取圖像中對象的材料、紋理等特征[11-13]或通過檢測工人活動[14-15]來推斷施工所處階段;定量進度計算則主要通過計算施工完成面積等方式確定進度完成比例[12]。例如Deng等[16]通過邊緣檢測的方法確定地面已鋪貼瓷磚部分的邊界線,并通過提前標定的方式校正圖片從而準確計算出瓷磚鋪貼面積與進度。

然而,現階段基于圖像識別的室內進度定量化計算方法僅能通過安裝固定攝像頭監控有限區域的施工進度[17],無法通過一套設備實現整個施工層的大范圍施工進度監控,且無法同時獲取墻面和地面在內的整體鋪貼進度。筆者以室內瓷磚鋪貼場景為例,提出了一套室內連續空間施工進度智能評估框架,該框架基于語義分割與圖像軌跡追蹤算法自動獲取墻面和地面的整體鋪貼進度,最終在BIM模型中實現進度信息集成與可視化。

1 室內施工進度自動化識別框架

1.1 整體框架

室內連續空間施工進度智能評估框架(如圖1所示)主要分為3個步驟:1)圖像預處理,即對獲取的墻面與地面的圖像進行自動畸變校正;2)圖像分割與進度計算,即基于改進的Mask R-CNN算法獲取已鋪貼與未鋪貼部分面積,并計算進度完成百分比;3)進度映射與可視化,將上述獲取的進度結果映射至BIM模型,實現進度可視化。

1.2 數據預處理

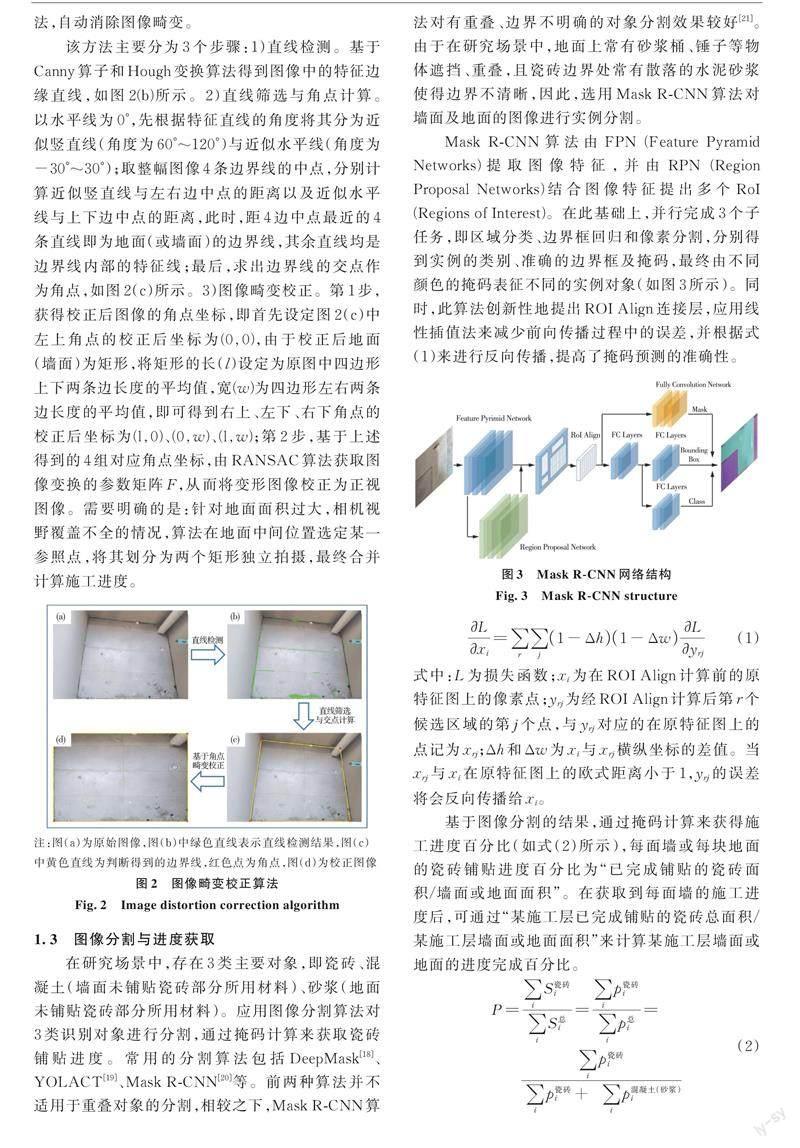

實際墻面和地面多為矩形平面,但由于拍攝角度及鏡頭畸變等因素影響,相機拍攝的圖片存在透視畸變,造成圖像處理和進度計算誤差。因此,基于Canny算子與Hough變換提出一種圖像校正方法,自動消除圖像畸變。

該方法主要分為3個步驟:1)直線檢測。基于Canny算子和Hough變換算法得到圖像中的特征邊緣直線,如圖2(b)所示。2)直線篩選與角點計算。以水平線為0°,先根據特征直線的角度將其分為近似豎直線(角度為60°~120°)與近似水平線(角度為-30°~30°);取整幅圖像4條邊界線的中點,分別計算近似豎直線與左右邊中點的距離以及近似水平線與上下邊中點的距離,此時,距4邊中點最近的4條直線即為地面(或墻面)的邊界線,其余直線均是邊界線內部的特征線;最后,求出邊界線的交點作為角點,如圖2(c)所示。3)圖像畸變校正。第1步,獲得校正后圖像的角點坐標,即首先設定圖2(c)中左上角點的校正后坐標為(0,0),由于校正后地面(墻面)為矩形,將矩形的長(l)設定為原圖中四邊形上下兩條邊長度的平均值,寬(w)為四邊形左右兩條邊長度的平均值,即可得到右上、左下、右下角點的校正后坐標為(l,0)、(0,w)、(l,w);第2步,基于上述得到的4組對應角點坐標,由RANSAC算法獲取圖像變換的參數矩陣F,從而將變形圖像校正為正視圖像。需要明確的是:針對地面面積過大,相機視野覆蓋不全的情況,算法在地面中間位置選定某一參照點,將其劃分為兩個矩形獨立拍攝,最終合并計算施工進度。

1.3 圖像分割與進度獲取

在研究場景中,存在3類主要對象,即瓷磚、混凝土(墻面未鋪貼瓷磚部分所用材料)、砂漿(地面未鋪貼瓷磚部分所用材料)。應用圖像分割算法對3類識別對象進行分割,通過掩碼計算來獲取瓷磚鋪貼進度。常用的分割算法包括DeepMask[18]、YOLACT[19]、Mask R-CNN[20]等。前兩種算法并不適用于重疊對象的分割,相較之下,Mask R-CNN算法對有重疊、邊界不明確的對象分割效果較好[21]。由于在研究場景中,地面上常有砂漿桶、錘子等物體遮擋、重疊,且瓷磚邊界處常有散落的水泥砂漿使得邊界不清晰,因此,選用Mask R-CNN算法對墻面及地面的圖像進行實例分割。

Mask R-CNN算法由FPN (Feature Pyramid Networks)提取圖像特征,并由RPN (Region Proposal Networks)結合圖像特征提出多個RoI (Regions of Interest)。在此基礎上,并行完成3個子任務,即區域分類、邊界框回歸和像素分割,分別得到實例的類別、準確的邊界框及掩碼,最終由不同顏色的掩碼表征不同的實例對象(如圖3所示)。同時,此算法創新性地提出ROI Align連接層,應用線性插值法來減少前向傳播過程中的誤差,并根據式(1)來進行反向傳播,提高了掩碼預測的準確性。

式中:P表示整施工層的瓷磚鋪貼進度;i為施工層內房間序號;S為實際面積;p為像素數(像素面積);右上角標表示對象類別。

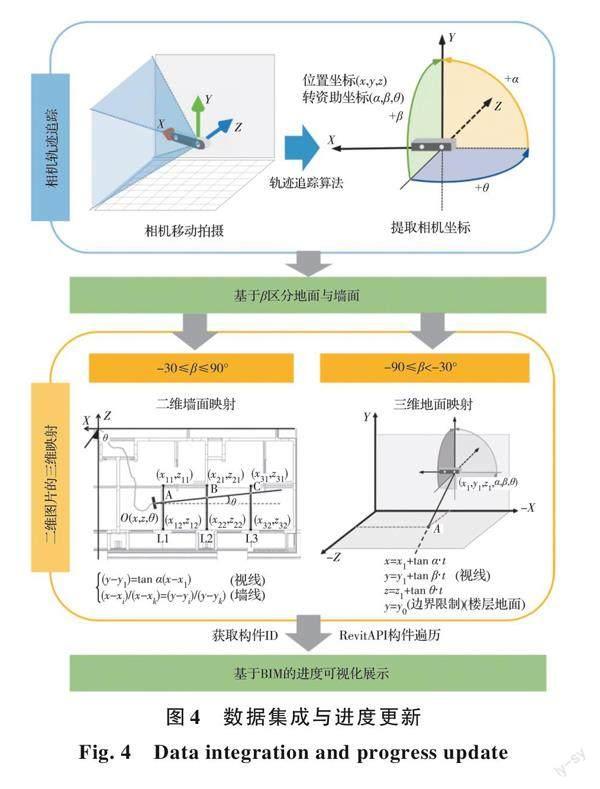

1.4 軌跡追蹤與BIM映射

依照圖4所示步驟確定拍攝對象和對應的BIM模型構件之間的映射關系,從而將施工進度結果集成至BIM模型:1)相機軌跡追蹤。將相機的拍攝路徑起點設定為BIM模型的原點坐標,手持相機持續拍攝墻面與地面。在此過程中基于Positional tracking算法(PT算法)來自動提取相機在移動路徑上的坐標信息(x1,y1,z1)與角度信息(α,β,θ);2)區分墻面與地面對象。根據俯仰角β的大小來區分拍攝對象為墻面還是地面,當-30°≤β≤90°時表示相機平視,拍攝墻面;當-90°≤β≤-30°時表示相機完全俯視,拍攝地面;3)二維圖片的三維模型映射。當拍攝墻面對象時,采用俯視平面坐標系,墻構件端點坐標和構件ID可在BIM模型中通過Revit API獲取。根據已知的相機平面坐標(x1,y1)與水平角θ能夠得到準確的平面視線方程,并求出該方程與墻線方程的交點。距離相機位置最近的交點所在的墻即為相機拍攝的構件,同時可以確定該構件在BIM模型中的ID。當拍攝地面對象時,采用空間坐標系,由已知的相機坐標(x1,y1,z1)與角度信息(α,β,θ)等參數可以得到準確的空間視線方程,此視線將與地面相交并可求得交點坐標,由于在BIM模型中每個房間地面的邊界信息和ID已知(通過Revit API獲取),因此,交點所在的構件即為相機所拍攝的地面,同時可以確定其在BIM模型中的ID。

在獲得所拍攝對象的施工進度和構件ID后,應用Revit API插件在BIM模型中通過構件ID進行遍歷,找到唯一的墻面或地面構件并導入進度信息。在構件的屬性欄中將自動顯示進度完成百分比,同時在三維視圖中將根據構件進度情況給構件外觀賦予不同顏色進行區分。

2 Mask R-CNN算法改進與提升

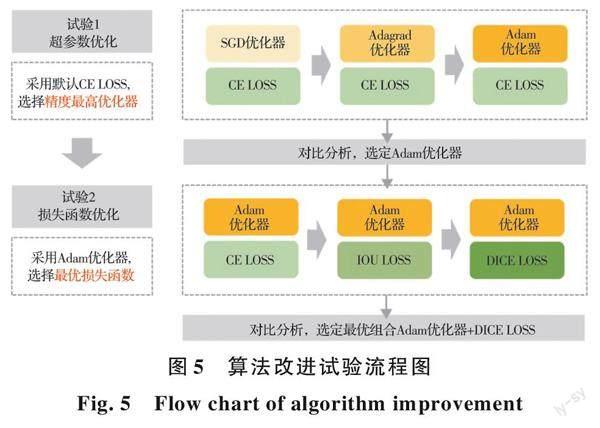

在深度神經網絡算法中,超參數和損失函數是影響算法效果的兩個重要因素,其中,超參數直接影響算法的訓練收斂過程,對模型性能有直接影響,而損失函數則決定了模型優化的方向,因為優化目標就是減小損失。因此,為提升模型分割精度,本研究針對本場景下數據特征單一、類別不平衡的特點從超參數優化和損失函數優化這兩方面對Mask R-CNN算法進行了如下改進與提升,如圖5所示。

2.1 超參數優化

由于數據集的數據量不足、特征單一,在未經超參優化的情況下易發生難以收斂或過擬合問題,因此,對于算法的收斂性能要求更高。分割算法常見的超參優化器包括SGD、Adagrad和Adam等。Mask R-CNN默認采用SGD優化器,其在數據特征單一的情況下易使得參數收斂到近似的局部極小值[22]且收斂速度偏慢,使得模型難以得到有效更新。Adagrad優化器相較于SGD優化器在參數空間平緩的方向上梯度下降更快,不易在局部收斂,在眾多小數據量的數據集上表現更優[23],這恰好契合研究的需求。但Adagrad優化器可能使得學習率下降過快,訓練后期無法更新。而相比于Adagrad優化器,Adam優化器采用更優的自適應步長的優化策略,在訓練后期仍保持較好的更新效率,這大大提高了算法收斂的速度[24]。

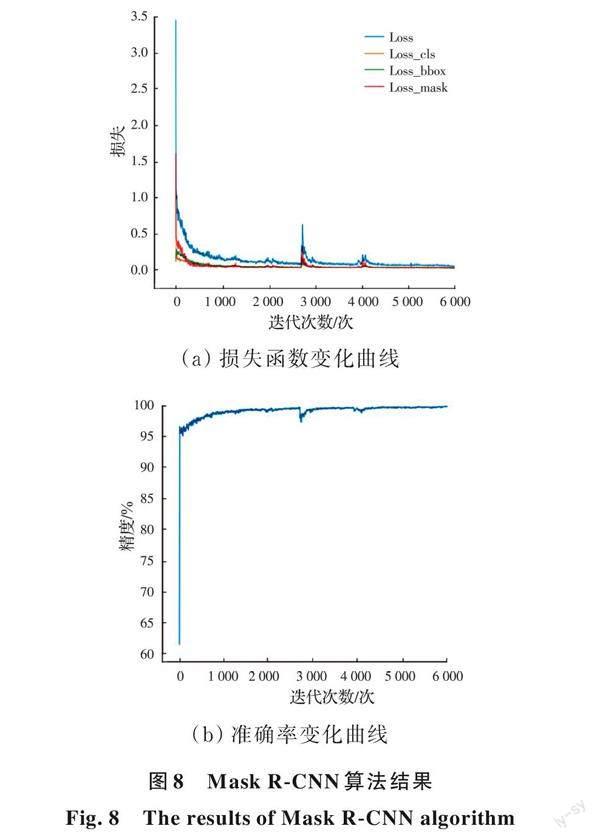

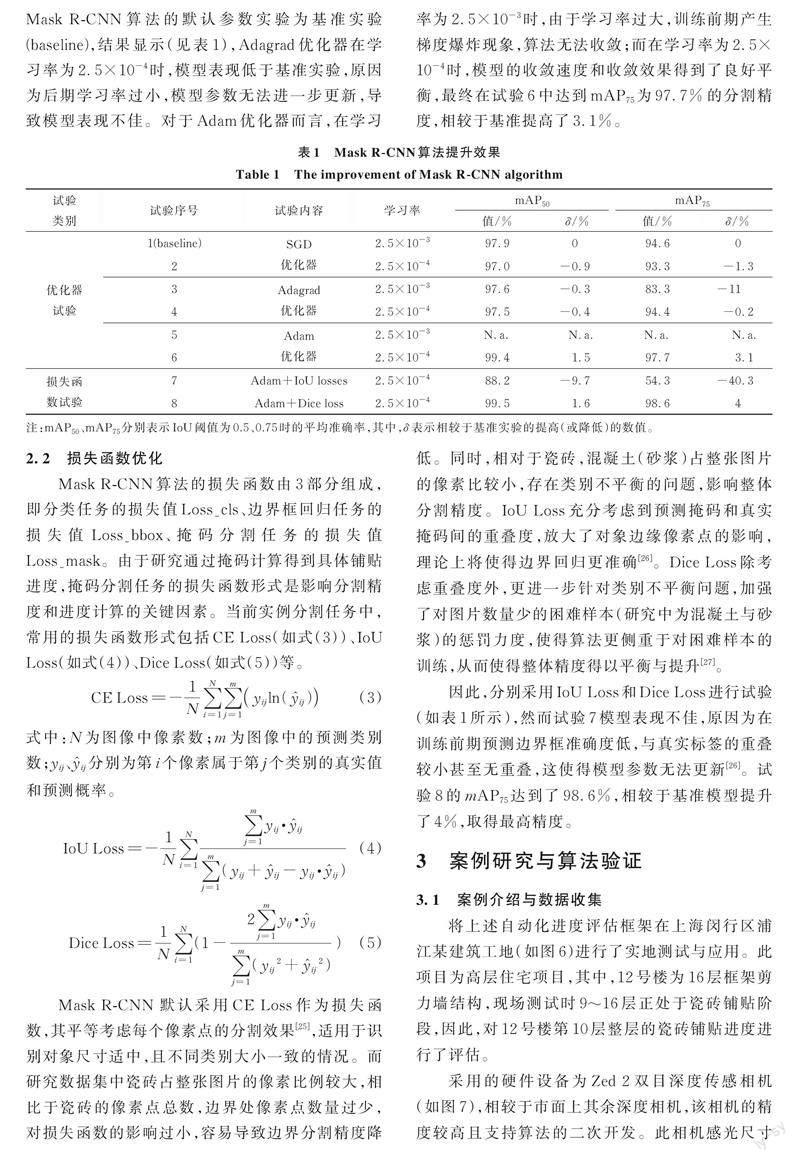

因此,應用3種優化器分別進行試驗,并以Mask R-CNN算法的默認參數實驗為基準實驗(baseline),結果顯示(見表1),Adagrad優化器在學習率為2.5×10-4時,模型表現低于基準實驗,原因為后期學習率過小,模型參數無法進一步更新,導致模型表現不佳。對于Adam優化器而言,在學習率為2.5×10-3時,由于學習率過大,訓練前期產生梯度爆炸現象,算法無法收斂;而在學習率為2.5×10-4時,模型的收斂速度和收斂效果得到了良好平衡,最終在試驗6中達到mAP75為97.7%的分割精度,相較于基準提高了3.1%。

2.2 損失函數優化

Mask R-CNN算法的損失函數由3部分組成,即分類任務的損失值Loss_cls、邊界框回歸任務的損失值Loss_bbox、掩碼分割任務的損失值Loss_mask。由于研究通過掩碼計算得到具體鋪貼進度,掩碼分割任務的損失函數形式是影響分割精度和進度計算的關鍵因素。當前實例分割任務中,常用的損失函數形式包括CE Loss(如式(3))、IoU Loss(如式(4))、Dice Loss(如式(5))等。

Mask R-CNN 默認采用CE Loss作為損失函數,其平等考慮每個像素點的分割效果[25],適用于識別對象尺寸適中,且不同類別大小一致的情況。而研究數據集中瓷磚占整張圖片的像素比例較大,相比于瓷磚的像素點總數,邊界處像素點數量過少,對損失函數的影響過小,容易導致邊界分割精度降低。同時,相對于瓷磚,混凝土(砂漿)占整張圖片的像素比較小,存在類別不平衡的問題,影響整體分割精度。IoU Loss充分考慮到預測掩碼和真實掩碼間的重疊度,放大了對象邊緣像素點的影響,理論上將使得邊界回歸更準確[26]。Dice Loss除考慮重疊度外,更進一步針對類別不平衡問題,加強了對圖片數量少的困難樣本(研究中為混凝土與砂漿)的懲罰力度,使得算法更側重于對困難樣本的訓練,從而使得整體精度得以平衡與提升[27]。

因此,分別采用IoU Loss和Dice Loss進行試驗(如表1所示),然而試驗7模型表現不佳,原因為在訓練前期預測邊界框準確度低,與真實標簽的重疊較小甚至無重疊,這使得模型參數無法更新[26]。試驗8的mAP75達到了98.6%,相較于基準模型提升了4%,取得最高精度。

3 案例研究與算法驗證

3.1 案例介紹與數據收集

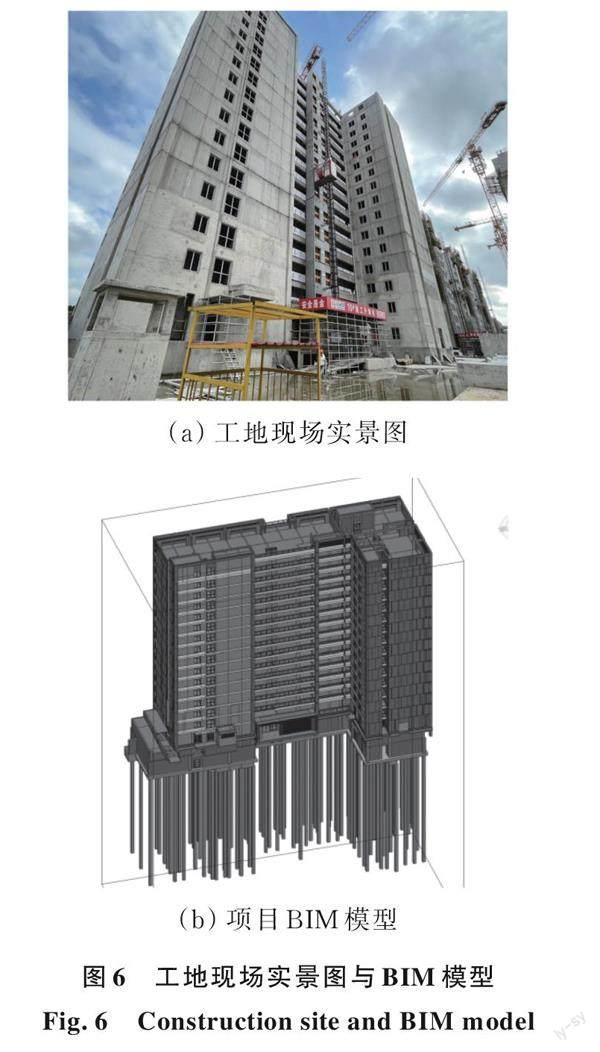

將上述自動化進度評估框架在上海閔行區浦江某建筑工地(如圖6)進行了實地測試與應用。此項目為高層住宅項目,其中,12號樓為16層框架剪力墻結構,現場測試時9~16層正處于瓷磚鋪貼階段,因此,對12號樓第10層整層的瓷磚鋪貼進度進行了評估。

采用的硬件設備為Zed 2雙目深度傳感相機(如圖7),相較于市面上其余深度相機,該相機的精度較高且支持算法的二次開發。此相機感光尺寸為175 mm×30 mm×33 mm (6.89"×1.18"×1.3"),深度范圍為0.2~20 m,景深場最大尺寸為110°(H)×70°(V)×120°(D),契合數據收集的硬件需求。

最終,收集到912張圖像,均用labelme軟件進行標注,并按照7:2:1比例將數據隨機劃分為訓練集(638張)、驗證集(184張)和測試集(90張)。

3.2 Mask R-CNN算法驗證

采用一塊RTX3090顯卡進行訓練,深度學習基本環境配置為cuda11.1+cudnn8.0+pytorch-gpu1.8.0+numpy1.21.0。Mask R-CNN算法應用了在MS-COCO數據集上預訓練的Resnet-101做特征提取網絡,基本參數設置如下:采用Adam優化器,恒定學習率為2.5e-4,batch size為4,共訓練100epoch,其余設置均采用默認參數[20]。

Mask R-CNN算法應用效果如圖8所示。其中,損失函數變化曲線和準確率變化曲線表征了模型的收斂效果與總體準確率,其中,在第3 000次迭代(iter)后,損失函數曲線波動趨于穩定,最終穩定在0.1左右,并且在驗證集上的最終準確率達到了99.5%。同時,采用實例分割任務常用的評價指標mean Average Precision (mAP)來表征模型在各類別對象上的平均檢測性能。在實例分割任務中,當實例預測掩碼與其真實掩碼的交并比IoU大于閾值時(0.5與0.75為圖像分割常用的IoU閾值),認為該實例為正確樣本,并以此計算整個測試集的精確度。最終模型在90張測試集的mAP50、mAP75分別達到99.5%、98.6%。

3.3 PT算法驗證

通過設置校準點的方式來驗證PT算法的準確度。如圖9所示,測試者手持Zed 2相機從原點出發,依次經過3個校準點,并最終回到原點。此3個校準點在路徑長度上均勻分布,且均位于門框中心或房間中心,因此,可獲得其在BIM坐標系下的實際坐標。同時,基于PT算法求,3個點的預測坐標。通過計算實際坐標和預測坐標的相對距離,以及起點和終點坐標的相對距離,可知實時預測路徑上平面坐標的最大偏差為60.82 mm。由于在室內場景下,目標對象即墻面和地面的長寬尺寸均大于3 m,最大平面坐標偏差僅占其2%,可忽略不計。

3.4 進度評估與BIM信息集成

基于室內連續空間施工進度智能評估框架,對12號樓第10層整層的瓷磚鋪貼進度進行評估。

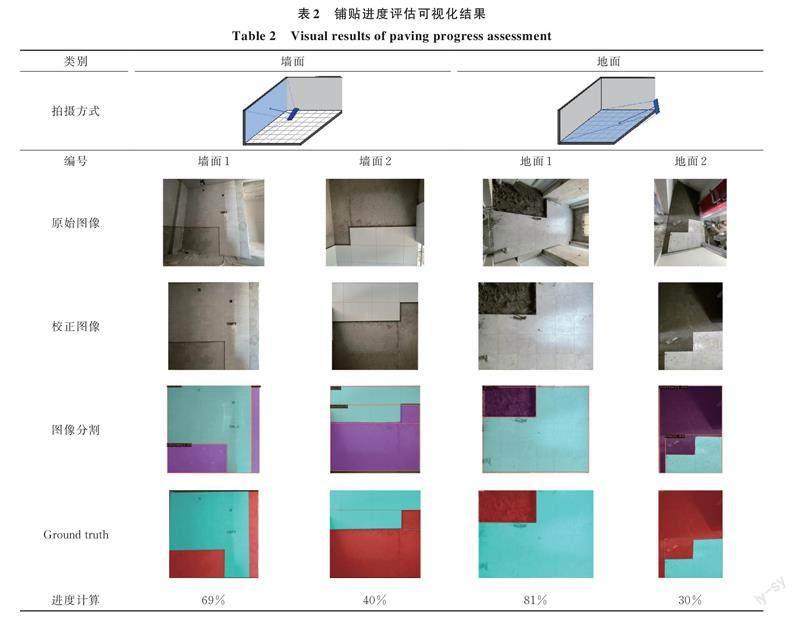

1)圖像分割結果可視化

針對墻面、地面兩類對象,表2展示了原始圖像、畸變校正、圖像分割、進度計算4個過程的可視化結果以及圖像分割的真實標簽(ground truth)。其中,兩墻面的鋪貼進度分別為69%、40%(鋪貼施工中),兩地面的鋪貼進度分別為81%、30%(施工鋪貼中)。

2)BIM模型信息集成與可視化

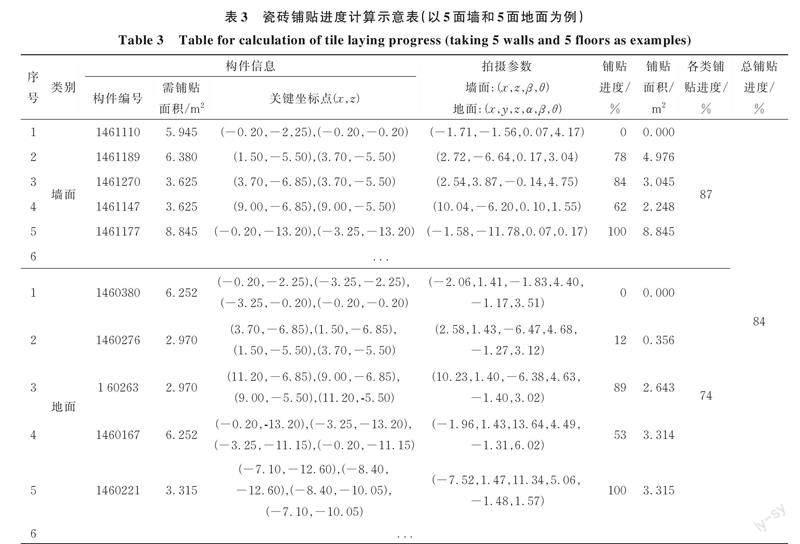

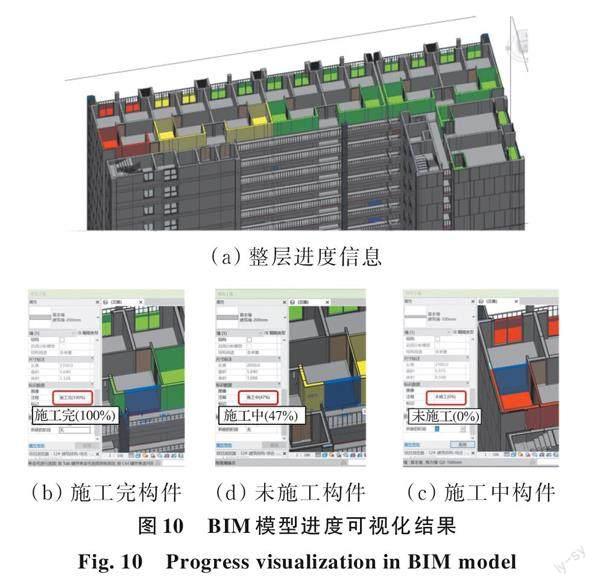

該項目僅有衛生間的墻面和地面,廚房墻面與陽臺地面需要瓷磚鋪貼,經統計第10層共有27面墻和50塊地面參與計算。應用提出的框架,該項目第10層墻面瓷磚鋪貼總面積為360.47 m2,已完成鋪貼面積為313.61 m2,整層施工進度為87%。地面瓷磚鋪貼總面積為109.10 m2,已完成鋪貼面積為80.73 m2,整層施工進度為74%。詳細的構件屬性及拍攝參數如表3所示。同時,在BIM模型通過顏色編碼對第10層的瓷磚鋪貼進行了可視化進度展示(如圖10所示),其中,未施工、施工中、施工完的對象分別以綠、黃、紅三色表示。同時,在構件屬性欄中可以獲取每個構件的進度完成信息。

4 結論

施工進度監控是工程項目管理的重要組成部分,傳統的施工進度管理人為主觀性強,自動化程度低。室內施工由于復雜的構件堆積和視線遮擋,其進度管理將耗費更多的時間和成本。以室內墻面地面瓷磚鋪貼為例,提出一套室內連續空間施工進度智能評估框架。基于改進的Mask R-CNN算法自動獲取施工進度百分比,并基于圖像軌跡追蹤算法將進度信息集成至BIM模型,為施工數字孿生奠定基礎。該框架在上海某高層建筑項目中進行了實地測試與應用,實現圖像高精度分割(mAP為98.6%),驗證了框架的可行性。相對于現有的室內飾面施工進度評估框架[17]僅能通過安裝固定攝像頭監控相機所在房間的地面鋪貼進度。該框架可通過一套可穿戴設備實現整個施工層的大范圍施工進度監控,且同時獲取墻面和地面在內的整體鋪貼進度,在進度監控面積和應用范圍方面得以拓展和提升。該框架不僅適用于室內瓷磚鋪貼,針對抹灰、刷涂等室內裝修工程同樣具有普適性。本文具備如下兩點創新性貢獻:

1)提出了一套連續空間室內瓷磚鋪貼進度自動化評估框架。通過圖片畸變校正、瓷磚像素分割與掩碼計算,自動獲取量化的進度信息并更新集成到BIM模型。

2)提出了一種基于圖像軌跡追蹤技術的室內移動拍攝方法,用于自動區分與同步計算水平(地面)與豎向(墻面)瓷磚鋪貼的進度,實現整個施工層的大范圍施工進度監控。

研究仍存在以下局限性:

1)數據集包含瓷磚僅包含白色瓷磚,在未來工作中需要擴大數據集的瓷磚類別,并建立抹灰、刷涂等多類型施工工序數據集以提高框架的遷移性。

2)圖像采集目前采用可穿戴設備巡檢,未來可在綜合考慮技術成熟度與成本問題的基礎上,結合室內導航設備實現自動化更高的進度巡檢。

參考文獻

[1]? LI X, XU J, ZHANG Q. Research on construction schedule management based on BIM technology [J]. Procedia Engineering, 2017, 174: 657-667.

[2]? 李勇. 施工進度BIM可靠性預測方法[J]. 土木建筑與環境工程, 2014, 36(4): 51-56.

LI Y. Analysis on predictive methods of BIM based on construction schedule reliability [J]. Journal of Civil, Architectural & Environmental Engineering, 2014, 36(4): 51-56. (in Chinese)

[3]? KAYHANI N, ZHAO W D, MCCABE B, et al. Tag-based visual-inertial localization of unmanned aerial vehicles in indoor construction environments using an on-manifold extended Kalman filter [J]. Automation in Construction, 2022, 135: 104112.

[4]? SHAHI A, SAFA M, HAAS C T, et al. Data fusion process management for automated construction progress estimation [J]. Journal of Computing in Civil Engineering, 2015, 29(6): 04014098.

[5]? KIM C, KIM H, RYU J, et al. Ubiquitous sensor network for construction material monitoring [J]. Journal of Construction Engineering and Management, 2011, 137(2): 158-165.

[6]? GOLPARVAR-FARD M, PE?A-MORA F, SAVARESE S. Automated progress monitoring using unordered daily construction photographs and IFC-based building information models [J]. Journal of Computing in Civil Engineering, 2015, 29(1): 04014025.

[7]? KIM S, KIM S, LEE D E. Sustainable application of hybrid point cloud and BIM method for tracking construction progress [J]. Sustainability, 2020, 12(10): 4106.

[8]? 黃仁, 馮阿瑞. 基于Ncut的自適應圖像分割方法[J]. 土木建筑與環境工程, 2013, 35(Sup2): 107-110.

HUANG R, FENG A R. Adaptive image segmentation method based on Ncut [J]. Journal of Civil, Architectural & Environmental Engineering, 2013, 35(Sup2): 107-110. (in Chinese)

[9]? 舒江鵬, 李俊, 馬亥波, 等. 基于特征金字塔網絡的超大尺寸圖像裂縫識別檢測方法[J]. 土木與環境工程學報(中英文), 2022, 44(3): 29-36.

SHU J P, LI J, MA H B, et al. Crack detection method based on feature pyramid network for super large-scale images [J]. Journal of Civil and Environmental Engineering, 2022, 44(3): 29-36. (in Chinese)

[10]? REJA V K, VARGHESE K, HA Q P. Computer vision-based construction progress monitoring [J]. Automation in Construction, 2022, 138: 104245.

[11]? MAHAMI H, GHASSEMI N, DARBANDY M T, et al. Material recognition for automated progress monitoring using deep learning methods [EB/OL]. 2020: arXiv: 2006.16344. https://arxiv.org/abs/2006.16344.

[12]? HUI L D, PARK M, BRILAKIS I. Automated brick counting for fa?ade construction progress estimation [J]. Journal of Computing in Civil Engineering, 2015, 29(6): 04014091.

[13]? KROPP C, KOCH C, K?NIG M. Drywall state detection in image data for automatic indoor progress monitoring [C]//2014 International Conference on Computing in Civil and Building Engineering. June 23-25, 2014, Orlando, Florida, USA. Reston, VA, USA: American Society of Civil Engineers, 2014: 347-354.

[14]? HAMLEDARI H, MCCABE B, DAVARI S. Automated computer vision-based detection of components of under-construction indoor partitions [J]. Automation in Construction, 2017, 74: 78-94.

[15]? ASADI K, HAN K. Real-time image-to-BIM registration using perspective alignment for automated construction monitoring [C]//Construction Research Congress 2018. April 2-4, 2018, New Orleans, Louisiana. Reston, VA, USA: American Society of Civil Engineers, 2018: 388-397.

[16]? DENG Y C, HAO H, HAN L, et al. Automatic indoor progress monitoring using BIM and computer vision[C]// 2017.

[17]? DENG H, HONG H, LUO D H, et al. Automatic indoor construction process monitoring for tiles based on BIM and computer vision [J]. Journal of Construction Engineering and Management, 2020, 146(1): 04019095.

[18]? PINHEIRO P O, COLLOBERT R, DOLLAR P. Learning to segment object candidates [EB/OL]. 2015: arXiv: 1506.06204. https://arxiv.org/abs/1506.06204.

[19]? BOLYA D, ZHOU C, XIAO F Y, et al. YOLACT: Real-time instance segmentation [C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV). Seoul, Korea (South). IEEE, 2019: 9156-9165.

[20]? HE K M, GKIOXARI G, DOLLáR P, et al. Mask R-CNN [C]//2017 IEEE International Conference on Computer Vision. Venice, Italy. IEEE, 2017: 2980-2988.

[21]? ZHANG Q H, CHANG X N, BIAN S B. Vehicle-damage-detection segmentation algorithm based on improved mask RCNN [J]. IEEE Access, 2020, 8: 6997-7004.

[22]? ALLEN-ZHU Z Y. Natasha 2: Faster non-convex optimization than SGD [C]// NIPS'18: Proceedings of the 32nd International Conference on Neural Information Processing Systems December 2018: 2680-2691

[23]? LYDIA A, FRANCIS S. Adagrad-An optimizer for stochastic gradient descent [J]. International Journal of Information Security, 2019, 6(5): 566-568.

[24]? BOCK S, GOPPOLD J, WEI? M. An improvement of the convergence proof of the ADAM-Optimizer [EB/OL]. 2018: arXiv: 1804.10587. https://arxiv.org/abs/1804.10587.

[25]? POLAT G, ERGENC I, KANI H T, et al. Class distance weighted cross-entropy loss for ulcerative colitis severity estimation [EB/OL]. 2022: arXiv: 2202.05167. https://arxiv.org/abs/2202.05167.

[26]? ZHENG Z H, WANG P, LIU W, et al. Distance-IoU loss: Faster and better learning for bounding box regression [J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 12993-13000.

[27]? MILLETARI F, NAVAB N, AHMADI S A. V-net: Fully convolutional neural networks for volumetric medical image segmentation [C]//2016 Fourth International Conference on 3D Vision (3DV). Stanford, CA, USA. IEEE, 2016: 565-571.

(編輯? 胡玲)

DOI: 10.11835/j.issn.2096-6717.2022.076

收稿日期:2022?04?19

基金項目:國家自然科學基金(52078374)

作者簡介:盧昱杰(1985- ),男,教授,博士生導師,主要從事智能建造、低碳建造與工程管理等研究,E-mail:lu6@tongji.edu.cn。

通信作者:魏偉(通信作者),男,博士生,E-mail:weiw@tongji.edu.cn。

Received: 2022?04?19

Foundation item: National Natural Science Foundation of China (No. 52078374)

Author brief: LU Yujie (1985- ), professor, doctorial supervisor, main research interests: intelligent construction, low-carbon construction and engineering management, E-mail: lu6@tongji.edu.cn.

corresponding author:WEI Wei (corresponding author), PhD candidate, E-mail: weiw@tongji.edu.cn.