基于改進YOLOv5的工業安全帽檢測

劉斯逸,何 青

(長沙理工大學電氣與信息工程學院,長沙 410114)

0 引言

在工廠生產和工地施工期間,車間和工地人員的安全問題是一個不容忽視的問題。鋼鐵廠車間存在著各種潛在的安全隱患,例如高溫、高空墜物、重物滑落等。這些潛在的安全風險對工廠施工人員的生命和財產造成了巨大的威脅。近些年來,有些企業沒有很好地規范職工使用安全防護用品,例如安全帽、手套等,為此付出了比較慘重的代價。近些年來,工廠企業和工地施工單位逐步將施工安全放在首要位置,安全繩、安全帽等防護用品的佩戴得到了本行業甚至是其他行業越來越多的重視。當下,對于安全帽佩戴檢測主要采用的是傳統人為視頻監控和傳感器監測的方式,容易出現人為疏漏,且費時、費力。

隨著深度卷積神經網絡快速發展,其在圖像分類、目標識別、目標檢測和跟蹤等多個領域展現出其特有的優勢。對于工業現場安全帽佩戴的檢測引起了學者的廣泛關注并對其投入了一定的研究。

閆蓉蓉[1]運用形態學和膚色分割法處理并定位出人臉位置,結合設計的EHSW-Adaboost算法定位出安全帽的位置。Wen等[2]提出基于改進Hough 變換的圓弧/弧檢測方法,并將其應用于ATM監控系統中的安全帽檢測。

Wu 等[3]將安全帽顏色分類,把目標切分成不同尺度,在此基礎上采用改進后的SSD 算法進行識別,取得了較好的效果。劉瑞昊等[4]在安全帽檢測中改進YOLOv3算法,對其特征融合進行改進,加入了Inception_shortcut 的結構。呂宗喆等[5]改進YOLOv5 算法,將輸入的圖片進行重疊切片,應用于安全帽檢測,提高對于小目標檢測的準確性。金源等[6]對YOLOv5 的預測輸出層進行改進,加入了二級目標的分類數量并對損失函數進行優化。Fang 等[7]提出了基于改進YOLOv2模型的方法,把密集網絡和特征提取網絡結合起來,利用MobileNet 輕量型網絡模型,提高了檢測精度和檢測速度。吳冬梅等[8]提出了改進的Faster R-CNN 的安全帽佩戴檢測方法,將骨干網絡中的5個網絡階段的特征圖進行融合,提高了對被檢測目標的檢測準確性。喬炎等[9]引入輕量型網絡Shuffletnetv2,在C3 模塊引入了Swin Transformer Block 模塊,在其中加入了CBAM_H 注意力機制,減少了參數量,提高了檢測的準確性。梅國新等[10]提出了基于EfficientDet 的用于檢測邊緣環境下面向復雜監控視頻背景的安全帽檢測算法。鄧開發等[11]通過將Faster R-CNN 目標檢測模型和深度特征流算法相結合,實現了對施工現場攝像頭監控視頻中安全帽的檢測,但容易受到外界復雜因素的干擾。王雨生等[12]提出了新的安全帽佩戴檢測姿態估計的方法。趙麗等[13]改進YOLOv5 模型,將PANet 改為BiFPN 并改進了邊界框損失函數。岳衡等[14]在YOLOv5 模型中加入了壓縮激勵層,和Soft-NMS 保留更多的預測框,進一步使用加權非極大值抑制法獲得更為準確的預測框,將其運用到工業安全帽檢測中。肖體剛等[15]提出一種基于改進SSD 的安全帽佩戴快速檢測算法,通過將SSD 中的骨干網絡VGG-16 替換為輕量型卷積神經網絡MobileNetV3-small,減少了模型的參數,同時使用特征金字塔結構將深層特征與淺層特征進行融合,提升了檢測精度。Liu等[16]提出新的SSD 算法,結合了Faster R-CNN和YOLO 的思想,有效地運用多尺度特征圖融合預測的思想,對于小目標檢測有一定的效果。

綜上所述,目前基于深度學習的目標檢測算法雖相比于傳統的檢測算法有了較大的改進,但對于復雜環境下的小目標檢測效果不佳。對于上述問題,本文以YOLOv5算法模型為基礎對模型結構以及損失函數進行調整和改進,改進后的算法模型相比于之前的對于小目標檢測的效果更好,檢測精度也有所提高。

1 YOLOv5網絡結構模型

本文以YOLOv5 算法模型為基礎,算法模型主要由以下三個部分組成,主干網絡(Backbone)即特征提取網絡、頸部(Neck)即PANet特征融合模塊和頭部(Head)預測模塊。如圖1所示。

圖1 YOLOv5網絡結構圖

主干特征提取網絡主要由一個SPPF 層和多個卷積和C3 層組成,C3 模型中引入了Cross Stage Partial Network(CSP)模塊,用于加速特征圖的計算,并提高模型的準確性,運用到了殘差連接使得模型能夠更好地學習目標的特征信息。空間金字塔池化(SPPF)位于特征提取網絡的最后一層,即輸出端,其主要作用是由于輸入的圖像尺寸總是不能滿足輸入時要求的大小,通常需要進行手動裁剪、拉伸或者縮放,但這種做法并不好,對于圖像的原始特征造成了一定的影響,損失了圖像原始的特征。SPPF 層通過將候選區的特征圖劃分為多個不同尺寸的網格,對每個網格內都做最大池化,將提取到的任意大小的特征圖轉換成固定大小的特征向量。

頸部,即特征融合層(PANet),采用自下而上和自上而下的特征金字塔融合方式,使得模型能夠獲得不同尺度目標特征圖的特征信息,從而學習到更多的目標特征信息,提高了模型檢測目標的精度,有效地解決了多尺度特征融合的問題。

預測模塊(Head)采用1×1 的卷積預測輸出,利用置信度損失函數、目標定位損失函數、目標類別損失函數判定目標預測框和真實框之間的差距,再通過非極大值抑制(NMS)濾除多余的選框,得到最終的預測輸出框。

相比于之前的YOLO 系列的算法模型,YOLOv5 在檢測精度和檢測速度上有了很大的提升,PANet模塊的引入使得算法模型能更好地學習到不同尺度的目標特征信息,改善了檢測的精度,能夠相對較好地預測中小目標,但對于本文所述的目標檢測任務,由于施工現場復雜的環境容易受到光照、時間等因素的影響,且被檢測的目標大多為中小目標,YOLOv5算法模型以及當下一些主流的算法對于中小目標以及密集型目標檢測效果不佳,存在漏檢、錯檢的問題。

2 Mosaic數據增強

YOLOv5輸入端,即數據預處理端主要通過選框的聚類選擇出合適標準的anchors,圖像的自適應縮放以及數據增強操作。由于被檢測的目標大多為中小目標,在復雜環境下,被檢測目標的精度會受到一定程度的影響,因此為了提高檢測的精度,增加一張圖像中目標的數量,豐富數據的多樣性,采用Mosaic 方法對輸入圖像進行數據增強。Mosaic 會從訓練集中隨機選取四張不同的圖片,隨機初始化拼接的中心點,將四張圖片通過裁剪、縮放、翻轉等操作,拼接成一張大圖。通過這種方式,可以有效地擴展訓練集規模,提高模型的泛化能力和檢測精度,較為有效地提高了圖片中被檢測目標的數量。Mosaic 數據增強處理后的圖像如圖2 所示。在訓練過程中有50%的概率會采用Mosaic數據增強的方法,不難發現通過此種方式處理后的數據,圖像中被檢測目標的數量有了明顯的增加。

圖2 Mosaic數據增強處理后的圖像

本文采用kmeans++聚類方法對選框進行聚類,分別得到9種不同的選框用于預測三個不同預測特征層中的小、中、大目標。其anchors 大小分別為[10,13,16,30,33,23],[30,61,62,45,59,119]和[116,90,156,198,373,326]。再將聚類選擇出的anchors 以及數據增強處理后打包得到的圖像數據送入模型的主干網絡中進行特征提取。

3 YOLOv5算法改進

由于被檢測的目標安全帽大多為中小目標且較為密集,YOLOv5算法模型的檢測精度受到施工現場復雜環境影響不是很高。因此有必要在主干網絡中引入注意力機制,來提升網絡模型對于被檢測目標安全帽相關特征信息的關注度,學習到更多的目標特征信息,從而提升網絡的檢測精度。

注意力機制是一種基于神經網絡的模型模塊,用于增強模型對輸入中重要部分的關注度和記憶能力。在注意力機制中,計算輸入中每個元素的權重,這些權重可以通過各種方法得到,如加權平均、向量相似度、自適應加權等,增大有效特征信息的權重參數,來讓算法模型更好地、有目的地抓住需要關注的目標特征信息,忽略無關信息,從而提高算法模型的泛化能力和魯棒性,以及對于被檢測目標的關注度,進而提升檢測精度。

3.1 SKNet注意力機制模塊

由于被檢測的目標主要為小型目標,故需要對Neck 模塊融合后的特征進行進一步篩選,在Head 預測小目標1×1 卷積核輸出預測之前加入SKNet 注意力模塊,以此提高模型對于小目標檢測的魯棒性。SKNet[17](Selective Kernel Networks)是卷積核注意力機制,可以讓網絡自適應地選擇合適的卷積核,主要通過引入選擇性注意力機制來提高模型的準確性和泛化能力。具體來說,在SKNet 中,每個卷積層都包含多個不同大小的卷積核,不同大小的感受視野(卷積核)對于不同尺度(遠近、大小)的目標會有不同的效果,為小目標的檢測提供指導。通過選擇不同大小的卷積核,來適應不同尺度的特征,使得不同的圖像能夠得到具有不同重要性的卷積核,提高模型對于檢測小目標的能力,從而提高模型的靈活性和表達能力。同時,SKNet還引入了通道注意力機制,用于進一步篩選具有重要信息的特征通道,從而加強模型對關鍵特征的捕捉和記憶。由于引入了注意力機制,算法模型的深度增加,容易出現梯度消失和梯度爆炸的問題,殘差連接的引入能更好地提升模型的表達能力和性能。同時,殘差連接跨層進行,可以有效地幫助模型更好地學習目標特征,在訓練時可以使得模型更加容易收斂,減少訓練所需的時間,引入殘差連接的SKNet如圖3所示。

圖3 帶有殘差連接的SKNet模塊

將輸入的特征圖分別通過一個3×3 的卷積和5×5 的卷積生成兩個特征圖,分別為U1 和U2。然后將這兩個特征圖相加,生成新的特征圖U,再通過全局平均池化(Fgp)生成1×1×C 的特征圖S,再通過一個全連接層(Ffc 函數)生成d×1 的向量Z,利用Softmax 對Z 向量進行歸一化,這時每個通道對應一個權重值,其大小代表了通道的重要程度,再將得到的權重值分別乘以對應的特征圖U1 和U2,得到U3 和U4。將兩個特征圖進行融合,得到帶有通道權重值的特征圖V,最后再將輸出的特征圖V與輸入特征圖X 相加得到模塊的最終輸出。其最終輸出的特征圖相比于輸入的特征圖X 經過了特征信息的篩選和提煉,融合了不同感受野的信息。該模塊的引入使得模型可以更多地關注小目標,提高了模型對于小目標的檢測精度。

3.2 CA注意力機制模塊

相較于小目標,算法模型對于中等目標的檢測效果有了一定的提升,但中等目標具有空間方向和位置的敏感性。雖然通道注意力會較為顯著地改善算法模型的性能,但其通常會忽略對中等目標生成空間選擇性注意力圖非常重要的位置信息且參數量較大,考慮到算法模型的復雜度,本文針對中等目標預測1×1 的卷積輸出層前引入了CA注意力機制。

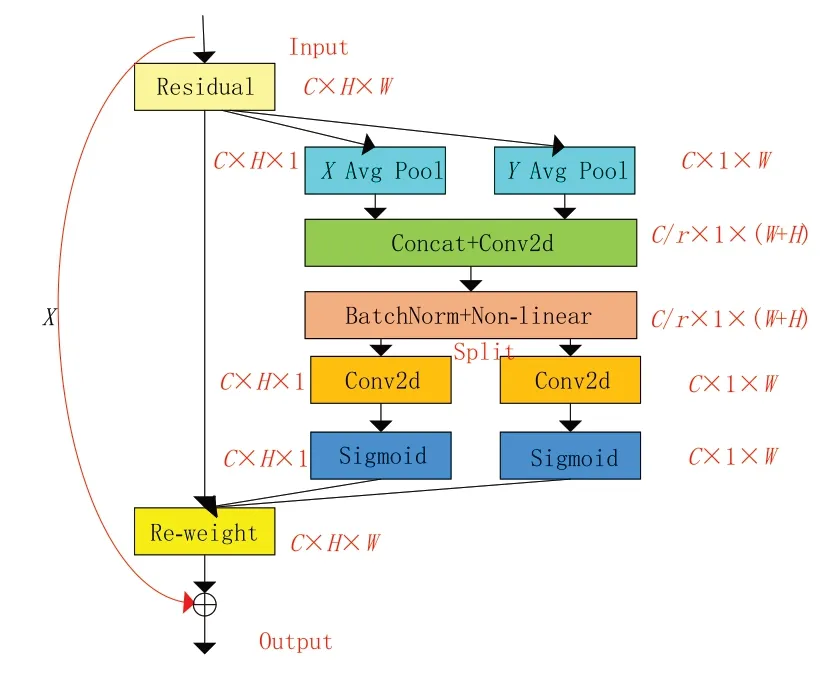

CA[18](coordinate attention)注意力機制是較為簡單和靈活的注意力機制,在幾乎不帶來額外的計算開銷的前提之下,可以顯著提升模型對于中等目標的關注度。CA 注意力機制能捕獲跨通道的信息,還可以獲取方向和位置的信息,其將通道注意力分解為兩個沿著不同方向進行聚合,形成一對方向感知和位置敏感的特征圖,它們可以互補地運用以增強輸入特征圖對于中等目標的檢測能力,使得算法模型更加精準地定位和識別圖像中重要的目標信息,提升網絡模型的檢測精度。最后,和引入SKNet 注意力模塊一樣,考慮到算法模型深度和梯度消失的問題,引入了殘差連接。引入殘差連接的CA 注意力機制模塊如圖4所示。

圖4 帶有殘差連接的CA模塊

將輸入的特征圖在w 和h方向進行平均池化操作,通過此兩種池化操作使得注意力機制模塊可以很好地捕捉到沿著一個空間方向的長程依賴,同時保存沿著另一個空間方向的精確位置信息,相比于一般的注意力機制,這樣可以使得網絡更準確地定位感興趣的目標區域。如圖5所示,將兩個方向上的特征圖拼接以后送入1×1 卷積中進行降維處理,然后通過BN 和非線性激活函數,切分成不同方向的張量卷積后進行Sigmoid 處理,輸出對于輸入特征圖的權重系數,再與原輸入相乘,最后再將帶有權重系數的特征圖與原輸入通過殘差連接相加得到模塊的最終輸出。此注意力模塊完成了對于輸入特征圖豎直和水平方向上的自注意力,改善了算法模型對于中等目標的檢測精度。

圖5 帶有殘差連接的ECA模塊

3.3 ECA注意力模塊

由于被檢測的大目標在數據集中數量較少,為進一步提高對于模型的檢測精度和能力,本文在Head 模塊1×1 卷積預測大目標輸出之前,引入了ECA注意力機制模塊。

SE 注意力機制首先對輸入特征圖進行了通道壓縮,該做法對于學習到通道之間的依賴關系造成一定的影響。ECA[19](efficient channel attention)注意力機制與之不同,其通過應用一維卷積層將全局特征向量轉換為注意力權重向量,并將其應用于特征圖上,從而提高重要特征通道的權重。如圖5 所示,ECA 注意力機制舍去了降維,直接將輸入特征圖X 通過全局池化變成1×1×C的張量,再用1×1卷積對輸入的張量進行通道得分的學習,其中k=3 或5 自適應地選擇卷積核的大小,然后經過Sigmoid 激活函數獲得對于各個通道的權重參數,將獲得的權重值與原始輸入特征圖對應元素相乘,得到帶有通道權重值的特征圖。相較于其他注意力機制,ECA 注意力機制具有計算速度快、參數量少等優點,并且不需要顯式地計算特征之間的相關性。同時也考慮到模型深度和梯度消失以及更好學習目標特征的問題,引入了殘差連接,引入殘差連接的ECA模塊如圖5所示。

3.4 損失函數的改進

YOLOv5算法模型的損失函數主要由目標類別預測損失(Class probability loss)、置信度損失(Confident loss)和邊界框定位損失(Location loss)三部分組成。其中類別損失和置信度損失都采用二分類交叉熵損失(BCEloss),邊界框定位損失原算法中采用了GIoU 損失。GIoU 損失計算的公式如下所示:

GIoU相比于直接計算IoU值引入了預測框和真實框的最小外接框,但當兩個預測框高寬相同,且處于同一水平面或者是一種包含關系時,GIoU就退化為IoU。此外,GIoU在兩框相交的時候在水平和豎直方向上收斂速度較慢,回歸不夠準確。本文采用DIoU損失替換原算法中計算定位損失的方式,如圖6所示。

圖6 DIoU計算圖

其中,c為真實框和預測框外接最小矩形的對角線,d為真實框和預測框中心點的距離。DIoU采用直接回歸兩個框中心點的歐式距離,加速收斂,加快了算法模型的訓練速度。DIoU損失函數的基本公式如下所示:

4 算法模型訓練及結果

4.1 實驗環境

本文采用的操作系統為Windows10,所使用的GPU為ATX A4000,顯存大小為16 GB,運行內存大小為25 GB,內存32 GB。算法模型訓練基于深度學習框架PyTorch 和Python3.8 編程語言,利用cuda11.6 在模型訓練過程中對GPU 進行加速。

4.2 數據集以及實驗參數設置

本文訓練時所用到的數據集為開源的數據集(SHWD),此數據集主要包含兩個大類:person 和helmet,共7851 張圖像,含有9044 個合理佩戴了安全帽的目標即正樣本和111514 個未合理佩戴安全帽的目標。由于原始數據集的圖像標注信息以VOC數據格式進行存儲,因此,將Python 腳本VOC 格式的數據集轉換成了YOLO格式。同時,對原有的數據集中的圖像進行一定的篩選,最終得到6056 張圖像,將圖像按照9∶1 的比例劃分為訓練集和驗證集,得到訓練集5450張圖像,驗證集606張圖像。

實驗訓練設置的超參數如下:初始學習率為0.001,采用余弦退火函數調整學習率,學習率動量0.937,權值衰減量為0.0005,考慮到計算機資源的實際情況,設置epoch 值為100,batch size 為16,算法模型對訓練的數據集有0.5的概率會采用Mosaic數據增強。

4.3 指標評價

對算法模型的評判主要通過精確率P、召回率R、F1 分數以及均值平均精度mAP等來綜合考量。F1 的取值為0~1 之間,其大小反映了算法模型的性能,綜合考慮了算法模型的查準率和查全率。mAP即均值平均精度,在平均精度的基礎上根據類別數量求平均值,考慮訓練好的算法模型在數據集所有類別上的預測性能好壞。F1與mAP值計算公式如下:

其中TP、FP、FN分別為預測正確的正樣本、負樣本錯誤地預測為正樣本、預測正確的負樣本。

4.4 實驗結果分析

本文將改進前的YOLOv5算法和改進之后的YOLOv5算法進行對比實驗,在一臺實驗機器上訓練100 輪。改進前后的YOLOv5 算法實驗結果如圖7所示。

圖7 實驗結果對比

從實驗數據不難看出,改進后的YOLOv5算法模型相比于改進之前,對于被檢測目標的P值提高了0.4 個百分點,達到了93.43%,R值提高了2.13 個百分點,到達78.79%,mAP值提升了1.6個百分點,達到83.78%,F1值提高了1個百分點。多項實驗數據表明,改進后的YOLOv5算法模型各項性能指標優于改進前的算法模型,對于中小目標安全帽的檢測精度有了較大的提升,預測的準確度也得到了提高,能夠更好地預測實際工程中安全帽的佩戴問題,證明改進后的YOLOv5算法模型的可行性。對比結果如圖8所示。

圖8 算法對比結果

5 結語

利用測試集同時結合施工現場實際情況進行驗證,發現改進后的YOLOv5算法模型對目標的識別精度有了一定的提升,進一步說明了改進的可行性。