通過美顏保護人臉隱私

汪 濤,張玉書+,趙若宇,溫文媖,朱友文

1.南京航空航天大學 計算機科學與技術學院,南京 211106

2.江西財經大學 信息管理學院,南昌 330013

隨著在線社交網絡的發展,人們日常生活的社會交往和信息交換方式發生了巨大的改變。目前,越來越多的人傾向于在社交網絡上共享圖像以表達自己和與他人互動。然而,在線圖像中作為通用身份標識符的人臉信息一經泄露,將對用戶隱私構成巨大威脅。一方面,不可信第三方在社交網絡中任意收集用戶的人臉圖像來構建人臉庫,之后依托于高性能的人臉識別系統對用戶行為進行大規模的監控。另一方面,人臉圖像中包含的大量軟生物屬性(如性別、年齡、種族等)可以被自動識別技術提取并與現有數據庫進行匹配,從而進一步推斷用戶的敏感信息。出于隱私考慮而簡單地限制發布人臉圖像盡管是一個可行的解決方案,但極大地降低了用戶分享圖片的樂趣,開發基于深度學習的隱私保護技術來解決技術本身帶來的問題會更有效。

為保護社交網絡上用戶的人臉隱私,一類方法[1-5]旨在生成一個參考人臉來替代原始人臉從而完全去除可識別信息。雖然這類方法達到了令人滿意的去識別效果,但是由于生成人臉和原始人臉的視覺外觀存在顯著的差異,使得用戶的好友也無法在視覺上感知圖像中人臉的身份,違背了用戶上傳個人圖像的初衷。

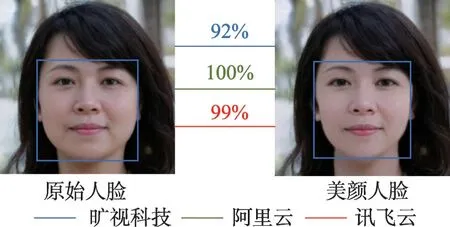

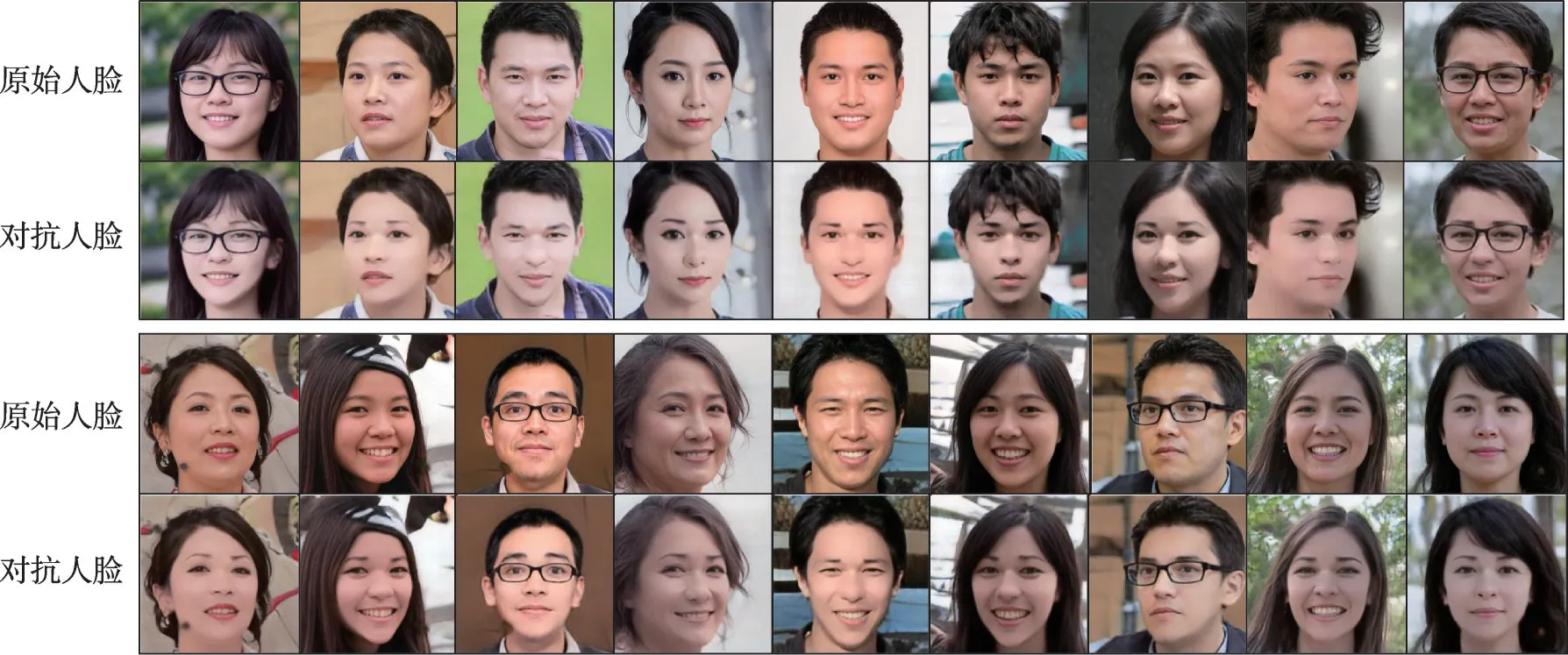

因此,另一類方法[6-11]通過在面部區域添加具有對抗性的擾動,以躲避未知識別系統的檢測而不阻礙人類對身份的感知。TIP-IM(targeted identityprotection iterative method)[8]允許用戶在分享個人圖像之前為人臉佩戴上具有對抗性的隱私面具。通過這種方式,圖像中人臉的身份無法被未知人臉識別模型以及商業應用程序編程接口(application programming interfaces,APIs)所識別,但是依舊可以被人類感知。考慮到特定于圖像的隱私面具不僅耗時而且安全性較低,OPOM(one person one mask)[10]利用優化理論為用戶生成一個定制的隱形斗篷,其可以被添加到該用戶的所有圖像中,進一步提高了隱私保護的實時性和實用性。盡管如此,如圖1 所示,這些方法生成的對抗性人臉依舊存在能被人眼感知的不自然擾動,影響了用戶的視覺體驗。為了緩解擾動帶來的不良視覺效果,AMT-GAN(adversarial makeup transfer generative adversarial network)[11]利用廣泛可見的化妝作為布局擾動的關鍵思想,合成了具有目標人臉妝容和目標人臉身份的對抗人臉。但是化妝對普通用戶不具有通用性,一般來說,成年女性更喜歡化妝,而兒童、老人以及成年男性對化妝較為反感。

圖1 本文方案與主流方案的結果圖Fig.1 Results of proposed scheme and mainstream schemes

目前,短視頻記錄平臺、直播分享平臺等都支持人臉自動美顏的功能。加上用戶自身對美的追求,在社交網絡平臺發布自拍之前對人臉進行適當的美顏也變得越來越普遍。不同于化妝主要對眼影和唇彩進行濃烈的渲染,人臉美顏[12-14]在于去除皮膚瑕疵以及微調五官的比例,因此適當的美顏更容易被用戶所接受。如果能夠通過人臉美顏實現對人臉的隱私保護將具有重大的現實意義。如圖2所示,現有人臉美顏技術生成的結果注重保留原始身份,使得美顏人臉與原始人臉的身份相似度較高,因此無法直接用于人臉隱私保護。

圖2 美顏人臉與原始人臉的身份匹配置信度Fig.2 Confidences of identity matching between beautified face and original face

為此,本文考慮通過人臉美顏來遮蓋擾動信息,從而提高對抗性人臉在視覺上的自然性。總的來說,本文主要貢獻如下:

(1)探究了通過美顏來保護人臉隱私的可能性,這相對化妝來說更易被用戶所接受;

(2)提出了一種基于美顏的身份對抗方案,通過在人臉上產生類似美顏的擾動,以對抗未知的人臉識別系統;

(3)為身份損失添加了對抗性閾值,防止身份特征的過度偏離而導致的人臉區域扭曲。

1 本文方法

本文提出了一種身份對抗方案Adv-beauty,該方案能夠在全臉產生類似美顏的擾動,換句話說美顏帶來的像素變化遮蓋了擾動信息,緩解了擾動信息帶來的不良視覺效果。此外,該方案能夠學習更好的泛化特征來對抗未知人臉識別系統。

1.1 Adv-beauty框架

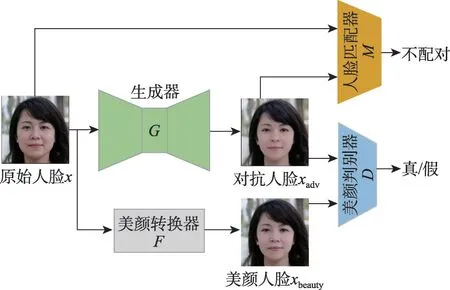

如圖3 所示,Adv-beauty 由四個組件組成,分別是生成器G、美顏轉換器F、美顏鑒別器D和人臉匹配器M。首先,原始人臉x∈RH×W×3輸入到美顏轉換器中生成美顏人臉F(x)=xbeauty,同時也輸入到生成器中生成對抗人臉G(x)=xadv。隨后美顏鑒別器判定美顏人臉xbeauty的美顏效果為真,判斷對抗人臉xadv的美顏效果為假。生成器通過與鑒別器進行多輪對抗性的訓練,最終生成的對抗人臉xadv也會具有美顏效果。此外,人臉匹配器為對抗人臉xadv添加了身份特征約束,使得生成器鼓勵對抗人臉xadv的身份特征遠離原始特征,從而使得人臉匹配器輸出結果為不匹配。在人臉匹配器和美顏鑒別器對生成器的雙重約束下,生成器最終會生成具有美顏效果的對抗性人臉。

圖3 Adv-beauty框架圖Fig.3 Framework of Adv-beauty

1.2 模型結構

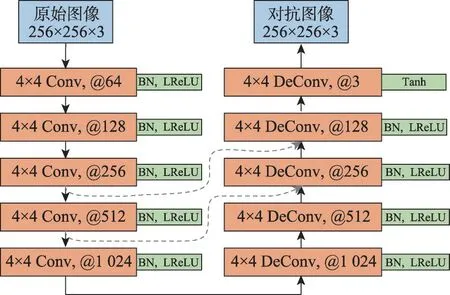

1.2.1 生成器

生成器的網絡結構如圖4所示,該結構參考了自動編碼器的架構,以有效在高級特征層中處理原始人臉,使得生成的對抗性人臉更加自然。具體地,生成器接受輸入大小為256×256×3 的人臉圖像。輸入圖像經過連續的5個核尺寸為4和步幅為2的卷積層(Conv)用于下采樣,得到了大小為8×8×1 024的高級特征;之后,高級特征經過5 個核尺寸為4 和步幅為2的轉置卷積層(DeConv)用于下采樣,最初輸出256×256×3 大小的對抗人臉圖像。其中,在每個卷積層后面添加了一個批歸一化層(batch normalization,BN)和一個LeakyReLU 激活層(LReLU),用來穩定和加速模型的訓練。特別地,最后一個轉置卷積層只添加了Tanh 激活函數以將特征映射為RGB 圖像。此外,在卷積層和轉置卷積層之間添加了U-Net中的跳躍連接層,緩解了梯度消失的問題和深度網絡訓練中的網絡退化,同時保留了網絡中間層輸出的低級特征,例如顏色、輪廓等。

圖4 生成器的網絡結構圖Fig.4 Network structure diagram of generator

1.2.2 美顏轉化器

美顏轉化器通過去除皮膚瑕疵和微調五官比例將原始人臉轉化為美顏人臉。現有的美顏技術較為成熟,它們采用基于深度學習的方式來檢測人臉和定位人臉關鍵點,之后運用計算機圖像學的方法來實現人臉的美顏。本文方案采用曠世科技的自動美顏API(https://www.faceplusplus.com.cn/face-beautify/)作為美顏轉化器。

考慮到高強度的美顏會明顯改變原始人臉的外觀,使得原始身份無法被人類所識別,因此本文方案固定了美顏轉化器的相關參數。以本文方案采用的曠視科技美顏API為例,設定美白程度、磨皮程度、瘦臉程度、大眼程度均為50%。

1.2.3 美顏鑒別器

美顏鑒別器需要鑒定對抗人臉的美顏效果為假以及美顏人臉的美顏效果為真。不同于傳統鑒別器[15]利用全連接層輸出真或假的分類結果,PatchGAN[16]被設計成全卷積的形式對每個感受野輸出分類結果,更加關注人臉的局部結構和細節特征,將更利于對美顏效果的評估。因此選用PatchGAN 作為美顏鑒別器。

1.2.4 人臉匹配器

與大部分人臉隱私保護的工作一致,采用預訓練的人臉匹配器作為輔助模型來幫助生成器的訓練。由于需要對抗的目標敵手是未知的識別模型,選取了兩種先進的人臉匹配器FaceNet[17]和Cosface[18],它們都在公共人臉圖像數據集上具有高準確度,通過集成它們的預測結果來學習更泛化的特征以對抗未知識別模型。

1.3 損失函數

Adv-beauty 在三種損失的加權和下進行監督訓練,它們分別是對抗損失、身份損失和重構損失。接下來,詳細介紹每種損失的細節。

1.3.1 對抗損失

生成對抗網絡中采用的對抗損失能夠增強生成圖像的清晰度和視覺質量。作為生成對抗網絡的變種,Adv-beauty中的對抗損失目的是學習美顏人臉的分布,從而引導生成器生成具有較強真實感和美化效果的人臉圖像。同時,采用WGAN-GP(Wasserstein GAN gradient penalty)[19]中的梯度懲罰項來提高判別器的擬合能力,以穩定對抗訓練的過程。具體地,美顏鑒別器的輸入為一對圖像,當輸入圖像對為(x,xadv)時,輸出為假;當輸入圖像對為(x,xbeauty)時,輸出為真。生成器和美顏鑒別器的對抗損失分別表示為:

其中,x和xadv分別表示原始人臉和對抗人臉,D(·)表示美顏鑒別器預測輸入的人臉是否為美顏人臉的概率,Ex(f(y))表示在給定條件變量y的情況下f(y)在其分布下的期望值,λgp為梯度懲罰的系數。

1.3.2 身份損失

為了使對抗人臉不被未授權的人臉識別器所檢測,加入人臉匹配器來監督生成器的訓練,使得對抗人臉與原始人臉的輸出結果為不匹配。主流方案采用最大化原始人臉身份特征和對抗人臉身份特征的余弦相似度來實現對抗過程,身份損失為:

其中,M(?,?)為人臉匹配器輸出的身份特征相似度。

由于公式未能控制對抗人臉的身份變化程度,當人臉相似度越來越低時,對抗人臉的部分區域會發生顯著的變化,如鼻子扭曲及明顯斑點。考慮到現有人臉識別系統多采用匹配閾值來判定兩張人臉是否匹配,因此只需要控制身份相似度低于匹配閾值即可完成對抗。為此,本文同樣設置了一種對抗性閾值,當身份相似度低于該閾值時,身份損失便不再下降,將公式表示的身份損失修改為:

其中,ξ為對抗性閾值。對抗性閾值會小于匹配閾值,在本文中根據實驗結果,將ξ設置為0.5。

此外,為進一步提高對抗人臉的可遷移性以對抗未知識別系統的攻擊,在訓練中使用增強輸入多樣性的集成訓練策略。具體地,聯合FaceNet 和Cosface識別模型的輸出試圖逼近未知目標模型的決策邊界。通過調整圖像的大小以及添加一定的高斯噪聲作為輸入的變化函數來增強輸入的多樣性。因此,進一步將公式表示的身份損失修改為:

其中,MF(?)和MC(?)分別表示FaceNet 和Cosface 輸出的結果,T(?)表示輸入的變化函數,α控制了不同集成模型對結果的影響程度,本文中設置為0.5。

1.3.3 重構損失

添加重構損失用來保留原始圖像的更多細節,同時也使得對抗人臉的美顏效果更好。具體地,采用美顏人臉和對抗人臉的平均絕對誤差L1損失來保留更多的圖像細節:

1.3.4 總損失

最終,生成器和鑒別器的總目標損失定義為:

其中,λ1和λ2分別為身份損失和重構損失的權重,以平衡生成器的輸出結果。

2 實驗結果與分析

2.1 實驗設置

2.1.1 數據集

由于不同種族對美的定義不同,本實驗只針對黃種人的美化對抗開展了實驗。實驗采用Seepretyface數據集用于訓練和測試,該數據集包含了50 000張圖像且涵蓋了不同性別、不同年齡段以及不同顏值的人臉。原始圖像分辨率為1 024×1 024,選取了數據集中的10 000張圖像用于訓練和1 000張圖像用于測試。

2.1.2 實驗環境及參數設置

本文基于Pytorch 深度學習框架,采用NVIDIA GeForce RTX 3080 GPU進行計算。訓練時采用Adam優化器,其中β1=0.5,β2=0.99。所有訓練圖像調整至256×256分辨率,輸入圖像的批量大小設置為4,初始學習率設置為0.000 2,之后調整為0.000 1。訓練中,首先不加入身份損失,讓生成器和鑒別器交替訓練,設置λ2=100,等訓練穩定后再加入身份損失訓練少量批次,設置λ1=2.5。

2.1.3 基準方案

選取了三種典型的對抗人臉生成方案作為基準方案,它們分別是PGD(projected gradient descent)[20]、FGSM(fast gradient sign method)[21]和GAP(generative adversarial perturbation)[22],其中PGD 和FGSM基于迭代優化的方式找到最佳擾動,GAP 和本文一樣利用GAN(generative adversarial network)模型學習到每張圖像的泛化擾動。同時將它們原始的分類損失函數替換為身份特征損失,選擇FaceNet 作為它們需要對抗的白盒人臉識別模型。

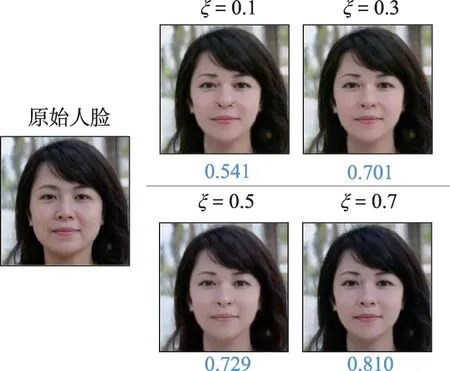

2.2 對抗性閾值選擇

對抗性閾值用于防止身份特征的過分偏離而導致的人臉區域扭曲。如果對抗性閾值設置過大,身份信息將會大部分保留,隱私保護性能較差;如果對抗性閾值設置過小,身份信息丟失嚴重,視覺質量變差。對抗性閾值的取值需要小于匹配閾值(實驗中為0.75),從0.1~0.7 間隔0.2 取值作為對抗性閾值開展相應實驗。結果如圖5所示,其中藍色數字表示對抗人臉與原始人臉的相似度。在對抗性閾值為0.1時,人臉的鼻子兩邊會發生扭曲,同時眼周出現其他顏色斑點。當取值為0.5 時,對抗人臉既能保持較高的視覺質量也能有效降低身份相似度,因此,本文方案選擇0.5作為對抗性閾值。

圖5 不同對抗性閾值下的對抗人臉及相應的置信度Fig.5 Adversarial faces with different adversarial thresholds and corresponding confidence levels

2.3 視覺評估

圖6 展示了Adv-beauty 在Seepretyface 黃 種人數據集上生成的結果,其中第一行和第三行是數據集中的原始圖像,第二行和第四行分別為對應的對抗圖像。通過觀察可以發現,所提出的方案能夠對人臉進行美顏,包括磨皮、美白、瘦臉等效果。相較于原始人臉,Adv-beauty 生成的人臉五官更加精致,皮膚更加白皙。

圖6 本文方案生成的對抗人臉圖像Fig.6 Adversarial face images generated by proposed scheme

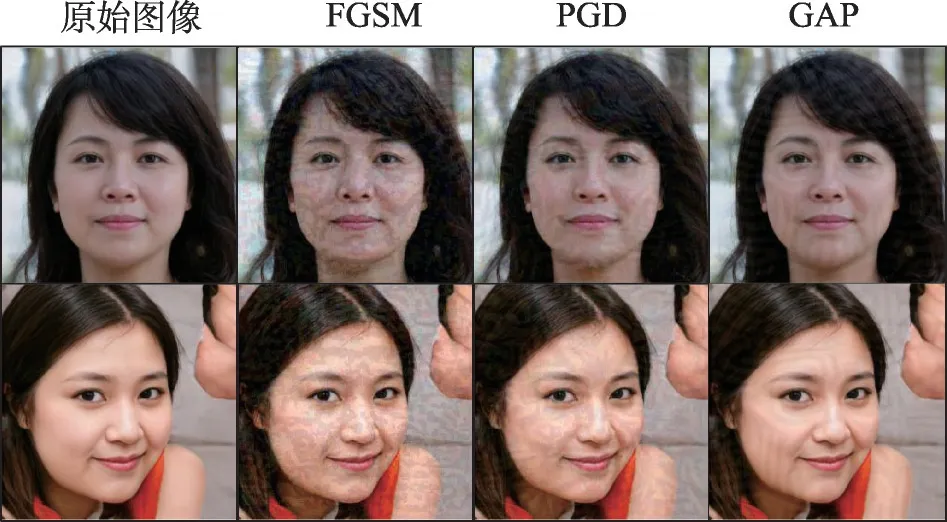

圖7展示了基準方案生成的結果,能明顯注意到對抗人臉上存在不同形狀的擾動信息,其中非人臉區域也存在擾動信息,影響了用戶的視覺體驗,并不利于社交網絡的圖片分享。

圖7 基準方案生成的對抗圖像Fig.7 Adversarial images generated by other schemes

2.4 身份保護評估

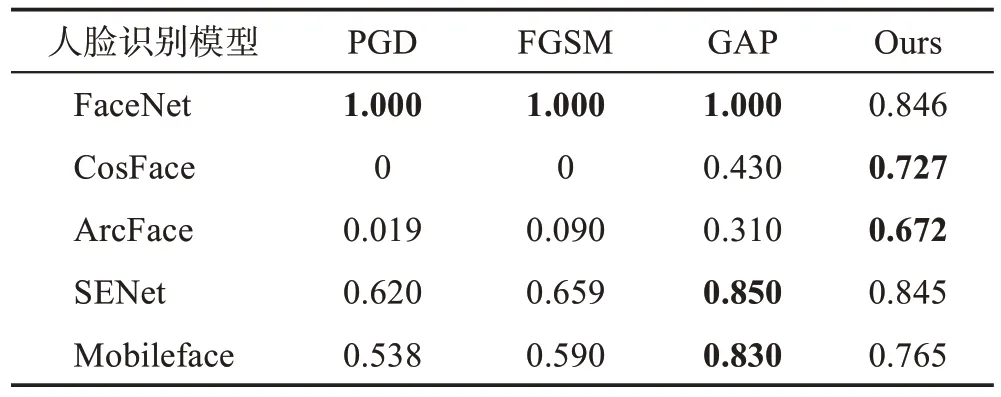

為了評估所提出的方案對人臉隱私保護的有效性,在五種人臉識別模型上測試了Adv-beauty的對抗性能,分別是FaceNet[17]、CosFace[18]、Arcface[23]、SENet[24]和Mobileface[25]。當原始人臉的身份特征相似度小于身份匹配閾值時,定義身份保護成功,即I(x,) <δ,其中x為原始人臉,為對抗人臉,δ為匹配閾值(實驗中設置為0.75)。采用成功保護率(successful protection rate,SPR)作為身份保護評估的指標。

m為測試樣本數量。

表1 給出基準方案和本文方案在不同人臉識別模型下的成功保護率。可以發現傳統對抗擾動方法PGD 和FGSM 對FaceNet 的成功保護率已經達到了100%,說明此類迭代優化方法對白盒模型最為有效,同時它們對SENet和Mobileface達到了近一半的成功保護率。然而,它們對CosFace 和ArcFace 的成功保護率幾乎為0,無法抵抗部分未知模型的攻擊。GAP利用了生成對抗網絡來生成對抗擾動,其保護效果較PGD 和FGSM 有明顯提升,對SENet 和Mobileface 有比較好的泛化作用,對CosFace 和ArcFace 也起到一定的對抗效果但依舊不夠理想。而本文方法雖然不能在所有模型上達到最優的成功保護率,但對這些模型都能起到令人滿意的對抗效果,泛化效果較強。總的來說,本文方案較基準方案能夠更好地抵抗人臉識別模型的攻擊。

表1 不同方案對抗人臉識別模型的成功保護率Table 1 Successful protection rates of different adversarial schemes against face recognition models

隨著對抗樣本的發展,一些人臉比對商業APIs會定期更新人臉比對算法,從而抵抗對抗樣本的攻擊。如果所設計的人臉隱私保護方案能夠抵抗人臉比對商業APIs 將更具有現實意義。因此,在國內的人臉比對商業APIs上開展了對抗實驗。

表2 展示了不同方案生成的人臉與原始人臉在三種國內商業APIs 上的比對結果的平均置信度,分別是曠視科技(https://www.faceplusplus.com.cn/facecomparing/)、阿里云(https://vision.aliyun.com/experience/detail?tagName=facebody&children=CompareFace)和訊飛云(https://www.xfyun.cn/services/xf-face-comparisonrecg#anchor264312),其中平均置信度越小表示人臉的相似度越低,即身份保護效果越好。需要注意的是,每種APIs的匹配閾值并不一致。由表2可知,GAP獲得的置信度最高,抵御人臉比對APIs的效果最差。這是因為它在非人臉區域也產生了部分擾動,但先進的人臉比對APIs只保留人臉區域用于識別。PGD和FGSM 也降低了人臉比對置信度,但效果并不明顯。Adv-beauty 生成的對抗人臉與原始人臉的身份比對置信度在所有方案中達到了最低水平,因此所提出的方案相較基準方案隱私保護效果更好。

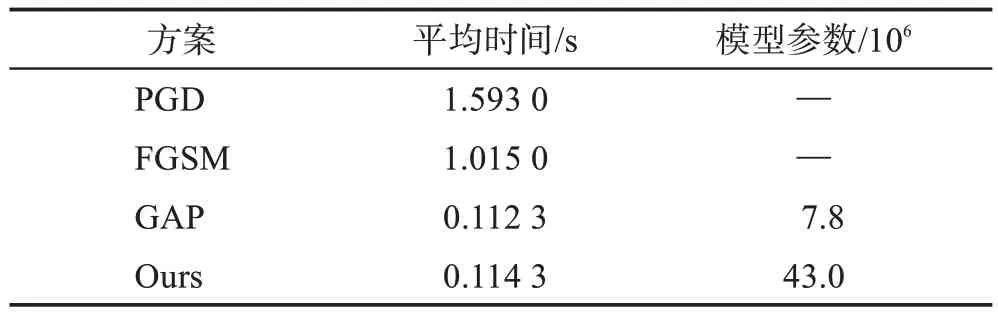

2.5 效率評估

表3 展示了所提出的方案與基準方案平均生成一張對抗人臉所需要的時間以及所使用模型的參數。PGD 和FGSM 都是基于迭代優化的方法生成對抗擾動,因此相對GAP 來說耗時更長,但它們無需模型參數。本文提出的方案需要同時考慮對人臉進行美顏,在模型結構上要比GAP 復雜,模型參數也相對更多。由于深度模型能夠借助GPU 并行地處理數據,本文方案和GAP在時間效率上差異并不明顯。

表3 對抗人臉生成的平均時間和模型參數Table 3 Average time and model parameter of adversarial faces generation

2.6 討論

不同于基準方案直接在人臉圖像上添加擾動,這易被對抗防御方法所檢測,Adv-beauty產生的擾動聚焦在身份的特征級上而不是像素級上,因此生成的對抗人臉更加自然,很難被檢測。然而,隨著人臉識別技術的不斷發展,Adv-beauty產生的特征級的擾動可能被人臉識別技術所去除,使得身份信息無法被保護。

本文方案嚴格固定了美顏參數,無法滿足用戶對美顏的個性化需求,因此很難在現實場景中得到應用。如何提供可控的美顏和隱私保護是需要解決的重要問題。

3 結束語

現有基于對抗擾動的人臉隱私保護工作生成的人臉在視覺上并不自然,為此,本文提出了一種基于美顏的對抗性人臉生成方案Adv-beauty。該方案利用人臉匹配器和美顏鑒別器協同監督生成器的訓練過程,使得生成器在原始人臉上產生類似美顏的擾動,或者說用美顏帶來的像素變化遮蓋擾動。此外,還加入了對抗性閾值來防止身份過度遠離造成的人臉扭曲。在Seepretyface黃種人的數據集上開展的充分實驗表明,Adv-beauty不僅能夠生成較為自然的美顏人臉,同時能夠有效防御多種人臉識別模型和商業人臉比對APIs的攻擊。