AI通過損壞照片解決版權爭議

2024-07-14 00:00:00進三

攝影之友 2024年7期

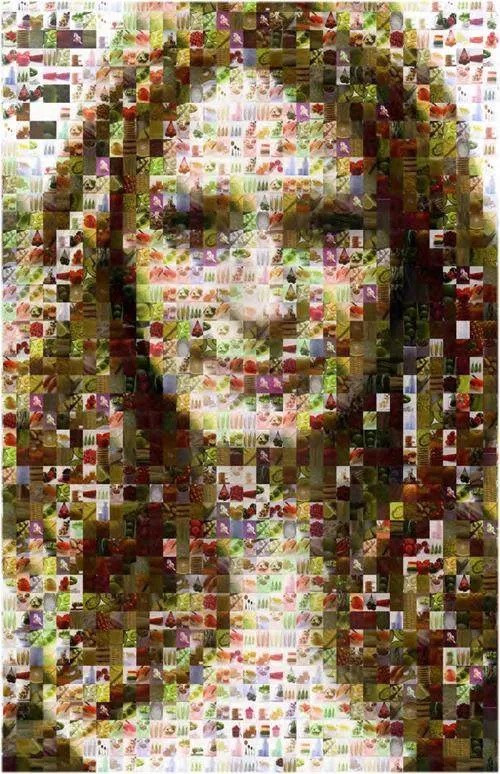

隨著AI技術的快速發展,AI圖像生成器因其能夠基于未經同意的藝術家和攝影師的版權作品進行創作而備受爭議。然而,如果這些作品被損壞,原創作者的感受可能會有所不同。在這種情況下,得克薩斯大學的研究團隊提出了一種可能的解決方案。

研究團隊開發了一種“環境擴散”模型,首先使用部分掩蓋的圖像來訓練文本到圖像的模型。隨后,團隊開始嘗試使用其他類型的噪聲來破壞圖像,以測試模型的性能。他們使用一組3000張清晰的名人圖像對第一個傳播模型進行訓練,結果發現模型能夠生成與訓練數據“明顯相似”的副本。然而,當研究人員開始破壞訓練數據,隨機掩蓋高達90%的像素時,圖像生成器仍然能夠創建高質量的人類圖像,但這些圖像看起來并不像任何現實生活中的名人。

計算機科學研究生GiannisDaras表示:“我們的框架可以控制記憶和性能之間的平衡。隨著訓練過程中遇到的損壞程度增加,訓練集的記憶就會減少。”這一發現表明,通過提高圖像的損壞程度,可以有效減少AI模型對原始圖像的記憶,從而減輕版權問題。

盡管一些人可能預期該模型只會輸出噪點圖片,但研究人員指出,其性能仍然會隨圖像掩蓋程度的增加而變化,即照片被掩蓋得越多,輸出質量就越差。此外,計算機科學教授亞當·克里文斯補充說:“該框架對科學和醫學應用也很有用。對于任何研究來說,從黑洞成像到某些類型的MRI掃描,只要獲得一整套未損壞的數據是昂貴的或不可能的,那么該框架基本上都是有用的。”

這項研究不僅為AI圖像生成提供了一種新的解決方案,也為未來的科學研究和應用開辟了新的可能性。通過這種創新方法,AI技術的應用將更加廣泛,同時也更加尊重原創內容的版權。