面向多應用場景的遙感圖像LSTM分類模型

摘 要:遙感圖像能夠更為豐富地反映地物內部信息,但多種應用場景下會出現時間序列關鍵特征難以提取,導致圖像分類效果不佳的問題。為此,設計一種面向多應用場景的遙感圖像長短期記憶(Long Short Term Memory,LSTM) 網絡分類模型。對場景遙感圖像時間序列特征進行表示;改進動態時間彎曲質平均算法,利用改進算法提取場景遙感圖像時間序列關鍵形態特征;構建LSTM 模型,利用梯度下降法訓練LSTM 模型,更新網絡的權值與偏置,在訓練完成的網絡內,輸入時間序列關鍵形態特征,輸出遙感圖像場景分類結果。實驗結果表明,所設計模型可有效分類遙感圖像場景,對場景遙感圖像分類的Kappa 值為0. 97,分類耗時5. 6 s,分類不同類別遙感圖像場景時的預測分布方差最大為0. 6,該方法的分類精度較高,且消融實驗結果顯示所設計模型的召回率高達95% ,F1 值高達0. 96,由此可見,所設計模型對場景遙感圖像分類具有顯著的有效性。

關鍵詞:遙感圖像;場景;關鍵形態特征;長短期記憶模型;分類

中圖分類號:TP391. 4 文獻標志碼:A 開放科學(資源服務)標識碼(OSID):

文章編號:1003-3106(2024)04-0977-07

0 引言

在遙感技術的快速發展下,通過不同場景中的遙感圖像捕獲能夠得到豐富的地物信息。遙感圖像的產生,不僅在土地利用、城市規劃和環境檢測等民用方面得到廣泛應用,在軍事領域也發揮了重要作用[1-2]。為從遙感圖像中捕獲有效信息,場景遙感圖像分類逐漸成為該領域研究的熱點。同一類別的圖像會有巨大差異,而不同類別的圖像會變得相似,由此加大了圖像分類的難度[3-4]。傳統的分類算法采用低級或中級手工特征,這些特征表示圖像高級語義信息的能力較差,難以在海量復雜場景圖像上取得滿意的效果[5-7]。為此,急需尋找一種高效的遙感圖像分類方法,選擇有效的特征信息來提高圖像分類性能。

許多相關研究應運而生,Yu 等[8]利用幾何歸一化預處理遙感圖像,再利用深度卷積神經網絡,提取深度特征,并完成遙感圖像場景分類,該方法具備遙感圖像場景分類的有效性,且場景分類精度較高,但分類耗時較長。Qi 等[9]提出了一種基于旋轉不變性正則化的深度孿生網絡的場景分類算法,以學習旋轉不變性設計深度卷積神經網絡模型,該模型通過直接強制旋轉前后訓練樣本的標簽彼此接近映射來實現,并對模型的目標函數施加了旋轉不變性正則化約束,該方法可有效分類遙感圖像場景,但預測分布方差較大。Yu 等[10]提出了一種金字塔形和條件卷積注意網絡的遙感圖像場景分類算法,該網絡通過不同權值和不同尺度的卷積核,全面有效地捕獲遙感圖像的信息,其中譜分支使用條件參數化卷積根據輸入特征自定義卷積核,提取圖像特征;空間分支使用金字塔卷積,捕獲遙感圖像中不同層次的詳細信息;同時通過門控自適應和信道歸一化來捕捉不同信道間的競爭與合作關系,共同處理譜分支與空間分支提取的特征,得到遙感圖像場景分類結果。該方法的遙感圖像場景分類精度較高,但時間序列特征分析欠缺。Yang 等[11]提出了一種基于多類損失反饋的判別字典學習的遙感圖像場景分類算法,該算法在訓練支持向量機的同時學習判別字典,使學習到的字典提取的特征與支持向量機更好地匹配;由于將字典學習和支持向量機訓練整合到一個統一的學習框架中,并且從反饋的角度為分類方案制定的循環多類損失項具有良好的準確性,因此可以獲得更好的分類性能,該方法具備較優的分類效率,但遙感圖像場景分類效果較差。Zhang 等[12]提出了一個兩階段半監督學習的遙感圖像場景分類算法,第一階段訓練2 個自監督模型,第二階段通過深度相互學習融合2 個模型,利用其中一個模型提供的互補信息增強2 個模型,實現遙感圖像場景分類精度。該方法的遙感圖像場景分類效率較好,但未考慮遙感圖像的時間序列信息,無法在時間域內得到場景遙感圖像時間序列特征的重要性差異,出現重要特征被忽視的問題,影響場景遙感圖像分類性能。

為解決現有研究存在的不足,提出面向多應用場景的遙感圖像長短期記憶(Long Short Term Mem-ory,LSTM)網絡分類模型,精準分類場景遙感圖像。所設計模型的創新點為:

① 改進動態時間彎曲質平均算法,提取出時間序列的關鍵形態特征,為后續分類提供了有效的特征向量。

② 利用梯度下降法訓練LSTM,該網絡利用時間序列關鍵形態特征進行訓練和分類,并在處理時序數據的同時,考慮了長期和短期記憶之間的平衡,從而提升了分類精度。

③ 充分考慮時間序列數據的時序性,有效地處理了遙感圖像數據中的時間序列信息,實現了對遙感圖像場景的準確分類。

1 多應用場景遙感圖像LSTM 分類模型框架設計

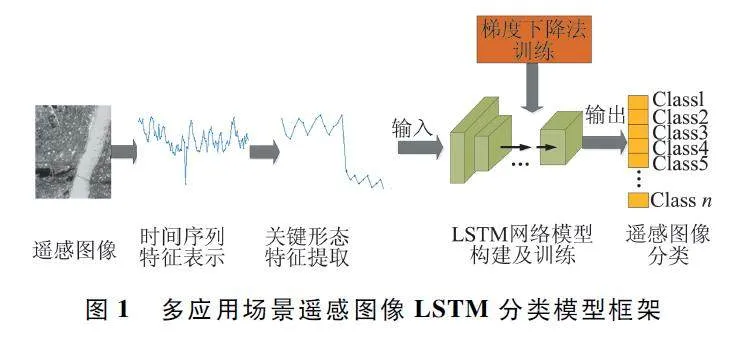

遙感技術因其能夠在較短時間內觀測大范圍地區的優勢,在多種應用領域和場景中得到廣泛應用。遙感圖像作為主要表現和利用形式,對其進行分類來獲取有效信息成為一個廣為關注的研究課題。本文引入當前先進的技術手段,采用深度學習進行遙感圖像分類研究,設計面向多應用場景的遙感圖像LSTM 分類模型,模型框架如圖1 所示。

由于場景遙感圖像時間序列具備多變量、高維度等特性,會加大場景遙感圖像的分類難度,為此,本文首先利用一種時間序列特征表示方法,降維處理場景遙感圖像時間序列數據集,提取場景遙感圖像時間序列的關鍵形態特征,降低后續場景遙感圖像分類難度;然后構建LSTM 分類模型,將遙感圖像信息輸入LSTM 分類模型中,通過模型訓練實現遙感圖像分類。

2 多應用場景中遙感圖像關鍵形態特征提取

2. 1 場景遙感圖像時間序列特征表示

在采集場景遙感圖像時,會產生大量時間序列數據,描繪遙感圖像的時間序列信息,通過提取時間序列特征,可全面了解時間序列特征的重要性差異[13-14],避免出現重要特征丟棄問題,提升場景遙感圖像分類精度。

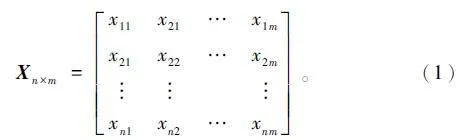

場景遙感圖像時間序列指數是具有一定關系的一元時間序列組建而成的時間序列。令場景遙感圖像的時間序列為X = (y1 ,y2 ,…,ym ),X 內的第i 個維度時的觀測值為yi = (x1i,x2i,…,xni );維度為m;時間維度為n。場景遙感圖像時間序列的n×m 矩陣形式如下:

令場景遙感圖像時間序列數據集為D ={X1,X2,…,XK},場景遙感圖像時間序列數量為 K,其中,yij是Xi 的第j 個變量分量。

令已知2 條一元時間序列ya = (a1 ,a2 ,…,aN )與yb = (b1 ,b2 ,…,bM ),由ya 與yb 建立的N×M 距離矩陣如下:

GN ×M = g(ai,bj), (2)

式中:ya 內第i 個變量分量為ai,yb 內第j 個變量分量為bj,ai 與bj 的距離為g(ai,bj)。

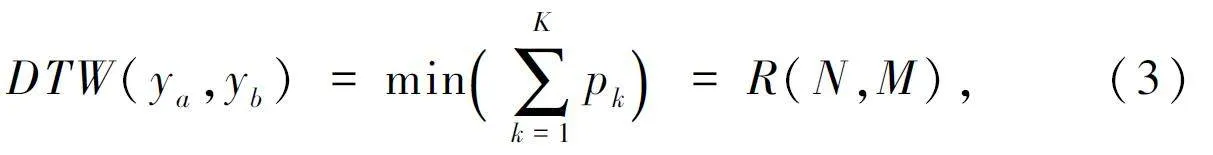

找到ya 與yb 間距離最短的彎曲路徑P = (p1 ,p2 ,…,pK )(max{N,M}≤K≤N+M-1),令累積距離R(N,M)最小,同時P 還需符合邊界性、不間斷性與單調性,為此距離函數DTW(ya,yb)如下:

式中:第k 個場景遙感圖像時間序列是pk。

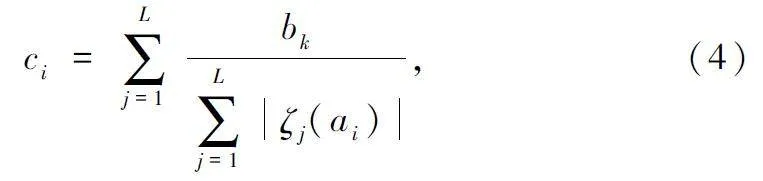

令ya 為初始簇中心,利用式(3)求解ya 和遙感圖像一元時間序列數據集B = {yb1,yb2,…,ybL }[15-16],其中,L 是B 內時間序列數量。場景遙感圖像時間序列數據集的中心時間序列ci 計算如下:

式中:bk 表示B 內第k 個變量分量,ζj(·)表示和ya內數據點匹配的點集合,ci 表示和ai 數據點存在匹配關系的全部數據點均值。

由此完成場景遙感圖像時間序列特征表示。

2. 2 場景遙感圖像關鍵形態特征提取

獲取場景遙感圖像時間序列特征后,對時間序列的關鍵形態特征進行提取,以更加全面地反映場景遙感圖像的變化和演化過程,為后續的場景遙感圖像處理和分析提供更為豐富和準確的信息。

為提取場景遙感圖像的時間序列關鍵形態特征,需要先分析各場景遙感圖像類別的多時間序列整體形態,各類別均由一個新的時間序列描繪其整體形態[17];再依據各場景遙感圖像類別的整體形態,獲取各場景遙感圖像類別間每個變量間的形態差異;最后依據類內和類間的形態差異,獲取遙感圖像的時間序列關鍵形態特征。

為提升遙感圖像的時間序列關鍵形態特征提取精度,在動態時間彎曲質平均算法的基礎上進行改進,設計一種關鍵形態特征表示方法。令變量是m的場景遙感圖像時間序列數據集為D = {X1 ,X2 ,…,XK },同一個場景遙感圖像時間序列數據集內,時間序列的長度可能相同,也可能不同,即Xi 與Xj 內時間維度ni = nj 或ni≠nj。

因為場景遙感圖像時間序列內,每個變量分量間都包含量綱,所以提取時間序列關鍵形態特征前,需要標準化處理場景遙感圖像的時間序列數據集,提升變量分量的不變性[18]。場景遙感圖像的時間序列關鍵形態特征依據類別數C 實施劃分,可獲取C 個子集,即Dα= {Xi}α,其表示類別是α 的場景遙感圖像時間序列子集。計算每個子集的ci,再尋找ci的β 個關鍵變量,即時間序列關鍵形態特征D′ ={X′1 ,X′2 ,…,X′K },且β<m。場景遙感圖像的時間序列關鍵形態特征提取步驟如下:

① 依據類別分割D,獲取Dα={Xi}α。

② 在Dα內任意選取一個時間序列,當成初始中心時間序列,并利用式(4)求解其余類別的中心時間序列。

③ 反復操作②,直到α = C 為止,獲取每個類別的中心時間序列。

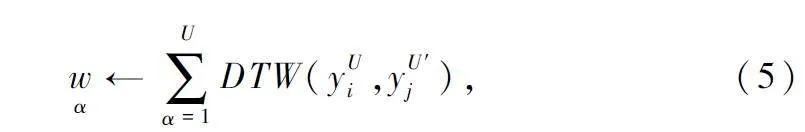

④ 求解類α 的時間序列變量權重wα,公式如下:

式中:yUi、yU′j 為遙感圖像一元時間序列數據集U、U′內第i、j 條時間序列。

⑤ 降序排列的wα,選擇前β 個值,β 個值相應的變量即關鍵特征變量Dα={Xi}α,在Dα= {Xi}α內提取分量,獲取Dα′= X′i { }α,反復操作⑤,直到C 個子集完成特征分量提取為止,融合新子集,得到場景遙感圖像的時間序列關鍵形態特征D′= {X′1 ,X′2 ,…,X′K }。

3 基于LSTM 的場景遙感圖像分類模型

場景遙感圖像分類是一個復雜的問題,需要對不同場景圖像之間的差異和特征進行深入研究和分析。因為LSTM 網絡既能剔除冗余時間維度數據,還能保留有效的時序信息,可以較好地發現場景遙感圖像時間序列數據集的潛在規律[19],所以在獲取場景遙感圖像的時間序列關鍵形態特征的基礎上,采用LSTM 網絡對時間序列關鍵形態特征進行分類,能夠更好地挖掘遙感圖像數據的時序信息,提升圖像分類精度。

3. 1 LSTM 網絡模型構建

LSTM 能夠在隱藏層學習數據的時序性,具備較優的學習性能,可避免出現梯度消亡問題。

令LSTM 的輸入門為zt,在zt 內輸入上述提取的場景遙感圖像時間序列關鍵形態特征D′ =X′1 ,X′2 { ,…,X′K},zt 的計算如下:

zt = Φ(ωz ·(ht-1 ,D′t )+ ρz ), (6)

式中:t 為時刻,Φ(·)為Sigmoid 函數,ωz、ρz 為zt 的權值與偏置,ht-1 為t-1 時刻的隱藏狀態,λ 為可調節因子。

令LSTM 的遺忘門為st,計算如下:

st = Φ(λ·ωs ·(ht-1 ,D′t )+ ρs ), (7)

式中:ωs、ρs 分別為st 的權值與偏置。

μt 為LSTM 的更新內容,計算如下:

μt = st × μt-1 + zt μ′t , (8)

式中:μ′t 為備選更新內容,μt-1 為t-1 時刻的更新內容。μ′t 的計算如下:

μ′t = tanh(λ·ωμ ·(ht-1 ,D′t )+ ρμ ), (9)

式中:ωμ、ρμ 分別為μt 的權值與偏置,tanh(· )為tanh 函數。

LSTM 的輸出門為Ot[20],計算如下:

Ot = Φ(λ·ωO ·(ht-1 ,D′t )+ ρO ), (10)

式中:ωO 、ρO 為Ot 的權值與偏置。

3. 2 基于模型訓練實現場景遙感圖像分類

通過上述步驟完成LSTM 網絡模型構建,然后對模型進行訓練。本文利用梯度下降法對LSTM 網絡進行訓練和優化,能夠自動學習數據中的規律和特征,提高分類模型的泛化能力和適應性,實現場景遙感圖像分類。

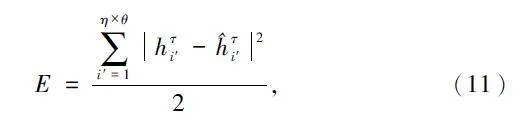

利用梯度下降法最小化損失函數,修正權值ω與偏置ρ,損失函數E 的計算如下:

式中:η 為遙感圖像場景類別數量,θ 為每個類別內遙感圖像數量,hτi′ 為第i′類第τ 個場景遙感圖像的分類結果, ^hτi′為期望分類結果。

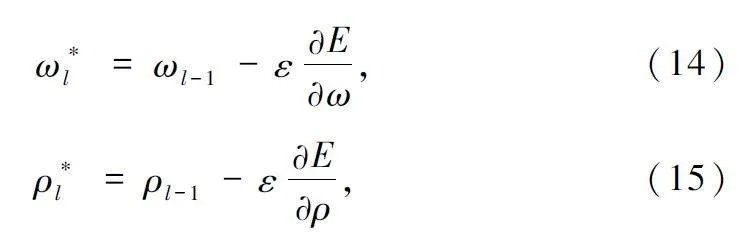

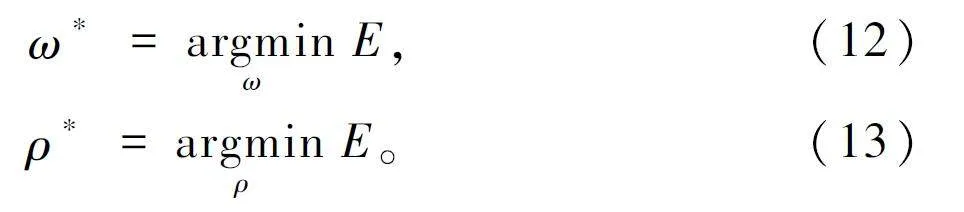

訓練LSTM 的目的在于找到最佳的ω 與ρ,提升遙感圖像場景分類精度。通過最小化E,可獲取最佳的權值ω* 與偏置ρ* ,公式如下:

通過求導式(12)、式(13)可獲取ω*l 與ρ*l 的修正公式如下:

式中:ε 為學習率,l 為迭代次數。

訓練完成后,在LSTM 內輸入提取的時間序列關鍵形態特征,輸出遙感圖像場景分類結果。LSTM的輸出結果是ht,計算如下:

ht = Ot × tanh(μt)。(16)

式(16)的結果為t 時刻場景遙感圖像分類結果。利用LSTM 遺忘的信息,能夠進一步縮減場景遙感圖像時間序列關鍵形態特征維度的數據冗余,加快場景遙感圖像分類效率。

4 實驗分析

4. 1 實驗環境和數據集

為測試面向多應用場景的遙感圖像LSTM 分類模型的性能,進行仿真測試分析。在Matlab 仿真軟件上搭建場景遙感圖像分類仿真分析平臺,使用Python 編程語言以及相關的TensorFlow 機器學習庫來實現算法。實驗硬件環境為:4 核CPU,16 GB RAM。

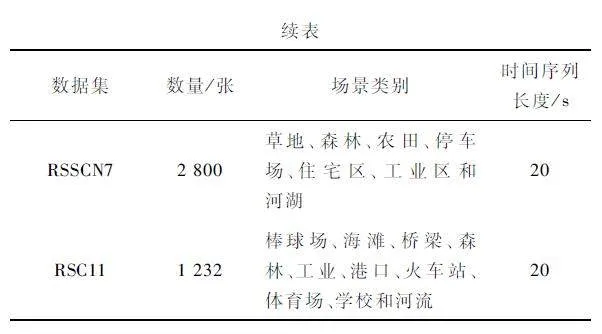

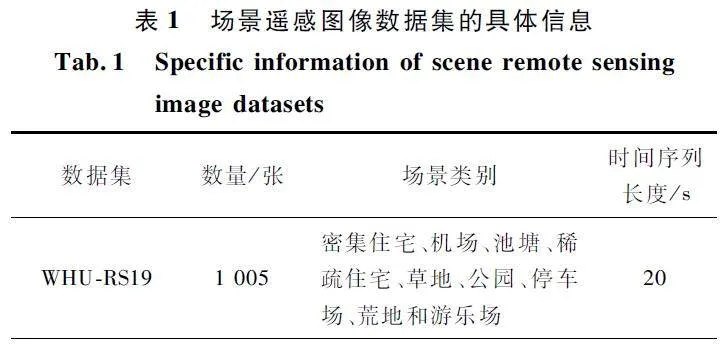

本文選擇3 個遙感領域公開數據集為實驗對象,分別為WHURS19 數據集、RSSCN7 數據集和RSC11 數據集。利用本文算法對這3 個數據集的場景遙感圖像進行分類,分析本文算法場景遙感圖像分類的有效性。3 個數據集的具體信息如表1所示。

4. 2 實驗步驟和細節

實驗步驟和細節如下:

① 將原始的多時相遙感圖像數據進行預處理,如裁剪、歸一化和數據增強等操作,以生成用于訓練和測試的圖像數據。

② 利用關鍵形態特征表示方法,對遙感圖像的時間序列數據集進行降維處理,提取時間序列關鍵形態特征,并用這些特征來訓練分類器。

③ 搭建LSTM 模型,利用梯度下降法對LSTM進行訓練,并更新網絡的權值與偏置。通過不斷調整優化,將學習率設置為0. 001,衰減率設置為0. 9,最小化損失函數。

④ 在訓練完成的LSTM 內,輸入大小為100 pixel×100 pixel 的原始遙感圖像,步長設置為10,卷積核尺寸為3×3,輸出特征圖大小為10 pixel×10 pixel,完成場景遙感圖像分類任務。

4. 3 實驗結果分析

實驗指標設置如下:

① 遙感圖像場景分類效果;

② Kappa 值分析;

③ 場景遙感圖像分類耗時;

④ 預測分布方差結果分析;

⑤ 消融實驗:以召回率、F1 值為指標,設計消融實驗,驗證本文設計模型的有效性。

4. 3. 1 遙感圖像場景分類效果

在WHU-RS19 數據集內隨機選擇9 類遙感圖像,分別對應9 個場景,每類場景選擇100 張圖像,利用6 種算法對這9 類共900 張遙感圖像進行場景分類,結果如表2 所示。

根據表2 可知,5 種對比算法均存在對遙感圖像場景分類錯誤的現象,而采用本文算法可有效分類遙感圖像場景,對900 張遙感圖像場景分類結果均正確。實驗結果證明,本文算法可精準分類遙感圖像場景。由于本文算法準確對遙感圖像場景進行了降維處理,提取出了時間序列的關鍵形態特征,從而提升了遙感圖像場景分類的準確率。

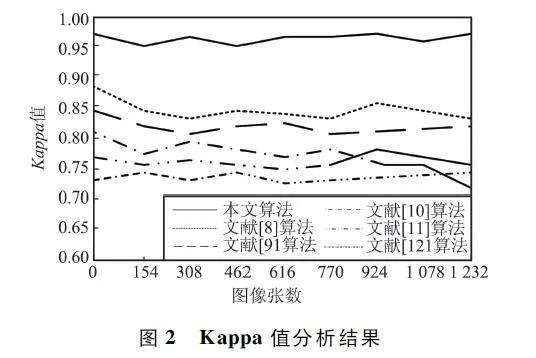

4. 3. 2 Kappa 值分析

分析本文算法的遙感圖像場景分類效果,利用Kappa 值衡量本文算法遙感圖像場景分類精度,其值越接近1,遙感圖像場景分類精度越高。以RSSCN7 數據集為例,得出6 種算法的Kappa 值分析結果如圖2 所示。

根據圖2 可知,本文算法對RSSCN7 數據集中1 232 張遙感圖像場景分類的Kappa 值為0. 97,遠高于其他5 種對比方法,且遙感圖像場景分類過程中Kappa 值的穩定性也好于對比方法。實驗證明,在剔除不同樣本量時,本文算法遙感圖像場景分類的Kappa 值較高,即場景分類精度較高。

4. 3. 3 場景遙感圖像分類耗時

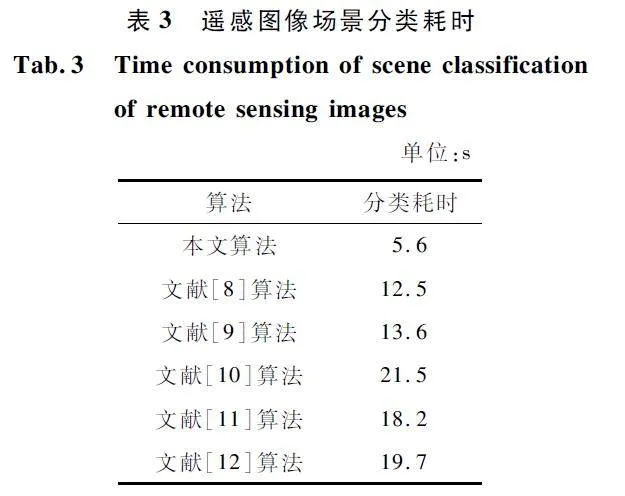

為進一步明確遙感圖像場景分類的性能,以RSC11 數據集為例,測試6 種算法的分類耗時,測試結果如表3 所示。

從表3 可知,本文算法的分類耗時遠優于對比算法,具有較高的遙感圖像場景分類效率。這是因為本文算法利用梯度下降法訓練LSTM,利用時間序列關鍵形態特征進行訓練和分類,避免了高維數據的訓練耗時較長的問題,提高了方法的分類效率。本文算法采用LSTM 網絡對遙感圖像場景分類,能夠有效地捕捉時間序列數據中的時序信息,通過梯度下降法進行訓練和優化,能夠自適應地學習數據中的規律和特征,提高分類模型的泛化能力。同時,LSTM 網絡具有一定的自適應能力和記憶功能,能夠更好地處理復雜的序列數據,從而提高分類效率。

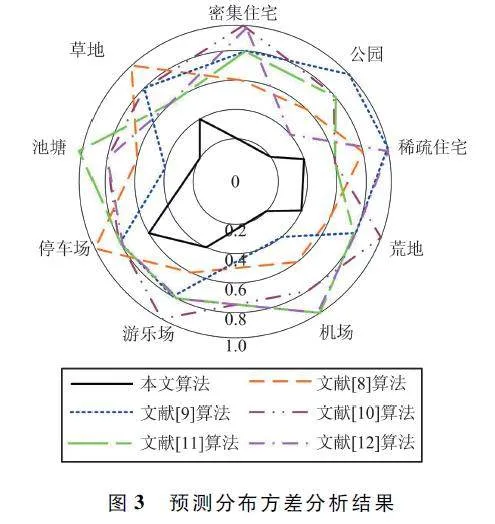

4. 3. 4 預測分布方差結果分析

以WHU-RS19 數據集為例,分析6 種算法對WHU-RS19 數據集進行遙感圖像場景分類時的預測分布方差,預測分布方差越小,說明遙感圖像場景分類精度越高,分析結果如圖3 所示。

根據圖3 可知,對于不同場景類別,本文算法的預測分布方差均明顯低于其余5 種算法,本文算法的最高預測分布方差為0. 6,其余5 種算法的最高預測分布方差均為1. 0。實驗證明,本文算法的預測分布方差明顯低于其余5 種算法,說明本文算法的遙感圖像場景分類精度較高。本文算法通過結合動態時間彎曲質平均算法和關鍵形態特征表示方法,提取出時間序列的關鍵形態特征。這些特征向量為后續分類提供了有效的信息基礎。同時,利用梯度下降法訓練LSTM,該網絡能夠充分考慮時間序列數據的時序性,從而提升分類精度。

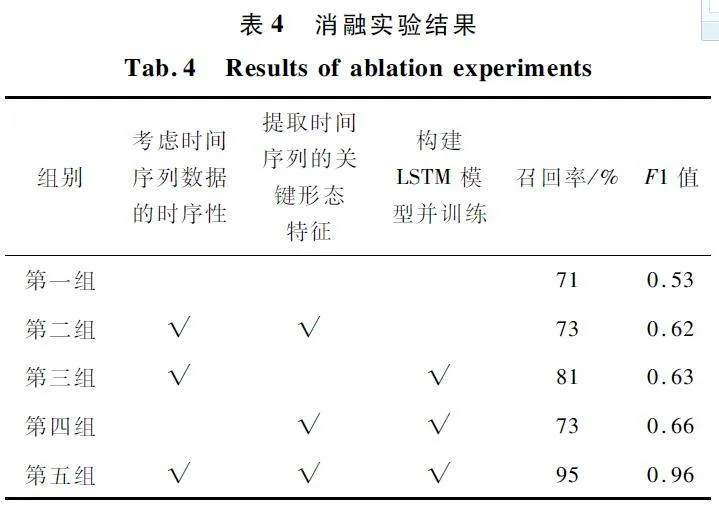

4. 3. 5 消融實驗

為進一步驗證本文分類模型的有效性,設計消融實驗,分析考慮時間序列數據的時序性、提取時間序列的關鍵形態特征、構建LSTM 模型并訓練3 個步驟對遙感圖像分類的影響。消融實驗結果如表4所示。實驗中第一組數據為傳統的遙感圖像分類方法,第二組將考慮時間序列數據的時序性和提取時間序列的關鍵形態特征組合,第三組將考慮時間序列數據的時序性和構建LSTM 模型并訓練組合,第四組將提取時間序列的關鍵形態特征和構建LSTM模型并訓練組合,第五組將三者組合。通過分析可以看出,本文設計的分類模型的召回率高達95% ,F1 值高達0. 96,相較其他情況下的分類效果,本文方法的性能明顯較好,表明本文方法的創新點具有一定的應用效果。

5 結束語

地物幾何結構復雜和目標種類繁多等問題,加大了遙感圖像的背景信息繁瑣程度,導致在各領域的應用效果不佳。為提升遙感圖像的應用效果,提出并設計了面向多應用場景的遙感圖像LSTM 分類模型。通過實驗得出,所設計模型具有較高的遙感圖像場景分類的精度,并且Kappa 系數達到了0. 97,在分類不同目標物的遙感圖像場景時具有更小的預測分布方差,且消融實驗結果顯示具有較高的召回率和F1 值,進一步驗證了其分類性能。可見應用所設計模型能夠精準分類遙感圖像場景,為遙感圖像在各個領域內的應用提供了更為精準的數據支持。

參考文獻

[1] 李大湘,南藝璇,劉穎. 面向遙感圖像場景分類的雙知識蒸餾模型[J]. 電子與信息學報,2022,45 (10):3558-3567.

[2] 陳篧,張明波. PSDenseNet 下的代數模型遙感圖像場景分類研究[J]. 激光與紅外,2022,52(3):442-450.

[3] 黃罛,侯相君. 基于BiLSTM 模型的時間序列遙感作物分類研究[J]. 中國農業科學,2022,55 (21 ):4144-4157.

[4] 何曉軍,劉璇,魏憲. 融合字典學習與視覺轉換器的高分遙感影像場景分類方法[J]. 激光與光電子學進展,2023,60(14):189-198.

[5] 楊志文,張合兵,都偉冰,等. 基于CBAMResHybridSN的高光譜圖像分類研究[J]. 航天返回與遙感,2023,44(3):85-96.

[6] HOSSEINY B,SHAHHOSSEINI R. A Hyperspectral Anomaly Detection Framework Based on Segmentation and Convolutional Neural Network Algorithms[J]. International Journal of Remote Sensing,2020,41(18):6946-6975.

[7] WANG Y,SONG X,GONG G H,et al. A Multiscale Feature Extractionbased Normalized Attention Neural Network for Image Denoising [J ]. Electronics,2021,10(3):319.

[8] YU D H,ZHANG B M,ZHAO C,et al. Scene Classification of Remote Sensing Image Using Ensemble Convolutional Neural Network[J]. Journal of Remote Sensing,2020,24(6):717-727.

[9] QI K L,YANG C,HU C L,et al. Rotation Invariance Regularization for Remote Sensing Image Scene Classification with Convolutional Neural Networks[J]. Remote Sensing,2021,13(4):569.

[10] YU Z K,CUI Y,SHAO C,et al. Pyramidal and Conditional Convolution Attention Network for Hyperspectral Image Classification Using Limited Training Samples[J]. International Journal of Remote Sensing,2022,43(8):2885-2914.

[11] YANG B Q,GUAN X P,ZHU J W,et al. SVMs Multiclass Loss Feedback Based Discriminative Dictionary Learning for Image Classification [J]. Pattern Recognition,2021,112:107690.

[12] ZHANG J,YANG J N,YU J,et al. Semisupervised Image Classification by Mutual Learning of Multiple Selfsupervised Models[J]. International Journal of Intelligent Systems,2022,37(5):3117-3141.

[13] 胡濤,茅健. 基于降采樣和改進ShiTomasi 角點檢測算法的PCB 圖像拼接[J]. 電子測量技術,2021,44(22):134-140.

[14] 何!澤,張帆,劉昊,等. 風機葉片無人機紅外熱圖像拼接方法[J]. 電子測量與儀器學報,2022,36 (7):44-53.

[15] 周國華,蔣暉,顧曉清,等. 基于半監督子空間遷移的稀疏表示遙感圖像場景分類方法[J]. 浙江大學學報(理學版),2021,48(6):684-693.

[16] 雷江波,王澤民,李靜. 基于Faster RCNN 的破片群圖像目標檢測研究[J]. 國外電子測量技術,2021,40(1):70-74.

[17] 閆鈞華,張琨,施天俊,等. 融合多層級特征的遙感圖像地面弱小目標檢測[J]. 儀器儀表學報,2022,43(3):221-229.

[18] XIE F D,GAO Q S,JIN C,et al. Hyperspectral Image Classification Based on Superpixel Pooling Convolutional Neural Network with Transfer Learning[J]. Remote Sensing,2021,13(5),930.

[19] XIE H,CHEN Y S,GHAMISI P. Remote Sensing Image Scene Classification via Label Augmentation and IntraClass Constraint[J]. Remote Sensing,2021,13(13):2566.

[20] LI J,LIN D Y,WANG Y,et al. Deep Discriminative Representation Learning with Attention Map for Scene Classification[J]. Remote Sensing,2020,12(9):1366.

作者簡介

王換換 女,(1988—),碩士,講師。主要研究方向:數據挖掘與信息處理。

王建玲 女,(1987—),碩士,講師。主要研究方向:網絡安全。

閆新慶 男,(1967—),博士后,副教授。主要研究方向:RFID、無線傳感器網絡、軟件開發。

基金項目:河南省科技廳軟科學研究項目(212400410245)