AI“愛男厭女”?

最近,主打黏土風的修圖軟件Remini火爆全網,多位女性博主在嘗試后發現了一個共同點——自己的性別變成了男性。比如,某博主將自己登山、潛水、滑雪、開越野車的照片交給Remini,結果被轉變成了一個個留絡腮胡子、大眼睛的男性。

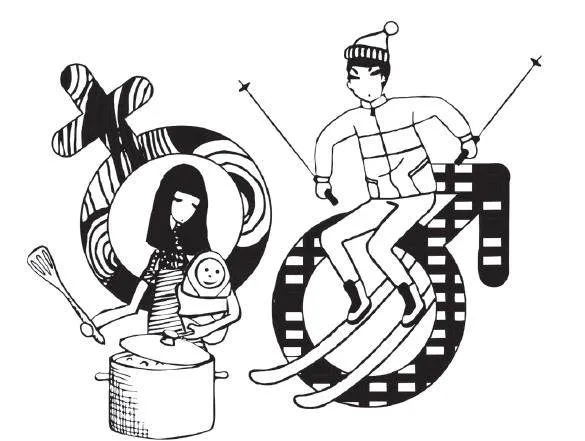

類似的刻板印象遠不止Remini。一位博主將電影《后翼棄兵》描繪女主下國際象棋的劇照放在美圖秀秀的黏土濾鏡里。很快,女主角的臉變成了萌萌的卡通人物,但是桌上的象棋變成了鍋碗瓢盆,甚至,女主角的身旁還多了個嬰兒。

由人類編寫的AI 世界,似乎也自帶偏見和歧視。這到底是AI 隨機的行為,還是根深蒂固的刻板印象?清華大學交叉信息研究院助理教授于洋認為,首先要分清楚:AI 只是出錯,還是產生了系統性偏見或者主觀性歧視。

為了弄清楚這個問題,我們在網絡隨機選擇了10 張女性在戶外的照片,一半是背影,一半露了臉,接著將它們分別放在了Remini 的clay 濾鏡、美圖秀秀的熱門AI 黏土濾鏡和小紅書的黏土濾鏡特效里。結果是在三個軟件里,留長發的、有正面臉龐的女性照片,都能正確生成黏土版的女孩。但如果照片的面部被部分或者全部遮擋,那她大概率就會變成男性。

AI 也許有些“臉盲”。但如果,將女性的臉龐更清晰地展示出來,AI 還會歪曲現實嗎?我們選擇了女性被認為是少數參與者的運動領域,例如電影《熱辣滾燙》里的女拳擊手、綜藝《海妖的呼喚》里參加競技的女人們,作為觀察樣本。在提供清晰的正面原圖后,Remini 均生成了符合原圖性別的卡通人物,而在美圖秀秀、小紅書里都變成了男性。

偏見甚至遠比想象中的普遍。彭博社曾在2023 年對AI 畫圖軟件Stable Diffusion專門進行了觀察。他們用文字生成圖片的方式,讓AI 分別畫出從事14 種工作的代表人物。結果發現,AI 生成的圖片中,男性數量幾乎是女性的三倍。

膚色和種族在AI 世界里也非常失衡。AI 的畫像顯示,世界是由白人男性CEO 管理的,深色皮膚的男人熱衷犯罪,深色皮膚的女人樂于翻轉漢堡。而且,這類偏見已經遠遠超出現實狀況。例如,在針對關鍵詞“法官”生成的圖像中,女性只占約3%。而實際上,官方數據顯示,34% 的美國法官是女性。

一切究竟是怎么發生的?一個解釋是,AI 也許就是現實的一部分體現——訓練AI 的現實數據集被發現具有傾向性。Stable Diffusion 使用了世界上最大可公開訪問的圖集數據集訓練,里面包含各類色情、種族偏見和性別歧視等未經過濾的內容。AI 的性別偏見也可能與分享個人圖像的文化差異有關。女性的數據量較少,也導致了訓練出來的AI 可能更“愛男厭女”。除了數據量,研究者發現,AI 在大量接受數據并進行深度學習的過程中,通常會丟棄異常值,產生更接近主導趨勢的結果。AI 從設計之初,其目的就是模仿以前的多數情況,而不是創造多樣性。

好消息是,越來越多AI 研究者注意到AI 的性別歧視和偏差。于洋與團隊近日提出一種讓AI 學習因果關系的機制,簡單來說,就是“教它(學會價值觀)”。“很多人講技術是中性的,我們現在漸漸認為,技術存在著向善和中性,也存在向惡的。AI 時代,不能再以中性的角度看待技術,有價值觀的技術,一定要得到鼓勵。”于洋說。

(摘自“南風窗”微信公眾號,本刊有刪節,蘿卜葉子圖)