基于改進3D U-Net模型的肺結節分割方法研究

摘 要:由于肺部CT圖像的特征信息復雜度較高,經典3D U-Net網絡在肺結節分割方面準確率較低,存在誤分割等問題。基于此,提出一種基于改進3D U-Net的網絡模型。通過將加入了密集塊的3D U-Net網絡和雙向特征網絡(Bi-FPN)融合,提高了模型分割精度。同時采用深度監督訓練機制,進一步提高了網絡性能。在公開數據集LUNA-16上對模型進行比較實驗和評估,結果顯示,改進后的3D U-Net網絡,Dice相似系數較原模型提高4%,分割精度為93.9%,敏感度為94.3%,證明該模型在肺結節分割精度及準確率方面具有一定的應用價值。

關鍵詞:肺結節分割;CT;3D U-Net;雙向特征網絡;深度監督

中圖分類號:TP391;TP183 文獻標識碼:A 文章編號:2096-4706(2024)13-0052-05

Research on Lung Nodule Segmentation Method Based on Improved 3D U-Net Model

SHI Zhengjin, LI Wenhui, GAO Tian

(Shenyang Ligong University, Shenyang 110159, China)

Abstract: Due to the high complexity of feature information in lung CT images, the classic 3D U-Net network exhibits low accuracy in lung nodule segmentation, leading to issues such as miss segmentation. To address this, a network model based on improved 3D U-Net is proposed. This model integrates 3D U-Net network with dense blocks with the Bidirectional Feature Pyramid Network (Bi-FPN) to improve the model's segmentation accuracy. The adoption of deep supervision training mechanism further enhances network performance. Comparative experiments and evaluations are conducted on the public dataset LUNA-16, and the results show that the improved 3D U-Net network has a 4% increase in Dice similarity coefficient, a segmentation accuracy of 93.9%, and a sensitivity of 94.3% compared to the original model. This proves that the model has certain application value in the accuracy and precision of lung nodule segmentation.

Keywords: lung nodule segmentation; CT; 3D U-Net; bi-directional feature network; Deep Supervision

0 引 言

目前,肺癌已經成為當今世界死亡率最高的癌癥之一[1],給人類的健康及生活帶來了嚴重影響。肺癌早期通常以極少數良性結節的形式存在,由于此時結節的形狀不規則、位置不規律,會影響醫生的主觀判斷。近年來,隨著醫學圖像數據集的增加和計算機GPU計算能力的提升,深度學習技術在計算機視覺領域取得了巨大進展,尤其在醫學圖像領域表現突出。借助深度學習方法輔助醫生進行診斷,有效解決了漏診、誤診等問題。

傳統肺結節檢測方法是基于人工手動提取肺結節[2],極其依賴醫生個人經驗,受人的主觀影響較大,而基于深度學習的方法可以自動提取病灶特征[3],不需要人工參與,可以更加高效準確的完成分割任務。?i?ek等[4]提出了一種3D U-Net網絡模型,該網絡在原U-Net架構基礎上引入了密集體積分割模塊,以增強特征信息的復用;并通過半監督訓練機制提高了模型整體性能,但由于半監督訓練對數據的依賴性較強,從而限制了模型的分割性能。Milletari等[5]提出了V-Net模型,一種基于U-Net的三維圖像分割網絡,加入了殘差連接模塊,但其分割精度仍有待提高。Lin等[6]提出了一種基于3D U-Net改進的圖像分割方法,該網絡加入了Dense blocks模塊,并通過深度監督結構進一步提升性能,但對不同尺度和層次信息的感知能力還有些許不足。

針對以上問題,本文提出了一種基于改進的3D U-Net密集連接雙向特征網絡,并通過加入深度監督結構,有效提高了模型的性能及對不同尺寸結節的感知能力,進一步提高分割精度,使其適用于多類型肺結節的高效分割。

1 網絡結構

1.1 整體網絡結構

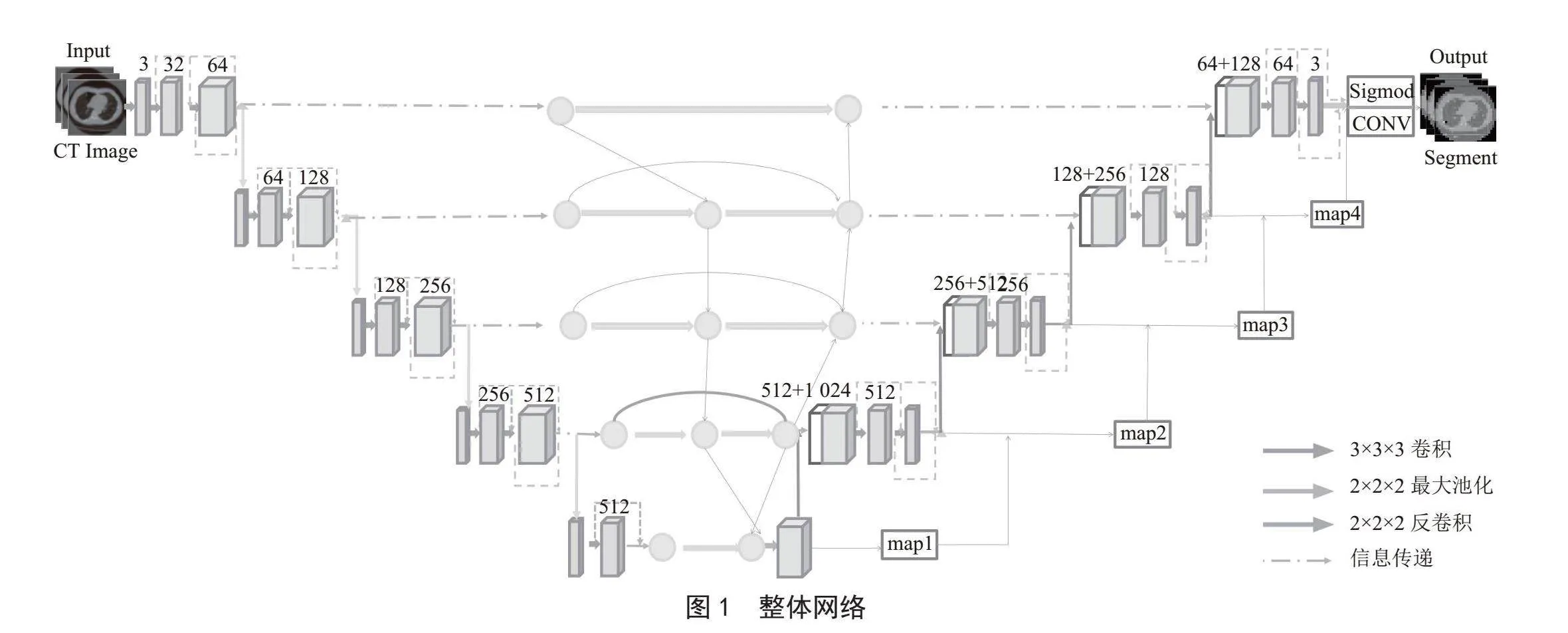

由于肺結節類型多,在肺部CT圖像中占比較小,形狀復雜,給肺結節的早期發現及治療帶來很大困難。基于這些問題,本研究提出了一種改進的3D U-Net分割模型,通過端到端深度學習方法,在編碼器與解碼器之間引入雙向特征網絡,進行多層次的特征融合。并在骨干網絡部分采用密集連接網絡[7](DenseNet)和深度監督模塊,實現特征的重復使用并提高網絡性能。整體網絡結構如圖1所示。

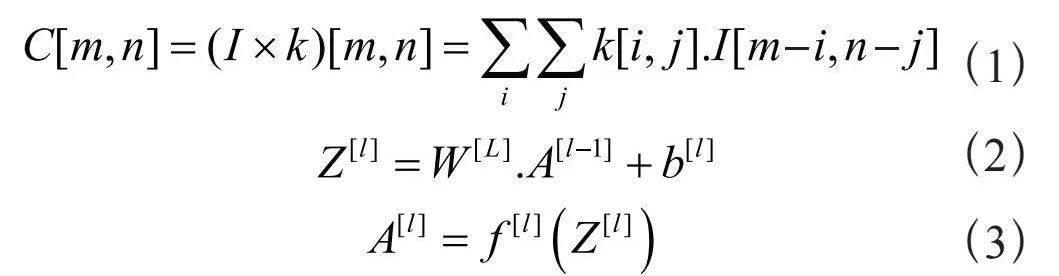

分割網絡由加入了密集塊的3D U-Net和Bi-FPN融合網絡以及深度監督模塊構成,在這個架構中,收縮路徑具有卷積網絡的典型結構,由兩個3×3×3的卷積組成,每個卷積后跟一個非線性的Mish激活函數和一個2×2×2的步幅為2的最大池化,用于對輸入圖像特征進行降采樣,收縮路徑的深度為5。此外,為了對模型進行正則化,在深度為4的第二個3×3×3卷積塊之后使用了一個因子為0.5的Dropout層。在模型的每一層發生的卷積過程計算式為:

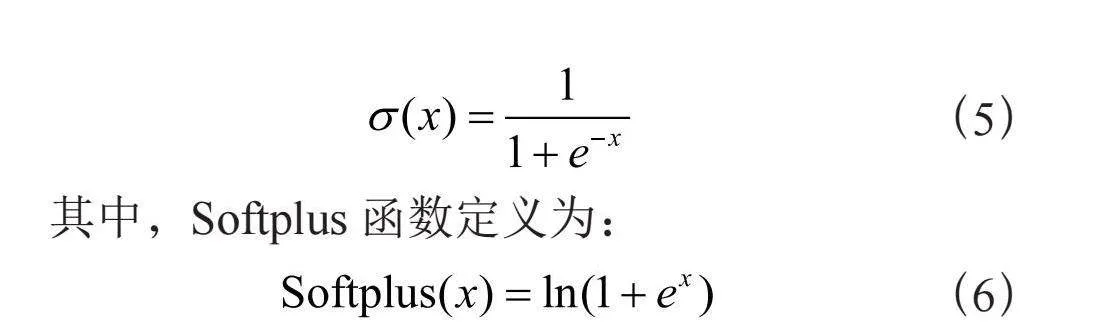

式中i和k分別表示輸入圖像和核,A[l]、W [l]、b[l]、f [l]分別表示第1層的激活度、權值、偏置、激活函數。在5個深度處得到的特征被輸入到Bi-FPN,輸出的特征向量被輸入到擴展部分。擴展路徑中的每一步都包括對特征圖進行上采樣,然后進行2×2×2的卷積。在上采樣后獲得的特征向量與特征網絡中相應的特征向量進行串聯。串聯操作后緊跟兩個3×3×3的卷積。在骨干網絡的最后一層,經歷兩個3×3×3的卷積。接著是Mish激活函數和一個最終的1×1×1卷積塊,在網絡的最后,通過一個大小為1×1×1步幅為1的卷積層構成一個輸出模塊,經由Sigmoid激活函數輸出CT圖像的掩膜,Mish和Sigmoid函數定義如下:

其中,Softplus函數定義為:

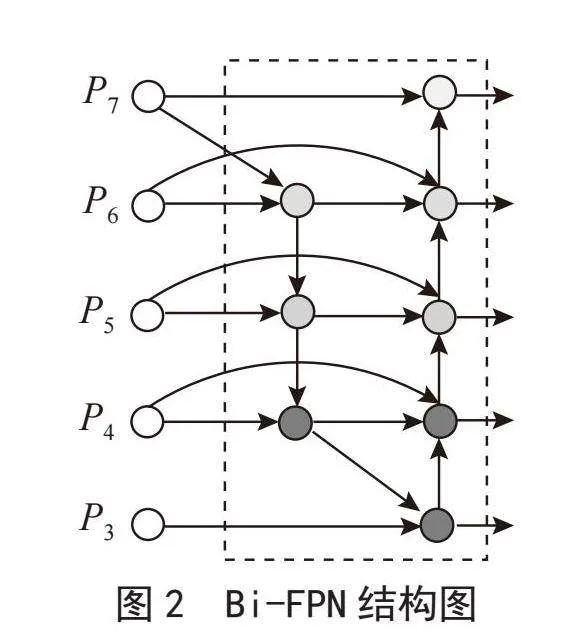

1.2 Bi-FPN

Bi-FPN [8](Bidirectional Feature Pyramid Network)是特征金字塔網絡的一種改進版本,其目標是通過引入雙向跨尺度連接和權重特征融合,提高網絡的特征提取效率,并豐富特征向量,實現對低級精細特征和高級語義特征的融合。Bi-FPN的輸入是骨干架構收縮路徑相應5個深度的特征圖,Bi-FPN的輸出饋送到骨干網絡的擴展路徑,其網絡結構圖如圖2所示。

Bi-FPN在特征融合過程中引入了每個輸入的附加權重,使得網絡能夠學習特定輸入特征的重要性。為了實現動態學習行為和準確性,實施了快速標準化融合。此外,為了提高效率,采用了深度可分離卷積,隨后進行批歸一化和非線性激活函數ReLU。通過雙向跨尺度連接,Bi-FPN豐富了網絡每個深度的特征圖,并在3D U-Net骨干架構的編碼器部分各個深度之間提供了高效的特征融合。Bi-FPN的整體結構如下:

式中p1表示自上而下路徑,p2表示自下而上路徑的特征圖;U表示上采樣操作,D表示下采樣操作;W表示帶有權重的特征融合。

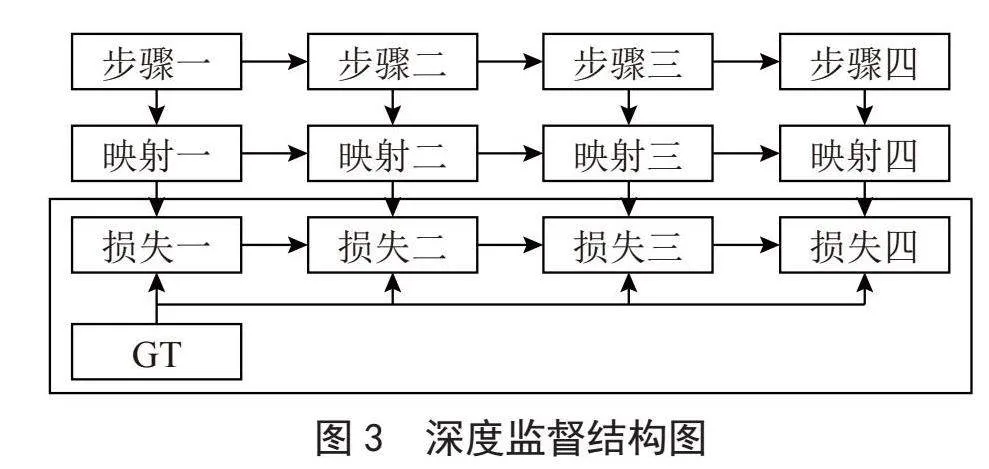

1.3 深度監督模塊

深度監督[9]是在深度神經網絡的一些中間隱藏層添加一個輔助分類器作為網絡分支,用于監督骨干網絡,以解決深度神經網絡訓練中的梯度消失和收斂緩慢的問題。其結構圖如圖3所示。

一般而言,增加神經網絡的深度能夠在一定程度上提高網絡的表征能力,但隨著深度的增加,神經網絡會逐漸變得難以訓練,包括梯度消失和梯度爆炸等現象。為了更好地訓練深層網絡,我們嘗試在神經網絡的某些層添加一些輔助分支分類器來解決這個問題。這個輔助分支分類器可以在評估隱藏層的特征圖質量方面發揮作用。

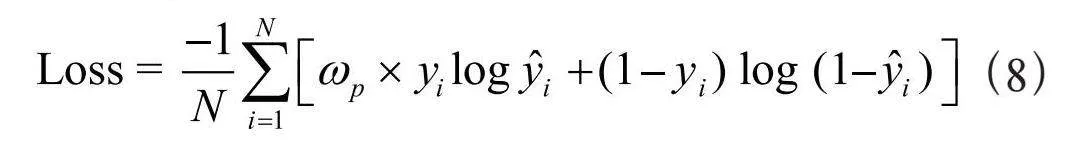

1.4 損失函數

網絡訓練的目標是提高每個掩膜中每個體素正確類別的概率。為了實現這一目標,本文采用了加權二元交叉熵損失(Weighted Binary Cross-Entropy Loss)作為損失函數。在實施加權二進制交叉熵時,通過對訓練集中的負體素與正體素的比例進行加權,對每個樣本進行了權重設置。由于肺結節掩膜中正類的大小相對較小,而負類的大小較大,訓練集的類別權重被設定為正值,從而增加了對錯誤輸出正值的懲罰。因此,網絡將學習減少對輸出負體素的偏好,以應對掩膜中的類別不平衡。加權二元交叉熵損失表達式為:

式中,N表示樣本數,ωp表示正預測權值, 表示為模型的預測值。

2 數據處理

2.1 實驗數據集

本實驗所使用的數據來自LUNA16數據集,該數據集源于規模更大的LIDC-IDRI [10]。在LIDC-IDRI數據集的1 018個CT掃描病例中,選擇厚度大于2.5 mm的888個CT圖像用于模型的訓練、驗證及測試。在這些圖像中,共包含1 186個肺結節[11],并且每張圖像都被4名經驗豐富的放射科專家進行了標注。

2.2 圖像預處理

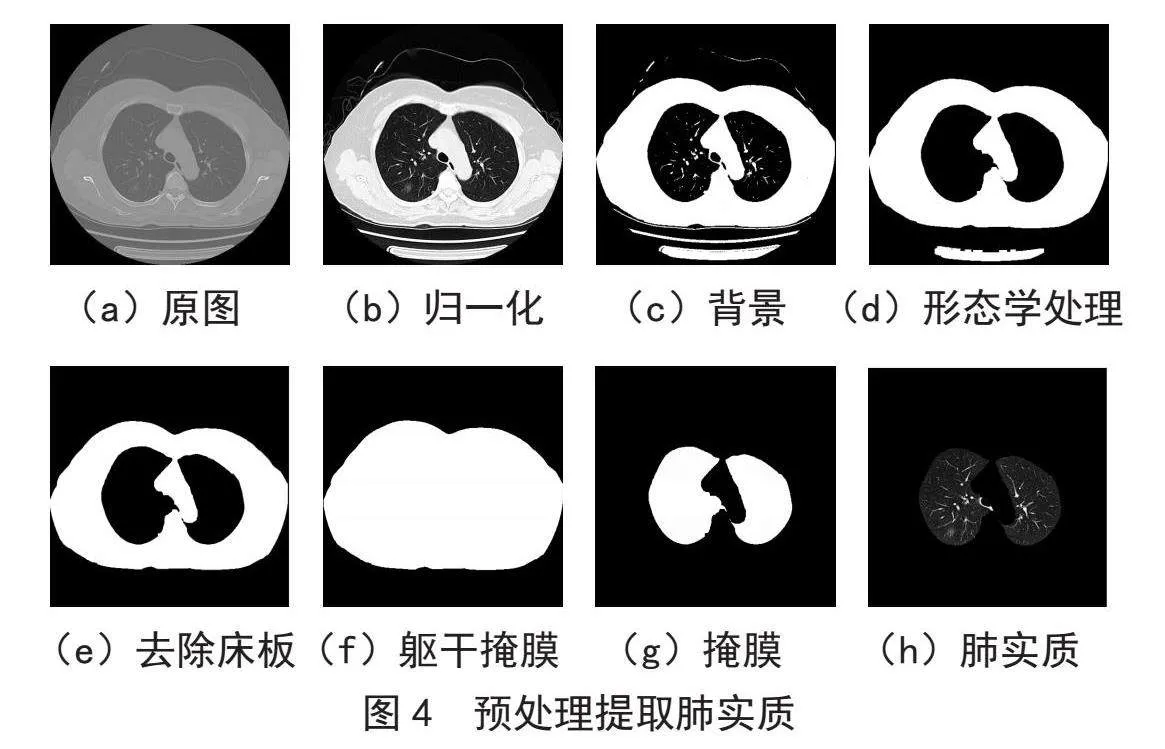

由于CT原始圖片是整個肺部的切片,冗余信息過多,因此需要先提取出肺實質再進行后續結節的分割工作。為了提高圖像的對比度,首先對圖像進行直方圖均衡化處理和二值化處理,粗略分割出肺實質。接著,采用膨脹和腐蝕兩種數學形態學方法消除肺實質噪聲,使肺實質邊緣更加平滑。最后,通過掩膜提取ROI區域,各階段圖像如圖4所示。

由于深度神經網絡對數據高度依賴,數據量較少可能導致模型過度擬合。為了緩解這一問題,對數據進行不同角度的旋轉和翻轉,生成更多的新訓練樣本,以防止過度擬合并提高分割網絡的通用性。最后,將整個數據集分成10份,其中8份用于訓練,剩下的2份分別用于驗證和測試模型。

3 實驗結果與分析

3.1 模型訓練

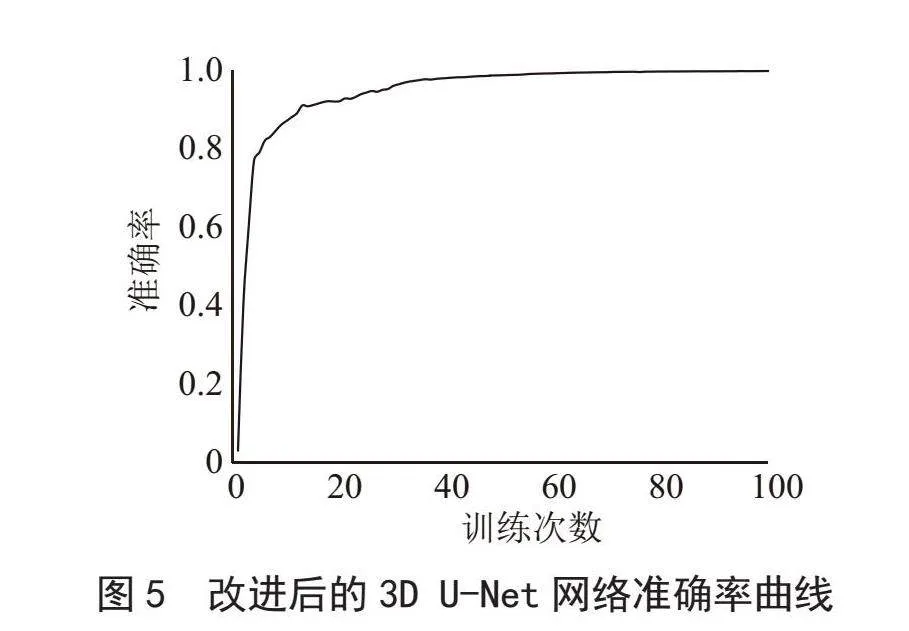

本文模型采用學習率為0.001的Adam優化器進行訓練,每迭代3次衰減為原來的0.1倍,采用的訓練迭代次數Epoch為100。圖5是模型在訓練過程中的準確率曲線,經過80個Epoch后,模型整體準確率趨于穩定。所用模型在GPU上使用TensorFlow深度學習庫實現,編碼使用的是Python 3.6。

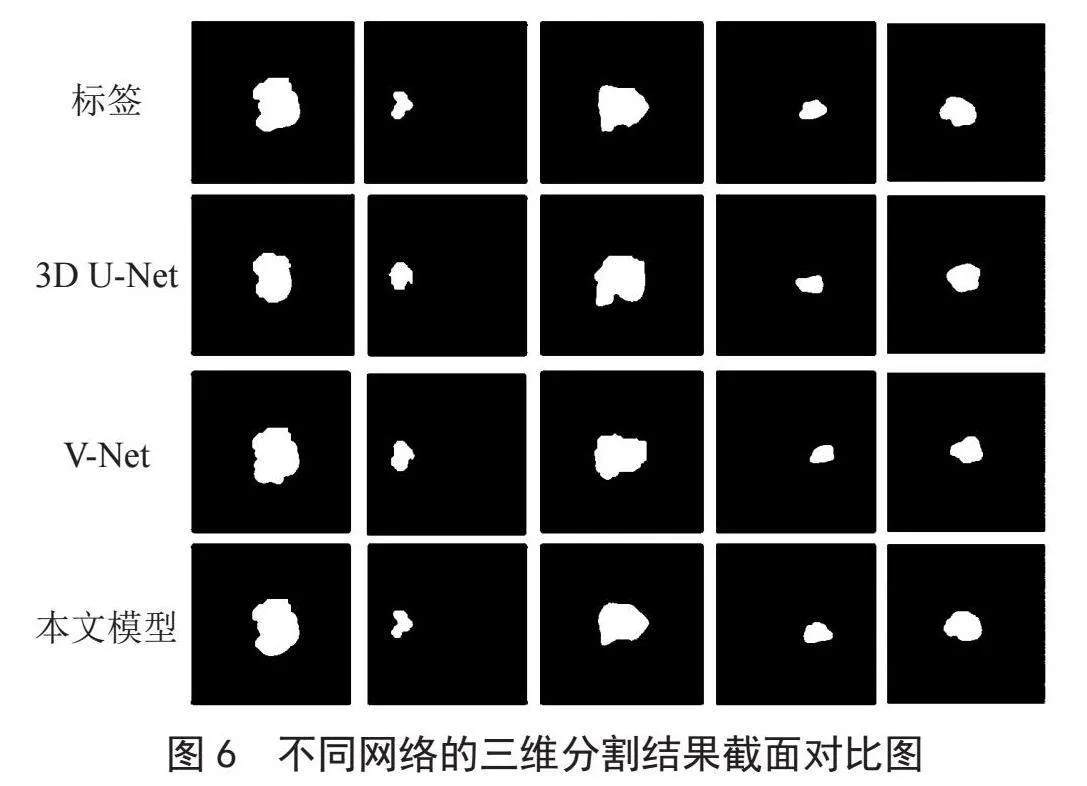

3.2 對比試驗

為了評估本文模型在肺結節分割方面的性能,我們將改進后的網絡與3D U-Net和V-Net進行了對比實驗。圖6展示了這3種網絡對5種不同尺寸肺結節圖像的三維分割剖面圖。

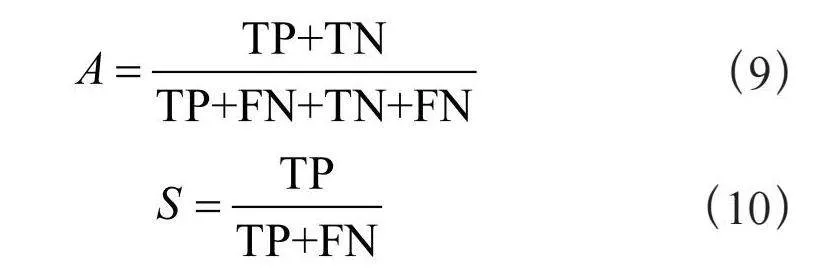

通過觀察不同網絡分割結果圖,可以清晰看出改進后的3D U-Net在結節分割方面更為準確,其分割結果更接近于標簽標注的結節邊緣信息。為了全面評估模型性能,我們將提出的模型與其他兩種網絡在LUNA16數據集下進行了分割性能的評估和比較,主要考察了3個關鍵指標:Dice系數(DSC)、靈敏度(Sensitivity)和準確率(Precision)。其中準確率(A)和靈敏度(S)的計算公式如下:

式中,TP表示真正類;TN表示真負類;FN表示假負類;FP表示假正類。

比較不同網絡結構在肺結節分割性能上的表現,表1清晰地展示了本文改進后的3D U-Net網絡在該領域取得的結果最佳。具體而言,Dice相似系數達到了79.6%,靈敏度為94.3%,精確度為93.9%。與此相反,3D U-Net和VNet兩種網絡結構在感知不同尺寸肺結節方面表現較差,難以取得準確的分割結果。相對而言,本文提出的改進的3D U-Net網絡通過引入Bi-FPN,將底層特征與頂層特征圖進行連接,從而增強了模型對不同尺寸結節的感知能力。同時,結合深度監督訓練機制,進一步提升了3D U-Net的網絡性能,最終實現了卓越的肺結節分割效果。

4 結 論

本研究提出了一種基于改進的3D U-Net肺癌CT圖像分割網絡。該網絡通過在編碼器和解碼器之間引入雙向特征網絡,促使特征在不同深度之間雙向傳播,從而增強模型的適應性和感知能力,顯著提高了模型分割準確性。同時采用深度監督機制,提高了網絡的性能和泛化能力。

然而,雖然該算法取得了一定的成果,但仍存在一些局限性,需要在未來的研究中進行改進。肺結節種類繁多且判斷標準復雜,目前的數據集并未充分涵蓋肺結節的多樣性,因此該算法尚未完全應用于臨床實踐。隨著技術的不斷進步,計算機輔助診斷系統有望在肺結節檢測領域發揮更為重要的作用。未來的研究可以側重于擴充數據集、改進算法以適應更多肺結節的多樣性,并不斷優化系統,以提高在臨床環境中的實用性和準確性。

參考文獻:

[1] 周清華,范亞光,王穎,等.中國肺部結節分類、診斷與治療指南:2016年版 [J].中國肺癌雜志,2016,19(12):793-798.

[2] ARMATO S G,GIGER M L,MORAN C J,et alQb3h9HaYQJKehJHD0vH8RA==. Computerized detection of Pulmonary Nodules on CT Scans [J].Radiographics,1999,19(5):1303-1311.

[3] LONG J,SHELHAMER E,DARRELL T. Fully Convolutional Networks for Semantic Segmentation [C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Boston:IEEE,2015:3431-3440.

[4] ?I?EK ?,ABDULKADIR A,LIENKAMP S S,et al. 3D U-Net: Learning Dense Volumetric Segmentation from Sparse Annotation [C]//Medical Image Computing and Computer-Assisted Intervention–MICCAI 2016.Athens:Springer,2016:424-432.

[5] MILLETARI F,NAVAB N,AHMADI S,et al. V-Net: Fully Convolutional Neural Networks for Volumetric Medical Image Segmentation [C]//2016 Fourth International Conference on 3D Vision (3DV).Stanford:IEEE,2016:565-571.

[6] LIN H B,XIA L Z,ZHANG Y H,et al. Research of Lung Nodule Segmentation Algorithm Based on 3D U-Net Network [C]//2022 IEEE 10th Joint International Information Technology and Artificial Intelligence Conference (ITAIC).Chongqing:IEEE,2022:1795-1799.

[7] HUANG G,LIU Z,MAATEN L V D,et al. Densely Connected Convolutional Networks [C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu:IEEE,2017:2261-2269.

[8] LIN T Y,DOLLáR P,GIRSHICK R,et al. Feature Pyramid Networks for Object Detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Honolulu:IEEE,2017:936-944.

[9] YANG J Z,WU B,LI L T,et al. MSDS-UNet: A multi-Scale Deeply Supervised 3D U-Net for Automatic Segmentation of Lung Tumor in CT [J/OL].Computerized Medical Imaging and Graphics,2021,92:101957[2023-12-03].https://pubmed.ncbi.nlm.nih.gov/34325225/.

[10] ARMATO S G,MCLENNAN G,BIDAUT L,et al. The Lung Image Database Consortium (LIDC) and Image Database Resource Initiative (IDRI): a completed reference database of lung nodules on CT scans [J].Medical physics,2011,38(2):915-931.

[11] HARITH M Z M Z,NOOR N M,IDRIS M Y I,et al. Intersection and Complement Set (IACS) Method to Reduce Redundant Node in Mobile WSN Localization [J/OL].Sensors,2018,18(7):2344[2023-12-03].https://pubmed.ncbi.nlm.nih.gov/30029508/.

作者簡介:石征錦(1963—),男,漢族,遼寧錦州人,教授,碩士,主要研究方向:先進控制理論及應用、現代檢測與自動化裝置;李文慧(1997—),女,漢族,遼寧鞍山人,碩士研究生在讀,主要研究方向:復雜系統綜合自動化技術;高天(1998—),男,漢族,遼寧朝陽人,碩士研究生在讀,主要研究方向:復雜系統綜合自動化技術。