基于圖神經網絡的航空數據異常檢測

摘 要:飛行品質監控(FOQA)數據記錄了飛行狀態的詳細參數,對于評估飛行操作的質量和安全性至關重要。傳統的“超限檢測”算法通過與預先建立的閾值進行比較來識別異常行為。相比之下,深度學習方法能夠更全面、靈活地分析FOQA數據,提高異常行為的檢測精度。文章提出的TAGDNet是用于FOQA數據多類別異常檢測的創新框架,包括時序卷積網絡、圖神經網絡和分層圖池化等關鍵組件。該框架首先通過時序卷積網絡提取時序特征,然后通過引入圖神經網絡進行節點間信息傳播,最后通過分層圖池化獲得異常檢測結果。通過在公開可用的FOQA數據多類別異常檢測數據集上進行大量實驗證明,該方法相較于其他先進的方法表現更為優越。

關鍵詞:FOQA數據;異常檢測;圖神經網絡;圖池化;時序卷積

中圖分類號:TP391;TP183 文獻標識碼:A 文章編號:2096-4706(2024)16-0053-07

Aviation Data Anomaly Detection Based on Graph Neural Networks

Abstract: Flight Operational Quality Assurance (FOQA) data records detailed parameters of flight status, which is crucial for evaluating the quality and safety of flight operations. Traditional “Exceedance Detection” algorithm identifies abnormal behavior by comparing it with predefined threshol1xrabizTN6g5MLF7p0P9ZA==ds. In contrast, Deep Learning methods can comprehensively and flexibly analyze FOQA data, improving the accuracy of abnormal behavior detection. The TAGDNet proposed in the paper is an innovative framework for multi-class abnormal detection in FOQA data, including key components such as Temporal Convolutional Networks, Graph Neural Networks, and Hierarchical Graph Pooling. The framework extracts temporal features through Temporal Convolutional Networks firstly, then propagates information between nodes through introducing Graph Neural Networks and finally obtains abnormal detection results through Hierarchical Graph Pooling. Through extensive experiments on publicly available FOQA multi-class abnormal detection datasets, it has been demonstrated that this method outperforms other state-of-the-art methods.

Keywords: FOQA data; anomaly detection; Graph Neural Networks; graph pooling; temporal convolutional

0 引 言

隨著航空運輸業的迅速發展,飛機數量和航班次數的增加使飛行監控任務變得復雜。通過實時監測飛機系統、引擎和飛行過程能及早發現并識別潛在異常情況,確保飛行安全。傳統飛行監控方法主要依賴與預設閾值進行比較,僅適用于預定義異常情況,難以有效分析FOQA(Flight Operations Quality Assurance)數據中的未知異常,也無法滿足對監控效率和準確性的需求。因此,引入先進的異常檢測技術成為提高航空安全性的必然選擇。

近年來,隨著人工智能和深度學習等領域的發展,異常檢測技術在航空領域備受關注。異常檢測的目標是識別與大多數數據明顯不同的樣本。深度學習算法通過學習“決策邊界”來檢測輸入數據中的異常模式。Li等人[1]通過對同一組已知11個異常的數據進行實驗,比較了多核異常檢測(Multiple Kernel Anomaly Detection, MKAD)[2-3]和聚類異常檢測算法[1]的性能。

然而,本文的首要目標是開發一種專用于FOQA數據異常檢測的方法,通過捕捉傳感器之間的關聯關系以實現更高精度的異常檢測。隨著圖神經網絡(Graph Neural Network, GNN)的引入[4],基于圖的方法通過邊來表示傳感器之間的相互依賴關系。GNN采用局部聚合機制,遞歸地聚合和轉換其鄰居的信息,計算每個節點的嵌入向量。這種方法的優勢在于能夠捕捉到節點之間的潛在關聯。

對于FOQA數據多類別異常檢測任務,很難找到預定義的圖結構。圖偏差網絡(Graph Deviation Network, GDN)[5]通過余弦相似度對可建模為圖的相鄰矩陣進行精細的兩兩關系學習。MTAD-GAN[6]將面向特征和面向時間的圖注意層連接起來學習圖結構。目前,大多數時間序列GNN都是為交通預測而設計的,而在FOQA數據多類別異常檢測任務中存在需要填補的空白。為了解決上述問題,本文設計了一種帶有注意力機制的時序卷積網絡,引入自動圖結構學習方法,使用圖神經網絡實現傳感器數據之間的信息傳播,以及通過分層圖池化技術提高模型性能。

1 問題陳述

本節旨在明確闡述本文所涉及的關鍵概念和符號。

1.1 問題定義

FOQA數據就是按照時間記錄的飛行相關信息,是典型的多變量時間序列。它可以用多變量時間序列表示:X={x1,x2,…,xd}∈Rd×l,其中Xi={xi1,xi2,…,xil}且i=1,2,…,d。這里l∈N*表示多元時間序列的長度。給定一組多元時間序列X={X1,X2,…,Xd}∈Rm×d×l

和相應的標簽Y={y1,y2,…,ym},其中y表示每個多元時間序列的預定義類標簽,m∈N*表示時間序列的個數。FOQA數據多類別異常檢測任務的目標是通過訓練分類器f(?)從X到Y,以預測未標記的多變量時間序列。

1.2 圖相關概念

時態圖由多變量時間序列構成,其形式為G=(V,E),其中V={v1,v2,…,vn}表示包含n個節點的節點集,E表示邊的集合。這里,節點表示變量,而邊則表示由相似性或結構學習結果定義的不同變量之間的關系。鄰接矩陣A可以表示一個n×n的矩陣,其中A(i,j)表示節點i到節點j是否有邊相連或者邊的權重。

2 方法簡介

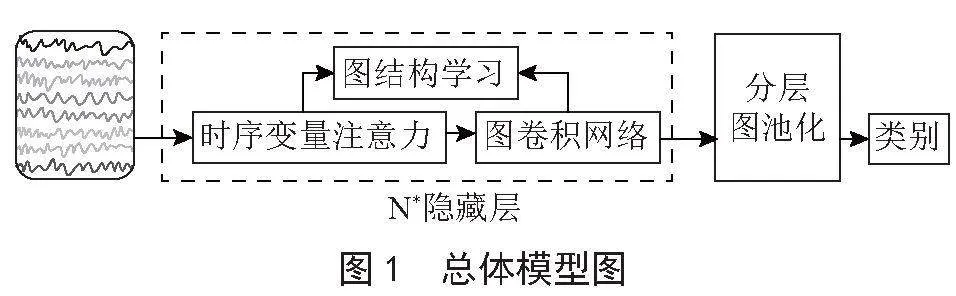

在實際的FOQA數據中,傳感器之間呈現復雜的拓撲關系。將整個傳感器網絡視為圖結構,每個傳感器被看作圖中的一個節點。為了提取時序特征的,采用帶有注意力機制的時序卷積網絡。通過高斯核函數度量節點之間的關系,學習圖結構,并將其輸入圖卷積層以建模信息傳播。最后,將時序卷積層和圖卷積層集成,可進行多層操作,并通過分層圖池化操作得到多類別異常檢測的結果,整體模型架構被命名為TAGDNet(Temporal Attention Graph Neural Network with Differentiable Pooling NetworL9tcpOVCaw+c5g11VSNZsl4aXvq7mBn0Ymy1a9cJM64=k),如圖1所示。

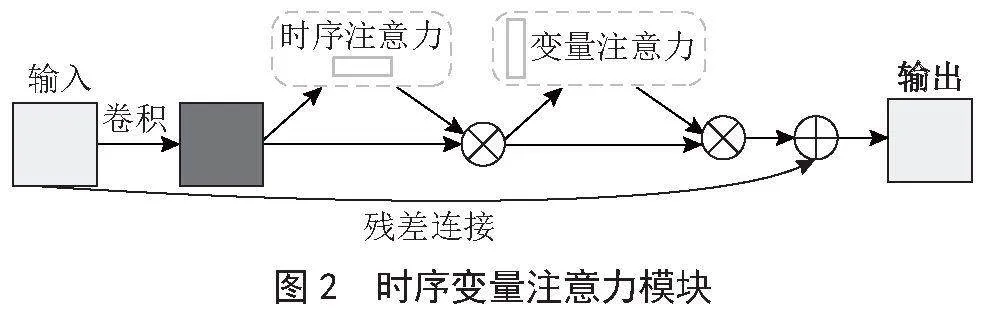

2.1 時序變量注意力

Woo等人[7]提出了CBAM(Convolutional Block Attention Module),這是一種輕量級的視覺注意力模塊,能夠在通道和空間維度上執行注意力操作。受此啟發,本文提出了時序變量注意力模塊,旨在突出時序信息和關鍵特征,該模塊由時序注意力和變量注意力兩部分組成,能夠在時間維度和變量維度執行注意力操作,如圖2所示。

2.1.1 時序注意力

為了捕捉序列的整體趨勢和關鍵信息,引入了自適應平均池化和自適應最大池化。自適應平均池化通過計算輸入序列每個時間步的平均值生成整體平均特征表示。相對應地,自適應最大池化通過計算每個時間步的最大值,突出序列中的顯著特征。隨后,通過兩個一維卷積層,將輸入特征映射到新的表示。最后,將這兩個特征相加,使模型能夠同時捕捉時間維度上的整體趨勢和關鍵特征,提高對多元時間序列的表征能力。具體的數學表達式如下:

TA(x)=(C2(R(C1(AdaAvgPool(x)+C2(R(C1(AdaMaxPool(x)))) (1)

其中,x表示輸入序列,C1和C2表示兩個一維卷積層,卷積核大小均為1,填充為0。R表示ReLU激活函數,AdaAvgPool表示一維自適應平均池化,AdaMaxPool表示一維自適應最大池化。表示Sigmoid激活函數。

2.1.2 變量注意力

為了捕捉各傳感器的整體趨勢和關鍵信息,該模塊通過在變量維度上計算均值和最大值,實現了對輸入序列的全局性信息提取。均值關注于變量的平均水平,有助于捕捉序列的整體趨勢。而最大值操作突出了在每個變量上的最顯著特征,有助于捕捉序列中的峰值、異常值或其他重要的局部變化。為了融合這兩種關注方式的信息,通過拼接操作將均值和最大值在變量維度上進行組合。然后通過一維卷積層對拼接后的序列進行進一步的特征提取和注意力增強。具體公式如下:

FA(x)=(C(concat(mean(x),max(x)) (2)

其中,mean(x)表示沿變量維度計算均值,max(x)表示沿變量維度計算最大值,concat表示沿著變量維度進行拼接,C表示一維卷積,輸入通道為2,輸出通道為1,卷積核大小為7,填充為3。表示Sigmoid激活函數。

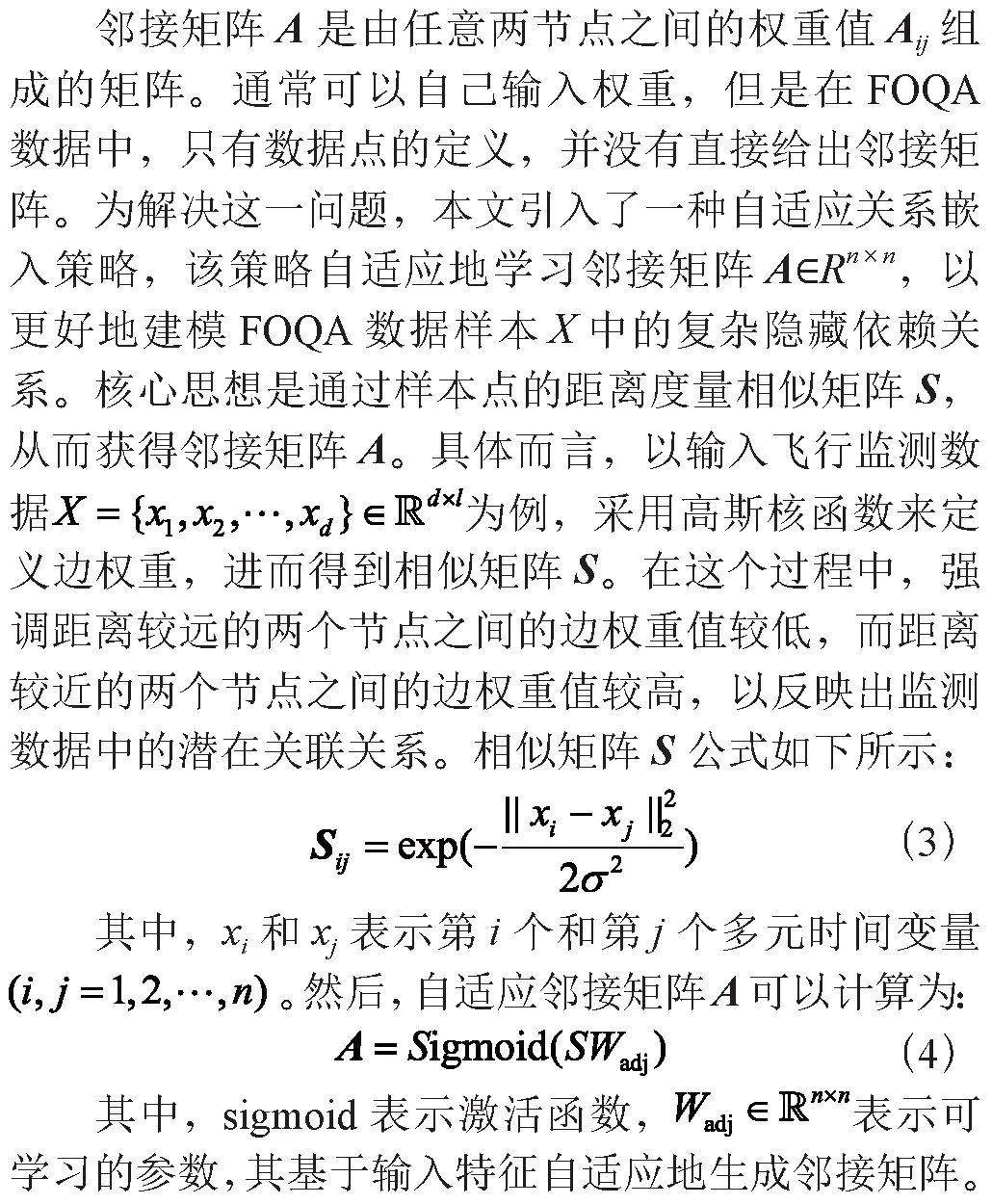

2.2 圖結構學習

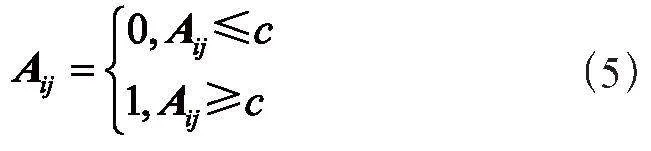

為了提高訓練效率,減少噪聲影響并增強模型魯棒性,設置閾值c以實現鄰接矩陣的稀疏性。具體而言,只保留鄰接矩陣A中前k個最大權重的元素,(其中k取節點數的值,即k=20),將這些元素設為1,并將其他值設置為0,如下所示:

2.3 圖神經網絡

在已學習的拓撲結構基礎上,圖卷積模塊的設計旨在進一步建模信息傳播過程,通過整合鄰居節點的信息來更新每個特定節點的表示。在處理異常檢測等任務時,通常異常的發生涉及一個或多個節點,形成一系列鏈式影響。因此,為了直觀地捕捉節點之間的差異,使用GraphSAGE[8]算法進行傳播計算。GraphSAGE的關鍵思想是通過采樣鄰居節點和聚合鄰居信息來生成每個節點的向量表示,從而捕捉圖中的結構信息。以下是GraphSAGE的主要步驟:

首先對于每個節點v,從其鄰居節點中隨機采樣一定數量的節點。這些采樣的鄰居節點用集合N(v)表示:

其中,表示節點v的所有鄰居節點。

其次聚合鄰居節點信息,對于每個節點v,將其采樣的鄰居節點的特征進行聚合,得到一個聚合的鄰居特征表示。這通常通過平均或池化操作來實現:

其中,表示節點v的第一層表示,表示節點u的初始特征表示。

再次,使用聚合的鄰居特征表示來更新節點v的表示:

其中,表示激活函數,W表示可學習的權重矩陣,conact表示將兩個向量連接起來。

最后,通過多次重復上述過程,得到多層的節點表示:

其中,l表示迭代的層數。

2.4 分層圖池化

傳統的GNN池化方式采用全局池化對圖中所有節點的嵌入進行處理,卻忽略了圖中的層次結構,這限制了模型的有效性。相比之下,DiffPool(Differentiable Pooling)是一種專為圖神經網絡設計的池化操作[9],其優勢在于能夠學習到網絡的層次化表示,從而提高模型的表達能力。在經過圖神經網絡后使用DiffPool的方法進行分層池化,以更好地捕捉圖的層次信息。以下是DiffPool的主要步驟:

對于第l層來說,數學公式可以寫為:

其中A(l)表示第l層的鄰接矩陣,X (l)表示第l層的節點特征。節點的表示Z (l)是通過應用圖神經網絡模型來計算的。A(l+1)和X (l+1)表示經過分層池化后的新的鄰接矩陣和節點特征。每次經過一次DiffPool,相應的節點個數減少,直至最后一次保留一個節點。假設該節點包含一個d維向量,從該向量出發得到最終的異常分類結果。

DiffPool的過程包括兩個關鍵步驟。首先,利用一個GNN通過輸入

鄰接矩陣A(l)和和節點特征X (l)抽取信息生成表示Z (l),其表達式為:

其次,通過另一個GNN,該GNN用于計算權重矩陣S (l),這個權重矩陣反映了上一層中的每個節點以何種權重被分配到下一層的哪些節點中。權重矩陣的計算使用Softmax函數,如下:

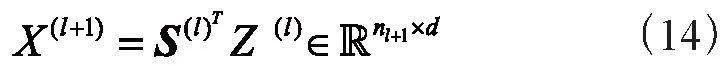

接下來,通過以下形式生成新一層的節點鄰接矩陣和節點特征,實際上是根據學習到的權重矩陣進行加權聚合。具體而言,新一層的節點特征X (l+1)通過對Z (l)進行的加權聚合得到,表達式為:

同時,新一層的節點鄰接矩陣A(l+1)通過對A (l)和S (l)進行相應的加權聚合計算得到,表達式為:

這一過程明確展示了通過學習得到的權重矩陣,實現了有效的節點信息傳遞和分層圖池化。

3 實驗評估

本節分為三個子節,包括實驗設置、消融實驗、對比實驗,對所提出的模型進行全面評估。

3.1 實驗設置

3.1.1 評價指標

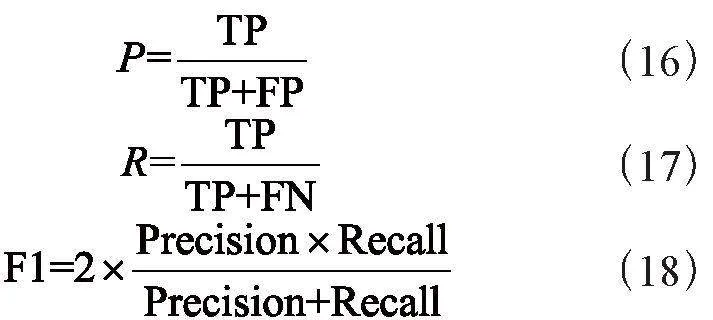

本文主要旨在準確檢測FOQA數據中的異常類別,使用精確率(P)、召回率(R)、F1分數這三個評價指標來對模型進行全面評價。具體計算公式如下:

其中,TP表示真陽性(真實類別是正類,并且模型識別的結果也是正類),TN表示真陰性(真實類別是負類,并且模型將其識別為負類),FP表示假陽性(真實類別是負類,并且模型將其識別為正類),FN表示假陰性(真實類別是正類,但模型將其識別為負類)。

3.1.2 數據集

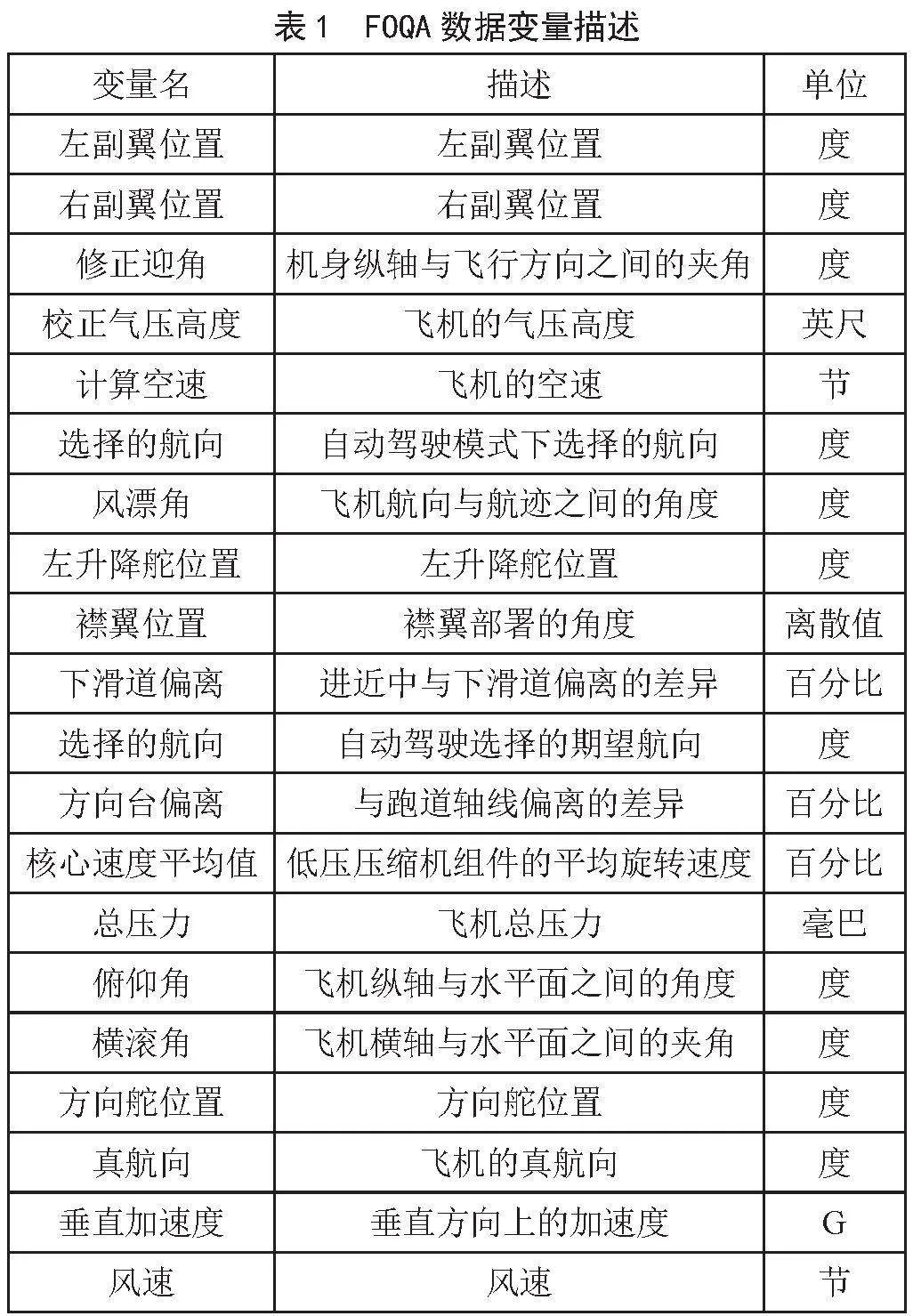

本文使用了一個基于商業航空公司FOQA數據的多類別異常檢測數據集[10]。該數據集包括每次飛行的1 Hz記錄,涵蓋了各種系統,如飛機的狀態和方向、控制表面的位置和輸入、發動機參數、自動駕駛模式及其相應狀態。研究中使用了20個變量進行實驗,詳細變量名如表1所示。這些數據在飛機飛行過程中實時獲取,并在飛機抵達目的地登機口后由航空公司下載。專業人員對這些FOQA數據進行分析,以標記已知事件并創建相應的標簽。每個數據實例都代表飛機接近著陸期間的記錄,持續160秒。

該數據集包括99 837個數據實例,包括四個類別:

1)正常(占總數據的89.81%)此類別包括那些已知不存在其他三個異常類別的實例。

2)速度異常(占總數據的7.02%),通過檢測進近過程中與目標著陸空速的偏差來識別異常。

3)路徑異常(占總數據的2.21%),包含那些著陸下降路徑明顯偏離下滑道的實例。

4)控制異常(占總數據的0.96%),將那些在接近著陸期間,與預期的標稱展開相比,襟翼伸展延遲的情況標記為控制異常。為了保證數據集的公平性,按照6:2:2的比例劃分為訓練集、驗證集和測試集,并且每個樣本集中各類異常的比例相同。

3.1.3 實現細節

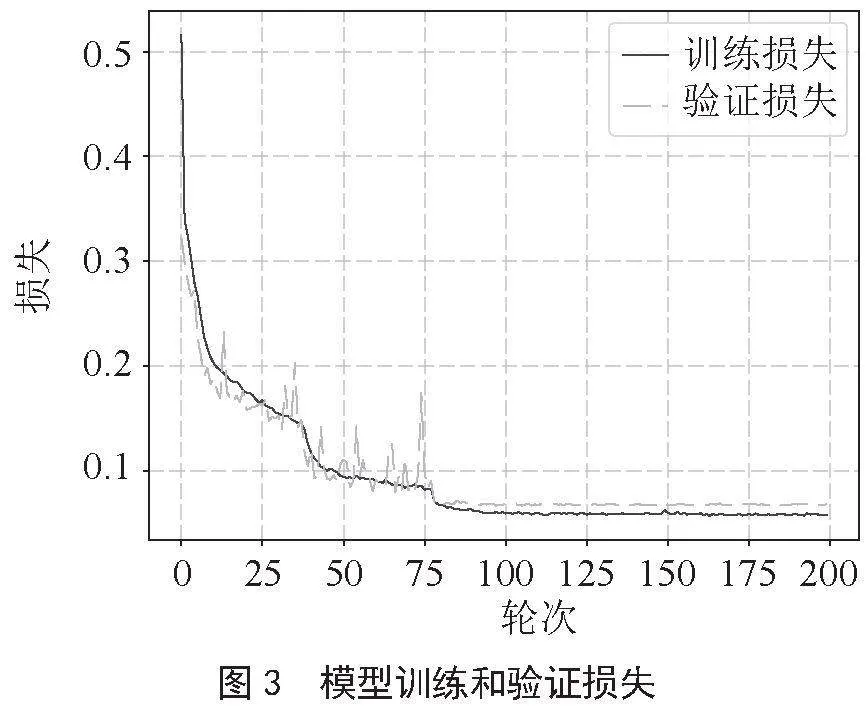

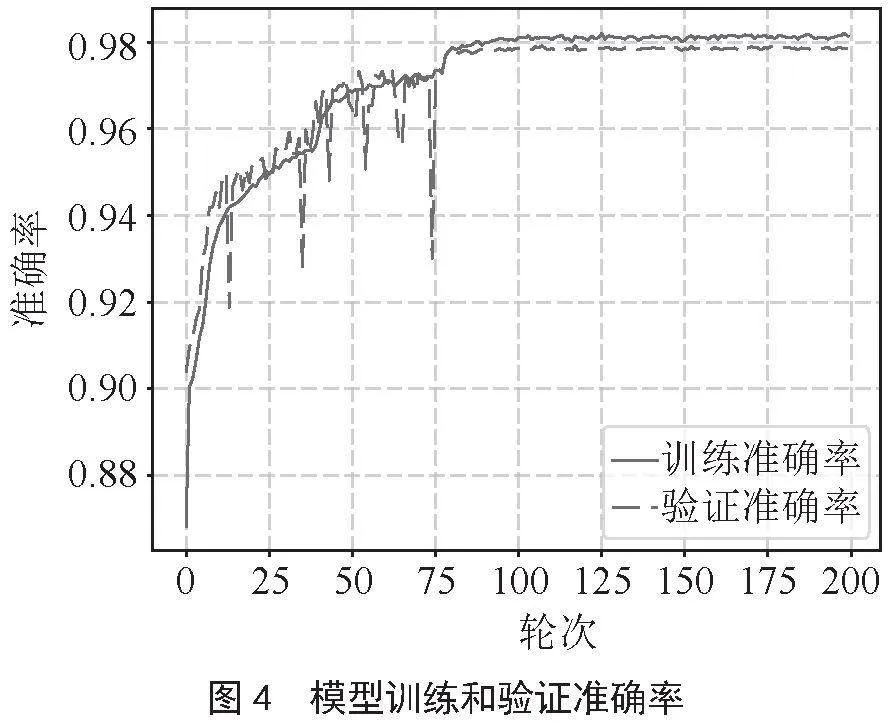

在Ubuntu 18.04系統上,采用了PyTorch 1.12.0、CUDA 11.3和Torch-Geometric 2.1.0,在NVIDIA 3090 Ti上來實現所有模型。對模型進行了200輪次的訓練,訓練期間最后一輪模型用于評估,并記錄了測試集上每個類別的實驗結果。訓練過程中批次的大小為128,采用了Adam優化器,隨機丟棄率為0.05,初始學習率為0.003,在經過150個輪次后將學習率調整為0.001,模型損失如圖3所示,準確率如圖4所示。

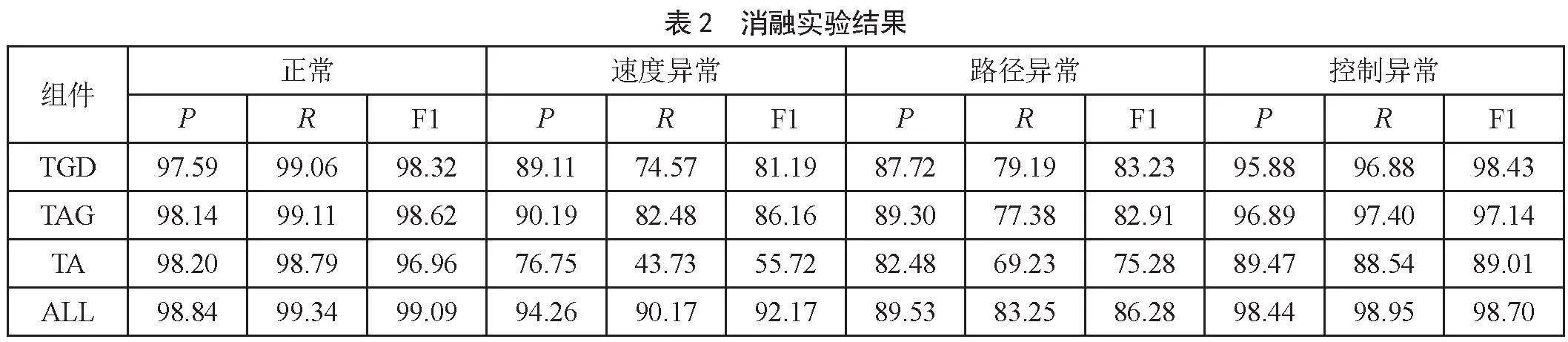

3.2 消融實驗

本小節將深入探討TAGDNet模型的各個組成部分的貢獻,具體包括:

1)TGD具有圖卷積模塊和分層圖池化模塊的模型,但沒有使用注意機制。

2)TAG具有注意力機制和圖卷積模塊,但沒有分層圖池化模塊的模型。

3)TA僅有注意機制,沒有圖卷積和分層圖池化的模型。

消融實驗結果如表2所示,組件ALL取得最佳結果。

基于消融實驗結果,研究得出了兩個重要結論。首先,TAGDNet模型,結合了注意力時序卷積和分層池化的圖神經網絡,實現了在真實數據集上的最佳性能,凸顯其有效的多類別異常檢測能力。其次,具有圖神經網絡的變體優于僅有注意力機制的變體,證明在TAGDNet模型中,圖神經網絡的影響更為顯著。

在深度學習模型中,隱藏層數是決定模型復雜性和性能的關鍵參數之一。為了探究隱藏層數對模型性能的影響,進行了隱藏層數消融實驗,通過調整隱藏層數(分別為3、5、7、9、11、13和15)來評估該參數的影響,結果如表3所示。正常和速度異常時,P、R、F1均在9層取得最佳結果。路徑異常時,P、R、F1分別在3層、7層、15層取得最佳結果。控制異常時,P在13層取得最佳結果,R、F1均在9層取得最佳結果。

經過實驗觀察與分析,在增加隱藏層數的過程中,模型的性能首先得到顯著提升。具體而言,隨著隱藏層數的增加,多異常分類的準確性不斷提高。這表明增加隱藏層數有助于模型更好地捕捉數據中的復雜特征,提高了其對異常樣本的準確分類能力。然而,當隱藏層數增加到一定值(即9層)之后,模型性能開始下降。這可能是由于過多的隱藏層數導致模型發生過擬合的原因。

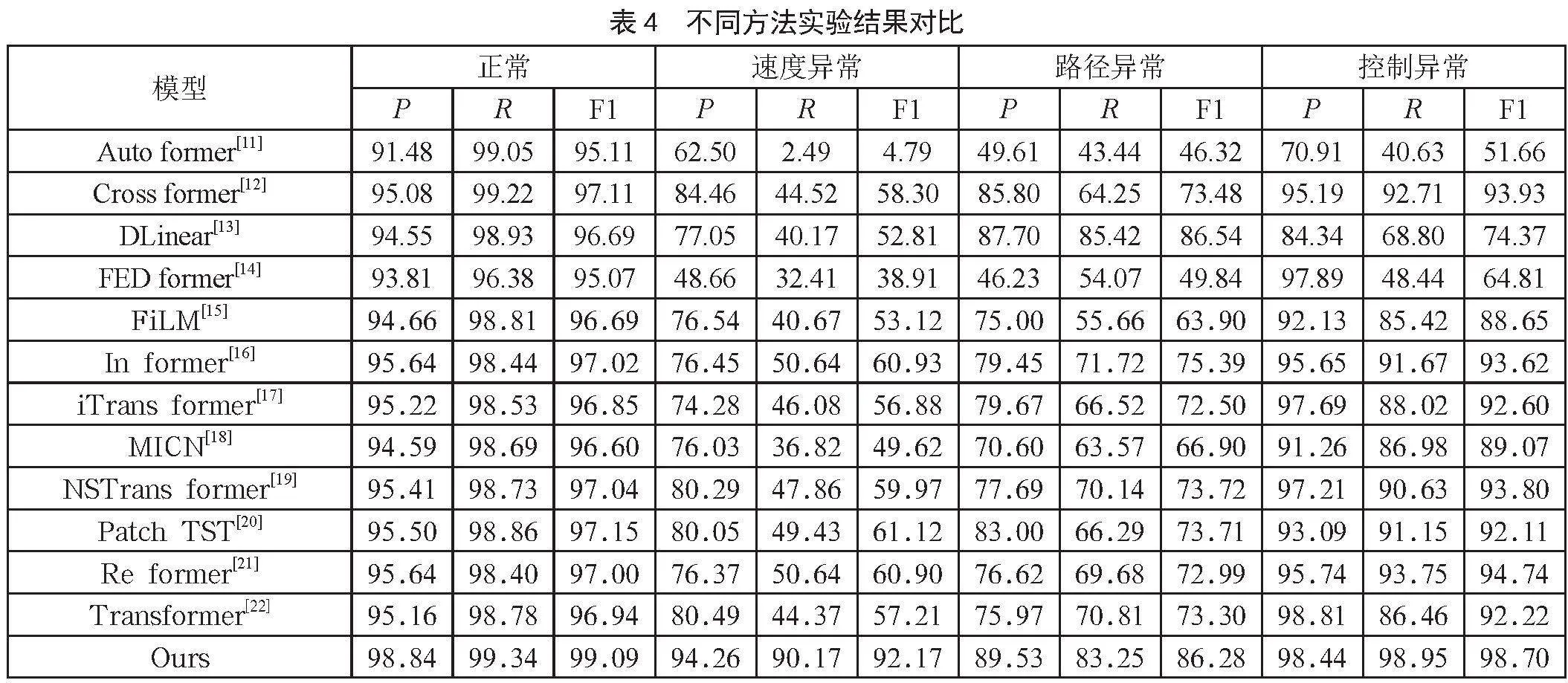

3.3 對比實驗

為了驗證TAGDNet的性能,選擇了最先進的方法作為基線進行比較,結果如表4所示,除了DLinear在路徑異常時R和F1結果最佳,其他情況下都是我們設計的模型獲得最佳結果,可以看出TAGDNet在數據集上實現了最高的分類精度。特別是TAGDNet的圖結構機制相較最先進的方法有著顯著改進。這表明不同傳感器之間的隱藏依賴關系共同決定了異常行為,而TAGDNet能夠很好地捕捉到這些復雜關系。

4 結 論

在這項工作中,本文提出了TAGDNet,一個基于圖神經網絡的FOQA數據異常檢測框架。為了提取FOQA數據的重要特征,提出了注意力時序卷積網絡。同時,通過引入圖結構學習和圖神經網絡來處理傳感器變量之間的相互依賴關系,并最終通過分層圖池化方法克服圖神經網絡的平坦性問題。大量實驗證明了該策略在分類精度方面優于其他最先進的方法,并通過消融實驗證明了各部分組件的有效性。未來的研究方向將集中在將這種方法與半監督學習策略相結合,以便在缺少標簽的航空大數據場景中實現更好的應用。

參考文獻:

[1] LI L S,GAREL M,HANSMAN R J,et al. Anomaly Detection in Onboard-recorded Flight Data Using Cluster Analysis [C]//2011 IEEE/AIAA 30th Digital Avionics Systems Conference.Seattle:IEEE,2011:1-11.

[2] DAS S,MATTHEWS B,SRIVASTAVA A,et al. Multiple Kernel Learning for Heterogeneous Anomaly Detection: Algorithm and Aviation Safety Case Study [C]//Proceedings of the 16th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining.Washington:ACM,2010:47-56.

[3] DAS S,MATTHEWS B,LAWRENCE R. Fleet Level Anomaly Detection of Aviation Safety Data [C]//2011 IEEE Conference on Prognostics and Health Management.Denver:IEEE,2011:1-10.

[4] SCARSELLI F,GORI M,TSOI A C,et al. The Graph Neural Network Model [J].IEEE Transactions on Neural Networks,2009,20(1):61-80.

[5] DENG A L,HOOI B. Graph Neural Network-based Anomaly Detection in Multivariate Time Series [C]//Proceedings of the AAAI Conference on Artificial Intelligence.2021,35(5):4027-4035.

[6] ZHAO H,WANG Y J,DUAN J Y,et al. Multivariate Time-series Anomaly Detection Via Graph Attention Network [J/OL].arXiv:2009.02040 [cs.LG].(2020-09-04).https://arxiv.org/abs/2009.02040.

[7] WOO S,PARK J,LEE J,et al. CBAM: Convolutional Block Attention Module[J/OL].arXiv:1807.06521 [cs.CV].(2018-07-17).https://arxiv.org/abs/1807.06521v1.

[8] HAMILTON W L,YING R,LESKOVEC J. Inductive Representation Learning on Large Graphs [J/OL].arXiv:1706.02216 [cs.SI].(2017-06-07).https://arxiv.org/abs/1706.02216v2.

[9] YING R,YOU J X,MORRIS C,et al. Hierarchical Graph Representation Learning with Differentiable Pooling [J/OL]. arXiv:1806.08804 [cs.LG].(2018-06-22).https://arxiv.org/abs/1806.08804.

[10] MATTHEWS B. Curated 4 Class Anomaly Detection Data Set [EB/OL].(2022-12-22).https://c3.ndc.nasa.gov/dashlink/resources/1018/.

[11] WU H X,XU J H,WANG J M,et al. Autoformer: Decomposition Transformers with Auto-correlation for Long-term Series Forecasting [J/OL].arXiv:2106.13008 [cs.LG].(2021-06-24).https://arxiv.org/abs/2106.13008.

[12] ZHANG Y H,YAN J C. Crossformer: Transformer Utilizing Cross-dimension Dependency for Multivariate Time Series Forecasting [C]//The Eleventh International Conference on Learning Representations.Kigali :ICLR,2023:1-21.

[13] ZENG A L,CHEN M X,ZHANG L,et al. Are Transformers Effective for Time Series Forecasting? [J/OL].arXiv:2205.13504 [cs.AI].(2022-05-26).https://arxiv.org/abs/2205.13504.

[14] ZHOU T,MA Z Q,WEN Q S,et al. FEDformer: Frequency Enhanced Decomposed Transformer for Long-term Series Forecasting [J/OL].arXiv:2201.12740 [cs.LG].(2022-01-30).https://arxiv.org/abs/2201.12740.

[15] ZHOU T,MA Z Q,WANG X,et al. FiLM: Frequency Improved Legendre Memory Model for Long-term Time Series Forecasting [J/OL].arXiv:2205.08897 [cs.LG].(2022-05-18).https://arxiv.org/abs/2205.08897.

[16] ZHOU H Y,ZHANG S H,PENG J Q,et al. Informer: Beyond Efficient Transformer for Long Sequence Time-series Forecasting [J/OL].arXiv:2012.07436 [cs.LG].(2020-12-14).https://arxiv.org/abs/2012.07436v1.

[17] LIU Y,HU T G,ZHANG H R,et al. ITransformer: Inverted Transformers are Effective for Time Series Forecasting [J/OL].arXiv:2310.06625 [cs.LG].(2023-10-10).https://arxiv.org/abs/2310.06625.

[18] WANG H Q,PENG J2a71d5668ab474192922bbc5dee372b0,HUANG F H,et al. MICN: Multi-scale Local and Global Context Modeling for Long-term Series Forecasting [C]//The Eleventh International Conference on Learning Representations.Kigali:ICLR,2023:1-22.

[19] LIU Y,WU H X,WANG J M,et al. Non-stationary Transformers: Exploring the Stationarity in Time Series Forecasting [J/OL].arXiv:2205.14415 [cs.LG].(2022-05-28).https://arxiv.org/abs/2205.14415.

[20] NIE Y Q,NGUYEN N H,SINTHONG P,et al. A Time Series is Worth 64 Words: Long-term Forecasting with Transformers [J/OL].arXiv:2211.14730 [cs.LG].(2022-11-27).https://arxiv.org/abs/2211.14730.

[21] KITAEV N,KAISER ?,LEVSKAYA A. Reformer: The Efficient Transformer [J/OL].arXiv:2001.04451 [cs.LG].(2020-01-13).https://arxiv.org/abs/2001.04451.

[22] VASWANI A,SHAZEER N,PARMAR N,et al. Attention is all You Need [J/OL].arXiv:1706.03762 [cs.CL].(2017-06-12).https://arxiv.org/abs/1706.03762v2.