商家評論的情感分類研究和應用

袁立宇,鞠久朋,楊豪杰,宋平波

(1.中國電信股份有限公司廣東研究院 廣州 510630;2.海量信息技術有限公司 北京 100190)

商家評論的情感分類研究和應用

袁立宇1,鞠久朋2,楊豪杰1,宋平波1

(1.中國電信股份有限公司廣東研究院 廣州 510630;2.海量信息技術有限公司 北京 100190)

大多數基于有指導機器學習方法的情感分類采用N元(n-gram)詞袋(bag-of-words)模型,使用二值(binary)作為特征項的權重。本文系統地分析了信息檢索中常用的特征權重計算方法,并從項頻、倒文檔率、歸一化因子等角度加以借鑒和改進,研究其在商家評論上的應用。最主要的改進在于考慮了特征項在不同類別中分布情況的差異以及對倒文檔率的平滑。在餐飲評論語料上的實驗結果表明,經典的tf·idf若干變形,尤其是倒文檔率類差異(delta idf)及平滑因子(smoothing factor)的引入,能有效提高分類準確率。在酒店、電腦、書籍等領域的在線評論公開數據集上也取得了較好的性能,證明了方法的普遍適用性。這一方法目前已經在中國電信“號碼百事通”業務中用于餐飲商家及優惠券推薦,效果良好。

商家評論;消費偏好;情感分析;褒貶分類;特征權重

1 引言

移動互聯網的普及助推了Web 2.0技術的發展,用戶由當初PC時代簡單接收互聯網上的信息,向主動發布交互信息轉變。產生的評論數據正以指數級的速度在增長,這些評論包括對商家品牌、服務和產品的評論。如果對這些用戶主動發布的評論進行數據挖掘,判別情感傾向,就能更好地了解用戶的消費習慣、分析熱點輿情,給商家提供重要的決策依據。因此,情感分析(sentiment analysis)已經成為自然語言處理研究中的熱點。情感分析又稱意見挖掘(opinion mining),是指通過計算機手段,幫助用戶快速獲取、整理和分析相關評價信息。

目前,按照處理文本粒度的不同,情感分析可以分為詞語級、短語級、句子級、篇章級以及多篇章級等幾個研究層次。按照處理文本的類別不同,可分為基于產品評論的情感分析和基于新聞評論的情感分析。按照研究任務的不同,可以分為3項層次遞進的研究任務,即情感信息抽取、情感信息分類以及情感信息檢索與歸納。本文主要研究情感信息分類中情感表達的褒貶二元分類問題。

基于特征的機器學習是情感分類的主要方法。在基于有指導機器學習方法的情感分類研究中,特征項的權重設置大部分采用二值法。本文借鑒了信息檢索中tf·idf的權重計算方法,分析其若干變形,系統地研究了特征權重對篇章級情感分類的作用,在餐飲類評論語料上取得了良好的性能,并在多個領域的公開數據集上實驗證明其普遍適用性。

2 相關工作

一般而言,研究者將主觀本文的情感極性分為褒義和貶義兩類。學術上一般認為,對情感分類比較系統的研究工作始于Turney[1]基于無指導學習(un-supervised learning)對多個領域評論情感傾向性分類以及Pang等[2]基于有指導學習(supervised learning)對電影評論進行情感傾向性分類。縱觀目前的研究工作,可分為兩種研究思路:基于情感知識的方法以及基于特征分類的方法。

一部分學者通過考察文本內部情感知識的屬性來完成情感分類。Turney利用點對互信息(PMI),通過計算文本中抽取的關鍵詞和種子詞的語義相似度來判斷關鍵詞的情感極性,從而預測整個句子(篇章)的情感傾向性。也有學者構建情感模板判別情感文本的情感傾向。上述基于情感知識的情感分類方法的工作重心在于情感文本中情感知識的挖掘以及各種情感知識融合的方法研究。

還有一部分學者將情感分類定義為一種二元分類任務,即對任意給定的情感文本單元,由分類器協助判斷其情感極性。Pang等使用樸素貝葉斯、最大熵、SVM等算法,考慮了unigram、bigram的二值及項頻等特征權重,對影評進行分類,其結果顯示基于SVM算法的unigram二值權重取得了比較好的效果。基于特征分類的方法目前還是情感分類的主流方法。這種方法定義明確,其根本問題在于特征的選取。因此嘗試使用更深層、更復雜的分類特征也許是這類方法的突破方向之所在。

其后的基于機器學習的特征分類方法的研究大多是基于此,算法的改進主要在對文本的預處理和特征的選擇。一個重要的預處理是檢測出主觀性評論 (句子),Hatzivassiloglou等[3]表明主觀性檢測往往比情感傾向性分析更為困難。Pang等后續的研究也表明,對刪除客觀性句子后的評論作情感分類的精確率比對整個文本作分類高。Li等[4]提出了情感極性轉移結構(polarity shifting structure)用于發現情感轉移特征(如否定、對比、轉折等),從一定程度上提高了分類性能。

目前,基于特征的方法的研究重點在于有效特征的發現、特征選擇以及特征權重等問題的研究。其中特征權重的研究是重要突破點之一,本文的研究就是基于此,從信息檢索理論中借鑒和改進特征權重的計算方法,并將其成功應用于情感分類。

3 特征權重研究

文檔D用詞袋(bag of words)的特征向量表示法,可記為D={w1,w2,…,wr}。其中r為詞典的維度(特征項項數),wi,i=1,2,…,r為項 i(一個 n-gram單元)在文檔D中的權重。Pang等實驗表明,采用unigram的二值的權重(當tfi>0時,wi=1;當tfi=0時,wi=0。其中tfi為特征項出現的頻率),用SVM分類器,取得了最好的性能。與文本分類相比,一個有趣的現象是,簡單地使用tfi的權重往往會導致性能的降低。

這一部分將說明經典的tf·idf權重計算方法,并在此基礎上擴展其若干變形,包括類差異idf、SMART和BM25算法,并介紹其在情感分類領域的應用。這一部分,包括實驗部分都是采用unigram模型,但是,特征權重計算方法的概念可以很容易地擴展到n-gram模型,本文將不作特別說明。

3.1 經典的 tf·idf權重

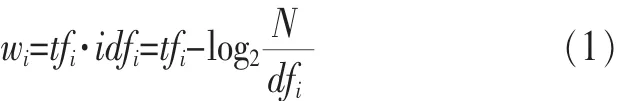

在信息檢索中,經典的tf·idf計算方法賦予文檔D中項i的權重為:

其中,tfi為特征項在文檔中出現的頻率,idfi為倒文檔率(inverse document frequency,IDF),N為訓練集合中總的文檔數,dfi為含有項i的文檔數。

在分類問題中使用項頻是很直觀的,因為項在文檔中出現的頻率越高,該文檔屬于某一類的概率就越大。但正如先前討論,在情感分類領域往往會帶來性能的下降。另一方面,在信息檢索中,使用倒文檔率的作用是降低類無關項的權重(如停用詞),提高只在少量文檔中出現項的權重。但是,倒文檔率僅提供了項在所有文檔中的分布情況,而沒有考慮項在類與類之間分布的差異性。

3.2 類差異 tf·idf

鑒于以上對idf的討論,類差異idf主要衡量特征項在某一類與在其他類分布情況的差異。因此,項i在文檔D中的權重為兩者之差,即:

其中Nj為訓練集合中屬于類別cj的文本數目,dfi,j為類cj中包含項i的文檔數。

但是,這種計算方法也存在著缺陷,它沒有提供任何對dfi,j的平滑因子。因此,當特征項僅在某一類或都在其他類出現時,dfi,j=0,會帶來災難性的錯誤(如被零除或求零的對數)。

3.3 SMART 和 BM25 的 tf·idf變形

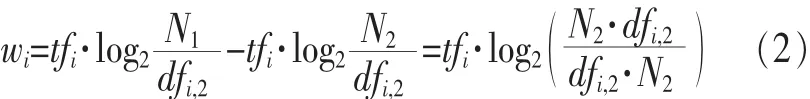

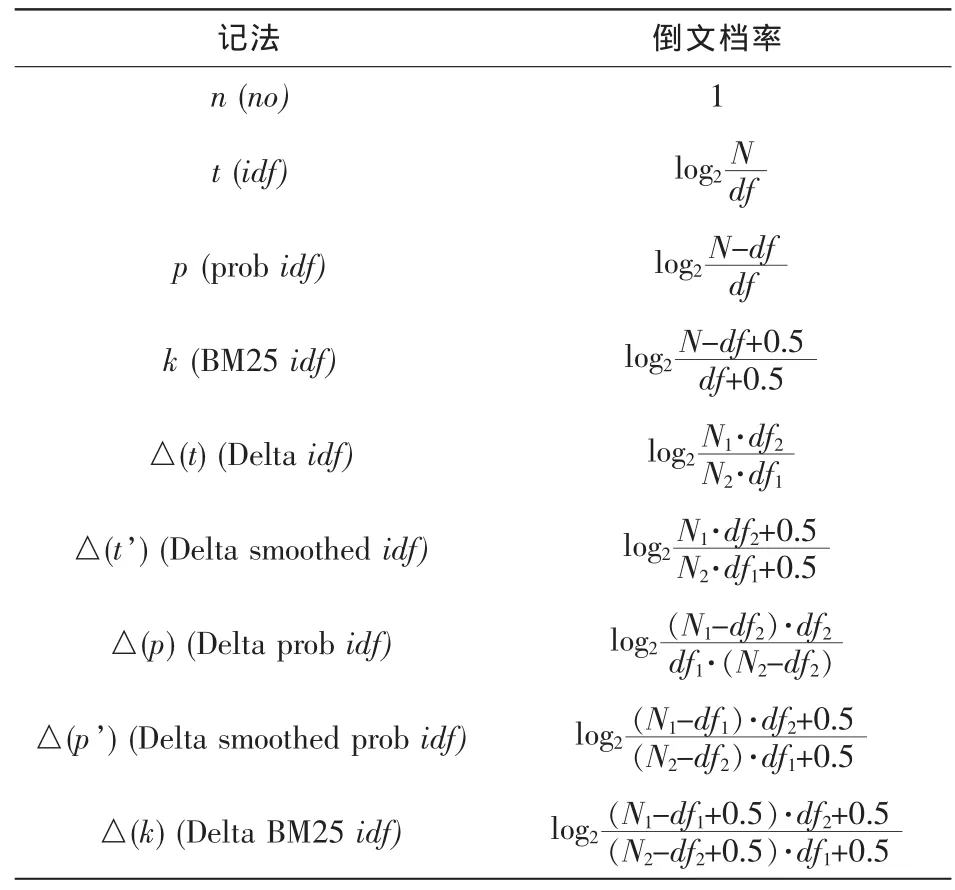

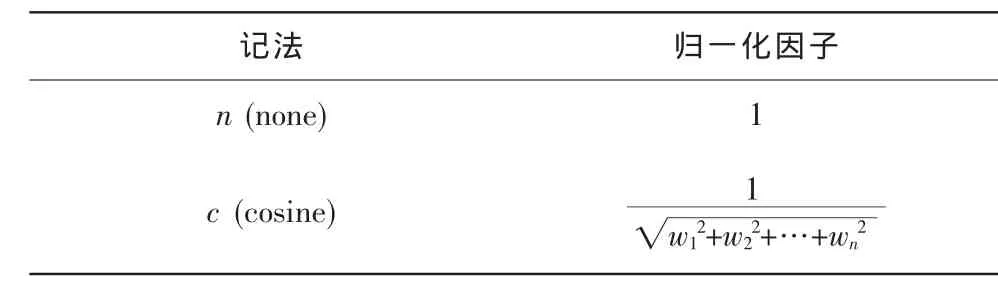

SMART[5,6]是一個基于特征向量空間模型(vector space model,VSM)的信息檢索系統,它提出了若干tf·idf的變形。主要從項頻、倒文檔率、歸一化因子等3個角度考慮,分別見表1、2、3的前幾行。

其中,maxt(tf)是該文檔中所有項出現頻數的最大值;avg_dl是所有文檔中,文檔項個數的平均(平均有效特征維度)。最后一行是BM25算法,參數k1和b均被置為默認的 1.2 和 0.95。注意到,在 L(對數平均)以及 o(BM25)的項頻計算方法中,新引入了平均文本長度avg_dl這一因素,這是因為長文本通常有更大的項頻,從一定意義上對項頻作了歸一化處理,使得統計更為合理。

表1 項頻tf的若干計算方法

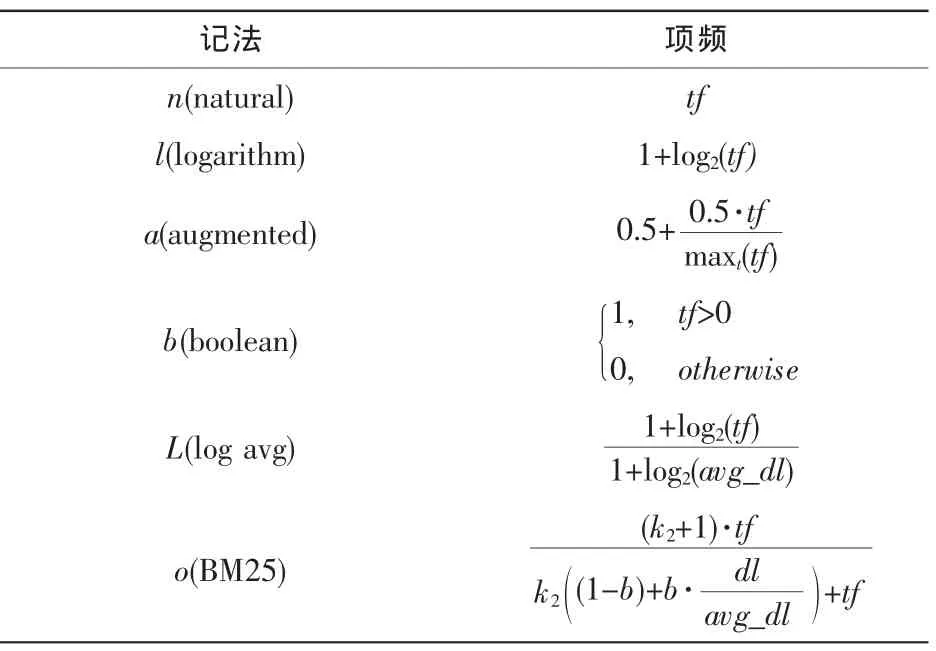

表2的前3行是常見的形式,第4行是BM25的形式,其余行是考慮了類差異(△)和平滑因子(’)的變形,具體細節在后面介紹。

表2 倒文檔率idf的若干計算方法

表3 歸一化因子

這里,歸一化因子取余弦距離(cosine distance)。

SMART系統特征權重計算方法的每個形式都由3個字母表示,第一個表示tf的若干變形,第二個表示idf的若干變形,第三個是歸一化因子。這樣,權重就有6×9×2=108種不同的計算組合。如bnn表示二值的特征權重(boolean tf No idf No normalization,bnn),原始的項頻的權重可記為nnn,帶有歸一化因子的項頻權重記為nnc,BM25的權重就記為okn。

3.4 SMART和BM25的類差異變形

這里,沿用參考文獻[7]對SMART和BM25的倒文檔率所作的類差異擴展,用希臘字母“△”表示類差異的計算方法,用重音符號“’”標記平滑后的權重,見表2最后幾行。

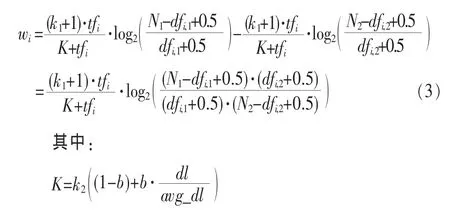

例如,o△(k)n表示的權重為使用BM25的tf以及類差異 BM25 的 idf方法,式(3)為:

由于BM25算法本身已經帶有平滑因子,△(k)默認就是平滑的,因此沒有平滑變形。筆者對上述公式根據參考文獻[8]作了部分修正,如表2最后一行。主要出于以下兩點考慮:首先,當dfi大于1時,在改進的版本中,平滑因子對最終idf值的影響會比較小,因為它加dfi與Ni在乘積之后;其次,當dfi=0時,平滑因子正確地作了小部分修正,避免了潛在的被零除的風險。

4 實驗結果與分析

筆者在中國電信“號碼百事通”業務中的餐飲類中文評論數據上做了實驗,并在多個領域的公開數據集上作了驗證。前者主要是驗證其可行性,后者側重于說明方法的普遍適用性。

4.1 實驗設置

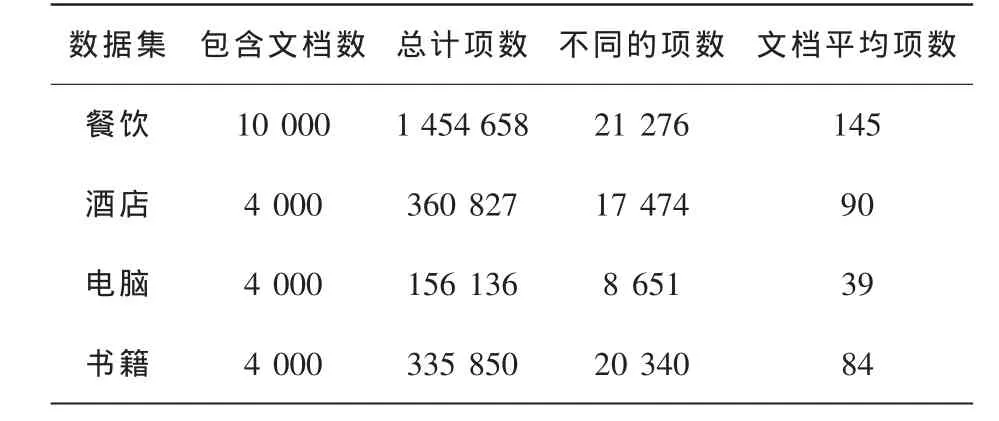

采集到的餐飲類評論共計1萬條,來源于點評網(www.dianping.com)與口碑網(www.koubei.com)。經過標注人員手工標注后分成兩類,其中含有正例6718條、負例3282條。為了使正、負例數據樣本均衡,一次性隨機抽樣兩類各3000條作為實驗數據。另3個領域的評論數據包含從攜程網(www.ctrip.com)抓取的酒店評論、從京東網上商城(www.360buy.com)抓取的電腦(筆記本)評論以及從當當網(www.dangdang.com)抓取的書籍評論[9]。這3類語料都是經過去重后的平衡語料,每類語料均含有正、負例各2000條。語料的一些信息見表4。

表4 多領域語料信息統計

對中文的分詞,使用海量分詞系統。選用支持向量機的SVMlight[10]實現作為分類器,所有參數均為默認。為了易于對比起見,不作復雜的文本預處理,如常見的繁簡轉換、去除英文單詞、保留指定詞性列表中的詞性、去除停用詞等,僅去除了符號字符,對分詞后的結果抽unigram特征。

由于tf、idf的變形較多,不同的組合有108種,限于篇幅,只對具有代表性的組合做了實驗,并展示了性能較好的若干組合結果。一般而言,對于沒有平滑的類差異idf,采用了歸一化因子,因為它們通常比沒有歸一化的表現要好;對于平滑的,不對其作歸一化處理,因為主要關注平滑的性能。經過這樣的篩選,每類數據設計了13組有代表性的、相同參數的實驗,見表4第一列。

為了從訓練集中獲得較為精確的idf信息,所有實驗都是基于leave-one-out的交叉驗證,而不是常用的n-fold(特別地 n≠N1+N2,其中 N1、N2分別為正、負例的樣本數)。主要是因為idf及類差異idf是項固有的屬性(經驗值),且只能從訓練語料中獲得(無法在測試集中獲得),訓練語料數量越多,統計結果就越精確。這里,測試集合上項的idf被假定為與訓練集合中的分布情況一致。

4.2 實驗結果與分析

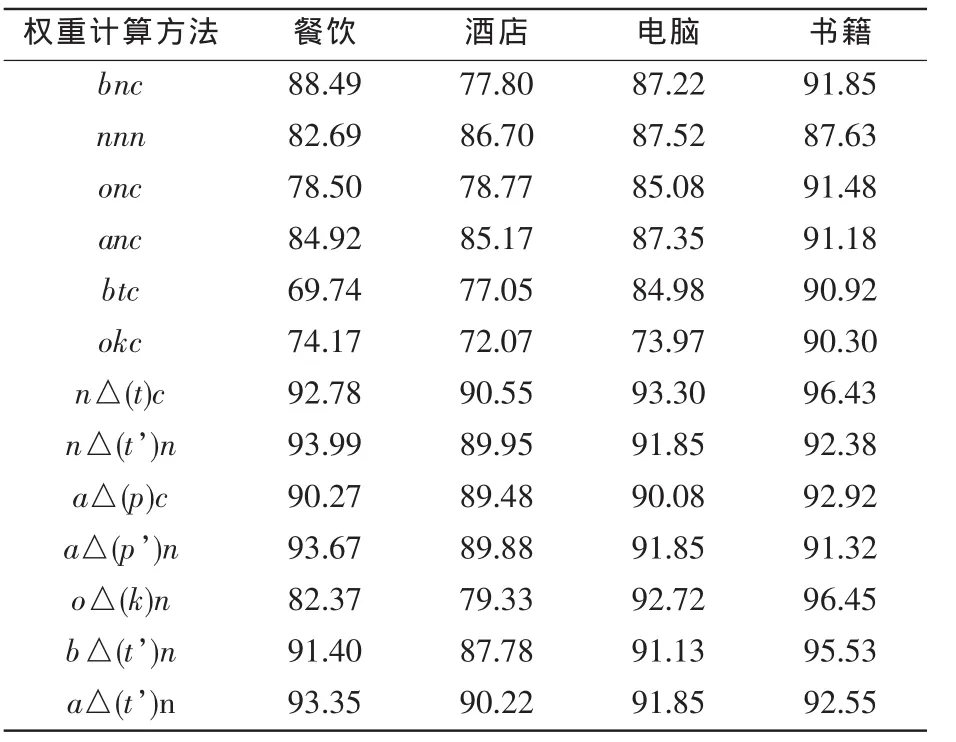

根據上述實驗設置,在餐飲、酒店、電腦以及書籍等4個領域的數據上做了實驗,實驗結果見表5。第一列是權重計算參數的選擇,其余列為不同的數據集。

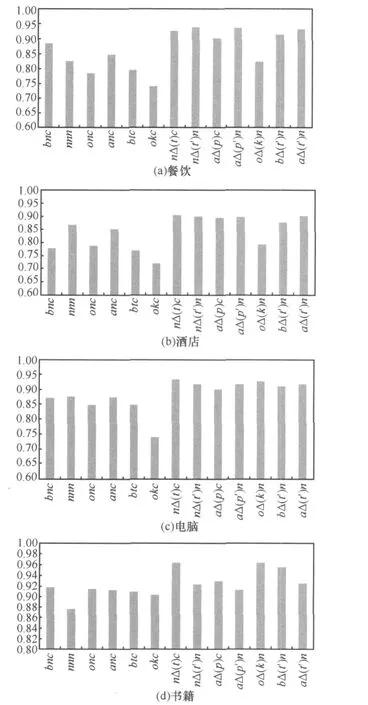

為了更直觀地展示實驗結果,表4對應的柱狀圖如圖1所示。

表5 評論情感分類準確率(%)

圖1 4類數據實驗結果柱狀圖

以下將就各個類別上的實驗結果加以分析。

在餐飲類數據上,實驗結果再次表明二值的特征權重(bnc)比直接的項頻(nnc)(82.71%)性能要好。在簡單的 tf設置(nn)中,歸一化因子(c)的作用微乎其微(nnn 82.69%vs.nnc 82.71%)。tf的若干變換(o、a)也沒有能明顯的效果改善,甚至導致性能的下降。更為有趣的是,在信息檢索中表現良好的BM25算法,在這里的性能卻一般。idf的若干全局變形(t、k)在餐飲類上也沒有新的貢獻。考慮了類差異idf及平滑因子的若干變形(除了△(k))都對性能帶來了較大幅度的提升,最高可達到5.5%(93.99%~88.49%),且提升的性能相當。對比數據可以看到,平滑因子起到了積極的作用(n△(t)c 92.78%vs.n△(t’)c 92.98%,以及 n△(t)n 93.57%vs.n△(t’)n 93.99%)。除此以外,作了歸一化處理的性能反而比沒有作歸一化處理的性能差,這種復雜的計算并沒有帶來應有的效果。在性能較好的各種類差異 idf及平滑變形中,tf的 n、a、b,idf的 t、p 及平滑因子的引入,都對性能提升起到了重要的作用。

在酒店的評論中,各種組合的分布情況與餐飲類的數據大致相同。這里,tf的性能比二值的性能要好,且差距較大。也就是說,并不能直截了當地給出結論,究竟是二值的好、抑或是tf的好,在不同的數據集或不同的領域中,它們存在著差異性。但是不管怎樣,從實驗結果來看,類差異的idf變形以及對它們的平滑,使最終性能同樣有了大幅度提升(從86.70%提升到90%左右)。

電腦(筆記本)領域的實驗結果中,當選擇 BM25的形式(okc)時,性能有較大程度的降低,其余權重計算方法基本保持相當的性能。除okc外,未考慮類差異idf與考慮類差異idf的性能百分點的方差分別為1.3167和0.9295,相對較小。

在書籍領域上測試的性能,雖然沒有特別離群的結果,但是波動比較大,兩組的方差分別為1.9462和3.8998。但是可以看到,在書籍領域的平均準確率比較高,最高的準確率達到了96.45%。在眾多idf類差異的變形中,△(t)和△(k)與其他變形的性能差異尤為明顯。

總體而言,類差異idf的引入,在各領域的數據上都顯示了其對性能提升的重要性,且通常情況下,平滑因子對性能也能起到積極的作用。歸一化因子的作用并不是很明顯,考慮到其計算代價,在以后的實踐中,歸一化因子可暫不納入考慮的范疇。就類差異idf的若干變形而言,△(t’)的變形表現出普遍適用的效果,BM25的變形所起到的作用,卻不及其在信息檢索中的作用大。

5 結束語

本文系統地研究了從信息檢索領域繼承和擴展來的特征權重的計算策略在商家評論情感分析上的應用。在多個領域的評論數據上的實驗結果表明了該方法的有效性與普遍適用性。

本文的方法已經在中國電信“號碼百事通”業務中微博客上的餐飲商家及優惠券推薦上實際得到了應用。這一推薦業務的框架包括根據用戶所發表的博文生成用戶興趣概要(profile)的模塊,用戶興趣概要與待推薦商品、服務的類別匹配以及待推薦商品服務的篩選等模塊。其中,前兩個模塊使用了海量公司的基于知識樹的關鍵詞提取以及文本分類,待推薦商品服務的篩選應用了本文的情感分析方法。實際應用效果良好。

進一步研究在于,將提出的權重調整方法用于自然語言處理的其他領域,如文本分類、話題發現等,并將其從二分問題擴充到多分問題中。

1 Peter Turney.Thumbs up or thumbs down Semantic orientation applied to unsupervised classification of reviews.In:Proc of the 40th Annual Meeting ofthe Association for Computational Linguistics(ACL),2002

2 Pang Bo,Lee Lilian,Vaithyanathan S.Thumbs up Sentiment classification using machine learning techniques.In:Conferenee on Empirieal Methods in Natural Language Processing,Morristown,NJ,USA,2002

3 Vasileios Hatzivassiloglou,Janyce Wiebe.Effects of adjective orientation and gradability on sentence subjectivity.In:the International Conference on Computational Linguistics(COLING),2000

4 Li Shoushan,SophiaY M,YingChen,et al.Sentiment classification and polarity shifting.In: the International Conference on Computational Linguistics(COLING),2010

5 Salton G.The SMART retrieval system-experiments in automatic document.In:Processing of Prentice-Hall,Inc,Upper Saddle River,NJ,USA,1971

6 Gerard Salton,Chris Buckley.Term weightingapproaches in automatic text retrieval.Technical report,Ithaca,NY,USA,1987

7 Justin Martineau,Tim Finin.Delta TFIDF:an improved feature space for sentiment analysis.In:Proceedings of the Third AAAI International Conference on Weblogs and Social Media,San Jose,CA,2009

8 Georgios Paltoglou,Mike Thelwall.A study of information retrieval weighting schemes for sentiment analysis.In:Proc of the 48th Annual Meeting of the Association for Computational Linguistics,Uppsala,Sweden,2010

9 http://www.searchforum.org.cn/tansongbo/corpus-senti.htm

10 http://www.cs.cornell.edu/People/tj/svm_light

11 薛立宏,張云華,曹敏.移動互聯網運營關鍵問題及商業模式探討.電信科學,2009,25(5)

12 羅志強,沈軍.移動電子商務用戶溯源認證技術研究與應用.電信科學,2009,25(6)

Feature Weighting for Sentiment Classification of Online Chinese Reviews

Yuan Liyu1,Ju Jiupeng2,Yang Haojie1,Song Pingbo1

(1.Guangdong Research Institute of China Telecom Co.,Ltd.,Guangzhou 510630,China;2.Hylanda Information Technology Co.,Ltd.,Beijing 100190,China)

Most supervised machine learning method based sentiment classifications apply binary n-gram weights.In this paper,we systematically explore whether more sophisticated feature weighting schemes adapted from information retrieval(IR)can enhance the accuracy of sentiment classification for business reviews.Considered points of view are term frequency(tf),delta inverse document frequency(idf),and smoothing factor.Using restaurant reviews from the number wizard service created by China Telecom as experimental data show that,variants of the classic tf·idf scheme,especially incorporating of delta idf and smoothing factors,provide significant increases in accuracy.Tests on multi-domain public data sets indicate the universality of our approach.The proposed method has been implemented as effective application of restaurant recommendation system on China Telecom Number Wizard micro-blog.

business review, consumer preference, sentiment analysis, polarity classification,feature weighting

2011-05-13)