基于語音結構化模型的數字語音識別

姜 瑩,俞一彪

(蘇州大學 電子信息學院,江蘇 蘇州215006)

0 引 言

目前非特定人語音識別已經取得了很大進展,但與特定人的語音識別系統相比還有很大的差距。影響系統性能的一個重要因素是說話人語音之間的聲學差異,包括不同說話人的性別、年齡、不同的聲道長度和形狀以及說話的風格口音等對語音特征參數的影響。傳統的消除說話人之間的聲學差異通過對模型以及參數處理,如模型自適應、說話人聚類方法等,以減少說話人之間的聲學差異。或者采集數量很大的說話人語音用于訓練,讓訓練語音覆蓋更為廣泛的語音空間,因此對語音訓練量要求較高。

事實上傳統的語音識別方法都是采用聲學特征來描述模型,無論采用模型補償方法還是歸一化方法,都無法解決說話人差異對識別系統性能的影響。最近,日本東京大學N.Minematsu教授從挖掘語音信號中具有相似語義特征的基本單元以及它們之間特征分布的內在關系著手,通過運用Bhattacharyya測度,提出了一種全局聲學結構AUS,理論上可以證明這一結構化描述對于說話人差異具有不變性[1],即可以從語音中提取對說話人差異具有魯棒性的結構化特征AUS,它可以忽略說話人個性特征,只包含語義特征信息。該理論已被成功用于基于方言的說話人分類[2]、音素的切分[3]、語音評測系統[4]、語音轉換[5]、語音合成[6]、計算機輔助語言學習[7](computer aided language learning,CALL)系統以及日語元音串和詞的識別研究[8-9]。漢語數字發音也有其本身特點,時長較短,且含有豐富的聲學音素,因此將AUS用于數字語音識別具有一定的實際意義。

首先介紹語音結構化模型的相關理論,并將其應用于中文數字語音識別。實驗測試了少量語料訓練下,AUS方法和HMM方法在以下說話人差異情形下的識別情況:①采用聲道彎折方法模擬不同說話人之間的差異性;②20個實際說話人之間的差異性。實驗結果表明,在少量語料訓練下,該方法可以取得優于HMM的性能,語音結構化模型可以有效消除說話人之間的差異。

1 語音結構化模型及數字識別

1.1 全局聲學結構AUS

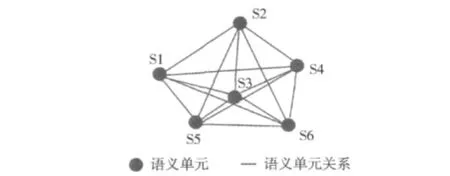

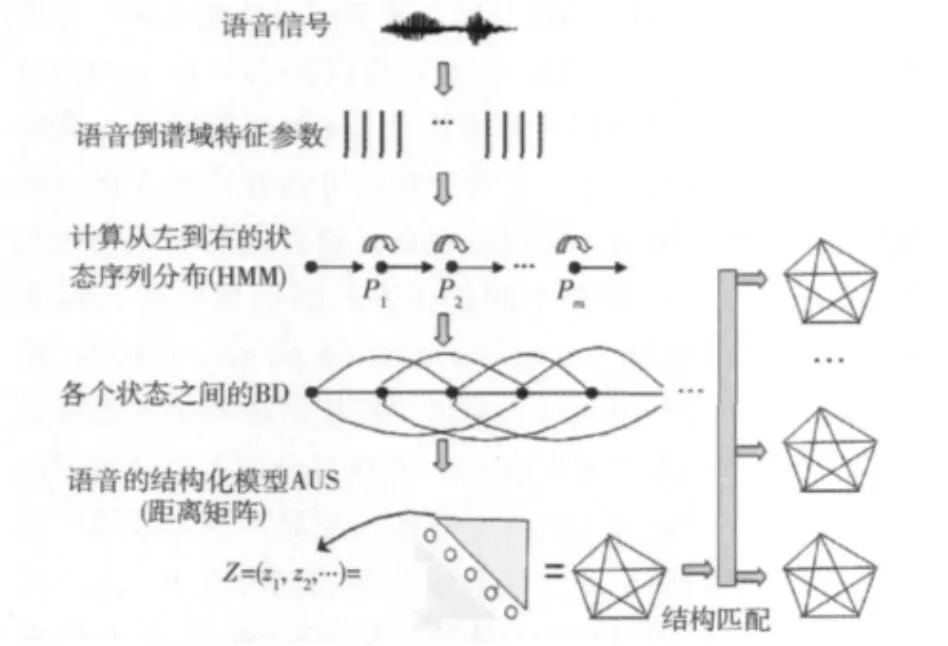

全局聲學結構AUS描述的是語音內在的聲學特征結構關系[10],如圖1所示。其中,結構點表示語音中最小語義單元的聲學特征分布,構成語義的基本單元,其大小并不是固定的,從漢語來講語義單元可以是單詞、音節、聲韻母或者是更為精細的音素等;而節點之間的連線表示語義單元聲學特征分布之間的關系,所有連線形成的網絡被定義為全局聲學結構。

圖1 語音的全局聲學結構AUS

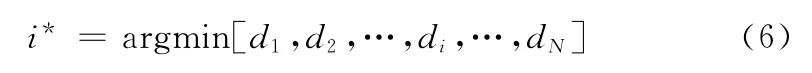

全局聲學結構AUS的基本語義單元是用聲學特征參數的統計分布描述的,而聲學特征參數不可避免地會受到說話人差異性影響而引起一定的變化。說話人差異性包括不同說話人具有不同的聲道形狀 (主要指聲道長度)和其個性特征[11]等。不同說話人聲道長度差異通常在頻域視為雙線性變換

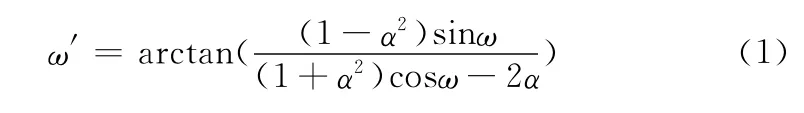

頻率彎折曲線如圖2所示。

圖2 對應不同聲道彎折因子α的頻率彎折曲線

這里,ω和ω′分別表示變換前、后的角頻率,α為聲道彎折因子,α=0時變換前后的角頻率滿足線性關系,對應聲道長度不進行彎折處理。一般,有:-1<α<1,α的正負分別對應聲道長度的縮短和增長[12],α絕對值的大小決定了聲道彎折程度的大小。這種頻域的非線性變換在倒譜域表現為一種線性映射。假設一說話人語音的倒譜域特征矢量為X,那么同一語音不同說話人的倒譜域特征矢量為AX。高斯混合模型 (Gaussian mixture model,GMM)用于說話人時,對不同說話人的語音的短時譜特征矢量所具有的概率密度函數進行建模[13],實現對說話人個性特征的建模。因此不同說話人之間個性特征差異可視作頻域的乘性失真,在倒譜域空間可以表示為疊加性失真B,那么失真后的說話人的倒譜特征矢量變為X′=X+B。綜合最終的特征矢量變為X′=AX+B。

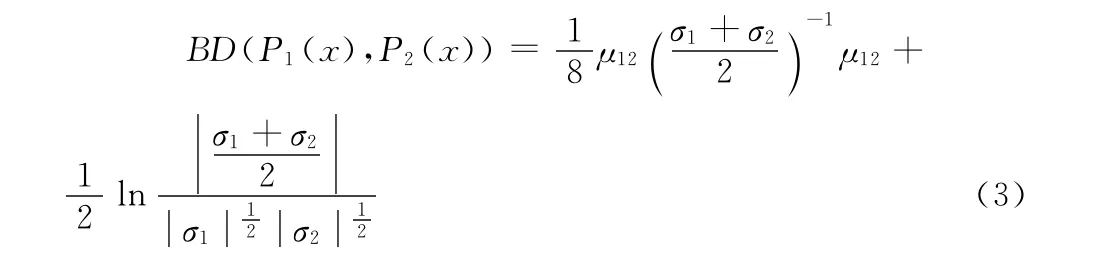

AUS中特征分布之間的關系,用衡量統計分布之間的Bhattacharyya距離測度來描述,以保證在說話人差異的干擾下倒譜特征參數分布之間的關系保持不變。Bhattacharyya距離是衡量兩個統計分布之間距離的一種測度。如下所示

如果統計分布是高斯分布,則上式可以推導為

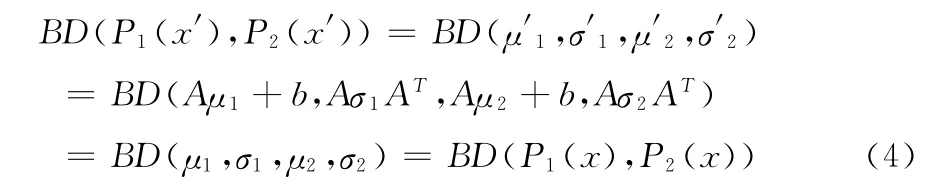

設原始倒譜域特征矢量x,服從分布P(μ,σ),相同語音不同說話人的倒譜特征矢量為x′=Ax+b,服從的特征分布為P(μ′,σ′)。

由于μ=E(x),σ=E(x-μ)(x-μ)T,μ′=E(x′)=E(Ax+b)=Aμ+b,σ′=E(x′)=E(x′-μ′) (x′-μ′)T=AσAT,那么有

以上說明,我們可以從語音中提取對不同說話人和其個性特征具有魯棒性的結構化特征,這種結構化特征采用了語音內部各個內在特征統計分布的相對Bhattacharyya距離來表示,它是語音的一種有效的結構性模型,這一模型不會受到不同說話人語音之間差異的影響。理論上不同說話人發相同語音盡管具有不同的聲學特征分布,但其AUS是保持不變的[14]。

1.2 基于語音結構化模型的數字識別

AUS結構化模型用于數字識別的整個過程如圖3所示,包括兩部分工作:①對訓練數字語音建立全局聲學結構AUS;②提取測試語音的AUS,與各數字的語音結構模型匹配,進行識別。

圖3 基于AUS模型的數字識別流程

對訓練和測試語音建立全局聲學結構時,首先對數字語音提取倒譜特征參數 (如MFCC參數),然后通過HMM訓練提取內在聲學特征分布,構成一個自左向右的狀態序列分布。最后計算各個分布之間的Bhattacharyya距離形成AUS。數字AUS模型的描述可以采用一個M×M對角線元素值為零的二維對稱矩陣表達,其中M代表基本語義單元數,存放各語義單元特征分布之間的距離值。矩陣中各語義單元必須按序排列,第一個語義單元對應第一行,第二個語義單元對應第二行,并依次類推,表達各語義單元的相對時序關系。對訓練語音建立AUS時,訓練語音可以是一遍或者多遍樣本數據,而對于測試語音,僅由一遍測試語音樣本構建其AUS。

識別實際上是求兩個AUS之間的距離,如果把各個二維矩陣元素看作是二維空間點的話,那么兩個矩陣T和R之間的距離可以通過計算對應點之間的歐幾里德距離進行計算并匯總得到[15],即

式中:N——計算的元素個數,M——基本語義單元數,BDij——語義單元i和j之間的Bhattacharyya距離值。

首先,對各個數字 (假設N個數字)語音建立AUS,得到N個參考AUS結構化模型,識別時提取測試語音的AUS,并與N個數字的AUS匹配,得到與各個數字的結構匹配差值d1,d2,…di,dN。第i*個數字串即為最終識別結果

其中1≤i≤N。

2 實驗分析

實驗中訓練語音數據庫為SUDA-2008數據庫,均在普通實驗室環境下用普通聲卡進行錄音,采樣率為16KHz,量化精度為16位。參加實驗的人數共有20人,其中10位男性說話人,10位女性說話人。每人錄制了3遍電話號碼中的11 個 數 字 的 發 音:0 (ling)、1 (yi)、2 (er)、3(san)、4(si)、5 (wu)、6 (1iu)、7 (qi)、8 (ba)、9(jiu)、1 (yao)。語音信號分幀處理,幀長25ms,幀移10ms,加漢明窗,預加重系數取0.97,參數采用17階MFCC參數。語音模型采用6個狀態,每個狀態下單高斯分布HMM。AUS方法中同樣采用6個狀態的HMM,形成6×6的數字AUS模型。

基于以上語音數據,進行兩組實驗,實驗一:對訓練集的語音進行不同程度的聲道彎折以模擬更多 “不同說話人”的語音,并構成測試集。實驗二:來自非訓練集的實際說話人語音構成測試集。兩組實驗均采用少量語料訓練,分析AUS方法消除說話人差異性的性能,并與傳統的HMM方法比較。

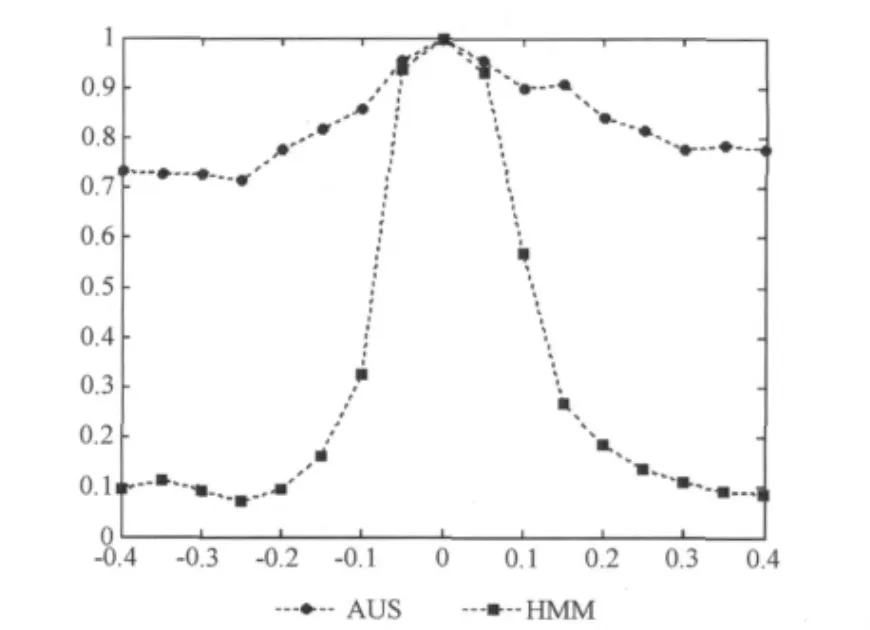

實驗一:測試集作如下處理,對20個說話人的3遍語音采用 (1)進行頻率的非線性變換,實現不同程度的聲道彎折,以模擬具有不同聲道長度的說話人語音。實驗中彎折因子α取-0.4,-0.35,…,0,…,0.35,0.4,共17個彎折系數,其中α=0表示聲道不做彎折處理,并以該 “說話人”的各個數字的1遍語音分別作為訓練集,進行Mel倒譜分析,訓練HMM,建立AUS結構化模型。其余16個彎折因子下,即16個 “不同說話人”的語音構成測試集,同樣訓練HMM提取其AUS與各個數字的結構化模型進行匹配。實驗統計20個說話人的語音數據的識別情況,其中每個彎折因子下660(=20×3×11)個識別數據。實驗結果如圖4所示。

圖4 不同彎折因子下的識別率

由圖4可以看出:

(1)聲道彎折因子α=0時,該情況下測試語音來自訓練語料集,AUS方法和HMM方法具有一致的性能。識別率都為100%。

(2)在聲道彎折程度較小α=-0.05和α=0.05時,由于說話人聲道長度差異性較小,AUS方法的識別率略高于HMM方法,AUS方法的優越性并不明顯。

(3)當聲道彎折程度|α|>0.05時,隨著聲道彎折程度的增加,不同說話人之間聲道長度差異增大,HMM方法下的識別率迅速下降,而AUS方法的識別率在不同彎折因子下仍能都保持在70%以上。在|α|>0.2的各個彎折因子下,AUS方法的識別率效果相當,并沒有隨著說話人差異的增加而導致識別率降低。可見,語音結構化模型可以有效消除說話人之間的差異,提高系統的識別率。

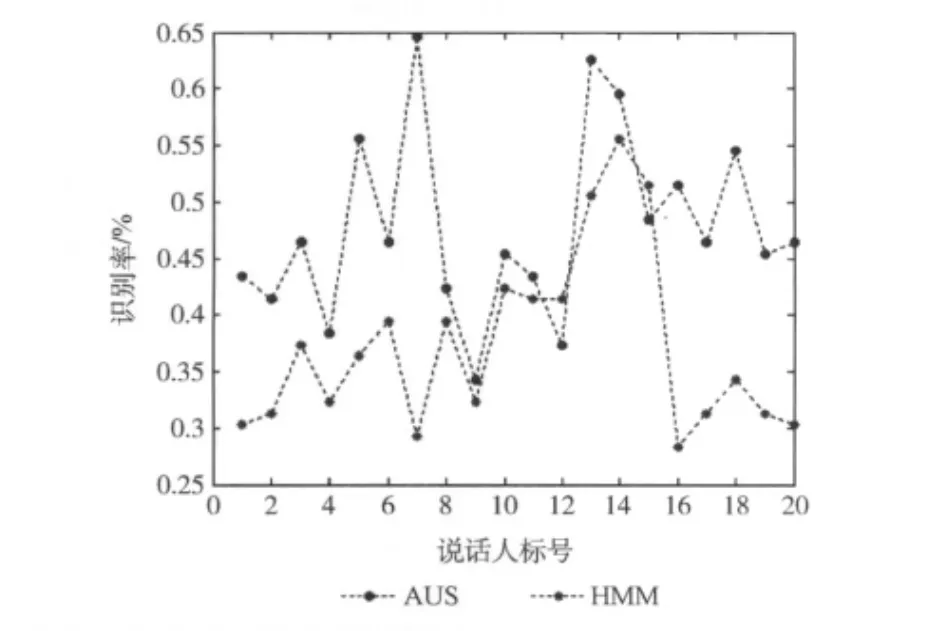

實驗二:以來自非訓練集的實際說話人語音構成測試集,對20個說話人依次標號,其中1-10為男性說話人,11-20為女性說話人。以說話人1的各個數字的2遍語音作為訓練集,進行Mel倒譜分析,訓練HMM,建立AUS結構化模型。除說話人1外其余19個說話人每人3遍的語音,共627(=19×3×11)個測試語音構成測試集做識別;同樣以說話人2的各個數字的3遍語音做訓練集,除說話人2外其余19個說話人的語音構成測試集,依次類推。實驗分析以20個說話人語音依次作訓練集時,AUS方法和HMM方法的識別性能,實驗結果如圖5所示。

圖5 20個說話人語音依次作訓練集時AUS方法和HMM方法的識別率

由圖5可以看出:

(1)AUS方法下的識別率大多高于HMM方法下的識別率,只有在說話人13和說話人15都為女性說話人時,HMM方法的識別率高于AUS方法。在以說話人7作為訓練模板時,AUS方法達到最大的識別率65.12%。可見在較少訓練量的情況下,AUS方法能夠消除實際說話人之間的差異性,獲得比HMM更高的識別率。

(2)實際上從實驗一的結果可以看出,如果實際說話人差異不大,HMM方法和AUS方法的性能相當,所以在實驗二中以個別說話人作為訓練集時,HMM方法的識別率高于AUS方法。因此少量語料且說話人差異較大時,較HMM方法AUS方法能很好地體現其優勢性。

(3)由于不同說話人聲道長度的差異不一定能很好地符合頻域的非線性變換,且實際中說話人之間的差異性還受很多其它因素影響,如聲音的不穩定性等。因此與實驗一結果相比AUS在消除實際說話人差異性方面的效果不那么明顯。

以上兩個實驗表明,在少量語料訓練下,AUS方法可以取得優于HMM方法的性能。HMM方法在說話人語音特征差異下,即訓練和測試語音特征空間相差較大時,其識別性能迅速下降。而AUS方法能有效消除模擬說話人和實際說話人之間的差異,且較少的訓練語料就可以達到較好的識別效果。

3 結束語

本文介紹了一種新穎、不同于傳統聲學特征來描述模型的語音識別方法—語音結構化模型的識別方法。引出語音結構化模型的相關理論,并運用語音結構化模型方法進行數字語音識別。實驗中比較了AUS方法和HMM方法在兩種情形下的識別率:①采用聲道彎折方法模擬不同聲道長度的說話人之間差異性;②實際說話人之間的差異性。實驗結果表明,在少量語料訓練下,AUS方法可以取得優于HMM的性能,語音結構化模型可以有效消除說話人之間的差異。但實際說話人之間的差異性除了聲道長度和個性特征差異外,還有其它因素的影響,此時AUS方法在消除差異性方面效果相對不那么明顯。

[1]Nobuaki Minematsu.Mathematical evidence of the acoustic universal structure in speech [C].Japan:Proceedings of IEEE International Conference on Acoustics Speech and Signal Processing,2005:889-892.

[2]MA Xuebin,Nobuaki Minematsu.Dialect-based speaker classification of Chinese using structural representation of pronunciation [C].Proc of Speech and Computer,2008:350-355.

[3]YU Qiao,Shimomura N,Minematsu N.Unsupervised optimal phoneme segmentation:Objectives,algorithm and comparisons[C].IEEE International Conference on Acoustics Speech and Signal Processing,2008:3989-3992.

[4]Daisuke Saito,YU Qioa,Nobuaki Minematsu,et al.Improvement of structure to speech conversion using iterative optimization [C].Proc of Speech and Computer,2009:174-179.

[5]DAO Jianzeng,YU Yibiao.Voice conversion using structured Gaussian mixture model[C].Beijing:10th International Conference on Signal Processing,2010:541-544.

[6]Saito D,Asakawa S,Minematsu N,et al.Structure to speech conversion-speech generation based on infant-like vocal imitation[C].9th Annual Conference of the International Speech Communication Association,2008:1837-1840.

[7]Minematsu N,Asakawa S,Hirose K.Structural representation of the pronunciation and its use for CALL [C].Proc of IEEE Spoken Language Technology Workshop,2006:126-129.

[8]Takao Murakami,Kazutaka Maruyama,Nobuaki Minematsu,et al.Japanese vowel recognition using external structure of speech [C].Proceedings of Automatic Speech Recognition and Understanding,2005:203-208.

[9]YU Qiao,Nobuaki Minematsu,Keikichi Hirose.On invariant structural representation for speech recognition:theoretical validation and experimental improvement[C].10th Annual Conference of the International Speech Communication Association,2009:3055-3058.

[10]Minematsu N,Satoshi Asakawa.Implementation of robust speech recognition by simulating infants’speech perception based on the invariant sound shape embedded in utterances[C].Proc of Speech and Computer,2009:35-40.

[11]Nobuaki Minematsu.Yet another acoustic representation of speech sounds [C].Proceedings of International Conference on Acoustics Speech and Signal Processing,2004:585-588.

[12]Michael Pitz,Sirko Molau,Ralf Schluter,et al.Vocal tract normalization equals linear transformation in cepstral space [J].IEEE Trans on Speech and Audio Processing,2005,13(5):930-944.

[13]RUI Xianyi.Research on speaker identification in noisy environment[D].Suzhou:Soochow University,2005 (in Chinese).[芮賢義.噪聲環境下說話人識別研究 [D].蘇州:蘇州大學,2005.]

[14]Nobuaki Minematsu,Tazuko Nishimura,Katsuhiro Nishinari,et al.Theorem of the invariant structure and its derivation of speech gestalt[C].Proceedings of Speech Recognition and Audio Processing,2005:930-944.

[15]Nobuaki Minematsu.Mathematical evidence of the acoustic universal structure in speech [C].Japan:Proceedings IEEE International Conference on Acoustics Speech and Signal Processing,2005:889-892.