基于灰度相似性的圖像融合質(zhì)量評估標(biāo)準(zhǔn)

紀(jì)啟國

(安徽城市管理職業(yè)學(xué)院計算機系,安徽 合肥 230011)

基于灰度相似性的圖像融合質(zhì)量評估標(biāo)準(zhǔn)

紀(jì)啟國

(安徽城市管理職業(yè)學(xué)院計算機系,安徽 合肥 230011)

基于MI和SSIM的圖像評估方法很多,但它們在評估的效果與質(zhì)量上準(zhǔn)確度不夠,針對不足之處,提出了一種新的圖像融合質(zhì)量評估標(biāo)準(zhǔn),其基于灰度相似性并利用Minkovski距離的顏色似然偶數(shù)來對圖像的融合效果進行評估.實驗結(jié)果表明,利用該方法,對圖像進行融合評估時,效果優(yōu)于目前同類的大多數(shù)評估方法.

圖像處理;圖像融合質(zhì)量評估;灰度相似性

0 引 言

圖像融合就是將來自不同圖像傳感器或信道上的同一圖像,利用現(xiàn)有的計算機圖像處理技術(shù),盡可能多地提取源圖像的有用信息,提高圖像信息的利用率,并最終融合出近乎源圖像的高質(zhì)量圖像.文獻[1-16]給出了對圖像的融合效果與質(zhì)量進行評估的各種方法及特點.在此基礎(chǔ)上,本研究提出一種基于灰度相似性的圖像融合質(zhì)量評估標(biāo)準(zhǔn),它能有效地解決基于交互信息(MI)和結(jié)構(gòu)相似度(SSIM)等評估方法對噪聲污染后的圖像評估不夠準(zhǔn)確的問題,實驗結(jié)果表明,這種新的評估標(biāo)準(zhǔn)在衡量圖像融合效果中表現(xiàn)更為好一些.

1 基于灰度相似性的融合度量

灰度相似性(顏色)常用于序列圖像的目標(biāo)追蹤,對于2個顏色矢量距離的度量最常見的則是Bhattacryya距離[13].本研究采用顏色信息為輸入源圖像中的有用信息,把Minkovski距離作為相似度的度量.

1.1 基本原理

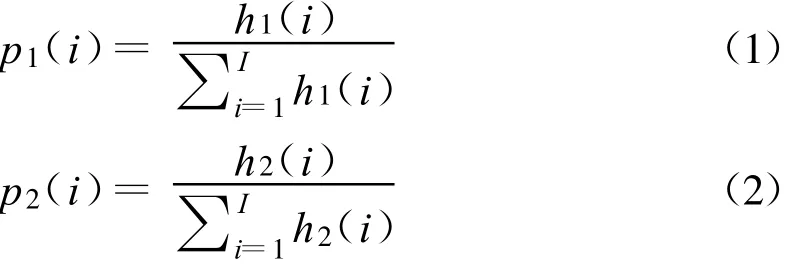

假設(shè)h1(i)和h2(i)是2幅圖像的顏色直方圖,i∈[0,I].其概率分布為,

2者之間的Minkovski距離為,

顏色似然偶數(shù)與Dm的指數(shù)函數(shù)成比例,

其中,σ取經(jīng)驗值.

式(4)定義了一種顏色似然偶數(shù),它具備對噪聲、旋轉(zhuǎn)和局部阻塞的魯棒性[14].顏色似然偶數(shù)對于灰度圖像來說,可以認(rèn)為是灰度似然偶數(shù)L(z1,f).在灰度空間上,應(yīng)最大限度地把有用信息保存在原始圖像中.因此,在評估融合效果中灰度似然偶數(shù)是可以被采用的.

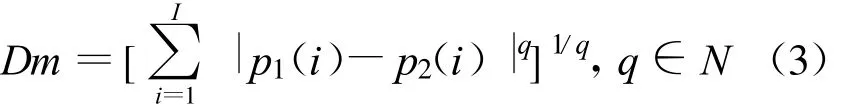

假設(shè),L(z1,f),L(z2,f)是2幅圖像的灰度似然偶數(shù)值,定義它和融合圖像間的融合評估函數(shù)為,

值得注意的是,式(5)輸入圖像的數(shù)目可以為任意正整數(shù).

1.2 評估方法的數(shù)學(xué)分析

對式(5)進行加權(quán)平均融合評估分析設(shè)2幅輸入圖像的像素值為zk(k=1,2),表示為,

其中,Ak決定了理想情況下觀測到的物體質(zhì)量,s是理想場景(無噪聲和失真影響),Aks是高斯隨機變量,是加性失真和噪聲,它是均值的高斯隨機變量,方差為.nk、Aks相互之間是獨立的[15].使用加權(quán)平均法后得到的融合圖像為,其中,ω1+ω2=1,0 < ω1<1.

這樣,zk也是高斯隨機變量,均值 μzk=βkμs,方.對應(yīng)式中的 f也是高斯隨機變量,均值 μf= μs(β1ω1+β2ω2),方差

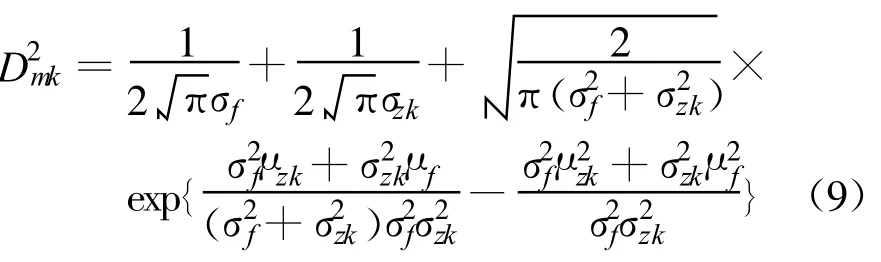

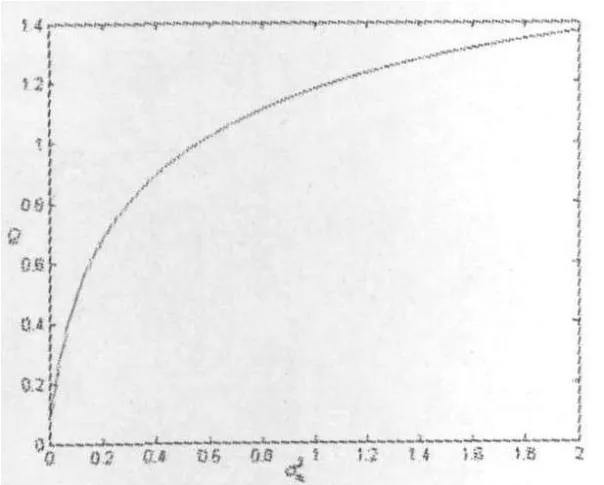

為了使計算不太復(fù)雜又有一定的代表性,令式(3)中的 q=2.這樣,Minkovski距離就變?yōu)?

計算這個積分,得到,

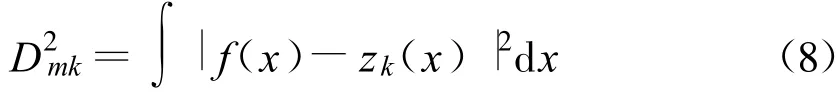

將一幅輸入圖像的噪聲方差固定,觀察另一幅圖像的噪聲與Q變化曲線(見圖1).參數(shù)設(shè)計為,ω1=0.7,ω2=0.3,μs=100,β1=0.1,β2=0.05,σn2=0.0001,σs=0.1.可以觀察到,Q隨噪聲方差變大而變大,但它的增長速率卻在逐漸減小.這主要是使用了加權(quán)均值法,它將噪聲進行加權(quán)后存于融合的圖像當(dāng)中,這樣兩者就越接于白噪聲圖像.

圖1 Q關(guān)于的變化曲線

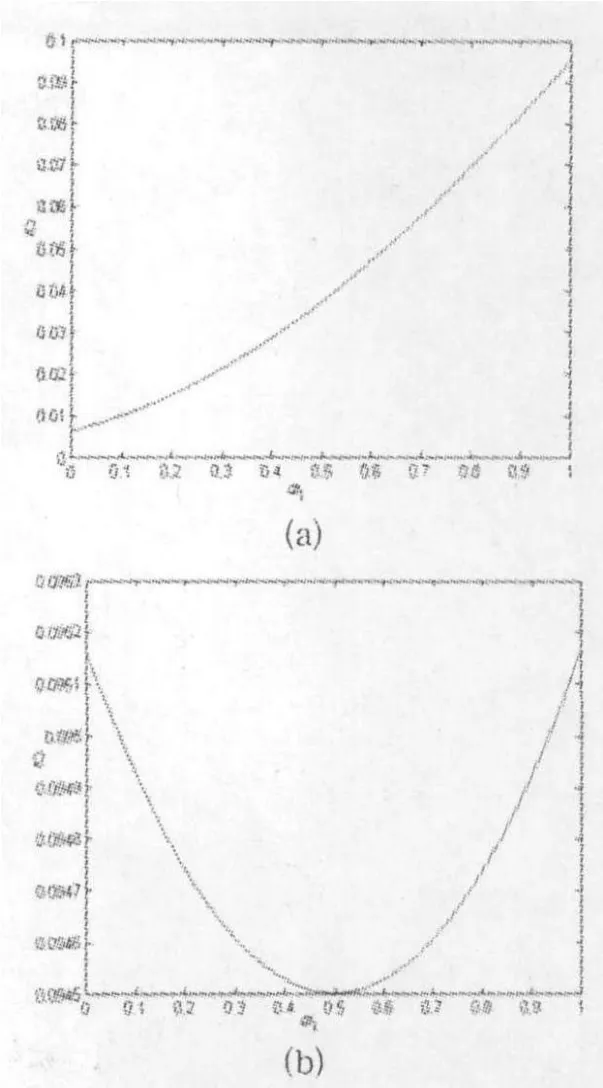

現(xiàn)在將加權(quán)系 ω設(shè)為變量,在輸入圖像噪聲不變的情況下Q的變化曲線(見圖2).參數(shù)設(shè)計為,μs=100,σn1=σn2=0.0001.圖2(a)中的其他參數(shù)設(shè)定為 ,β1=0.1,β2=0.05;在圖 2(b)中,β1=β2=0.1.可以看到,β1>β2時,根據(jù)圖2(a),最好的融合參數(shù)是 ω1=1,ω2=0,融合圖像與輸入圖像相等;當(dāng) β1=β2時,曲線的兩端出現(xiàn)最大值,而最小值出現(xiàn)在 β1>β2=0.5處,這和上面得到同樣的結(jié)果.

圖2 Q關(guān)于ω1的變化曲線

從理論數(shù)據(jù)分析的結(jié)果來看,式(5)取得的效果不理想,其原因:一是由于加權(quán)均值法本身的缺陷;二是對圖像信息的不固定性沒有考慮到.

1.3 新度量函數(shù)

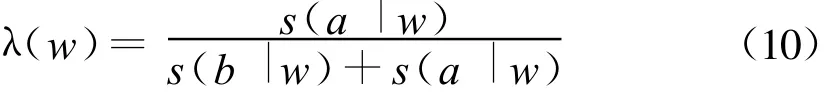

Wang等[16]對每個窗口中的本地質(zhì)量指數(shù)用顯著程度加權(quán).它是輸入圖像重要程度的一個具體的反映,是可被量化了的“有用信息”的值.假設(shè) s(a|w)和s(b|w)分別是a,b窗口中的顯著程度,計算權(quán)值為,

這樣,就可以得到融合質(zhì)量指數(shù),

結(jié)合式(10)顯著度帶來的權(quán)值式(11),對灰度似然函數(shù)進行加權(quán),最終可得到新度量函數(shù)為,

2 實 驗

為驗證一下新度量函數(shù)的有效性,本研究使用TNO Human Factors Research Institute所提供的“UNcamp”序列和文獻[1]所使用的120組異源圖像進行實驗.實驗參數(shù)分別是:步長為32,計算Qm時的滑動窗大小為128×128,式(3)中的q取2,式(4)中的q取0.015.而本地顯著度采用方差.

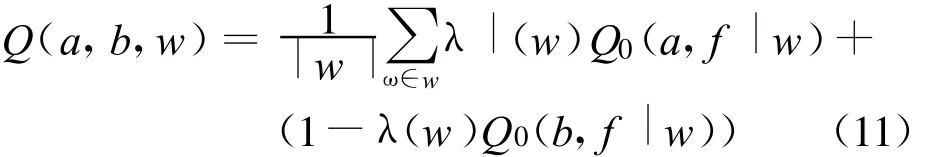

在第一個實驗中,本研究采用了均值法、離散小波變換法(DWT)[18]、拉普拉斯金字塔(LP)[19]和形態(tài)學(xué)差異金字塔(MDP)[20]4種方法分別對源圖像進行融合處理,圖3是其中一組的圖像融合結(jié)果.

圖3 源圖像及融合結(jié)果

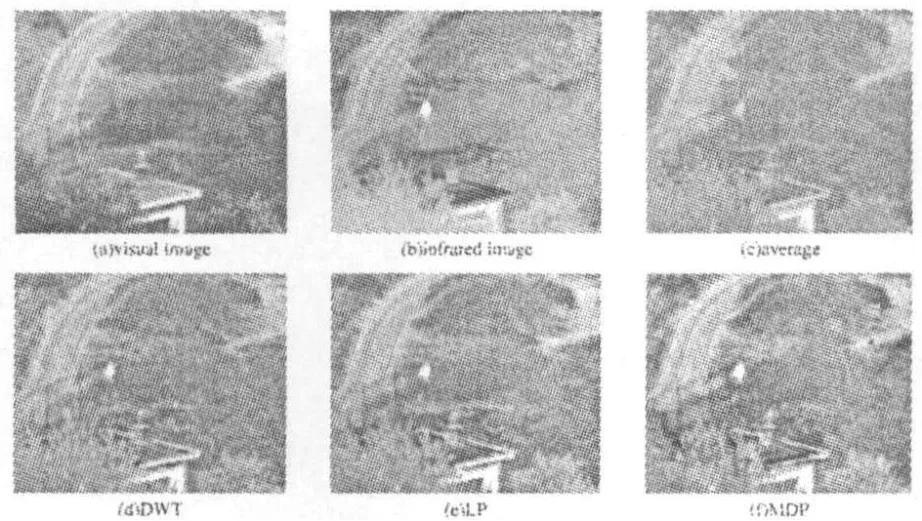

本研究分別采用文獻[3]的MI,文獻[13]的Q,文獻[21]的以及本文提出的Qm4種方法來評估這些圖像的融合效果,得到的結(jié)果如表1所示.

表1 各種評估方法對圖3中圖像融合的評價結(jié)果

從表1及圖3可看出,均值法和DWT的融合結(jié)果明顯沒有LP和MDP好,對比表1可以看出,Qm與直觀結(jié)果基本吻合;從MI的結(jié)果來看,均值法最好;除了 Qm之外表現(xiàn)最好,但它也顯示出MDP的效果不及DWT,這與直觀效果不相符.

在實驗中選擇了32組其他源圖像,其圖像融合后的評估結(jié)果如圖4所示.

圖4 圖像融合后的評估結(jié)果

顯而易見,對于MI來說,均值法始終取得最好的效果;在評估MDP效果時,人眼或多或少會出現(xiàn)主觀印象偏差;而Qm在4種融合方法排序的結(jié)果表明它和人眼視覺相吻符.

在第二個實驗中,本研究仍然采用DWT、梯度金字塔(GRP)[22]、均值法和偏微分方程法(PDE)[23]4種融合方法.

用每種方法對每組融合圖像按照成績的高低排成一個序列,并對實驗的120組圖像的排序名次進行了分別統(tǒng)計,結(jié)果如表2所示.

表2 4種融合方法名次排序的統(tǒng)計

表2數(shù)據(jù)顯示:MI評估方法中排在第一的是均值法;Q的結(jié)果與融合算法的常規(guī)評價不符;本研究提出的評估方法Qm中,成績最好的是PDE,均值法則處于最后一位,這與的結(jié)果相近,這也是現(xiàn)階段學(xué)者們的普遍共識.

3 結(jié) 論

針對現(xiàn)有圖像評估方法中噪聲污染后的圖像評估不夠準(zhǔn)確的具體問題和存在的一些根本缺陷,本研究提出了一種基于灰度相似性的圖像融合質(zhì)量評估標(biāo)準(zhǔn).實驗表明,這種評估標(biāo)準(zhǔn)更為接近人眼感知,在性能上優(yōu)于現(xiàn)有的一些評估方法.

[1] Petrovic V.Subjective tests for image fusion evaluation and objective metric validation[J].Information Fusion,2007,8(2):208-216.

[2] Liu Z,Syth D S,Laganiere R.A feature based metric for the quantitative evalution of pixel level image fusion[J].Computer Vision and Image Understanding,2008,109(1):56-68.

[3] Qu Guihong,Zhang Dali,Yan Pingfang.Information measure for performance of image fusion[J].Electronics Letters,2002,38(7):313-315.

[4] 姜丹.信息論與編碼[M].合肥:中國科學(xué)技術(shù)大學(xué)出版社,2001.

[5] Hong R,Wang C,Wang M,et al.Salience preserving multifocus image fusion with dynamic range compression[J].International Journal of Innovative Computing,Information and Control,2009,5(8):2369-2380.

[6] Cvejic N,Canagarajah C N,Bull D R.Image fusion metric based on mutual information and Tsallis entropy[J].Electronics Letters,2006,42(11):626-627.

[7] Wang Z,Bovik A C.A universal image quality index[J].IEEE signal processing letters,2002,9(3):81-84.

[8] Piella Gemma,Heijmans Henk.A new quality metric for image fusion[C]//Proceedings 2003 International Con ference on Image Processing.Barcelona:IEEE Press,2003:173-176.

[9] 李珊珊,王琦,馮興樂.基于亮度和對比度模型的圖像融合質(zhì)量評估標(biāo)準(zhǔn)[J].激光與光電子學(xué)進展,2011,48(6):1-7.

[10] Chen G,Yang C,Po L,et al.Edge-based structural similarity for image quality assessment[C]//Proceedings of ICASSP 2006.Toulouse:IEEE Press,2006:993-996.

[11] Li S,Hong R,Liu B,et al.A quality metric based on colorsimilarity for image fusion[J].International Journal of Information Acquisition,2008,5(3):235-245.

[12] Wang Hanzi,Suter David.Efficient visual tracking by probabilistic fusion of multiple cues[C]//The 18th International Conference on Pattern Recognition(ICPR'06).Hongkong:IEEE Press,2006:892-895.

[13] Cvejic N,Nikolov S G,KnowlesH D,et al.The effect of pixel-level fusion on object tracking in multi-sensor surveil-lance video[C]//IEEE Conference on Computer Vision and Pattern Recognition 2007(CVPR'07).Minneapolis,MN:IEEE Press,2007:1-7.

[14] Perez P,Hue C,Vermaak J,et al.Color-based probabilistic tracking[C]//The European Conference on Computer Vision(ECCV 2002).Copenhagan:Springer-Verlag Berlin Heidelberg,2002:661-675.

[15] Chen Y,Xue Z,Blum R S.Theoretical analysis of an information-based quality measure for image fusion[J].Information Fusion,2007,9(2):161-175.

[16] Wang Z,Bovik A C.A universal image quality index[J].IEEE Signal Processing Letters,2002,9(3):81-84.

[17] Toet A.Detection of dim point targets in cluttered maritime backgrounds through multisensor image fusion[C]//Proceedings SPIE 4718,Targets and Backgrounds Ⅷ:Characterization and representation.Orlando:SPIE Press,2002:118-129.

[18] Nunez J,Otazu X,Fors O,et al.Multiresoluntion-based image fusionwith additive wavelet decomposition[J].IEEE Transactions on Geoscience and Remote Sensing,1999,37(3):1204-1211.

[19] Burt P J,Adelson E H.The Laplacian pyramid as a compact image code[J].IEEE transactionson Communications,1983,31(4):532-540.

[20] Marshall S,Matsopoulos G K.Morphological data fusion in medical imaging[C]//IEEE Winter Workshop on Nonlinear Digital Signal Processing,1993.Tampere,Finland:IEEE Press,1993.

[21] Xydeas C S,Petrovic V.Objective image fusion performance measure[J].Electronics Letters,2000,36(4):306-309.

[22] Aiazzi B,Alparone L,Baronti S,et al.Assessment of pyramidbased multisensor image data fusion[C]//Proceedings SPIF 3500,Image and Signal Processing for Remote Sensing IV.Barcelona:SPIE Press,1998:237-248.

[23] Hong R,Wang C,Wu X,et al.Salience preserving multi-focus fusion[C]//2007 IEEE Internation Conference on Multimedia and Expo.Beijing:IEEE Press,2007:1663-1666.

Quality Evaluation Standard For Image Fusion Based on Gray Similarity

JI Qiguo

(Department of Computer,Anhui Occupational College of City Management,Hefei 230011,China)

The image evaluation methods based onMI and SSIM are not accurate enough in effect and quality of evaluation,so we put forward a new quality evaluation standard for image fusion,which is based on gray similarity and uses the even number of color likelihood based on Minkovski distance to measure the fusion effect.The experimental result shows that the proposed method is superior to most of the existing evaluation methods during evaluating the image fusion performance at different levels.

image processing;quality evaluation of image fusion;gray similarity

TP391.41

A

1004-5422(2013)01-0054-04

2012-12-25.

紀(jì)啟國(1980—),男,碩士,講師,從事計算機圖像處理技術(shù)研究.