融合HOG與顏色特征的粒子濾波行人跟蹤算法*

郝 溪 ,陳淑榮 ,尹道素 ,梁 晶

(1.上海海事大學 信息工程學院,上海 201306;2.中國石油工程建設公司華東設計分公司,山東 青島 266071)

行人跟蹤是運動目標跟蹤的一部分。目前,運動目標跟蹤方法主要包括基于主動輪廓、基于特征、基于區域和基于模型的跟蹤[1]。參考文獻[2]利用壓縮感知技術對多尺度圖像特征進行降維處理,并在線更新分類器;參考文獻[3]提取光流特征來檢測和跟蹤目標,運用機器學習的正負反饋,達到有效跟蹤目標,但兩種方法對非剛性行人跟蹤的魯棒性較低。參考文獻[4]提出基于顏色直方圖的視覺跟蹤,適用于行人形變、部分遮擋、旋轉以及尺度變化,但僅利用顏色單一特征易造成背景顏色干擾。參考文獻[5]將粒子濾波算法與Mean Shift算法相結合,短時間內能快速跟蹤目標,但長時間遮擋易造成行人目標丟失。

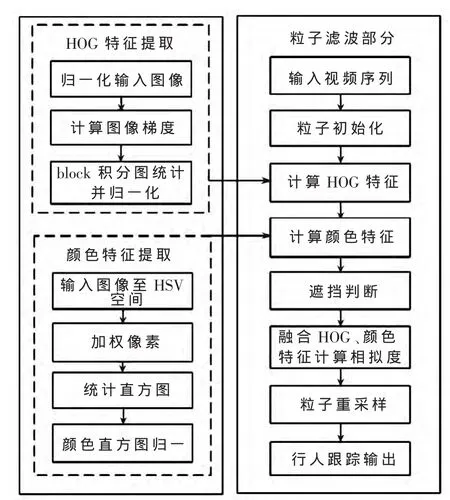

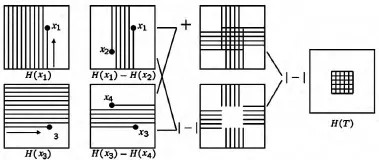

本文融合梯度直方圖HOG(Histograms of Oriented Gradient)[6]特征與加權的顏色直方圖特征,利用粒子濾波實現了行人跟蹤。提取HOG特征,抑制行人的形變干擾;利用加權的顏色直方圖特征,降低背景干擾;引入顏色分塊擴展相似度,解決了混合遮擋問題。算法框圖如圖1所示。

圖1 行人跟蹤算法框圖

1 算法理論

1.1 HOG特征提取

HOG對圖像幾何形變、光學形變具有不變性,允許行人細微動作變化。先將圖像分成小的單元,統計其中的梯度方向直方圖,然后按block大小掃描整幅圖像,最后獲得block統計直方圖并進行歸一化,串聯形成HOG特征向量。

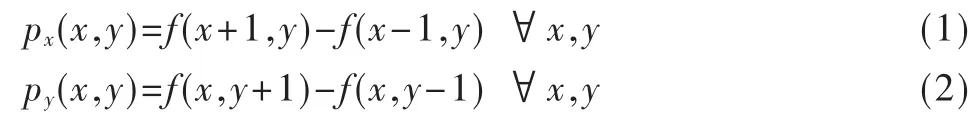

圖像中每一個像素點梯度為:

其 中 ,px(x,y)、py(x,y)、f(x,y)分 別 為 像 素(x,y)水 平 、垂 直方向梯度以及像素值。

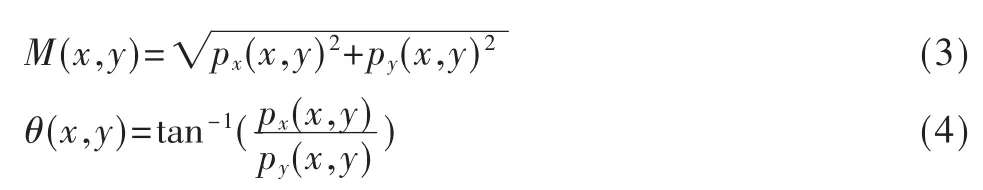

每一個像素的梯度模的大小和方向為:

實驗選取4×4像素為一單元,將單元角度離散至[0,π]的9個區間,統計每個區間的梯度幅值,設置 2×2個單元為一個block,以單元為步長掃描目標區域,利用式(5)歸一化block,并串聯作為HOG特征。

其中,e為略大于0的常數。

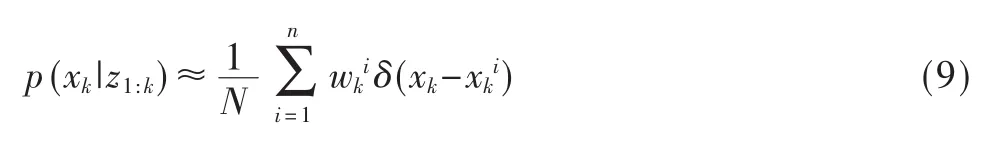

引入積分直方圖[7],簡化HOG特征計算。從原點開始掃描,按照從上到下、從左到右的順序,累計經過像素點9個方向的bin值,獲得當前點的積分直方圖。block區域的積分直方圖通過加減4個角的點積分值來獲得,計算過程如圖2所示。積分直方圖避免了掃描block重復區域像素點梯度的計算,加快了HOG特征提取。

圖2 block積分直方圖計算

1.2 顏色特征提取

顏色直方圖對目標部分遮擋、旋轉及形變等具有較強的適應性,且計算簡易。

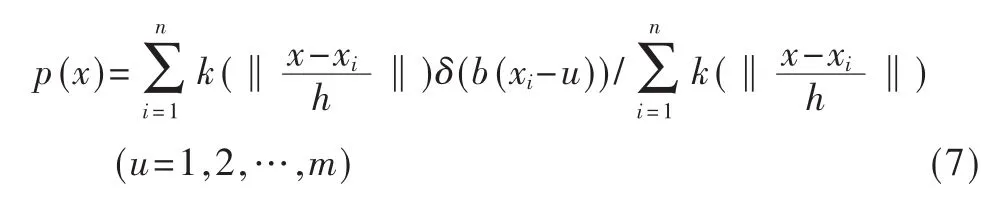

RGB空間受光照影響,易引起跟蹤目標丟失,本文采用HSV空間模型。將圖像離散成n個子區域,對每個像素采用式(6)所示的加權處理,實現對目標區域高加權,目標邊緣區域低加權,獲得式(7)所示的像素分布,通過統計加權后像素顏色向量落在子區域的頻數得到顏色特征直方圖,如圖3所示。依據HSV對光照的敏感度不同,設置量化級數為 8×8×4。

圖3 HSV空間模型顏色直方圖特征提取

其中,r為像素點到目標行人中心的距離。

其中,x為行人中心位置,c=(cx,cy)為區域半徑,δ為Kronecker delta函數,n為區域像素總個數,b為每個像素相應的顏色直方圖條柱。

1.3 融合HOG與顏色特征的粒子濾波

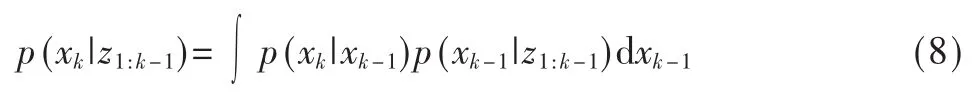

粒子濾波適于非線性、非高斯的行人運動估計,分為預測和更新兩個階段。

預測階段,利用系統模型預測狀態的先驗概率密度為:

更新階段,用最新觀察數據修正得到當前狀態的后驗概率密度為:

其中,N為粒子個數,為第i個粒子的權值。

權值更新為:

兩個直方圖模型相似度距離定義為:

其中,p為行人目標模型,q為行人侯選區模型。

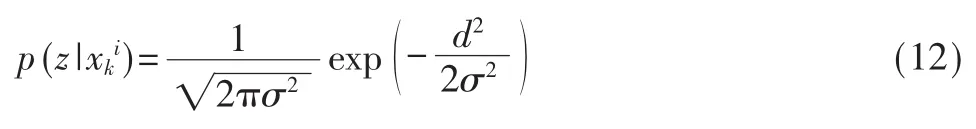

利用相似度距離,得到粒子觀測值為:

其中,σ2是縮放因子。

最后,得到顏色特征與HOG特征融合觀測值為:

1.4 遮擋檢測

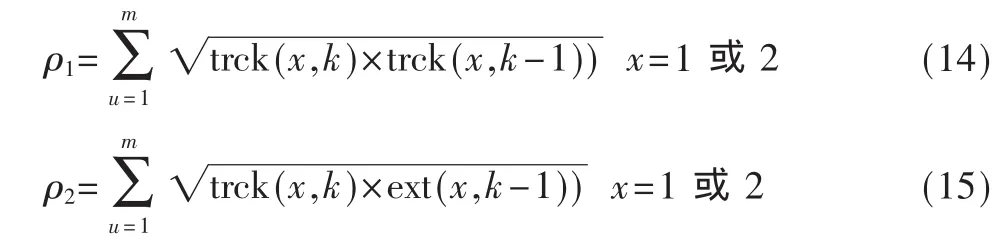

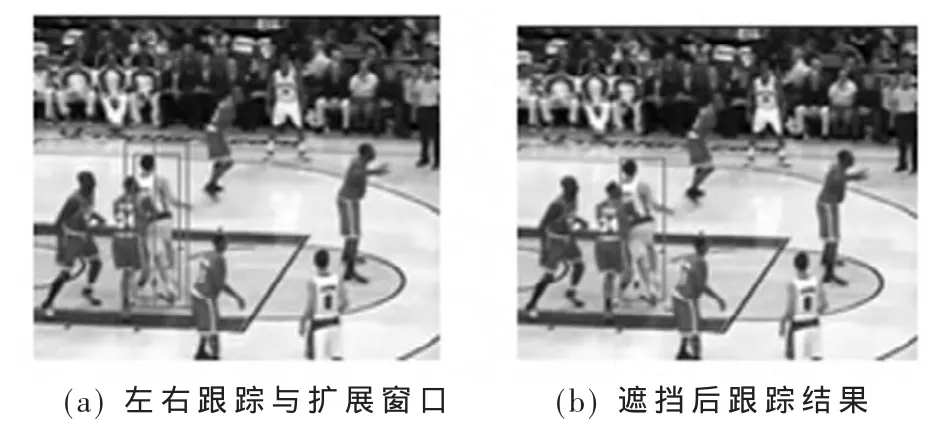

為檢測行人遮擋,以目標中心對稱劃分左右跟蹤窗口與擴展窗口,如圖4(a)所示。k時刻發生遮擋時,k-1時刻擴展窗口與k時刻跟蹤窗口的直方圖相似度較高,k-1時刻跟蹤窗口與k時刻跟蹤窗口相似度較低,利用式(14)和 式(15)判 斷 遮 擋[8]。

其中,ρ1、ρ2分別表示k幀與k-1 幀的相似度,trck(x,k)為跟蹤窗口,ext(x,k)為擴展窗口,x=(1,2)分別代表左右窗口,k為第k幀。

若 ρ2>ρ1,則k時刻發生遮擋,不更新特征模板,保證遮擋結束后正確跟蹤到行人,圖4(b)為遮擋后跟蹤效果圖。

圖4 遮擋檢測跟蹤結果

2 算法描述

算法實現的具體步驟如下。

(1)輸入視頻,讀取第一幀圖像,選擇感興趣行人區域,利用高斯噪聲方式產生N個粒子{,i=1,2,…,N},初始權重為1/N,取N為100。

(2)轉換為灰度圖像并歸一化行人區域,計算圖像梯度,得到簡化的HOG特征。

(3)將目標圖像轉至HSV空間,加權顏色直方。根據式(14)和式(15)檢測遮擋并處理,獲得目標模板特征。

(5)依據步驟(2)和步驟(3),獲得預測粒子的顏色直方圖特征、HOG特征,計算預測粒子與目標粒子相似度,得到融合觀測值,通過式(13)計算粒子權重,按照式(16)歸一化粒子權重。

(6)輸出最優估計為:

依據狀態向量位置坐標、長寬信息,畫出行人預測矩形圖和軌跡圖。

(8)若視頻未結束,置k=k+1,轉到步驟(2);否則,結束。

3 實驗結果及分析

為驗證算法有效性,采用PETS數據庫進行行人跟蹤實驗,在VS 2010環境下開發,計算機配置為3 GHz CPU和2 GB內存,使用OpenCV 2.4.4開源庫,并與經典粒子跟蹤算法、Mean Shift結合粒子濾波算法進行比較。

圖5為PETS數據庫中行人3種算法的結果比較,從初始化至400幀正確跟蹤。圖5(a)中第500幀由于新進行人顏色直方圖與目標行人顏色直方圖相似,跟蹤錯誤,在第600幀處錯誤跟蹤至新進行人。圖5(b)中Mean Shift與粒子濾波結合算法第500幀處仍可跟蹤到部分行人,第600幀則急劇發散。圖5(c)是本文算法跟蹤結果,第500幀、第600幀處皆能正確跟蹤,圖示白線表明行人的運動軌跡。

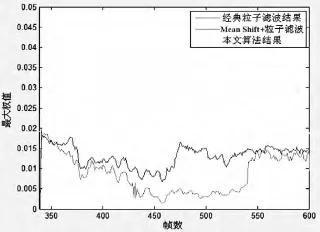

圖6給出了跟蹤過程中,粒子最大權重值的變化。本文算法最大粒子權重值平均較高,表示跟蹤過程中模板與粒子相似度較高。在第400幀~第500幀之間,由于行人間出現遮擋,經典粒子濾波平均權值較低,Mean Shift結合粒子濾波算法平均權值較大,而本文算法最大權重值較穩定,提高了行人跟蹤的效果。

圖6 粒子濾波每幀中最大權重值

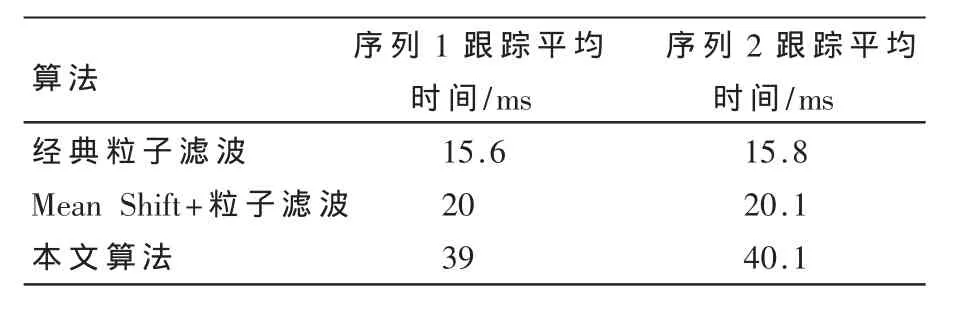

表1列出實驗視頻中3種算法的平均處理時間,由于引入了HOG特征,本文算法所用時間相對經典粒子濾波跟蹤時間較長,但仍能滿足實時跟蹤要求。

表1 幾種算法跟蹤平均每幀時間比較

本文融合簡化HOG特征和加核的顏色直方圖特征,實現了粒子濾波行人跟蹤。采用積分圖加速HOG特征提取,利用圖像分塊相似度檢測,提高了行人間遮擋、背景行人混合遮擋情況下跟蹤的準確性與魯棒性。但由于HOG特征計算量較大,算法運行時間相對傳統粒子跟蹤方法較長,后續將進一步改進算法,提高算法運行速度。

[1]楊戈,劉宏.視覺跟蹤算法綜述[J].智能系統學報,2010(2):1.

[2]ZHANG K,ZHANG L,YANG M H.Real-time compressive tracking[M].Computer Vision-ECCV 2012,Springer Berlin Heidelberg,2012:864-877.

[3]KALAL Z,MIKOLAJCZYK K,MATAS J.Tracking-learning detection[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(7):1409-1422.

[4]NUMMIARO K,KOLLER-MEIER E,GOOL V L.An adaptive color-based particle filter[J].Image and Vision Computing,2003,21(1):99-110.

[5]邢浪漫,范蟠果.基于 mean shift和粒子濾波的混合目標跟蹤算法[J].微型機與應用,2011,30(20):47-49.

[6]DALAL N,TRIGGS B.Histograms of oriented gradient for human detection[C].Proceedings of IEEE Conference on Computer Vision and Pattern Recongnition(CVPR),2005,1:886-893.

[7]PORIKLI F.Integral histogram:a fast way to extract histograms in cartesian spaces[C].IEEE Computer Society Conference on Computer Vision and Pattern Recognition,CVPR 2005,2005(1):829-836.

[8]劉濤,程小平,向本科.改進的基于顏色的粒子濾波目標跟蹤算法[J].計算機工程與設計,2010(8):1750-1752.