圖像拼接技術在雙攝像機監控中的應用

魏 川,張功國,,呂曉萌

(1.重慶信科設計有限公司,重慶401121;2.重慶郵電大學重慶400065)

1 引言

在廣場等大場景使用的監控系統中,由于視頻質量的高低和視頻監控范圍大小二者相互制約,為了得到較高的監控視頻質量,一般都采用多個監控攝像頭同時使用。但是,當需要從監控視頻中獲取有用的信息,如進行人群密度估計[1],由于多個監控的分別使用,得到的視頻圖像無法從整體角度來進行評估,造成信息采集人員的工作不便。

圖像拼接是將有共同部分的待拼接圖像通過計算機技術進行處理,拼接成一幅整體圖像。1996年,Richard Szeliski通過獲取圖像間的幾何變換完成圖像配準,進而完成圖像拼接的全景圖像拼接模型[2]。2010年,吳錦杰,劉肖琳提出了一種基于雙目相機的圖像拼接方法[3],該方法引入自適應的非極大值抑制技術,檢測重合區域的Harris角點,對圖像進行快速匹配;但其在圖像匹配階段的運算時間較長,實時性不強。

本文提出一種基于雙目攝像機的圖像拼接方法,在圖像配準階段借鑒文獻[3]中所采用基于特征點的圖像匹配方法的思想,采用基于特征點的圖像匹配方法,通過對匹配階段描述子的維數降低來減少運算時間,采用BBF匹配算法來提高匹配效率,RANSAC消除錯誤匹配對,最后用加權平均融合法消除拼接縫隙,達到平滑拼接縫隙的目的。

2 改進的圖像拼接方法

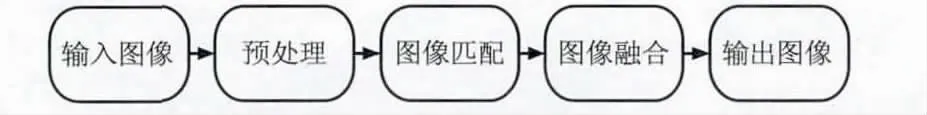

圖像拼接的一般流程如圖1所示。

圖1 圖像拼接流程

圖像預處理就是在進行圖像匹配之前,對圖像進行噪聲消除、幾何校正等工作,以此來提高拼接的成功率。圖像匹配是圖像拼接階段最重要的一個步驟,匹配結果的好壞直接影響后期拼接的效果。圖像融合是圖像拼接的最后一步,圖像匹配解決圖像相同部分的對齊問題,圖像融合解決圖像對齊后的縫隙問題。

本文方法的適宜應用場景大多采用固定攝像頭,本文使用水平固定的兩個小型攝像頭來進行視頻的采集,采集到的圖像受到的幾何畸變對后期的匹配和配準影響不大,因此可以對所獲取的圖像可以直接進行匹配操作。

SIFT(Scale Invariant Feature Transform)算法是David G.Lowe教授提出的一種圖像局部特征描述算子,它是基于圖像特征尺度選擇的思想,在尺度空間尋找極值點,獲取特征點的位置、尺度、方向等信息。

2.1 改進的SIFT算法

SIFT算法主要步驟如下:

(1)極值點檢測

基于特征的圖像匹配的關鍵是穩定的特征點[4]。為了使最終的描述子具有尺度及縮放不變性,要對圖像進行多次的高斯模糊和降采樣處理,形成高斯金字塔。1994年,Lindeberg[5]發現高斯差分函數(Difference of guassian)與尺度歸一化的高斯-拉普拉斯函數σ2▽2G非常相似,而尺度歸一化的高斯-拉普拉斯函數σ2▽2G的極大值和極小值和特征提取函數,如Hessian矩陣比較,能夠產生最穩定的圖像特征。

在生成的DOG尺度空間中,將任意一個像素點與同尺度周圍8個像素點及上下尺度對應的18個點比較其像素值,如果為極大值或極小值時,標注為極值點。

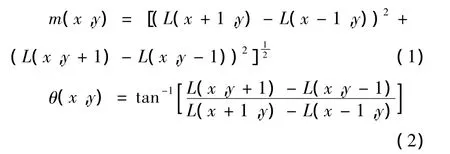

(2)特征點方向確定

為了使生成的SIFT特征點具有旋轉不變性,利用特征點鄰域像素的梯度方向分布特性為每個特征點分配方向參數,特征點的梯度的模和方向計算公式為:

其中,L為對應特征點所在的尺度;(x,y)為特征點的位置。

(3)改進的描述子

以特征點為中心,計算16×16鄰域內的像素梯度值的大小和方向,將特征點鄰域劃分為4×4的種子點,統計每個種子點8個方向的梯度方向直方圖。16個種子點,每個種子點8個方向,形成16×8=128維描述子。生成的SIFT描述子有較好的旋轉不變性,光照不變性,當檢測到的特征點數量較多的時候,128維描述子會產生龐大的計算量,實時性不強。對此,本文給出一種改進方法,降低計算量,提高實時性。

以檢測到的特征點為中心,構造分別以半徑為2,4,6,8,10,12,14,16 個像素的 8 個圓,計算這 8個半徑圓內各像素的梯度信息,統計出每個圓域的8個方向的梯度值。將特征點的鄰域高斯加權,這樣可以避免由于圖像旋轉而造成的特征點發生位移導致生成描述子偏差。

接下來將2個像素鄰域內的8個方向的梯度累加值作為生成描述子的前8個向量,然后對第2到第4像素鄰域內的梯度累加值作為描述子的9~16個向量,然后是計算第4到第6像素鄰域內的梯度累加值,生成17~24個向量。依次地,形成8組鄰域的向量,總共64維描述子。

與改進前相比較,特征點的鄰域范圍為16×16,但特征點的描述子維數降低到了64維,描述子維數明顯降低。維數的降低將會直接導致計算速率的提高,運算時間的減少。

(4)匹配和誤匹配的消除

對描述子的匹配常采用的方法是窮舉法,窮舉法的優點是不需要進行任何數據預處理,但其搜索效率不高。本文通過BBF查尋機制來提高匹配點的搜索效率。

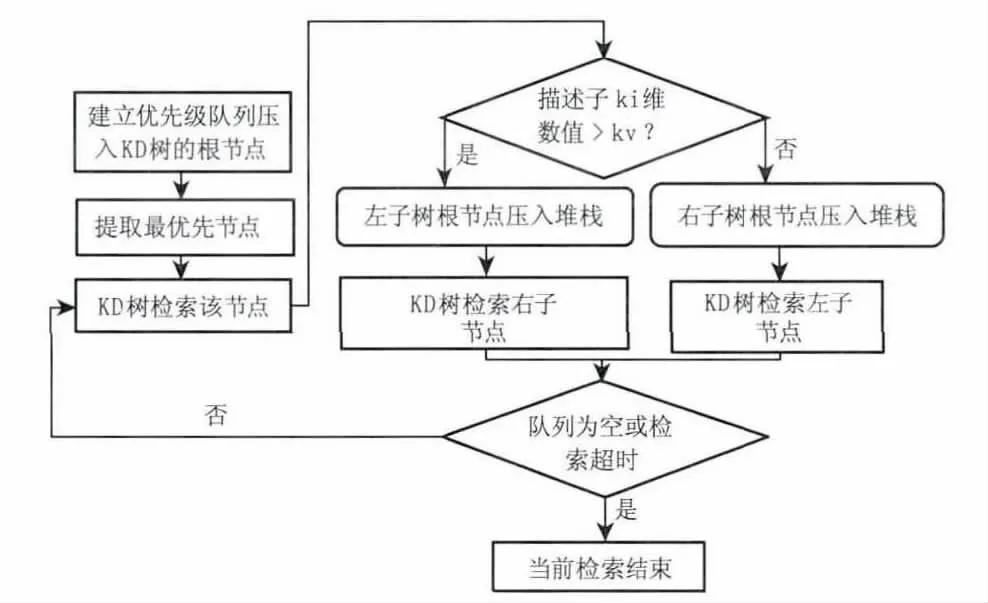

BBF(Best-Bin-First)查尋機制,是 KD-Tree(k dimension tree)的一種擴展[6]。KD-Tree 是一個二叉樹,它是用分而治之的思想對數據點在K維空間劃分的一種數據結構,在檢索的數據集的維數高于20維時,其檢索效率明顯下降[7]。BBF是在 KDTree的基礎上加入了查找優先級的概念,它的檢索總是從優先級最高(Best Bin)的節點開始,通過設置一個運行超時限定來確保在所有節點檢查完畢或超出時間限制后算法能返回當前找到的最好結果,其主要流程如圖2所示。

圖2 基于BBF的KD-Tree檢索流程

采用BBF查尋機制,可以將KD-Tree擴展到高維數據集上,通過建立優先隊列,其很好地控制了‘最佳點’查尋的進程,可以在任何時候中斷并退出查詢進程,并且能得到比較好的結果。

初始匹配對中,存在部分匹配錯誤,消除匹配錯誤的方法有最小二乘法和隨機抽樣一致性[8]。隨機抽樣一致性(RANSAC RANdom SAmple Consensus)是一種數學模型的參數迭代算法,它的主要特點是隨著迭代次數的增加,正確的幾率會逐漸提高。它通過將數據分為內點和外點,然后判斷出內點,取出外點來達到消除錯誤匹配的目的。在該方法中有3個關鍵參數可以對其效果產生影響,分別是:估計次數,內外點距離判定閾值和一致性集合的大小閾值。

本文中的隨機抽樣一致性消除錯誤匹配分為3步來進行:①隨機選取3對匹配對,然后根據待匹配圖像的變換模型估計出變換參數。②利用估計的參數剩余的匹配點進行判斷,通過內外點的判定閾值區分出內外點,然后重復步驟1。③當內點數目最大時,得出變換模型的最佳估計。

2.2 圖像融合

圖像融合是將采集到的包含有同一目標的圖像數據經過處理,綜合到同一幅圖像中。由于圖像采集視角的不同,拼接的重疊部分會產生模糊和重影等。為了提高拼接效果,就需要對拼接后的圖像進行融合處理。

圖像融合技術分為像素級、特征級和決策級3個層次,多數應用場合都需要進行像素級融合,原因是像素級融合能盡可能多地保留場景的原始信息[9]。本文采用加權平均融合法進行像素級圖像融合。

3 實驗結果與分析

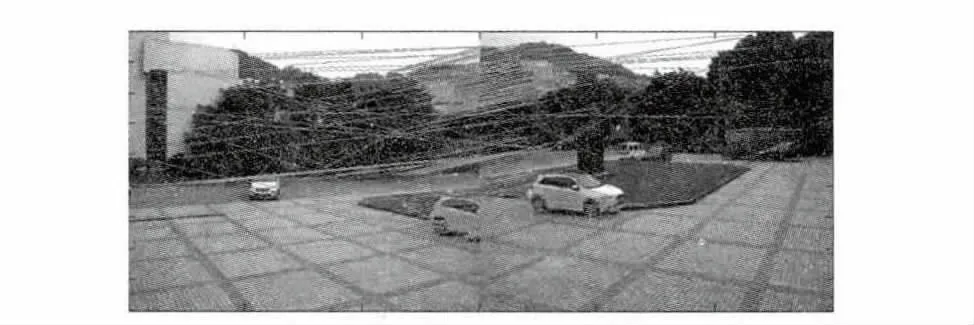

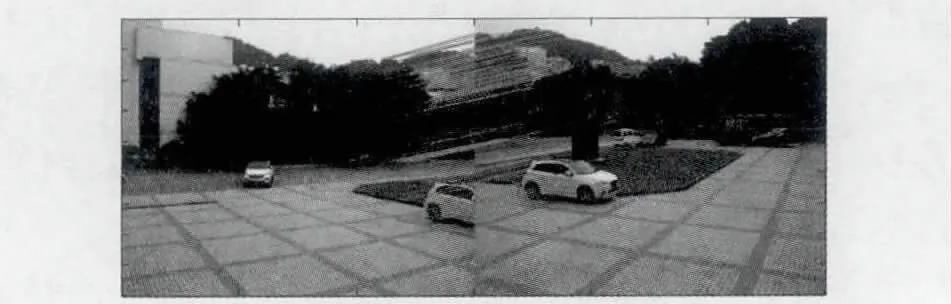

本文使用水平固定的兩個小型攝像頭來進行視頻的采集,水平夾角為40°,采集的視頻分辨率為640×480,幀率為30 f/s。獲取的原始圖像幀如圖3所示。

圖3 待拼接圖像

SIFT算法匹配結果如圖4,采用本文的改進方法進行匹配操作,結果如圖5,圖中出現的交叉線表示匹配錯誤。與改進前相比,使本文改進方法進行匹配,錯誤的匹配點明顯減少,匹配準確率明顯提高。

圖4 SIFT配準

圖5 本文方法配準

由于圖像拼接的關鍵在圖像匹配過程,為進一步檢驗本文改進方法的匹配性能,本文分別將本文方法、改進前SIFT算法及其改進—SURF算法進行仿真對比,采用圖像尺寸大小不同的10組圖像進行匹配,并對其匹配時間進行統計,結果如圖6所示。

圖6 特征點數目與運算時間關系

如圖6中統計結果,本文方法經過對描述子的降維處理和匹配階段BBF匹配策略的引入,大幅減少了匹配時間;在檢測到的特征點數目較少的時候,與SIFT算法和SURF算法相比,本文方法有較少的匹配時間,并且在一定的特征點數目范圍內保持穩定匹配性能;隨著檢測到的特征點數目的繼續增加,SIFT算法和SURF算法的匹配時間大幅增加,而本文方法的匹配時間趨于穩定增加,這是因為BBF匹配策略利用優先級隊列,針對某查詢點,搜索整個KD-Tree的根節點和樹節點,然后從這些節點中通過超時限制提取出優先級最高的節點,并退出搜索進程。

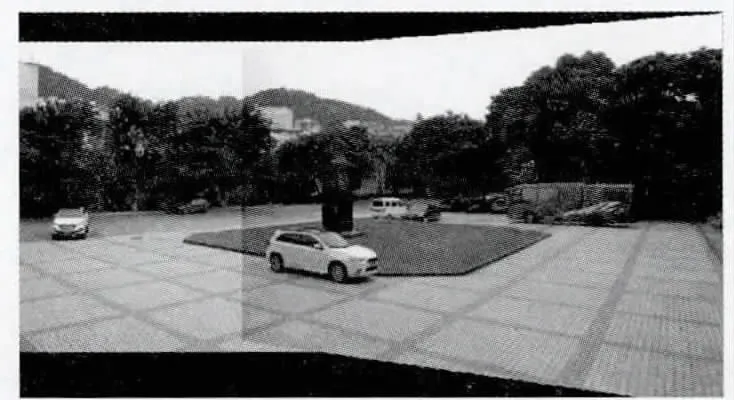

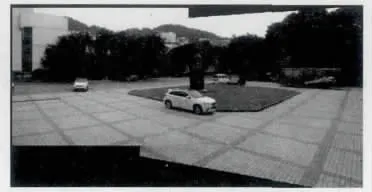

為驗證本文采用加權平均融合法對拼接縫隙的處理性能,本文采用目前普遍使用的直接平均法與本文方法作對比處理,實驗結果分別如圖7和圖8所示。

圖7 直接平均法

圖8 本文方法

可以看出,直接平均法對拼接縫隙的處理不夠,存在較明顯的拼接縫隙,而本文采用的加權平均法,能夠根據權值對拼接的重合區域很好的處理。

綜合來看,本文方法提高了圖像的匹配效率,大幅減少了匹配時間,并且有較高的匹配準確率,實現了圖像的無縫拼接,經過實驗證明,本文方法是有效的。

4 結束語

針對但攝像頭和雙攝像頭拍攝范圍各自的局限性,給出了一種圖像拼接方法,通過該方法可以對雙攝像頭的拍攝視頻圖像進行快速拼接,有較高的實時性,在相關的監控視頻信息收集中有一定的應用價值。本文方法是正常的自然光照條件下進行的,若遇突發情況,如較強的光照影響下(如攝像頭受到燈光照射),采集到的視頻資料受到影響較大,如何在影響較大的情況下繼續進行準確快速拼接有待做進一步的研究。

[1] GUO Sen,LU Xin.Application of the binocular camera to crowd density estimation[J].Computer& Digital Engineering,2012,40(8):116 -118.(in Chinese)郭森,盧鑫.應用雙目攝像機進行人群密度估計[J].計算機與數字工程,2012,40(8):116 -118.

[2] Richard Szeliski.Video mosaics for virtual environments[J].IEEE Computer Graphics and Applications.1996.16(2):22-30.

[3] WU Jinjie,LIU Xiaolin.Image mosaicing based on binocular cameras[J].Computer Engineering,2010,36(12):209 -212.(in Chinese)吳錦杰,劉肖琳.基于雙目相機的圖像拼接[J].計算機工程,2010,36(12):209 -212.

[4] ZHANG Jiao,LI Junshan,ZHANG Shaohua.Algorithm for IR/Visual images matching based on line features and SIFT points[J].2013,43(5):554 -558.(in Chinese)張姣,李俊山,張少華.線特征和SIFT點特征結合的異源圖像匹配算法[J].激光與紅外,2013,43(5):554-558.

[5] Lindeberg T.Scalespace theory:A basic tool for analyzing structures at different scales[J].Journal of Applied Statistics,1994,21:224 -270.

[6] ZHAO Qinghua,CHEN Luo,JING Ning.Distributed spatial join query based on kd-tree recursive partitioning[J].Computer Engineering & Science,2011,33(8):167 -173.(in Chinese)趙清華,陳犖,景寧.基于Kd樹遞歸區域劃分的分布式空間連接查詢[J].計算機工程與科學,2011,33(8):167-173.

[7] WANG Peizhen,CHEN Ping,ZHOU Fang.Method of feature extraction and matching for complex image[J].J.of Anhui University of Technology,2012,29(1):73 - 77.(in China)王培珍,陳平,周芳.復雜圖像特征點提取與匹配方法[J].安徽工業大學學報,2012,29(1):73 -77.

[8] CAO Hongxing,LIU Jiahang,RUAN Ping.Stitching image based on SIFT[J].Video Engineering,2008,32(S1):146 -148.(in Chinese)曹紅杏,柳稼航,阮萍.基于SIFT特征的圖像自動拼接[J].電視技術,2008,32(S1):146 -148.

[9] SONG Baosen,FU Yongqing,SONG Hailiang.New efficient image fusion algorithm for image mosaic[J].Computer Science,2011,38(2):260 -264.(in Chinese)宋寶森,付永慶,宋海亮.一種消除圖像拼接痕跡的新方法[J].計算機科學,2011,38(2):260 -264.