基于視覺的機器人抓取電梯門板定位系統設計

張建業, 潘 豐

(江南大學 輕工過程先進控制教育部重點實驗室,江蘇 無錫214122)

工件的識別和定位是工業機器人在生產線上有效應用的重要環節。目前機器人已廣泛應用于工業生產線上,但很多都是在示教人員的示教編程或離線編程下完成一些預先設定的固定動作和功能[1-2]。如果工件周圍的環境發生了變化,則就很可能導致機器人任務失敗[3]。

機器視覺是使機器人具有像人一樣的視覺功能,從客觀事物的圖像中提取出有用的信息,從而實現各種檢測、判斷、識別和測量等功能。將機器視覺技術和機器人技術相結合,利用機器視覺的定位功能使機器人具有自己的“眼睛”以獲取工件的位置信息,引導機器人完成抓取、搬運等工作[4]。

針對機器人抓取電梯門板的高精度、高速度和智能化要求,文中設計開發了基于視覺的機器人抓取電梯門板的定位系統,且針對電梯門板尺寸較大單相機定位精度差、不穩定的難題,提出了采用雙相機的方法保證定位的精確性和穩定性,并基于康耐視VisionPro 視覺開發軟件設計了視覺定位程序。實際應用結果表明,該系統能夠準確、穩定地定位電梯門板的位置。

1 視覺定位原理及系統組成

1.1 視覺定位原理

視覺定位原理如圖1 所示。

圖1 視覺定位原理Fig.1 Diagram of the visual location principle

由圖1 可以看出,電梯門板來料的標準位置是偏移量為零的位置,實際生產中工人通過吊裝設備將電梯門板放置在來料臺面上,每次放置的位置都有變化。由于電梯門板尺寸較大為2 120 ×430 mm,角度計算偏差稍大經過坐標系原點旋轉后會在門板的另一端造成較大偏差,且門板越長偏差就越大;而相機的視野有限,再加上不同門板采集圖像時噪聲的干擾,會使得單相機定位精確度不夠、穩定性不高。為解決此問題本系統采用雙相機定位的方法,通過求取兩個相距較遠的點擬合的直線角度保證定位的精度和穩定性;因機器人上料時電梯門板一端距離地面較近,則兩相機只能安裝在吸盤抓手的一端,因此兩個點分別取電梯門板一端兩個矩形孔的左上頂點A 和B。

兩個相機分別采集電梯門板一端的兩個矩形孔圖像,相機1 視野中的A 點通過尋找特征邊La1和La2的交點提取,相機2 視野中的B 點通過尋找特征邊Lb1和Lb2的交點提取。

機器人工件坐標系Or原點建在特征點A0處,選取點A 計算位移偏移量,直線AB 計算角度偏移量。首先采集基準位置電梯門板圖像,計算點A0(x0,y0)、B0的坐標和直線A0B0的角度α0(其中A0為原點x0= 0,y0= 0),并分別保存為基準位置坐標和基準位置角度;然后每次來料時,采集圖像計算此時點A(x,y)和直線AB 的角度α,可知偏移量ΔX = x -x0= x,ΔY = y -y0= y,Δα = α -α0。

1.2 系統總體結構設計

根據定位檢測的要求,設計了如圖2 所示的機器人視覺定位系統的硬件總體結構,由相機、鏡頭、光源、圖像采集卡、機器人和工控機等組成。兩個相機安裝在機器人吸盤抓手一端,光源安裝在相機下面,圖像采集卡安裝在工控機PCI 插槽中,工控機和相機以及工控機和機器人都通過以太網相連接,工控機是系統的核心,承擔著圖像處理、界面顯示和通信的重要任務。

圖2 定位系統硬件組成Fig.2 Hardware components of the location system

當機器人抓手到達圖像采集位置后,發出圖像采集信號控制相機采集圖像,采集的圖像通過千兆以太網傳送給工控機;工控機獲取圖像后通過圖像處理算法計算出位置偏移量并發送給機器人,引導機器人調整自己的抓取位姿,如果定位失敗則需要人工調整門板位置重新定位。圖3 為視覺定位系統的整體定位流程。

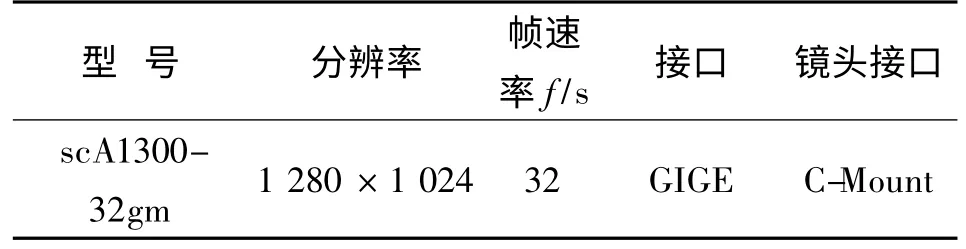

1.3 視覺系統的硬件選型

1.3.1 工業相機 相機是機器視覺系統的核心部件,由感光芯片的不同主要分為CCD 相機和CMOS相機。一般情況下CCD 相機芯片的感光度比CMOS相機芯片敏感,圖像效果好,故本系統采用CCD 相機。根據實際生產要求確定的相機分辨率、幀率以及接口類型等參數,采用德國 Basler 公司scA1300-32gm 工業相機。相機的主要參數見表1。

圖3 視覺定位系統流程Fig.3 Flow chart of the visual location system

表1 工業相機主要參數Tab.1 Main parameters of industry camera

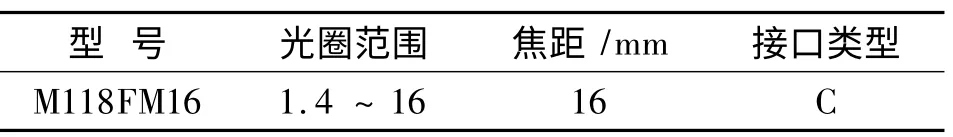

1.3.2 鏡頭 光學鏡頭是機器視覺系統中必不可少的部件,直接影響成像質量的好壞。根據相機分辨率的大小、視野范圍和工作距離等要求,采用日本TAMRON 公司的M118FM16 型號的百萬定焦工業鏡頭。鏡頭的主要參數見表2。

表2 鏡頭主要參數Tab.2 Main parameters of lenses

1.3.3 光源 圖像的質量對整個視覺系統極為重要。在機器視覺系統中好的打光設計可以克服環境光干擾,保證圖像質量穩定,增強圖像的對比度,使目標與背景的邊界清晰,形成有利于圖像處理的效果圖像。

本系統采用的是OPT 公司OPT-RI12000 型號的紅色環形LED 光源,主要考慮了以下幾點因素:

1)采用環形光源,角度是90° 直射方式,可以使光照均勻,增強圖像對比度;

2)由于電梯門板的反光性相對較強,所以采用波長較長的紅色光源可以使采集到的圖像效果更加均勻、穩定;

3)光亮穩定,使用壽命長。

1.4 系統安裝方式

根據來料位置允許誤差范圍為±50 mm 相機視野可控制在160 ×120 mm 左右;提取的特征點A,B距離是260 mm,則兩相機的光心距離保持在260 ±5 mm;受機器人工作最大高度限制相機工作距離不超過470 mm 等實際情況,設計了如圖4 所示的視覺定位系統的安裝方式。

圖4 視覺定位系統安裝方式Fig.4 Installation of the visual location system

2 坐標系的轉換

由于系統采集到的圖像使用的是圖像坐標系,而機器人是通過調整工件坐標系實現位姿的調整,所以需要建立圖像坐標系與工件坐標系的關系。系統中包括3 個坐標系:圖像坐標系、世界坐標系和機器人工件坐標系,Z 軸坐標由激光傳感器確定,視覺系統是在二維平面內的定位,3 個坐標系都是二維坐標系,不考慮Z 軸。

3 個坐標系的關系如圖5 所示。

圖5 3 個坐標系的關系Fig.5 Relationship chart of the coordinate systems

由圖5 可知,要實現圖像坐標系到機器人工件坐標系的轉換,首先要進行相機標定,實現圖像坐標系到世界坐標系的轉換;再進行機器人手眼標定,實現世界坐標系到機器人工件坐標系的轉換。

2.1 相機標定

視覺定位過程中需要確定電梯門板表面點的位置與其在圖像中位置的關系,即需要構建相機成像的幾何模型,相機標定即是求解模型參數的過程[5]。相機標定分為線性標定和非線性標定。成像過程中普遍存在透視畸變和徑向畸變[6-7]。其中,透視畸變主要是因為相機光軸與電梯門板平面不垂直造成的,屬于線性畸變;徑向畸變主要是鏡頭自身的工藝造成的,包括桶形畸變和枕形畸變,屬于非線性畸變。為了能夠準確反映其對應關系,提高視覺定位的精確度,采集的圖像需要畸變矯正,采用非線性標定法。

非線性標定即通過建立攝像機成像的非線性模型,根據標定板圖像中特征點的像素坐標和世界坐標的對應關系求解出攝像機的內外參數及畸變參數。系統中非線性標定采用VisionPro 中的CogCalibCheckerBoardTool 工具,相機1 和相機2 的標定方法相同,下面以相機1 為例說明標定方法。

1)采集標定板圖像。標定板分為棋盤格標定板和網格點標定板,由于當棋盤格標定板采用“詳盡棋盤格”搜索特性時標定精度優于網格點標定板,所以采用棋盤格標定板。標定板圖像的采集環境和工具配置與相機正常工作時一致,根據相機視野和精度的要求制作了平面大小為270 × 190 mm,網格大小為5 mm ×5 mm 的標定板。

2)提取標定信息。獲取標定板圖像后,采用CogCalibCheckerBoardTool 工具提取圖像的特征點;標定模式選擇非線性,特性搜索模式選擇詳盡棋盤格。圖6 為搜索到的特征點分布,圖7 為特征點的坐標值。

圖6 特征點分布Fig.6 Feature point distribution

圖7 特征點坐標Fig.7 Feature point coordinates

3)相機標定。求解相機成像模型的參數,包括透視和徑向畸變模型參數以及線性轉換模型參數;系統運行時,采用求得的模型完成對畸變圖像的矯正,并將圖像坐標系轉換為世界坐標系。圖8 為具體的標定信息。

圖8 標定結果Fig.8 Calibration result

RMS 誤差是特征點位置的均方根誤差,誤差越小標定效果越好,計算公式如下:

其中:N 為找到的特征點的個數;i 為特征點的編號;e 為某個特征點的位置誤差,等于此點通過相機標定轉換求得的世界坐標與未校正前此點真實的世界坐標間的距離。CogCalibCheckerBoardTool 工具中把RMS 誤差分為了5 個等級:(0,0.1)為優秀,(0.1,0.5)為良好,(0.5,2)為合格,(2,5)為差,(5,+ ∞)為非常差。由圖8 可以看出,相機標定的RMS 誤差是0.381 760,由此可知標定結果良好。

2.2 手眼標定

手眼標定完成世界坐標系到機器人工件坐標系的轉換,其關系如圖9 所示。

圖9 世界坐標系和工件坐標系關系Fig.9 Relationship of world coordinate system and workpiece coordinate

由圖9 可以看出,兩坐標系主要的關系是縮放、旋轉和偏移。Ow是世界坐標系,Or是機器人工件坐標系,M 點是坐標系中的任意點,坐標分別為(xwm,ywm)和(xrm,yrm)。則世界坐標系和機器人工件坐標系的關系可表示為

其中:fx,fy為世界坐標系X,Y 方向的縮放比例;α 為旋轉角度;x0,y0為兩坐標系原點偏移量。采用CalibNPointToNPointTool 標定工具計算其轉換關系。

1)確定特征點。通過工具CalibNPointTo-NPointTool 實現坐標系轉換需要一組特征點的坐標值,特征點的選取要對比度好、清晰、計算精確度高,圖1 中的點A 即是本系統選取的特征點。

2)記錄坐標并轉換。常用的坐標系轉換方法有四點法和九點法,點數越多精確度越高,因此文中采用九點法。讓機器人分別沿其X,Y 方向移動兩次,每次移動20 mm,共記錄9 個點,移動到每個點時分別記錄下其未校正坐標和原始的已校正坐標。圖10 為特征點的部分坐標,圖11 為坐標系轉換的結果。系統運行時,通過此轉換即可完成世界坐標系到機器人工件坐標系的轉換。

圖10 特征點坐標Fig.10 Feature point coordinates

圖11 坐標系轉換的結果Fig.11 Coordinate system transformation Results

3 視覺定位系統軟件設計

3.1 開發環境介紹

視覺定位是機器人抓取上料的關鍵環節,在圖像處理的核心算法上必須保證高精度、高效率和高穩定性,這樣無疑要做大量的實驗,增加系統開發的難度和周期[8]。VisionPro 是美國Cognex 公司研發的一套基于PC 的完整的、強大的軟件開發包,包含了定位、圖像標定、檢測、通信等復雜而高效的圖像處理算法,并且支持Gige,FireWire 和Camera-Link 等硬件平臺。本系統基于VisionPro 采用·NET語言進行二次開發,保證系統的穩定性和高效性,同時加快應用程序開發周期,降低開發成本。

3.2 提取特征點坐標

3.2.1 轉換坐標系 采用CogAcqFifoTool 工具采集圖像。此時圖像采用的坐標系是圖像坐標系,根據上述坐標系轉換方法進行坐標系的轉換,使偏移量的計算都在工件坐標系下完成,這樣可以直接為機器人使用。

3.2.2 模板匹配 模板匹配可以在幾何變換中找出特征圖像和其檢測目標之間的坐標對應關系。由于來料位置的變動會使相機采集的圖像特征位置相應變動,采用模板匹配的辦法實現對特征邊搜索區域的粗定位,再用VisionPro 中的CogPMAlignTool工具提取圖片的特征位置信息并通過CogFixtureTool 工具建立其與特征邊搜索區域的坐標對應關系,即使來料門板位置發生了變動也不會影響對特征邊的提取,保證A 點和B 點的穩定提取。

CogPMAlignTool 工具有多種模板匹配算法,主要包括PatQuick,PatMax 和PatFlex,由于對計算速度的要求以及CogPMAlignTool 工具只是用來粗定位,所以采用PatQuick 算法。選擇的模板在整個圖像中要具有唯一性,保證可以唯一的、穩定的匹配到此模板,在此系統中選擇兩條邊相交處矩形孔的直角為匹配模板。CogPMAlignTool 工具模板匹配分為兩個階段,即離線模板訓練和在線模板匹配。首先使用CogPMAlignTool 工具中的圖像掩膜編輯器繪制自己需要訓練的特征模板進行離線訓練并保存;然后對采集到的新圖像進行模板匹配,尋找模板并計算相似度;最后把CogPMAlignTool 工具匹配到的特征位置變化信息傳達給CogFixtureTool 工具實現模板與特征邊搜索區域的坐標相對應關系。兩相機的模板匹配結果分別如圖12、圖13 左上角方框所示。

圖12 相機1 模板匹配和點特征點AFig.12 Template matching and feature point A of Camera 1

圖13 相機2 模板匹配及特征點BFig.13 Template matching and feature point B of Camera 2

3.2.3 提取特征點A,B 首先擬合特征邊,然后求兩條擬合特征邊的交點。特征邊是通過求取邊上的點擬合的,特征邊上點的求取采用VisionPro 中CogFindLine 工具的卡尺實現,本系統中使用40 個探索長度為14 mm、投影長度為4 mm 的卡尺提取特征邊上40 個特征點,同時考慮到外界噪聲對圖像的干擾,在擬合特征邊時忽略5 個偏差最大特征點,以提高擬合的精確性。

把CogFindLine 工具擬合的兩條特征邊Restlt.GetLine()傳遞給CogIntersectLineLineTool 工具求取兩條特征邊的交點,CogIntersectLineLineTool 工具有兩個輸出終端X 和Y,即表示交點的坐標值。特征點A,B 提取的結果分別如圖12、圖13 左上角兩條擬合直線的交點所示。

3.3 計算偏移量

如圖1 所示,把電梯門板放在抓取標準位置,機器人抓手移動到拍照位置采集圖像,經上述圖像處理計算出A0(x0,y0)點的坐標;作為基準位置坐標,采用函數CogMath.AnglePointPoint()計算出直線A0B0的角度α0作為基準角度。

當來料位置發生變化時,用此時計算的點A(x,y)的坐標減去基準位置坐標,即可求得

采用函數CogMath.AnglePointPoint()計算出直線AB 的角度α,減去其基準角度即可求得

4 系統功能測試

為了測試視覺定位系統的功能,選取90 個門板進行重復性測試,并不斷地調整系統參數,使系統盡量達到最佳工作狀態。具體調節參數見表3。

表3 系統工具參數Tab.3 Parameters of system tools

測試結果表明:當電梯門板來料位置允許偏差ΔX 和ΔY 在±50 mm 內、Δα 在±5°內時,視覺系統可以穩定提取特征并實現精確定位。定位誤差在±1.5 mm 內,最大定位誤差為1.36 mm,平均誤差0.863 mm,誤差統計分析見表4。整個視覺定位系統的運行時間穩定在2 s 以內,系統可完成數據追溯和參數設定,滿足實際工業應用要求。

表4 誤差統計分析Tab.4 Statistical analysis of error

5 結 語

在電梯門板上料系統中,將視覺定位技術應用于機器人,使其能夠獲取電梯門板位置信息并調整自己的抓取位姿,以替代人工勞動力提高了生產效率,提升了機器人的智能化水平和工作靈活性,從而擴大其在工業生產中的應用范圍。對于像電梯門板這樣大物件的定位,為保證定位精確性和穩定性采用雙相機定位的方法。目前,該視覺定位系統已經在實際生產中應用,能夠快速、精確、穩定地引導機器人完成電梯門板的上料任務,具有較大的實用價值。

[1]翟敬梅,董鵬飛,張鐵.基于視覺引導的工業機器人定位抓取系統設計[J].機械設計與研究,2014,30(5):45-49.

ZHAI Jingmei,DONG Pengfei,ZHANG Tie.Positioning and grasping system design of industrial robot based on visual guidance[J].Machine Design and Research,2014,30(5):45-49.(in Chinese)

[2]王金濤.基于手眼視覺的工業機器人自動分揀系統研究[J].工業技術創新,2014,1(2):216-220.

WANG Jintao.Research on industrial robot automatied sorting system based on eye-in-hand vision[J]. The Industry Technical Innovation,2014,1(2):216-220.(in Chinese)

[3]廖萬輝,李琳.基于機器視覺的工業機器人定位系統[J].微計算機信息,2009,25(3):242-244.

LIAO Wanhui,LI Lin.Stereo vision for tracking and location system working on industrial robot[J].Microcomputer Information,2009,25(3):242-244.(in Chinese)

[4]張小清,周廣兵.基于機器視覺的動力電池分揀機器人定位系統[J].物流工程與管理,2012,34(1):95-98.

ZHANG Xiaoqing,ZHOU Guangbing. Location system of power battery sorting robot based on machine vision[J]. Logistics Engineering and Management,2012,34(1):95-98.(in Chinese)

[5]廖曉波,李眾立,廖璇.磚窯卸垛機器人視覺定位系統研究[J].控制工程,2013,20(4):650-654.

LIAO Xiaobo,LI Zhongli,LIAO Xuan. Research of brick destacking robot vision orientation system[J]. Control Engineering of China,2013,20(4):650-654.(in Chinese)

[6]王曉華,傅衛平.零件的雙目視覺識別定位與抓取系統研究[J].制造業自動化,2010,32(11):129-132.

WANG Xiaohua,FU Weiping. Research on recognition and location system of work-piece based on binocular vision[J].Manufacturing Automation,2010,32(11):129-132.(in Chinese)

[7]薛白,段鎖林,鄒凌.考慮徑向畸變的機器人視覺系統的參數標定[J].計算機工程與設計,2012,33(11):4407-4411.

XUE Bai,DUAN Suolin,ZOU Ling.Calibration of camera parameters with radial distortion for robot vision system[J].Computer Engineering and Design,2012,33(11):4407-4411.(in Chinese)

[8]晏祖根,李明,徐克非,等.高速機器人分揀系統機器視覺技術的研究[J].包裝與食品機械,2014,32(1):28-31.

YAN Zuigen,LI Ming,XU Kefei,et al.High-speed robot auto-sorting system based on machine vision[J]. Packaging and Food Machinery,2014,32(1):28-31.(in Chinese)