可遷移測度準則下的協變量偏移修正多源集成方法

楊興明 吳克偉 孫永宣 謝 昭

(合肥工業大學計算機與信息學院 合肥 230009)

可遷移測度準則下的協變量偏移修正多源集成方法

楊興明 吳克偉 孫永宣 謝 昭*

(合肥工業大學計算機與信息學院 合肥 230009)

遷移學習通過充分利用源域共享知識,實現對目標域的小樣本問題求解,然而,對訓練和測試樣本分布差異測度仍然是該領域的主要挑戰。該文針對多源遷移學習算法中,由于源域選擇和源域輔助樣本選擇不當引起的“負遷移”問題進行研究,提出一種可遷移測度準則下的協變量偏移修正多源集成方法。首先,根據源域和目標域之間的協變量偏移原則,利用聯合概率的密度估計,定義輔助樣本的可遷移測度,驗證目標域和源域在數據空間中標記分布的一致性。其次,在多源域選擇階段,引入非遷移判別過程,提高了源域知識的遷移準確性。最后,在Caltech 256數據集中,驗證了Gist特征知識表示和遷移的有效性,分析了多種條件下的輔助樣本選擇和源域選擇的有效性。實驗結果表明所提算法可有效降低“負遷移”現象的發生,獲得更好的遷移學習性能。

集成學習;遷移學習;協變量偏移;圖像分類

1 引言

傳統機器學習方法在訓練樣本有限的情況下,難以有效描述特定類別的數據空間分布。遷移學習通過利用與目標任務相關的大量輔助樣本,彌補訓練樣本不足,實現了不同領域和任務之間的知識共享、樣本傳播和再利用[1,2]。在遷移學習中將目標任務所在的領域稱作目標域,把與當前任務不同但存在相關性的領域稱作源域,遷移學習利用源域數據作為目標域任務的輔助樣本,實現知識由源域到目標域的遷移[3]。遷移學習的難點在于遷移知識選擇不當而引起的目標域任務性能降低的“負遷移”效應,即關注于共享知識選擇的度量。當前研究根據共享知識策略的不同,大致可以分為實例層遷移、特征層遷移和模型層遷移。

實例層將待分類樣本作為研究對象,描述其可能具有的共享知識。實例層遷移通過分析不同類別樣本之間的關聯特性,利用源域輔助樣本擴充目標域實例的標記,實現異類小樣本分類。實例層的度量關注于輔助樣本的可遷移程度[4]與差異程度[5]、源域和目標域的相容性[6]與相關性(如類間相關性[7],視角相關性[8],幀間相關性[9])。實例層遷移還涉及多模態數據的應用場合,例如,跨域的標簽傳播[10]以及人臉識別[11]等問題。

特征層遷移通過構建有效的特征變換,提取樣本中的抽象表示作為遷移知識載體。特征層的度量體現在目標域樣本和源域樣本的分布差異性,并期望通過特征映射實現分布差異的最小化。特征層的研究關注于利用稀疏學習[12,13]、層次分組[14]方法實現源域與目標域之間特征提取,并嘗試獲得特征空間的若干屬性(如稀疏性[15]、可分解性[15]、幾何流形[3])。此外,通過加入正則約束[16],防止遷移特征的學習過程中的過擬合現象的發生,提高遷移學習方法的執行效率。

模型層將不同分類方法中的控制參數作為共享知識對象,通過對數據分布建模,實現兩域分布差異的度量。模型層研究關注于源域和目標域分類建模的可靠性(如基分類器[17],有序分類器[18],L2核分類器[19],條件與邊緣概率[20])。模型層方法通過引入數據分布先驗作為多級評價過程,確保遷移過程在不同級別下誤差的有限積累[21,22],從而達到提高遷移精度的目的。

上述不同方法都將目標域和源域間的數據分布估計視為可靠的遷移先驗信息[23]。但是,多源TrAdaboost[24,25]作為實例層的代表性方法,卻沒有對數據分布進行充分估計。此外,多源TrAdaboost方法在源域類別選擇過程中,每輪學習對每個源域類別都進行一次目標域的“試遷移”,該過程沒有考慮源域類別引入,是否會直接引起“負遷移”效應。

因此,本文重點關注實例多源TrAdaboost遷移學習對該問題分析的不足,通過考慮目標域和源域樣本分布間的差異性,利用協變量偏移測量樣本可遷移能力,調整樣本權重更新策略,以反映數據分布估計對樣本選擇的影響。并根據源域類別的可遷移能力,引入源域非遷移選擇過程,重新設計基于協變量偏移修正的遷移損失估計方法,提高遷移學習方法的執行效率。實驗結果表明,本文算法能有效降低“負遷移”的發生,在有限樣本下的圖像分類任務中,獲得更好的分類性能。

2 多源Adaboost集成遷移學習

Adaboost集成遷移(即 TrAdaboost)[25]采用Adaboost集成學習框架[6]。TrAdaboost算法放寬了原始Adaboost算法受限于訓練與測試數據同分布的約束限制。TrAdaboost算法的遷移能力大小主要取決于該源域與目標域的關聯程度,因此,僅依賴單個源域進行遷移的TrAdaboost算法,本質上易造成“負遷移”現象。為降低“負遷移”風險,通常可將單源域遷移過程擴展至多源域,從多個源域向目標域進行知識的遷移,即多源遷移學習,如多源TrAdaboost[4]。

在遷移學習分類任務中,假設樣本數據空間為X,樣本標記空間為 Y∈{- 1 ,+1}(這里舉例二值情況)。定義目標域T,該域包含少量有標記的訓練樣本集合 DT和用于模型測試的無標記樣本集合DTEST,數據均服從概率分布 PT。定義 K個源域S1,S2,…, SK,各源域包含標記數據 DS1,DS2,…, DSK,均服從概率分布 PSk。多源TrAdaboost通過合理利用源域輔助學習,獲得目標域上的分類模型 fT/S: X → Y,并盡可能地減小其經驗誤差。

其中?·?為指示函數,當內部條件為真時,返回值為1,否則返回值為0。

多源TrAdaboost在每一輪學習中,根據最小損失選出該輪(第t輪)的優勝源域和優勝分類器(St,ht)= argminht,SkL( htT,k)。根據式(1),多源TrAdaboost算法雖然在一定程度上進行了知識的遷移,但是,該方法沒有顯式估計目標域和源域樣本分布之間存在的差異性,對源域中知識遷移能力的解釋能力有限。因此,難以從本質上解決源域關聯性不足引起的“負遷移”現象。

3 可遷移測度準則下協變量偏移修正

針對多源TrAdaboost方法在目標域與源域樣本分布一致性估計不足的問題,本文提出一種可遷移測度準則下的協變量偏移修正多源集成遷移方法。一方面,根據源域和目標域之間的協變量偏移原則,利用聯合概率的密度估計,設計樣本密度比值描述樣本的可遷移度;另一方面,在多源域選擇階段,利用源域經驗誤差進行源域初步選擇,避免由于分布差異引起的“負遷移”效應,提高遷移過程的可靠性。

考慮協變量偏移下的可遷移測度后,對式(1)中的原始損失函數進行修正,則有其中,為一次迭代過程中源域 Sk和目標產生的遷移分類器, δ={δT/S(x,y )}為樣本密度比值,}為源域遷移選擇系數, ET[·]和ES[·]分別表示目標域和源域中的分類器預測損失期望。

3.1 協變量偏移下的樣本可遷移測度

一般情況下,在遷移學習中,雖然源域與目標域樣本分布形式不同,但對于給定的樣本觀測數據,該樣本屬于某個已知類別的條件概率相同,即標記y的正例和負例分布在目標域和源域樣本x中是一致的這種現象被稱為樣本分布的協變量偏移(covariate shift)[26],而這種樣本分布可較好解釋多源TrAdaboost在目標域與源域樣本分布一致性估計假設。

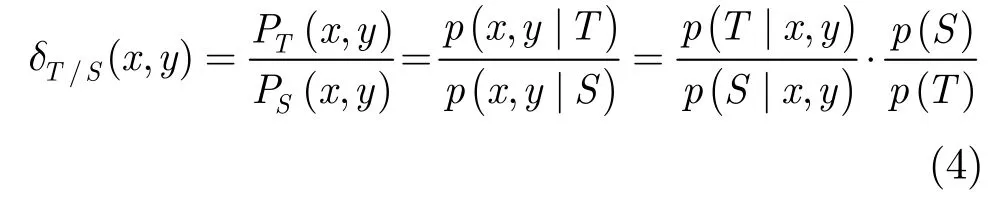

在協變量偏移條件下,討論目標域和源域在數據空間中標記分布的一致性,分析聯合概率,實現源域中每個實例的可遷移程度的有效估計。定義目標域和源域樣本分布的密度比值為 δT/S(x,y)= PT(x,y )/ PS(x,y),則根據貝葉斯定理對該密度比值進行求解有

一般認為目標域和源域先驗分布概率相同,即p(T )= p(S),因此δ取值僅取決于條件概率 p(T由于給定樣本(x, y)屬于目標域或源域的條件概率,無法先驗獲取,因此,實際通常采用預測標簽與真實標簽的指數函數進行近似:

其中, HS(x)表示利用源域訓練樣本所得分類器,HT(x)表示利用目標域訓練樣本所得分類器,可根據傳統機器學習方法直接學習獲得。

3.2 源域非遷移選擇

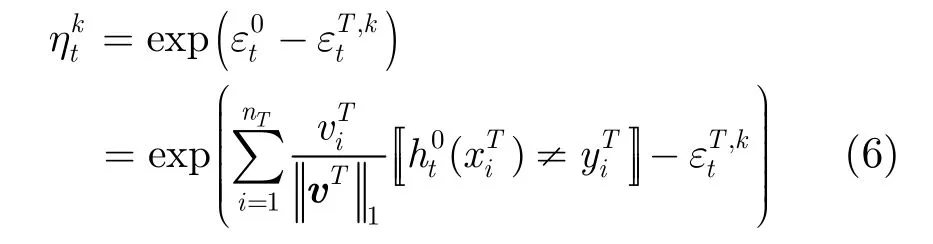

由式(1)進行的源域類別選擇是一種確定性估計,但是,真實數據的損失估計存在不確定性,源域類別選擇通常采用隨機采樣的過程,保證源域的多樣性。本文通過估計源域的可遷移能力,調整隨機采樣的權重,實現源域非遷移選擇,降低不良源域類別對目標域任務的“負遷移”效應。在第t次迭代中,源域 Sk對目標域T的可遷移能力定義為

由于引入了源域非遷移選擇,本文算法在多源TrAdaboost的框架中,通過重新估計隨機采樣的權重,抑制源域的“負遷移”現象。在每輪學習開始階

3.3 協變量偏移下的樣本權重更新

對于每個樣本來說,樣本分布密度比值僅依賴于源域和目標域。在最小化損失函數求解過程中,密度比值的估計對模型的影響主要體現在樣本的權重更新過程中。

本文方法利用式(3)實現協變量修正下的損失估計,通過對其最小化獲得最優分類器 ht,并進一步估計目標域和優勝源域在該分類器上的誤差該誤差是樣本權重更新的重要依據。對于目標域中的樣本來說,采用增大權重的方式強調該樣本對分類判決面決策過程的影響。在源域樣本的權重更新策略中,采用降低權重方式將其濾除。為進一步分析目標域樣本權重的穩定性,迭代過程中的目標域樣本權重可表示為

一般情況下,假設遷移學習的先驗分布為等概率分布,各樣本的初始權重相同,故忽略后不影響采樣過程,更新過程等價為

式(9)給出了更為直接的計算形式,可以提高遷移學習的計算效率。

通過上述權重計算過程,可解釋目標域樣本分布 PT(x, y)和源域樣本分布PSK(x,y)存在協變量偏移現象。在迭代運算過程中,目標域和源域的樣本權重隨之更新,用于調整對各源域的遷移誤差估計。本文方法根據式(3)選出每輪優勝基分類器,最終將每輪的優勝基分類器組合獲得的遷移學習分類器

4 實驗與分析

4.1 實驗圖像集

為證明本文算法的有效性,分別采用加州理工學院的 Caltech256數據集[22]和麻省理工學院的SUN09數據集[27]進行實驗。在本文實驗中,通過對Caltech 256數據集進行數據統計,選擇圖像數不少于100幅的136個類別作為候選源域類別,剩余的120個類別作為候選目標域類別。對于SUN09數據集,選取144個類別中圖像數目最少的前15個類別作為候選目標域類別,剩余的129個類別作為候選源域類別。本文采用Gist特征用于目標類別識別[28],Gist作為一種描述目標布局屬性的主旨特征,具備描述Caltech256及SUN09數據集目標類的能力。

4.2 算法性能分析

目標域和源域的構造是遷移學習的基本步驟[4]:從候選目標域類別中任意選取某個類別作為目標域,從該類別中隨機選取 n幅圖像作為目標域正例樣本,隨機加入 n幅背景干擾圖像作為目標域負例樣本;從剩下的圖像中隨機選取 n幅正例和 n幅負例作為測試圖像。接著,從候選源域類別中任意選取K個類別構建K個源域,從每個源類別中隨機選取 n幅圖像作為源域正例樣本,在每個源域中隨機加入幅背景干擾圖像作為源域負例樣本。

實驗1 源域和目標域之間的密度比值估計

實驗2 多源域遷移選擇

進一步考察算法的源域選擇情況和基分類器的誤差,每輪迭代過程中隨機選擇5個源域。圖2分別以Caltech256數據集的目標域類別hourglass和SUN09數據集的目標域類別 cup為例。其中,Caltech256數據集實驗中隨機選擇的 5個源類為llama, ketch, T-shirt, hammock, light-house;SUN09數據集實驗中隨機選擇的5個源類為table,gate, jar, pillow, pot。用柱狀圖給出前10輪源域選擇結果,每輪選擇1個優勝分類器,圖中文字表示在該輪迭代中算法所選擇的遷移源域類別。圖2中部分源域選取的結果可能與人類認知并不相符,這種現象可以解釋為:(1)源域類別隨機且數量有限,選擇范圍內缺少更好的類別,每輪的分類器誤差可能會增加;(2)算法除了選擇源域,也對源域內樣本進行了選擇,可能其中的部分樣本起到了正向遷移的作用。

圖1 目標/源域數據分布密度比值δ

圖2 前10輪迭代過程中的源域選擇情況

實驗3 對比試驗

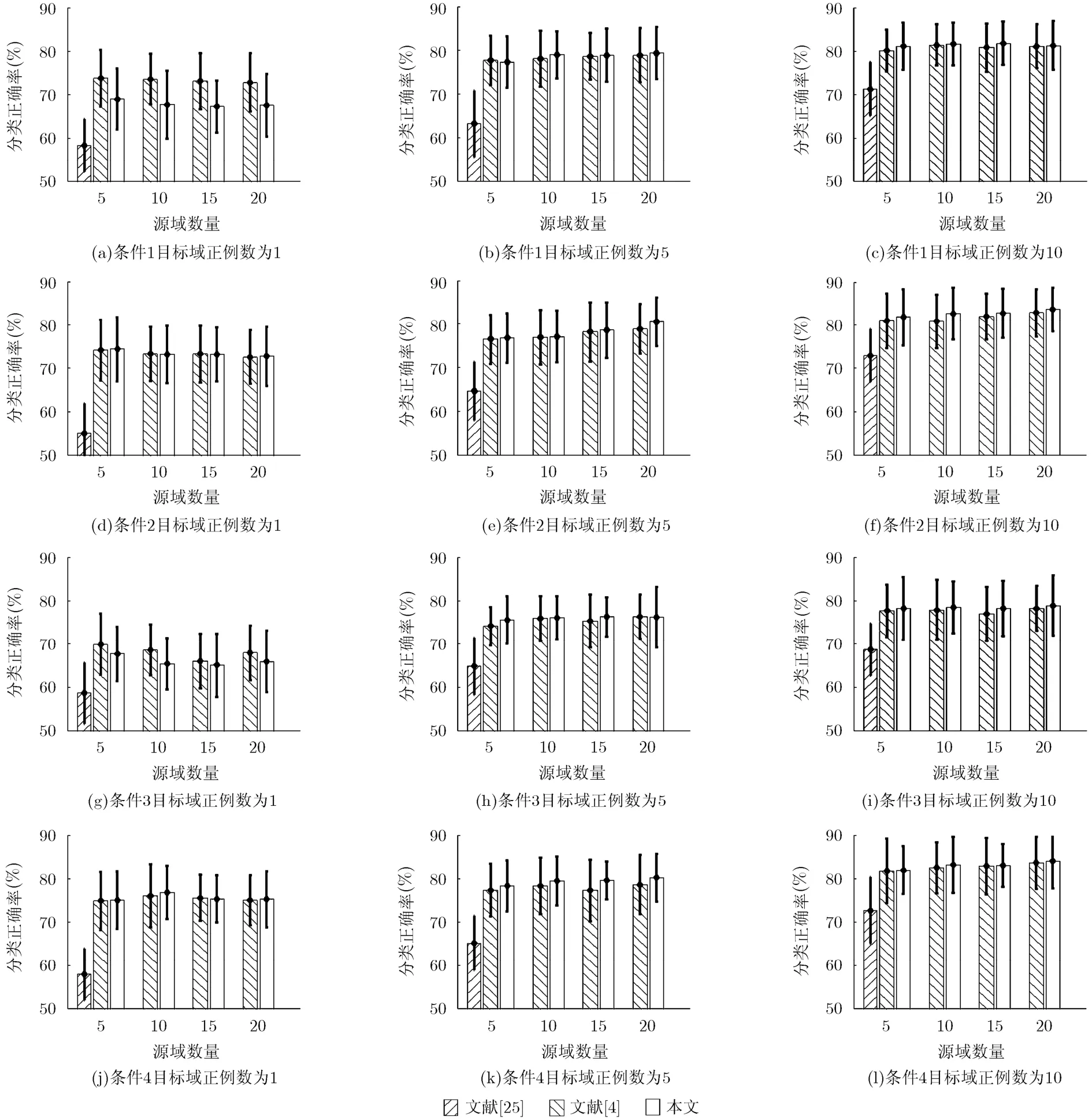

為進一步說明算法的有效性,分別在Caltech256和SUN09數據集上實驗,與目前公認經典有效的多類 Adaboost[25]、多源 TrAdaboost[4]算法進行對比。實驗中各參數取值如下:目標域正例樣本數,源域個數源域正例樣本數基學習器均采用線性支持向量機(linear SVM), Adaboost弱分類器迭代次數均為30次。為增強實驗客觀性,所有實驗結果均在15個隨機目標域類別上進行測試,且由于實驗中源域類別和樣本選取的隨機性,實驗的定量評價結果為每個目標域類別上的5次重復實驗的平均分類準確率。兩個數據集下實驗的參數設置相同。

圖3 Caltech256數據集在4種條件下各算法的實驗結果

實驗結果考慮有限樣本的規模對遷移學習算法的影響,分別在 4種條件下進行實驗,測試圖像中的比例和的比例保持一致,且固定在Caltech256和SUN09數據集下實驗結果如圖3和圖4所示,其中45°斜線紋理柱為多類 Adaboost[25], 135°斜線紋理柱 為 多 源Adaboost[4],空心柱為本文方法實驗結果,橫坐標是源域個數K(4種情況),縱坐標為對應分類正確率,柱狀圖上方細線表示正確率變化的范圍(即正確率方差)。

圖4 SUN09數據集在4種條件下各算法的實驗結果

根據圖3和圖4,實驗分析源域個數對遷移學習影響情況可以發現,并非源域個數越多,遷移效果就一定越好,這是因為“遷移效應”主要和目標域、源域間的關聯程度密切相關,過多的不相關源域可能反而會對遷移造成負向干擾。

4種條件分別給出了不同正負例分布的遷移學習情況,進一步分析負例樣本數對遷移學習的影響。通過對比圖3和圖4中的數據可以發現,以條件(1)下的實驗結果為基準,在條件(2)和條件(4)中,增加目標域的負例樣本后,分類準確率可大幅上升且浮動較小,這表明目標域的負例樣本對分類器的性能起到提升作用。然而,條件(3)中僅有源域的負例樣本增加時,分類準確率反而下降,這說明過量的源域負例樣本會給遷移過程帶來干擾。總體而言,本文算法分類結果相對多源TrAdaboost方法具有明顯優勢。當目標域訓練樣本數為5和10時,多數情況本文方法完全勝出,少量條件下經典多源TrAdaboost方法能給出較好的結果,本文方法也能接近可行解。

從Caltech256和SUN09數據集實驗均可以看出,新方法在極端情況(即目標域僅有1個正例訓練樣本)時的遷移效果不佳,這是因為在改進算法中增加了非遷移分類器作為判定條件。非遷移判斷條件發生在以下的情況:由于在僅有1個正例訓練樣本時,所訓練出的非遷移分類器隨機性很大,只要對極少量的目標域樣本分類正確,則視其誤差為 0;在之后的源域類別的遷移能力計算中,會因為遷移分類器的誤差大于0而出現大量負值,導致算法認定出現了“負遷移”而未能合理的進行源域的有效選取,在一定程度上限制了遷移過程的發生。

5 結束語

本文著重研究如何使用遷移學習理論解決小樣本問題,通過分析遷移學習的“負遷移”現象產生的原因,解釋了訓練、測試樣本不同分布的估計與評價方法,針對現有多源遷移算法,從兩個方面分別解決源域選擇和輔助樣本選擇的不足,通過考慮目標域、源域樣本分布之間的差異性,對現有多源遷移損失函數引入了協變量偏移修正,抑制了單源域情況下的“負遷移”樣本影響;通過在每輪迭代中計算源域的可遷移度,并增加非遷移判斷,一定程度上抑制了多源域條件下的“負遷移”現象。實驗結果證明了本文算法的有效性。由于本文實驗采用單類別屬性標記,未來工作將在此基礎上向目標類的語義關系方向進行研究,分析語義指導下的源域選擇方法。此外,本文算法在目標域僅有1個正例樣本時效果不穩定,這種條件下的分類識 別(稱為“one-shot learning”)已成為一個特定的研究課題,有待進一步改進的有效算法處理單樣本跨域的遷移學習問題。

[1] Tommasi T, OrabonaF, and Caputo B. Learning categories from few examples with multi model knowledge transfer[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 36(5): 928-941.

[2] Yao Y and Doretto G. Boosting for transfer learning with multiple sources[C]. Proceedings of Computer Vision and Pattern Recognition, San Francisco, 2010: 1855-1862.

[3] Long M S, Wang J M, Ding G G, et al.. Adaptation regularization a general framework for transfer learning[J]. IEEE Transactions on Knowledge and Data Engineering,2014, 26(5): 1076-1089.

[4] Lin D, An X, and Zhang J. Double-bootstrapping source data selection for instance-based transfer learning[J]. Pattern Recognition Letters, 2013, 34(11): 1279-1285.

[5] Kuzborskij I, Orabona F, and Caputo B. From N to N+1: multiclass transfer incremental learning[C]. Proceedings of Computer Vision and Pattern Recognition, Portland, 2013: 3358-3365.

[6] Zhu Y, Chen Y Q, Lu Z Q, et al.. Heterogeneous transfer learning for image classification[C]. Proceedings of AAAI Conference on Artificial Intelligence, San Francisco, 2011: 1304-1309.

[7] 張倩, 李明, 王雪松, 等. 一種面向多源領域的實例遷移學習[J]. 自動化學報, 2014, 40(6): 1176-1183. Zhang Qian, Li Ming, Wang Xue-song, et al.. Instance-based transfer learning for multi-source domains[J]. Acta Automatica Sinica, 2014, 40(6): 1176-1183.

[8] Pang J, Huang Q, Yan S, et al.. Transferring boosted detectors towards viewpoint and scene adaptiveness[J]. IEEE Transactions on Image Processing, 2011, 20(5): 1388-1400.

[9] Li G, Qin L, Huang Q, et al.. Treat samples differently: object tracking with semi-supervised online CovBoost[C]. Proceedings of International Conference on Computer Vision,Barcelona, 2011: 627-634.

[10] Qi G J, Aggarwal C, Rui Y, et al.. Towards cross-category knowledge propagation for learning visual concepts[C]. Proceedings of Computer Vision and Pattern Recognition,Colorado Springs, 2011: 897-904.

[11] Chu W S, Torre F D, and CohnJ F. Selective transfer machine for personalized facial action unit detection[C]. Proceedings of Computer Vision and Pattern Recognition,Portland, 2013: 3515-3522.

[12] Yang S Z, Hou C P, Zhang C S, et al.. Robust non-negative matrix factorization via joint sparse and graph regularization for transfer learning[J]. Neural Computing and Applications,2013, 23(2): 541-559.

[13] 方耀寧, 郭云飛, 丁雪濤, 等. 一種基于標簽遷移學習的改進正則化奇異值分解推薦算法[J]. 電子與信息學報, 2013,35(12): 3046-3050. Fang Yao-ning, Guo Yun-fei, Ding Xue-tao, et al.. An improved regularized singular value decomposition recommender algorithm based on tag transfer learning[J]. Journal of Electronics & Information Technology, 2013,35(12): 3046-3050.

[14] Gopalan R. Learning cross-domain information transfer for location recognition and clustering[C]. Proceedings of Computer Vision and Pattern Recognition, Portland, 2013: 731-738.

[15] Luo Y, Liu T L, Tao D C, et al.. Decomposition-based transfer distance metric learning for image classification[J]. IEEE Transactions on Image Processing, 2014, 23(9): 3789-3801.

[16] Long M S, Wang J M, Ding G G, et al.. Transfer learning with graph co-regularization[J]. IEEE Transactions onKnowledge and Data Engineering, 2014, 26(7): 1805-1818.

[17] 洪佳明, 印鑒, 黃云, 等. TrSVM: 一種基于領域相似性的遷移學習算法[J]. 計算機研究與發展, 2011, 48(10): 1823-1830. Hong Jia-ming, Yin Jian, Huang Yun, et al.. TrSVM: a transfer learning algorithm using domain similarity[J]. Journal of Computer Research and Development, 2011,48(10): 1823-1830.

[18] Seah C W, Tsang I W, and Ong Y S. Transfer ordinal label learning[J]. IEEE Transactions on Neural Networkand Learning System, 2013, 24(11): 1863-1876.

[19] 許敏, 王士同, 史熒中. 一種新的面向遷移學習的 L2核分類器[J]. 電子與信息學報, 2013, 35(9): 2059-2065. Xu Min, Wang Shi-tong, and Shi Ying-zhong. A novel transfer-learning-oriented L2 kernel classifier[J]. Journal of Electronics & Information Technology, 2013, 35(9): 2059-2065.

[20] Long M S, Wang J M, Ding G G, et al.. Transfer feature learning with joint distribution adaptation[C]. Proceedings of International Conference on Computer Vision, Sydney,2013: 2200-2207.

[21] Patricia N and Caputo B. Learning to learn, from transfer learning to domain adaptation: a unifying perspective[C]. Proceedings of Computer Vision and Pattern Recognition,Columbus, 2014: 1442-1449.

[22] Zhang B, Wang Y, Wang Y, et al.. Stable learning in coding space for multi-class decoding and its extension for multi-class hypothesis transfer learning[C]. Proceedings of Computer Vision and Pattern Recognition, Columbus, 2014: 1075-1081.

[23] Gretton A, Smola A, Huang J, et al.. Covariate Shift by Kernel Mean Matching[M]. Cambridge: MIT Press, 2009: 131-160.

[24] Huang P P, Wang G, and Qin S Y. Boosting for transfer learning from multiple data sources[J]. Pattern Recognition Letters, 2012, 33(5): 568-579.

[25] Nie Q F, Jin L Z, and Fei S M. Probability estimation for multi-class classification using AdaBoost[J]. Pattern Recognition, 2014, 47(12): 3931-3940.

[26] Sugiyama M, Krauledat M, and Müller K R. Covariate shift adaptation by importance weighted cross validation[J]. The Journal of Machine Learning Research, 2007, 8(1): 985-1005.

[27] Choi M J, Lim J J, Torralba A, et al.. Exploiting hierarchical context on a large database of object categories[C]. IEEE Conference on Computer Vision & Pattern Recognition, San Frencisco, CA, 2010: 129-136.

[28] Han Y and Liu G. Biologically inspired task oriented gist model for scene classification[J]. Computer Vision and Image Understanding, 2013, 117(1): 76-95.

楊興明: 男,1976年生,副教授,研究方向為計算機控制、模式識別、物聯網應用.

吳克偉: 男,1984年生,講師,研究方向為計算機視覺、圖像處理、模式識別.

孫永宣: 男,1978年生,講師,研究方向為計算機視覺、圖像處理.

謝 昭: 男,1980年生,副研究員,研究方向為計算機視覺、圖像處理、模式識別.

Modified Covariate-shift Multi-source Ensemble Method in Transferability Metric

Yang Xing-ming Wu Ke-wei Sun Yong-xuan Xie Zhao

(School of Computer and Information, Hefei University of Technology, Hefei 230009, China)

Transfer learning usually focuses on dealing with small training set in target domain by sharing knowledge generated from source ones, in which one main challenge is divergence metric of distributed samples between training and test data. In order to deal with “negative transfer” problem caused by improper auxiliary sample selections in source domains, this paper presents a modified covariate-shift multi-source ensemble method with transferability criterion. Firstly, transferability metric of auxiliary samples is defined by joint density estimation in accordance with co-variant transfer principles from source to target, so that the coherency of data distributions is verified. After that, whether transfer learning occurs or not should be determined after evaluating transferability metric in different sources to boost accuracy. Finally, experiments on Caltech256 using GIST demonstrate effectiveness and efficiency in the proposed approach and discussions of performance under diverse selections from auxiliary samples and source domains are presented as well. Experimental results show that the proposed method can sufficiently hold back “negative transfer” for better learnability in transfer style.

Ensemble learning; Transfer learning; Covariate shift; Image classification

s: The National Natural Science Foundation of China (60905005, 61273237)

TP391

A

1009-5896(2015)12-2913-08

10.11999/JEIT150323

2015-03-17;改回日期:2015-08-13;網絡出版:2015-10-13

*通信作者:謝昭 xiezhao@hfut.edu.cn

國家自然科學基金(60905005, 61273237)