機器人智能抓取系統視覺模塊的研究與開發*

葉 卉,張為民,1b,張 歡,Jürgen Fleischer

(1.同濟大學 a.機械與能源工程學院; b.中德學院; c.先進制造技術中心, 上海 201804;2.卡爾斯魯厄理工學院 生產技術研究所, 德國 卡爾斯魯厄 76131)

機器人智能抓取系統視覺模塊的研究與開發*

葉 卉1a,張為民1a,1b,張 歡1a,Jürgen Fleischer1c,2

(1.同濟大學 a.機械與能源工程學院; b.中德學院; c.先進制造技術中心, 上海 201804;2.卡爾斯魯厄理工學院 生產技術研究所, 德國 卡爾斯魯厄 76131)

以ABB機器人、快換手爪、雙目相機為硬件基礎,搭建了基于雙目立體視覺的工業機器人智能抓取系統,旨在實現隨機放置物體的識別定位和自動抓取。基于視覺模塊,研究了圖像處理、立體匹配和深度計算以及坐標轉換,以C++為開發平臺,結合OpenCV圖像開發庫和Triclops庫,開發了視覺識別與定位算法,實現對圓柱體和長方體薄板對象的分類和位姿識別。最后,通過實驗驗證,表明該視覺算法有較高的識別定位精度,滿足抓取系統的要求。

工業機器人;機器視覺;智能抓取;立體匹配;坐標轉換

0 引言

隨著“中國制造2025”戰略口號的提出,機器人在生產制造領域的應用越來越廣泛。工業機器人自身可實現復雜動作的自動化,但難以實現自適應作業的自動化[1]。在裝配、分揀、搬運和碼垛等工業環境中,機器人的應用大多停留在示教階段,機器人與人、與環境之間的交互不夠,機器人的感知能力較差,這種情況下單一的機器人作業往往只能應對結構化環境,早已不能滿足現代生產對柔性化和智能化的要求。

“中國制造2025”的核心就是以智能制造為主攻方向,對于工業機器人智能化研究來說,從工作場景中識別并抓取指定物體是其一大熱點,其關鍵技術就在于識別并提取目標物體相對于機器人的位姿[2]。機器視覺技術在目標識別和目標位姿求取方面具有強大的技術優勢,它具有信息量大、精度高、非接觸測量、響應快速等特點[3],可以快速自動處理大量信息, 并且易于與控制信息實現集成。同時將機器視覺技術與機器人技術結合,通過對機器人操作對象及其所處環境的智能化處理,從一定程度上降低了對對象的具體要求,使機器人能更好地適應非結構化的環境,從而提高了工業機器人系統的智能化程度。

目前,應用機器視覺的機器人系統的主要搬運對象是形狀規則的扁平物體,此類系統多采用配有吸盤式末端執行器的工業機器人[4-8],搬運對象相對局限;且攝像機多采用單目相機,固定在物體上方,視覺研究多是基于二維圖像層面。本文初步建立了智能抓取系統的系統架構,并針對機器人智能抓取系統視覺模塊的關鍵技術進行研究。本文構建的機器人智能抓取系統,使用ABB六軸串聯工業機器人,和SCHUNK的氣動手爪以及快換夾具,能夠實現對不同對象的處理操作。系統采用雙目相機開發視覺模塊,通過邊緣特征將目標識別出來,基于立體視覺的視差原理完成對空間三維物體的空間定位[9-10],并通過上位機實現智能抓取過程的控制。

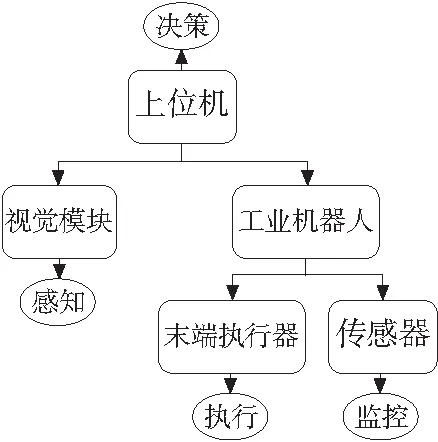

1 智能抓取系統整體設計

本文構建的智能抓取系統架構如圖1所示。視覺模塊作為智能抓取系統的感知模塊,主要獲取系統需要處理的對象信息,并將信息傳遞給上位機,例如類型和位姿信息,從而解決了處理對象“是什么”和“在哪兒”的問題;機器人結合末端執行器,作為抓取操作的執行模塊,完成智能抓取系統的快速換爪和抓取搬運操作;各類傳感器的引入,例如力傳感器、位置傳感器,可以對末端手爪的開合位置和抓取力進行監控,并反饋給機器人控制器;上位機集成各模塊,并對各模塊起決策作用,控制機器人根據視覺模塊的處理結果智能選擇合適的末端執行器,并對物料采取對應的動作響應處理。本文根據機器人智能抓取系統對視覺模塊的要求,重點研究視覺平臺的搭建和視覺處理算法的開發。視覺模塊自身和機器人的運動控制過程相對獨立,通過上位機集成控制,因而視覺模塊可以快速集成到現有的工業機器人系統中。

圖1 智能抓取系統原理

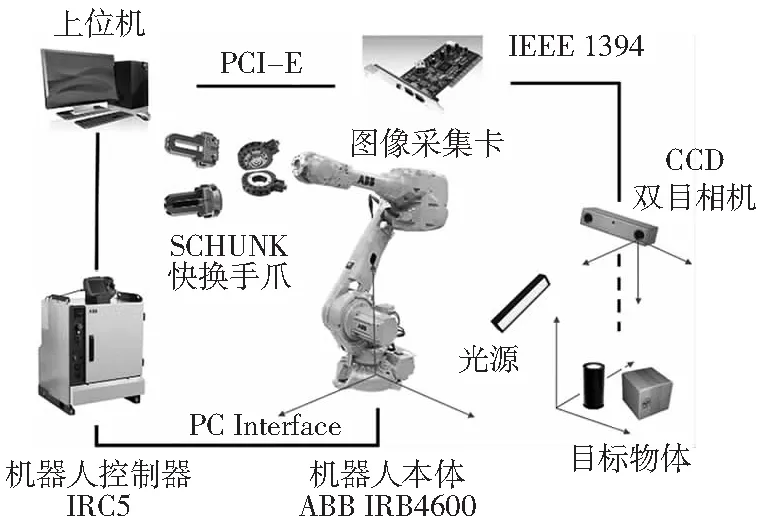

如圖2所示為機器人智能抓取系統的硬件結構,系統采用CCD相機進行圖像拍攝,通過圖像采集卡采集圖像信息,氣動快換手爪裝在機器人末端并作為抓取動作的執行機構,用上位機集成控制,同時配備光源等輔助設備。

圖2 智能抓取系統硬件結構圖

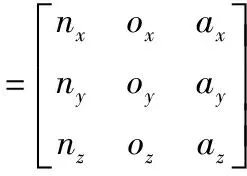

2 視覺模塊硬件平臺

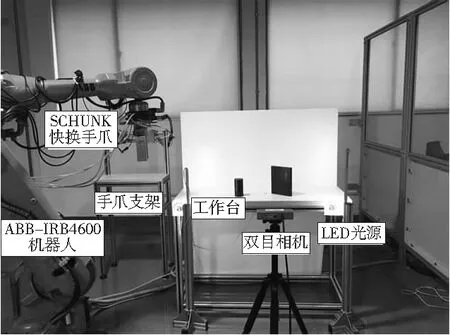

本文機器人智能抓取系統平臺搭建在同濟大學先進技術制造中心實驗室,機器人所處環境周圍受自然光影響較大,識別物體為圓柱體和長方體薄板工件。機器人智能抓取系統視覺模塊的硬件平臺如圖3所示。相機選用Point Grey 公司的BB2雙目立體相機,置于工作臺前側,距離工作臺前端面1m,距地面高度85mm,稍高于工作臺平面;LED條形光源隨支架置于工作臺兩側,與工作臺前端面約成45°角放置;機器人型號為ABB-IRB4600,在工作臺右前方;快換手爪的支架置于工作臺右后側。

圖3 機器人智能抓取系統視覺模塊平臺布局

3 視覺模塊軟件開發

視覺模塊是整個系統的核心,機器人準確而穩定地抓取依賴于視覺算法的精確處理。視覺算法基于C++平臺開發,使用的開發包有Point Grey research公司BB2系列相機基于圖像獲取和3D識別的開發包——FlyCapture2和Triclops Stereo Vision SDK及圖像處理開源庫——OpenCV。

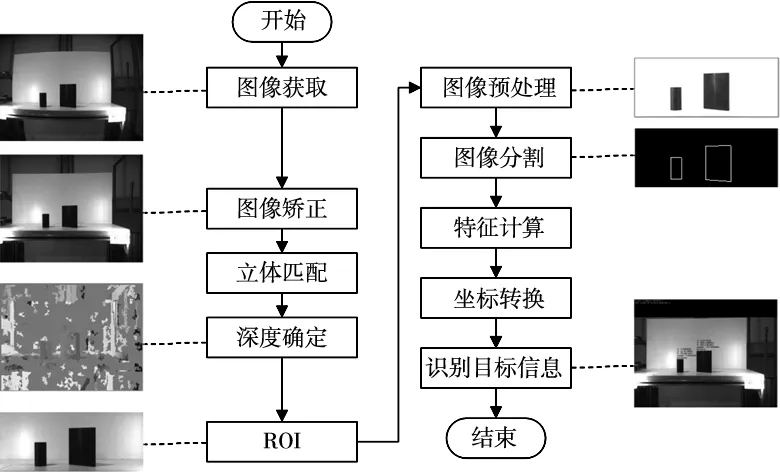

如圖4所示為軟件算法的視覺處理流程,雙目相機首先同時拍攝同一場景左右兩副圖像,調用標定信息并進行矯正畸變獲得矯正后的圖像,矯正后圖像經過立體匹配獲得匹配點,再進行相關計算得到整個場景的深度信息,供后續處理調用;另一方面,矯正后圖像經過濾波降噪等預處理后,提取包含目標的感興趣區域(ROI),ROI圖像經過圖像分割處理得到目標輪廓,再經過特征計算得到相機坐標系下的目標位姿,繼而通過坐標轉換得到機器人坐標系下目標的三維信息,至此完成視覺模塊目標識別和定位的任務。

圖4 視覺處理流程

3.1 立體匹配

立體匹配是實現空間立體測量的基礎,它是通過對所選特征進行計算從而建立特征之間的對應關系,將同一個空間物理點在不同圖像中的映像點對應起來的過程。建立立體匹配由三個基本步驟組成[11]:①從立體圖像對中的一幅圖像中選擇與實際物體結構相應的圖像特征;②在另一幅圖像中確定出同一物理結構的對應圖像特征;③確定這兩個特征之間的相對位置,得到視差。

立體匹配的關鍵在于建立相關性,這里使用絕對偏差和的方法,其原理是:在遍歷參照圖中每一個像素后,按照給定的正方形尺寸選擇一個鄰域,將這個鄰域沿著同一行與另一幅圖像中的一系列鄰域相比較,據此找到最佳的匹配。

鄰域的比較方法如下面的公式所示:

(1)

其中,dmin和dmax是最小和最大視差;m是模板尺寸;Ileft和Iright是右面的圖像和左面的圖像;x和y是圖像平面的坐標。

3.2 深度確定

建立圖像間的特征匹配后即可根據相機的結構參數通過計算恢復目標場景的三維信息。

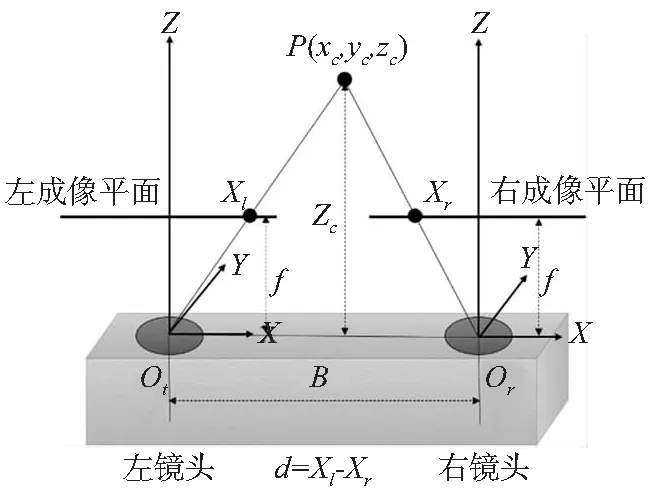

本系統采用的雙目立體相機兩鏡頭光軸沿Z向平行,焦距相同,可以完成立體視覺空間測量的任務。如圖5所示,設兩鏡頭在同一時刻觀看空間物體的同一特征點P(xc,yc,zc),分別在左、右鏡頭上獲取了點P的圖像,其圖像坐標分別為pl=(Xl,Yl),pr=(Xr,Yr)。現兩攝像機的圖像在同一個平面上,則特征點P的圖像坐標Y坐標相同,即Yl=Yr=Y,則由三角幾何關系可得:

(2)

圖5 雙目立體視覺示意圖

其中,d=Xl-Xr,為視差;f為相機焦距;B為基線距。

設圖像坐標u=Xl,v=Y,由式(2)可得空間點的三維坐標計算公式:

(3)

確定兩圖像平面所有的匹配點并進行相關計算,即可得到整副圖像各個匹配點的三維信息,恢復場景3D信息并保存成深度圖像。

3.3 ROI提取

對預處理后的圖像提取目標所在的區域,去除背景和平臺邊緣所在部分,可以專注和簡化工作過程,有效減少后續特征提取的工作量,提高圖像處理的實時性。本文采用表示矩形區域的Rect,通過指定矩形的左上角坐標和矩形的長寬定義一個矩形區域——即ROI。實際操作時,可根據對象對ROI區域范圍進行調整。

3.4 圖像預處理

由于實驗室環境特殊性,機器人所在區域受外界自然光照影響較大,即便使用了合適的光源,原始圖像也不適合直接進行特征處理操作,因此,本文采用的預處理算法可根據當前的光照環境對圖像各參數進行調整,使目標特征更加易于提取,將原始圖像變成適合計算機進行特征提取的形式。系統以ROI圖像為輸入,基于像素處理,圖像先后經過雙邊濾波降噪、直方圖均衡化、亮度和對比度調節等處理,得到易于特征提取的圖像。

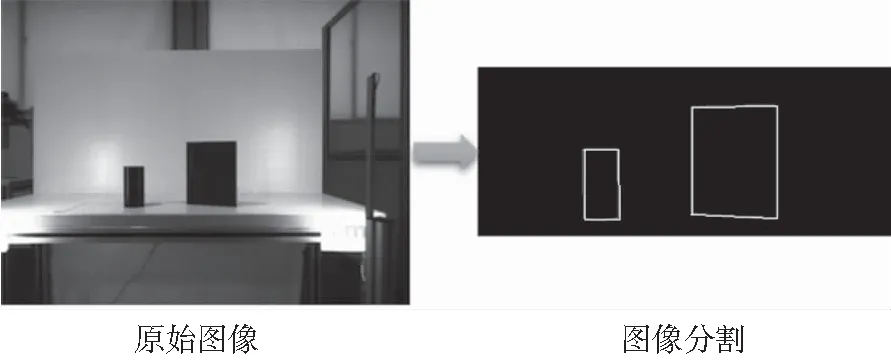

3.5 圖像分割

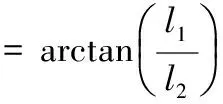

圖像分割就是把圖像分成若干個特定的、具有獨特性質的區域,并提取出需求目標的技術。本文首先使用Canny邊緣檢測[12]提取出圖像中物體的邊緣特征,再通過腐蝕膨脹處理得到精確的閉合輪廓。由于抓取對象的形狀和大小已知,因此通過設置相關參數,可以將任務規定機器人要抓取的對象從工作區域的其他非抓取目標中分割出來,實現目標的識別,由閉合輪廓的數量可以實現目標的數量識別。圖像分割效果如圖6所示。

圖6 圖像分割的效果

3.6 特征計算

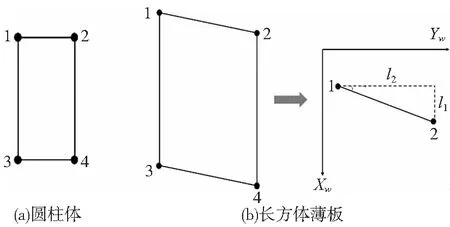

獲取目標在三維空間的精確位姿是實現機器人準確抓取的關鍵。本文以圓柱體和長方體薄板兩種類型工件作為例進行分析。經過圖像分割獲取對象的閉合輪廓后,基于兩種類型對象的尺寸特征進行分類,進而根據對象的幾何特征計算其位姿。如圖7所示,對于圓柱體工件,由于旋轉體不存在姿態信息,只需得到其中心點的位置信息。根據圖像分割得到的矩形輪廓的頂點信息,取四個頂點坐標的平均值即可得到圓柱體工件的中心坐標。

(4)

圖7 目標輪廓示意圖

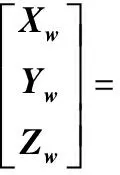

對于長方體薄板,由于放置角度的不同,其質心計算公式與圓柱體相同,從ZW負方向看過去薄板的邊與YW軸正向的夾角為α其計算方法如下(α角以YW軸正向轉向XW軸正向為正):

(5)

(6)

如圖8所示,通過特征計算實現對圓柱體和長方體薄板工件的分類的位姿信息的獲取。

圖8 視覺識別定位結果

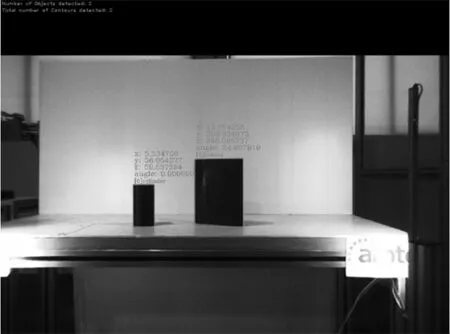

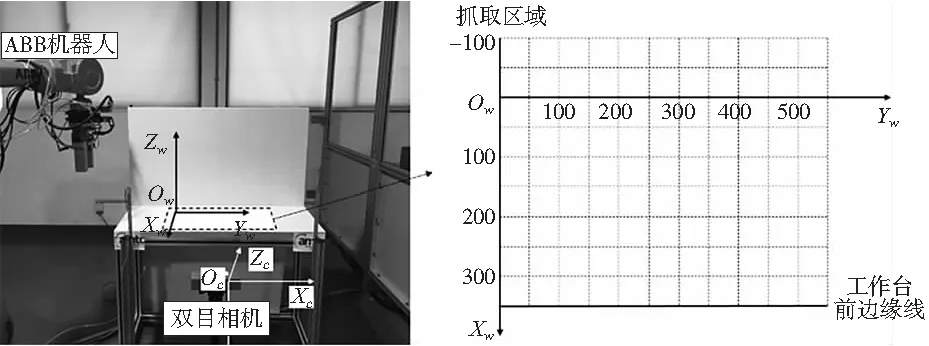

3.7 坐標轉換

在本文系統相機固定方式采用eye to hand系統[13]。如圖9所示,首先在ABB機器人系統中,以物料工作臺為參考面建立工件坐標系wobj_user,其中XW-YW平面與桌面平行,ZW垂直于桌面正方向朝上;以快換系統法蘭盤中心點為TCP點建立工具坐標系tool_sws。建立坐標系操作通過示教控制器實現。ABB機器人的運動路徑控制可以通過描述工具坐標系的TCP點在工件坐標系中的位置實現,因而坐標轉換需要標定工件坐標系wobj_user與相機坐標系的轉換關系,即轉換矩陣HFZ(〗WTBX〗wc。

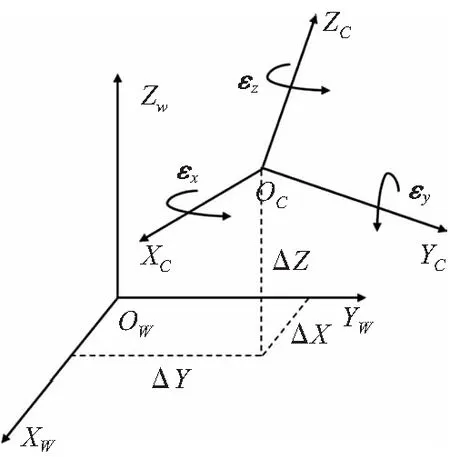

圖9 系統坐標系示意圖

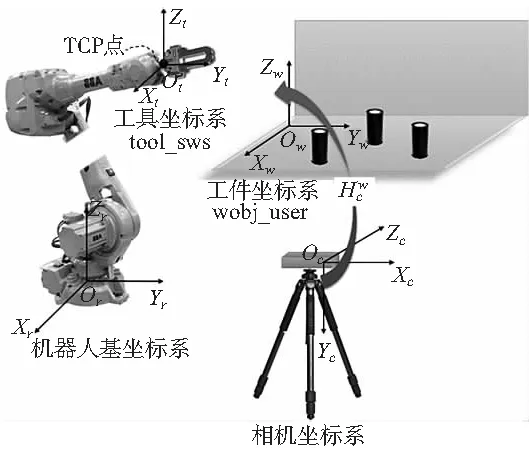

如圖9所示,兩個空間坐標系為工件坐標系OW-XWYWZW和攝像機坐標系OC-XCYCZC,兩坐標系間存在三個平移參數△X、△Y、△Z和三個旋轉參數εx、εy、εz。同一點在兩個坐標系中的坐標分別是(XW,YW,ZW),和(XC,YC,ZC)。兩坐標系可通過坐標軸的平移和旋轉變換成為一致,坐標間的轉換關系為:

(7)

圖10 坐標轉換示意圖

其中,λ為兩坐標系間的比例因子,稱R為旋轉矩陣,與三個旋轉參數有關,可以化為一個3×3矩陣(獨立參數只有3個),T為平移矩陣。

本文采用基于羅德里格矩陣的坐標轉換方法[14],通過采集四套公共點坐標,即可求得現有硬件布局下的坐標轉換關系。

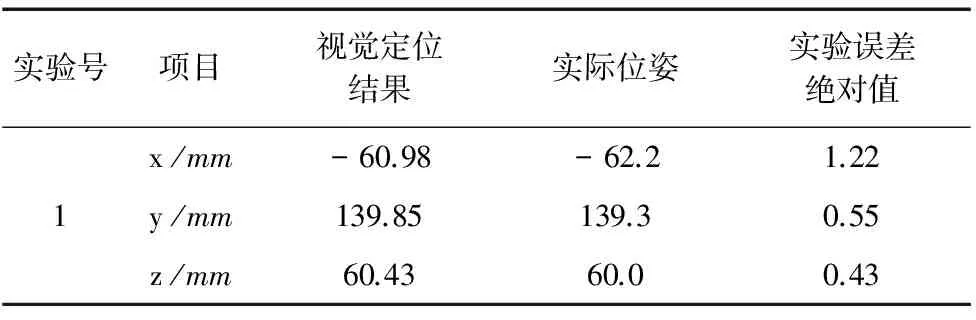

4 實驗

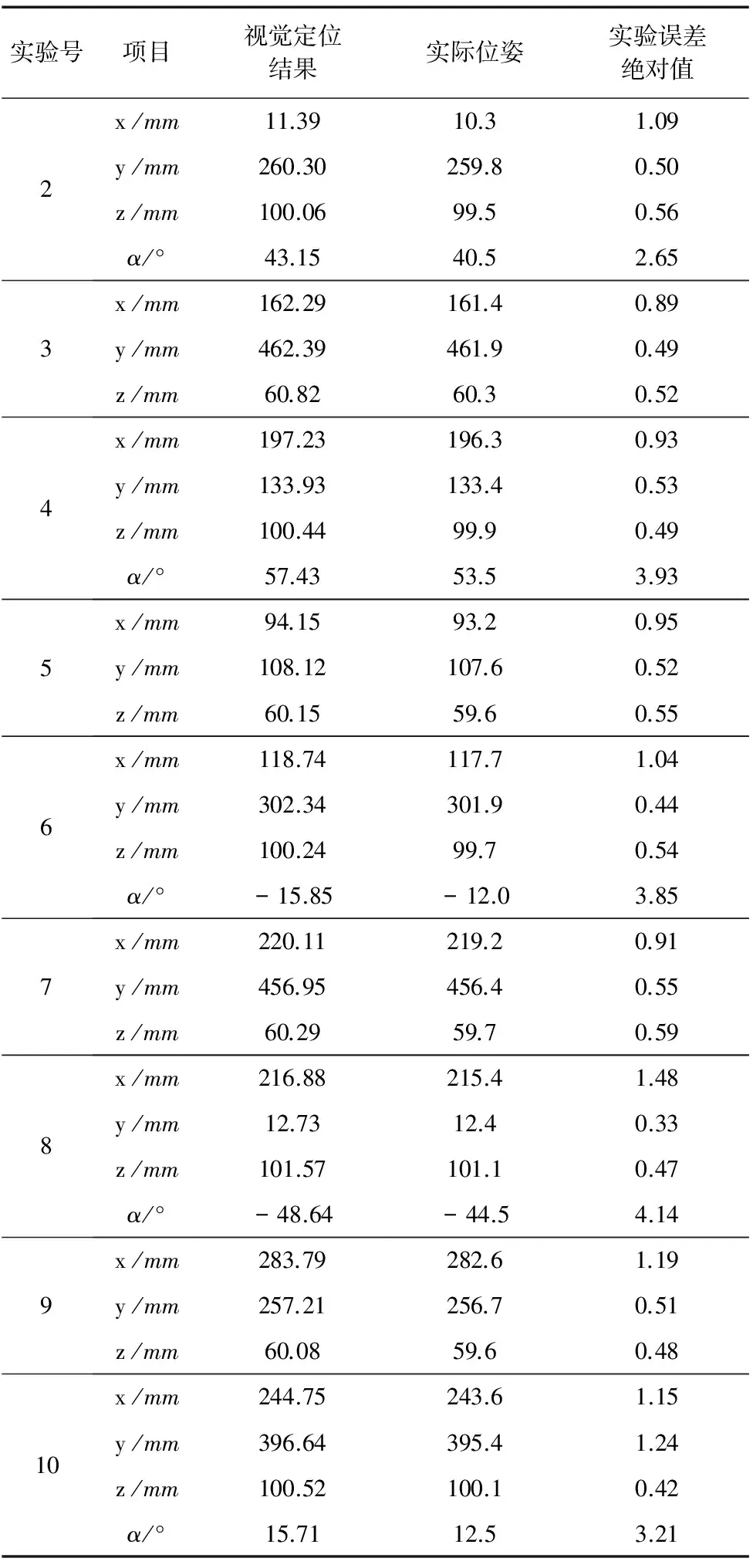

如圖11所示,完成硬件設備連接,將雙目相機固定好。將圓柱體和長方體薄板工件隨機擺放在抓取區域不同位置,啟動視覺程序,如圖8所示,程序可準確識別工件種類。并且得到10組視覺定位數據,視覺定位結果取小數點后兩位記錄,如表1所示,其中奇數組為圓柱體工件,偶數組為長方體薄板工件。

圖11 視覺實驗布局

實驗號項目視覺定位結果實際位姿實驗誤差絕對值1x/mmy/mmz/mm-60.98139.8560.43-62.2139.360.01.220.550.43

續表

實驗號項目視覺定位結果實際位姿實驗誤差絕對值2x/mmy/mmz/mmα/°11.39260.30100.0643.1510.3259.899.540.51.090.500.562.653x/mmy/mmz/mm162.29462.3960.82161.4461.960.30.890.490.524x/mmy/mmz/mmα/°197.23133.93100.4457.43196.3133.499.953.50.930.530.493.935x/mmy/mmz/mm94.15108.1260.1593.2107.659.60.950.520.556x/mmy/mmz/mmα/°118.74302.34100.24-15.85117.7301.999.7-12.01.040.440.543.857x/mmy/mmz/mm220.11456.9560.29219.2456.459.70.910.550.598x/mmy/mmz/mmα/°216.8812.73101.57-48.64215.412.4101.1-44.51.480.330.474.149x/mmy/mmz/mm283.79257.2160.08282.6256.759.61.190.510.4810x/mmy/mmz/mmα/°244.75396.64100.5215.71243.6395.4100.112.51.151.240.423.21

由實驗結果可知,在實驗區域內,工件坐標系x方向即相機深度x方向誤差在1.5mm以內,y和z方向誤差在0.6mm以內,長方體薄板的擺放角度誤差在5°以內,精度較高,滿足智能抓取系統對位置精度的定位要求。相對于現有制造工業中應用較廣泛的單目相機,往往固定在物體正上方特定高度,深度信息固定,本系統采用的雙目相機可以獲取深度隨機的目標的三維信息,并且可以得到較高的定位精度。

5 結束語

本文搭建了一個視覺識別平臺,結合立體視覺技術,實現對圓柱體和長方體薄板的識別和位姿信息提取。基于視覺程序的模塊流程化結構,能實現不同環境、不同對象條件下視覺算法的快速更新;同時,視覺處理流程清晰,通用性好,具有較高的定位精度。另一方面,視覺模塊的控制和機器人的運動控制獨立開,由上位機集成控制,便于視覺模塊的移植和開發。由此可見,視覺技術的引入有效提高了機器人的靈活性和適應性,以及抓取作業的穩定性、快速性和準確性。

[1] 金桂根, 穆建軍. 視覺識別機器人在物流作業中的智能應用[J]. 制造業自動化, 2013(11):103-105.

[3]BatchelorBG,Maschine.MachineVisionHandbook, 3Vols.[M].Berlin:Springer, 2010.

[4] 游素亞. 立體視覺研究的現狀與進展[J]. 中國圖象圖形學報, 1997,2(1):17-24.

[5]XuL,HeX,LiX,etal.Amachine-visioninspectionsystemforconveyingattitudesofcolumnarobjectsinpackingprocesses[J].Measurement, 2016, 87: 255-273.

[6]TsarouchiP,MichalosG,MakrisS,etal.VisionSystemforRoboticHandlingofRandomlyPlacedObjects[J].ProcediaCirp, 2013, 9(4):61-66.

[7] 翟敬梅, 董鵬飛, 張鐵. 基于視覺引導的工業機器人定位抓取系統設計[J]. 機械設計與研究, 2014,30(5):45-49.

[8] 晏祖根, 李明, 徐克非,等. 高速機器人分揀系統機器視覺技術的研究[J]. 包裝與食品機械, 2014,32(1):28-31.

[9]YangY,GaoM,ZhangJ,etal.Depthmapsuper-resolutionusingstereo-vision-assistedmodel[J].Neurocomputing, 2015, 149:1396-1406.

[10]GordonI,LoweDG.WhatandWhere: 3DObjectRecog-nitionwithAccuratePose[C]//TowardCategory-LevelObjectRecognition,2006:67-82.

[11]ComlekcilerIT,GunesS,IrginC,etal.Measuringtheoptimumluxvalueformoreaccuratemeasure-mentofstereovisionsystemsinoperatingroomofOrthognathicsurgery[C]//Electronics,ComputerandComputation, 2014:1-6.

[12]CannyJ.AComputationalApproachtoEdgeDetection[J].PatternAnalysis&MachineIntelligenceIEEETransactionson, 1986,PAMI-8(6):679-698.

[13]FlandinG,ChaumetteF,MarchandE.Eye-in-hand/eye-to-handcooperationforvisualservo-ing[J].IEEEInt.conf.onRobotics&Automation, 2000, 3: 2741-2746.

[14]YuanYL,JiangLX,LiuLJ.ApplicationsofLodriguesmatrixincoordinatestransformation[J].ScienceofSurveying&Mapping, 2010, 35(2): 178-177.

(編輯 李秀敏)

Development of Intelligent Robot Grasping System Based on Machine Vision

YE Hui1a, ZHANG Wei-min1a,1b, ZHANG Huan1a, Jürgen Fleischer1c,2

(1 a.School of Mechanical Engineering, b.Chinese-German College for Postgraduate Studies, c.Advanced Manufacturing Technology Center, Tongji University, Shanghai 201804, China;2. Institute of Production Science, Karlsruhe Institute of Technology, Karlsruhe 76131, Germany)

With ABB industrial robot, quick-change gripper, and binocular Camera being as hardware foundation, this paper develops an intelligent industrial robot grasping system based on binocular stereo vision,aiming at the recognition, location and automatic grasping of randomly placed objects. Based on the vision module, the principles of camera calibration, coordinate transformation, image processing and stereo matching are researched, and based on C++, visual recognition and location algorithm is developed combined with OpenCV library and Triclops SDK, and the vision module can realize objects classification and pose recognition of cylinder and rectangular plate. Finally experiments are carried out to validate that the vision module can recognize cylindrical and rectangular plate objects successfully, and the positioning accuracy can meet the requirements.

industrial robot;machine vision;intelligent grasping; stereo matching;coordinate transformation

1001-2265(2016)12-0001-05

10.13462/j.cnki.mmtamt.2016.12.001

2016-07-20;

2016-08-22

“高檔數控機床與基礎制造裝備”科技重大專項(2012ZX04005031)

葉卉(1992—),女,安徽蕪湖人,同濟大學碩士研究生,研究方向為機器人視覺,(E-mail)1432527@tongji.edu.cn。

TH166;TG659

A