一種基于置信度的深度圖融合方法

董鵬飛

(四川大學計算機學院,成都 610065)

一種基于置信度的深度圖融合方法

董鵬飛

(四川大學計算機學院,成都 610065)

在三維重建過程中,由于受到噪聲影響,計算出的深度圖精度無法保證。針對此問題,提出一種基于置信度的抗噪融合方法。首先對每幅深度圖來進行修正,并利用一致性原理來剔除錯誤點并填補某些空洞。然后通過保留在自身鄰域內具有最高置信度的三維點,以刪除冗余。最后將深度圖反投影到三維空間,采用迭代最小二乘法優化三維點并剔除離群點。通過在測試數據集上與其他算法比較,驗證此方法的有效性。

多目立體視覺;三維重建;深度圖融合

0 引言

多視角三維重建的目的是從多幅二維圖像當中恢復目標場景的3D模型,是計算機視覺領域中重要的研究課題之一,并且在最近幾年也受到了越來越多的關注。根據Seitz等人的研究[1],現有的多視角三維重建算法可以分為四類:基于特征點擴展的方法[2],該方法首先提取和匹配一系列特征點重建出較稀疏的點云,然后將稀疏點云向周圍擴展得到稠密的點云;基于體素的方法[3],該方法在一個三維立體中計算出代價函數,并且從這些立體中提取出目標物體表面;基于表面演化的方法[4],該方法通過最小化能量方程來迭代估計出目標物體表面;基于深度圖融合的方法[5-6],該方法首先計算出每幅圖像的深度圖,然后通過融合這些深度圖來獲取最終的三維模型。在所有的算法中,基于深度圖融合算法具有較高的精確度和靈活性,更適用于絕大多數場景的重建[1,5]。

一般來說,基于深度圖融合的三維重建方法可以分為兩個步驟:①計算每幅圖像所對應的深度圖。②將這些深度圖融合成為一個三維模型。目前,已有許多研究者在深度圖計算方面做出了杰出的工作。Goesele等人利用了基于窗口的投票方法,但是這種方法只能得到匹配度較高的像素對[7]。Bradley等人通過尺度可變的窗口來增加匹配的像素對,從而使深度計算更加準確[8]。Shuhan Shen等人提出了一種有效的基于塊的匹配算法,得到每幅圖像的深度圖[5]。

本文提出了一種基于置信度的深度圖融合方法,能夠比較準確地融合那些被噪聲干擾的深度圖像。在此算法中,本文將圖像序列和它們所對應的深度圖像與攝像機參數作為輸入,將具有法向量的稠密三維點云作為輸出。此算法總共可以分為三個步驟:①修正深度圖。②刪除冗余。③深度圖融合。

1 算法描述

在算法開始階段,本文首先采用Seitz提供的Bundler[9]對原圖像作標定,目的是獲取對應的攝像機的內外參數。然后,利用這些參數信息,采用PM框架計算出所有圖像對應的深度圖[10]。

1.1 深度圖修正

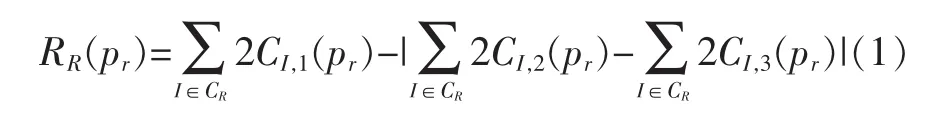

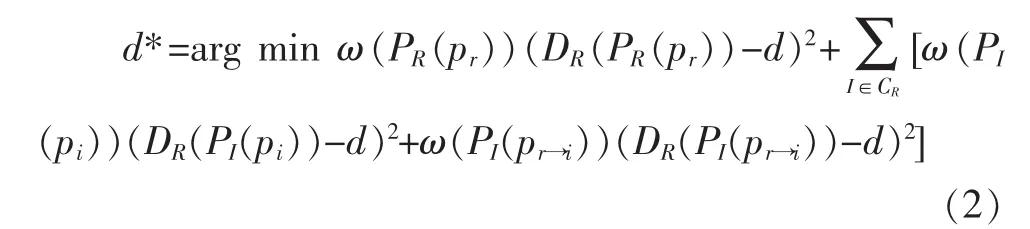

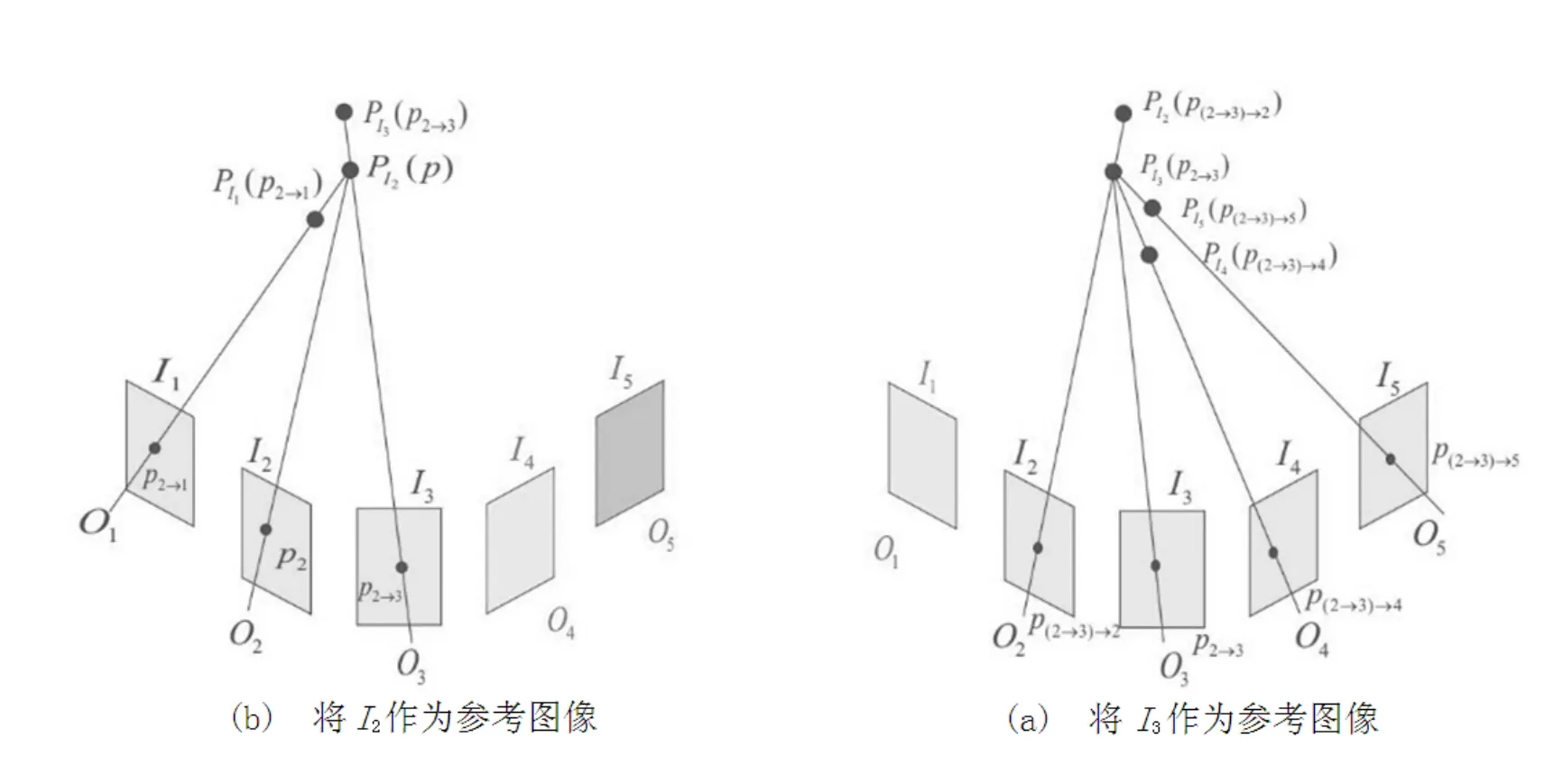

由于基于PM框架的深度圖計算是以一副圖像為參考圖像進行深度估計,這也就是說每幅深度圖的計算是無法并行,這就會導致一個問題,就是同一場景在不同深度圖中不匹配。因此,本算法需要對已計算的深度圖進行再次修正。給定圖像R中的某個像素位置pr,能夠得到三個與之有關系的三維點PI(pi),PR(pr),PI(pr→i),并且獲得這三個點相對于圖像R的深度DR(PR(pr)),DR(PI(pi)),DR(PI(pr→i))。根據實際情況來看,如果有兩幅圖像可以觀察到同一個點,這也就是說,當DR(PI(pi))和DR(PR(pr))的相對差充分小的情況下,并且DI(PI(pr→i))和DI(PR(pr))的相對差也充分小,那么本文便可判定在pr處圖像R和圖像I是相互連續的。本文利用[11]和[12]中提供的方法定義圖像R在pr處的一致性比率RR(pr),如公式(1)。

由于低一致性比率也表示估計的深度值有較大可能是不準確的,因此,在算法開始之前先丟掉一致性比率較小的深度值。然后,利用公式(2)得到d*來更新原來的深度值。

其中,權重的定義如[11]中所示。

1.2 刪除冗余

在將所有深度圖融合為一個單一的3D模型之前,需要對所有深度圖進行冗余信息剔除。為此,本文提出了一種新算法來實現這個目的。

該方法首先利用深度圖將原始圖像中每個像素點反投影到三維空間中,然后對每個三維點賦予一個置信度。本文綜合考慮了三個影響因素來定義置信度:①匹配誤差。判斷三維點估計地是否準確最直觀的辦法就是計算深度時的匹配誤差,估計地越精確,誤差就會越小。②場景離攝像機中心的距離。因為對于較近的場景,拍攝的圖像可以保留較完整的細節信息,重建的三維點也就越準確。③攝像機基軸和場景視角的夾角、場景表面法向量與場景視角的夾角。當夾角越接近于零,估計的深度值就會越準確。

對于每個三維點,綜合考慮以上三個因素,最終獲得對應的的置信度。之后,本文在互為冗余的點集中,選擇出具有最大置信度的點作為最終點。另外,為了減少選擇的誤差,若在前一輪中已經選出了某點作為最終點,那么在接下來的選擇中便不再刪除此點。具體過程如圖1所示。

考慮新型拓撲結構的統一潮流控制器五端功率注入模型//吳熙,殷天然,祁萬春,蔡暉,蔣平,陳琛//(19):155

1.3 深度圖融合

在以上的處理過程中,本文只是從局部考慮,每次只對一幅深度圖進行處理,這樣的過程將會導致不可能刪除所有的冗余點和離群點。那么本文將從全局出發對三維模型進行二次優化,提高重建結果的精度。

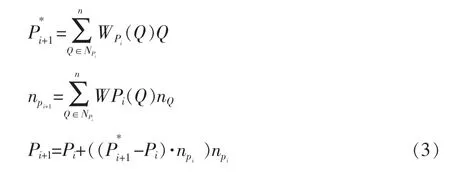

本文首先利用深度圖,將所有圖像的所有像素點反投影到三維空間中去,獲得一個初始點云。為了加快刪除冗余信息的速度提高算法的效率,本文首先對初始點云進行重新采樣,減少初始點云中點的個數。之后,本文利用類似[12]的方法從全局考慮對點云進行整體優化。優化過程如下:對點云中任意一點P,假設法向量為nP,P的鄰域內所有三維點所組成的集合為NP。利用公式(3)對其進行迭代優化,在迭代開始階段,假設初始值P0=P,如果算法在不超過最大迭代次數k時就可以收斂到NP范圍內,就用迭代優化之后的三維點代替原來的三維點,否則便將此點作為離群點,進行刪除。

圖1 刪除冗余信息的過程

其中,權重的定義由[12]給出。

2 實驗結果與分析

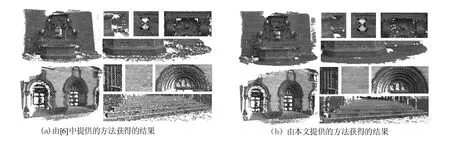

圖2 [6]中方法和本文方法進行比較的結果。

本文實驗使用了C.Strecha提供的標準數據集Fountain和Herziesu[14]。為了證明本文算法與其他算法相比,具有更好的性能和更高的準確性,本文首先將與[6]中方法在上述數據集上進行定性地比較,比較結果如圖2所示,圖(a)中的點云是[6]中方法獲得的,圖(b)中的點云是本文方法獲得的。在每幅子圖中,左邊對應的是場景對應的完整三維點云,為了更好地區分兩種算法的結果,本文將完整點云在某些局部區域進行放大,對應于圖像的右邊。由圖可以看到,本文方法獲得的三維點云具有更高的準確性和完整度。

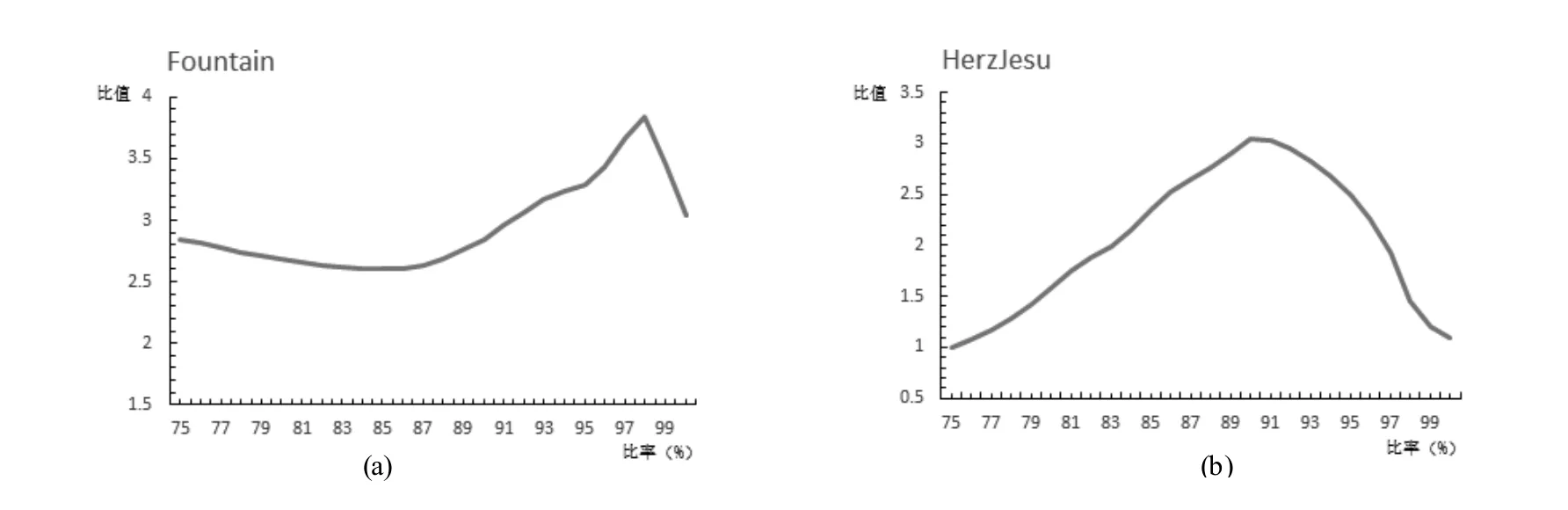

另外,本文認為定性的比較結果無法充分地說明此算法的性能。因此,本文又對這兩種方法進行定量地比較,首先,利用開源工具對點云進行處理,得到估計的點云與實際之間的誤差。最后可畫出兩種算法的誤差比值可視圖像,如圖3所示。在圖中我們可以看到,兩者的比值始終大于1,甚至可以超過3。也就是說這,本文方法重建的結果更加精確可信。

通過以上定性和定量的比較,我們可以看到由本文提出的基于置信度的深度圖融合算法可以較好地融合被噪聲干擾的深度圖。

圖3 方法[6]與本文方法的比較結果

參考文獻:

[1]Seitz S M,Curless B,Diebel J,et al.A Comparison and Evaluation of Multiview Stereo Reconstruction Algorithms[C].Proceedings of 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.New York:IEEE Press,2006,1:519-528.

[2]Furukawa Y,Ponce J.Accurate,Dense,Robust Multiview Stereopsis[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,32(8):1362-1376.

[3]George V,Carlos H E,Torr P H S,et al.Multiview Stereo Via Volumetric Graph-Cuts and Occlusion Robust Photo-Consistency[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2007,29(12):2241-2246.

[4]Cremers D,Kolev K.Multiview Stereo and Silhouette Consistency Via Convex Functionals Over Convex Domains[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2011,33(6):1161-1174.

[5]Shen Shuhan.Accurate Multiple View 3D Reconstruction Using Patch-Based Stereo for Large-Scale Scenes[J].IEEE Transactions on Image Processing,2013,22(5):1901-1914.

[6]劉怡光,易守林,吳鵬飛等.一種新的大場景三維重建算法[J].四川大學學報(工程科學版),2015,47(6):91-96.

[7]Goesele M,Curless B,Seitz S M.Multi-View Stereo Revisited[J].Proceedings of 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.New York:IEEE Press,2006,2(2):2402-2409.

[8]Bradley D,Boubekeur T,Heidrich W.Accurate Multi-View Reconstruction Using Robust Binocular Stereo and Surface Meshing[C]. Proceedings of 2008 IEEE Conference on Computer Vision and Pattern Recognition.Anchorage:IEEE,2008:1-8.

[9]Snavely N,Seitz S M,Szeliski R.Photo Tourism:Exploring Photo Collections in 3D[J].ACM Transactions on Graphics(TOG),2006,25(3)

[10]Bleyer M,Rhemann C,Rother C.PatchMatch Stereo-Stereo Matching with Slanted Support Windows[C].Proceedings of the British Machine Vision Conference.Dundee:BMVA Press,2011,11:1-11.

[11]Wei J,Resch B,Lensch H P A.Multi-view Depth Map Estimation with Cross-View Consistency[C].Proceedings of the British Machine Vision Conference.Nottingham:BMVA Press,September 2014.

[12]Bailer C,Finckh M,Lensch H.Scale Robust Multi View Stereo[C].Proceedings of the 12th European Conference on Computer Vision.Volume Part III.Springer-Verlag,2012:398-411.

[13]Strecha C,von Hansen W,Van Gool L,et al.On Benchmarking Camera Calibration and Multi-View Stereo for High Resolution Imagery[C].Proceedings of 2008 IEEE Conference on Computer Vision and Pattern Recognition.Anchorage:IEEE,2008:1-8.

Fusion of Depth Maps with Confidence of Points

DONG Peng-fei

(College of Computer Science,Sichuan University,Chengdu 610065)

In the process of 3D reconstruction,due to the influence of noise,the calculation precision of depth cannot be guaranteed.Introduces an antinoise fusion method that takes advantage of the confidence of 3D points.This method first performs a refinement process on every depth map to enforce consistency over its neighbors,which can remove most errors and fill many holes simultaneously.After refinement,it deletes redundancies of every point by retaining the point that its confidence is maximal in its neighbors.Finally,it obtains a point cloud by merging all depth maps and uses an iterative least square algorithm to further eliminate the noise points.The quality performance of the proposed method is evaluated on several data sets and the comparison with other algorithm.

Multiple View Stereo;3D Reconstruction;Fusion of Depth Maps

1007-1423(2016)35-0066-04

10.3969/j.issn.1007-1423.2016.35.014

董鵬飛(1992-),男,河南洛陽人,碩士,研究方向為計算機視覺、三維重建

2016-11-18

2016-12-05