計算語義合成性綜述

王超超,熊德意

(蘇州大學 計算機科學與技術學院,江蘇 蘇州 215006)

計算語義合成性綜述

王超超,熊德意

(蘇州大學 計算機科學與技術學院,江蘇 蘇州 215006)

隨著自然語言處理技術的飛速發(fā)展,單純在語法層上的研究已經(jīng)不能解決目前的問題,語義層的研究逐漸成為熱點。計算語義合成性作為語義學的關鍵部分,受到了諸多研究人員的關注。計算語義合成性的研究方法可以分為兩大類: 語言學方法和分布式方法。該文詳細介紹了它們各自具有代表性的工作,著重闡述了近年來使用廣泛的深度學習方法在計算語義合成性研究中的應用,并對這兩種方法進行了比較;然后對計算語義合成性在情感分析以及機器翻譯中的應用做了細致分析;最后,展望了計算語義合成性未來的研究趨勢。

語義合成;自然語言處理;分布式方法;深度學習

1 引言

自然語言在語言學上一般被劃分為四個層次: 語音文字層、語法層、語義層和語用層[1],目前對于前兩層的研究相對比較成熟,越來越多的研究人員開始聚焦于語義層的研究。計算語義合成性作為語義層研究的重要組成部分,可以利用單詞的語義信息合成短語乃至句子的語義信息,從而進一步擴大語義信息的表示范圍。因此,近年來計算語義合成性在人工智能、自然語言處理的諸多領域得到了廣泛的應用[2]。

計算語義合成性是一個古老的概念,最早可以追溯到柏拉圖,他在一次對話中指出: 一句話由名詞和動詞組成,如果動詞能夠表示名詞當前正在執(zhí)行的動作,則這句話是正確的[3]。換句話說,柏拉圖闡述了語義合成性的一般原則,即每句話都具有一定的結構;每句話中的各個部分都具有不同的功能;這句話的意思由它的各組成部分的意思所決定。

1892年,德國著名哲學家、邏輯學家Frege[4]正式提出了計算語義合成性的概念: 合成表達的語義由它的各組成部分的語義以及連接它們的規(guī)則所共同決定。它是形式語義學的一個基本原則,也是允許語言使用者們理解他們從未聽過的短語和句子語義的一個基本原則。形式語義學以數(shù)學為工具,利用符號和公式精確定義和解釋語言的語義,強調語義解釋和句法結構的統(tǒng)一。1995年,Partee等人[5]進一步闡述了計算語義合成性的概念: 整體語義是部分語義通過函數(shù)運算并按一定的語法規(guī)則組合在一起而得到的語義表示。因此,目前計算語義合成性的工作主要集中于發(fā)現(xiàn)更好的單詞表示以及更好的合成規(guī)則這兩個方面。了解單詞的語義以及各個單詞之間的連接規(guī)則,人類可以很容易識別句子的語義和創(chuàng)造新的句子,但是對于計算機這仍然是一件非常具有挑戰(zhàn)性的工作。

縱觀國內外研究人員關于計算語義合成性的研究現(xiàn)狀,根據(jù)所處階段的不同以及單詞表示方法的不同,我們將計算語義合成性的研究方法分為以下兩大類[6-7]。

(1) 語言學方法: 采用語言學方法進行計算語義合成性的研究主要起源于Montague等[8]的工作,包括諸如λ演算等符號邏輯表示的方法[9]。這些語言學方法在語義學研究中發(fā)揮了重要的作用,它們將語言學的研究方法與計算語義合成性的原則有機結合,使得我們可以用組合的方法分析語法與語義之間的對應關系。但是采用語言學方法僅能簡單表示已知子表達式利用合成規(guī)則所得到的合成表達式正確與否,并不能明確表示單詞、短語以及句子的語義信息,同時也不能對結果進行定量分析[2]。

(2) 分布式方法: 近年來有關計算語義合成性的研究多基于分布式方法[10]。分布式方法在單詞表示、識別單詞之間的語義相關性以及處理合成性等方面取得了顯著進步,有效克服了采用語言學方法進行語義合成性研究時所出現(xiàn)的表達能力弱、不便于計算等問題。

對比發(fā)現(xiàn),分布式方法比語言學方法在計算語言合成性的研究中有更具體的單詞表示,且采用了更簡單的合成運算方法[4]。使用分布式方法獲取到的短語和句子的語義信息,可以更方便地應用于情感分析以及統(tǒng)計機器翻譯等諸多自然語言處理的任務中。

本文第二章詳細介紹了語言學方法在計算語義合成性研究中的應用,第三章詳細介紹了分布式方法在計算語義合成性研究中的應用,第四章比較了計算語義合成性研究中的語言學方法與分布式方法,第五章舉例闡述了近年來計算語義合成性在情感分析以及統(tǒng)計機器翻譯領域的應用。最后總結了計算語義合成性的研究現(xiàn)狀并展望了未來的研究方向。

2 語言學方法

根據(jù)Montague等[8]所提出的方法,使用語言學方法進行計算語義合成性研究必須具備以下兩個先決條件: 擁有能夠提供單詞與邏輯表達形式相對應的邏輯詞典;能夠提供正確的語義合成規(guī)則。針對第二點,Bach等[11]提出了一種規(guī)則到規(guī)則的假設,即在語法和語義之間存在著一種映射關系,可以利用語法層的合成運算來近似表示語義層的合成運算。

λ演算最早由Church等提出用來研究函數(shù)定義、函數(shù)應用和遞歸的形式系統(tǒng)[12]。在確定語法規(guī)則的基礎上,使用λ演算能有效進行語法層的合成運算,因此根據(jù)Bach等提出的規(guī)則到規(guī)則的假設,可以將λ演算應用于語義層的合成運算。以文獻[2]所舉的實例為例,假如要得到“Every car runs”的合成語義表示,首先從邏輯詞典中獲取每個單詞的語法類型和邏輯表示形式即λ表達式,如式(1)所示。

a.everyDet:λP.λQ.?x[P(x)→Q(x)]

b.carN:λy.car(y)

(1)

c.runsVerb:λz.runs(z)

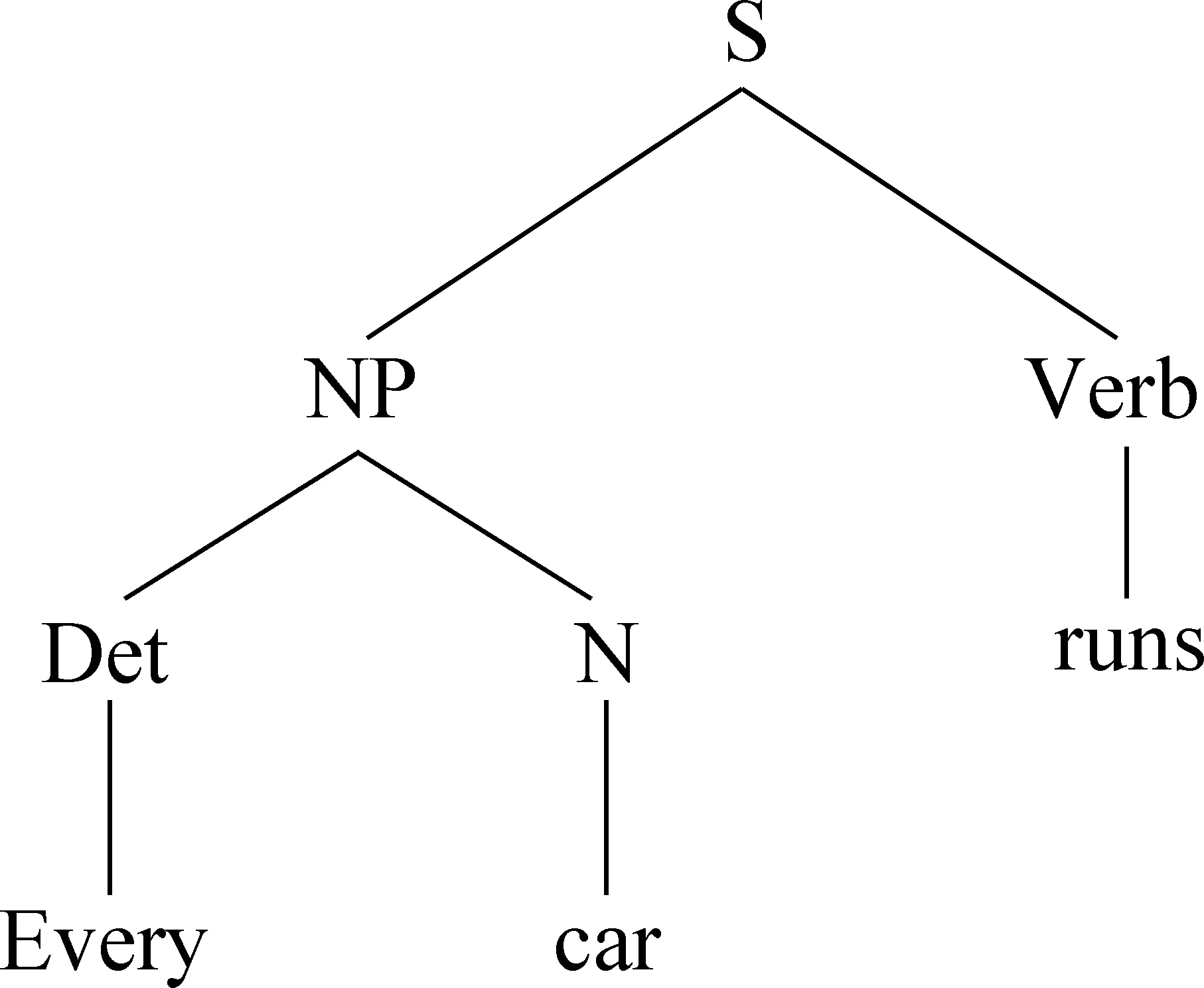

其中,邏輯詞典為存取所有單詞語義信息的邏輯形式的集合,λ表達式為用λ運算符約束每一個變量的數(shù)學式。(1a)表示一個限定詞的語義邏輯表示形式,λP、λQ起到了占位符的作用,并不表示具體值,這些未知的變量可以用一組實體詞替換;(1b)表示一個實體名詞的語義邏輯表示形式,y為它的一個特征,通過后續(xù)語法基礎上的進一步處理可以對它進一步量化,例如y可取為ford,則該表達式表示ford類的car;(1c)表示一個不及物動詞的語義邏輯表示形式,z為它的一個特征,假設z也取為ford,而ford確實有runs的屬性,則runs(ford)的語義是正確的。在單詞邏輯表示的基礎上,依據(jù)語法規(guī)則生成如圖1所示帶有詞性特征的簡單語法樹。

圖1 “Every car runs.”的簡單語法樹

從圖1所生成的語法樹中可以獲取兩個簡單的合成運算形式,合成運算(1):Det+N→NP,由限定詞與名詞合成一個名詞短語,其具體的計算過程如式(2)所示。通過使用β-歸約獲取名詞短語的語義邏輯表示形式,所謂β-歸約名用一個簡單的邏輯表達式替換較復雜邏輯表達式中的變量,最終得到它們合成表示的更簡單的邏輯表示形式。首先用(1b)替換(1a)中的變量p,再用x替換(1b)中的變量y,通過兩次β-歸約最終得到名詞短語的邏輯表示形式。

λP.λQ.?x[P(x)→Q(x)](λy.car(y))

→βλQ.?x[(λy.car(y))(x)→Q(x)]

P:=λy.car(y)

→βλQ.?x[car(x)→Q(x)]y:=x

(2)

合成運算(2):NP+Verb→S,由名詞短語與動詞合成一個句子,其具體的計算過程如式(3)所示,同樣使用多次β-歸約最終得到整句話的語義邏輯表示形式。

λQ.?x[car(x)→Q(x)](λz.runs(z))

→β?x[car(x)→(λz.runs(z))(x)]

(3)

Q:=λz.runs(z)

→β?x[car(x)→runs(x)]z:x

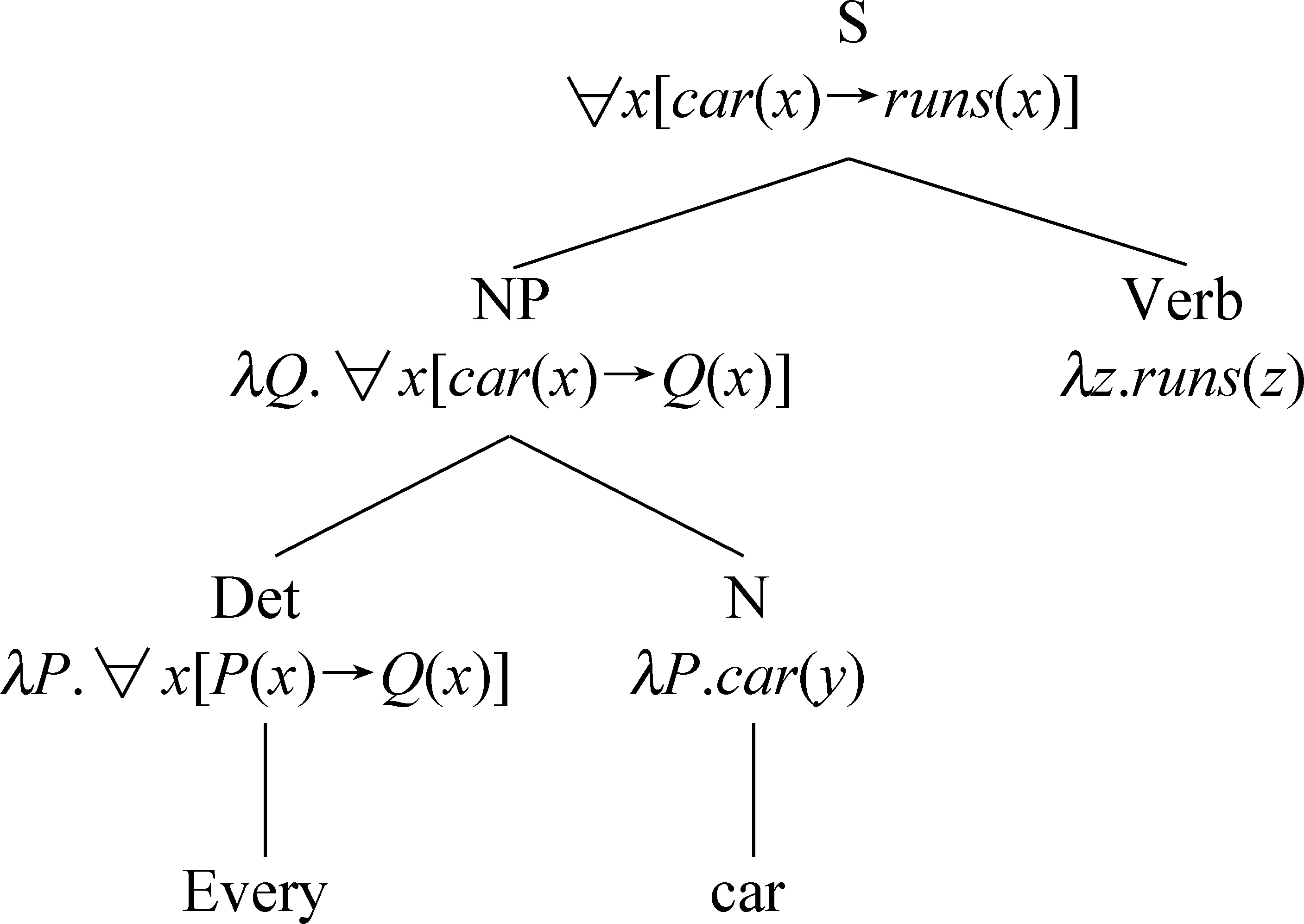

通過上述計算最終生成如圖2所示帶有語義特征的語法樹,從樹中可以獲取到“Every car runs”采用邏輯表達式表示的語義信息即為?x[car(x)→runs(x)]。

圖2 帶有語義特征的語法樹

3 分布式方法

在計算語義合成性研究中語言學方法的一個最大弊端是: 從詞典中獲取單詞的邏輯表示并不能表示單詞的具體含義,因此不能處理單詞語義相似度比較[13]、語義角色標注[14]等諸多問題。分布式方法使用向量表示單詞,每個單詞都具有特定的語義信息。在單詞向量表示的基礎上,參考文獻[2]提出了計算語義合成性分布式方法的分類體系,本節(jié)詳細介紹了三種目前常用的語義合成方法,即基于向量混合模型的方法、基于向量矩陣模型的方法和基于深度學習的方法。

3.1 基于向量混合模型的語義合成性

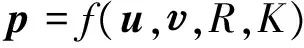

Mitchell等[15]基于分布式假設[16]提出利用向量混合模型來獲取短語和句子的向量表示,其具體的合成模型如式(4)所示。

(4)

其中,u和是兩個單詞的初始向量,R是這兩個單詞之間的語法關系,K是所需要的背景知識,即構造這兩個詞的合成表達的意思所需要的附加信息或知識。在同一個語料庫中,詞與詞之間、短語與短語之間以及句子與句子之間通常具有相同的R和K,因此上述合成模型進一步簡化為式(5)。

(5)

假如利用乘法和加法作為合成函數(shù),則可以得到向量乘法和帶權向量加法這兩種具體的計算方法:

(6)

(7)

其中帶權向量加法中的α和β是兩個可以調整的表示合成短語中每個單詞的重要程度的權值。向量混合模型是分布式方法中的最簡單的合成運算形式,利用向量混合模型方法得到的輸出向量可以看作是相關的輸入向量的元素的混合。向量混合模型方法十分簡單,在許多自然語言處理的任務,例如文獻檢索、論文評分以及一致性評估等諸多領域得到了廣泛的應用,同時它也是評價其他復雜模型計算語義合成性優(yōu)劣與否的基礎。

此外,Coecke等[17]將張量積引入到了向量混合模型中來。張量積是刻畫兩個不同維度向量之間乘積的函數(shù),對于兩個向量u和,它們的張量積可以通過式(8)計算得到:

(8)

其中,ci,cj分別為向量u和中每一維的值;ni和nj分別為向量u和的偏置向量。同時,在張量積的基礎上,Coecke等人又提出了將語法特性作為一個向量融入其中的合成運算方法。假設我們定義u為名詞,為動詞,則其計算過程如式(9)所示。

(9)

3.2 基于向量矩陣模型的語義合成性

基于向量混合模型的計算語義合成性在許多自然語言處理的任務中取得了良好的效果,但是它仍然不能解決語義合成的核心問題,即從語法層中最直接的淺層詞的語義獲取相應語義層的語義。于是,諸多研究人員在最初的向量混合模型基礎上提出了向量矩陣模型的方法,但是主要聚焦于某些特定短語,如動詞及其賓語的合成語義信息表示等。本節(jié)我們以Baroni等人[18]所提出的名詞與形容詞的語義合成運算為例,說明基于向量矩陣模型的語義合成性的相關問題。

Baroni等提出用向量表示名詞,而修飾該名詞的形容詞則看作是用矩陣表示的將名詞的語義信息映射到名詞短語或形容詞名詞短語語義空間的線性函數(shù)。Baroni等在語義合成一般框架的基礎上,提出形容詞名詞語義合成的計算公式如式(10)所示。

(10)

其中,p是合成的n維的向量,B是修飾名詞的形容詞矩陣,是存儲了名詞的語義信息的向量。

在實際的應用中通常使用某種監(jiān)督學習的方法來獲取各個權值矩陣的值,但是并不需要手工標記的數(shù)據(jù),只需要在語料庫中分別訓練出不同的形容詞模型,然后再根據(jù)具體的輸入向量對矩陣值做適當?shù)恼{整,從而確保輸入和輸出向量具有相同的維數(shù)。

采用上述向量矩陣模型處理計算語義合成性問題,比簡單的向量混合模型取得了更優(yōu)的結果,同時也避免了采用張量積時的繁瑣計算。但是目前向量矩陣模型仍然局限于動詞與名詞、形容詞與名詞的合成語義表示,并沒有應用到所有組成單詞的合成運算中。

3.3 基于深度學習的語義合成性

使用深度學習的方法來進行計算語義合成性的研究,是目前的趨勢之一。深度學習方法本質是一類機器學習的算法,最早在2006年由Hinton等人[19]提出,它的概念起源于人工神經(jīng)網(wǎng)絡的研究,通過組合低層特征形成更加抽象的高層表示屬性的類別或特征,以發(fā)現(xiàn)數(shù)據(jù)的分布式特征表示。使用深度學習的方法能夠捕獲任意語法類型和長度的短語和句子的語義。深度學習的方法的最大優(yōu)勢在于: 它能真正充分地利用上下文信息來預測出其鄰近詞,而不像上一節(jié)所述的工作那樣,只利用目標詞與相關詞的同現(xiàn)次數(shù)來預測目標詞的語義信息。

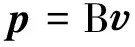

圖3 基于深度學習方法的合成語義結構圖

Socher等人[20]將深度學習的方法應用到了計算語義合成性的研究中,利用如圖3所示的神經(jīng)網(wǎng)絡研究短語和句子的合成語義信息。對于輸入的一對單詞向量c1和c2,利用式(11)可以計算得到合成向量p:

(11)

其中,[c1;c2]表示兩個單詞向量的連接。W和b是模型參數(shù),g(x)為如sigmoid或tanh的非線性函數(shù)。如圖3所示,圖中帶有實心點的框圖表示輸入的單詞或短語的語義向量,帶空心點的框圖表示通過父節(jié)點重新構造生成的與原葉子節(jié)點相對應的節(jié)點。葉子節(jié)點c2、c3通過式(11)計算得到它們父節(jié)點的語義向量p1,依此類推,該父節(jié)點語義向量又被用作新的葉子節(jié)點向量計算更長距離的短語語義向量。獲取到父節(jié)點向量p1后,通過式(12)重新構造孩子節(jié)點向量。

(12)

對于每一個非葉子節(jié)點,計算它們原始孩子節(jié)點向量與重新構造的孩子節(jié)點向量之間的歐幾里德距離作為重構誤差,如式(13)所示,通過尋找到誤差最小的根節(jié)點,從而獲取模型的最優(yōu)參數(shù)計算得到合成短語的語義向量。

(13)

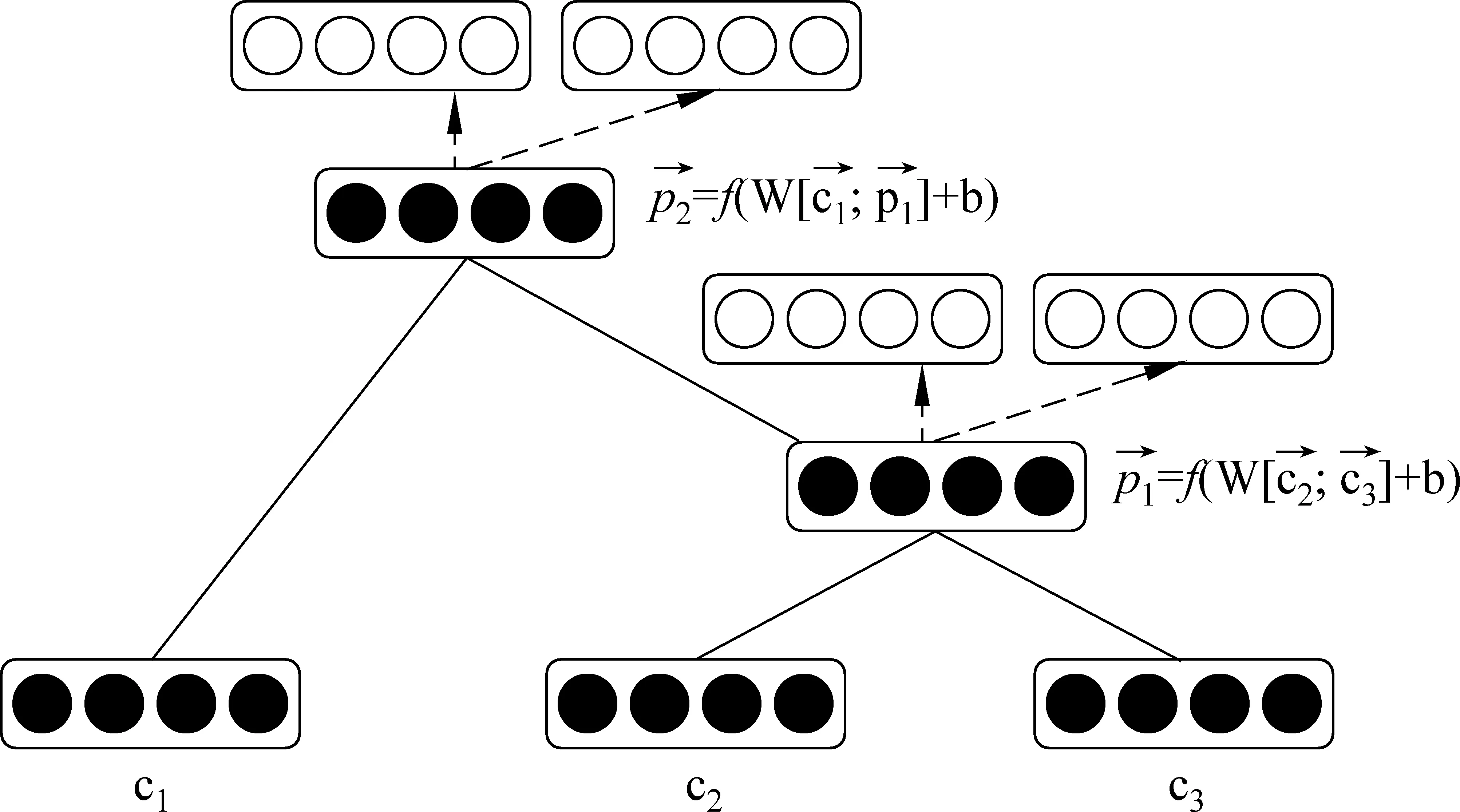

Socher等人[21]后續(xù)又對這種簡單的合成模型做了進一步的改進,借鑒向量矩陣模型方法提出了如圖4所示的MV-RNN模型。首先借助于分詞工具并通過適當?shù)恼Z法分析構建一棵二元語法樹,然后搜尋樹的每一個葉子節(jié)點得到其向量和矩陣M。其中,向量存儲的是每一個節(jié)點自身的內部信息,M存儲的是目標節(jié)點與它相鄰節(jié)點之間的連接規(guī)則。對于每一個單詞,首先將它初始化為一個n維的向量,然后利用Collobert等人[22]提出的無監(jiān)督學習的方法,對其進行進一步的優(yōu)化處理,最終得到的向量中存儲了單詞的語義信息。

圖4 基于MV-RNN模型的語義合成實例

對于每一個單詞的矩陣M,首先將它初始化為M=I+ε,其中I是隨機初始化的值,ε是高斯噪音,如果向量是n維的,則每一個單詞的矩陣M是Rn×n的。因此,對于任意長為m的短語或句子,可以用向量矩陣對: ((c1,M1),(c2,M2)…,(cm,Mm))表示,其中(c1,M1)和(cm,Mm)分別表示短語或句子中單詞的向量矩陣表示形式。

與上述提到的許多用于計算語義合成性的方法不同,深度學習的方法預訓練的過程通常非常漫長,例如,計算中所需要的參數(shù)W和b都是通過使用多次迭代運算而得到的,因此需要大量的訓練時間,而且也并不能確保訓練得到的參數(shù)適用于不同的主題。但是基于深度學習的方法訓練得到的單詞向量表示帶有更豐富的語義信息,采用非線性的合成運算得到的短語和句子的語義信息也更準確。

4 語言學方法與分布式方法比較

前文我們分兩個部分分別闡述了語言學方法以及分布式方法在計算語義合成性研究中的應用。對比諸多計算語義合成性的研究方法,從采用λ演算的語言學方法到近年來逐步占據(jù)主導地位的基于向量表示的分布式方法,再到現(xiàn)在基于深度學習的方法,在這些方法的不斷演變中,計算語義合成性的神秘面紗也逐步被揭開。

語言學的方法在語義學的研究中發(fā)揮了重要的作用,它綜合利用使得語義合成的過程得到了簡化,但是語言學方法不能明確表示單詞的語義信息,對單詞合成的短語進行邏輯表達時,僅能簡單地表示特定子表達式在一定規(guī)則下所得到的合成表達式語義的正確與否,并不能定量地分析結果所包含的語義信息。此外,語言學方法對于規(guī)則和函數(shù)具有較強的限制,并不適用于大規(guī)模的數(shù)據(jù)處理。

基于向量模型的分布式方法的引入,使得我們可以通過簡單的數(shù)學運算得到短語以及句子的合成語義信息。分布式語義表示,采用向量表示語義,在語義的表示以及可計算性上得到了極大的改善。尤其是隨著深度學習技術的發(fā)展,能夠真正充分利用整個語料的上下文信息,雖然其所得的向量每一維的具體意義目前仍無法解釋,但是通過相似度計算等諸多處理方式,能極為方便進行語義層面的研究。但是由于深度學習的方法包含了多層訓練模型,并通常需要預處理,因此它的訓練速度通常較慢,仍然有許多值得改進的地方[23]。

5 計算語義合成性的應用

迄今為止,計算語義合成性在諸多自然語言處理的任務中得到了廣泛的應用,本節(jié)著重闡述其在情感分析以及統(tǒng)計機器翻譯領域中的應用。

5.1 計算語義合成性在情感分析中的應用

從大規(guī)模數(shù)據(jù)集中分析用戶情感是一件非常具有挑戰(zhàn)性的工作,但是目前多采用基于“詞袋”模型的方法分析用戶情感,即不考慮詞與詞之間、詞與短語之間以及詞與句子之間的語法語義關系,判斷出錯的情況不可避免[24]。舉例來說,有這樣兩個句子“白細胞摧毀了病毒的一次攻擊”和“病毒的一次攻擊摧毀了白細胞”,顯然第一句話表達了積極的情感,第二句話表達了消極的情感。但在采用傳統(tǒng)基于“詞袋”模型的方法,不可避免將這兩句話判定為包含同樣的情感。此外,目前對于用戶情感的描述也存在著一定的局限性,并不能描述用戶復雜的情感狀態(tài)。

文獻[25]針對上述問題,以深度學習方法中的遞歸自動編碼器模型(RAE)為基礎將合成語義應用到用戶情感分析中,有效解決了缺乏語法結構以及用戶情感復雜描述的局限性。針對語料情況,將用戶情感分為五個大類,例如,“understand,sorry, hugs, wow,just wow”,每一大類中與之相對應有若干個標簽,例如,“excited,cried”等,形成一個標簽庫。對于一個待分析的句子,首先獲取單詞語義向量,此時的單詞語義向量可以通過多種方式(如逐點互信息或Word2vec*https://code.google.com/p/word2vec/等)獲取到,再依據(jù)如圖3所示的深度學習模型結構,每次選取誤差率最小的組合,兩兩組合依次向上迭代,直至到達根結點。其中,誤差率通過式(14)計算得到。

(14)

其中,Erec為重構誤差可通過式(13)計算得到。式(13)中的A(x)表示從語句x能夠構造樹的全部可能集合,T(y)是返回樹中所有非葉子結點的索引s的函數(shù),c1和c2為樹中的兩個葉子結點,表示待合成的兩個單詞的語義向量表示形式。

此時,我們獲取了目標句子或短語帶有語法結構的語義向量表示形式,在此基礎上為所得到的樹中的每個父結點增加一個平滑層d(p;θ):

d(p;θ)=softmax(Wlabelp)

(15)

(16)

對目標函數(shù)采用梯度下降求解,便可求出模型參數(shù)θ。此時,訓練一個簡單的邏輯回歸分類器利用該模型參數(shù)θ便可以分析待處理句子的情感。實驗結果表明,將計算語義合成性應用于情感分析中能有效解決基于“詞袋”模型導致誤判的問題,此外還大大簡化了人工處理的成本。

5.2 計算語義合成性在統(tǒng)計機器翻譯中的應用

經(jīng)過50多年的發(fā)展,統(tǒng)計機器翻譯的方法經(jīng)歷了從詞語層面、淺層語法層面、深層語法層面到半語義層面的進步[26],近年研究人員逐漸把研究的方向轉向語義層的研究。在語義層的研究中,計算語義合成性的研究也越來越廣泛。這一節(jié),我們以文獻[27]將計算語義合成性加入到短語翻譯模型中的工作為例介紹計算語義合成性在統(tǒng)計機器翻譯領域的應用。

其主要的思想是: 首先在源語言端和目標語言端分別抽取出短語,然后將源語言和目標語言中的短語,通過多層神經(jīng)網(wǎng)絡模型映射到一個低維的淺層語義空間。于是,對于源語言和目標語言的短語,都可以用一個與語言環(huán)境無關的特征向量來表示它的語義信息,最后通過計算各特征向量之間的相似度獲得源短語對到目標短語對的翻譯得分。由于該翻譯得分是這些特征向量之間的平滑函數(shù),所以語義上的微小改變僅會略微改變翻譯得分的值,確保了翻譯得分能夠保持適當?shù)闹担缓髮⑺鳛橐粋€特征加入到訓練模型中。

將語義合成性應用到統(tǒng)計機器翻譯中,關鍵在于把源語言和目標語言短語映射到同一個語義空間,然后計算出翻譯得分[28]。假設從源語言或者目標語言中抽取的短語用向量表示為p,則它映射到語義空間中的特征向量y可采用式(17)計算得到。

(17)

其中,W1是從輸入層到隱藏層的映射矩陣,W2是從隱藏層到輸出層的映射矩陣。在語義空間的特征向量基礎上,通過計算源語言短語向量ps與目標語言短語向量pt的相似度來表示源語言短語和目標語言短語的翻譯得分。它的計算過程如式(18)所示。

score(s,t)≡simθ(ps,pt)=ysTyt

(18)

其中,s和t為源語言和目標語言短語,ps和pt分別為源語言語義空間和目標語言語義空間下源語言短語和目標語言短語語義向量。ys和yt分別為源語言短語和目標語言短語在語義空間中得到的特征向量,得到翻譯得分后,將其作為一個參數(shù)加入到傳統(tǒng)的基于線性對數(shù)模型的短語機器翻譯過程中。英法機器翻譯上的實驗結果表明,這種新的模型的BLEU值比傳統(tǒng)的短語翻譯模型提高了0.7~1.0。

目前計算語義合成性在機器翻譯中的應用多采用這種在單語空間計算語義向量再投影的方法,在投影的時候不可避免地會產生語義丟失的現(xiàn)象。Hermann等[29]提出一種多語言模型,將分布式假設擴展到了多語空間,在多語空間計算短語乃至句子的合成語義信息,有效避免了投影時可能出現(xiàn)的語義丟失現(xiàn)象。將通過這種模型獲得的語義向量應用于機器翻譯中,相信定能有效提升翻譯的質量。

6 總結與展望

本文對計算語義合成性的研究方法進行了全面的綜述和分析,參考了國內外諸多研究人員有關計算語義合成性研究的文章、方法。首先概要介紹了傳統(tǒng)語言學方法在計算語義合成性研究中的應用,然后對于近年來興起的基于單詞向量表示的分布式方法選取了具有代表性的基于向量混合模型、基于向量矩陣模型以及基于深度學習的方法做了詳細的介紹。同時也介紹了計算語義合成性在情感分析和統(tǒng)計機器翻譯領域中的應用。

從本文對語言學方法和分布式方法的分析比較中可以看出: 計算語義合成性質量的好壞直接影響了其應用的質量的好壞,而單詞的表示以及單詞之間的合成規(guī)則直接影響了計算語義合成性質量的好壞。因此,計算語義合成性研究的重點仍然是尋求更好的單詞向量表示以及更便利、有效的合成規(guī)則。

計算語義合成性研究是一件非常具有潛力和挑戰(zhàn)性的工作,它可以極大地影響與改善自然語言處理的過程。但是即使采取目前最新的分布式方法,計算語義合成性研究仍然沒有取得最優(yōu)的結果。采用單詞向量表示的分布式方法的前提是分布式假設是正確的,然后才可以利用上下文信息表示目標單詞的語義信息,但是正如文獻[2]所提出的質疑,Harris等人提出的分布式假設是否正確仍然是一個需要商榷的命題。此外,對于介詞、限定詞以及關系代詞這些功能詞的語義很難有一個穩(wěn)定正確的表示方法。在單詞向量表示的基礎上,無論是線性的或者非線性的合成運算方法,都沒有綜合利用語法和語義規(guī)則。而這些問題都需要研究人員進一步挖掘與探究。

[1] 馮志偉. 自然語言處理的歷史與現(xiàn)狀[J]. 中國外語,2008,01:14-22.

[2] Kartsaklis D. Compositional Operators in Distributed Semantics. Springer Science Reviews[OL]. DOI: 10.1007/s40362-014-0017-z. 2014. www.cs.ox.ac.uk/files/6248/kartsaklis-springer.pdf

[3] Cornford FM,ed. Plato’s theory of knowledge: The theaetetus and the sophist[M]. Courier Dover Publications,2003.

[4] Frege G. ‘über Sinn und Bedeutung’,in P Geach and M Black,eds.Translations from the Philosophical Writings of Gottlob[M]. Oxford: Blackwell,1892: 56-78.

[5] Partee B. Lexical semantics and compositionality[J]. An invitation to cognitive science: Language. 1995. 1: 311-360.

[6] Clark S,Pulman S. Combining Symbolic and Distributional Models of Meaning[C]//Proceedings of the AAAI Spring Symposium on Quantum Interaction,2007: 52-55.

[7] Blacoe W,Lapata M. A comparison of vector-based representations for semantic composition[C]//Proceedings of the 2012 Joint Conference on Empirical Methods in Natural Language Processing and Computational Natural Language Learning. Association for Computational Linguistics,2012: 546-556.

[8] Montague R. English as a formal language[J]. Linguaggi nella societae nella tecnica. 1970: 189-224.

[9] Moggi E. Computational lambda-calculus and monads[M]. University of Edinburgh,Department of Computer Science,Laboratory for Foundations of Computer Science,1988.

[10] Guevara E. Computing semantic compositionality in distributional semantics[C]//Proceedings of the 9th International Conference on Computational Semantics.Association for Computational Linguistics,2011: 135-144.

[11] Bach E. An extension of classical transformational grammar[C]//Proceedings of the 1976 Conference at Michigan State University,1976: 183-224.

[12] Church A. The calculi of lambda-conversion[M]. Princeton University Press,1985.

[13] 石靜,吳云芳,邱立坤等. 基于大規(guī)模語料庫的漢語詞義相似度計算方法[J]. 中文信息學報,2013,27(1)1-6,80.

[14] 王鑫,孫薇薇,穗志方.基于淺層句法分析的中文語義角色標注研究[J]. 中文信息學報,2011,(25)01: 116-122.

[15] Mitchell J,Lapata M. Vector-based Models of Semantic Composition[C]//Proceedings of the 46th Annual Meeting of the Association for Computational Linguistics,2008: 236-244.

[16] Harris Z S. Mathematical structures of language[J]. Wiley. New York. 1968.

[17] Coecke B,Sadrzadeh M,Clark S.Mathematical Foundations for Distributed Compositional Model of Meaning[J]. Lambek Festschrift. Linguistic Analysis. 2010,36: 345-384.

[18] Baroni M,Zamparelli R. Nouns are vectors,adjectives are matrices: Representing adjective-noun constructions in semantic space[C]//Proceedings of the 2010 Conference on Empirical Methods in Natural Language Processing. Association for Computational Linguistics,2010: 1183-1193.

[19] Hinton G E,Salakhutdinov R R. Reducing the dimensionality of data with neural networks[J]. Science,2006,313(5786): 504-507.

[20] Socher R,Lin C C,Manning C,et al. Parsing natural scenes and natural language with recursive neural networks[C]//Proceedings of the 28th International Conference on Machine Learning (ICML-11),2011,129-136.

[21] Socher R,Huval B,Manning C D,et al. Semantic compositionality through recursive matrix-vector spaces[C]//Proceedings of the 2012 Joint Conference on Empirical Methods in Natural Language Processing and Computational Natural Language Learning. Association for Computational Linguistics,2012,1201-1211.

[22] Collobert R,Weston J,Bottou L,et al. Natural language processing (almost) from scratch[J]. The Journal of Machine Learning Research,2011,12: 2493-2537.

[23] Mitchell J,Lapata M. Composition in distributional models of semantics[J]. Cognitive science,2010,34(8): 1388-1429.

[24] Pang B,Lee L,Vaithyanathan S. Thumbs up?: sentiment classification using machine learning techniques[C]//Proceedings of the ACL-02 Conference on Empirical Methods in Natural Language Processing-Volume 10. Association for Computational Linguistics,2002: 79-86.

[25] Socher R,Pennington J,Huang E H,et al. Semi-supervised recursive autoencoders for predicting sentiment distributions[C]//Proceedings of the Conference on Empirical Methods in Natural Language Processing. Association for Computational Linguistics,2011: 151-161.

[26] 劉群. 統(tǒng)計機器翻譯綜述[J]. 中文信息學報,2003,17(4): 1-12.

[27] Gao J,He X,Yih W,et al. Learning Continuous Phrase Representations for Translation Modeling[C]//Proceedings of the 52nd Annual Meeting of the Association for Computational Linguistics: Long Papers-Volume 1. Association for Computational Linguistics. Baltimore,Maryland. 2014: 699-709.

[28] He X,Deng L. Maximum expected bleu training of phrase and lexicon translation model[C]//Proceedings of the 50th Annual Meeting of the Association for Computational Linguistics,2012: 292-301.

[29] Hermann K M,Blunsom P. Multilingual Models for Compositional Distributed Semantics[C]//Proceedings of the 52nd Annual Meeting of the Association for Computational Linguistics,2014: 58-68.

A Survey of Computational Semantic Compositionality

WANG Chaochao,XIONG Deyi

(School of Computer Science and Technology,Soochow University,Suzhou,Jiangsu 215006,China)

Despite of the rapid development of natural language processing,studies at the syntax level can’t fully satisfy what we need. Semantics is becoming a hot research topic in the NLP community. As the key part of semantics,computational semantic compositionality receives more attention. In this paper,we classify the approaches towards computational semantic compositionality into two categories: linguistic methods and distributional methods. We present some typical studies for each category,including the recent deep learning approaches. After an introduction to these two approaches,we make a comparison between linguistic methods and distributional methods. Then we introduce several applications of computational semantic compositionality on sentiment analysis and machine translation. Finally,we provide some suggestions on future directions of computational semantic compositionality.

semantic compositionality; natural language processing; distributional method; deep learning

王超超(1989—),碩士研究生,主要研究領域為機器翻譯。E?mail:chaochaowang@foxmail.com熊德意(1979—),教授,主要研究領域為自然語言處理,機器翻譯。E?mail:dyxiong@suda.edu.com

2014-6-9 定稿日期: 2015-12-8

江蘇省自然科學基金青年基金(BK20140355)

1003-0077(2016)03-0001-08

TP391

A