淺談數據機房的氣流組織形式

劉潤宇 趙昌新

摘要:本文闡述了數據機房內的氣流組織對數據機房制冷效率的重要性,并以某銀行數據機房的氣流組織形式設計為例,通過CFD模擬對機房空調現有常見的氣流組織形式進行對比與分析。

關鍵詞:機房空調;氣流組織;能耗

中圖分類號:TM63 文獻標識碼:A 文章編號:1674—3024(2016)05—164—03

1概述

電子信息系統由計算機、通信設備、處理設備、控制設備及其相關的配套設施構成,按照一定的應用目的和規則,對信息進行采集、加工、存儲、傳輸、檢索等處理的人機系統。主要為其提供運行環境的場所叫做電子信息系統機房,包括主機房、輔助區、支持區和行政管理區等。主機房內置大量網絡交換機、服務器及存儲器等用于電子信息處理、存儲、交換及傳輸的IT設備,可以比喻為數據中心的大腦。

機房內的氣候環境尤為重要,會直接或間接地對IT設備產生不良影響。如溫度偏高會導致電子元器件的性能劣化、使用壽命降低,改變材料的膨脹系數,加速絕緣材料老化變形等。而溫度偏低會造成電容器、電感器和電阻器的參數改變,直接影響到計算機的穩定工作。可能使潤滑脂和潤滑油凝固凍結。還會引起金屬和塑料絕緣部分因收縮系數不同而接觸不良,材料變脆,個別密封處理的電子部件開裂等。濕度偏高會使金屬材料氧化腐蝕、造成磁帶運轉時打滑影響磁帶機工作的穩定性等,濕度過高還會產生微薄的凝結水,容易引起漏電以致擊穿損壞電子元器件。而濕度偏低會使機房內容易產生靜電,靜電容易吸附灰塵,如被粘在磁盤、磁帶的讀、寫頭上,輕則出現數據誤差,嚴重的會劃傷盤片,損壞磁頭。故機房環境的穩定是決定IT設備能否全年每天24小時不間斷安全穩定運行的重要因素。

2數據中心的能耗

目前,隨著我國信息化事業的大力發展,數據中心機房的數量也隨之劇增。據研究顯示,IT/電信目前相關的碳排放已經成為最大的溫室氣體排放源之一,而該領域的排放勢頭還在隨著全球對計算、數據存儲和通信技術需求的增長快速上升,解決設備散熱及機房散熱量日漸趨高的現象開始受到了各界強烈關注。

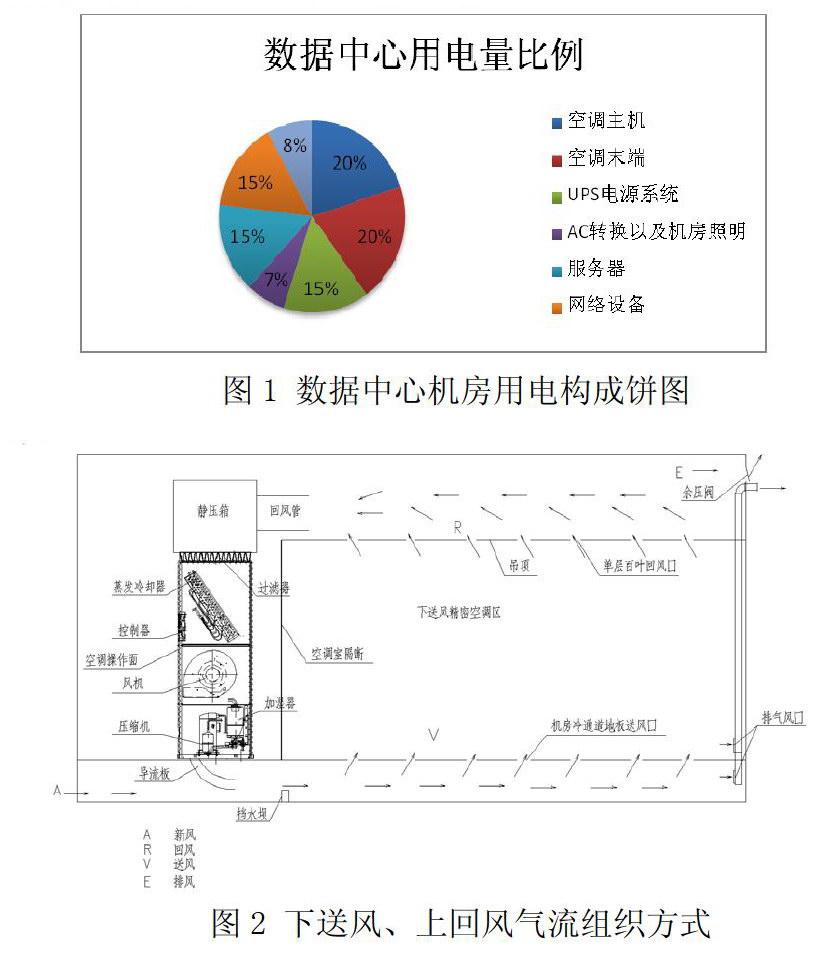

圖1給出了數據中心機房用電分布圖,服務器占15%、網絡設備占15%、存儲設備占8%、空調主機占20%、空調末端占20%、UPS電源系統占15%、Ac轉換以及機房照明占7%;即大約有38%的電力(服務器15%、網絡設備15%、存儲設備8%)真正用于網絡設備消耗,而其余的電力則用于改善設備運行環境。可見,空調占到了40%的用電量,是機房中的主要用電設備。目前造成空調系統能耗過高的原因主要為以下幾點:

(1)企業需求增大,功率密度升高;

(2)設備集中布置,熱源越加集中;

(3)機架布置隨意,熱點分布不均;

(4)機架布置緊湊,氣流空間受限。

所以,合理設計氣流組織可減少空調冷量的損失,從而提高制冷效率,是降低空調系統能耗的途徑之一。

3氣流組織的常見種類及分析

近年來大中型數據中心機房的數據機柜功率繼續增長,且布置越來越密,從而使數據中心的熱管理成為一個非常具有挑戰性的任務。數據機房的氣流組織方式主要有上送下回(側回)、下送上回等。

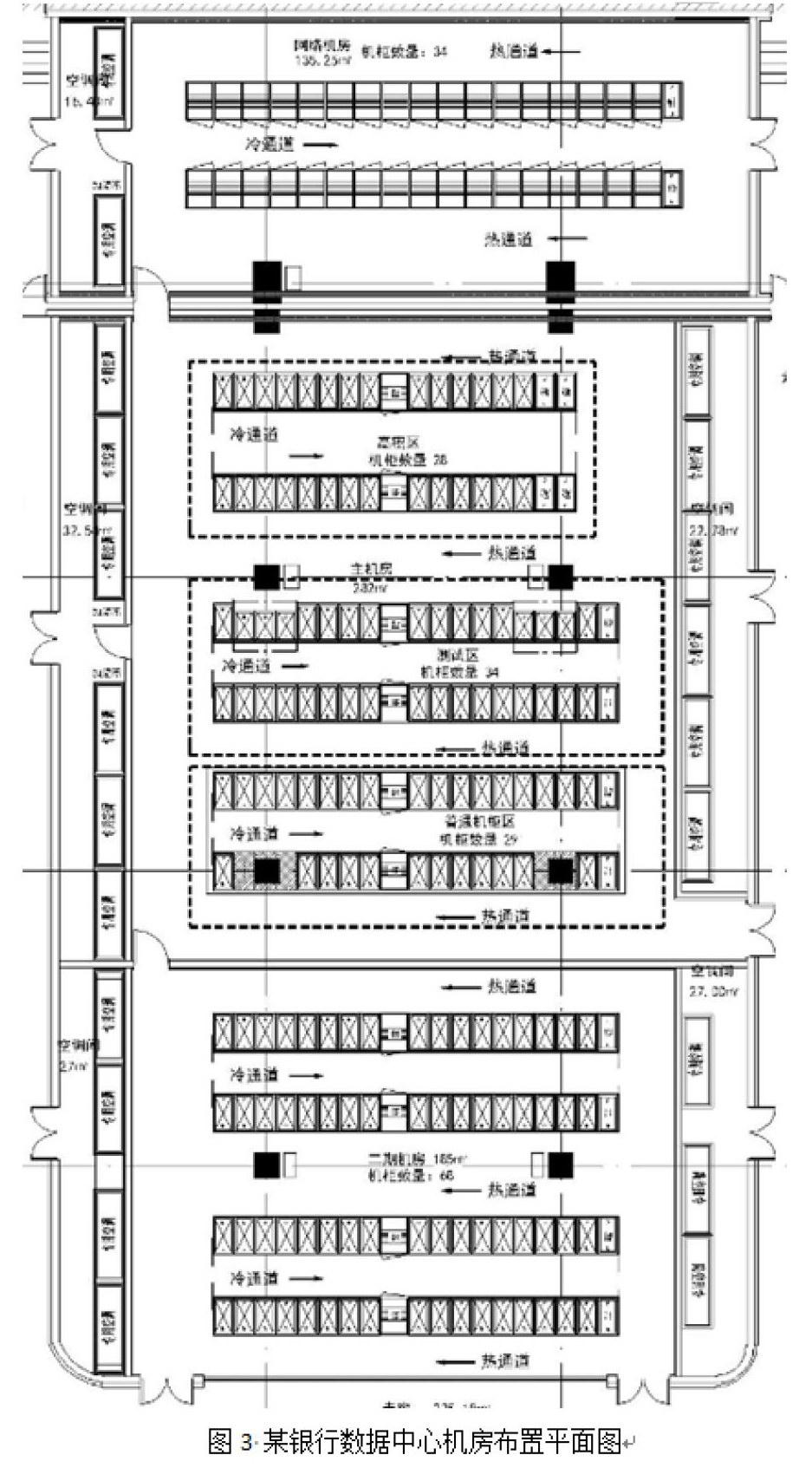

由于機房空調送出的低溫空氣由地板送風口送出后從機柜一側進入,迅速冷卻機柜后從另一側排出,利用熱空氣密度小、輕,上升后被機房空調從機房上部抽回,從而達到最佳冷卻效果,故而數據中心架空地板下板送風、上回風的氣流組織形式成為數據中心送風方式的主流,如圖2。在此基礎上,通過冷熱通道的封閉可以進一步提高制冷效率,降低能耗。

現以某銀行數據中心機房(見圖3)為例,本工程機房由網絡機房、主機房及二期機房組成,因上述機房區域溫濕度要求嚴格,全年需要恒溫恒濕,為保證室內的溫度及相對濕度全年每天24小時都滿足使用要求,采用自帶冷源的機房專用空調,根據《電子信息系統機房設計規范》GB50174-2008附錄A中對于機房專用空調設備數量的要求為N+X(X取1~N)臺。

網絡機房為一個精密空調分區,單臺機柜散熱量為2kW,共34臺,配置精密空調兩臺(顯冷量≥72kW/臺,一用一備);主機房為一個精密空調分區,其中高密區單臺機柜散熱量為12kW,共28臺,測試區及普通機柜區單臺機柜散熱量為5kW,共63臺,配置精密空調十二臺(顯冷量≥84kw/臺,八用四備);二期機房為一個精密空調分區,單臺機柜散熱量為5kW,共68臺,配置精密空調七臺(顯冷量≥72kW/臺,五用兩備)。

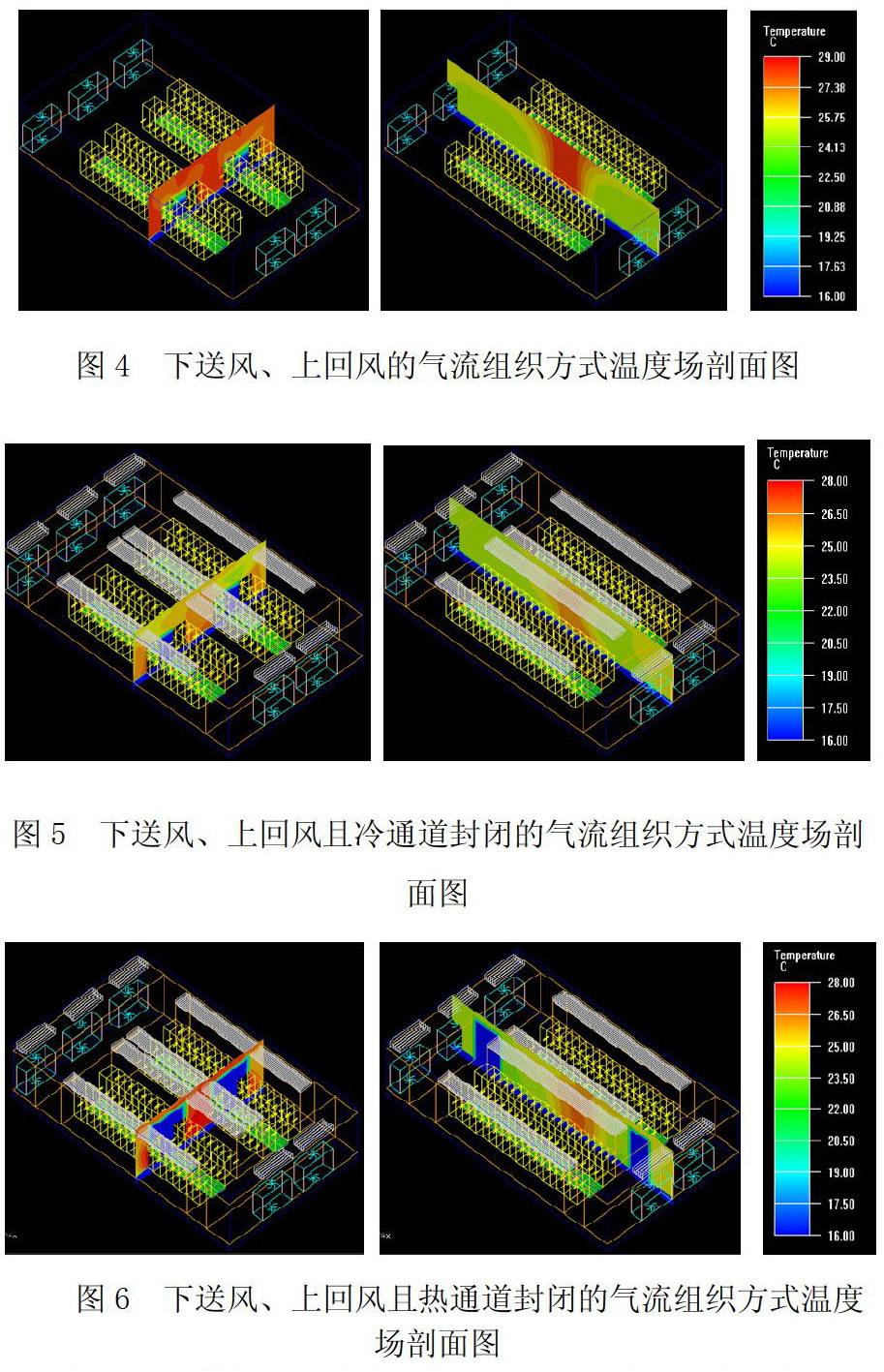

以二期機房為研究對象,機房面積185平米,長19.7米,寬11.7米,高5.4米,利用FluentAirpak軟件對其進行模擬。為了研究二期機房的氣流組織情況,將房間簡化成19.7×11.7×5.4m的長方體結構,由于二期機房內設置了七臺精密空調(五用兩備),故僅設置五臺精密空調作為實物模型,還依據實際情況設置了68臺機柜模型,保持以上設備的尺寸、風量、散熱量等實際參數不變,僅改變房間的氣流組織方式,分別采用以下送風、上回風的氣流組織方式(如圖4),下送風、上回風且冷通道封閉的氣流組織方式(如圖5),下送風、上回風且熱通道封閉的氣流組織方式(如圖6)進行模擬,根據3種CFD(Computational Fluid Dynamics)模擬結果進行對比分析。

傳統的地板下送風、上回風方式,容易造成氣流短路,導致送風量不足,降低空調的制冷效率。從CFD模擬結果中可以看出,低溫空氣從地板送風口送出后,由于冷通道完全不密封,一部分冷空氣進入機柜,另一部分穿過冷通道,在機柜上方與經過機柜的冷空氣混合,造成浪費,導致機房整體的環境溫度偏高,由圖4可以看出,機柜出風側溫度已經達到29℃以上。通過采用冷熱通道封閉的方式,將冷熱空氣相互隔離開來,防止氣流短路及冷熱風相混合,可以大大提高空調機的制冷效率,在能夠滿足機房設備正常散熱的情況下,可以降低空調風機的風量,達到節能的效果。從封閉冷通道(圖5)及封閉熱通道(圖6)的CFD模擬結果的中可以看出,封閉冷通道后,機柜出風側溫度降到26℃左右,而封閉熱通道后,機柜出風側溫度則降到將近28℃,故采用冷通道封閉的制冷效果優于封閉熱通道的制冷效果。

根據CFD模擬得到的結果作為依據,通過對比本工程最終采用地板下送風、冷通道封閉、室內上回風的氣流組織形式。

2007年,綠色網絡組織(The Rreen Grid)制定了數據中心的能源效率指標PUE(Power Usage Effectiveness)值,該值是數據中心年總耗電量與IT設備用年耗電量的比值,它代表了數據中心的電能利用率,比值越小,表明其利用率越高。該值是目前國際上較為通用的對數據中心的評價標準。其公式為:

PLF——0.108~0.114,供配電損耗與IT設備總能耗的比值。

通過公式可以計算得到本文中某銀行的數據中心機房PUE值為:

PUE=0.345+(0.108~0.114)+1=1.453~1.459。

4結論

通過CFD模擬結果對三種氣流組織方式進行分析,在實現相同制冷效果的前提下,封閉冷、熱通道的方式都可以有效的優化機房內氣流組織,通過減少機房空調室內風機送風量來實現數據中心的節能,從模擬結果上看下送風、上回風且封閉冷通道的制冷效果最好。