基于RBF神經(jīng)網(wǎng)絡(luò)的集成增量學習算法

彭玉青 趙翠翠 高晴晴

(河北工業(yè)大學計算機科學與軟件學院 天津 300401)

?

基于RBF神經(jīng)網(wǎng)絡(luò)的集成增量學習算法

彭玉青趙翠翠高晴晴

(河北工業(yè)大學計算機科學與軟件學院天津 300401)

摘要針對增量學習的遺忘性問題和集成增量學習的網(wǎng)絡(luò)增長過快問題,提出基于徑向基神經(jīng)網(wǎng)絡(luò)(RBF)的集成增量學習方法。為了避免網(wǎng)絡(luò)的遺忘性,每次學習新類別知識時都訓練一個RBF神經(jīng)網(wǎng)絡(luò),把新訓練的RBF神經(jīng)網(wǎng)絡(luò)加入到集成系統(tǒng)中,從而組建成一個大的神經(jīng)網(wǎng)絡(luò)系統(tǒng)。分別采用最近中心法、最大概率法、最近中心與最大概率相結(jié)合的方法進行確定獲勝子網(wǎng)絡(luò),最終結(jié)果由獲勝子網(wǎng)絡(luò)進行輸出。在最大概率法中引入自組織映(SOM)的原型向量來解決類中心相近問題。為了驗證網(wǎng)絡(luò)的增量學習,用UCI 機器學習庫中Statlog(Landsat Satellite)數(shù)據(jù)集做實驗,結(jié)果顯示該網(wǎng)絡(luò)在學習新類別知識后,既獲得了新類別的知識也沒有遺忘已學知識。

關(guān)鍵詞RBFSOM增量學習

0引言

傳統(tǒng)神經(jīng)網(wǎng)絡(luò)只能進行一次學習,不能在第一次學習的基礎(chǔ)上實現(xiàn)二次學習。現(xiàn)實生活中不可能一次性獲得所有的神經(jīng)網(wǎng)絡(luò)訓練數(shù)據(jù),所以很多學者提出了增量學習的神經(jīng)網(wǎng)絡(luò)。但是設(shè)計增量學習網(wǎng)絡(luò)必須要面對網(wǎng)絡(luò)的穩(wěn)定性和可塑性這個難題[1]。所謂穩(wěn)定性就是為了記住已學過的知識,網(wǎng)絡(luò)結(jié)構(gòu)和參數(shù)不能發(fā)生改變;可塑性就是為了學習新的知識,要對已有網(wǎng)絡(luò)的結(jié)構(gòu)和參數(shù)進行調(diào)整,不能完全保持網(wǎng)絡(luò)結(jié)構(gòu)和參數(shù)不變。但是網(wǎng)絡(luò)結(jié)構(gòu)和參數(shù)一旦發(fā)生改變,網(wǎng)絡(luò)就會產(chǎn)生遺忘性,這樣的增量學習網(wǎng)絡(luò)是沒有意義的,所以要實現(xiàn)增量學習就必須建立在穩(wěn)定性的基礎(chǔ)之上。

神經(jīng)網(wǎng)絡(luò)集成就是保持穩(wěn)定性和可塑性之間很好的折中方法。Learn++算法[2]和負相關(guān)算法[3]都是神經(jīng)網(wǎng)絡(luò)集成的增量學習算法。通過對新知識的學習產(chǎn)生多個弱分類器,加入到增量學習系統(tǒng)中。這種網(wǎng)絡(luò)能夠很好地保留已學知識,但是網(wǎng)絡(luò)增長的速度非常快,使得網(wǎng)絡(luò)過于龐大,不具有實用性。雖然有些學者又提出了選擇性負相關(guān)的增量學習[4],但是在進行網(wǎng)絡(luò)選擇的過程中,會使得網(wǎng)絡(luò)產(chǎn)生一定的遺忘性。

RBF神經(jīng)網(wǎng)絡(luò)和模糊規(guī)則相結(jié)合的增量學習[5,6],通過規(guī)則增長條件判斷是否增加RBF的核函數(shù)來進行增量學習。選用高斯函數(shù)作為RBF的核函數(shù),該函數(shù)能夠?qū)斎胧噶慨a(chǎn)生局部響應,輸出節(jié)點對隱層節(jié)點的輸出進行線性加權(quán),從而實現(xiàn)輸入空間到輸出空間的映射,使整個網(wǎng)絡(luò)達到分類和函數(shù)逼近的目的[7]。但是這種增量學習網(wǎng)絡(luò)在學習的過程中會修改已學規(guī)則的參數(shù),從而產(chǎn)生遺忘性。

自組織映射與概率神經(jīng)網(wǎng)絡(luò)相結(jié)合的增量學習網(wǎng)絡(luò)(IMSOMPNN)[13],通過SOM對每一個類別的訓練數(shù)據(jù)進行學習并得到原型向量,用原型向量構(gòu)建PNN。這種增量學習在沒有遺忘已學知識的前提下實現(xiàn)了增量學習。但是IMSOMPNN每次只能學習一個類別的知識,不能實現(xiàn)知識的多類別學習,會使得網(wǎng)絡(luò)的學習過于繁瑣。

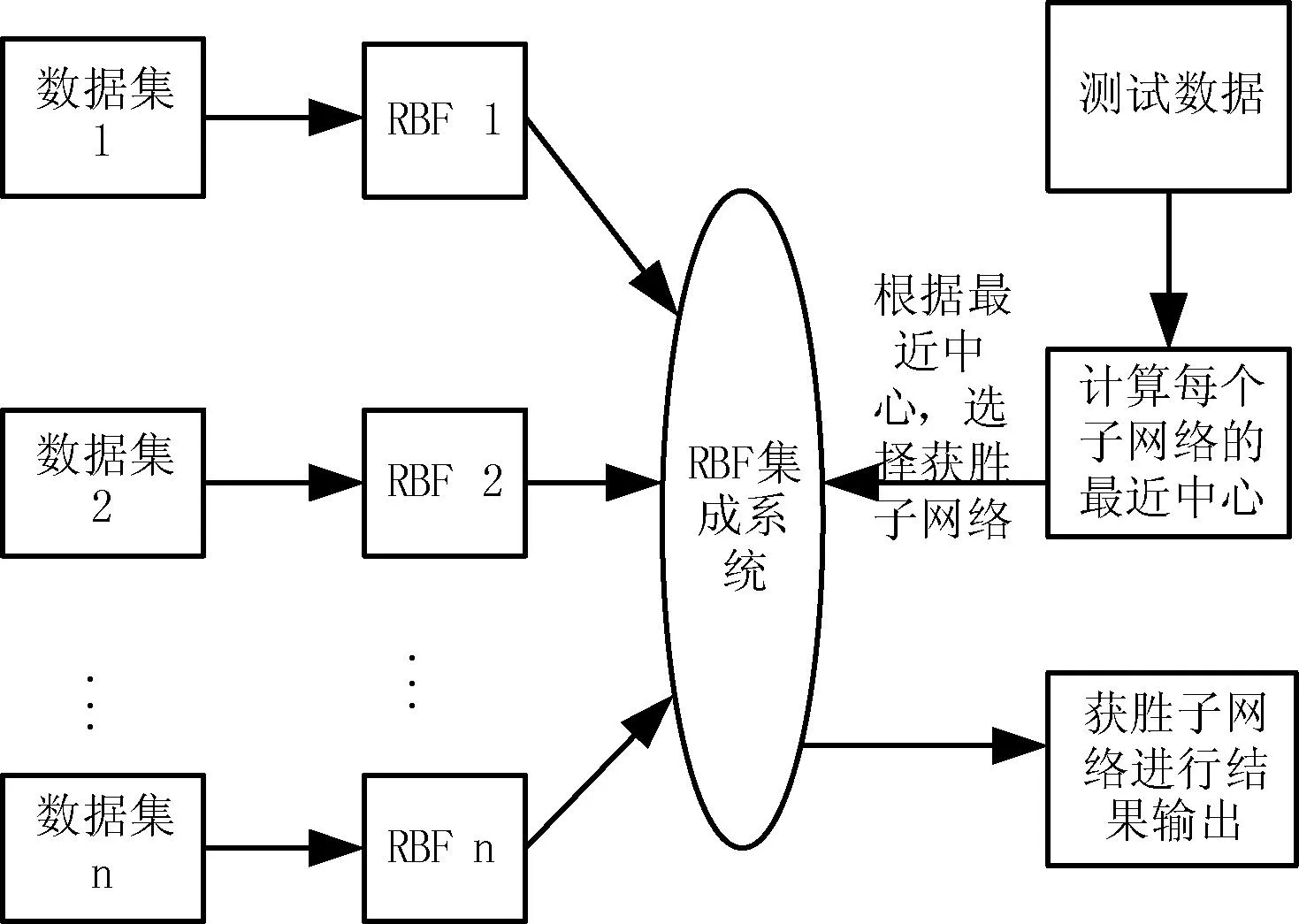

針對以上問題本文提出了基于RBF集成增量的學習方法。當新知識到來時通過RBF神經(jīng)網(wǎng)絡(luò)進行學習,在RBF神經(jīng)網(wǎng)絡(luò)學習的過程中,采用k-均值聚類算法找中心和相應的寬度,用偽逆法[8]求子網(wǎng)絡(luò)權(quán)值和偏置權(quán)值,將得到的子網(wǎng)絡(luò)加入到神經(jīng)網(wǎng)絡(luò)集成系統(tǒng)中,通過最近中心確定獲勝子網(wǎng)絡(luò),最終結(jié)果由獲勝子網(wǎng)絡(luò)輸出。

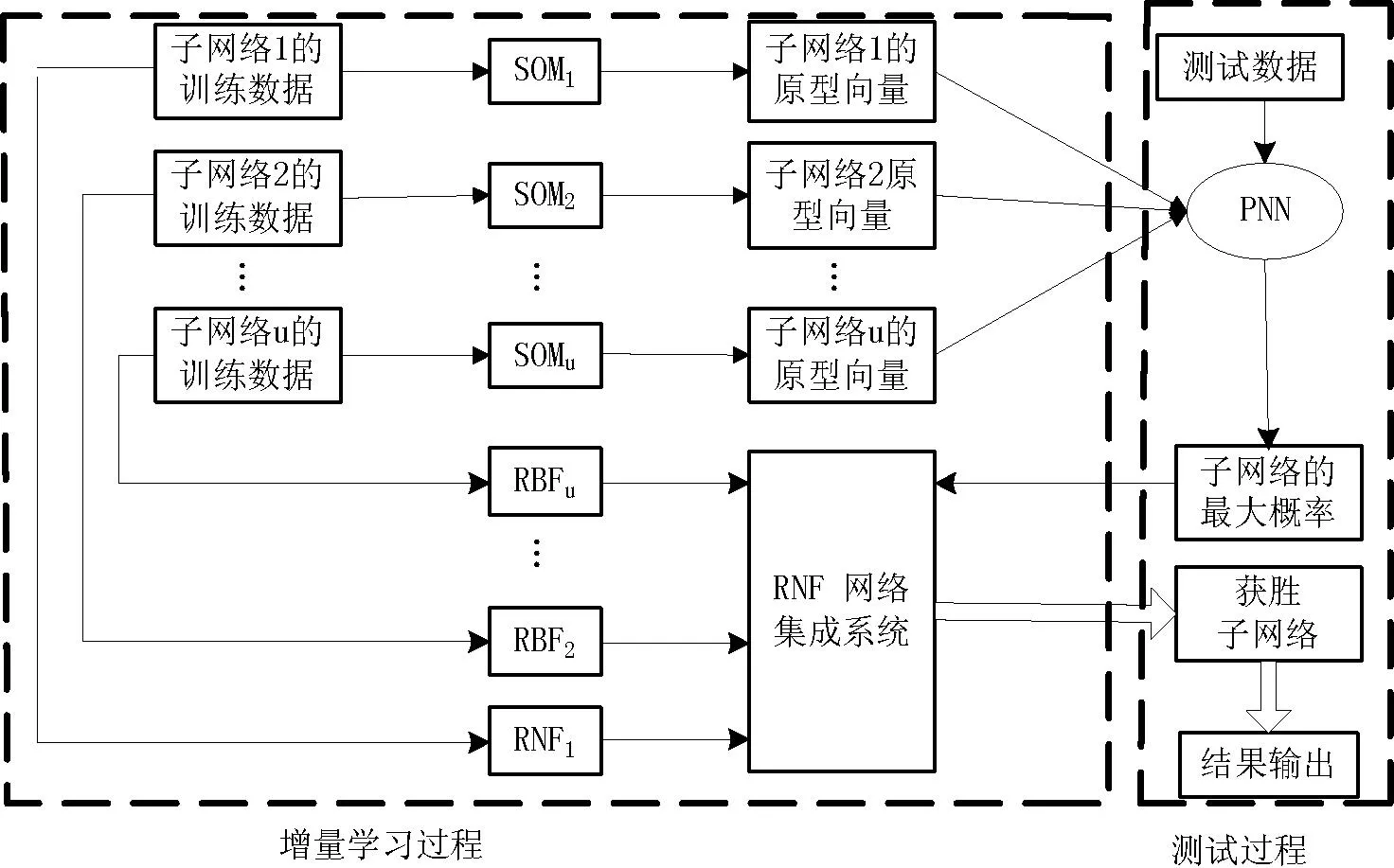

由于RBF神經(jīng)網(wǎng)絡(luò)學習不能去除噪聲數(shù)據(jù),也不能包含所有的特征信息,所以本文又提出了RBF與SOM相結(jié)合的集成增量學習方法。與上述方法不同之處在于:該方法采用SOM對子網(wǎng)絡(luò)的訓練數(shù)據(jù)進行學習,子網(wǎng)絡(luò)的訓練數(shù)據(jù)有可能是一個類別的訓練數(shù)據(jù),也可能是多個類別的訓練數(shù)據(jù)。用SOM訓練后的原型向量構(gòu)建概率神經(jīng)網(wǎng)絡(luò),用于求出每個子網(wǎng)絡(luò)的最大概率,通過最大概率準則確定獲勝子網(wǎng)絡(luò),而不是通過最近中心確定獲勝子網(wǎng)絡(luò)。

結(jié)合以上兩種方法,本文又提出了最近中心與最大概率相結(jié)合的方法來確定獲勝子網(wǎng)絡(luò)。最后分別采用這三種方法進行實驗。實驗結(jié)果表明了這三種集成的增量學習方法沒有改變已學知識的子網(wǎng)絡(luò)結(jié)構(gòu)和參數(shù),不會對已學知識產(chǎn)生遺忘性,所以本文提出的增量學習網(wǎng)絡(luò)可以在對已學知識不產(chǎn)生遺忘的基礎(chǔ)上,進行增量學習,而且增量學習后的網(wǎng)絡(luò)識別率很高;與其他集成增量學習相比,本文的方法每次增量學習只增加一個子網(wǎng)絡(luò),避免了網(wǎng)絡(luò)系統(tǒng)過于龐大的問題;每次增量學習可以實現(xiàn)多類別知識的學習,避免了逐個類別知識學習的繁瑣性。

1網(wǎng)絡(luò)結(jié)構(gòu)

如圖1所示本網(wǎng)絡(luò)分為四層。第一層為網(wǎng)絡(luò)輸入層,輸入為xi(i=1,2,…,n)。第二層為核函數(shù)層,本網(wǎng)絡(luò)采用高斯函數(shù)作為核函數(shù),核函數(shù)為:

(1)

(2)

圖1 RBF增量學習網(wǎng)絡(luò)結(jié)構(gòu)圖

第三層為子網(wǎng)絡(luò)輸出層,期望輸出公式為:

(3)

第四層為集成系統(tǒng)的輸出,輸出公式為:

(4)

其中,bj為第j個子網(wǎng)絡(luò)與系統(tǒng)輸出之間的輸出權(quán)值,j的取值為:j=1,…,u,y為集成系統(tǒng)的總輸出。

2增量學習過程

本文的RBF神經(jīng)網(wǎng)絡(luò)采用K-均值聚類算法得到中心,用偽逆法求得權(quán)值和偏置。分別用最近中心法、最大概率法、最近中心與最大概率相結(jié)合的方法確定獲勝子網(wǎng)絡(luò)。獲勝子網(wǎng)絡(luò)的輸出權(quán)值為1,非獲勝子網(wǎng)絡(luò)的輸出權(quán)值為0,網(wǎng)絡(luò)的最終結(jié)果由獲勝子網(wǎng)絡(luò)進行輸出。最大概率法中用SOM已學過的原型向量通過PNN(概率神經(jīng)網(wǎng)絡(luò))得到子網(wǎng)絡(luò)的最大概率。

本文每次增量學習只增加一個子網(wǎng)絡(luò),避免了網(wǎng)絡(luò)系統(tǒng)過于龐大的問題;每次增量學習可以實現(xiàn)多類別知識的學習,避免了逐個類別知識學習的繁瑣性。

2.1K-均值算法選取網(wǎng)絡(luò)中心

K-均值聚類算法[9,10]是一種模式聚類算法,聚類分析是根據(jù)數(shù)據(jù)空間的內(nèi)在性質(zhì)將其分成一些聚合類,它是在不對數(shù)據(jù)作任何假設(shè)的條件下進行的,是完全非監(jiān)督的學習過程。其原理是首先初始化中心,中心的個數(shù)主觀確定。然后將輸入樣本按最鄰近規(guī)則分組。

假設(shè)初始中心的個數(shù)為m,即將xi(i=1,2,…,n)按最鄰近規(guī)則分配給中心m個初始中心,得到m個輸入樣本聚類集合θk(k=1,…,m)。要求滿足:

(5)

中心確定以后,相應的計算寬度σk,本文的寬度為:

σk=λ×dk

(6)

經(jīng)過多次實驗,本文取λ為2。

2.2偽逆求子網(wǎng)絡(luò)的權(quán)值和偏置

在中心和寬度已知的情況下,用偽逆法可直接求解核函數(shù)層與子網(wǎng)絡(luò)輸出層的輸出權(quán)值和偏置權(quán)值。

用k-均值聚類法計算出中心并求出相應的寬度,根據(jù)中心和寬度求出核函數(shù)層輸出矩陣R。由于加了一個偏置神經(jīng)元,并且偏置神經(jīng)元的取值為1,所以要擴展核函數(shù)輸出矩陣為:

(7)

其中,G比R增加了一維偏置神經(jīng)元的輸出,期望輸出矩陣D,權(quán)值矩陣W的輸出公式為:

W=DG+

(8)

其中G+為G的偽逆:

G+=(GTG)GT

(9)

2.3確定獲勝子網(wǎng)絡(luò)

本文采用三種方法確定獲勝子網(wǎng)絡(luò),分別是用最近中心確定獲勝子網(wǎng)絡(luò)、最大概率確定獲勝子網(wǎng)絡(luò)、最近中心與最大概率相結(jié)合的方法確定獲勝子網(wǎng)絡(luò)。

2.3.1最近中心確定獲勝子網(wǎng)絡(luò)

RBF是一種局部分布的、中心對稱衰減的非負非線性函數(shù)[11]。局部分布是指僅當輸入落在輸入空間一個很小的指定區(qū)域時,隱單元的徑向基函數(shù)才做出有意義的非零響應。中心徑向?qū)ΨQ衰減是指與基函數(shù)中心徑向距離相同的輸入,隱節(jié)點中的徑向基函數(shù)都產(chǎn)生相同的輸出[12]。并且輸入與RBF的中心越近,核函數(shù)的響應越大,所以本論文中子網(wǎng)絡(luò)與集成系統(tǒng)輸出之間的權(quán)值由測試數(shù)據(jù)與RBF的最近中心決定,所謂最近中心就是指輸入數(shù)據(jù)與RBF所有中心的徑向距離中最小的一個中心。圖2為最近中心確定獲勝子網(wǎng)絡(luò)增量學習方法。

圖2 最近中心法確定獲勝子網(wǎng)絡(luò)方法

具體算法如下:

(1) 計算測試數(shù)據(jù)與網(wǎng)絡(luò)集成中心的徑向距離,找出徑向距離最小的中心,即為最近中心。

(2) 判斷最近中心所屬子網(wǎng)絡(luò),即為獲勝子網(wǎng)絡(luò);獲勝子網(wǎng)絡(luò)的輸出權(quán)值為1,非獲勝子網(wǎng)絡(luò)的輸出權(quán)值為0。

RBF訓練過程中不能去除噪聲數(shù)據(jù),而且網(wǎng)絡(luò)的中心個數(shù)是有限的,如果中心太多RBF的訓練會出現(xiàn)過擬合現(xiàn)象。由于RBF中心個數(shù)的限制,每個中心都包含了一部分特征信息,導致網(wǎng)絡(luò)中心不能完全包含所有的特征信息。如果兩個子網(wǎng)絡(luò)的訓練數(shù)據(jù)特別相似,就會出現(xiàn)部分中心相似性,當用最近中心確定獲勝子網(wǎng)時,很有可能選錯子網(wǎng)絡(luò)。而通過SOM學習得到的原型向量包含了訓練數(shù)據(jù)更多的特征信息,同時也會去除噪聲數(shù)據(jù),所以本文考慮采用SOM的原型向量進一步確定獲勝子網(wǎng)絡(luò)。

2.3.2最大概率確定獲勝子網(wǎng)絡(luò)

SOM是無導師學習的方法,具有良好的自組織能力。通過SOM學習可以去除含有噪聲的特征數(shù)據(jù),得到更為緊湊的原型向量,并且原型向量的維數(shù)和輸入數(shù)據(jù)的維數(shù)相同,用得到的原型向量來構(gòu)建PNN。SOM[12,13]訓練時,采用批量處理的訓練方式,鄰域函數(shù)為高斯函數(shù)。

具體算法如下:

(2) 根據(jù)劃分到Voronoi區(qū)域Vj中的樣本個數(shù)nj,計算這些樣本的均值,公式如下:

(10)

其中,xp∈Vj,1≤p≤nj。

(3) 更新原型向量:

(11)

其中,hjk(t)為鄰域函數(shù),hjk(t)依賴于獲勝神經(jīng)元k和興奮神經(jīng)元j在輸出空間的側(cè)向距離,本文中鄰域函數(shù)為高斯函數(shù)。

由于k-均值聚類法沒有對訓練數(shù)據(jù)進行去除噪聲,不同網(wǎng)絡(luò)的相似性高的訓練數(shù)據(jù)會得到相似的中心,從而在選擇獲勝子網(wǎng)絡(luò)時發(fā)生錯誤,所以增加了子網(wǎng)絡(luò)的最大概率這個判定條件,圖3為最大概率確定獲勝網(wǎng)絡(luò)的整體增量學習過程圖。

圖3 增量學習過程

最大概率確定獲勝子網(wǎng)絡(luò)具體算法如下:

(12)

p(x|ωj)=max(pl(x|ωj))

(13)

式中,第j個子網(wǎng)絡(luò)的概率p(x|ωj)為pl(x|ωj)中最大的一個。其中δ為平滑因子,公式如下:

(14)

其中‖χu,l-χu,j‖為兩個原型向量的徑向距離。

2.3.3最近中心與最大概率確定獲勝子網(wǎng)絡(luò)

經(jīng)過多次的實驗發(fā)現(xiàn),最近中心和次近中心如果屬于同一個子網(wǎng)絡(luò),那么僅根據(jù)最近中心確定的獲勝子網(wǎng)絡(luò)輸出的結(jié)果正確率很高,所謂最近中心就是指輸入數(shù)據(jù)與RBF所有中心的徑向距離中最小的一個中心,輸入數(shù)據(jù)與RBF所有中心的徑向距離中第二小的中心為次近中心;如果最近中心和次近中心所屬的子網(wǎng)絡(luò)不同,那么僅根據(jù)最近中心確定的獲勝子網(wǎng)絡(luò)對結(jié)果的輸出,有少部分會出現(xiàn)錯誤。這就說明當最近中心和次近中心所屬子網(wǎng)絡(luò)不同時,它們所屬的子網(wǎng)絡(luò)都有可能為真正的獲勝子網(wǎng)絡(luò),僅憑借最近中心確定的獲勝的正確率顯然要低。

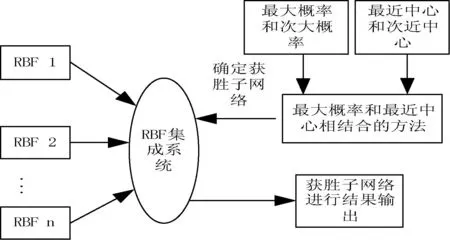

最大概率法確定獲勝子網(wǎng)絡(luò)也存在上述問題,所以想結(jié)合以上兩種方法來解決該問題。本文又提出了最近中心與最大概率相結(jié)合的方法來確定獲勝子網(wǎng)絡(luò)。

該方法的主要思想是:如果最近中心和次近中心所屬的子網(wǎng)絡(luò)是同一個網(wǎng)絡(luò),那么它們所在的網(wǎng)絡(luò)為獲勝子網(wǎng)絡(luò);如果最近中心和次近中心的所屬的網(wǎng)絡(luò)不同,并且最近中心所在子網(wǎng)絡(luò)的最大概率大于次近中心所在網(wǎng)絡(luò)的最大概率,那么最近中心所在子網(wǎng)絡(luò)為獲勝子網(wǎng)絡(luò);如果最近中心和次近中心所屬子網(wǎng)絡(luò)不同,而且最近中心所在子網(wǎng)絡(luò)的最大概率小于次近中心所在網(wǎng)絡(luò)的最大概率,就要考慮最近中心和次近中心距離了,假設(shè)最近中心、次近中心的徑向距離分別為d1和d2,并且d1≤d2,離中心越近,核函數(shù)的響應越大,所以d1/(d1+d2)的取值越小,代表最近中心的重要性越大。最近中心和次近中心所在子網(wǎng)的最大概率為pj和pg,j=1,2,…,u;g=1,2,…,u,圖4為最近中心與最大概率確定獲勝子網(wǎng)絡(luò)方法。

圖4 最近中心與最大概率確定獲勝子網(wǎng)絡(luò)方法

具體算法如下:

(1) 計算出測試數(shù)據(jù)與最近中心、次近中心的徑向距離d1和d2,并用PNN求出最近中心和次近中心所在子網(wǎng)絡(luò)的最大概率pj和pg。

(2) 如果最近中心和次近中心屬于相同的網(wǎng)絡(luò),則最近中心和次近中心所在的網(wǎng)絡(luò)為獲勝子網(wǎng)絡(luò),輸出權(quán)值為1;其他網(wǎng)絡(luò)為非獲勝子網(wǎng)絡(luò),輸出權(quán)值為0。

(3) 如果最近中心和次近中心屬于不同的網(wǎng)絡(luò)yj和yg,pj大于等于pg,則yj為獲勝子網(wǎng),輸出權(quán)值為1;其他網(wǎng)絡(luò)為非獲勝子網(wǎng)絡(luò),輸出權(quán)值為0。

(4) 如果最近中心和次近中心屬于不同的子網(wǎng)絡(luò)yj和yg,pj小于pg,d1/(d1+d2)大于閾值T,則yg為獲勝子網(wǎng)絡(luò),輸出權(quán)值為1;其他網(wǎng)絡(luò)為非獲勝子網(wǎng)絡(luò),輸出權(quán)值為0。

(5) 如果最近中心和次近中心屬于不同的子網(wǎng)絡(luò)yj和yg,pj小于pg,d1/(d1+d2)小于閾值T,則yj為獲勝子網(wǎng)絡(luò),輸出權(quán)值為1;其他網(wǎng)絡(luò)為非獲勝子網(wǎng)絡(luò),輸出權(quán)值為0。

3實驗結(jié)果分析

本文采用自組織映射與概率神經(jīng)網(wǎng)絡(luò)的增量式學習算法(IMSOMPNN)的實驗數(shù)據(jù)[13]。該實驗數(shù)據(jù)為UCI機器學習庫中Statlog(LandsatSatellite)數(shù)據(jù)集。該數(shù)據(jù)集共有36個屬性,6個類別 ,6435個樣本,其中4435個是訓練樣本,2000個為測試樣本。T1∪T2∪…∪T6,分別代表6個類別的訓練數(shù)據(jù),6個類別的測試數(shù)據(jù)為E1∪E2∪…∪E6。

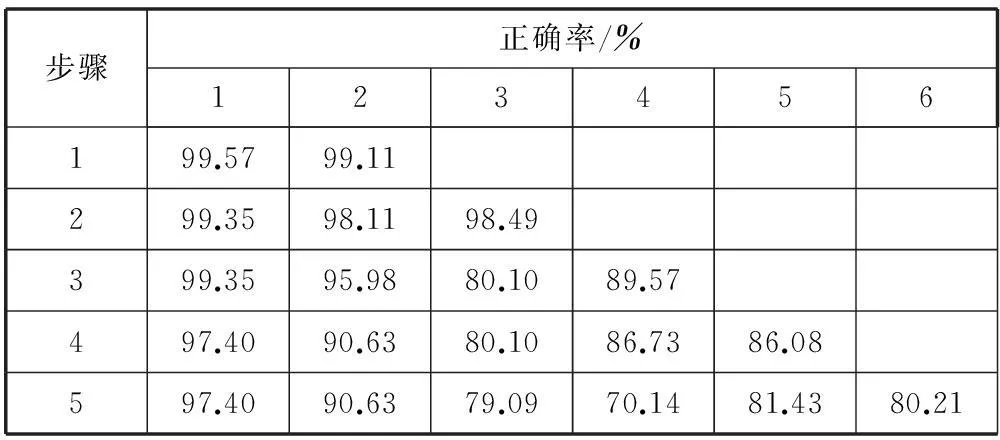

3.1最近中心確定獲勝子網(wǎng)絡(luò)的單類別增量學習

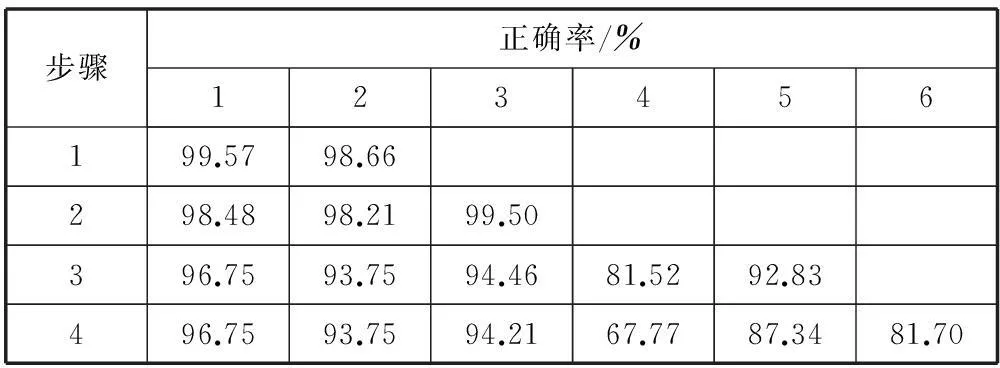

首先使用T1∪T2來訓練一個初始的RBF網(wǎng)絡(luò)集成系統(tǒng),然后使用E1∪E2來對模型進行測試;在第t步(2≤t≤5)時,用Tt+1訓練一個RBF網(wǎng)絡(luò),并把新訓練的RBF加入到RBF集成系統(tǒng)中,然后使用E1∪E2∪…∪Et+1測試模型。表1為最近中心確定獲勝子網(wǎng)絡(luò)的單類別增量學習結(jié)果。

表1 最近中心確定獲勝子網(wǎng)絡(luò)的增量學習

3.2最大概率確定獲勝子網(wǎng)絡(luò)的單類別增量學習

首先使用T1∪T2來訓練一個初始的RBF網(wǎng)絡(luò)集成系統(tǒng),訓練一個SOM神經(jīng)網(wǎng)絡(luò),從而得到SOM的原型向量。然后使用E1∪E2來對模型進行測試;在第t步(2≤t≤5)時,用Tt+1訓練一個RBF網(wǎng)絡(luò)和一個SOM,并把新訓練的RBF加入到RBF集成系統(tǒng)中,把新的SOM原型向量加入到神經(jīng)網(wǎng)絡(luò)集成系統(tǒng)中,然后使用E1∪E2∪…∪Et+1測試模型。如表2所示。

表2 最大概率確定獲勝子網(wǎng)絡(luò)的單類別增量學習

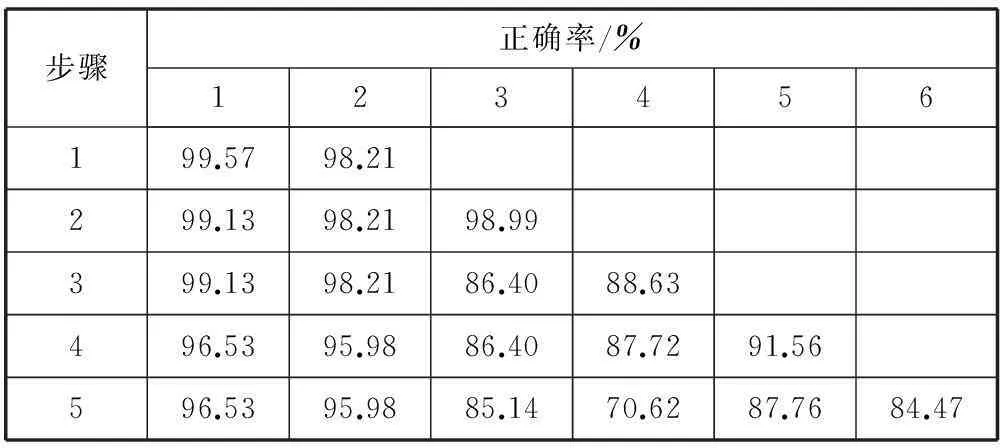

3.3最近中心與最大概率確定獲勝子網(wǎng)絡(luò)的單類別增量學習

首先使用T1∪T2來訓練一個初始的RBF網(wǎng)絡(luò)集成系統(tǒng),訓練一個SOM神經(jīng)網(wǎng)絡(luò),從而得到SOM的原型向量。然后使用E1∪E2來對模型進行測試;在第t步(2≤t≤5)時,用Tt+1訓練一個RBF網(wǎng)絡(luò)和一個SOM,并把新訓練的RBF加入到RBF集成系統(tǒng)中,把新的SOM原型向量加入到神經(jīng)網(wǎng)絡(luò)集成系統(tǒng)中,然后使用E1∪E2∪…∪Et+1測試模型。表3為最近中心與最大概率確定獲勝子網(wǎng)絡(luò)的單類別增量學習結(jié)果。

表3 最近中心與最大概率確定獲勝子網(wǎng)絡(luò)的單類別增量學習

3.4IMSOMPNN

首先,使用T1∪T2來訓練一個初始的IMSOMPNN,然后使用E1∪E2來對模型行進行測試;在第t步2≤t≤5時,將Tt+1提交至IMSOMPNN進行增量學習,然后使用E1∪E2∪…∪Et+1測試模型。表4給出了增量學習的每一步中,模型分類性能的變化。表4為自組織映射與概率神經(jīng)網(wǎng)絡(luò)相結(jié)合的單類別增量學習結(jié)果。

表4 自組織映射與概率神經(jīng)網(wǎng)絡(luò)相結(jié)合的增量學習

3.5最大概率確定獲勝子網(wǎng)絡(luò)的多類別增量學習

為了體現(xiàn)每次增量學習可以實現(xiàn)多個類別的學習,本次實驗第一步使用T1∪T2訓練一個初始的RBF網(wǎng)絡(luò)集成系統(tǒng)和SOM,然后使用E1∪E2來對模型進行測試;第二步使用T3訓練一個RBF和SOM,并把新訓練的RBF加入RBF網(wǎng)絡(luò)集成系統(tǒng)中,用E3對模型進行測試;第三步使用T4∪T5訓練一個RBF和SOM,并把新訓練的RBF加入到RBF集成系統(tǒng)中,用E4∪E5對模型進行測試;第四步使用T6訓練一個RBF和SOM,并把新訓練的RBF加入到RBF集成系統(tǒng)中,用E6對模型進行測試。表5為最大概率確定獲勝子網(wǎng)絡(luò)的多類別增量學習結(jié)果。

表5 最大概率確定獲勝子網(wǎng)絡(luò)的多類別增量學習

3.6實驗分析

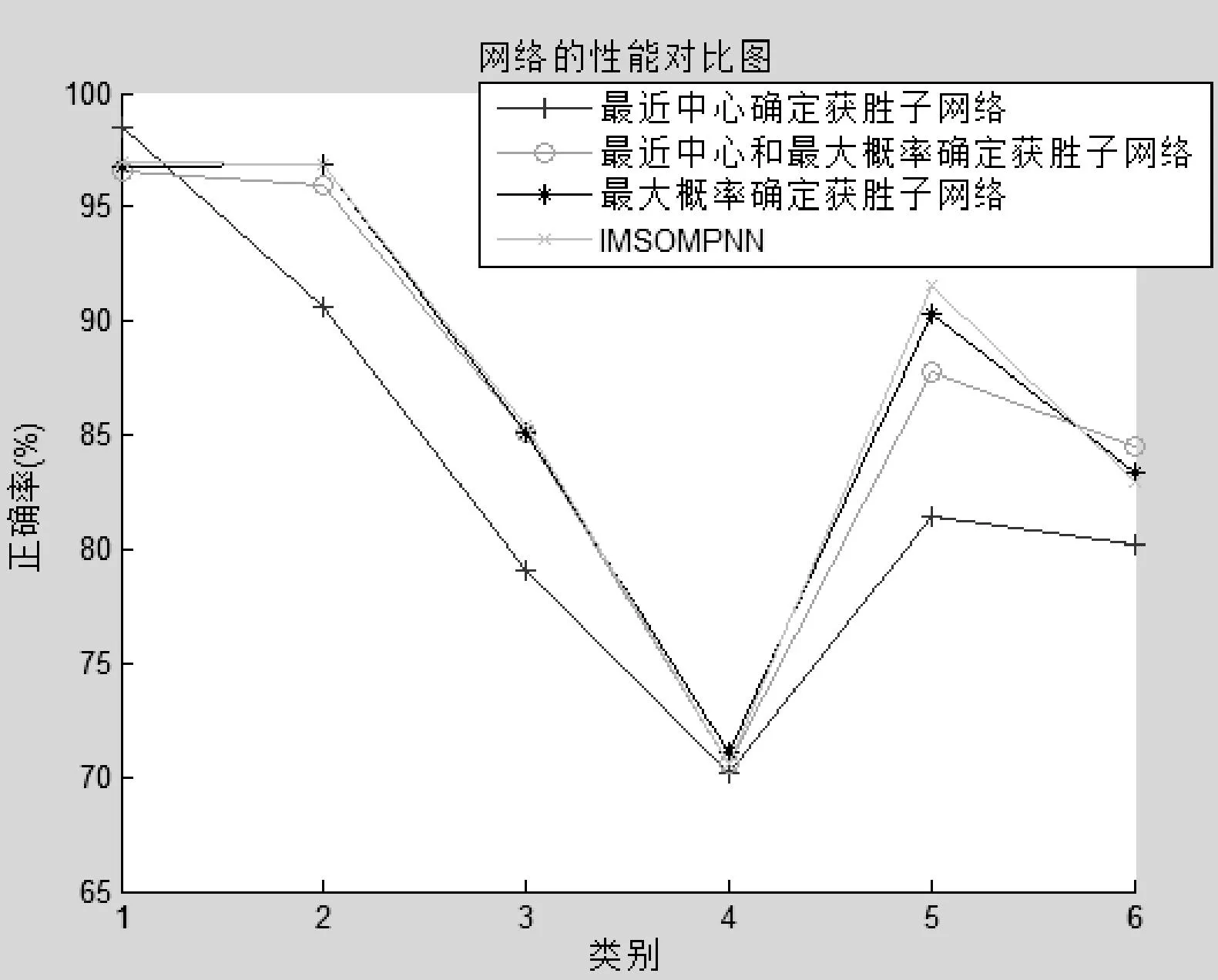

圖6為四種方法的性能對比圖。從結(jié)果和性能對比圖上可以看出最近中心確定獲勝子網(wǎng)絡(luò)的性能比較低,其他三種方法的性能相差不多,都沒有遺忘已學知識,同時也可以學習新類別的知識,每次增量學習只增加一個子網(wǎng)絡(luò),避免了網(wǎng)絡(luò)系統(tǒng)過于龐大的問題。

圖6 單類別學習性能對比圖

IMSOMPNN對六類知識學習需要學習六次,也就是每次只能學習一個類別的知識,不能進行多個類別知識的學習,會使得學習過程很繁瑣,不具有實用性。多類別增量學習實驗證實了該網(wǎng)絡(luò)可以進行多個類別的增量學習,表5給出了實驗結(jié)果。通過實驗表明了本文的方法既可以單個類別的增量學習,也可以進行多類別的增量學習,即在第3步增量學習中,同時學習了類別4和類別5的知識,這是IMSOMPNN所不能實現(xiàn)的,在現(xiàn)實生活中多類別的增量學習更具有使用價值。

從以上實驗可知,本文方法每次增量學習只增加了一個子網(wǎng)絡(luò),避免了網(wǎng)絡(luò)系統(tǒng)過于龐大的問題,同時在保證性能基本不變的基礎(chǔ)上實現(xiàn)了多個類別的學習,具有實用意義。

4結(jié)語

本文提出了一種基于RBF的集成增量學習的神經(jīng)網(wǎng)絡(luò)。這種增量學習模型主要是通過最近中心法、最大概率法以及以上兩種方法相結(jié)合的方法來決定獲勝子網(wǎng)絡(luò),通過獲勝網(wǎng)絡(luò)進而得到最終輸出。這種增量學習系統(tǒng)是建立在系統(tǒng)穩(wěn)定的基礎(chǔ)上進行增量學習的,所以對已學知識沒有遺忘,同時避免了逐個類別訓練的繁瑣性和網(wǎng)絡(luò)系統(tǒng)過于龐大的問題。該算法通過確定獲勝子網(wǎng)絡(luò)的方法進行確定獲勝子網(wǎng)絡(luò),最終結(jié)果由獲勝子網(wǎng)絡(luò)進行輸出。獲勝子網(wǎng)絡(luò)中可能包含單類別信息,也可能包含多個類別的信息,從而既可以實現(xiàn)單類別增量學習,也可以實現(xiàn)多個類別的增量學習,通過實驗論證了該方法的有效性。

參考文獻

[1]GrossbergS.Nonlinearneuralnetworks:Principles,mechanismsandarchitectures[J].NeuralNetworks,1988,1(1):17-61.

[2]PolikarR,UpdaL,UpdaSS,etal.Learn++:Anincrementallearningalgorithmforsupervisedneuralnetworks[J].Systems,Man,andCybernetics,PartC:ApplicationsandReviews,IEEETransactionson,2001,31(4):497-508.

[3]MinkuFL,InoueH,YaoX.Negativecorrelationinincrementallearning[J].NaturalComputing,2009,8(2):289-320.

[4] 林民龍.基于神經(jīng)網(wǎng)絡(luò)集成的增量式學習[D].中國科學技術(shù)大學,2012.

[5]WangN,ErMJ,MengX.Afastandaccurateonlineself-organizingschemeforparsimoniousfuzzyneuralnetworks[J].Neurocomputing,2009,72(16):3818-3829.

[6] 胡蓉,徐蔚鴻,甘嵐.一種連續(xù)增量學習模糊神經(jīng)網(wǎng)絡(luò)[J].模式識別與人工智能,2013,26(8):794-799.

[7] 夏長亮,王明超.基于RBF神經(jīng)網(wǎng)絡(luò)的開關(guān)磁阻電機單神經(jīng)元PID控制[J].中國電機工程學報,2005,25(15):161-165.

[8] 鄧繼雄,李志舜,梁紅.確定RBF神經(jīng)網(wǎng)絡(luò)參數(shù)的新方法[J].微處理機,2006,27(4):48-49.

[9] 劉小華,劉沛,張步涵,等.逐級均值聚類算法的RBFN模型在負荷預測中的應用[J].中國電機工程學報,2004,24(2):17-21.

[10] 李鑫濱,楊景明,丁喜峰.基于遞推k-均值聚類算法的RBF神經(jīng)網(wǎng)絡(luò)及其在系統(tǒng)辨識中的應用[J].燕山大學學報,1999,23(4):363-366.

[11] 王永驥,涂健.神經(jīng)元網(wǎng)絡(luò)控制[M].北京:機械工業(yè)出版社,1998:68.

[12]YuDJ,ShenHB,YangJY.SOMPNN:anefficientnon-parametricmodelforpredictingtransmembranehelices[J].Aminoacids,2012,42(6):2195-2205.

[13] 戚湧,胡俊,於東軍.基于自組織映射與概率神經(jīng)網(wǎng)絡(luò)的增量式學習算法[J].南京理工大學學報:自然科學版,2013(1):1-6.

RESEARCH ON RBF NEURAL NETWORK-BASED ENSEMBLE INCREMENTALLEARNINGALGORITHM

Peng YuqingZhao CuicuiGao Qingqing

(School of Computer Science and Engineering,Hebei University of Technology,Tianjin 300401,China)

AbstractAiming at the forgetfulness problem of incremental learning and the excessive network growth problem of the integrated incremental learning, this paper proposes an integrated incremental learning method which is based on the radial basis function (RBF) neural network. In order to avoid the forgetfulness of the network, for each knowledge learning of new category we all trained an RBF neural network, and added the newly trained RBF neural network to the integrated system so as to form a large system of neural networks. To determine the winning sub-network, we adopted the nearest centre method, the maximum probability method and the combination of these two methods, and the final result was outputted by the winning sub-network. Moreover, we introduced the prototype vectors of self-organising map to maximum probability method for solving the problem of class centre similarity. For verifying the proposed network incremental learning, we made the experiments using the Statlog (Landsat Satellite) dataset in UCI machine learning library. Experimental results showed that after learning the knowledge of new category, this network could accept the new without forgetting the learned knowledge.

KeywordsRBFSOMIncremental learning

收稿日期:2015-01-13。國家自然科學基金項目(51175145);天津市自然科學基金項目(13JCYBJC15400);河北省高等學校科學技術(shù)研究項目(ZD2014030)。彭玉青,教授,主研領(lǐng)域:計算機視覺,數(shù)據(jù)庫,智能信息處理。趙翠翠,碩士生。高晴晴,碩士生。

中圖分類號TP183

文獻標識碼A

DOI:10.3969/j.issn.1000-386x.2016.06.059