一種基于雙目立體視覺的測量方法*

于 振 劉書桂

(精密測試技術及儀器國家重點實驗室(天津大學),天津 300072)

?

一種基于雙目立體視覺的測量方法*

于振劉書桂

(精密測試技術及儀器國家重點實驗室(天津大學),天津 300072)

以雙目立體視覺理論為基礎,提出了一種基于射線交匯法的雙目模型。標定好雙目系統后,使用Harris算法提取圖像中的特征點,經過立體匹配,求出特征點在相機坐標系下的三維坐標,從而計算出任意點間的距離,并通過理論推導證明其比另一種雙目模型計算出的結果更精確。實驗表明該方法能夠較精確的對物體實現三維測量。

射線交匯法;雙目模型;三維測量

雙目立體視覺由于結構靈活、安裝方便、成本低而被廣泛采用。其作為計算機視覺的一個分支,是利用2臺攝像機同時對物體拍照,根據景物點在左右攝像機圖像上的位置關系計算出景物點的三維坐標,從而可以實現三維測量和恢復。由于結構簡單、數據采集方便迅速、屬于非接觸式測量,可以應用于各種復雜惡劣的環境中。雙目視覺被廣泛應用于三維檢測、機器人導航、醫學成像等領域[1],物體三維測量一直是人們研究的熱點。目前大多數研究集中在攝像機標定[2-3]特征匹配[4-5]及精度分析[6]等方面。為了獲得較高的三維測量精度,很多專家學者更是將研究重點放在了特征匹配部分,提出了如快速雙邊濾波算法[7]、 基于自適應權重的三邊濾波算法[8]、迭代優化的自適應權重算法[9]以及二進制立體匹配算法BSM[10]等方法。本文立足于雙目測量理論的基礎——雙目模型,提出了一種基于射線交匯法的簡單雙目模型,并與另一種基于三角法的雙目模型[11]進行了比對。通過誤差分析,在理論上證明了基于射線交匯法的雙目模型比基于三角法的雙目模型有更高的精度,并通過實驗以及實驗后的結果分析,驗證了這一觀點。

1 實驗裝置

1.1攝像機及試驗臺架

如圖1所示,系統采用兩臺型號參數一致的高分辨率低畸變CCD攝像機,安裝在與各攝像機相配的攝像機三腳架上,通過調節攝像機三腳架使兩臺攝像機之間的間距、夾角及高度可以任意調節,以滿足不同的工作距離及有效視場范圍的要求。測量誤差與兩鏡頭光軸夾角及基線距離間存在復雜的函數關系,在滿足工作距離及有效視場的前提下,系統誤差隨基線距增大而減小,且當基線與光軸的夾角在40°~60°之間取值時,平均綜合測量誤差達到最小值[12]。

1.2照明光源

如圖2所示,系統采用DLP投影儀作為光源。通過設計程序和分屏控制,讓投影儀分別投影出不同的圖案以方便測量。當對攝像機進行標定時,通過向棋盤格投影白光,從而使各像機像平面上的棋盤格成像更加清晰。當進行測量實驗時,可以通過投影不同的圖案以方便提取所測物體上的特征點并進行特征匹配,從而對物體三維形貌進行密集測量。

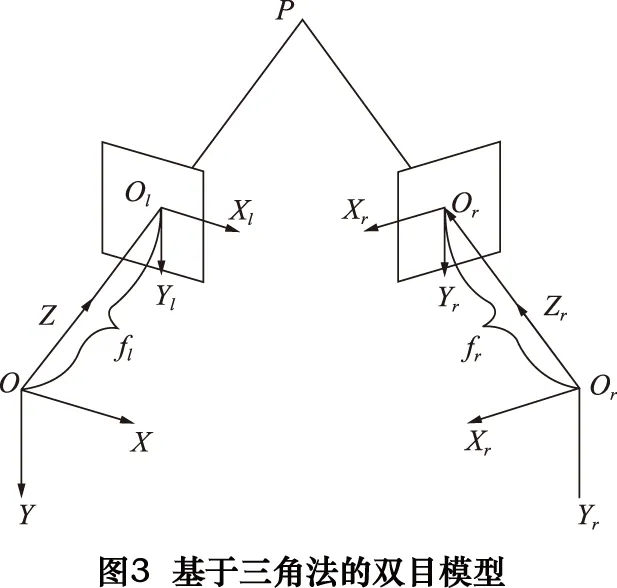

實驗采用兩臺型號參數一致的高分辨率低畸變CCD攝像機進行,為了提高結果的可靠性分別按照圖3、圖4的方法進行了3組獨立重復實驗,每次實驗中分別使用左、右攝像機各拍攝一幅圖像,再轉換標定板的擺放方式,繼續在左右拍攝點拍攝得到左右圖像,依此類推。

2 兩種雙目模型測量效果比對

2.1基于三角法的雙目模型[11]

如圖3所示,設左攝像機坐標系與世界坐標系重合,記為OXYZ,左攝像機圖像坐標系為OlXlYl,有效焦距為fl;右攝像機坐標系為OrXrYrZr,其圖像坐標系為OrXrYr,有效焦距為fr,P點為公共視野內的待測點。

根據攝像機透視變換模型可知,在傳感器坐標系下被測點與各攝像機像面點之間的對應變換關系分別為:

(1)

(2)

當左攝像機與世界坐標系重合時,設左攝像機有效焦距fl,右攝像機有效焦距fr,兩攝像機之間的位置關系為:

(3)

其中M=[RT],

R和T分別為左攝像機坐標系(世界坐標系)與右攝像機坐標系之間的旋轉矩陣和原點之間的平移向量。此時,在傳感器坐標系下表示的空間被測點與兩攝像機像面點之間的對應變換關系分別為:

(4)

(5)

由此,空間點三維坐標可以表示為:

(6)

(7)

(8)

(9)

(10)

式(6)~(10)便是基于三角法的雙目立體視覺模型的數學描述。如果旋轉矩陣R和平移矩陣T已知,通過兩攝像機像面點像素坐標(uldl,vld)和(urd,vrd)即可求解空間點的三維坐標(x,y,z)。

2.2基于射線交匯法的雙目模型

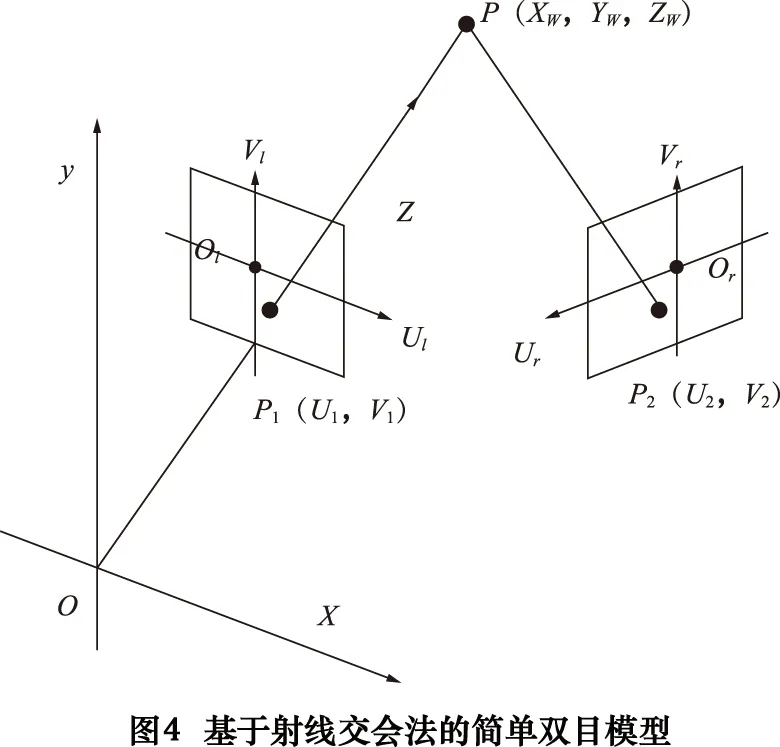

圖4所示為基于射線交匯法的簡單雙目模型,設世界坐標系為OXYZ,左攝像機圖像坐標系為OlUlVl,右攝像機圖像坐標系為OrUrVr,假定空間任意點P的世界坐標為(Xw,Yw,Zw),點P在兩臺攝像機的成像平面上的像點分別為P1與P2,P1和P2的像素坐標分別為:(U1,V1)和(U2,V2),兩攝像機的投影矩陣分別為:

(11)

(12)

根據攝像機的成像模型有攝像機坐標系與世界坐標系之間的轉換關系可表示為:

(13)

(14)

其中:zf1和zf2分別為空間點P在兩臺相機的光心坐標系中沿光軸方向的坐標值,M1=A1R1T1,M2=A2R2T2;A1、A2分別為左右攝像機的內參矩陣,R1、T1分別為左攝像機坐標系相對于世界坐標系的旋轉矩陣和相對于原點之間的平移向量,R2、T2分別為右攝像機坐標系相對于世界坐標系的旋轉矩陣和相對于原點之間的平移向量。

設左攝像機坐標系與世界坐標系重合,則此時:

(15)

M2=

(16)

由此得:

(17)

(18)

展開整理得到:

-flxx+(u1-uol)z=0

(19)

-flyy+(v1-vol)z=0

(20)

(21)

(22)

對于等式(19)-(22),為方便計算用矩陣形式表示如下:

Kq=l

(23)

K=

(24)

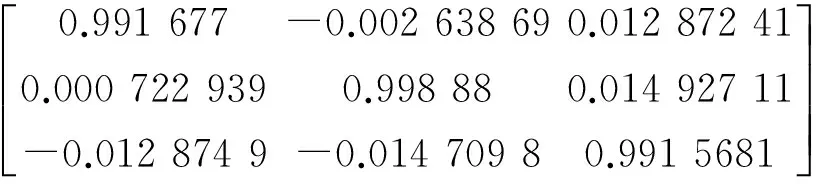

(25)

(26)

由于K不是方陣,為方便計算先求KTK,進而求得:

q=(KTK)-1KTl

(27)

(28)

上述討論表明:只要知道兩臺攝像機的內參矩陣和兩臺攝像機間的旋轉、平移矩陣,便可由空間一點分別在兩臺像機像平面上的坐標求出空間點的三維坐標。

2.3特征點提取和匹配

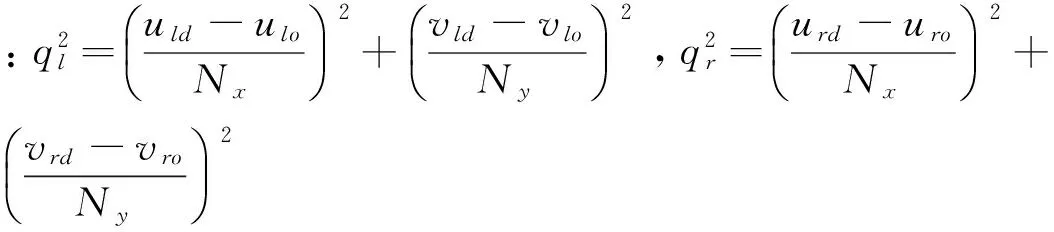

為了精確提取空間中點在兩像機像平面的坐標對,首先使用Harris算法提取圖像中的點作為特征點。其原理如下:

設定一個特定大小的窗口,讓此窗口在圖像上移動,以便圖像灰度變化進行檢測。圖5a為窗口在平滑區域移動時的情況,可見窗口周邊各方向的灰度沒有變化。圖5b為窗口在邊緣上移動時的情況,可見窗周邊各方向的灰度也沒有變化。圖5c為窗口在角點處移動的情況,可見窗口周邊各個方向的灰度有明顯變化。Harris算法正是利用了這個直觀的物理現象,通過窗口周邊各個方向上的灰度變化程度,來檢測角點。

特征點提取完成之后,需要對兩幅圖像上提取到的特征點進行匹配。匹配時需要先進行粗匹配,利用特征點附近的特征信息,參考圖像和待匹配圖像有相似尺度和灰度信息,以參考圖像作為模板在待匹配的圖像上遍歷,計算每個位置參考圖像和待匹配圖像對應位置的互相關度,建立一個局部匹配的準則,將Harris算法檢測結果(兩個特征點集合),劃分為多個一對一匹配對。

粗匹配之后,需要根據Ran sac算法[1]對粗匹配中的錯誤匹配點對進行剔除。Ran sac算法根據一組包含異常數據的樣本數據集,計算出數據的數學模型參數得到有效樣本數據。其基本假設是樣本中包含正確數據(Inliers,可以被模型描述的數據),也包含異常數據(Outliers,偏離正常范圍很遠、無法適應數學模型的數據)。異常數據可能是由于錯誤的測量、錯誤的假設、錯誤的計算等產生。同時Ran sac算法也假設,給定一組正確的數據,存在可以計算出符合這些數據的模型參數的方法。精匹配中使用的Ran sac算法基本思想描述如下:

(1)考慮一個最小抽樣集的勢為n的模型(n為初始化模型參數所需的最小樣本數)和一個樣本集P,集合P的樣本數>n,從P中隨機抽取包含n個樣本的P的子集S初始化模型M。

(2)Sc=P/S中與模型M的誤差小于某一設定閾值t的樣本集以及S構成S*。認為S*是內點(Inliers)集,它們構成S的一致集(Consensus set)。

(3)若S*≥N,認為得到正確的模型參數,并利用集S*采用最小二乘法等方法重新計算新的模型M*;重新隨機抽取新的S,重復以上過程。

(4)在完成一定的抽樣次數后,若找到的抽樣結果為一致集,則算法失敗,否則選取抽樣后得到的最大一致集判斷內外點,算法結束。

2.4模型誤差比對

通過將兩種模型進行對比可發現,基于三角法的測量模型沒有考慮到鏡頭畸變的問題,而基于射線交匯法的測量模型由于是從最原始的像機模型出發,考慮到了像平面中心的變化,通過將提取到的左右像機像平面坐標與標定出的左右像平面中心進行做差運算,之后再代入像機模型,從而消除了鏡頭畸變的影響。因此,基于射線交匯法的測量模型比基于三角法的測量模型有更好的精度。兩者之間的誤差計算方法如下:

文獻[11]中將畸變分為x方向上畸變和y方向上畸變,兩種畸變都分別由徑向畸變、偏心畸變和薄棱鏡畸變3種畸變組成。在正常情況下,徑向畸變已經足以描述模型中的畸變,因此只考慮徑向畸變即可。對于徑向畸變描述如下:

(29)

(30)

(31)

由此得系統誤差為:

(32)

(33)

2.5實驗與效果比對

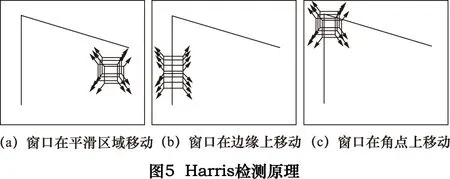

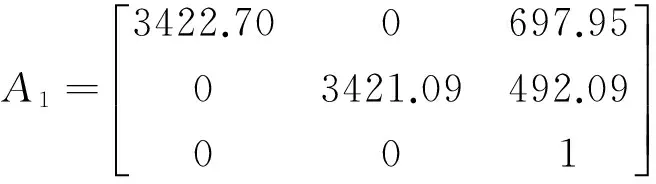

實驗中采用兩臺型號參數一致的高分辨率低畸變CCD攝像機進行實驗,分別按照圖3、圖4的方法進行了實驗,每次實驗中分別使用左、右攝像機各拍攝一幅圖像,再變換標定板的擺放方式,繼續在左右拍攝點拍攝以得到左右圖像,依此類推。實驗采用左、右各12幅圖像來標定,圖像大小為1280×1024,標定重投影誤差為0.6像素。雙目系統標定所得內外參如下:

左右像機內參為:

左右像機畸變系數為:

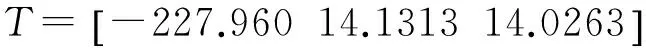

兩像機間的外參為:

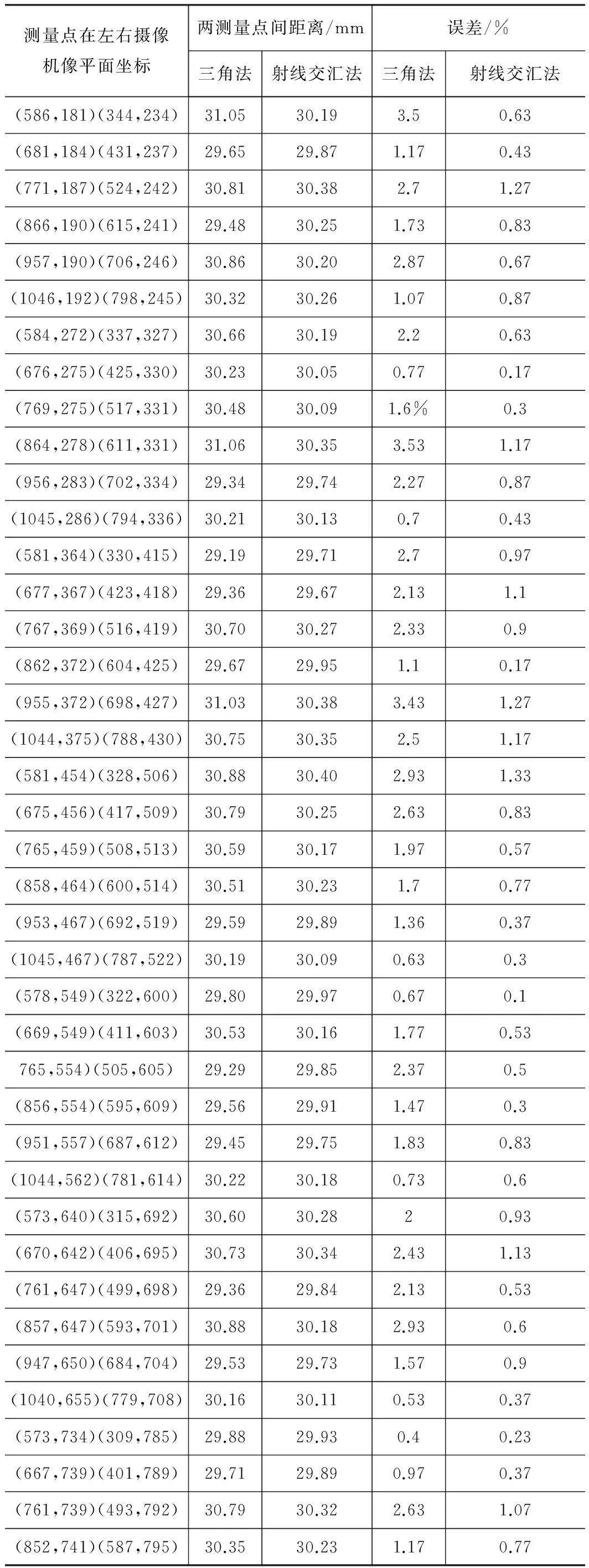

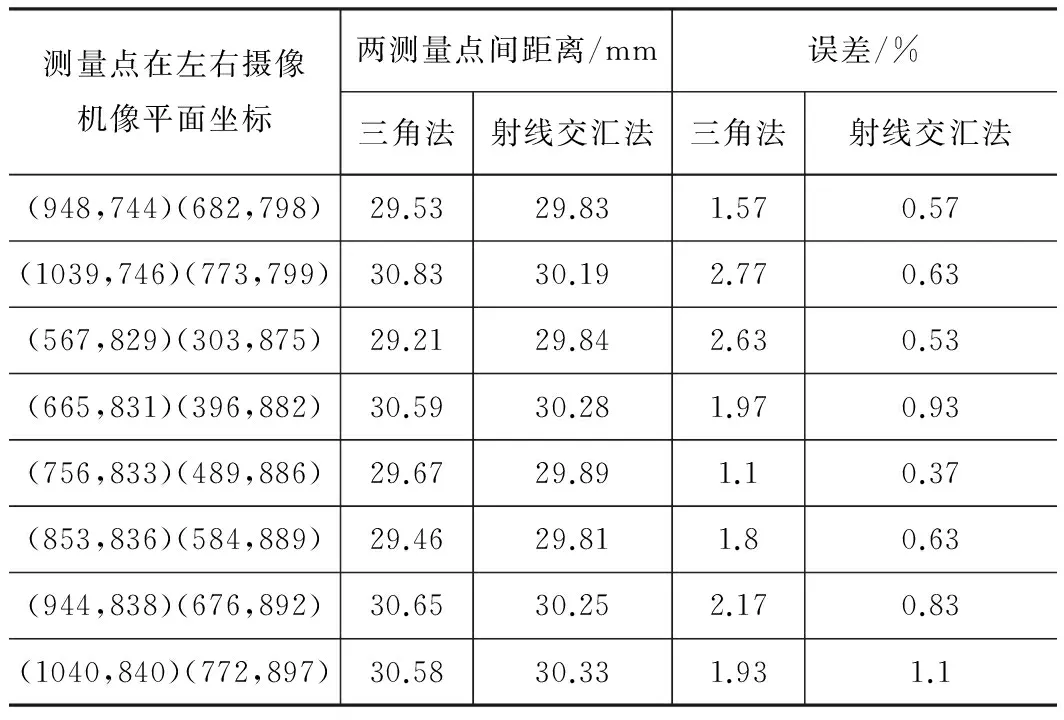

對左右攝像機分別進行單目標定,在得到像機內參之后,再進行立體標定從而得到兩像機間的旋轉平移矩陣,然后進行立體匹配以獲取某些對應的匹配點。如圖6所示,分別將得到的高精度標定板上的多組匹配點對代入前文介紹的兩種模型,從而測量這些點對間的距離。特征點提取和匹配效果如圖7所示,得到的實驗數據如表1所示。

3 結語

(1)在標定精度、提取精度、匹配精度、測量距離、像機主軸與Z軸夾角、基線長度、外界光線影響等影響因素都相同的情況下,基于射線交匯法的雙目模型比基于三角法的雙目模型有更高的測量精度。

(2)由實驗數據可知,在攝像機標定和立體匹配后,根據提出的簡單的雙目模型算法,對高精度標定板上兩點間的距離進行測量,測量誤差都是小于1.5%,可見該算法還是能達到一定的精度。

表1各模型代入相同標定參數后對同一標準件測量結果比較

測量點在左右攝像機像平面坐標兩測量點間距離/mm誤差/%三角法射線交匯法三角法射線交匯法(586,181)(344,234)31.0530.193.50.63(681,184)(431,237)29.6529.871.170.43(771,187)(524,242)30.8130.382.71.27(866,190)(615,241)29.4830.251.730.83(957,190)(706,246)30.8630.202.870.67(1046,192)(798,245)30.3230.261.070.87(584,272)(337,327)30.6630.192.20.63(676,275)(425,330)30.2330.050.770.17(769,275)(517,331)30.4830.091.6%0.3(864,278)(611,331)31.0630.353.531.17(956,283)(702,334)29.3429.742.270.87(1045,286)(794,336)30.2130.130.70.43(581,364)(330,415)29.1929.712.70.97(677,367)(423,418)29.3629.672.131.1(767,369)(516,419)30.7030.272.330.9(862,372)(604,425)29.6729.951.10.17(955,372)(698,427)31.0330.383.431.27(1044,375)(788,430)30.7530.352.51.17(581,454)(328,506)30.8830.402.931.33(675,456)(417,509)30.7930.252.630.83(765,459)(508,513)30.5930.171.970.57(858,464)(600,514)30.5130.231.70.77(953,467)(692,519)29.5929.891.360.37(1045,467)(787,522)30.1930.090.630.3(578,549)(322,600)29.8029.970.670.1(669,549)(411,603)30.5330.161.770.53765,554)(505,605)29.2929.852.370.5(856,554)(595,609)29.5629.911.470.3(951,557)(687,612)29.4529.751.830.83(1044,562)(781,614)30.2230.180.730.6(573,640)(315,692)30.6030.2820.93(670,642)(406,695)30.7330.342.431.13(761,647)(499,698)29.3629.842.130.53(857,647)(593,701)30.8830.182.930.6(947,650)(684,704)29.5329.731.570.9(1040,655)(779,708)30.1630.110.530.37(573,734)(309,785)29.8829.930.40.23(667,739)(401,789)29.7129.890.970.37(761,739)(493,792)30.7930.322.631.07(852,741)(587,795)30.3530.231.170.77

測量點在左右攝像機像平面坐標兩測量點間距離/mm誤差/%三角法射線交匯法三角法射線交匯法(948,744)(682,798)29.5329.831.570.57(1039,746)(773,799)30.8330.192.770.63(567,829)(303,875)29.2129.842.630.53(665,831)(396,882)30.5930.281.970.93(756,833)(489,886)29.6729.891.10.37(853,836)(584,889)29.4629.811.80.63(944,838)(676,892)30.6530.252.170.83(1040,840)(772,897)30.5830.331.931.1

(3)由于標定誤差、人為誤差、特征點提取誤差及其他因素的影響,如立體匹配時互相關匹配只查找兩幅圖像之間的強匹配點(即強紋理),Ran sac算法也只是剔除錯誤的匹配點,并沒有檢測到漏匹配點對等,這些因素都導致了兩點間距離的測量精度有一定的波動。

(4)基于射線交匯法的雙目模型相比于基于三角法的雙目模型考慮到了左、右像機像平面中心的變化帶來的影響,通過將提取到的左右像機像平面坐標與標定出的左右像平面中心進行做差運算,消除了鏡頭畸變的影響。因此,基于射線交匯法的測量模型比基于三角法的測量模型有更好的精度。

[1]章毓晉.圖像理解與計算機視覺[M].北京:清華大學出版社,2011.

[2]Bouguet J Y. Camera calibration toolbox for matlab[DB/OL].http://www.vision.caltech.edu/bouguetj/calib_doc/index.html.2013.

[3]Song X, Yang L,Liu Z. An improved two view convergent-style-based disparity estimation algorithm [C]. International Conference on Audio, Language and Image Processing, 2012:698-704.

[4]單潔,唐篧,姜暉.雙目立體相機中實時匹配算法的FPGA實現[J].激光與紅外, 2013, 43(12):1406-1410.

[5]NingKelin, Zhang Xiaoying, Ming Yue. Stereo matching algorithms with different cost aggregation[J].Proceedings of International Conference on Computer Science and Information Technology,2014(1):647-653

[6]Lorenzo Solrgi. Two-view geometry estimation using the Rodrigues rotation formula[C]. 18th IEEE International Conference on Image Processing (ICIP),2011:1009 - 1012.

[7]Rhemann C, Hosni A, Bleyer M, et al.Fast cost-volume filtering for visual correspondence and beyond [C].In Computer Vision and Pattern Recognition (CVPR), 2011 IEEE Conference on IEEE,2011:3017-3024.

[8]Chen D, Ardabilian M, Chen L.A novel trilateral filter based adaptive support weight method for stereo matching[J].BMVC,2013:318.

[9]Psota E T, Kowalczuk J, Carlson J, et al. A local iterative refinement method for adaptive support-weight stereo matching [C].International Conference on Image Processing, Computer Vision, and Pattern Recognition,2011:271-277.

[10]Zhang K, Li J, Li Y, et al.Binary stereo matching[C].In Pattern Recognition (ICPR), 2012 21st International Conference on IEEE,2012:356-359.

[11]邾繼貴.視覺測量原理與方法[M].北京:機械工業出版社,2012.

[12]劉瑜.劉纏牢.蘇海.一種基于結構光雙目視覺的特征匹配算法研究[J].光學儀器,2014,36(2):161-166.

如果您想發表對本文的看法,請將文章編號填入讀者意見調查表中的相應位置。

A measurement methodbased on the binocular stereo vision theory

YU Zhen, LIU Shugui

(State Key Laboratory of Precision Measuring Technology&Instrument, Tianjin University, Tianjin 300072, CHN)

A binocular method on account of ray intersection models is proposed based on the binocular stereo vision theory. After the binocular system is calibrated, using the Harris algorithm to extract the feature points of the images. Then the three-dimensional coordinates of the feature points in the camera coordinate system is obtained after stereo matching in order to calculate the distances between any points. And it is provided to be more accurate than another results which are calculated by the other binocular model. Experimental results show that this method can achieve more accurate three-dimensional measurement of objects.

ray intersection method; binocular model;three-dimensional measurement

TP391.41

B

10.19287/j.cnki.1005-2402.2016.08.028

(編輯李靜)(2016-06-21)

160839

* 天津自然科學基金重點項目(13JCZDJC34500)