基于Haar-CNN模型的自然場景圖像分類的研究

張慧娜, 李裕梅, 傅鶯鶯

(北京工商大學 理學院, 北京 100048)

基于Haar-CNN模型的自然場景圖像分類的研究

張慧娜, 李裕梅*, 傅鶯鶯

(北京工商大學 理學院, 北京 100048)

研究基于Haar-CNN模型的圖像特征提取用于自然場景圖像分類的問題.Haar小波變換是圖像處理中常見的一種變換,可以提取圖像的局部和空間信息,并把彩色圖像的顏色、輪廓和紋理信息進行分層次的表達.卷積神經網絡(CNN)是一種得到廣泛研究與應用的深度學習模型,對圖像特征具有很好的表達能力.基于Haar小波變換和CNN模型的優勢,提出一種新的圖像特征提取方法,即Haar-CNN模型;利用該模型提取得到圖像更豐富的特征信息;然后比較基于Haar-CNN和CNN模型提取的自然場景圖像特征在分類中的效果,探究Haar-CNN模型對于自然場景圖像特征提取的優勢.再對比在不同顏色空間上Haar-CNN模型對自然場景圖像的分類效果,實驗結果表明YCbCr顏色空間上的分類精度最高,為96.2%,比灰度圖像的分類精度提高了7.8%.同時,進一步分析Haar-CNN模型中圖像塊大小、隱藏層神經元個數、池化區域大小、模型深度等參數對圖像分類精度的影響,實驗結果表明參數選擇對圖像分類很重要,合適的參數選擇可以提高分類精度.

圖像分類; 深度學習; Haar-CNN模型; 顏色空間

隨著高新技術的創新和發展,人工智能和機器學習越來越受到研究者們的關注.如何利用計算機自動提取特征和自動進行圖像分類,已經發展成人工智能和計算機視覺領域的重要研究課題之一.自然場景圖像分類是基于圖像分析[1]開展起來的,在模式識別和人工智能中有著重要的作用.圖像分類一般需要人為構造有效底層特征(如顏色特征:顏色直方圖[2]、顏色矩[3]、顏色相關圖[4]等;形狀特征:HOG[5]、BOVW[6]、SIFT[7]等;紋理特征:LBP[8]、灰度共生矩陣[9]等),然后將提取得到的特征送入分類器進行分類.隨著研究的不斷深入,發現人為構造的底層特征已不能夠很好地表達圖像的內容,特征嚴重冗余且維數高,泛化能力差,于是如何從原始圖像中自主學習出高層特征已成為研究熱點.

CNN模型[10]是深度學習中一種有效的自主學習特征的方法,可以從原始圖像中重構圖像的高層語義特征,利用權值共享提高訓練性能.目前該模型已成功應用于手寫字符識別[11]、人臉識別[12]、MNIST識別[13]等領域,在圖像分類[14]中表現出很好的效果,受到了許多研究者的關注.

Haar小波變換是常用的一種變換分析方法,通過低通和高通濾波器把圖像分解為:低通低通(LL)、低通高通(LH)、高通低通(HL)和高通高通(HH)的表示.LL分量圖像是在原圖像上進行降采樣得到,在不顯著降低質量的前提下對信號進行壓縮和消噪等處理,同時也對原圖的顏色特征進行了更集中的表達,LH、HL和HH分量將提取圖像水平、垂直和對角的輪廓和紋理信息,在信號分析、圖像處理和計算機視覺領域應用十分廣泛[15].

彩色圖像在圖像中包含豐富的顏色信息.相比于灰度圖像,彩色圖像在模式識別中具有更加豐富的特征信息,尤其是在圖像分類的應用中[16].目前已有研究者探究Haar小波變換和顏色空間對圖像分類效果的影響.將Haar小波變換用到各個顏色空間上對圖像進行變換,然后提取出的特征對圖像分類效果更佳[17].

針對人工構造提取特征算法繁瑣,特征信息嚴重冗余,泛化能力差的問題,本文結合了Haar小波變換和CNN的優勢,提出一種新的圖像特征提取方法:Haar-CNN模型,對比傳統CNN模型與Haar-CNN模型在自然場景圖像特征提取和分類中的性能,通過在自然場景圖像庫中實驗,探究了Haar-CNN模型在不同顏色空間中對自然場景圖像分類的效果,分析了Haar-CNN模型中圖像塊大小、隱藏層神經元個數、池化塊大小、神經網絡的深度等參數對分類結果的影響.

合適的參數選擇可以提高Haar-CNN模型對自然場景圖像分類的精度.實驗結果還表明Haar-CNN模型提取了更豐富的局部和空間信息,后續分類效果優于傳統CNN模型提取出來的特征,在YCbCr顏色空間上的分類效果最高,為96.2%,比灰度圖像的分類精度提高了7.8%.

1 深度學習模型介紹

1.1 稀疏自編碼器 自編碼神經網絡[18]是一種無監督學習算法,讓輸出值等于輸入值,嘗試學習一個恒等函數hw,b(x)≈x,其中

w1和b1為第一層的權值和偏置項,w2和b2為第二層的權值和偏置項,f和g為激活函數.圖1是最典型的自編碼神經網絡結構,該結構包含了一個輸入層、一個隱藏層和一個輸出層.

如果輸入數據之間存在特定關系,自編碼神經網絡就能通過編碼和解碼過程發現數據間的相關性.當隱藏層神經元個數小于輸入層和輸出層神經元個數時,則從輸入層到隱藏層將迫使該網絡對輸入數據進行壓縮表示,這是編碼過程.然后,從隱藏層到輸出層重構原來的數據,這是解碼過程.相反,如果隱藏層神經元個數大于或等于輸入層和輸出層時,對該網絡結構引入稀疏性限制仍能挖掘出原始數據之間的關聯性.加入稀疏性限制后,稀疏自編碼網絡的整體代價函數為

式中,第一項是均方誤差項,用來衡量輸入數據和重構數據之間的誤差;第二項是權重衰減項,用來減小權重的幅度,防止過度擬合;第三項是稀疏項

其中

表示隱藏層神經元的平均激活度,稀疏性由ρ值來調節,β控制稀疏性懲罰因子的權重.將輸入數據經過自編碼神經網絡模型的訓練,通過控制該網絡的整體代價函數,待迭代算法收斂或達到最大收斂次數,就訓練好了該神經網絡的權值w和偏置值b.

1.2CNN模型CNN最早出現于20世紀80年代,文獻[19-20]開啟了深度學習的大門,使得CNN受到了廣泛的關注和應用.CNN模型是建立在傳統人工神經網絡上的一種深度學習算法,也是第一個成功訓練多層網絡的學習算法.

傳統的CNN模型由卷積層和降采樣層交替構成,通過局部感受野、權值共享和降采樣來獲得縮放和旋轉不變性[10].通過局部感受野,神經元可以提取低層的特征;權值共享大大減少了卷積神經網絡的參數,提高計算效率;降采樣降低了噪聲和旋轉對圖像特征的影響,增強了特征的泛化能力.圖2展示了灰度圖像基于CNN模型的圖像特征提取過程.該模型包括一個卷積層、一個池化層和一個全連接層,是基本的CNN網絡結構.如果對于彩色圖像,將其R、G、B通道分別送入CNN模型提取特征,然后將特征融合到一起得到彩色圖像的CNN特征.

卷積操作是CNN的核心,其作用類似圖像的邊緣檢測,其中,卷積層中每個神經元的權值矩陣稱為卷積核.該模型中,每一個特征圖與前一層的部分特征圖建立聯系,輸入圖像和卷積核進行卷積,通過激活函數形成S1特征圖.一般地,當前層的輸入可以表示為

其中,l表示層數,W和b表示由稀疏自編碼已訓練好的當前層的權值和偏置項,g代表激活函數,通常為sigmoid或tanh函數,在卷積層后對輸出結果進行調整.

池化層是為了防止特征過擬合,減小計算量,對卷積后特征的不同位置進行降采樣的操作.本文實驗采用最大池化的方式,將池化后的特征通過一個全連接網絡(特征融合),得到最終特征.

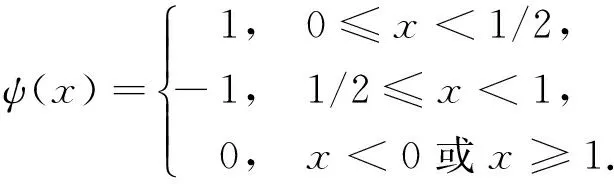

1.3Haar-CNN模型 小波分析是一種信息窗口大小固定但其形狀、時間窗和頻率窗都可以改變的時頻局部化分析方法.Haar小波變換[21]是其中的一種,通過加強局部對比提取局部特征,由尺度和小波基函數形成.Haar尺度函數可以定義為

一族函數通過尺度和變換從尺度基函數中產生

Harr小波函數可以定義為

Haar小波通過尺度和變換從母波基函數中產生

圖3展示了灰度圖像Haar小波變換的過程,通過低通和高通濾波器將灰度圖像分解成低通低通(LL)、低通高通(LH)、高通低通(HL)和高通高通(HH)4個部分.圖4展示了彩色圖像Haar小波變換的過程,對圖像進行了分層次的表達,對彩色圖像R、G、B通道分別進行類似灰度圖像Haar小波變換的過程,最后對3個通道得到的變換圖像進行抓取得到彩色圖像Haar小波變換的圖像.顯然,LH、HL和HH展現了彩色圖像水平、垂直和對角方向的輪廓和紋理信息,且圖像最主要的信息都集中在低頻子圖LL中,去掉圖像的高頻部分并不影響對圖像的理解,LL分量很好地表達了彩色圖像的主要信息,故實驗只選取LL分量提取圖像特征.

Haar-CNN是先對圖像進行不同水平Haar小波變換,對原始圖像做一次Haar小波變換,得到LL分量,記為LL1圖像,再對LL1做一次Haar小波變換,得到相應的LL分量,記為LL2圖像.然后對原圖像、LL1和LL2提取圖像塊(對彩色圖像R、G、B通道提取同一位置的圖像塊),并對圖像塊進行歸一化、ZCA白化的預處理過程,將其輸入到稀疏自編碼器訓練參數W和b,這是CNN參數訓練的過程.這里訓練好的參數W和b將作為CNN模型中的參數.將原圖、LL1和LL2分別輸入CNN訓練,就可以得到相應的原圖像CNN特征、Haar1-CNN特征和Haar2-CNN特征,最后將3個特征融合,得到彩色圖像的Haar-CNN特征.圖5展示了Haar-CNN特征的提取過程.

2 不同顏色空間的Haar-CNN的圖像分類

下面主要介紹5個彩色空間,分別為RGB、rgb、HSV、YCbCr和°RGB顏色空間[17].彩色圖像包含了3個顏色通道,每個像素點都可以用3個值來表示.

°RGB顏色空間是彩色圖像最常見的三基色空間,由紅色、綠色和藍色3種基色構成.其他顏色空間均是由RGB顏色空間通過線性或非線性變換而得到.

為了減小RGB圖像對光照和角度變化的影響,rgb顏色空間通過歸一化RGB顏色空間的3個通道得到.

HSV顏色空間由人類視覺系統而來,是RGB顏色空間的非線性變換

V=MAX.

YCbCr顏色空間是RGB顏色空間的線性變換

RGB顏色空間有3個通道:L、C1和C2.顏色信息包含在C1和C2中,且C1取值范圍為[-1,1],C2的取值范圍為[-0.866 0,0.866 0],L通道包含了亮度信息且其范圍為[0,1],

圖6展示了不同顏色空間中基于Haar-CNN特征的圖像分類過程.首先,將圖像轉換到5種不同的顏色空間,然后分別對每個空間中的圖像提取Haar-CNN特征,用PCA得到各個顏色空間中最具圖像表達力的特征,最后利用SVM對圖像進行分類.

3 實驗數據和實驗效果

3.1 實驗數據 本文實驗的1 000張圖像來自Corel圖像庫的圖像,且均為常見的自然圖像.Corel圖像庫[22]一共由1 000張彩色圖像構成,分10個類別:非洲人、沙灘、古建筑、公共汽車、恐龍、大象、花朵、馬、雪山和西餐.圖像大小為256×384或者384×256像素,均為彩色圖像,每類有100張圖像.圖7為Corel圖像庫中的示例圖像.

實驗中,訓練圖像和測試圖像均來自Corel圖像庫,從圖像庫的每類中隨機選取50張圖像作為訓練樣本,其余的50張圖像作為測試樣本,并記錄相應的類別標號.最終,訓練樣本共500張圖像,測試樣本共500張圖像.由于圖像大小不一致,且受到電腦內存的限制(8 G內存),這里將圖像統一縮放到100×100像素大小.

3.2 實驗結果與探討 主要比較了Haar-CNN模型和傳統CNN模型對自然場景圖像分類的效果,對比了Haar-CNN模型在不同顏色空間中對自然場景圖像的分類精度,討論了Haar-CNN模型中參數對圖像分類的影響,分析了如何選取Haar-CNN模型中的最佳參數.為保證實驗數據和結果的穩定性,訓練集和測試集將隨機選取5次,并重復實驗5次,取分類結果的均值作為最終的分類精度.

一般地,彩色圖像由RGB的3個通道組成,這里同時提取RGB 3個通道同一位置的圖像塊,將各個圖像塊按照R、G、B順序排列成一個長向量.當圖像塊的大小為8×8,且圖像塊的數量為100 000時,對圖像中RGB的每一個通道來說,將得到64×100 000大小的圖像塊特征向量,從而對彩色圖像就得到192×100 000的圖像塊特征向量,然后進行預處理并送入稀疏自編碼器去訓練,得到參數W和b,對其他顏色空間類似進行特征提取.以下實驗將采用固定其他參數,而只變化一種參數的方法來探究各個參數對圖像分類效果的影響.

3.2.1 Haar-CNN與CNN的比較 探究了Haar-CNN與傳統CNN模型對自然場景圖像的分類效果,得到Haar-CNN和CNN模型的分類精度分別為94.4%和92.8%.

由此可以看到Haar-CNN比CNN模型的分類精度提高了2.4%,Haar-CNN可以提取到更豐富的紋理信息和空間信息.

3.2.2 Haar-CNN模型在不同顏色空間上的分類效果 探究了Harr-CNN模型在5個不同顏色空間(RGB、rgb、HSV、YCbCr、°RGB)中對自然場景圖像分類的效果,如圖8所示.

從圖8中可以看出,Haar-CNN模型在YCbCr顏色空間中的分類效果最好,達96.2%,其次是°RGB、RGB、HSV、rgb顏色空間,對應的分類精度分別為95.6%、94.4%、93.8%、92.6%,而灰度圖像的分類精度為88.6%.YCbCr顏色空間上的分類精度比灰度圖像的分類精度提高了7.6%.顯然,顏色信息對圖像分類并不是冗余的,在一定程度上可以提高圖像分類的精度;因此,以下實驗將選擇YCbCr顏色空間,探究Haar-CNN模型中的參數的變化對圖像分類效果的影響.

3.2.3 圖像塊大小的影響 實驗中,圖像塊大小影響著Haar-CNN模型對圖像分類的效果.本文固定其他參數,選取8×8、16×16和32×32等3種大小圖像塊,從所有圖像中提取40 000個圖像塊對圖像進行分類,探究了當隱藏層神經元個數為50、60、70、80、90和100的條件下,3種圖像塊大小對圖像分類精度的影響,如圖9所示.

從本實驗分類效果來看,當固定其他參數時,圖像塊為16×16的分類效果最好,且對于不同的隱藏層神經元個數,16×16圖像塊的整體分類精度要普遍高于8×8和32×32圖像塊的分類精度.實驗表明,不同大小的圖像塊包含不同的特征信息,圖像塊太小不足以表達圖像的特征,圖像塊太大容易引入噪聲干擾.因此,選取合適的圖像塊大小,對圖像特征表示和圖像分類具有重要意義.

3.2.4 隱藏層神經元個數的影響 固定其他參數,探究當圖像塊選取16×16時,隱藏層神經元個數對自然場景圖像分類效果的影響,實驗結果如圖10所示.

從圖10不難發現,當固定其他參數和圖像塊大小為16×16時,圖像的分類精度隨著隱藏層神經元個數的增加而呈現出先增再減的趨勢.

當隱藏層神經元個數為50時,圖像的分類精度較低,為80%左右.當增加隱藏層神經元個數至90時,圖像分類精度迅速增加至96.5%.繼續增加隱藏層神經元個數,此時分類精度不增加,反而呈下降趨勢;因此,本文選取隱藏層神經元個數為90時就足以表達圖像特征了,其分類精度達到了96.5%.

同時,圖11進一步實驗了當圖像塊大小為8×8或32×32時,隱藏層神經元個數對圖像分類效果的影響.實驗結果與圖10一致,顯示分類精度隨著神經元個數的增加而表現出先增再減的變化趨勢.

3.2.5 池化區域大小的影響 探究當圖像塊為16×16,隱藏層神經元個數為90的情況下,池化塊區域的大小對Corel圖像庫分類精度的影響,實驗結果如圖12所示.

由圖12可知,圖像分類精度受池化區域大小的影響,并隨著池化區域大小的增加而呈現先遞增再遞減的變化趨勢.池化區域太小,不能達到減少計算量的優勢;池化區域較大,容易將不同特征聚合,干擾圖像分類的準確率.當池化區域大小為10×10時,Corel圖像庫分類精度最優,達到96.8%,因此,合適的池化區域的選取,對圖像特征的表達和圖像分類有著重要的影響.

3.2.6 網絡深度的影響 進一步研究了增加一層網絡深度對圖像分類效果的影響.Haar-CNN模型層數分別為1和2時,分類精度分別為96.2%和97.8%.由此可見,當增加Haar-CNN模型的深度時,對Corel圖像庫分類精度進一步提高.由于僅含有一層深度的Haar-CNN模型對圖像分類效果已達到較高的準確率,故再增加一層深度對圖像分類精度的提高并不是很明顯.文獻[23]說明了過多的層數也會導致過擬合,影響深度學習的泛化能力,因此,合適的模型深度對Haar-CNN模型的分類精度也有重要的影響.

4 結束語

本文結合Haar小波變換和CNN模型的優點提出Haar-CNN模型,提取了圖像時空上豐富的特征信息,提高了對圖像分類的精度.以Corel自然場景圖像庫為數據,對比了Haar-CNN模型與傳統CNN模型對自然場景圖像分類的效果,實驗結果表明:Haar-CNN可以提取更豐富的空間信息和紋理信息,明顯提高了分類精度.然后,研究Haar-CNN模型在不同顏色空間上對自然場景圖像的分類效果,更進一步表達了各個顏色空間對于顏色表達的不同程度上的重要性.同時,探究Haar-CNN模型中各類參數對圖像分類效果的影響,實驗依次研究了Haar-CNN中圖像塊大小,隱藏層神經元個數,池化區域大小,模型深度對圖像分類精度的影響,表明合適參數的選取對圖像分類效果的重要性,且可以提高分類精度.

[1] 彭輝. 基于紋理特征的圖像分類識別[J]. 計算機與信息技術,2007(10):16-20.

[2] 王向陽,楊紅穎,鄭宏亮,等. 基于視覺權重的分塊顏色直方圖檢索算法[J]. 自動化學報,2010,36(10):1489-1492.

[3] 楊紅菊,張艷,曹付元. 一種基于顏色矩和多尺度紋理特征的彩色圖像檢索方法[J]. 計算機科學,2009,36(9):274-277.

[4] 李永芳. 基于顏色相關圖和紋理矩的圖像檢索[J]. 計算機應用與軟件,2011,28(10):38-42.

[5] DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]//IEEE Conference on Computer Vision and Pattern Recognition,2005,1(12):886-893.

[6] BOLOVINOU A, PRATIKAKIS I, PERANTONIS S. Bog of spatio-visual words for context inference in scene classification[J]. Pattern Recognition,2013,46(3):1039-1053.

[7] LOWE D G. Distinctive image features from scale-invariant keypoints[J]. Inter J Comput Vision,2004,60(60):91-110.

[8] OJALA T, PIETIKAINEN M, MAENPAA T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns[C]//IEEE Transactions on Pattern Analysis and Machine Intelligence,2002,24(7):971-987.

[9] 薄華,馬縛龍,焦李成. 圖像紋理的灰度共生矩陣計算問題的分析[J]. 電子學報,2006,34(1):155-158.

[10] ZEILER M D, FERGUS R. Visualizing and Understanding Convolutional Networks[M]. New York:Springer International Publishing,2013:818-833.

[11] 高學,王有旺. 基于CNN和隨機彈性形變的相似手寫漢字識別[J]. 華南理工大學學報(自然科學版),2014,44(1):72-76.

[12] 汪濟民,陸建鋒. 基于卷積神經網絡的人臉性別識別[J]. 現代電子技術,2015,38(7):81-84.

[13] 余萍,趙繼生. 基于線性疊加特征和CNNs的圖像分類方法[J]. 微電子學與計算機,2015(10):36-40.

[14] SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition,2014:1-9.

[15] PATIDAR D, JAIN N, PARIKH A. Performance analysis of artificial neural network andKnearest neighbors image classification techniques with wavelet features[C]//International Conference on Computer Communication and Systems IEEE,2015:191-194.

[16] VERMA A, BANERJI S, LIU C. A new color SIFT descriptor and methods for image category classification[C]//Proceedings of 6th International Conference on Computer Vision,2010:1-8.

[17] BANERJI S, SINHA A, LIU C. Scene image classification:some novel descriptors[C]//IEEE International Conference on Systems, Man, and Cybernetics,2012:2294-2299.

[18] BENGIO Y. Learning deep architectures for AI[J]. Foundations and Trends in Machine Learning,2009,2(1):1-127.

[19] LECUN Y, BOSER B, DENKER J S, et al. Backpropagation applied to handwritten zip code recognition[J]. Neural Computation,2008,1(4):541-551.

[20] HINTON G E, SALAKHUTDINOV R R. Reducing the dimensionality of data with neural networks[J]. Science,2006,313(5786):504-7.

[21] BANERJI S, SINHA A, LIU C. New image descriptors based on color, texture, shape, and wavelets for object and scene image classification[J]. Neurocomputing,2013,117(14):173-185.

[22] CHAPELLE O, HAFFNER P, VAPNIK V N. Support vector machines for histogram-based image classification[J]. IEEE Transactions on Neural Networks,1999,10(5):1055-64.

[23] LAROCHELLE H, BENGIO Y, LOURADOUR J, et al. Exploring strategies for training deep neural networks[J]. J Machine Learning Research,2009,10(10):1-40.

(編輯 李德華)

Research on Natural Scene Image Classification Based on Haar-CNN Model

ZHANG Huina, LI Yumei, FU Yingying

(SchoolofScience,BeijingTechnologyandBusinessUniversity,Beijing100048)

In this paper, we Investigate natural scene image classification based on features’ extraction of Haar-CNN model. Haar wavelet transform is one of the common transforms, which extracts local information and space information by means of enhancing local contrast. The color, contour and texture information can be expressed hierarchically by Haar wavelet transform. Convolution neural network(CNN), one kind of deep learning models which has good expression ability for image features, is widely used in image classification research and applications. Based on the advantages of Haar wavelet transform and CNN model, this paper proposes a new method to extract features, which is called Haar-CNN model and it can extract rich information from images. The image classification performance can be compared based on the feature extraction by using Haar-CNN and CNN model, and the advantages of feature extraction on natural scene image classification by using Haar-CNN model are also explored. Moreover, in different color spaces, the classification performance by using Haar-CNN model on natural scene images is compared. Here, Haar-CNN model in YCbCr color space achieves the best average classification performance of 95.6%, which rises by 7.8% compared to that in gray space. In addition, we analyze the influence of model parameters on the classification performance, such as patch size, the number of hidden layer neurons, pooling size, and the depth of Haar-CNN. Results show that selecting parameters appropriately parameter selection plays a crucial role in image classification and the classification performances can be improved greatly.

image classification; deep learning; Haar-CNN model; color spaces

2016-07-01

國家自然科學基金(11101012)和北京市優秀人才培養資助青年骨干個人項目(2015000020124G032)

TP391.9

A

1001-8395(2017)01-0119-08

10.3969/j.issn.1001-8395.2017.01.020

*通信作者簡介:李裕梅(1976—),女,副教授,主要從事機器學習、人工智能與模式識別、圖像處理等的研究,E-mail:liwjyumei@163.com