基于Kinect的典型零部件識(shí)別與定位*

張志佳, 魏 信,, 周自強(qiáng), 鐘 玲, 何 欣

(1. 沈陽工業(yè)大學(xué) 視覺檢測技術(shù)研究所, 沈陽 110870; 2. 常熟理工學(xué)院 江蘇省機(jī)電產(chǎn)品循環(huán)利用技術(shù)重點(diǎn)建設(shè)實(shí)驗(yàn)室, 江蘇 常熟 215500)

基于Kinect的典型零部件識(shí)別與定位*

張志佳1, 魏 信1,2, 周自強(qiáng)2, 鐘 玲1, 何 欣1

(1. 沈陽工業(yè)大學(xué) 視覺檢測技術(shù)研究所, 沈陽 110870; 2. 常熟理工學(xué)院 江蘇省機(jī)電產(chǎn)品循環(huán)利用技術(shù)重點(diǎn)建設(shè)實(shí)驗(yàn)室, 江蘇 常熟 215500)

針對自動(dòng)化拆卸的零部件識(shí)別與定位問題,提出了一種結(jié)合深度信息的典型零部件圖像識(shí)別與定位方法.利用Kinect傳感器獲取彩色圖像與深度圖像,提取出兩者之間的仿射變換矩陣,實(shí)現(xiàn)彩色圖像的矯正;根據(jù)相關(guān)系數(shù)匹配法實(shí)現(xiàn)矯正后的彩色圖像零部件識(shí)別;利用彩色圖像與深度圖像的對應(yīng)關(guān)系對零部件進(jìn)行定位.針對典型零部件,對Kinect傳感器獲取的圖像進(jìn)行仿真實(shí)驗(yàn)與處理,結(jié)果表明,該方法能對目標(biāo)進(jìn)行識(shí)別與定位,驗(yàn)證了方法的有效性.

Kinect傳感器; 彩色圖像; 深度圖像; 仿射變換; 圖像矯正; 相關(guān)系數(shù)法; 圖像匹配; 典型零部件

近年來,機(jī)器視覺以其非接觸式、較寬的光譜響應(yīng)范圍、定位、測量和缺陷檢測的優(yōu)勢,在軍事目標(biāo)識(shí)別[1]、人臉識(shí)別[2]、指紋識(shí)別[3]、發(fā)票號(hào)碼識(shí)別[4]、農(nóng)作物質(zhì)量檢測[5]和醫(yī)學(xué)圖像檢測[6]等領(lǐng)域得到了廣泛的應(yīng)用.

在自動(dòng)化拆卸中,機(jī)器視覺是自動(dòng)獲取零部件特征信息和特征參數(shù)的一種較為可行的技術(shù)方法.對于一些高要求、高負(fù)荷的重復(fù)性和智能性的工作,比如細(xì)微缺陷檢測和零部件測量,人眼很難持續(xù)、穩(wěn)定地完成,機(jī)器視覺可以高效、高質(zhì)量地完成檢測任務(wù).

在機(jī)器視覺中,圖像采集設(shè)備大多制造工藝復(fù)雜,精確度高,價(jià)格昂貴.以Bumblebee2為例[7],該相機(jī)價(jià)格昂貴,體積大.但是,微軟Kinect相機(jī)的出現(xiàn),因其簡單、價(jià)廉、方便,在三維重構(gòu)[8]、物體跟蹤[9]和姿態(tài)識(shí)別[10]等領(lǐng)域被廣泛應(yīng)用.

目前,Kinect在零部件識(shí)別方面尚未有公開發(fā)表的文獻(xiàn).基于以上背景,本文深入研究了基于Kinect的零部件識(shí)別與定位方法,拓寬了Kinect的應(yīng)用領(lǐng)域.

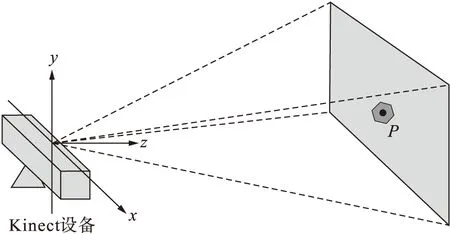

1 Kinect傳感器

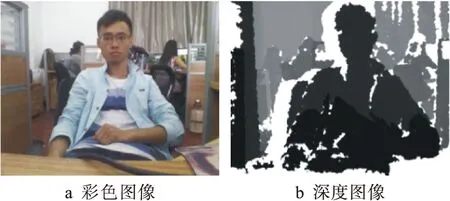

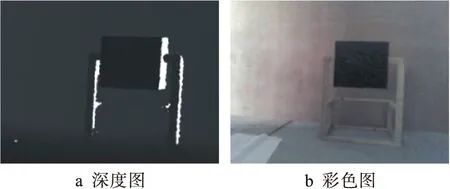

Kinect是微軟在2010年正式推出的XBOX360體感周邊外設(shè).Kinect共有三個(gè)攝像頭,其實(shí)物圖如圖1所示,中間的鏡頭是RGB彩色攝像頭,左右兩邊的鏡頭分別是紅外線發(fā)射器和紅外線CMOS攝像機(jī).Kinect在底部還配備了傳動(dòng)馬達(dá),在兩側(cè)內(nèi)置了陣列麥克風(fēng)系統(tǒng),用于語音識(shí)別.Kinect系統(tǒng)關(guān)于RGB彩色攝像頭和深度傳感器輸出的是640×480的彩色圖像和深度圖像.Kinect設(shè)備能獲取其視野范圍內(nèi)目標(biāo)的彩色圖像和深度圖像,如圖2所示.

圖1 Kinect傳感器

圖2 Kinect圖像

2 零部件識(shí)別與定位

圖2中,彩色圖像比深度圖像包含更多的圖像細(xì)節(jié),能滿足識(shí)別一些結(jié)構(gòu)復(fù)雜的零部件需求.但是彩色圖像提取的只是圖像中的坐標(biāo)信息,而利用深度圖像能提取零部件的三維空間信息,達(dá)到對零部件的識(shí)別與定位要求.基于以上特性,可以同時(shí)利用深度圖像與彩色圖像對零部件進(jìn)行識(shí)別,并確定零部件所在的三維空間位置.

2.1 圖像校正

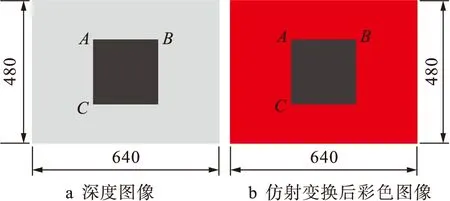

Kinect設(shè)備所獲取的深度圖像與彩色圖像里物體的大小不一致,深度圖像里的人物偏大,如圖2所示.本文提出了基于仿射變換的圖像校正方法,通過圖像校正,彩色圖像與深度圖像重合,對重合后的彩色圖像進(jìn)行識(shí)別,并實(shí)現(xiàn)對零部件的定位.

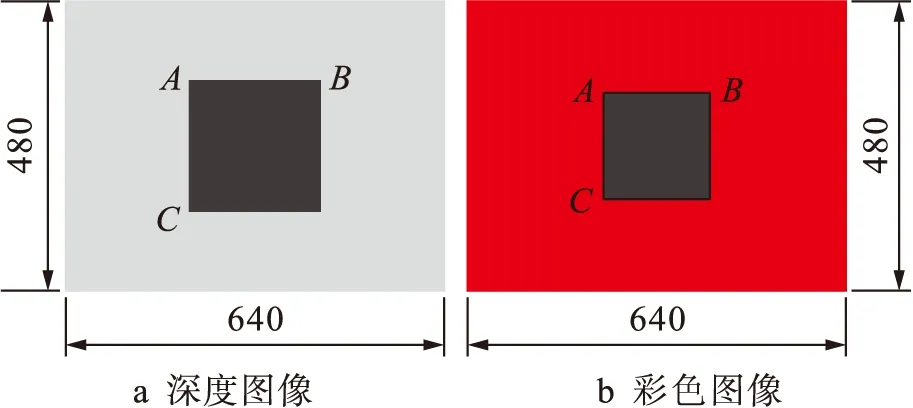

以一塊規(guī)則的正方形黑色木板平面作為目標(biāo),利用Kinect對其進(jìn)行掃描,獲取深度圖像與彩色圖像,圖3給出了Kinect掃描黑色木板示意圖,圖4給出了獲取的深度圖像與彩色圖像.

圖3 黑色木板掃描示意圖

圖4 Kinect圖像示意圖

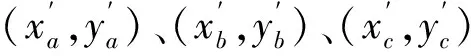

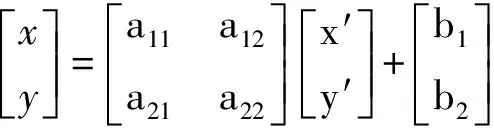

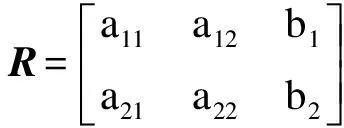

(1)

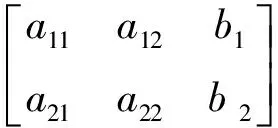

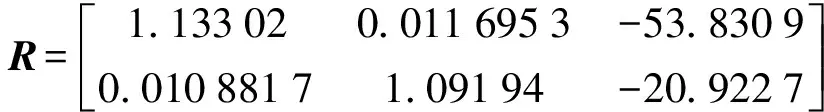

聯(lián)立六個(gè)方程解六個(gè)未知數(shù),得到一個(gè)2×3的仿射變換矩陣,其表達(dá)式為

(2)

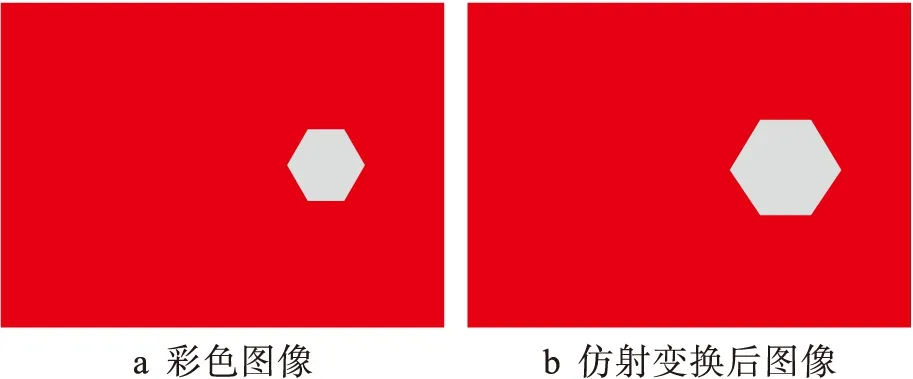

利用仿射變換矩陣R對彩色圖像進(jìn)行仿射變換,圖5給出了變換后對比示意圖.

圖5 仿射變換后對比示意圖

校正后彩色圖像中A、B、C與深度圖像中A、B、C位置重合.

2.2 零部件的圖像識(shí)別

由圖6可知,仿射變換后,彩色圖像中的六角螺母圖與深度圖像一致.圖像完成仿射變換后,將彩色圖像轉(zhuǎn)換為灰度圖像,如圖7所示.

圖6 仿射變換

圖7 灰度圖像

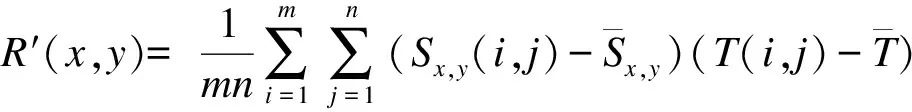

(3)

(4)

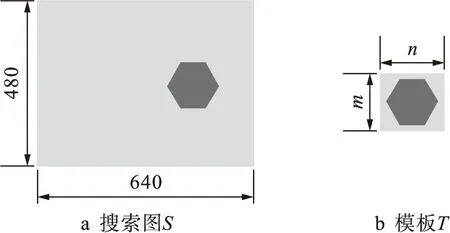

圖8為圖像匹配示意圖.搜索圖S是480×640的圖像,用m×n的模板圖像T在搜索圖S匹配最佳目標(biāo),可以利用相關(guān)系數(shù)法作為匹配測度,根據(jù)匹配相似度的大小來識(shí)別目標(biāo)圖像里的零部件.

圖8 圖像匹配示意圖

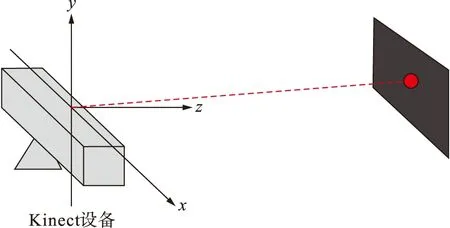

2.3 零部件位姿計(jì)算

典型零部件的位姿是在空間坐標(biāo)系下的坐標(biāo),即世界坐標(biāo),而由匹配算法得到的只是在圖像中的坐標(biāo),難以定位.若想得到典型零部件的空間位姿,可以利用彩色圖像與深度圖像的對應(yīng)關(guān)系求取,圖9給出了零部件定位示意圖.

圖9 定位示意圖

通過彩色圖像提取出典型零部件中心點(diǎn)P坐標(biāo)(u,v),圖像經(jīng)過變換,彩色圖像與深度圖像重合,從深度圖像里提取P點(diǎn)的深度值D,然后利用Kinect SDK工具包將零部件中心點(diǎn)P的二維圖像坐標(biāo)轉(zhuǎn)換為相對于Kinect的三維坐標(biāo)(xP,yP,zP),從而對零部件起到定位的作用.

3 實(shí)驗(yàn)概況

為了驗(yàn)證本文方法的有效性,針對典型零部件的識(shí)別與定位,實(shí)驗(yàn)分別對DIN934標(biāo)準(zhǔn)中的M20、M22、M27、M30四種型號(hào)六角螺母和M6、M8、M10、M12四種型號(hào)方形螺母進(jìn)行了實(shí)驗(yàn),結(jié)果表明,本文方法均能準(zhǔn)確識(shí)別并確定螺母所在的空間位置.

3.1 圖像變換

為了計(jì)算Kinect提取的彩色圖像與深度圖像之間的變換矩陣,設(shè)計(jì)了一個(gè)實(shí)驗(yàn)板進(jìn)行實(shí)驗(yàn),如圖10所示.獲取的深度圖和彩色圖如圖11所示.

圖10 實(shí)驗(yàn)板

圖11 深度圖和彩色圖

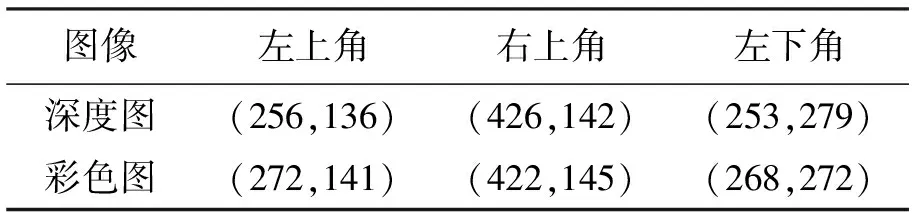

用Kinect深度攝像機(jī)和RGB彩色攝像機(jī)分別對圖10所示的實(shí)驗(yàn)板進(jìn)行拍攝,獲取出對應(yīng)圖像里黑色正方形木板左上角,右上角和左下角三個(gè)點(diǎn)的坐標(biāo),如表1所示.

表1 典型零部件模型三個(gè)參數(shù)

對于表1的兩組點(diǎn),利用仿射變換求出2×3仿射變換矩陣,即

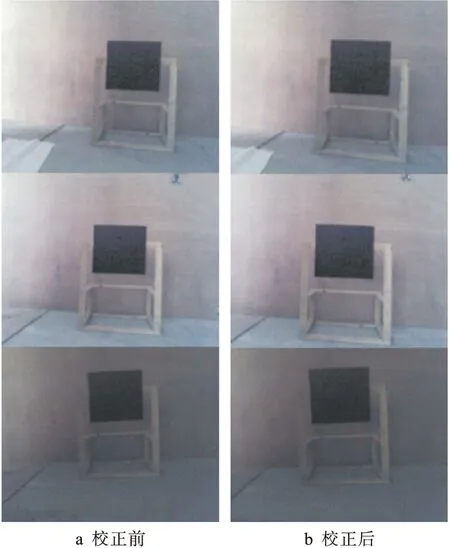

利用求出的仿射變換矩陣對RGB彩色圖像進(jìn)行仿射變換,使校正后的RGB彩色圖與深度圖重合,彩色圖校正前后對比如圖12所示.

圖12 彩色圖像校正

3.2 零部件識(shí)別

對Kinect提取的彩色圖像進(jìn)行仿射變換,然后將彩色圖像轉(zhuǎn)化為灰度圖像,如圖13a所示,用圖13b所示的模板對其進(jìn)行相關(guān)系數(shù)匹配來識(shí)別零部件.

圖13 圖像匹配

在相關(guān)系數(shù)匹配法識(shí)別中,首先當(dāng)R′(x,y)最大時(shí),圖像上(x,y)的灰度值最大,如圖14所示;然后對灰度值最大的點(diǎn)提取其輪廓,如圖15所示;最后確定方形螺母在圖像坐標(biāo)里的位置,方形螺母中心所在的圖像坐標(biāo)為(312,107),如圖16所示.

圖14 相關(guān)系數(shù)匹配法

圖15 輪廓

圖16 方形螺母識(shí)別

Kinect識(shí)別出的方形螺母中心所在的圖像像素坐標(biāo)為(312,107),單位為像素,相應(yīng)的深度值為1.035 m,可以用Kinect SDK開發(fā)工具包將圖像像素坐標(biāo)轉(zhuǎn)化為三維坐標(biāo),提取出相對于Kinect中心所在的空間位置坐標(biāo)為(-0.014,0.241,1.035),單位為m.

4 結(jié) 論

本文提出了一種基于Kinect提取的深度圖像和彩色圖像進(jìn)行目標(biāo)識(shí)別及定位的方法.利用仿射變換實(shí)現(xiàn)了彩色圖像與深度圖像之間的幾何矯正,結(jié)合彩色圖像中目標(biāo)的細(xì)節(jié)信息和深度圖像中目標(biāo)的深度信息對物體進(jìn)行識(shí)別與定位.實(shí)驗(yàn)結(jié)果表明,本文提出的方法能夠?qū)崿F(xiàn)典型零部件的識(shí)別與定位.

[1]李開明,張群,羅迎,等.地面車輛目標(biāo)識(shí)別研究綜述 [J].電子學(xué)報(bào),2014,42(3):538-546.

(LI Kai-ming,ZHANG Qun,LUO Ying,et al.Review of ground vehicles recognition [J].Acta Electronica Sinica,2014,42(3):538-546.)

[2]徐維清,嚴(yán)利民.基于視頻的人臉識(shí)別系統(tǒng)研究 [J].工業(yè)控制計(jì)算機(jī),2014,27(9):90-93.

(XU Wei-qing,YAN Li-min.Research on face recognition system based on video [J].Industrial Control Computer,2014,27(9):90-93.)

[3]楊霞,劉志偉,雷航.基于TrustZone的指紋識(shí)別安全技術(shù)研究與實(shí)現(xiàn) [J].計(jì)算機(jī)科學(xué),2016,43(7):147-152.

(YANG Xia,LIU Zhi-wei,LEI Hang.Research and implementation of fingerprint identification security technology based on ARM TrustZone [J].Computer Science,2016,43(7):147-152.)

[4]宮義山,王鵬.基于模板匹配的發(fā)票號(hào)碼識(shí)別算法 [J].沈陽工業(yè)大學(xué)學(xué)報(bào),2015,37(6):673-678.

(GONG Yi-shan,WANG Peng.Identification algorithm for invoice number based on template matching [J].Journal of Shenyang University of Technology,2015,37(6):673-678.)

[5]張亞靜,Sakac Shibusawa,李民贊.基于機(jī)器視覺的番茄內(nèi)部品質(zhì)預(yù)測 [J].農(nóng)業(yè)工程學(xué)報(bào),2012,26(2):366-370.

(ZHANG Ya-jing,Sakac Shibusawa,LI Min-zan.Prediction of tomato inner quality based on machine vision [J].Journal of Agricultural Engineering,2012,26(2):366-370.)

[6]張輝,王耀南,吳成中,等.高速醫(yī)藥自動(dòng)化生產(chǎn)線大輸液視覺檢測與識(shí)別技術(shù) [J].控制理論與應(yīng)用,2014,31(10):1404-1413.

(ZHANG Hui,WANG Yao-nan,WU Cheng-zhong,et al.Vision detection and recognition for medical infusion automatic production lines [J].Control Theory & Application,2014,31(10):1404-1413.)

[7]Beltran D,Basaez L.A comparison between active and passive 3D vision sensors:Bumblebee XB3 and microsoft Kinect [J].Advances in Intelligent Systems and Computing,2013,252:725-734.

[8]Um D,Ryu D,Kal M,et al.Multiple intensity diffe-rentiation for 3-D surface reconstruction with mono-vision infrared proximity array sensor [J].Sensors Journal IEEE,2011,11(12):3352-3358.

[9]Zhuang J Y,Xu Y R,Wan L,et al.Target detection of an unmanned surface vehicle based on a radar image [J].Journal of Harbin Engineering University,2012,33(2):129-135.

[10]Vermum K,Senapaty M,Sankhla A,et al.Gesture-based affective and cognitive states recognition using Kinect for effective feedback during E-learning [C]//2013 IEEE 5th International Conference on Technology for Education.Kharagpur,India,2013:107-110.

(責(zé)任編輯:鐘 媛 英文審校:尹淑英)

Identification and location of typical components based on Kinect

ZHANG Zhi-jia1, WEI Xin1,2, ZHOU Zi-qiang2, ZHONG Ling1, HE Xin1

(1. Computer Vision Group, Shenyang University of Technology, Shenyang 110870, China; 2. Jiangsu Key Laboratory of Recycling and Reuse Technology for Mechanical and Electronic Products, Changshu Institute of Technology, Changshu 215500, China)

Aiming at the problem of component identification and location in automatic disassembly process, a typical component image identification and location method in combination with the depth information was proposed. The color image and depth image were acquired with the Kinect sensor, and the affine transformation matrix was extracted so as to realize the correction of color image. In addition, the component identification with the corrected color image was realized with the correlation coefficient matching method, and the components were located with the corresponding relationship between color and depth images. Aiming at the typical components, the simulation experiment and processing for the image obtained with the Kinect sensor were carried out. The results show that the proposed method can identify and locate the target. And the effectiveness of the method is verified.

Kinect sensor; color image; depth image; affine transformation; image rectification; correlation coefficient method; image matching; typical part

2016-11-21.

國家自然科學(xué)基金資助項(xiàng)目(61540069); 江蘇省機(jī)電產(chǎn)品循環(huán)利用技術(shù)重點(diǎn)建設(shè)實(shí)驗(yàn)室基金資助項(xiàng)目(KF1508).

張志佳(1974-),男,河北晉州人,副教授,博士,主要從事機(jī)器視覺檢測技術(shù)、圖像處理與模式識(shí)別等方面的研究.

10.7688/j.issn.1000-1646.2017.03.11

TM 391.4

A

1000-1646(2017)03-0299-05

*本文已于2017-05-08 20∶25在中國知網(wǎng)優(yōu)先數(shù)字出版. 網(wǎng)絡(luò)出版地址: http:∥www.cnki.net/kcms/detail/21.1189.T.20170508.2025.004.html