新聞文本自動分類技術概述

劉冬瑤+劉世杰+陳宇星+張文波+周振

摘要:文本分類是對文本集按照一定的分類體系或標準劃分為不同的類別。該文總結了文本分類的基本流程,討論了中文文本分類的主要特點和常用技術,指出了現今新聞文本分類存在的問題,并對中文文本分類未來的發展前景和研究方向做出展望。

關鍵詞:文本預處理;新聞文本分類;機器學習;自然語言處理

中圖分類號:TP391 文獻標識碼:A 文章編號:1009-3044(2017)35-0087-05

The Research Summary of News Text Automatic Classification Technology

LIU Dong-yao, LIU Shi-jie, CHEN Yu-xing, ZHANG Wen-bo, ZHOU Zhen

(China University of Mining & Technology, Beijing 100083,China)

Abstract: The text classification is divided into different categories by the classification of the text set according to certain classification system or standard. This paper summarizes the basic flow of text classification, discusses the characteristics and key technologies of Chinese text classification, points out the existing problems of news text classification, and prospects the future development of Chinese text classification and its research direction.

Key words: text preprocessing; news text automatic classification; machine learning; NLP

1 概述

隨著網絡信息技術的迅速發展和傳統紙媒逐漸向信息化媒體的轉型,網絡中有越來越多的信息積累,尤其是新聞的無紙化使得人們更傾向于在網絡上搜索信息。其中大部分是以文本形式存在。文本分類則能有效解決這一問題,而傳統的文本分類主要使用手工分類的途徑,這種做法有著很多的弊處:首先,這樣會耗費大量的人力、物力;其次,存在獲得的成果與所要求的不一致的現象。效率低下的手工分類方式面臨愈來愈多的困難,面對大數據更顯得無從下手,為了提高分類的準確率和速度,新聞文本自動分類順理成章地成為了發展方向。

新聞是對時事、最新消息進行了解的重要途徑,新聞信息分類有助于實現新聞有序化、對新聞進行挖掘,從而引導決策等,很有意義。新聞文本分類已經有了大量的相關研究,包括分類的流程和大量的相關算法。

本文組織如下,第2節介紹了文本自動分類的三個步驟及各種分類方法,第3節介紹了新聞文本分類的應用方向和現今仍然存在的問題,第4節對新聞分類的成長發展遠景及研究方向進行展望。

2 文本自動分類的流程

文本自動分類一般有三個步驟組成:文本預處理、文本分類和常用基準語料預評估。圖1為文本自動分類的流程。

2.1 文本預處理

文本預處理是用預先處理原始文本數據的方式,來提高學習算法的精準度、分類效果和文本彈性。

2.1.1 文本表示

一般來說,語言在現實使用中的形式是文本。現實使用中,文本是根據一定的語言銜接和語義連貫規則構成的語句系統。主要采用向量空間模型 VSM ( Vector Space Model)來進行文本表示,這種模型將高維詞條空間中的向量與文本逐一對應。

1970s,向量空間模型由Salton等提出,并應用于有名的SMART文本檢索系統。把對內容的處理簡化為向量的變化,文檔間的相似程度可以通過計算向量之間的相似程度來衡量,直觀易懂。多數情況下,用余弦距離來進行相似性度量。

M個無序特征項,詞根/詞/短語/其他每個文檔可以用特征項向量來表示(,,…,)權重計算,N個訓練文檔AM*N= () 文檔相似度比較

1) Cosine計算,余弦計算的好處是,正好是一個介于0到1的數,如果向量一致就是1,如果正交就是0,符合相似度百分比的特性,余弦的計算方法為,向量內積/各個向量的模的乘積。

2) 內積計算,直接計算內積,計算強度低,但是誤差大。

向量空間模型只是一個理論模型,不同的應用中對項的權重評價、相似度的計算有著不同的定義,在各種權重評價函數和確定相似度的辦法中可以有不同的表示方法,所以模型適應能力很強,很好地應用于各種不同的系統。

VSM在計算性和操縱性上有著其獨特的優勢,在大數據時代,它的應用已經有了許多新的擴展,可以幫助人們檢索文本、摘錄文章段落語句、自動提取關鍵詞等,還可以在數據檢索方面代理信息、構建搜索引擎、實現web新聞發布等。在VSM中,用多維空間的一個點來代表文本內容,將文本用向量的形式與實數域中的數一一對應,在模式識別或者其余范疇中的成熟計算方法的輔助下,文本的可計算性和可操作性得到了很大的提高。

2.1.2 文本特征選擇

文本特征選擇是從原始特征中基于一些準則來選擇那些最能將類別區分開的特征詞。特征選擇篩選出相關性較低和多余的特征并將它們刪去,使處理效率大大提升。文本數據的特征選擇研究的重點就是用來衡量單詞重要性的評估函數,其過程就是首先根據這個評估函數來給每一個單詞計算出一個重要性的值,然后根據預先設定好的閾值來選擇出所有其值超過這個閾值的單詞。目前,國內外常用文本特征選擇方法主要有以下幾種: 文檔頻率、信息增益、互信息、統計量、期望交叉熵等。

1) 信息增益

在信息增益中,以特征能給分類程序帶來的信息量來作為度量標準的,帶來的信息與特征的重要程度成正比。是否有這個特征將為系統的信息量帶來波動,而信息量的差值即為系統中受它影響的信息量,換言之即為熵。設有變量X,有n種取值可能,Pi為每種可能被取值的概率,則定義X的熵為

(1)

換言之,X變化的可能性與其能帶來的信息量成正比,也就是與熵成正比。對聚類來說,就是文檔屬于哪個類別的變化越多,類別的信息量就越大。所以特征T給聚類C或分類C帶來的信息增益為。有兩種可能:一種是出現特征,將其記為T,用t表示,一種是特征T不出現,用表示。所以,再通過熵的計算公式求出特征與類別的信息增益公式。

信息增益的最大的不便就是只能判斷特征在整個系統中的影響,而判斷它在哪個類別中。

2) 文檔頻率

在文檔頻率方法中,使用特征詞在一個類別中出現的文檔數來表示這個特征詞與該類別的相關度。更大概率通過篩選的特征詞是在更多的文檔中出現過的。

文檔頻率是最簡易的特征抽取方法,由于它有基于訓練語料規模的線性計算復雜度,更適合大規模的語料統計,能夠極大地使效果改善。[1]

3) 互信息

互信息(Mutual Information)是基于信息熵概念上的,它是度量兩個隨機事件相關性的特征,廣泛使用于統計語言模型中。詞條(記為t)和文本類別(記為c)的互信息定義是:

(2)

其中 ∈C且包含t的文檔概率,表示包含詞條t的語料中的文本的概率,表示C類文本在語料中出現的概率。根據概率,如果在分布上一個詞與一個類別是在統計上獨立的,即=×,則=0,也就是說詞t的頻率無法對預測類別C產生影響。

在實際運用中,互信息表達式可近似為語料庫中對應的出現頻數。如果包含t且屬于C的文檔頻數(記為X),包含t但不屬于C的文檔頻數(記為Y),屬于C但不包含t的文檔頻數(記為Z),語料中文本總數(記為N),則有:

(3)

對于屬于不止一個類別的應用,算出t在每一類中的MI值,再算出對整個語料而言t的MI值:

(4)

互信息計算的時間復雜度與信息增益相似。互信息的缺點是評價結果受到詞條頻率影響較大,且之前的計算量很大。

4) 卡方統計量

卡方檢驗的基本方法就是對比實際值與理論值,以差值來判斷它的正確性。通常先假設兩個變量為獨立的,然后觀察實際值與理論值的偏差值,若偏差趨近于0,我們就將此誤差當作可接受樣本誤差,是受測量條件限制或小概率發生的,所以兩者獨立,原假設成立;如果發生了很大的偏差,對這種誤差來說,一般不可能是受測量條件限制或小概率發生的,我們就認為兩者不獨立,是相關的,原假設不成立。

訓練語料中的文本總數(記為N),某一特定類別(記為c),特定的詞條(記為t),屬于C類且包含t的文檔頻數(記為A),不屬于C類但包含t的文檔頻數(記為B),屬于C類但不包含t的文檔頻數(記為C),既不屬于C也不包含t的文檔頻數(記為D)。則對于C來說詞條t的CHI值是:

(5)

近似于處理互信息,為能夠在多個類別中應用CHI統計,先計算各個詞條與每一類的CHI值,再用式(6)計算對整個語料而言它的CHI值:

(6)

其中m為類別數。

詞條對于某類的統計學數值與該類之間的相關性和其具有的類別信息成正比。

5) 期望交叉熵

(7)

如果詞條t和類別Ci相關性越強,則越大,如果與此同時,又很小,則說明該詞對該類的影響大。這個量代表了文本類別的概率分布,以及文本類別在某種特征的基礎上的概率分布之間的距離。

2.2 分類

2.2.1 分類方法

文本分類是依照文本內容或特征,在規定的分類系統下將待劃分文本分配到一個及以上的之前定義好的分類中的方法[2]。

文本分類是一一對應的方法,將未明確的待分類文本對應到已定義的分類中,由于一篇文本可以同多個類別相關聯,這個映射一般來說是一對一或一對多的映射。數學公式為:

f:X→Y 其中:X=(M1,M2,…,Mn ) Y = ( N1,N2,…,Nm) (8)

即:X為所有待劃分的文本的集合;Y為規定的分類系統下,所有分類的集合。X可以為無限集合,而Y必須為有限集合。

分類方式一般依照基本劃分方法不同而分為兩種:基于機器學習的分類方法和基于規則的分類方法。

2.2.1.1 基于機器學習的分類方法

基于機器學習的分類方法是通過學習給定的訓練集,從而歸結出各分類的模板,從而使用模板來進行文本分類。

此方法的優點是簡易可行,一般來說分類精確度較高;但它的缺點主要是:

1) 當重疊現象在各個類別中較多時(特征重復),精確度將嚴重下降,特別在多層分類中,特征重疊現象在子類中更為多見,因此在基本分類大體正確的時候,卻發生了子類的分類精度嚴重下降的情況。比如說,在對金融,歷史,科學技術,醫療衛生等方面的種類的檢測中,顯示出分類效果中體育分類的效果最好,精確度趨近于100%,這主要是因為體育類的特征與其他類的重疊很少;而醫藥衛生和科學技術類的精確度不理想,都低于90%,因為這兩個類的特征之間重疊很多,并且與其他分類之間也有交叉。

2) 嚴格控制訓練語料的量與質。如果訓練集不全面,無法代表所在分類的特征,那么自動分類的精度將受到嚴重影響。對于每個分類來說,訓練集最好全面覆蓋該類。搜集訓練集一定要保證語料準確屬于所在類別,否則分類器的分類效果將受到影響。

文獻[3]中提出使用機器學習分類方法會降低分類速度,因而使用了基于標題的新聞網頁分類方法,然而目前的新聞信息玉石雜糅,很多新聞為博取讀者眼球,嘗嘗文不對題,且內容真實性不高,據此分類則會給人們的生活帶來不便甚至給人們帶來危害。

2.2.1.1.1 樸素貝葉斯分類器

貝葉斯分類是一類分類算法的總稱,這類算法均以貝葉斯定理為基礎,故統稱為貝葉斯分類。樸素貝葉斯算法(Naive Bayesian) 是其中應用最為廣泛的分類算法之一。樸素貝葉斯分類器是一系列以假設特征之間強(樸素)獨立下運用貝葉斯定理為基礎的簡單概率分類器。它基于一個簡單的假定:屬性之間在確定目標值的情況下彼此條件獨立。樸素貝葉斯分類器的一個優勢在于只需要根據少量的訓練數據估計出必要的參數(變量的均值和方差)。

貝葉斯定理是一個與隨機事件A和B的邊緣概率相關的定理。[4]其中P(A|B)是在B發生的情況下A發生的可能性。

(9)

樸素貝葉斯的思想大體上是:對于待分類項來說,解出各個類別在此項出現時出現的概率,此待分類項的類別就是最大概率的分類。

樸素貝葉斯分類模型的優勢是:

1) 時間復雜度、空間復雜度較低;

2) 算法邏輯清晰簡便,易于理解和轉化為具體程序;

3) 算法效果不易受其他因素干擾,模型健壯性良好。

在條件獨立性假設的基礎上,樸素貝葉斯分類器假設一個屬性對指定類別的影響與其他屬性無關,樸素貝葉斯分類算法的最小的誤分類率是在條件獨立性假設生效的情況下[5]。但樸素貝葉斯假設在實際中往往并不成立,多少影響了樸素貝葉斯分類器的分類效果。[6]

2.2.1.1.2 神經網絡算法

人工神經網絡(ANN),簡稱神經網絡,是以生物神經網絡的結構和功能的為原型的數學計算模型。一般來說,人工神經網絡是自適應系統,可以根據外界信息來改變內部結構。在現代,ANN是統計學中的一種工具,常用于非線性數據建模,它將輸入和輸出間復雜的關系轉化為模型,在探索數據的情況下用途甚廣。

現今,神經網絡的問題主要是收斂速度慢、計算量大、訓練時間長和泛化能力不足[7],很多研究人員仍在不懈地研究神經網絡算法,其研究目的是創新或改善神經網絡的算法和性能,追求更快的收斂速度、降低陷入局部極小的概率或消除局部極小問題、提高泛化能力等。[8]

2.2.1.1.3 KNN分類方法

1968年,KNN 算法由 Cover 和 Hart提出,該算法的思路是:用經典的向量空間模型把文本內容轉化為特征空間中的加權特征向量。計算檢測文本與訓練語料里的文本的相似程度,找出M個最相似的文本,用加權距離來判斷測試文本的種類。最大權重的類別即為文本所在的類別。[9]

KNN(k-Nearest Neighbor)算法穩定性好、準確率高,但由于其時間復雜度與樣本數量成正比,導致其分類速度慢,難以在大規模海量信息處理中得到有效應用。由于KNN方法主要依靠鄰近的樣本,但周圍樣本有限,因此對于類域重疊較多的待分語料來說,更適合使用KNN方法。

2.2.1.1.4 支持向量機(SVM)方法

在機器學習中,支持向量機(SVM)是在分類與回歸分析中分析數據的監督式學習模型與相關的學習算法,由Vapnik在1995年提出[10]。給定一組訓練實例,每個訓練實例被標記為屬于兩個類別中的一個或另一個,SVM訓練算法建立一個將新的實例分配給兩個類別之一的模型,使其成為非概率二元線性分類器。SVM模型是將實例表示為空間中的點,這樣映射就使得單獨類別的實例被盡可能寬的明顯的間隔分開。然后,將新的實例映射到同一空間,并基于它們落在間隔的哪一側來預測所屬類別。

而對于非線性分類,SVM還可以有效地使用所謂的核技巧(kernel trick),把它的輸入隱式映射到高維特征空間中。

如果數據未被標記,則需要進行非監督式學習,它會試著找出從數據到簇的自然聚類,并將心數據映射到這些已形成的簇。支持向量聚類[11]就是指由SVM改進的聚類算法,當數據并未或少量被標記時,支持向量聚類經常在應用中被用作分類步驟的預處理。

2.2.1.2 基于規則的分類方法

決策樹分類方法:使用決策樹的主要原因是其構造過程不需要使用者學習其他專業的知識來決定參數,因此在實際應用中,為了探索新知識,更應該使用決策樹。決策樹算法主要是通過構造決策樹來從給定樣本中找出區分它們的規則,構造精度高、規模小的決策樹是決策樹算法的主要目的。

決策樹被廣泛應用是因為其原理簡單易懂,分類過程中不需要人為設定參數,速度快、計算量較小,易于生成可理解的規則。但決策樹難以預測連續性的字段,對于有時間順序的數據,要進行許多預處理,類別太多時,錯誤增加速度很快。而且使用貪心算法的決策樹方法做出的只是某種意義上的局部最優選擇。[12]

2.2.2 方法的評估指標

機器學習(ML),自然語言處理(NLP),信息檢索(IR)等領域,評估(Evaluation)是一個必要的 工作,而其評價指標往往有如下幾點:準確率(Accuracy),精確率(Precision),召回率(Recall)。

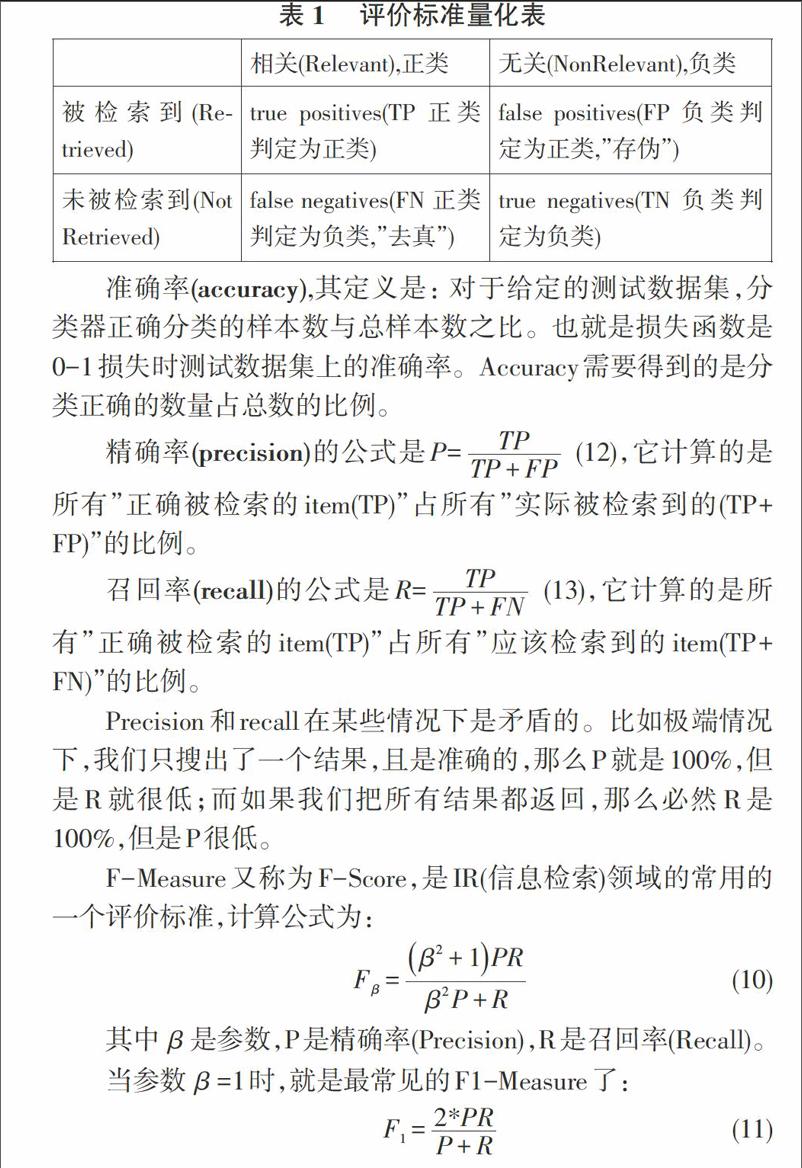

表 1 評價標準量化表

[ 相關(Relevant),正類 無關(NonRelevant),負類 被檢索到(Retrieved) true positives(TP 正類判定為正類) false positives(FP 負類判定為正類,”存偽”) 未被檢索到(Not Retrieved) false negatives(FN 正類判定為負類,”去真”) true negatives(TN 負類判定為負類) ]

準確率(accuracy),其定義是: 對于給定的測試數據集,分類器正確分類的樣本數與總樣本數之比。也就是損失函數是0-1損失時測試數據集上的準確率。Accuracy需要得到的是分類正確的數量占總數的比例。

精確率(precision)的公式是P= (12),它計算的是所有”正確被檢索的item(TP)”占所有”實際被檢索到的(TP+FP)”的比例。

召回率(recall)的公式是R= (13),它計算的是所有”正確被檢索的item(TP)”占所有”應該檢索到的item(TP+FN)”的比例。

Precision和recall在某些情況下是矛盾的。比如極端情況下,我們只搜出了一個結果,且是準確的,那么P就是100%,但是R就很低;而如果我們把所有結果都返回,那么必然R是100%,但是P很低。

F-Measure又稱為F-Score,是IR(信息檢索)領域的常用的一個評價標準,計算公式為:

(10)

其中是參數,P是精確率(Precision),R是召回率(Recall)。

當參數=1時,就是最常見的F1-Measure了:

(11)

2.3 常用基準語料

語料庫是對人們日常生活中的常用語言進行的搜集和整合,便于進行研究和實驗分析。語料的選擇恰當與否很大程度上影響了實驗結果的正確性。

Reuters-21578是路透社發布的常用英文語料庫,是一個常用于文本分類任務的測試集。它包含了21578個從1987年以來的路透社新聞文檔,它們被路透社全體成員人工的分類標記。標簽有五種不同的目錄分類,目錄總數為672個,但它們許多都僅僅出現的非常少。一些文檔從屬于許多不同的目錄,一些只從屬于一個分類,還有一些不屬于任何目錄。在過去的幾十年里,他們做出了許多努力來使數據庫升級并改進它,以使它能夠被用于各種科學研究。

20 Newsgroups包含了大約20000份新聞文檔,涵蓋了約20中不同的新聞分類,這個數據集最早是Ken Lang建立的。現在20 Newsgroups在機器學習技術的文本應用方面的實驗中成為了一個常用的數據集,例如文本分類和文本聚類。

TanCorp由譚松波整理搜集,是一個開放的中文語料庫,是中國的權威語料庫之一,通常用于自然語言處理等研究。語料庫共有兩個層次,收集14150篇文本,第一層為12個類別,第二層為60個類別。

復旦大學中文文本分類語料庫共9804篇文檔,分為20個類別,訓練預料基本按照1:1的比例來劃分。來源于復旦大學計算機信息與技術系國際數據庫中心自然語言處理小組,也是目前中文文本分類實驗常用的語料庫。

搜狗實驗室文本分類語料庫是根據Sohu新聞網站收集的大量經過編輯手工整理與分類的新聞語料及相應的類別信息。其分類體系有著幾十個分類節點,約為100,000個網頁。目的是構建一個較大規模的標準化的中文文本分類測試平臺,可用于中文文本分類和主題跟蹤與檢測等,是近年新興的中文文本分類語料庫。

3 中文新聞文本分類研究

中文新聞文本分類起步較晚,而且漢語語法結構繁雜,所以在技術和成果上中文新聞文本分類目前還略遜于英文新聞文本分類的研究進度。但近些年來發展仍是突飛猛進,尤其是基于中文新聞信息的相對詳細的語料庫的出現和發展使中文新聞文本分類變得更加便捷和容易。

3.1 新聞文本分類應用

1) 新聞網站的分類引導

新聞網站對于新聞進行分類使得讀者可以更準確地找到自己感興趣的分類并有利于關聯閱讀的進行,例如目前新聞頁面下方的新聞推薦,可以使讀者便捷地閱讀到與當前閱讀新聞相關的其他新聞頁面。這一點有些類似傳統紙媒的不同版面,在目前的新聞網站中已經非常普及。

2) 熱點話題追蹤

新聞的特點之一是時效性,有時一個事件的發展會經歷一段相當長的時間。如果讀者想要持續關注這一事件,則需要花費額外的精力每天在網絡上搜索相關報道。但新聞文本分類技術可以實現對熱點話題進行追蹤,從而實時推送相關事件的最新進展,節省了用戶耗費在信息搜集上的時間,例如,微博中的話題功能也有類似的新聞分類作用[13],但此功能由于是用戶依照主觀意識自主添加的,所以在準確率上非常不如意。

3) 特定類別新聞過濾和篩選

網絡是一把雙刃劍,既提升了信息傳播的便捷性,又使有害信息的傳播也變得相對容易。例如前些時間的“莆田系”醫院時間、求職陷入傳銷組織事件等,均是由于對網絡有害信息的不準確判斷而釀成的悲劇。若能利用新聞文本分類將有害信息在傳播過程中篩選和攔截,將使用戶接觸到這些不良信息的幾率大大降低。

3.2 中文新聞文本分類的問題

新聞的概括性較強,敘述時以較簡潔利落的文字,在有效時間內的發布附近新近發生的、有價值的事實,能夠讓特定的受眾獲得信息。六大新聞要素5W1H(Who\Where\What \Why\When\How)中,時間、人物、地點等實體要素在大部分情況下可以表現出新聞內容中的主體對象。所以在對新聞文本進行預處理時,主要將這些詞提煉出來以便后續分類的進行。

然而,新聞媒體經常以夸張標題吸引讀者注意是無論中外媒體均有的通病,這導致了新聞文本常常文不對題,從而使依靠標題進行文本分類的準確率大大下降,也增加了讀者的時間支出,使用戶體驗下降。

現有語料庫的分類層次太淺,仍是依靠大類來進行文本分類,但太過詳細的分類又會使新聞類別的數量指數增長,應做好新聞文本分類的準確性和類別數量之間的平衡。

4 總結和展望

文章主要介紹了在現今社會中,新聞文本自動分類的必要性和需求,重點介紹了文本分類的主要流程、基本原理和方法,介紹了中文新聞文本分類的進展,然后設想了文本分類技術在新聞領域的具體應用方向。雖然中文新聞文本分類技術在前輩學者的研究下已經有了一定的進展,但仍有許多方面需要進一步的研究和努力。

1) 新聞文本分類層次加深

將新聞文本的分類再進行細化,使新聞的分類更加準確和細致。但這會導致新聞數據的維護難度增加,并且需要計算速度提高方面的支持。

2) 新聞文本分類維度拓廣

現有的新聞文本分類語料庫大多是以主題進行的分類,這樣的分類方向太過于單一。今后可以建立以情感[14]、應用、行業綜合等不同方向的新聞文本分類語料庫,以滿足不同行業、不同用途的應用。

3) 新領域新聞分類

新聞的發展越來越快,承載形式從傳統紙媒發展到現在的網絡傳媒。而新聞的類型也在不斷增多,從過去的文字、圖像等單一形式,到現在視頻、音頻等多種形式。一大批自媒體的興起代表著視頻新聞的時代已經到來,所以新聞分類已經不能拘泥于傳統的文本分類,更要放眼于圖像識別、語音識別以及視頻中的動態圖像識別等技術,甚至于新近興起的AR、VR等技術。

4) 新聞文本分類在大數據方面的應用

網絡信息的爆炸式增長,掀起了大數據的浪潮。新聞分類也得益于大數據的到來,可以進行充足的數據分析和學習。通過分析用戶日常閱讀的新聞的興趣所在,從而實現新聞的個性化推薦,使新聞的受眾更精準,用戶體驗大大提高。

參考文獻:

[1] 劉依璐 . 基于機器學習的中文文本分類方法研究[D]. 西安:西安電子科技大學,2009:22-24.

[2] 龐劍鋒,卜東波,白碩.基于向量空間模型的文本自動分類系統的研究與實現[J].計算機應用研究,2001,18(9):23-26.

[3] 錢愛兵,江嵐. 基于標題的中文新聞網頁自動分類[J].現代圖書情報技術,2008(10):59-68.

[4] 張磊. 文本分類及分類算法研究綜述[J].電腦知識與技術,2016,(34):225-226,232.

[5] 李旭升,郭春香,郭耀煌. 擴展的樹增強樸素貝葉斯網絡信用評估模型[J]. 系統工程理論與實踐,2008(6):129-136.

[6] 王國才. 樸素貝葉斯分類器的研究與應用[D]. 重慶:重慶交通大學,2010.

[7] 楊旭華. 神經網絡及其在控制中的應用研究[D].杭州:浙江大學,2004.

[8] 周瑛. 神經網絡作為分類器的算法研究及在信息檢索中的應用[D].合肥:安徽大學,2006.

[9] 卜凡軍. KNN算法的改進及其在文本分類中的應用[D].無錫:江南大學,2009.

[10] Boser B,I.Guyon V N.Vapnik."A training algorithm for optimal margin classifiers[C]//Fifth Annual Workshop on Computational Learning Theory, San Mateo,CA:Morgan Kaufumann.1992:144-152,139.

[11] Ben-Hur Asa, Horn David, Siegelmann Hava,et al. Support vector clustering[J]. Journal of Machine Learning Research,2001(2):125-137.

[12] 王煜. 基于決策樹和K最近鄰算法的文本分類研究[D]. 天津:天津大學,2006.

[13] 劉志遠,高俊波. 基于話題的微博多特征情感極性分類[J]. 微型機與應用,2017(16):60-62+66.

[14] 陳巧紅,孫超紅,賈宇波. 文本數據觀點挖掘技術綜述[J]. 工業控制計算機,2017(2):94-95,102.