空間位置約束下的三維音頻對象參數動態量化*

李雪哲,王曉晨,高 麗,涂衛平,柯善發1,

1.武漢大學 計算機學院 軟件工程國家重點實驗室,武漢 430072

2.武漢大學 計算機學院 國家多媒體軟件工程技術研究中心,武漢 430072

3.武漢大學 多媒體網絡通信工程湖北省重點實驗室,武漢 430072

1 引言

三維音頻是使用信號處理方法利用耳機或音響重建一個三維虛擬空間聲場[1],使聽者可以感知到聲音來自于空間中的任意位置[2]。根據編碼內容的不同,三維音頻編碼可以分為多聲道三維音頻編碼和面向對象三維音頻編碼。

多聲道三維音頻播放系統,比如5.1.4(杜比)、22.2(NHK)、杜比Atmos等,已經在電影院、家庭影院等場景中得到廣泛使用,它可以提供一個生動的聲音場景與更好的聲音定位[3]。但是多聲道3D音頻只能提供固定的混合渲染模式,用戶只能對全局的音頻進行操作,而不能按照個性化需求對相應的對象進行音量控制、對象切換、空間渲染等。因此,針對三維音頻對象進行編碼可以滿足用戶的個性化需求,以極大的靈活性來實現場景中任意對象的個性化調整。

目前,針對對象進行編碼的實現方法主要分為兩種:一種是使用傳統編解碼器,如AAC、MP3等方法單獨對每個對象進行編碼傳輸。但這種方法會導致隨著三維音頻中對象數目的增多,總碼率隨之大幅增加,不利于傳輸。第二種則是將多個對象進行處理混合成一個單聲道/雙聲道,以降低音頻對象整體碼率。這種方法又可根據下混信號獲得方式分為兩類。

第一類是下混信號并不完全包含所有音頻對象的所有信息,而是作為一個存儲區域對每個對象的有效成分進行存儲,其中每個頻域成分是可以從待混合的某個音頻對象信號中直接純凈獲得的。主要代表方法有基于心理聲學的分析-合成(psychoacousticbased analysis-by-synthesis,PABS)方法[4]和Jia等人提出的利用對象頻域的稀疏性來進行多對象音頻壓縮[5]的方法。

基于心理聲學的分析-合成方法[4]利用了語音信號在短時頻域內的稀疏特性,在頻域中針對每個頻域索引選取具有最高能量的對象的頻譜進行保留,并組成單聲道。該方法適用于多方語音會議場景,即對象并發度不高。然而當音頻并發度與相關性較高時,該方法不能保證對象音頻的感知質量。

2015年Jia等人利用對象頻域的稀疏性來進行多對象音頻壓縮[5],在每個信號頻域,保留每幀中少部分能量較高的頻譜,使用一個相同大小的單聲道作為存儲工具,按照索引臨近的順序依次存放所有活動語音對象的時頻片段,以此作為下混信號。該方法適用于所有類型的連續音頻,但是它的下混信號僅用來存儲,不可回放,同時不具有向下兼容性。

第二類是將對象信號轉換到頻域,然后彼此之間進行線性組合。這類方法得到的下混信號具有所有對象音頻的信息,通過少量邊信息進行對象恢復。代表方法有知情音源分離(informed source separation,ISS)方法和面向對象音頻編碼(spatial audio object coding,SAOC)方法。

知情音源分離方法可以用于多個對象音頻的壓縮[6-9],在編碼端進行混合,得到一個下混對象信號和少量邊信息,傳輸到解碼端。盡管ISS可以做到在低碼率下進行多個音頻對象的壓縮,但是這種方法時間效率低,不能滿足實時音頻系統的要求,同時對混合信號的精度要求較高,較小的失真都會嚴重影響分離后的效果。

MPEG提出的SAOC方法是在每個頻域子塊內,將每個對象的頻域能量均與具有最高頻域能量的對象的頻譜能量求比例系數作為邊信息,針對每個對象都提取一組邊信息,同時獲得一個可聽的單聲道或立體聲[10-12]。該方法具有向下兼容性,但由于邊信息是按照對象提取的,這時當音頻對象數目增大時,就會產生大量的邊信息。比如當一個音頻場景中有32個音頻對象時,邊信息的碼率遠遠大于總碼率的一半。2011年,Kim等人針對SAOC提出殘差編碼方法提升了音質[13],但仍舊沒有解決因對象數目過大帶來的碼率問題。因此如何高效量化壓縮邊信息,并盡可能減少量化損失,亟待解決。

上述所有方法中,SAOC使用最為廣泛,且在對象并發度較高、實際有損的應用場景中,比其他空間對象編碼方法更為適用,更具代表性。但SAOC方法也存在固有問題,本文針對SAOC輸入對象增多時邊信息碼率非常大的問題,提出了一種基于空間約束的面向對象的空間參數(即邊信息,這里具體是方位角和高度角)動態量化方法,根據音頻對象的空間位置,來確定空間約束區域以及空間參數局部量化碼本,然后使用局部量化碼本對空間參數進行量化編碼,大幅降低參數碼率。

2 SAOC簡介

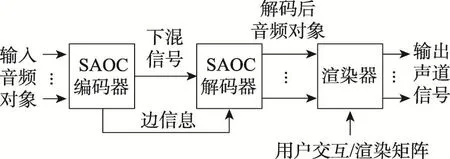

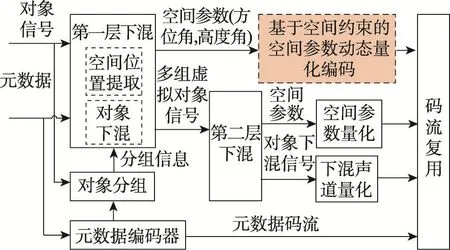

SAOC包括編碼模塊、解碼模塊以及渲染模塊,如圖1[11]。在編碼端,接受多個對象信號,并獲得一個單聲道下混信號以及一系列邊信息。為了計算下混信號以及邊信息,輸入的對象信號需要先進行離散傅里葉變換(discrete Fourier transform,DFT),從時域變到頻域,同時按照人耳感知特性劃分28個子帶[14]。

Fig.1 General structure of SAOC圖1 SAOC基本框架

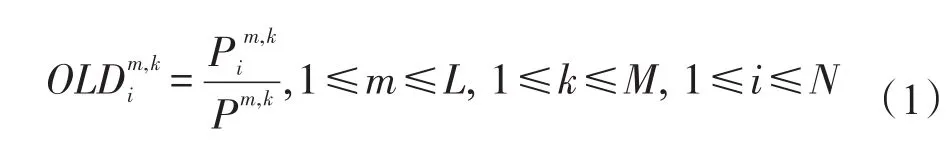

作為一個主要的參數,對象間聲級差(object level difference,OLD)[15]定義如下:

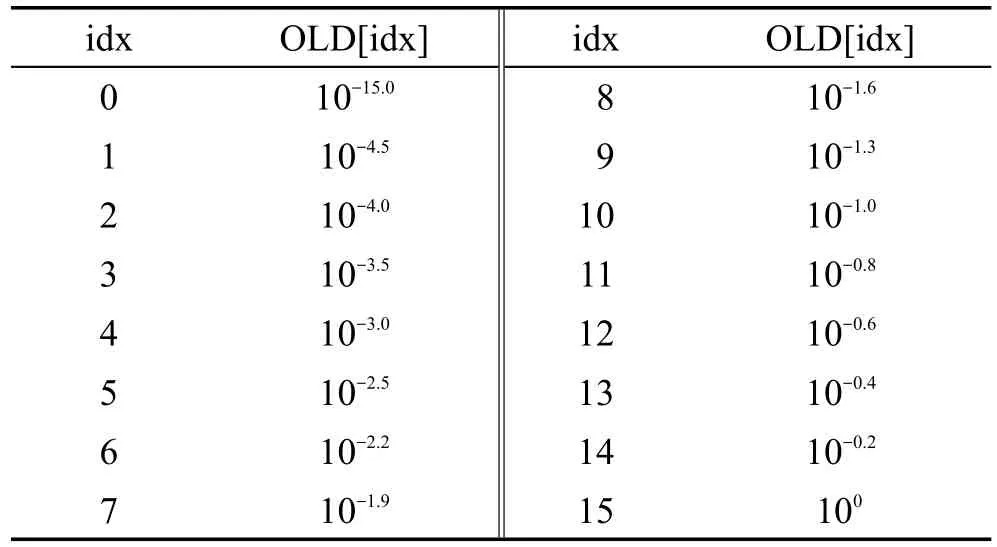

在SAOC中,OLD被量化到16個值上,如表1[16]。其中idx代表量化表索引,OLD[idx]表示OLD的量化值,如果用二進制編碼對整個量化表進行統一編碼,共需要4 bit。

正如前文所提到的,OLD是針對每個對象進行提取,且僅考慮了參數的數據統計特性,這會導致對象數目增大時,參數OLD數據量隨之增大。盡管下混信號的碼率與對象數目無關,但是參數的數據量和壓縮效率會嚴重影響整體碼率。OLD碼率計算公式如下:

Table 1 OLD parameter quantization table表1 參數OLD量化表

這里,bitsquan、M、L和N分別代表每個OLD數據量化所需要的比特數(恒定4 bit)、子帶數、每秒內幀數目以及輸入對象數。比如說,一個場景中有64個音頻對象,邊信息OLD參數的整體碼率為358.4 Kb/s。AVS(audio video coding standard)中提出未來音頻場景中最多要支持128個對象[17],這時OLD參數碼率會達到716.8 Kb/s,相當于下混聲道編碼碼率的16.8倍。因此,僅依賴數據分布特性來進行空間參數的量化編碼,碼率過高,亟需有效壓縮邊信息的量化編碼方法。

3 空間參數量化方法

3.1 整體編解碼框架

在3D音頻中,音頻對象有可能存在于空間的任意位置,因此音頻對象的重放也并不是如傳統的多聲道信號直接用固定的揚聲器重放。當多個音頻對象同時發聲時,由于疊加定位(summing localization)現象的存在,對于具有相同頻率成分的兩個空間位置分離的單頻音源,人耳會感知到一個位于兩個聲源之間的合成聲像[18]。同理,當三維空間中3個音頻對象同時發聲時,人耳只能感知到一個合成的聲像,且位于3個音頻對象圍成區域內。因此,音頻對象編碼和重建,與對象的空間位置以及人耳對3D空間感知特性有關。

本文提出一種逐層下混的方式。在三維空間中,重建任意位置空間聲像所需要的最少對象個數為3個,因此本文充分利用音頻對象的空間位置,采用三元組下混的方式作為逐層下混的第一層。第二層下混則采用二元組的混合方式。

3.1.1 編碼框架

本文提出一種采用逐層下混的編碼框架。第一層下混充分考慮音頻對象空間位置以及人耳空間感知特性對三維空間音頻下混的影響,采用三元組的下混方式,利用基于幅度矢量合成的虛擬聲像估計的方法[18]來進行對象的下混,第二層采用二元組的下混方式,如圖2所示。

Fig.2 General framework of this paper method in each layer in encoding stage圖2 本文方法在編碼端的逐層下混框架

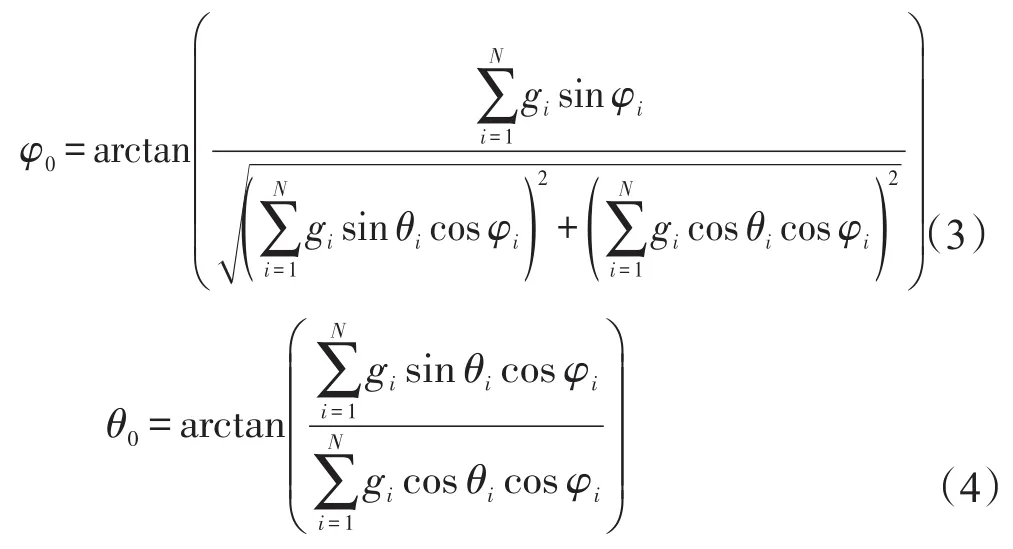

在編碼端,利用表征音頻對象空間位置(方位角,高度角)等信息的元數據,可以將空間位置臨近的3個音頻對象分為一組,作為一個下混三元組。由于同一時刻、每一頻率成分處人耳只能感知一個合成虛擬聲像,于是在每個三元組中,可以獲取3個對象音頻相同頻域成分處的能量,以及對象的空間位置,根據基于幅度矢量合成的虛擬聲像估計的方法[18],可以估計出合成虛擬聲像的能量,以及該聲像所處空間位置,即為第一層下混的空間參數。具體計算公式如下:

其中,θ0、φ0、g0、θi、φi和gi分別是虛擬聲像的高度角、方位角和增益,以及每組中第i個對象信號的高度角、方位角和增益。

方位角和高度角利用3.2節提出的量化編碼方式進行處理,而計算得到的多個合成虛擬聲像進行第二層下混。

第二層下混則只考慮音頻數據特性,將第一層下混得到的多個虛擬聲像作為新的對象信號,采用二元組提取參數的方法,直接基于頻譜系數的數值特性,每個對象提取一組空間參數,最終得到一個下混聲道和多組邊信息。

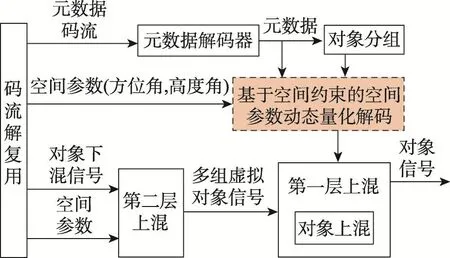

3.1.2 解碼框架

在解碼端可以獲得與編碼端相同的對象的元數據,以及下混對象信號和第一層下混的方位角、高度角空間參數以及第二層下混的空間參數,整體編碼框架如圖3所示。

Fig.3 General framework of this paper method in each layer in decoding stage圖3 本文方法在解碼端的逐層上混框架

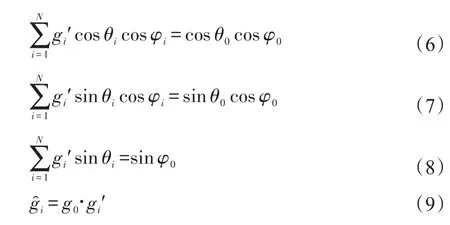

解碼端的音頻恢復與解碼端過程相逆。根據在編碼端提取的空間參數進行第二層下混的恢復,利用第二層空間參數對最終的下混對象進行上混,可以恢復得到第一層下混時獲得的虛擬聲像的能量。而利用第二層上混恢復的虛擬聲像的能量,以及傳輸得到的空間參數(方位角、高度角)以及初始對象的空間方位,利用下列公式進行第一層上混,得到恢復出的空間對象信號。

這里,g?i和gi′分別是第i個重建對象的增益以及增益比例因子。針對每個分組都使用該公式進行恢復,依次重建得到所有音頻對象。

3.2 基于空間約束的空間參數動態量化方法

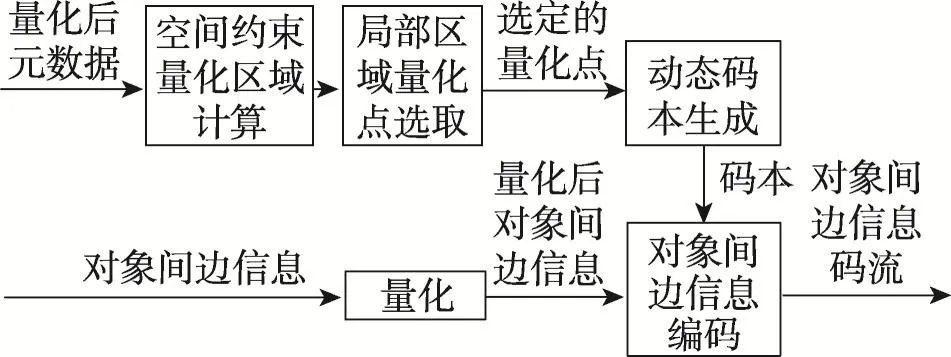

基于Summing Localization現象[19]可知,當三維空間中3個音頻對象同時發聲時,人耳只能感知到一個位于3個對象包圍下的合成聲像。基于此,本文提出了基于空間約束的空間參數動態量化方法,利用虛擬聲像的位置與產生該虛擬聲像的音頻對象的空間位置之間的關系,動態確定滿足人耳聽覺感知特性的局部量化點,以降低空間參數碼率。第一層下混的空間參數量化編碼模塊如圖4所示。

Fig.4 Certain layer process of this paper method in parameters encoding stage圖4 本文方法中參數編碼階段第一層下混流程

在量化模塊,方位角和高度角作為一個二元組來共同決定空間中的一個位置,同時也可以唯一地量化到某個量化點上。全局量化點的選取參考利用人耳對空間位置感知敏感度的基于JND(just noticeable difference)的空間方位角量化方法[20]。

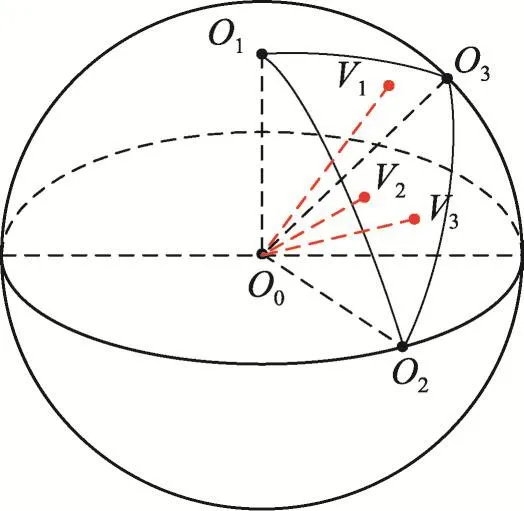

利用表征空間位置的元信息可以將所有音頻對象按照臨近位置關系劃分為三元組,每個三元組中的音頻對象的空間位置可以確定一個球面三角形區域。如圖5所示,在3個音頻對象O1、O2、O3圍成的球面三角形O1O2O3區域中,可以計算得到虛擬聲像V1、V2、V3,這些虛擬聲像可以位于球面三角形區域內的任意位置,同時它們所對應的量化點同樣也存在于該區域內。

Fig.5 Phantom source generated by 3 audio objects in spatial scene圖5 空間中一組3個音頻對象產生虛擬聲像

因此,本文根據該球面三角形所包圍的區域,可以確定一個空間量化局部碼本,并按照某種特定順序進行排序并給定索引;然后利用這個局部量化碼本來對計算得到的方位角和高度角進行量化,同時用索引來表征方位角、高度角這個二元組;最后對所有空間參數所對應的索引進行二進制編碼。對象元信息編碼后與空間參數碼流一起傳輸給解碼端。

在參數解碼端,如圖6,元信息以及相應的空間參數的Huffman碼流作為輸入。解碼端必須使用與編碼端相同的碼本選擇策略,這樣才可以對編碼后的參數信息進行解碼。因此,利用元信息中的空間位置可以確定與編碼端相同的球面三角形區域,進而確定局部量化點,得到與編碼端相同的索引以及二進制碼;然后利用二進制碼對參數碼流進行解碼,得到解碼后的方位角和高度角,并傳給上混模塊進行后續對象重建操作。

Fig.6 Certain layer process of this paper method in parameters decoding stage圖6 本文方法中參數解碼階段第一層上混流程

4 實驗

4.1 實驗條件

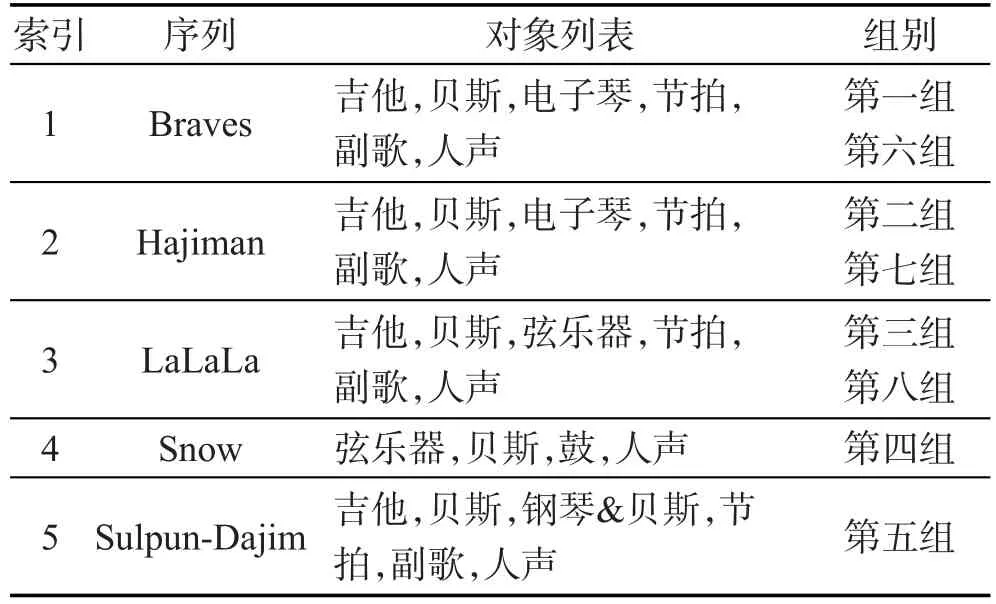

為了驗證方法的性能,針對兩種編碼方法——SAOC和本文提出的量化編碼方法進行了客觀實驗和主觀實驗。客觀實驗針對兩種方法所提取的空間參數的碼率進行對比;主觀實驗是針對兩種方法量化編碼前后的主觀空間音質進行CMOS評分。針對所有實驗,本文方法和對比SAOC方法的參數碼率以及音頻對象重建質量都進行分組對比。實驗序列如表2所示。

Table 2 List for experimental materials表2 實驗序列詳表

對測試序列中的音頻對象分別使用對比方法SAOC方法進行編碼解以及使用本文方法進行編解碼。下混聲道采用128 Kb/s碼率進行編碼。

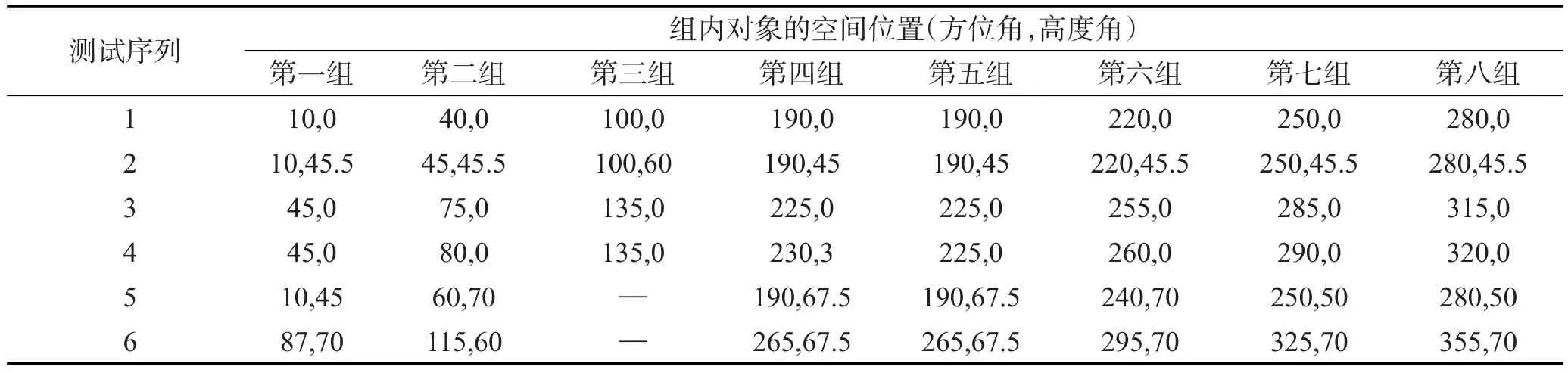

在真實場景中,每個音頻對象都具有自己的空間位置。實驗中每個對象的空間位置(方位角和高度角)在表3中列出。

4.2 碼率比較

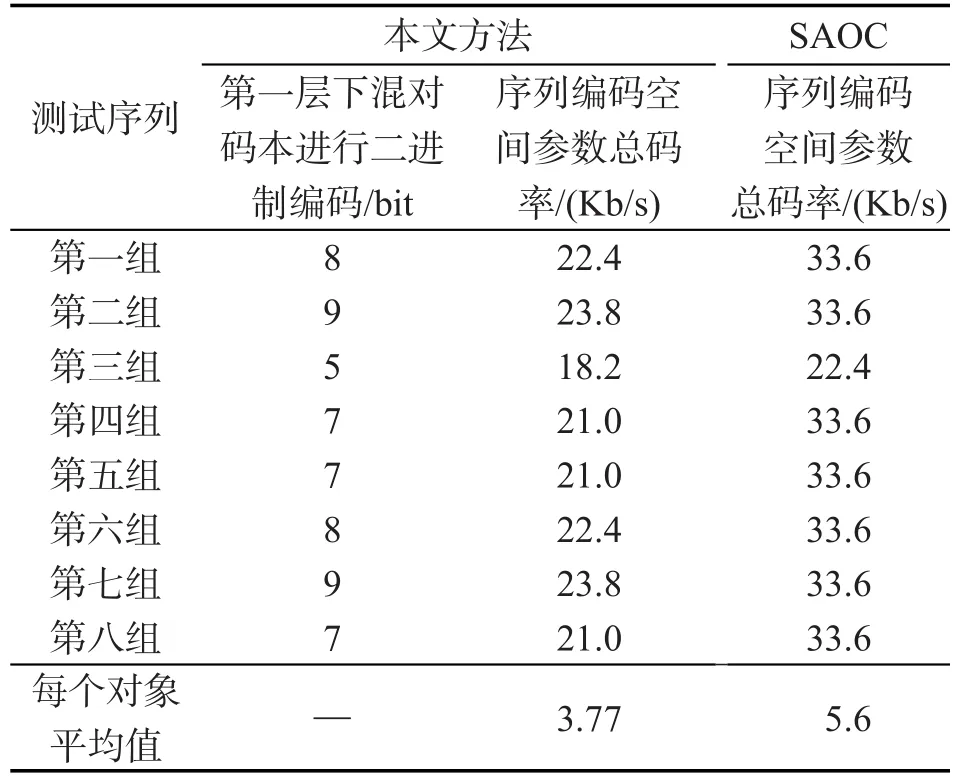

本節針對SAOC方法與本文方法的參數碼率進行比較。使用兩種方法對8組測試序列分別進行下混編碼,提取出的空間參數在實際應用中可以使用Huffman等編碼方式進行編碼壓縮。在實驗中為了獲得最直觀的結果比較,所有參數均按照二進制進行編碼。詳細比特率值如表4所示。

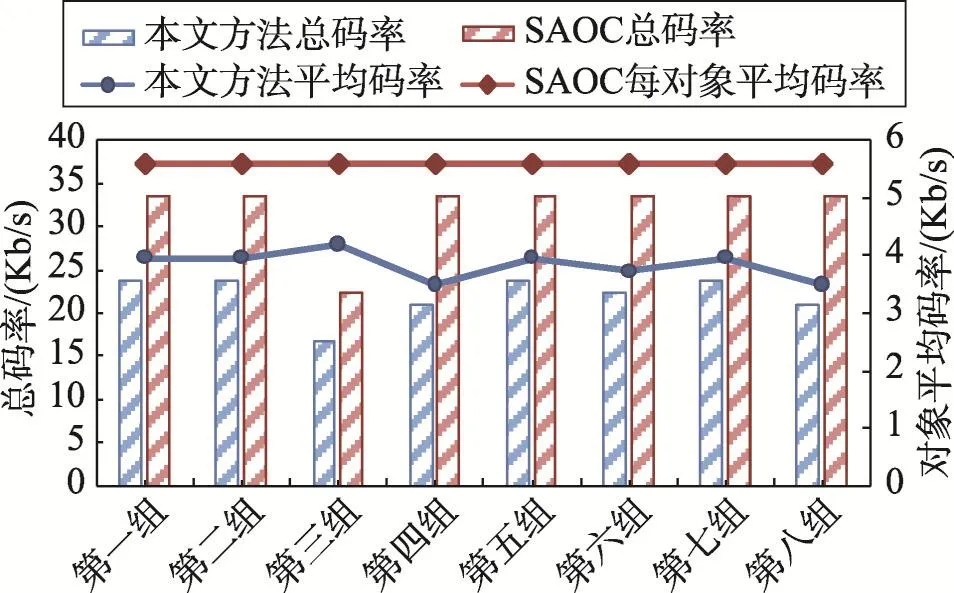

針對所有的測試序列,本文方法的邊信息的總比特率為18.2~23.8 Kb/s,每個對象平均碼率為3.77 Kb/s,而SAOC方法的邊信息的碼率為22.4~33.6 Kb/s,平均每個對象平均碼率5.6 Kb/s,每個對象平均降低了32%。并且由于對象空間位置不同以及量化點的非均勻量化,導致本文方法在第一層下混時所需要的量化比特數不固定,進而導致整體碼率的變動。

Table 3 Spatial location of audio objects表3 實驗對象空間位置

Table 4 Theoretical bitrate to code spatial parameters of objects with 28 sub-bands and 20 ms frame表4 每組音頻對象按照28個子帶、20 ms幀處理的參數碼率理論值

圖7為8組測試序列中本文方法與SAOC方法實驗所得的參數總碼率與每個對象平均參數碼率對比圖。

通過圖7可以直觀看出,本文方法實現的邊信息碼率比SAOC方法的邊信息碼率大幅降低。

Fig.7 Total bitrate and average bitrate of each object in each experimental group圖7 每組音頻對象總參數碼率以及對象平均參數碼率

4.3 主觀測試

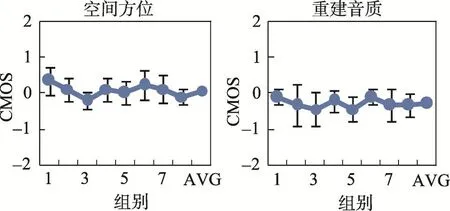

本節主要通過主觀實驗驗證本文提出的對象間空間參數編碼方法在重建效果方面的性能,并與參考方法SAOC進行性能對比。

主觀實驗采用標準CMOS(comparison mean opinion score)[21]主觀聽音測試方法評價不同面向對象音頻編碼方法編解碼前后的空間方位以及空間音質。主觀測試一共有8組實驗,每組4~6個對象,每組測試序列包含R、A、B這3個序列。其中所有原始音頻對象重建生成一個雙耳音頻,作為參考序列R,使用SAOC方法進行量化編解碼后恢復的對象信號再進行空間化得到的音頻序列記為A,而使用本文方法進行處理并空間化的音頻序列記為B。在測試時,序列A和B播放順序隨機(聽音者不知道A和B播放的先后順序),讓聽音者比較二者哪一個更接近序列R,如果后者相比前者更接近R,打分就為正分,反之則為負分。如果播放時按照先B后A的方式進行播放,那么后期處理時需要將數據取反。主觀評分標準如表5所示。

聽音測試選取8名有經驗的、具有正常聽力水平的、年齡在22~26歲之間的音頻領域研究生作為主觀聽音測試人員,實驗采用矢量幅度平移的權值分配方法將對象分配到22.2多聲道系統上,在專業的聽音室中進行聽音測試。最后給出的主觀測試統計結果為排除部分偏激分數之后的統計結果。統計結果包含兩部分:所有聽音者得分的平均分值和95%置信區間的標準偏差統計。

Table 5 Subjective evaluation of quality of CMOS表5 主觀CMOS的評分標準

具體實驗結果如圖8所示,圖中評分表示本文方法比SAOC編解碼之后的音頻效果如何,其中正分表示本文方法效果更好,反之代表SAOC實現的效果更好;而好的程度或差的程度詳如表5所示。據此可以看出:在重建音頻的空間方位方面,本文方法與對比方法SAOC等同。其中第一組序列Hajiman,本文方法重建后的音頻比SAOC方法方位感略準確,而第三組序列Snow略差,其余序列使用兩種方法量化編解碼后空間方位感幾乎沒有差異。而在重建音質方面,本文方法得到的雙耳音頻音質稍稍差于對比方法,整體平均打分約為-0.4分。其中第三組音頻Snow的重建音質得分最低,約為-0.5分,第一組評分最高,約為-0.22分。

Fig.8 CMOS scores of objects in 5 groups for spatial location and reconstruction quality圖8 5組音頻的空間方位和重建音質的CMOS評分

總而言之,在主觀感知方面,本文方法重建音頻空間方位與SAOC方法相當,音質方面略差于SAOC。在碼率方面,針對實驗序列,本文方法編碼邊信息的碼率比SAOC平均降低32%。

5 結論

面向對象編碼模式允許用戶以極大的靈活性針對不同對象進行個性化渲染,其中比較具有代表性的方法是MPEG的SAOC方法。然而隨著對象數目的增多,該方法產生的空間參數的碼率過大,造成比特浪費。針對這一問題,本文利用人耳空間感知特性,以及音頻對象的空間位置與該音頻對象產生的虛擬聲像的空間位置之間的約束關系,提出一種基于空間約束的面向對象的空間參數動態量化方法。

通過使用本文方法,在重建效果方面,本文方法重建音質與對比方法大致相當。在碼率方面,利用本文方法進行對象編碼產生的邊信息碼率約為每個對象平均3.77 Kb/s,比SAOC方法降低32%。實驗結果證明了本文方法可以在保持幾乎對等重建效果的同時,大幅降低邊信息碼率,更加適合對象較多的復雜三維場景。

[1]Yin Fuliang,Wang Lin,Chen Zhe.Review on 3D audio technology[J].Journal on Communications,2011,32(2):130-138.

[2]Hu Ruimin,Wang Xiaochen,Zhang Maosheng,et al.Review on three-dimension audio technology[J].Journal of DataAcquisition and Processing,2014,29(5):661-676.

[3]Dong Shi,Hu Ruimin,Yang Yuhong,et al.Three-channel dependent mid/side coding framework for multichannel 3D audio[J].Journal on Communications,2014,35(6):148-153.

[4]Zheng Xiguang,Ritz C,Xi Jiangtao.Encoding navigable speech sources:a psychoacoustic-based analysis-by-synthesis approach[J].IEEE Transactions on Audio,Speech,and Language Processing,2013,21(1):29-38.

[5]Jia Maoshen,Yang Ziyu,Bao Changchun.Encoding multiple audio objects using intra-object sparsity[J].IEEE/ACM Transactions on Audio,Speech,and Language Processing,2015,23(6):1082-1095.

[6]Liutkus A,Badeau R,Richard G.Low bitrate informed source separation of realistic mixtures[C]//Proceedings of the 2013 International Conference on Acoustics,Speech and Signal Processing,Vancouver,May 26-31,2013.Piscataway:IEEE,2013:66-70.

[7]Ozerov A,Liutkus A,Badeau R,et al.Informed source separation:source coding meets source separation[C]//Proceedings of the 2011 IEEE Workshop on Applications of Signal Processing to Audio and Acoustics,New Paltz,Oct 16-19,2011.Piscataway:IEEE,2011:257-260.

[8]Liutkus A,Ozerov A,Badeau R,et al.Spatial coding-based informed source separation[C]//Proceedings of the 20th European Signal Processing Conference,Bucharest,Aug 27-31,2012.Piscataway:IEEE,2012:2407-2411.

[9]Liutkus A,Pinel J,Badeau R,et al.Informed source separation through spectrogram coding and data embedding[J].Signal Processing,2012,92(8):1937-1949.

[10]Herre J,Disch S.New concepts in parametric coding of spatial audio:from SAC to SAOC[C]//Proceedings of the 2007 International Conference on Multimedia and Expo,Beijing,Jul 2-5.Piscataway:IEEE,2007:1894-1897.

[11]Engdeg?rd J,Breebaart R,Falch C,et al.Spatial audio object coding(SAOC)—the upcoming MPEG standard on parametric object based audio coding[C]//Proceedings of the 2008 Audio Engineering Society Convention,Amsterdam,May 17-20,2008.Red Hook:Curran Associates,2008:613-627.

[12]Herre J,Purnhagen H,Koppens J.MPEG spatial audio object coding—the ISO/MPEG standard for efficient coding of interactive audio scenes[J].Journal of the Audio Engineering Society,2012,60(9):655-673.

[13]Kim K,Seo J,Beack S,et al.Spatial audio object coding with two-step coding structure for interactive audio service[J].IEEE Transactions on Multimedia,2011,13(6):1208-1216.

[14]Faller C,Baumgarte F.Binaural cue coding-Part II:schemes and applications[J].IEEE Transactions on Speech and Audio Processing,2003,11(6):520-531.

[15]ISO/IEC DIS 23008-3 Information technology—high efficiency coding and media delivery in heterogeneous environments Part 3:3D audio[S].Geneva:ISO,2014.

[16]ISO/IEC 23003-2 Information technology—MPEG audio technologies-Part 2:sptatial audio object coding(SAOC)[S].Geneva:ISO,2010.

[17]Audio Video Coding Standard.Information technology—high efficiency multimedia coding Part 3:audio[S].Beijing,2016.

[18]Ke Shanfa,Wang Xiaochen,Gao Li,et al.Physical properties of sound field based estimation of phantom source in 3D[C]//LNCS 9314:Proceedings of the 16th Pacific-Rim Conference on Multimedia,Gwangju,Sep 16-18,2015.Cham:Springer,2015:699-710.

[19]Blauert J.Spatial hearing:the psychophysics of human sound localization[M].Cambridge:MIT Press,1997.

[20]Gao Li,Hu Ruimin,Wang Xiaochen.JND-based spatial parameter quantization of multichannel audio signals[J].EURASIP Journal onAudio,Speech,and Music Processing,2016(1):91.

[21]Chow C S.Research on objective speech quality measures[D].Cambridge:Massachusetts Institute of Technology,2001.

附中文參考文獻:

[1]殷福亮,汪林,陳喆.三維音頻技術綜述[J].通信學報,2011,32(2):130-138.

[2]胡瑞敏,王曉晨,張茂勝,等.三維音頻技術綜述[J].數據采集與處理,2014,29(5):661-676.

[3]董石,胡瑞敏,楊玉紅,等.面向多聲道三維音頻的和差壓縮編碼技術[J].通信學報,2014,35(6):148-153.

[17]數字音視頻編解碼技術標準工作.信息技術高效多媒體編碼第三部分:音頻[S].北京,2016.