混合卷積神經網絡的人臉驗證①

郭明金,倪佳佳,陳 姝

(湘潭大學 信息工程學院,湘潭 411105)

引言

人臉驗證是人臉識別領域的一個研究重點,本文專注于人臉驗證的任務,其目的是確定兩個臉部圖像是否屬于相同的身份.在現實中,兩個臉部圖像在姿勢、照明、表情、年齡情況下被給予其大量的個人變化.因此直接使用人臉圖像來進行驗證變得更加困難.這是因為在挑選圖像中的特征驗證身份時往往忽略隨著環境條件差異而變化的特征.

傳統方法通常分成兩個步驟中:特征提取和面部驗證.在特征提取階段,大都使用人工提取的特征,更重要的是這些人工提取的特征必須提前設計.因此,這些特征往往應用于某些特定的領域,從而導致這些特征缺乏統一性.

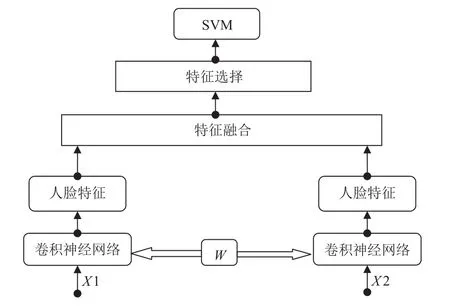

在人臉驗證的最后階段,往往可以選擇一些常用的分類器,例如用于判斷兩個臉部圖像是否屬于同一個人的支持向量機.這些分類器大都用于計算兩個臉部圖像的相似性[1-5].然而,這些模型所用的特征基本都是淺層結構的特征.但是由于Internet的發展使得大量數據的獲得十分容易,因此在使用模型時需要大量的數據提供的高維特征.但是淺層結構不能適應這一任務.因此為了解決上述問題,文章提了一種混合卷積神經網絡模型對臉部圖像進行分類.整個模型的框架如圖1所示.整個模型有以下幾個特點.

(1)從原始像素圖像中直接提取視覺特征,而不是使用傳統方法提取特征.在混合卷積神經網絡模型中特征首先從已經被訓練的卷積神經網絡提取出來.這是因為卷積神經網絡在特征提取時有良好的魯棒性并且可以表現來自不同方面的人臉相似性.

(2)特征提取后,模型先對提取到的兩個特征進行了特征融合操作.因為從同一個網絡中提取的同一個人的特征可能具有相似性.在進行特征融合以后可以使這個相似性擴大.最后使用單變量特征選擇和PCA來選擇有效的特征.

(3)提取人臉特征時模型首先優化了一個卷積神經網絡來進行特征提取操作,在這個階段為了確保良好的提取性從而引入識別率.相對與整個混合卷積神經網絡方法,這種分段訓練可以加快整體優化.

1 相關工作

用于人臉驗證的所有現有方法都是從兩個人臉提取特征開始.傳統方法大都采用淺層結構提取特征.通常使用各種淺層特征[6,7],包括SIFT[8],Gabor[9],Eigenface[10-12].還有許多人臉識別模型是淺層結構但使用了高維特征來進行最后的相似性判斷[13,14].一些方法[15]使用線性SVM進行相同或不同的驗證決策.Huang、Simonyan等[13,14]通過學習線性變換來增加圖片魯棒性.但是所有這些方法的一個主要缺點是它們對輸入圖像(移位,縮放,旋轉)的幾何變換以及面部表情,眼鏡和模糊圍巾的其他變化非常敏感.一些基于淺層網絡結構的模型學習高層的特征[16,17],這種方法與傳統的方法不同之處在于,特征提取和人臉驗證是在同一個網絡中.這些網絡的結構總是很復雜,且需要更多的時間優化參數.與傳統方法相比,它也失去了靈活性.但是由于互聯網的發展,產生了大量的數據且需要高層的特征.因此人臉識別模型需要高層特征的從原始圖像中學習.一些作者為人臉驗證設計了一些深層次的模型[1-5,18,19].但這些模型也失去了淺層模型的靈活性.所有這些方法都使用卷積神經網絡[20]來提取特征并且學習一個相似性度量方法來進行最后的判斷.這是因為卷積網絡是可訓練的多層非線性系統,可以以像素級運行,并且以集成的方式進行高級表示.雖然這些方法可以提取魯棒性良好的特征,但它們沒有考慮兩個人臉圖像的個體之間的差異性.提取特征以后所有這些模型開始直接分類判斷操作.這可能使得個體之間比較好的特征被忽略,從而導致整個網絡的準確性不高.

圖1 混合卷積神經網絡的框架

本文提出的模型和上述模型有較大的差異,即考慮淺層模型的靈活性,也保證了深層模型的有效性.模型和傳統方法一樣將人臉驗證分成特征提取和人臉驗證兩個階段.這樣做的優點是模型可以像傳統方法一樣學習到較好的人臉特征.與其他在提取后直接對不同特征進行分類的模型不同,混合卷積神經網絡模型添加了一個特征選擇和特征融合步驟,這樣在提取到兩個特征以后,考慮到兩個特征之間的相似性,模型進行一次融合操作使得整個相似性效果明顯.特征融合以后,模型使用單變量特征選擇和主成分分析(Principle Component Analysis,PCA)來選擇特征.它可以增強個體之間的差異性.單變量特征選擇通過選擇基于單變量統計檢驗得到最佳特征,PCA用于分解一組連續正交分量中的多變量數據集,其解釋了最大量的方差.

2 卷積神經網絡

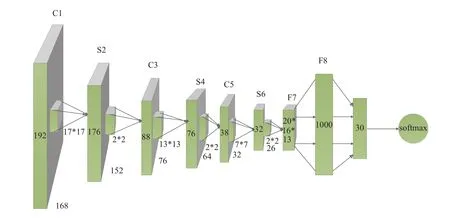

為了提取人臉特征,混合卷積神經網絡使用兩個卷積網絡模型(見圖2).這是一個典型的卷積神經網絡由交替卷積和次采樣操作組成[21].雖然架構的最后階段由通用的全連接網絡組成:最后幾層將是完全連接成一維層特征[22].卷積網絡是端對端進行訓練,將像素圖像映射到輸出[10].此外,它可以學習向量不變的局部特征,因為卷積網絡是非線性系統.提取的特征對于輸入圖像的幾何失真是魯棒的.為了保證整個模型提取到的特征效果比較好,模型先對單個卷積神經網絡進行了人臉識別研究,并保留最佳性能的網絡模型架構.在以下部分中,將詳細描述卷積神經網絡的結構.

圖2 卷積神經網絡模型(立方體的長度、寬度和高度表示輸入層大小)

2.1 混合卷積神經網絡模型

整個混合卷積神經網絡框架如圖1所示其中X1和X2表示兩幅人臉的圖片.用y表示兩幅人臉是否是一個人.在y=1表示是一個人,y=0表示不是同一個人.首先訓練一個卷積神經網絡然后保存模型參數W,用來后面提取出每個人臉的特征.這個模型參數在后面是共享.這樣使得兩張人臉圖片特征的提取都是用同一個模型.在提取到特征以后把兩個特征融合.融合以后應用PCA進行降維保留主要的特征.最后把這個特征用支持向量機(SVM)進行訓練輸出判斷的結果模型首先從使用已經訓練好的卷積網絡從兩張人臉圖像中學習特征.在網絡訓練階段,為了保證可以提取到較好的特征,模型引入了識別率進行定量分析.識別率越高,模型越好最后提取到的特征也越好.在保證了整個識別準率以后,保存整個模型結構進行后續的特征提取操作.

混合卷積神經網絡模型和其他方法最大的區別是引入了一個特征融合和特征提取操作.相比于其他方法往往直接使用提取的特征進行分類,沒有考慮到兩張人臉圖像的個人異同性.但在混合卷積神經網絡模型中,使用相加操作來融合以增加最后的特征的異同性.因為整個模型使用的是同一個卷積神經網絡模型進行特征提取操作,如果是同一個人提取到的特征必然具有相似性,在經過相加操作以后同一個特征的相似性便放大,如果不是同一個人經過相加操作以后特征的差異性會更大.最后在特征融合以后模型使用單變量特征選擇和主成分分析來選擇特征.因為在進行融合操作時有可能產生噪聲,進行特征選擇的這種方法可以確保最后使用的特征足夠好.特征融合時模型得到一個1000維特征.為了保持維度不變,在進行單變量選擇和PCA時各自選擇500維特征,最后統一這兩個特征從而可以得到1000維.

2.2 卷積神經網絡模型

模型卷積神經網絡使用了典型的卷積網絡(見圖2).Cx表示卷積層,Sx表示子采樣層,Fx表示全連接層,其中x為層索引.基本架構是C1---S2---C3---S4---C5---S6---F7---F8,具體參數設置如表1所示.

表1 神經網絡架構層參數

3 實驗分析

在上一小節具體分析了整個混合卷積神經網絡模型.這一小節整個模型將在兩個人臉數據庫上進行實驗,分別是YaleB人臉數據庫和AR人臉數據庫.整個實驗環境使用了keras在Windows10上進行.CPU:i7 6700 Hq,GPU:GTX960m.

3.1 數據處理

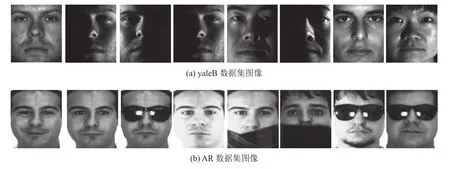

混合卷積神經網絡模型是在兩個人臉數據集的訓練和測試(見圖3).第一次在YaleB人臉數據庫上進行實驗.YaleB人臉庫由美國耶魯大學計算視覺與控制中心創建,包含了10個人的5760幅多姿態,多光照的圖像.每個人具有9種不同的頭部姿態,每種姿態下均有64種不同光照條件的圖像,每幅圖像原始大小為640×480并且具有38個對象,總共2470個圖像.本文只使用了其中的一部分并對圖片預處理得到每張圖片的大小為168 * 192.第二次訓練和測試實驗在AR人臉數據庫上進行.AR人臉庫是由西班牙巴塞羅那計算機視覺中心于1998年創建,該人臉庫包含了126個人的4000多幅彩色正面圖像,其中包括70名男性和56名女性不同面的部表情、光照變化及配飾(圍巾和墨鏡遮擋)等,在這里模型選擇只選取了2600張圖像,并進行尺寸為168 * 192的預處理.

圖3 不同數據庫的數據集圖像

為了驗證臉部圖像,每個圖像與數據集中的每個其他圖像配對.在yaleB中,2438個圖像對中有1215個正面(屬于一個人).在AR數據集中,有2587個圖像對,其具有1200個正面.測試(驗證)在20%圖像對中完成.在不同數據庫上使用卷積神經網絡進行驗證時的準確率見圖4.

3.2 模型訓練

整個混合卷積神經網絡模型的框架包括兩個網絡.模型的輸入是一對人臉圖像和標簽,然后通過各自的特征提取網絡(見圖2).最后,產生通過特征融合和特征選擇階段輸出訓練好的特征.在模型的頂部,模型使用SVM作為分類器來判斷兩張人臉圖片是否是一個人.

整個訓練過程分為兩個階段.首先,模型先訓練特征提取網絡.其次,訓練模型來驗證圖像對.為了保證提取良好的特征,混合卷積神經網絡引入識別率來衡量提取的特征的好壞,使用數據集來訓練卷積網絡來識別,然后保留對整個人臉有較好識別率的網絡結構模型.

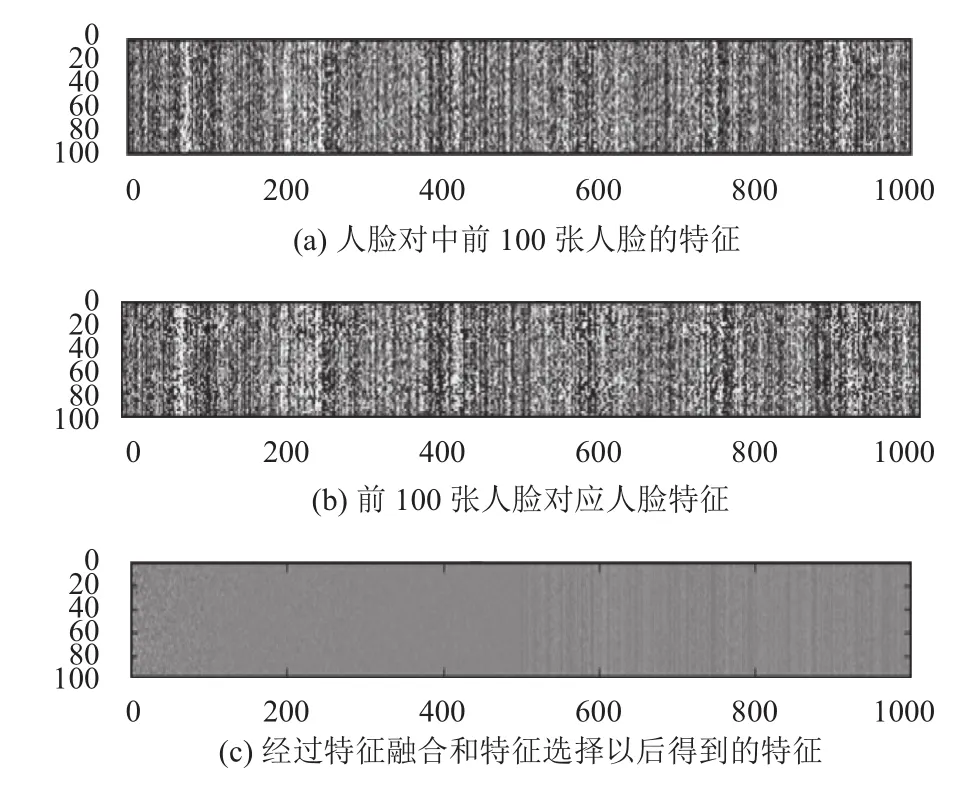

特征提取后,模型使用特征融合和特征選擇來增強個體之間的差異.在實驗中,模型從兩張人臉圖像中得到一個1000維特征.之后模型使用單變量特征選擇和PCA來選擇已融合的特征.這樣做的優點是減少特征合并中出現的噪音.經過上述操作,我們可以得到一個很好的特征.圖5顯示了提取的特征.

圖4 在不同數據庫上使用卷積神經網絡進行驗證時的準確率

圖5 前100張人臉特征圖

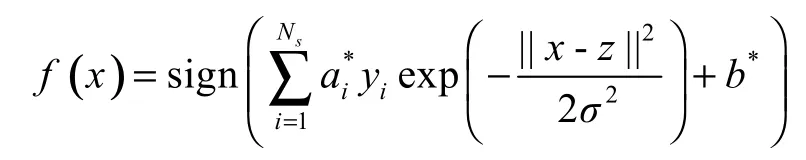

在網絡的頂端,混合卷積神經網絡使用SVM作為分類器.因為人臉圖像是非線性的,所以模型使用高斯核函數.其中高斯核函數為

其對應于SVM的高斯核函數是徑向基函數分類器.在這種情況下,分類器的函數為

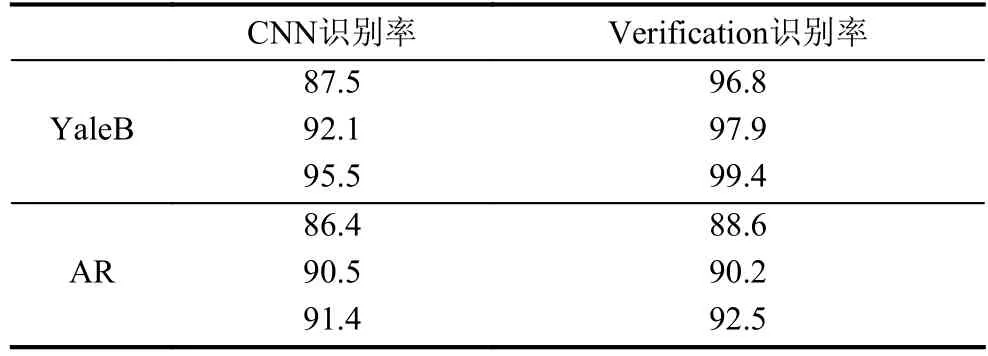

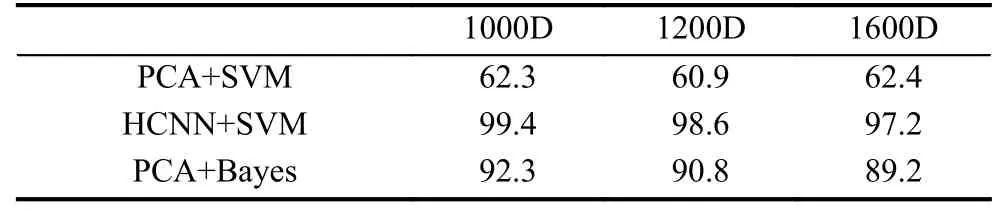

為了確保公平的比較,模型使用兩個數據庫.首先,使用兩個數據集的系統來驗證其有效性(見表2).從表中可以看出,CNN識別率對最終驗證率有影響.在表2的YaleB部分,可以看到,隨著卷積神經網絡的準確率的提高,人臉驗證的準確性也得到提高.在表2的AR部分,可以發現,即使AR數據集有很大的變化,所提出的方法也可以得到很好的結果.在表3中,混合卷積網絡方法與一些傳統方法進行比較.統計數據顯示,HBCNN在不同的維度上取得了較好的效果.

表2 在YaleB和AR人臉數據庫下HBCNN模型對不同CNN識別率下的精度比較(單位:%)

表3 HBCNN模型在YaleB數據集下與傳統方法的精度比較(D指維度)(單位:%)

4 總結

本文提出了一種用于人臉驗證的混合卷積神經網絡模型.該模型直接從人臉圖片中學習并提取特征.最后模型在兩個不同的數據集下進行了實驗,并且實驗證明整個模型在兩個人臉數據庫上都有比較好的應用.最后相對于傳統的的方法混合卷積神經網絡也有較好的效果.

1Sun Y,Wang XG,Tang XO.Hybrid deep learning for face verification.Proceedings of the IEEE International Conference on Computer Vision.Sydney,NSW,Australia.2013.1489-1496.

2Sun Y,Wang XG,Tang XO.Deep learning face representation from predicting 10,000 classes.Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Columbus,OH,USA.2014.1891-1898.

3Sun Y,Chen YH,Wang XG,et al.Deep learning face representation by joint identification-verification.Proceedings of the 27th International Conference on Neural Information Processing Systems.Montreal,Canada.2014.1988-1996.

4Sun Y,Wang XG,Tang XO.Deeply learned face representations are sparse,selective,and robust.Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Boston,MA,USA.2015.2892-2900.

5Taigman Y,Yang M,Ranzato MA,et al.Deepface:Closing the gap to human-level performance in face verification.Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Columbus,OH,USA.2014.1701-1708.

6Guillaumin M,Verbeek J,Schmid C.Is that you? Metric learning approaches for face identification.Proceedings of the 12th International Conference on Computer Vision.Kyoto,Japan.2009.498-505.

7Nguyen HV,Bai L.Cosine similarity metric learning for face verification.Proceedings of the 10th Asian Conference on Computer Vision.Queenstown,New Zealand.2010.709-720.

8Lowe DG.Distinctive image features from scale-invariant keypoints.International Journal of Computer Vision,2004,60(2):91-110.[doi:10.1023/B:VISI.0000029664.99615.94]

9Wiskott L,Krüger N,Kuiger N,et al.Face recognition by elastic bunch graph matching.IEEE Transactions on Pattern Analysis and Machine Intelligence,1997,19(7):775-779.[doi:10.1109/34.598235]

10Turk M,Pentland A.Eigenfaces for recognition.Journal of Cognitive Neuroscience,1991,3(1):71-86.[doi:10.1162/jocn.1991.3.1.71]

11Yang MH,Ahuja N,Kriegman D.Face recognition using kernel eigenfaces.Proceedings of the 2000 International Conference on Image Processing.Vancouver,BC,Canada.2000,1.37-40.

12Belhumeur PN,Hespanha JP,Kriegman DJ.Eigenfaces vs.fisherfaces:Recognition using class specific linear projection.IEEE Transactions on Pattern Analysis and Machine Intelligence,1997,19(7):711-720.[doi:10.1109/34.598228]

13Simonyan K,Parkhi OM,Vedaldi A,et al.Fisher vector faces in the wild.Proceedings of the British Machine Vision Conference (BMVC).Bristol,UK.2013.

14Huang C,Zhu SH,Yu K.Large-scale strongly supervised ensemble metric learning.US Patent 8873844.[2014-10-28].

15Huang GB,Lee H,Learned-Miller E.Learning hierarchical representations for face verification with convolutional deep belief networks.Proceedings of the 2012 IEEE Conference on Computer Vision and Pattern Recognition.Providence,RI,USA.2012.2518-2525.

16Kumar N,Berg AC,Belhumeur PN,et al.Attribute and simile classifiers for face verification.Proceedings of the 12th International Conference on Computer Vision.Kyoto,Japan.2009.365-372.

17Berg T,Belhumeur PN.Tom-vs-pete classifiers and identitypreserving alignment for face verification.Proceedings of the British Machine Vision Conference (BMVC).Surrey,Canada.2012.

18Shao H,Chen S,Zhao JY,et al.Face recognition based on subset selection via metric learning on manifold.Frontiers of Information Technology &Electronic Engineering,2015,16(12):1046-1058.

19Li QF,Zhou XF,Gu AH,et al.Nuclear norm regularized convolutional Max Pos@Top machine.Neural Computing &Applications,2016:1-10.[doi:10.1007/s00521-016-2680-2]

20Krizhevsky A,Sutskever I,Hinton GE.Imagenet classification with deep convolutional neural networks.Proceedings of the 25th International Conference on Neural Information Processing Systems.Lake Tahoe,Nevada,USA.2012.1097-1105.

21LeCun Y,Bottou L,Bengio Y,et al.Gradient-based learning applied to document recognition.Proceedings of the IEEE,1998,86(11):2278-2324.[doi:10.1109/5.726791]

22Bouvrie J.Notes on convolutional neural networks.Neural Nets,2006.https://pdfs.semanticscholar.org/2a43/93aa1bc3 cb7fe2deecc88720bfb84dabb263.pdf.