NFV硬件資源池規劃建設重點

沈蕾,王芳,吳麗華

?

NFV硬件資源池規劃建設重點

沈蕾,王芳,吳麗華

(中國移動通信集團設計院有限公司,北京 100080)

目前各大運營商均陸續商用部署NFV,NFV軟硬件解耦后,硬件、軟件需要分別規劃建設。硬件資源池及機房基礎設施是部署虛擬層及虛擬化網元的前提和基礎,基于NFV部署初期建設需求,分析了硬件資源池及機房基礎設施規劃建設應重點考慮的因素,闡述了計算、存儲、網絡設備配置要求,對比了刀片與機架服務器、磁陣與分布式存儲、增強二層與SDN組網等硬件及網絡配置,研究了硬件配置模式及重點考慮因素,分析了不同場景下的硬件冗余要求,得出了NFV硬件資源池規劃建設重點需求。

硬件資源池;計算;存儲;網絡;數據中心

1 引言

網絡功能虛擬化(network function virtualization,NFV)是將傳統電信設備功能通過軟件實現,運行于通用硬件設備之上,并采用虛擬化技術實現業務敏捷迭代、網絡演進支撐、整體成本降低的目標,是應對移動互聯網時代業務快速變化的有效手段,是向5G演進的基礎性技術和重要網絡基礎。

NFV軟硬件解耦背景下,硬件采用IT通用硬件,并且與軟件分別規劃建設。硬件及機房基礎設施是部署虛擬層及虛擬化網元的前提和基礎,本文將基于NFV部署初期建設需求,分析硬件及機房基礎設施規劃建設應重點考慮的因素。

2 硬件資源池配置重點考慮因素

NFV建設初期實現軟硬件解耦下,硬件資源池主要包括計算、存儲、網絡資源,可提供的主要硬件資源如下。

? 計算類:虛擬化服務器。

? 存儲類:磁盤陣列、分布式存儲。

? 網絡類:TOR(top of rack,架頂交換機)、EOR(end of row)。

后續隨著VNF類型的增加,硬件資源池還將提供存儲類服務器、轉發類服務器、數據庫服務器、安全設備等硬件資源。未來三層解耦后,資源池還應統籌考慮虛擬層、部分中間件、數據庫、操作系統等資源需求。

2.1 計算資源配置重點考慮因素

服務器配置一般需要考慮以下因素:服務器選型、網元側服務器需求和資源冗余因素。

2.1.1 服務器選型

服務器選型需考慮服務器形態和服務器規格,具體如下。

(1)服務器形態

通用x86 COTS服務器主流形態有刀片式、機架式和多節點服務器等。從規劃、運營維護(以下簡稱運維)角度,服務器形態應盡量少,以減小規劃運維復雜度。服務器選型應首先明確服務器形態。

現階段多節點服務器尚未得到充分的驗證。NFV建設初期,綜合考慮標準化程度、資源共享粒度等因素,建議優選機架式服務器。刀片、機架服務器主要對比見表1。

表1 刀片、機架服務器主要對比

(2)服務器規格

服務器規格需要考慮的因素較多,主要應考慮CPU性能及核數、內存容量、硬盤容量、網卡配置、擴展能力等性能及功能因素。

? 在控制面網元及業務平臺虛擬化場景下,對內存及計算性能需求較高,對網卡隔離要求較高,并需支持VT-x、超線程等功能。

? 面向大容量存儲的網元,對服務器的硬盤配置要求較高。

? 面向轉發面網元,對服務器網卡處理能力有較高需求,可能需要配置25 Gbit/s或40 Gbit/s網卡,并需支持網卡直通SR-IOV等功能。

2.1.2 網元側計算資源需求

軟件、硬件解耦后,硬件資源池與VNF項目獨立建設,網元側與硬件資源池側應有效銜接、合理分工、避免重復冗余。網元側提交計算資源需求時,應基于硬件資源池可提供的資源類型提供資源需求,并重點考慮以下因素。

? 網元自身利用率要求,可延續現網物理網元利用率要求。

? 網元內部容災備份要求,如所有業務模塊均應采用+或+方式部署。

? 跨安全域部署要求,當單個網元部署在多個安全域時,如有CMNet連接需求的業務平臺,應區分安全域并分別提交各域資源需求。

? 跨AZ(availability zone,可用區)部署要求,當單個網元跨AZ部署時,如MANO等管理類網元,應區分AZ并分別提交各AZ資源需求。

? 在二層解耦場景(虛擬層與VNF未解耦)下,硬件資源池側還需考慮虛擬層資源消耗需求,一般單服務器需要為Hypervisor+ OVS預留4核左右的資源。

? 硬件資源池側還需結合網元之間備份要求,將有容災備份關系的網元部署在不同的硬件資源池。

2.1.3 資源冗余因素

服務器資源冗余需要綜合考慮以下因素。

(1)服務器故障因素

為保障業務可用性,服務器出現故障后,資源池內應有足夠的冗余資源保障虛擬機由故障主機遷移至可用主機。

(2)資源碎片因素

資源池一定程度上實現了資源共享,但多個因素均可造成資源碎片,一般服務器數量越多、資源可共享的范圍越大,資源碎片越小;服務器分組越多、資源共享范圍越小,資源碎片越大。

資源碎片需主要考慮以下因素。

? 多VIM劃分因素:單個硬件資源池如部署多個廠商的VIM,多個廠商服務器資源獨立、無法共享。

? 多HA(host aggregate,主機組)劃分因素:HA劃分可包含多個維度,如按安全域、硬件規格、虛擬層參數、其他運維策略等,各HA資源獨立、無法共享。

? VM反親和部署因素:有容災備份關系的VM要求反親和性,具有反親和性要求的VM應部署在不同的服務器或不同的AZ,無法共享。

? 部分VM規格較大:當部分VM規格較大,超出物理機剩余可用核數時,則不能部署在剩余核數較少的物理機。

資源碎片同時也和VIM資源部署算法以及可靠性有一定關系。一般來說,VM資源部署越分散,可靠性越高,單個服務器故障不影響網元整體性能;VM資源分布越集中,則單個服務器出現故障,將造成一定性能損失。

(3)彈性伸縮預留

彈性伸縮(auto scaling)是虛擬化的優勢之一,可根據業務需求和彈性策略,自動調整彈性計算資源。

(4)升級等遷移預留

當硬件非熱插拔更換部件、VNF軟件、虛擬層軟件非在線升級時,都可能涉及虛擬資源需要從一部分物理機遷移至另一部分物理機,需要考慮該部分預留。

缺陷分析時需要計算一些分析指標,使分析結果得到定量描述,以便進行直觀地對比。度量分析指標能夠為定量分析缺陷提供基礎。對軟件產品發布后缺陷分析而言,分析指標主要包括:

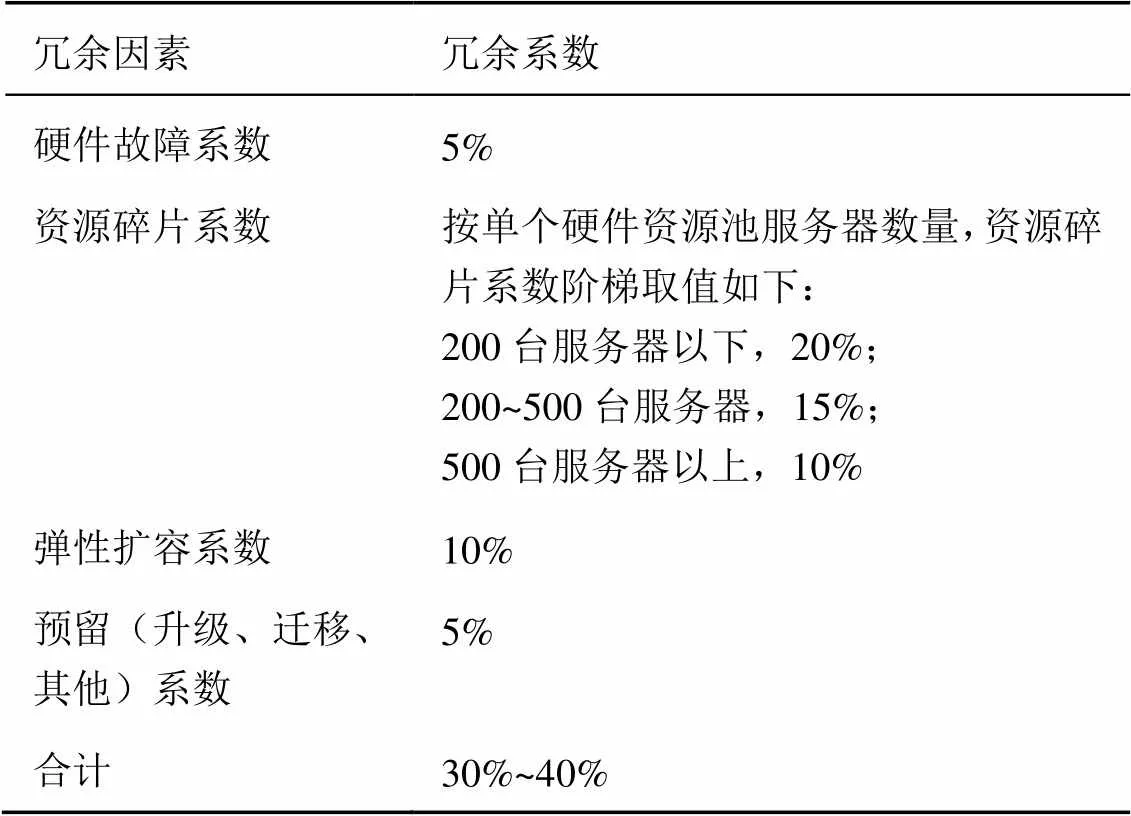

綜合考慮硬件故障、資源碎片、彈性擴容、遷移等預留需求及投資效益,服務器冗余系數建議取值在30%~40%,推薦值見表2。

2.2 存儲資源配置重點考慮因素

存儲配置一般需要考慮以下因素:存儲技術選型、網元側資源存儲需求和資源冗余因素。

表2 服務器冗余系數推薦值

2.2.1 存儲技術選型

(1)磁盤陣列與分布式存儲對比

磁盤陣列(redundant arrays of independent disk,RAID),把多塊獨立的硬盤(物理硬盤)按不同的方式組合起來形成一個硬盤組(邏輯硬盤),從而提供比單個硬盤更高的存儲性能和數據備份。

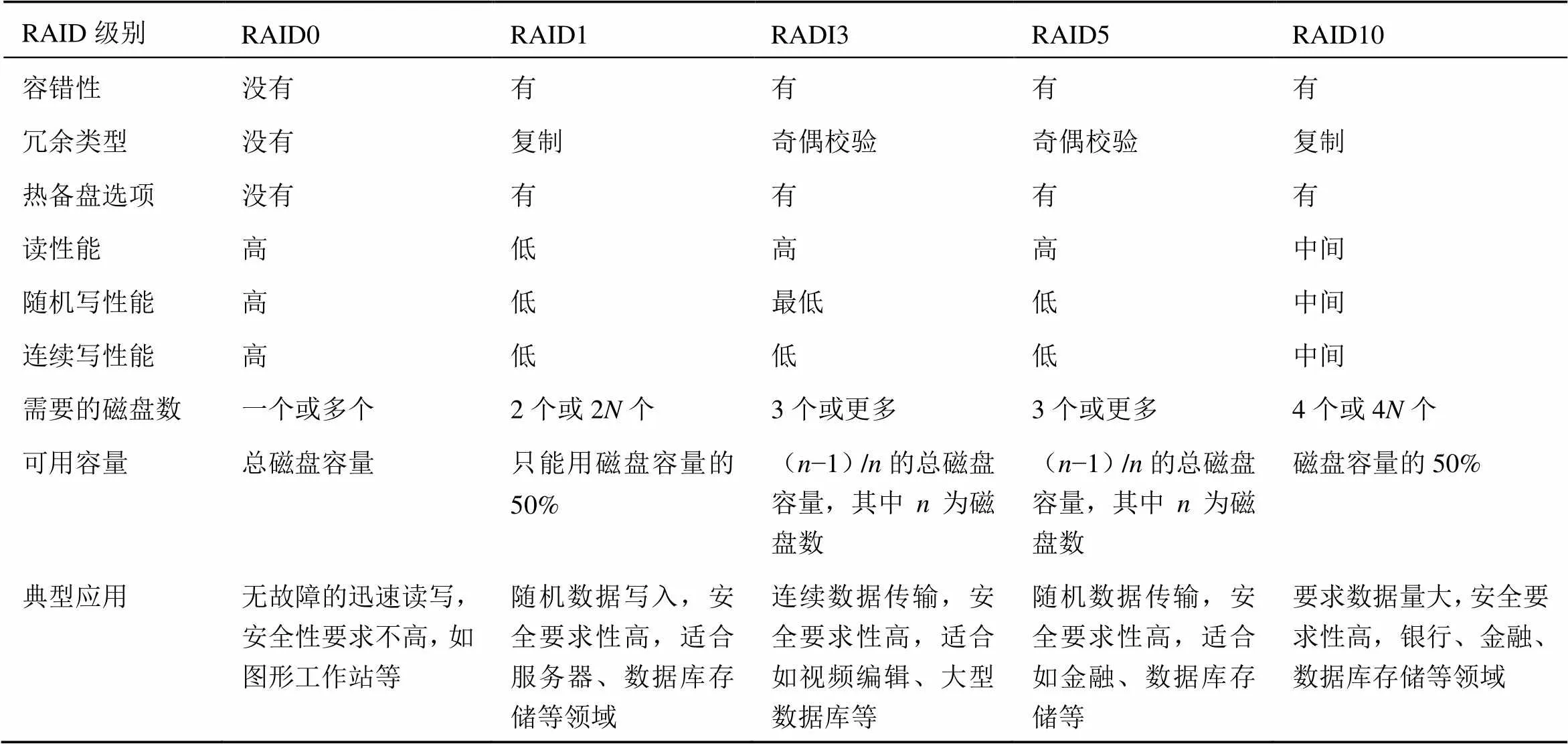

不同的磁陣組成和讀寫方式構成了不同的RAID級別。磁盤陣列可提供的RADI級別包括RAID0、RAID1、RAID3、RAID5和RADI10等,具體見表3。

表3 主要RAID方式對比

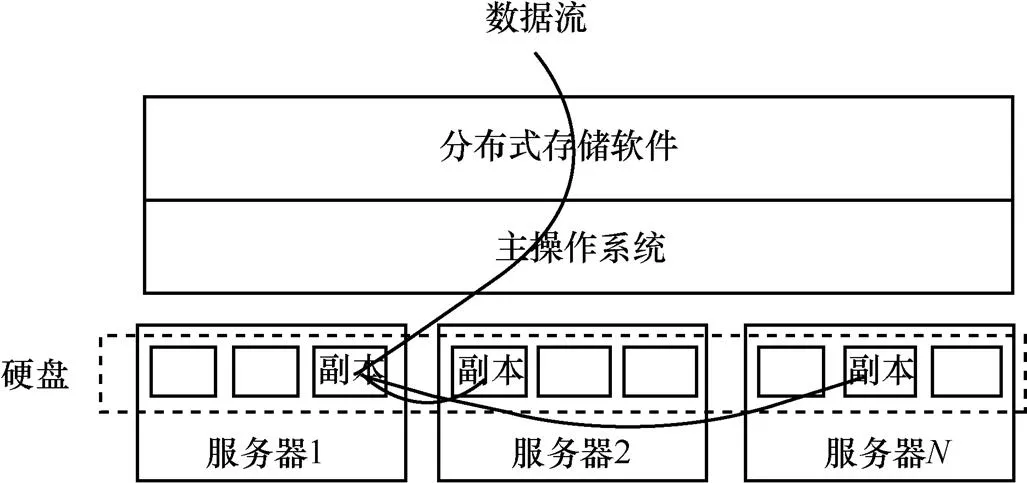

分布式存儲通過分布式存儲軟件實現將數據存儲在不同的服務器硬盤上,將分散在不同服務器的存儲資源構成一個虛擬的存儲設備。與集中的磁盤陣列不同,分布式存儲通過在服務器上加載分布式存儲軟件,數據通過分布式存儲算法計算出對應的主、副本硬盤,副本數據通過主硬盤相關進程將數據復制到副本硬盤中,如圖1所示。

圖1 分布式存儲原理示意

分布式存儲的核心是分布式存儲軟件與存儲設備相結合,通過應用軟件來實現存儲設備向存儲服務的轉變。與傳統的磁盤陣列存儲方式相比,分布式存儲不僅是一個硬件,還是一個由網絡設備、存儲設備、服務器、分布式存儲軟件、公用訪問接口、接入網和客戶端程序等多個部分組成的存儲系統。各部分以存儲設備為核心,通過分布式存儲軟件來對外提供數據存儲和業務訪問服務。

表4 磁陣與存儲服務器對比

從功能、性能、可靠性、管理和可擴展性等方面看,磁盤陣列和分布式存儲均可以滿足NFV硬件資源池需求,見表4。

分布式存儲適用于大容量、高IOPS(input/ output operations per second,每秒進行讀寫次數)需求場景,NFV資源池的存儲數據主要為讀寫要求不高、安全性要求高、數據存儲量需求不高的數據(包括用戶數據、話單數據、報表數據等)。對于基于存儲型服務器架構的分布式架構,與傳統磁盤陣列存儲方式相比,在存儲容量較小場景下,其優勢并不能得到充分發揮。

未來,隨著數據存儲量的不斷增長以及資源池規模的不斷擴大,分布式存儲優勢可充分顯現,可考慮引入計算、存儲融合架構的分布式存儲,進一步發揮其簡單、快速部署的優勢,解決傳統集中式存儲方式的單點故障問題。

(2)磁盤陣列規格

磁盤陣列規格要考慮的因素較多,在性能方面應主要考慮以下因素。

? 控制器數量及IOPS、緩存大小等。

? 硬盤容量(如900 GB、1 200 GB等)、硬盤轉速(如高速、低速或固態硬盤)。

? 前端接口、后端接口數量、類型、速率等因素。

在控制面網元及業務平臺虛擬化場景下,存儲容量及IOPS等性能需求一般不高,部分管理類網元有高IOPS需求,一般中端磁盤陣列即可滿足業務需求。

在功能方面,需結合業務、組網需求,按需選擇是否支持負載均衡、自動精簡配置、分層存儲、快照、克隆、鏡像、同步、異步遠程復制、存儲虛擬化、存儲在線遷移、支持多租戶等功能。

2.2.2 網元側資源存儲需求

網元側提交存儲資源需求時,應基于硬件資源池可提供的資源類型提供資源需求,并重點考慮以下因素。

? 網元有效存儲容量需求,應結合網元利用率考慮有效容量需求。

? 結合硬件資源池可提供的資源類型,在磁盤陣列場景下,網元側應提交RAID方式需求;在分布式存儲場景下,網元側應提交副本數量需求。

? IOPS及讀寫比例需求。

? 存儲介質要求,如使用服務器本地硬盤或外接磁盤陣列、分布式存儲等。

? 跨AZ部署要求,當單個網元跨AZ部署時,如MANO等管理類網元,應區分AZ并分別提交各AZ存儲資源需求。

2.2.3 資源冗余因素

存儲資源配置,主要應考慮以下冗余因素。

(1)對于集中塊存儲,需要考慮RADI利用率,常用RAID利用率如下。

? RAID10的存儲空間利用率為/2,取50%。

? RAID5的存儲空間利用率為(?1)/,一般取75%。

? RAID6的存儲空間利用率為(?2)/,一般取60%。

對于分布式存儲,則需要結合副本數量(一般2~4個不等),考慮存儲容量需求。

(2)對于存儲容量配置,還需考慮存儲廠商與網元側存儲容量換算單位差異,以1 TB機械硬盤來計算,1 TB實際容量為1×1 000×1 000× 1 000×1 000/1 024/1 024/1 024=931 GB空間,單位差異系數約為8%。

(3)對于磁盤陣列,還需考慮熱備盤需求及磁盤陣列自身元數據等開銷,可取10%~15%的冗余。

2.3 網絡資源配置重點考慮因素

網絡設備配置一般需要考慮以下因素:組網架構及組網技術、網元側網絡資源需求和資源冗余因素。

2.3.1 組網技術

NFV資源池規劃建設首先應明確組網技術選擇,不同的組網技術對組網架構、設備選型均有不同要求。

面向未來網絡演進,應采用SDN組網實現網絡自動化配置、增強網絡服務化能力及橫向擴展能力。但目前NFV場景下,SDN控制器北向與VIM接口以及南向與轉發設備之間的接口尚未標準化。如由VIM廠商統一提供SDN軟硬件設備,則造成了軟硬件的耦合,不滿足NFV現階段軟硬件解耦要求。

現階段NFV仍可考慮采用方案較為成熟的增強二層組網技術,目前該技術較為成熟,廠商支持情況較好,支持異廠商組網。能有效規避二層環路,無需啟用STP,當網絡中出現設備或鏈路級故障,可以快速收斂故障點實現電信級可靠性保護。后續應推動SDN接口標準化,并向SDN組網演進。

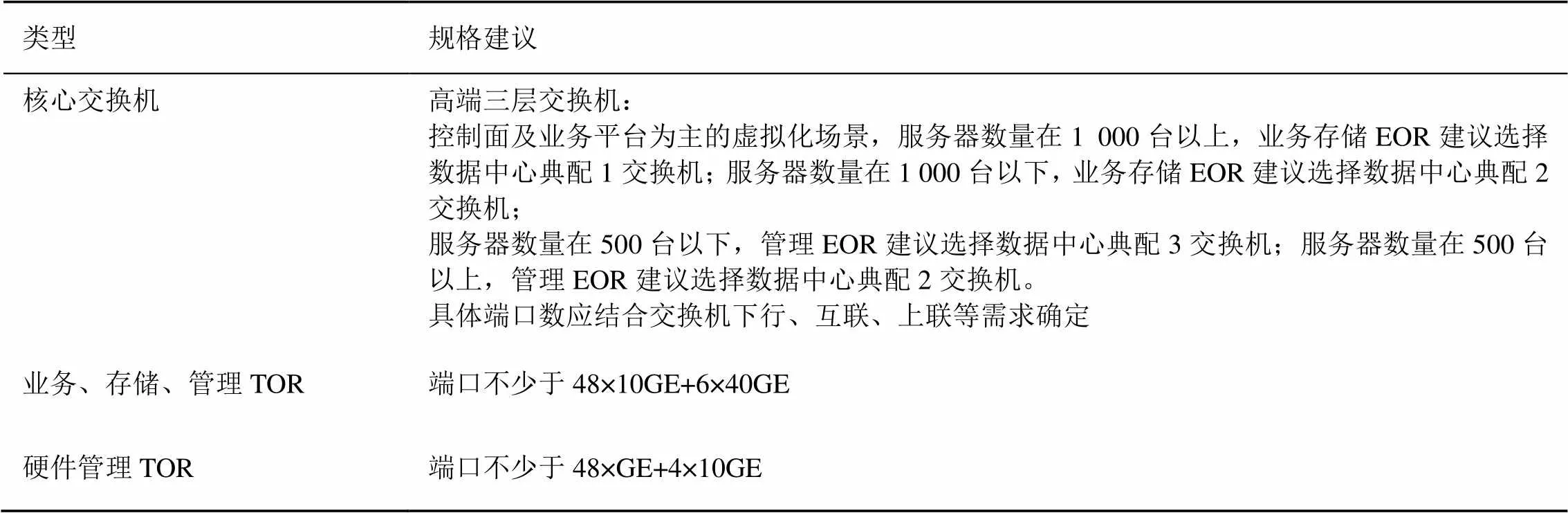

網絡設備選型方面,需結合交換機性能、功能,在性能方面,主要考慮線速轉發端口數需求。規格建議見表5。

表5 網絡設備規格建議

2.3.2 網元側網絡資源需求

網元側提交網絡資源需求時,應重點考慮以下與硬件資源池協同因素。

(1)網元側提供計算、存儲資源需求,硬件資源池側基于多網絡、多網元需求,統籌考慮資源池網絡設備端口及規格需求。

(2)網元側提供南北流量需求,南北流量既網元對外接口流量,虛擬化網元的對外接口流量及承載原則,與原有物理網元保持一致;新增網元如MANO,應提交南北流量及承載要求。

(3)網元側提供東西流量需求,東西流量既網元內部多個VM之間的流量,資源池側應結合網元東西、南北流量及組網架構,統籌考慮網絡設備上行、下行鏈路收斂比需求。

2.3.3 資源冗余因素

網絡設備冗余配置主要考慮以下因素。

? 考慮高可靠性,網絡設備應成對配置。

? 硬件分區要求,結合服務器、磁陣硬件分區要求分別部署TOR、成對EOR分別部署在兩個分區。

? 各類端口可建議考慮20%的冗余。

? 對于框式網絡設備,其業務板卡應成對配置,至同一臺/對設備的多條鏈路應分配到不同板卡的端口上,提高網絡可靠性。

3 機房及基礎設施配套重點考慮因素

3.1 機房布局

未來網絡布局將由現有“以網元為中心”向“以數據中心為中心”轉型,機房整體布局應面向未來、長遠規劃,按照滿足5~10年業務發展需求,提前規劃建設數據中心機房基礎設施。

初期應主要滿足控制面網元集中建設需求,結合運營商組網策略,可選擇全國集中、大區集中、省集中等方式。為滿足網元地理容災要求,全國/每大區/每省應選擇兩個或以上互為地理容災的局址部署硬件資源池,互為地理容災的局址應具備不同方向的市電和傳送。后續應考慮轉發面等網元對地市及以下層面機房的需求。

NFV機房面積及機架數除考慮NFV資源池需求外,應統籌考慮周邊安全管控、信令監測等系統對機房的需求。NFV機房還應具備虛擬化網元相關的承載、傳輸等網絡資源。

3.2 機房環境及工藝

機房環境和工藝應滿足IT硬件裝機需求,主要考慮以下因素。

(1)散熱要求

傳統專用硬件長期工作溫度一般在+5℃~ +40℃,IT硬件長期工作溫度范圍一般在+10℃~+35℃,進風口溫度一般要求在25±2℃(23℃~27℃);對于高保障、高密度的IT設備,進風口溫度可適當調低。

(2)送風方式

傳統專用硬件一般采用前進后出送風方式,IT硬件長期以前進后出送風為主,部分網絡設備有前進側出、左右送風等多種送風方式,需要考慮送風方式和散熱方式的匹配。

(3)承重

應綜合考慮機架重量、設備重量,并結合單位機架占地面積,換算為機房承重要求。磁盤陣列等較重的設備應安裝在承重較好的柱子列。

(4)走線槽道

部分NFV服務器網卡數量較多,造成服務器線纜較多。以單機架安裝約14臺服務器、2臺業務/存儲/管理TOR、1臺硬件管理TOR估算,單個機架約需布放236條尾纖+26條網線,需要綜合考慮尾纖槽道及尾纖下線槽的規格及數量。

? 單個機架內,服務器共需出線14×12(6個10GE口)條單芯尾纖+14×1(硬件管理GE口)條網線,其中約14×4+14×1可終結在機柜內部,仍有14×8=112條尾纖需要連接至其他機架TOR。

? 其他機架約有26臺設備,需連接至本機架TOR,共需約26×4+26×1=104條尾纖+26條網線。

? TOR互聯及上聯約需20條單芯尾纖。

? 本機架出入線口共需布放約236條單芯尾纖+26條網線。

數據中心裝機條件能較好滿足IT硬件裝機需求,應優選省級/省內數據中心機房,對于無數據中心機房或數據中心機房暫不具備裝機條件的省份,應選擇傳統通信機房進行DC化改造。

3.3 設備供電

IT硬件供電方式應與機房供電方式相匹配。為滿足IT設備較高密度部署需求、降低機房使用成本,建議優選單機架功耗5 kW及以上機架,不建議選擇單機架功耗3 kW以下機架。

3.4 機架配置

新增機架應采用19英寸標準機架(600 mm寬),機架深度需滿足IT設備安裝需求,建議不小于1 000 mm深(不含水冷前門及熱板背板深度),并結合機房具體條件,合理規劃機架尺寸。

為縮短線纜走線長度、盡量減少出機架線纜數量,服務器應與TOR共機架部署,鄰近的服務器機架應共用業務、存儲、管理、硬件管理接入TOR,成對配置的TOR應部署在不同的機架。不建議服務器與磁盤陣列、核心層及以上網絡設備共用機架。

磁盤陣列、核心層及以上網絡設備,應結合設備滿配功耗和單機架功耗實際情況,選擇是否共用機架。當單機架功耗大于磁盤陣列、核心層及以上網絡設備滿配功耗時,可共用機架。

4 結束語

NFV硬件資源池及機房基礎設施是虛擬層及虛擬化網元部署的前提和基礎,本文基于NFV部署初期建設需求,綜合考慮電信網元業務需求、解耦模式、容災要求等特點,從計算、存儲、網絡、機房資源等多層面,深入分析規劃建設重點考慮因素,為后續中國移動NFV商用部署提出了方案及建議。

[1] 孫振正, 龔靖, 段勇, 等. 面向下一代數據中心的軟件定義存儲技術研究[J]. 電信科學, 2014, 30(1): 39-43.

SUN Z Z, GONG J, DUAN Y, et al. Research on software defined storage technology for the next-generation data center [J]. Telecommunications Science, 2014, 30(1): 39-43.

[2] 顧戎, 王瑞雪, 李晨, 等. 云數據中心SDN/NFV組網方案、測試及問題分析[J]. 電信科學, 2016, 32(1): 126-130.

GU R, WANG R X, LI C, et al. Analysis on network scheme and resolution test of SDN/NFV technology co-deployed in cloud datacenter [J]. Telecommunications Science, 2016, 32(1): 126-130.

[3] 李晨, 段曉東, 陳煒, 等. SDN和NFV的思考與實踐[J]. 電信科學, 2014, 30(8): 23-27.

LI C, DUAN X D, CHEN W, et al. Thoughts and practices about SDN and NFV [J]. Telecommunications Science, 2014, 30(8): 23-27.

[4] ETSI. Network functions virtualisation whitepaper#3[S]. 2015.

[5] ETSI. Network functions virtualisation (NFV); usecases: GS NFV 001 [S]. 2015.

[6] ETSI. Network Functions Virtualisation (NFV); architectural framework: GS NFV 002[S]. 2015.

Key point of NFV hardware resource pool planning and construction

SHEN Lei, WANG Fang, WU Lihua

China Mobile Group Design Institute Co., Ltd., Beijing 100080, China

Major operators have been deploying NFV in succession, after hardware and software decoupling of NFV, hardware and software need to be separately planned and constructed. Based on the initial construction requirements of NFV deployment, the key factors were analyzed which should be considered in the planning and construction of the hardware resource pool and the machine room infrastructure. The calculation, storage, network equipment matching requirements were expounded. And the blade and rack service was compared.The hardware and network configuration of two layers and SDN networks were enhanced by the hardware, magnetic array and distributed storage. The hardware configuration mode and key considerations were studied.The hardware redundancy requirements under dif scenes were analyzed, and the key requirements of the NFV hardware pool planning and construction were obtained.

hardware resource pool, computing, storage, network, data center

TP393

A

10.11959/j.issn.1000?0801.2018201

沈蕾(1980?),女,中國移動通信集團設計院有限公司高級工程師,主要研究方向為NFV、網絡能力開放、數字化業務和未來網絡規劃。

王芳(1982?),女,中國移動通信集團設計院有限公司高級工程師,主要從事核心網及互聯網領域的方案設計和規劃咨詢工作。

吳麗華(1982?),女,中國移動通信集團設計院有限公司高級工程師,主要從事NFV、IMS網絡、RCS、物聯網等方案設計和咨詢工作。

2018?04?06;

2018?06?08