基于深度學習的室內場景識別的研究

張明,桂凱

(上海海事大學信息工程學院,上海 201306)

0 引言

深度學習最早由Hinton[1]等人在2006年提出。近年來深度學習的快速發展,在各行各業都有廣泛的應用,例如人臉識別領域,無人駕駛領域等。室內場景識別的難點在于場景圖像元素很多而且還很復雜,傳統的場景識別研究的比較多,然而利用深度學習來解決室內場景識別的研究還很少。

目標檢測是室內場景識別的核心組成部分,在多年的發展過程中產生許多經典算法。N.Dalai和B.Triggs提出梯度分布直方圖HOG[2]特征(Histogrames of Oriented Gradients),使用SVM分類器用于行人的目標檢測,該方法的優點是提取的邊緣特征可以較好地展示局部特征信息,缺點是需要圖像中的人物保持直立狀態才有較好的識別效果。Felzenszwalb等人在HOG特征的基礎上提出多尺度形變模型(Deformable Parts Models,DPM)[3]。DPM檢測方法大體與HOG一致,通過使用SVM(Support Vector Machine)訓練得到待測物的梯度模型(Model),簡單的說就是模型和目標匹配進行檢測。DPM在模型上做了很多改進工作,DPM方法被認為是目標檢測與識別領域的重要里程碑。

特征提取是室內場景識別中另一個重要部分,傳統的人工特征設計雖然能解決一些問題,但是泛化能力較弱,需要人工深度參與,并且需要人工擁有豐富的專業知識。相較而言,深度學習中特征學習不需要人工過多的參與其中,因此逐漸取代了人工設計特征。研究表明,使用深度學習技術對場景進行識別的準確率要比傳統方法要高很多[4-5]。

由于傳統的室內場景識別中需要大量的專業人員參與特征設計,時間長、工作量大。因此本文提出使用深度學習技術來解決特征設計的難題。具體來說就是先通過原圖得到高斯金字塔圖片集,然后采取優化的區域選擇算法得到待測圖片的顯著區域,接著使用CNN網絡對顯著區域的圖像進行特征學習,最后根據多層感知機對特征進行場景類別判斷。相比傳統的室內場景識別方法,本文方法優勢主要體現在不需要人工過多的參與特征設計,利用神經網絡的學習特征相比人工特征設計效果提升明顯。同時,使用多尺度提取特征比單一尺度的特征提取,特征信息更豐富,對場景識別準確度的增加有明顯提升。室內場景識別的流程圖如圖1所示。

圖1 室內場景識別流程圖

1 顯著區域提取

顯著區域是圖像中最能表現圖像內容的區域,對應到室內場景中就是指能夠代表場景內容特征的區域。通過獲取圖像顯著區域的特征,可以增加場景識別的準確度。

1.1 多尺度預處理

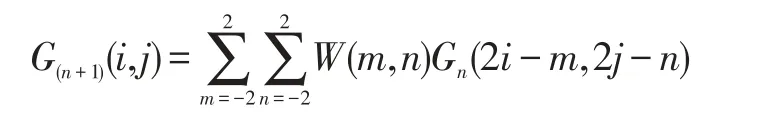

其中G(n+1)(i,j)表示新圖像,Gn表示原始圖像。W(m,n)=W(m)*W(n)是長度為5的高斯卷積和,新圖像Gn+1是通過對原圖像Gn進行偶數行采樣而得到。用MATLAB編程運行如圖2所示。

根據人眼視距的特點,景物尺寸的大小和其所在位置的距離都會影響到目標物的判斷與識別。在卷積神經網絡的特征學習過程中,一般采用池化方法來解決由于景物尺寸大小帶來的影響,不過這樣就會使得卷積神經網絡的規模變得非常大,影響網絡的性能,同時還會降低學習模型對目標的定位與描述。

為了解決這個問題,本文提出利用高斯金字塔[6]對圖像進行預處理。高斯金字塔過程是對原圖像進行多尺度像素采樣,生成一系列不同分辨率的圖像。本文主要使用下采樣,通過對一張圖片選取高斯金字塔中三張圖片輸入到卷積神經網絡中,由于圖像視野窗口一定,而每張圖片的像素點所包含的背景信息是不同的,可以得到更好的圖像表示效果。高斯金字塔的圖像可以采用如下公式來獲取:

圖2 高斯金字塔圖片

1.2 區域選擇

陳媛媛在文獻[7]中介紹了通過閾值法提取圖像顯著矩形區域的方法。具體做法是通過相關算法得到二值化的圖像。然后設定一個初始值為T的閾值,通過計算圖像中所有小于閾值T的像素平均值A1以及大于閾值T的像素平均值A2,新的閾值T'取A1和A2的和的均值,反復計算直道兩次閾值的差小于1,最后得到的閾值為最終閾值。對于大于閾值的點,用矩形框覆蓋,最后形成的矩形區域即為顯著區域。

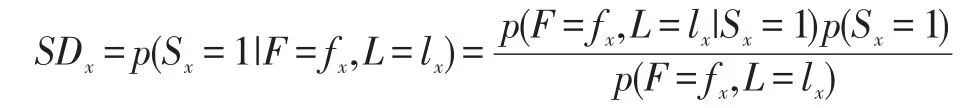

受陳媛媛方法影響,本文中將待測場景圖像的每一個點進行判斷,分為顯著類或非顯著類。這個點可以是一個像素,一個區域,或一個目標。通過該方法估算每個點的顯著度,顯著度指的是該點屬于顯著類的概率。在知道場景圖像的位置信息以及特征信息的前提下,顯著度檢測可以采用貝葉斯定理公式進行推導,本文在陳媛媛方法的基礎上做了改進,待測場景圖像中某一點的顯著度公式如下:

上式中變量Sx是二值變量,表示該點屬于顯著類還是非顯著類,變量F和變量L分別表示該點的特征信息與位置信息,fx和lx表示的是未知點x的特征信息和位置信息。因此,通過上式待測點x的顯著度SDx的概率可以用公式表示為p(Sx=1|F=fx,L=lx)。

因為特征圖表示的是圖像的不同特征,每個特征之間是相互獨立的,如果需要對不同的特征進行比較,需要將這些特征圖的取值設定標準,而且取值區間應當在相同的范圍內,對特征圖進行標準化的操作如下:

(1)對于計算得到的圖像中的點的顯著度,需要轉化成一個取值區間[0,N];

(2)將待測圖劃分成一個個小的區域,然后將每一個小區域得到的顯著度最大值N以及周圍的局部最大值n找出來;

(3)對于待測圖中所有點,計算(N-n)2。

通過上述步驟,可以根據(N-n)2的取值變化對圖像中點的顯著度區域進行判斷。如果取值變化不大,則表示該幅圖中沒有很顯著的區域,因為跟周圍的點區別不明顯。如果取值變化很大,說明該幅圖確實有很明顯的顯著度區域。

2 特征學習

室內場景識別研究中,傳統的人工特征設計都是基于特殊的場景進行。隨著深度學習的快速發展,可以采用深度學習技術對室內場景識別進行研究。

卷積神經網絡

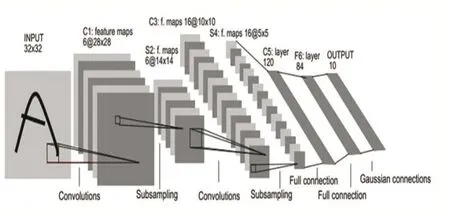

卷積神經網絡[1](Convolutional Neural Networks,簡稱CNN)是一種多層神經網絡,其隱藏層由卷積層和池化層以及全連接層組成。選用良好的卷積神經網絡模型不僅可以取得較好的識別效果,同時可以提升識別效率,減少訓練參數,加快訓練時間等。LeNet-5是最經典的卷積神經網絡,其結構如圖3所示。

圖3 LeNet-5卷積神經網絡

上圖中C1,C3,C5表示的是卷積層,S2,S4是池化層,F6是全連接層,最后一層是輸出層。卷積神經網絡通過卷積核提取圖像的特征,每個卷積層中都有多個特征平面(Feature Map),同個特征平面的神經元共享權值。對待測圖像進行卷積操作,利用局部感受野和共享參數等特性,使用池化層對圖像進行局部下采樣,可以有效減少處理的數據量,同時保留有效的數據信息。卷積神經網絡的訓練過程以圖3為例,輸入的圖像大小為32×32,若卷積核大小為5×5,通過第一層卷積操作后,得到28×28的特征圖。然后進入第二層池化層,輸入是以卷基層的輸出為基礎,若池化采用2×2均值操作,則得到14×14的池化層數據。如此反復操作,最后通過損失函數計算誤差,通過誤差修正權值,從而達到訓練目的。

3 室內場景識別方法

利用深度學習解決室內場景識別的研究主要從兩個方向入手,一個是場景圖像的顯著區域提取,一個是利用卷積神經網絡進行特征學習。本文的研究方法也是從這兩方面展開。

3.1 多尺度顯著區域的提取

為了解決視距原因造成的目標室內場景識別準確度的影響,本文提出多尺度顯著區域提取的方法來優化該問題。具體做法如下,對于一幅室內場景圖像A,將原圖標記為(Q1=A),使用高斯金字塔對A預處理,提取兩張不同分辨率圖像,然后通過區域選擇方法提取兩張圖像的顯著度,標記為Q2和Q3。通過Q1,Q2和Q3組成的多尺度顯著區域進行實驗,結果表明相比單一尺度的特征提取,多尺度的顯著區域特征提取可以更好地表示室內場景信息,同時識別準確率有明顯的提升。

3.2 顯著區域的特征學習

通過上述方法提取得到的顯著區域Q1、Q2和Q3,利用卷積神經網絡對其進行前向傳導,提取對應的特征U1,U2和U3。

上式中,W表示權重,b表示偏置。Q(k)表示輸入,g(G(k);(W,b))表示對輸入Q(k)進行前向傳導。通過卷積神經網絡提取三個不同尺度下的顯著區域特征,本文采取加權平均的方式對獲取的特征進行融合,具體如下:

其中α+β+γ=1。

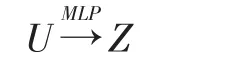

U表示融合后的顯著區域特征,為了充分提現多尺度下特征提取的互補性,取α=β=γ=1/3,由于多層感知器在圖像識別方面的廣泛應用,預測場景類別時可以訓練一個多層感知機(MLP),具體如下:

Z是MLP的輸出,即為針對場景類別的一個概率分布。MLP的損失函數定義為:

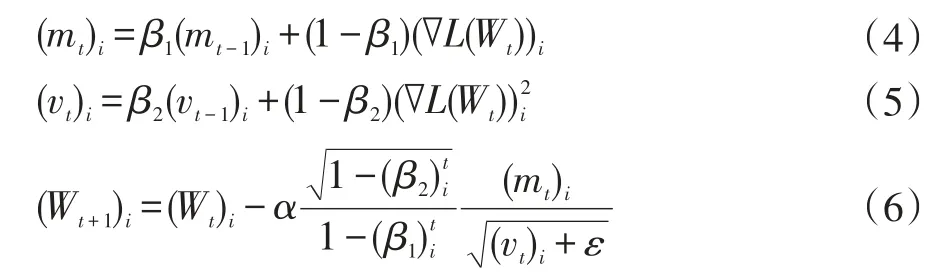

上式中,fj表示得分向量的第j個元素的得分,yi代表正確的類別。Softmax函數將一組向量的任意數值壓縮到0和1之間,使其和為上式即模型的優化目標函數,其中第二項為二次正則項。我們的目標是通過訓練,可以最小化損失。因此本文采用了Adam方法[8]對模型進行訓練。Adam方法的優化公式為:

上式中,L表示損失函數,下標t代表迭代的次數,i代表訓練樣本的標號,W為權值,mt和vt是引入的力矩估計參數,α是學習率,β1和β2是自適應參數。室內場景的類別由多層感知機(MPL)中預測概率最大的那一類所確定。

4 實驗分析

實驗所用的卷積神經網絡框架為Caff,該框架支持Python和MATLAB接口。實驗所需圖片數據庫選用的是MIT-67[9],該數據庫包含的室內場景圖像比較豐富,在場景識別領域使用廣泛,部分場景圖片如圖4。為了驗證本文方法,做了如下說明。

(1)顯著區域的選擇,選擇了原圖Q1以及經過高斯金字塔預處理得到的Q2和Q3。相比只選用原圖Q1,由Q1、Q2和Q3組成的多尺度顯著區域可以更準確地表示場景信息。

(2)特征的提取,對三個不同尺度的顯著區域特征提取,輸入到卷積神經網絡的圖像大小均為32×32。同時將學習速率α和權值λ的值分別設置為1×10-5和5×10-4。對于α的取值,試驗結果表明1×10-5是理想的學習速率。而λ則是基于經驗值,并未進行特別的調試。

實驗結果

本文所選取的MIT-67數據庫包含了67個室內類別圖像,共15620張圖像。每種類別的圖像數量上有差異,但是都不少于100張圖像,所有的圖像都是JPG格式。為了方便研究,本文選擇的圖像都是常見的如臥室、廚房等室內場景。每種場景圖片各選擇30張,共180張圖片。選擇30張圖像進行室內場景識別模型測試,剩下150張進行場景識別模型的訓練。表1展示的是預測準確度。

從圖表可以看出,辦公室和臥室的識別準確率最高,達到75%以上,原因可能是它們的室內特征相對單一明顯。而客廳和廚房的準確率在60%-70%之間,要低于臥室和辦公室,分析原因可能是顯著度提取不夠明顯,導致特征學習出現偏差。總體而言,本文使用的基于深度學習的室內場景識別方法是有效的。

其次,與傳統單一人工特征設計的場景識別的準確率的對比,將待測圖片放入訓練好的室內場景識別模型中進行測試,其中HOG,LBP,GIST[10]是傳統的單一的人工特征設計在場景識別中的準確率。Q1-Q3是指多尺度下特征融合后的場景識別準確率。測試結果如圖5所示。

從圖5可以看出,Q1-Q3的識別準去率在50%左右,相比單一尺度的特征學習的準確度提升5%,即表中Q1、Q2、Q3所示。同時相比傳統的人工特征設計的場景識別算法優勢明顯。從而可以得出本文提出的方法在室內場景識別的研究中是有效的,也說明未來使用深度學習技術進行場景識別將會成為主流的研究方向。

5 結語

室內場景識別由于室內環境的復雜性,一直是研究的熱點與難點,隨著深度學習的發展,采用不同的學習模型取得的效果也是不一樣的。通過選擇更好的學習模型,同時在優化神經網絡的參數方面進行深入研究,可以進一步改善實驗的結果。

[1]HINTONGE,OSINDEROS,TEHYW.A Fast Learning Algorithm for Deep Belief Nets[J].Neural Computation,2006,18(7):1527-1554.

[2]Dalal N,Triggs B.Histograms of Oriented Gradients for Human Detection[C].In 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition(CVPR'05)2005 jun 25(Vol.1,pp.886-893).

[3]Felzenszwalb PF,Girshick R B,McAllester D,et al.Object Detection with Discriminatively Trained Part-Based Models[J].Pattern Analysis and Machine Intelligence,IEEE Transactions on,2010,32(9):1627-1645

[4]KRIZHEVSKY A,SUTSKEVER I,HINTON G E.ImageNet Classification with Deep Convolutional Neural Networks[C].Lake Tahoe,USA:MIT Press,2012:1106-1114.

[5]SZEGEDY C,LIU W,JIA Y,et al.Going Deeper with Convolutions[C].Boston,USA:IEEE,2015:1-9.

[6]劉晨羽,蔣云飛,李學明.基于卷積神經網的單幅圖像超分辨率重建算法[J].計算機輔助設計與圖形學學報,2017(09).

[7]陳媛媛.圖像顯著區域提取及其在圖像檢索中的應用[D].上海交通大學,2006

[8]D.kingma,J.Ba.Adam.A Method for Stochastic Optimization[C].International Conference for Learning Representations,2015.

[9]QUATTONI A,TORRALBA.A Recognizing Indoor Scenes[C].Miami,USA:IEEE,2009:413-420.

[10]ZUO Z,WANG G,SHUAI B,et al.Learning Discriminative and Shareable Features for Scene Classification[C].ECCV.Zurich,Switzerland:Springer,2014:552-568.