大規模GNSS網發展及數據處理現狀

李林陽,張學東,黃 嫻,李崇輝,呂志平

(1. 信息工程大學地理空間信息學院,河南 鄭州 450001; 2. 31439部隊,遼寧 沈陽 110000;3. 河南工業大學,河南 鄭州 450001)

發展衛星導航系統已成為體現國家綜合實力的重要標志,隨著我國北斗衛星導航系統(BDS)的運行服務,美國GPS與俄羅斯GLONASS系統的現代化,以及歐洲Galileo系統的建設,多系統兼容互操作已成為衛星導航領域的核心議題。衛星導航定位基準站網不僅是提供國家、區域、全球高精度時空基準的重要基礎設施,也是導航與位置服務、精密衛星定軌、地質災害監測等工程和科學研究的重要支撐[1],地面基準站網的規模在不斷擴大,GNSS數據總量呈倍增趨勢。大規模GNSS網的發展面臨著不少機遇和挑戰,尋求GNSS大網數據的快速處理成為當前的研究熱點,受到越來越多的關注和重視[2-6]。

1 大規模GNSS網發展現狀

1.1 空間段

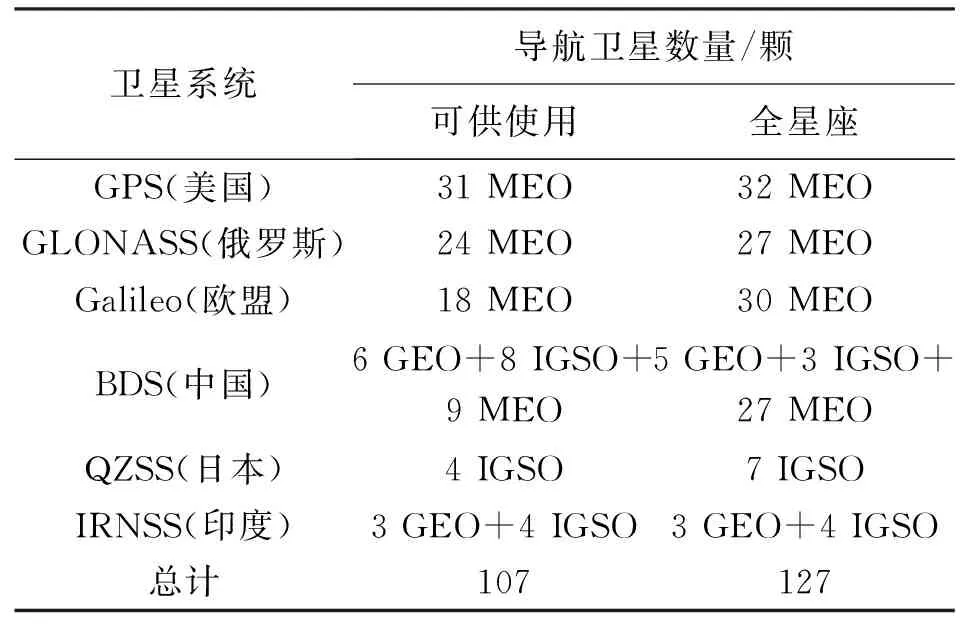

各大衛星導航系統都在加快建設與部署或升級與現代化,而提供多于兩個頻點的信號是未來GNSS的重要特征與優勢[7]。如表1所示,截至2017年11月30日,在軌運行的導航衛星數量已達107顆,表中MEO為中圓地球軌道(medium earth orbit),GEO為地球靜止軌道(geostationary orbit),IGSO為傾斜地球同步軌道(inclined geosynchronous orbit)。

表1在軌運行導航衛星數量統計(截至2017年11月30日)

衛星系統導航衛星數量/顆可供使用全星座GPS(美國)31 MEO32 MEOGLONASS(俄羅斯)24 MEO27 MEOGalileo(歐盟)18 MEO30 MEOBDS(中國)6 GEO+8 IGSO+9 MEO5 GEO+3 IGSO+27 MEOQZSS(日本)4 IGSO7 IGSOIRNSS(印度)3 GEO+4 IGSO3 GEO+4 IGSO總計107127

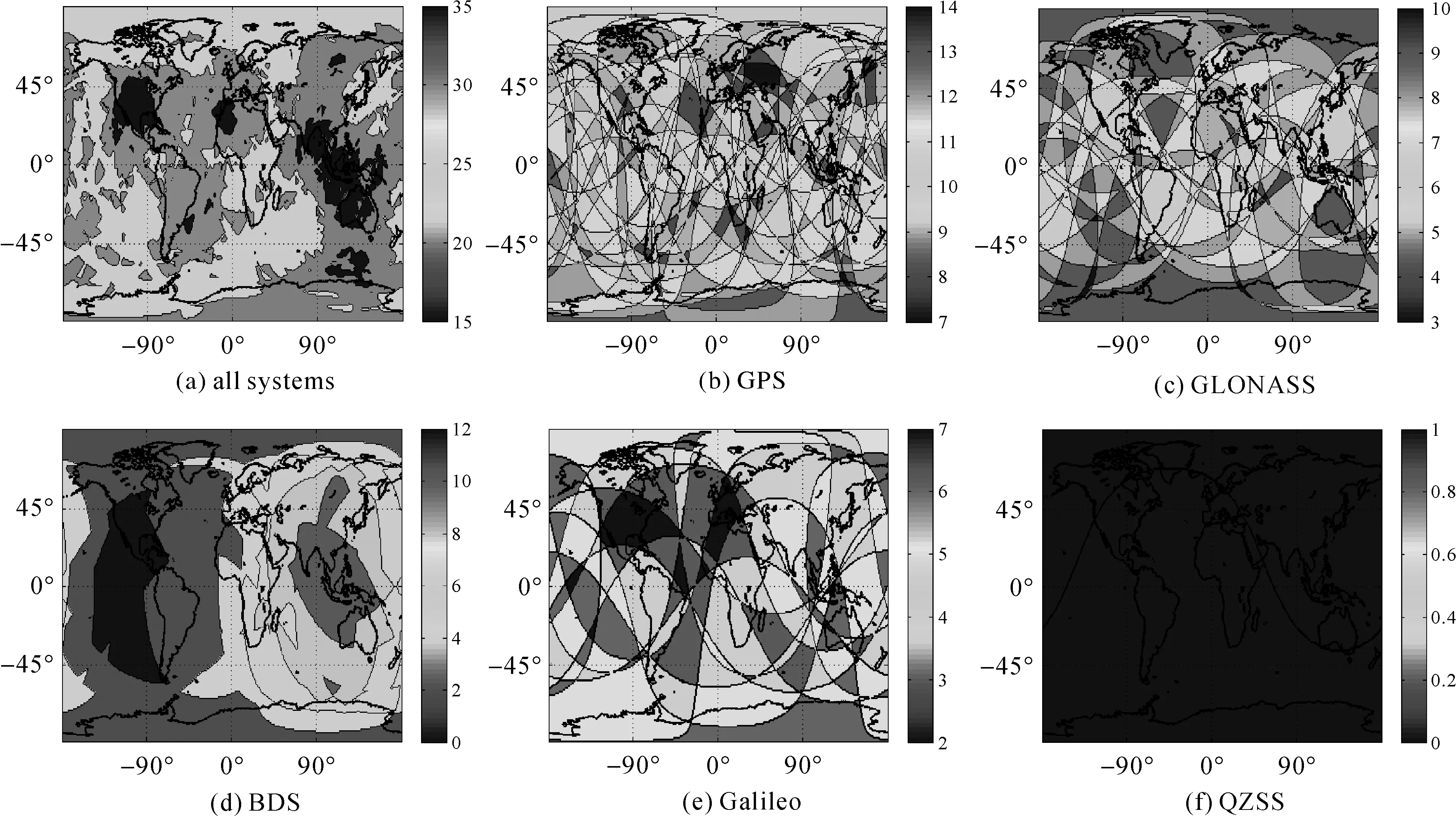

如圖1所示,新興導航系統空間段都提供至少3個頻率信號,GPS系統現代化進程中雙頻衛星也逐步由三頻衛星所取代,BDS采用全星座三頻設計,Galileo則提供4個頻率的服務。

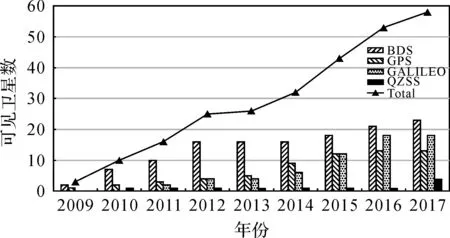

以2017年9月24日00:00:00秒為例,全球范圍內的可見衛星數如圖2所示。從圖中可以看出,多系統條件下的可見衛星數量顯著增加,任何地區的可見衛星數量不低于15顆,受目前BDS提供區域導航定位服務的限制,亞太地區的可見衛星數最多,平均超過了30顆。相較于單一的GPS,多系統融合不僅能夠擴展GNSS應用的地域范圍,增加可見衛星數量和觀測值類型,而且可以優化衛星幾何構型,緩解高山、城市峽谷等對PNT(positioning,navigation and timing)用戶的影響,進一步提升服務的可用性、精度和可靠性[8]。

圖1 多頻GNSS星座組成

圖2 全球范圍內的可見衛星數(2017年9月24日00:00:00)

1.2 地面段

與空間段對應的是,全球范圍內多個國家、地區、組織、行業和部門建立了或正在建設不同用途和功能的、包含數百甚至上千個參考站的GNSS大型觀測網絡,基準站網得到了快速發展。我國已建成上千個連續運行參考站(CORS)。整合獨立型CORS、基準站更多、層次更高的聯合型CORS也陸續開始組網[9],GNSS網的規模越來越大。同時,地面段也在不斷更新與升級,如國際GNSS服務組織(International GNSS Service,IGS)正在實施的多系統試驗計劃(multi-GNSS experiment,MGEX)[10-11],以及我國北斗地基跟蹤站網的布設、北斗地基增強系統全國“一張網”的建設[12]和我國開展的全球連續監測評估系統(iGMAS)的建設和運行[13]。

1.3 數據規模

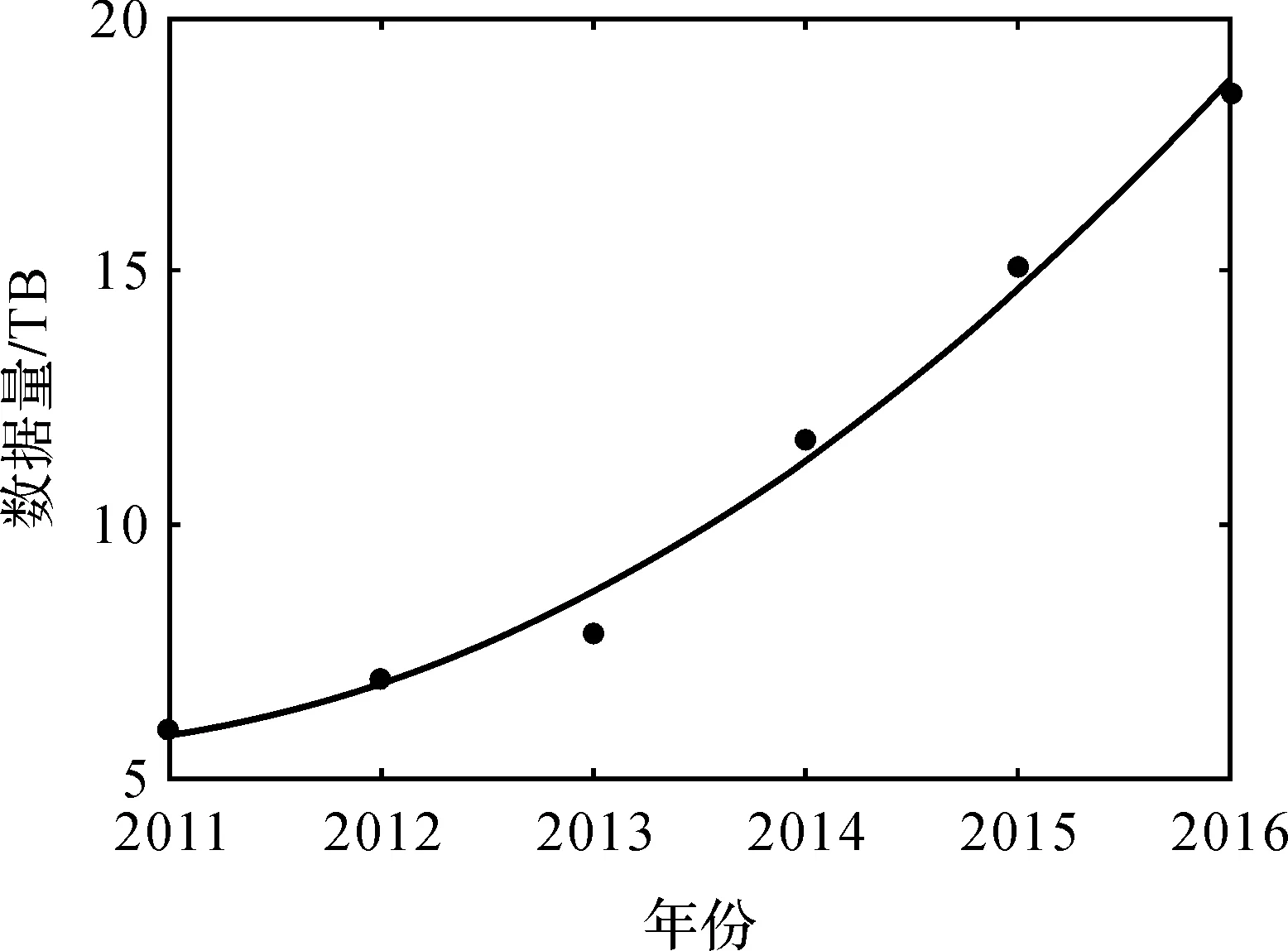

GNSS已經進入了上萬個全球參考站、超過100顆導航衛星的多系統多頻信號時代。如圖3 IGS的數據中心CDDIS存儲的數據總量所示,500個IGS跟蹤站對應的數據規模已逐步達到近20 TB。

圖3 CDDIS存儲的數據規模

大規模GNSS網數據同時也是位置大數據(location big data,LBD)[14-15]和時空大數據[16]的重要組成部分,同樣也具有大數據的5V特性[17]:Volume(海量)、Velocity(快速)、Variety(多樣)、Veracity(精確)和Value(價值)。

2 GNSS大網數據處理方法

2.1 存儲與管理

GNSS數據管理是解算和應用的基礎,GNSS數據增長的速度遠遠超過存儲技術進步帶來的成本降低的速度[17],傳統的SAN(storage area network)和NAS(network-attached storage)在容量和性能的擴展上存在瓶頸,集中式數據管理方式,如文件傳輸協議(FTP)和關系數據庫(RDBMS),難以滿足高并發讀寫和訪問、高擴展性和可用性的需求,集中式存儲方法已不能滿足大規模GNSS數據存儲應用的需要[6]。研究表明,云存儲是解決海量GNSS數據存儲瓶頸的一種有效途徑[18]。2014年,美國衛星導航系統與地殼形變觀測研究大學聯合體(University NAVSTAR Consortium,UVAVCO)提出了GNSS數據云存儲的需求和規劃[19];劉楓等設計了云GNSS管理體系,并基于Hadoop設計了CNDMA實現模型[20];李林陽等提出了GNSS數據分布式存儲與解算體系結構,基于HDFS(Hadoop distributed file system)改進了GNSS數據存儲目錄結構,基于HBase設計了GNSS數據存儲表結構[6];針對HDFS處理海量GNSS小文件效率不高的問題,結合GNSS數據類型、特點及存儲過程,提出了一種GNSS小文件高效云存儲方法,優化了GNSS小文件的寫入、讀取、添加和刪除策略[21]。

2.2 解算策略及其改進

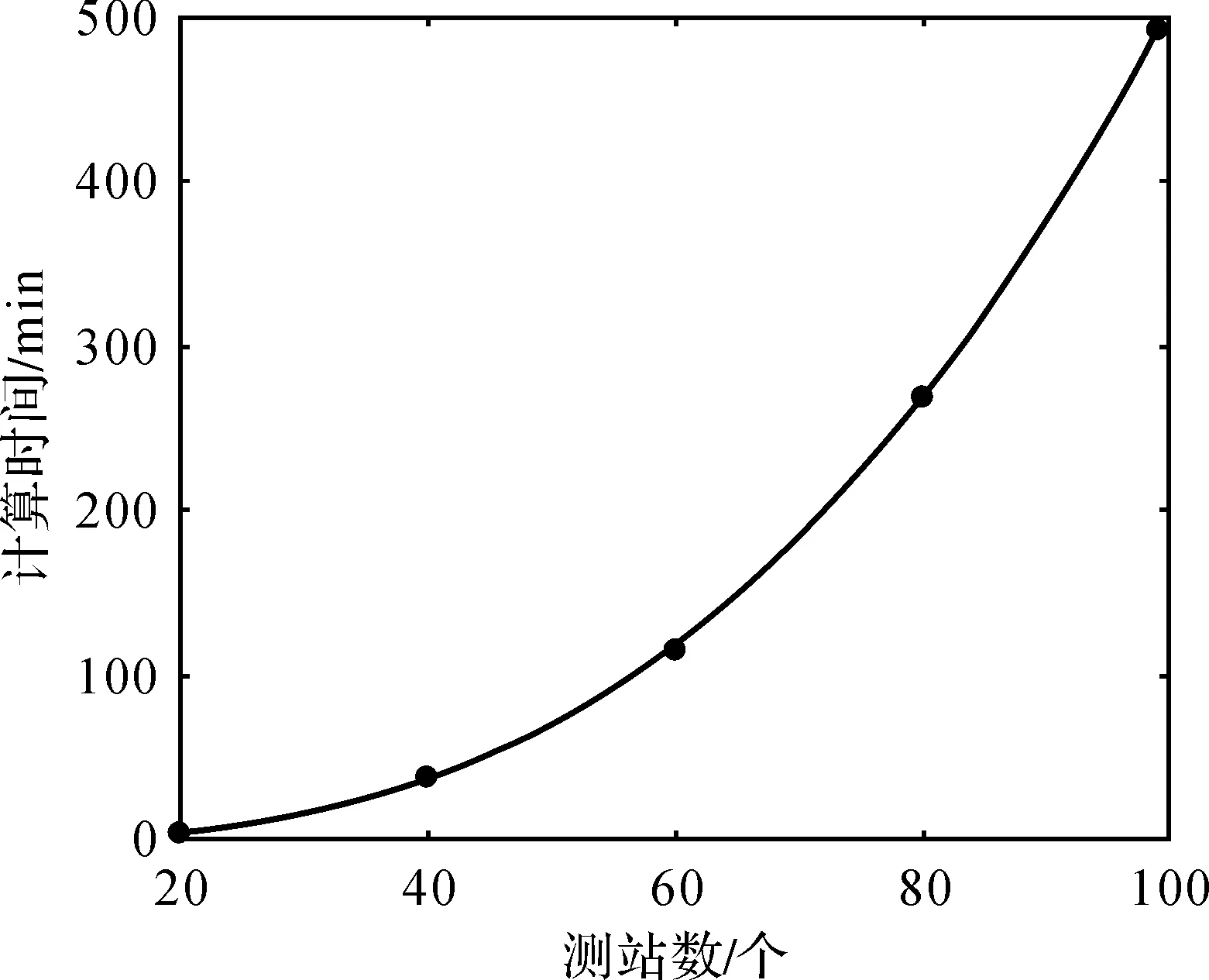

基于非差和雙差模式的解算方法是GNSS大網數據解算的兩種主要策略。對于n個測站,非差模式下的時間復雜度為O(n)(O(·)表示處理時間量級階數的函數,O(n)為線性階的時間復雜度),但其收斂時間較長,浮點解定位精度低于雙差網解[22],并且相關性較差,不利于整網平差[23]。雙差模式下的時間復雜度為O(n3),如圖4所示,以GAMIT雙差網解為例,其采用全網全基線組合,隨著GNSS網規模的擴大,處理時間呈幾何倍增加,難以滿足GNSS大網快速處理的需求。GNSS數據解算不僅需要更高性能的計算機和大量的計算時間,更為重要的是,基于雙差模式,大多數GNSS數據軟件同時解算的測站數小于100個,如GAMIT編譯時受MAXSIT參數的限制,最多同時解算99個測站。如果同時處理200個及以上測站(如Bernese、GIPSY等),則需消耗大量的計算機硬件資源和時間,嚴重影響數據解算效率,并導致解算結果的滯后[1]。

圖4 不同GNSS網規模下雙差網解計算時間

IGS分析中心通常采用子網劃分的策略,以SOPAC為例,其將全球網劃分為若干子網,每個子網測站數約為50個左右,子網通過公共站相連接。在子網劃分模型中,需要選擇3~5個重復站點,這些站點多次參與了計算,子網劃分再整體平差的協方差陣與直接整體平差的協方差陣不相同,數學模型的嚴密性受到了影響,精度也取決于重復站點的數量、分布和觀測數據的質量[24]。

GNSS大網解算時的待估參數主要由模糊度參數構成,對于由100個基準站組成的網絡,在僅觀測GPS衛星的條件下,模糊度參數數量約是其他參數的3倍;隨著GNSS衛星數量和頻率資源的增加,模糊度參數的數目還會迅速增大。另一個數目較多的待估參數是對流層延遲(zenith total delay,ZTD)參數,ZTD模型采用分段函數,通常每1~2 h估計一個ZTD參數。因此,目前主要通過以下兩個途徑解決GNSS大網數據解算面臨的瓶頸:

(1) 改進模型與算法。無論是模糊度參數還是ZTD參數,它們都是典型的與時間相關的參數,只在特定的時間段有效,分為活躍和不活躍兩種狀態。若法方程僅考慮活躍參數,則法方程的維度將會大大降低,約為原來的25%左右。基于此,很多學者研究采用參數消除與恢復方法,通過消去法方程中大量失效的模糊度等參數來降低法方程的維度[25-26,3],大大降低了內存消耗和計算時間。此外,基于高精度載波距(carrier range),提出了大規模GNSS網整體快速處理的方法,該方法首先利用約100個測站估計精密軌道和鐘差,并計算衛星端的FCB(fractional cycle bias);其次逐站進行非差模糊度固定,將載波相位量扣除固定的非差模糊度,得到高精度的新觀測值載波距;最后聯合載波距和偽距進行大網嚴密解算[5]。

(2) 采用并行計算技術。2004年,IGS在總結過去10年成就的基礎上,對GNSS數據處理能力及處理規模提出了新的要求。以此為驅動,2006年國際大地測量協會(IAG)的第1工作小組開展了Digger、Dancer和Dart(Dancer Real-Time),旨在利用網格計算和分布式計算技術,高效快速地處理全球范圍內的參考框架數據[27];2006年,Schrock展望了分布式技術和CORS的融合,提出了GNSS數據分布式處理策略[28];Enrico等采用分區分布式解算的方法,基于子網劃分的方法,高效解算了地中海中部1998—2004年超過80個CORS站的數據[29];2009年,李健等提出了一種面向聯合CORS的網格計算理論模型和大規模CORS網的體系結構[30];2010年,基于分布式計算技術,美國提出采用面向服務的體系結構(SOA)實現GPS運行控制系統(GPS-OCX)的現代化[31];2013年,呂志平等提出了大規模GNSS數據分布式處理體系架構[32];2014年,基于云計算技術,陳正生提出了GNSS測量云服務、云GNSS接收機的概念及實現形式[33],劉楓基于MPI+OpenMP混合模型實現了GNSS分布式計算[20];2016年,李林陽等基于Hadoop提出了云GNSS體系結構[34];2016年,王成等利用位置與云計算建立了電離層TEC主動式播發平臺[35];借助于Dancer項目前期開展的研究,2016年,IGS成功將協調分析中心生成融合產品的任務部署到亞馬遜云平臺上[36];2016年,楊元喜提出了綜合PNT的概念,并將云端化運控(云平臺控制體系)作為其核心關鍵技術[37]。在軟件開發上,2007年,Bernese 5.0版本就支持多核多處理器的并行計算[38],陳正生等對其進行了多節點的分布式改造[39];2013年,呂志平等從底層采用了云存儲、分布式、并行化數據處理技術,如TPL、WCF、HDFS、MapReduce等,開發了GNSS分布式處理軟件GNSSer,致力于大規模、高精度、自動化、云服務的GNSS數據快速處理和服務[40]。在實際應用中,我國陸態網數據處理[41]和美國CORS數據重處理[42]等都采用了并行計算、云計算技術,高效處理了基準站網的數據。

3 結 語

衛星導航系統和基準站網分別是實現高精度位置服務的重要空間段和地面段基礎設施,是一個國家或地區的重要戰略資源。本文首先從空間段可用衛星和頻率資源的增加、地面段基準站網的建設和升級,以及GNSS數據量的倍增3個方面闡述了大規模GNSS網的發展現狀;其次總結了GNSS大網存儲與管理的現狀,集中式數據管理存在諸多的瓶頸,云存儲是一種有效的解決方案;最后歸納了GNSS大網數據解算的研究現狀,采用改進的模型與算法和利用并行計算技術是兩種切實可行的方法。

隨著我國BDS全球覆蓋進程的加快推進,以及地基基準站網的加密和升級,大規模GNSS網迎來了新的發展機遇,研究GNSS大網的數據存儲、管理、解算和發布將一直是GNSS領域的熱點問題。